Matriz simétrica

En álgebra lineal, una matriz simétrica es una matriz cuadrada que es igual a su transpuesta. Formalmente,

Aes simétrico⟺ ⟺ A=AT.{displaystyle A{text{ is symmetric}iff A=A^{textsf {T}}

Debido a que las matrices iguales tienen dimensiones iguales, solo las matrices cuadradas pueden ser simétricas.

Las entradas de una matriz simétrica son simétricas respecto a la diagonal principal. Así que si aij{displaystyle a_{ij} denota la entrada en i{displaystyle i}a j{displaystyle j}la columna entonces

Aes simétrico⟺ ⟺ para todosi,j,aji=aij{displaystyle A{text{ is symmetric}iff {text{ for every }i,j,quad a_{ji}=a_{ij}}

para todos los índices i{displaystyle i} y j.{displaystyle J.

Toda matriz diagonal cuadrada es simétrica, ya que todos los elementos fuera de la diagonal son cero. De manera similar, en una característica diferente de 2, cada elemento diagonal de una matriz simétrica oblicua debe ser cero, ya que cada uno es su propio negativo.

En álgebra lineal, una matriz simétrica real representa un operador autoadjunto representado en una base ortonormal sobre un espacio de producto interno real. El objeto correspondiente para un espacio de producto interno complejo es una matriz hermitiana con entradas de valor complejo, que es igual a su transpuesta conjugada. Por lo tanto, en álgebra lineal sobre los números complejos, a menudo se supone que una matriz simétrica se refiere a una que tiene entradas con valores reales. Las matrices simétricas aparecen naturalmente en una variedad de aplicaciones, y el software típico de álgebra lineal numérica hace adaptaciones especiales para ellas.

Ejemplo

A continuación 3× × 3{displaystyle 3times 3} matriz es simétrica:

Propiedades

Propiedades básicas

- La suma y diferencia de dos matrices simétricas es simétrica.

- Esto no siempre es cierto para el producto: dadas matrices simétricas A{displaystyle A} y B{displaystyle B}, entonces AB{displaystyle AB} es simétrico si y sólo si A{displaystyle A} y B{displaystyle B} Comute, es decir, si AB=BA{displaystyle AB=BA}.

- Para cualquier entero n{displaystyle n}, An{displaystyle A^{n} es simétrico si A{displaystyle A} es simétrico.

- Si A− − 1{displaystyle A^{-1} existe, es simétrico si y sólo si A{displaystyle A} es simétrico.

- Rancho de una matriz simétrica A{displaystyle A} es igual al número de eigenvalues no cero de A{displaystyle A}.

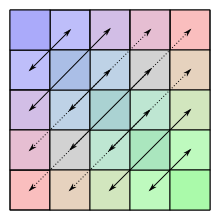

Descomposición en simétrica y asimétrica

Cualquier matriz cuadrada se puede escribir únicamente como suma de una matriz simétrica y simétrica. Esta descomposición se conoce como la descomposición de Toeplitz. Vamos Matn{displaystyle {mbox{Mat}_{n}} denota el espacio de n× × n{displaystyle ntimes n} matrices. Si Symn{displaystyle {mbox{Sym}_{n}} denota el espacio de n× × n{displaystyle ntimes n} matrices simétricas y Skewn{displaystyle {mbox{Skew}_{n} el espacio de n× × n{displaystyle ntimes n} matrices simétricas de puerco entonces Matn=Symn+Skewn{fnK}mbox{mbox {fn}mbox {fn}mbox{mbox{Skew}}_{n}}}} {n}} {fn} {fn} {fn}} {mbox{mbox{mbox {mbox{n}}}}}} {mbox}}}}}}}}}} {mbox {mbox {mbox {mbox{n}}}}}}}}}}}}}}}}}}} {mbox {mbox{n}}}}}}}}}}}}}}}} {mbox {mbox {mbox {mbox{n}} {mbox {mbox {mbox {mbox {mbox {mbox {mbox {}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} y Symn∩ ∩ Skewn={}0}{displaystyle {mbox{Sym}_{n}cap {fnK} {fn}} {fn}} {fn}} {fn}}} {mbox {fn} {fn}}} {fn}}}}} {mbox {mbox{0}}} {mbox {mbox{0}}}} {mbox {mbox{0}}}}}}}}}}}}}}}}}}}}} {mbox {mbox {mbox {mbox {mbox {mbox {mbox {mbox {mbox {mbox {}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {mbox}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {mbox {mbox {mbox {mbox {mbox {, es decir.

Note que 12()X+XT)▪ ▪ Symn{textstyle {frac {1}{2}left (X+X^{textsf {T}right)in {mbox{Sym}_{n} y 12()X− − XT)▪ ▪ Skewn{textstyle {frac {1}{2}left(X-X^{textsf {T}right)in mathrm {Skew} _{n}. Esto es verdad para cada matriz cuadrada X{displaystyle X} con entradas de cualquier campo cuya característica es diferente a 2.

Simétrica n× × n{displaystyle ntimes n} matriz determinada por 12n()n+1){displaystyle {tfrac {2}n(n+1)} escalares (el número de entradas en o por encima de la diagonal principal). Del mismo modo, una matriz simétrica de un puerco se determina por 12n()n− − 1){displaystyle {tfrac {2}n(n-1)} escalar (el número de entradas por encima de la diagonal principal).

Matriz congruente con una matriz simétrica

Cualquier matriz congruente con una matriz simétrica es otra vez simétrica: si X{displaystyle X} es una matriz simétrica, entonces lo es AXAT{displaystyle AXA^{mathrm}} para cualquier matriz A{displaystyle A}.

Simetría implica normalidad

Una matriz simétrica (de valor real) es necesariamente una matriz normal.

Matrices simétricas reales

Denote by .. ⋅ ⋅ ,⋅ ⋅ .. {displaystyle langle cdotcdot rangle } el producto interno estándar en Rn{displaystyle mathbb {R} {} {}} {fn}}. El verdadero n× × n{displaystyle ntimes n} matriz A{displaystyle A} es simétrico si y sólo si

Dado que esta definición es independiente de la elección de la base, la simetría es una propiedad que depende únicamente del operador lineal A y de la elección del producto interno. Esta caracterización de la simetría es útil, por ejemplo, en geometría diferencial, ya que cada espacio tangente a una variedad puede estar dotado de un producto interno, dando lugar a lo que se denomina una variedad de Riemann. Otra área donde se usa esta formulación es en los espacios de Hilbert.

El teorema espectral finito-dimensional dice que cualquier matriz simétrica cuyas entradas son reales puede ser diagonalizada por una matriz ortogonal. Más explícitamente: Para cada matriz simétrica real A{displaystyle A} existe una matriz ortogonal real Q{displaystyle Q} tales que D=QTAQ{displaystyle D=Q^{mathrm {T}AQ} es una matriz diagonal. Cada matriz simétrica real es así, hasta la elección de una base ortonormal, una matriz diagonal.

Si A{displaystyle A} y B{displaystyle B} son n× × n{displaystyle ntimes n} matrices simétricas reales que comunican, entonces pueden ser simultáneamente diagonalizadas: existe una base de Rn{displaystyle mathbb {R} {} {}} {fn}} tal que cada elemento de la base es un eigenvector para ambos A{displaystyle A} y B{displaystyle B}.

Cada matriz simétrica real es Hermitian, y por lo tanto todos sus eigenvalues son reales. (De hecho, los eigenvalues son las entradas en la matriz diagonal D{displaystyle D} (arriba), y por consiguiente D{displaystyle D} está determinado por A{displaystyle A} hasta el orden de sus entradas.) Esencialmente, la propiedad de ser simétrica para matrices reales corresponde a la propiedad de ser Hermitian para matrices complejas.

Matrices simétricas complejas

Una matriz simétrica compleja puede ser 'diagonalizada' utilizando una matriz unitaria: A{displaystyle A} es una matriz simétrica compleja, hay una matriz unitaria U{displaystyle U} tales que UAUT{displaystyle UAU^{mathrm {T} es una matriz diagonal real con entradas no negativas. Este resultado se denomina el Factorización Autonne-Takagi. Fue probado originalmente por Léon Autonne (1915) y Teiji Takagi (1925) y redescubierto con diferentes pruebas por varios otros matemáticos. De hecho, la matriz B=A† † A{displaystyle B=A^{dagger }A} es Hermitian y semi-definido positivo, por lo que hay una matriz unitaria V{displaystyle V} tales que V† † BV{displaystyle V^{dagger }BV} es diagonal con entradas reales no negativas. Así C=VTAV{displaystyle C=V^{mathrm {T}AV} es complejo simétrico con C† † C{displaystyle C^{dagger }C} real. Escritura C=X+iY{displaystyle C=X+iY} con X{displaystyle X} y Y{displaystyle Sí. matrices simétricas reales, C† † C=X2+Y2+i()XY− − YX){displaystyle C^{dagger }C=X^{2}+Y^{2}+i(XY-YX)}. Así XY=YX{displaystyle XY=YX}. Desde X{displaystyle X} y Y{displaystyle Sí. coma, hay una matriz ortogonal real W{displaystyle W. tal que ambos WXWT{displaystyle WXW^{mathrm {T} y WYWT{displaystyle WYW^{mathrm {T} son diagonales. Ajuste U=WVT{displaystyle U=WV^{mathrm {T} (una matriz unitaria), la matriz UAUT{displaystyle UAU^{mathrm {T} es complejo diagonal. Pre-multiplying U{displaystyle U} por una matriz unitaria diagonal adecuada (que preserva la unicidad de U{displaystyle U}), las entradas diagonales de UAUT{displaystyle UAU^{mathrm {T} se puede hacer para ser real y no negativo como se desee. Para construir esta matriz, expresamos la matriz diagonal como UAUT=diag ()r1eiSilencio Silencio 1,r2eiSilencio Silencio 2,...... ,rneiSilencio Silencio n){displaystyle UAU^{mathrm {T}=operatorname {diag} (r_{1}e^{itheta ¿Qué? ¿Qué? - Sí.. La matriz que buscamos es simplemente dada por D=diag ()e− − iSilencio Silencio 1/2,e− − iSilencio Silencio 2/2,...... ,e− − iSilencio Silencio n/2){displaystyle D=operadorname {diag} (e^{-itheta - ¿Qué? ¿Qué?. Claramente DUAUTD=diag ()r1,r2,...... ,rn){displaystyle DUAU^{mathrm {T} }D=operatorname {diag} (r_{1},r_{2},dotsr_{n}} como se desea, por lo que hacemos la modificación U.=DU{displaystyle U'=DU'. Puesto que sus cuadrados son los eigenvalues de A† † A{displaystyle A^{dagger }A}, coinciden con los valores singulares A{displaystyle A}. (Nota, sobre la descomposición eigena de una matriz simétrica compleja A{displaystyle A}, la forma normal de Jordania A{displaystyle A} puede no ser diagonal, por lo tanto A{displaystyle A} puede no ser diagonalizado por cualquier transformación de semejanza.)

Descomposición

Utilizando la forma normal de Jordan, se puede demostrar que toda matriz real cuadrada se puede escribir como producto de dos matrices simétricas reales, y que toda matriz compleja cuadrada se puede escribir como producto de dos matrices simétricas complejas.

Toda matriz real no singular se puede factorizar de forma única como el producto de una matriz ortogonal y una matriz definida positiva simétrica, lo que se denomina descomposición polar. Las matrices singulares también se pueden factorizar, pero no de forma única.

La descomposición de Cholesky indica que cada matriz simétrica real positiva-definida A{displaystyle A} es un producto de una matriz triangular inferior L{displaystyle L. y su transpose,

Si la matriz es simétrica indefinida, puede ser descompuesta como PAPT=LDLT{displaystyle PAP^{textosf {T}=LDL^{textsf {T}} Donde P{displaystyle P} es una matriz de permutación (a partir de la necesidad de pivotar), L{displaystyle L. una matriz triangular de unidad inferior, y D{displaystyle D} es una suma directa de simetría 1× × 1{displaystyle 1times 1} y 2× × 2{displaystyle 2times 2} bloques, que se llama Bunch-Kaufman descomposición

Una matriz simétrica general (complejo) puede ser defectuosa y por lo tanto no ser diagonalizable. Si A{displaystyle A} es diagonalizable que puede ser descompuesto

Desde λ λ 1{displaystyle lambda ¿Qué? y λ λ 2{displaystyle lambda _{2} son distintos, tenemos .. x,Sí... =0{displaystyle langle mathbf {x}mathbf {y} rangle =0}.

Arpillera

Simétrico n× × n{displaystyle ntimes n} matrices de funciones reales aparecen como los hesianos de dos funciones diferentes n{displaystyle n} variables reales (la continuidad del segundo derivado no es necesaria, a pesar de la creencia común a lo opuesto).

Cada forma cuadrática q{displaystyle q} on Rn{displaystyle mathbb {R} {} {}} {fn}} puede ser escrito en forma única q()x)=xTAx{fnMicrosoft Sans Serif} con un simétrico n× × n{displaystyle ntimes n} matriz A{displaystyle A}. Debido al teorema espectral anterior, se puede decir que cada forma cuadrática, hasta la elección de una base ortonormal de Rn{displaystyle mathbb {R} {} {}} {fn}}, "parece como"

Esto es importante en parte porque el comportamiento de segundo orden de cada función suave de múltiples variables se describe mediante la forma cuadrática que pertenece a la hessiana de la función; esto es una consecuencia del teorema de Taylor.

Matriz simetrizable

An n× × n{displaystyle ntimes n} matriz A{displaystyle A} se dice que simmetrizable si existe una matriz diagonal invertible D{displaystyle D} y matriz simétrica S{displaystyle S. tales que A=DS.{displaystyle A=DS.

La transposición de una matriz simetrizable es simmetrizable, ya que AT=()DS)T=SD=D− − 1()DSD){displaystyle A^{mathrm {T}=(DS)^{mathrm {T}=SD=D^{-1}(DSD)} y DSD{displaystyle DSD! es simétrico. Una matriz A=()aij){displaystyle A=(a_{ij}} es simmetrizable si y sólo si se cumplen las siguientes condiciones:

- aij=0{displaystyle a_{ij}=0} implicación aji=0{displaystyle a_{ji}=0} para todos 1≤ ≤ i≤ ≤ j≤ ≤ n.{displaystyle 1leq ileq jleq n.}

- ai1i2ai2i3...... aiki1=ai2i1ai3i2...... ai1ik{displaystyle a_{i_{1}i_{2}a_{i_{2}i_{3}dots a_{i_{k}i_{1}=a_{i_{2}i_{1}a_{i_{3}i_{2}dots A_{i_{1}i_{k}} para cualquier secuencia finita ()i1,i2,...... ,ik).{displaystyle left(i_{1},i_{2},dotsi_{k}right).}

Contenido relacionado

Semicontinuidad

Medida de haar

Grupo cuaternión