Estimador consistente

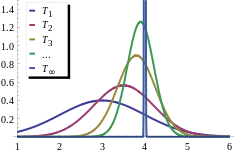

En estadística, un estimador consistente o un estimador asintóticamente consistente es un estimador: una regla para calcular estimaciones de un parámetro θ 0: tiene la propiedad de que a medida que el número de puntos de datos utilizados aumenta indefinidamente, la secuencia resultante de estimaciones converge en probabilidad a θ0. Esto significa que las distribuciones de las estimaciones se concentran cada vez más cerca del valor real del parámetro que se estima, de modo que la probabilidad de que el estimador esté arbitrariamente cerca de θ0 converge a uno.

En la práctica, uno construye un estimador en función de una muestra disponible de tamaño n, y luego imagina que puede seguir recopilando datos y expandir la muestra ad infinitum. De esta manera se obtendría una secuencia de estimaciones indexadas por n, y la consistencia es una propiedad de lo que ocurre cuando el tamaño de la muestra “crece hasta el infinito”. Si se puede demostrar matemáticamente que la secuencia de estimaciones converge en probabilidad al valor verdadero θ0, se denomina estimador consistente; de lo contrario se dice que el estimador es inconsistente.

La coherencia, tal como se define aquí, a veces se denomina consistencia débil. Cuando reemplazamos la convergencia en probabilidad con una convergencia casi segura, entonces se dice que el estimador es fuertemente consistente. La coherencia está relacionada con el sesgo; ver sesgo versus consistencia.

Definición

Hablando formalmente, se dice que un estimador Tn del parámetro θ es débilmente consistente, si converge en probabilidad al valor verdadero del parámetro:

- plimn→ → JUEGO JUEGO Tn=Silencio Silencio .{displaystyle {underset {ntoinfty}{operatorname {plim} };T_{n}=theta.}

es decir si, para todos ε > 0

- varepsilon {big)}=0.}" xmlns="http://www.w3.org/1998/Math/MathML">limn→ → JUEGO JUEGO Pr()SilencioTn− − Silencio Silencio Silencio■ε ε )=0.{displaystyle lim _{nto infty }Pr {big (}PrinceT_{n}-theta ANTEvarepsilon {big)}=0.}

varepsilon {big)}=0.}" aria-hidden="true" class="mwe-math-fallback-image-inline mw-invert" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/48701705bb84b4272165a0ff433b3e7392019dca" style="vertical-align: -1.838ex; width:26.561ex; height:4.009ex;"/>

Un estimador Tn del parámetro Silencio se dice que firmemente coherente, si es converge casi seguramente al verdadero valor del parámetro:

- Pr()limn→ → JUEGO JUEGO Tn=Silencio Silencio )=1.{displaystyle Pr {big (}lim _{nto infty }T_{n}=theta {big)}=1.}

Una definición más rigurosa tiene en cuenta el hecho de que θ es en realidad desconocido y, por tanto, la convergencia en probabilidad debe tener lugar para cada valor posible de este parámetro. Supongamos que {pθ: θ ∈ Θ} es una familia de distribuciones (la distribución paramétrica modelo), y Xθ = {X1, X2, …: Xi ~ pθ} es una muestra infinita de la distribución pθ. Sea { Tn(Xθ) } una secuencia de estimadores para algún parámetro g(θ). Normalmente, Tn se basará en las primeras n observaciones de una muestra. Entonces se dice que esta secuencia {Tn} es (débilmente) consistente si

- plimn→ → JUEGO JUEGO Tn()XSilencio Silencio )=g()Silencio Silencio ), para todos Silencio Silencio ▪ ▪ . . .{displaystyle {underset {ntoinfty}{operatorname {plim} };T_{n}(X^{theta )=g(theta), {text{for all} theta in Theta.}

Esta definición utiliza g(θ) en lugar de simplemente θ, porque a menudo uno está interesado en estimar una determinada función o una sub- vector del parámetro subyacente. En el siguiente ejemplo, estimamos el parámetro de ubicación del modelo, pero no la escala:

Ejemplos

Media muestral de una variable aleatoria normal

Supongamos que tenemos una secuencia de observaciones estadísticamente independientes {X1, X2,... } de una distribución normal N(μ, σ2). Para estimar μ basándose en las primeras n observaciones, se puede utilizar la media muestral: Tn = (X1 +... + Xn)/n. Esto define una secuencia de estimadores, indexados por el tamaño de muestra n.

De las propiedades de la distribución normal, conocemos la distribución de muestreo de esta estadística: Tn se distribuye normalmente, con media μ y diferencia σ2/n. Equivalentemente, ()Tn− − μ μ )/()σ σ /n){displaystyle scriptstyle (T_{n}-mu)/(sigma /{sqrt {n}}} tiene una distribución normal estándar:

- Pr[SilencioTn− − μ μ Silencio≥ ≥ ε ε ]=Pr[nSilencioTn− − μ μ Silencioσ σ ≥ ≥ nε ε /σ σ ]=2()1− − CCPR CCPR ()nε ε σ σ ))→ → 0{displaystyle Pr !left[, pacienciaT_{n}-mu TENgeq varepsilon ,right]=Pr !left[{frac {sqrt {n},{big Silencio. {bign} {fn} {fn}}gn}varepsilon /sigma right]=2left(1-Phi left({frac {{sqrt {n},varepsilon }{sigma }right)to 0}

como n tiende a infinito, para cualquier fijo ε ■ 0. Por lo tanto, la secuencia Tn de los medios de muestra es consistente para el medio de población μ (recalcando que CCPR CCPR {displaystyle Phi es la distribución acumulativa de la distribución normal).

Establecer la coherencia

La noción de consistencia asintotica es muy cercana, casi sinónimo de la noción de convergencia en probabilidad. Como tal, cualquier teorema, lema o propiedad que establezca convergencia en probabilidad puede ser utilizado para probar la consistencia. Existen muchas de esas herramientas:

- Para demostrar la coherencia directamente desde la definición se puede utilizar la desigualdad

- Pr[h()Tn− − Silencio Silencio )≥ ≥ ε ε ]≤ ≤ E [h()Tn− − Silencio Silencio )]h()ε ε ),{displaystyle Pr !{big [}h(T_{n}-theta)geq varepsilon {big]}leq {frac {operatorname {E} {big [}h(T_{n}-theta){big} {h(varepsilon)}}}}, }

la elección más común para la función h es el valor absoluto (en cuyo caso se conoce como desigualdad de Markov) o la función cuadrática (respectivamente, la desigualdad de Chebyshev).

- Otro resultado útil es el teorema de mapeo continuo: si Tn es consistente para Silencio y g(·) es una función de valor real continua en el punto SilencioEntonces g()Tn) será consistente para g()Silencio):

- Tn →p Silencio Silencio ⇒ ⇒ g()Tn) →p g()Silencio Silencio ){displaystyle T_{n} {xrightarrow {p}theta quad Rightarrow quad g(T_{n} {xrightarrow {p}} g(theta)}

- El teorema de Slutsky se puede utilizar para combinar varios estimadores diferentes, o un estimador con una secuencia convergente no raramente. Si Tn →dα, y Sn →pβEntonces

- Tn+Sn →d α α +β β ,TnSn →d α α β β ,Tn/Sn →d α α /β β , siempre que β β ل ل 0{displaystyle {begin{aligned} âTMa {n}+S_{n} {xrightarrow {d} alpha +beta\ {xrightarrow {d} alpha beta\ âTMa {n}/S_{n} {xrightarrow {d} alpha /beta{text{ provided that }beta neq 0end{aligned}}}

- Si estimador Tn es dado por una fórmula explícita, entonces más probable que la fórmula empleará sumas de variables aleatorias, y luego la ley de números grandes se puede utilizar: para una secuencia {Xn} de variables aleatorias y en condiciones adecuadas,

- 1n. . i=1ng()Xi) →p E [g()X)]{displaystyle {frac {fn}sum _{i=1}{n}g(X_{i}) {xrightarrow {p}\fnMicrosoft Sans Serif}

- Si estimador Tn se define implícitamente, por ejemplo como un valor que maximiza cierta función objetiva (véase el estimador de extremum), entonces un argumento más complicado que implica equicontinuidad estocástica tiene que ser utilizado.

Sesgo versus coherencia

imparciales pero no consistentes

Un estimador puede ser imparcial pero no consistente. Por ejemplo, para una muestra de iid {x

1,..., x

n} se puede usar T

n(X) = x

n como estimador de la media E[X]. Tenga en cuenta que aquí la distribución de muestreo de T

n es la misma que la distribución subyacente (para cualquier n, ya que ignora todos los puntos menos el último), por lo que E[T

n(X)] = E[X] y es imparcial, pero no converge a ningún valor.

Sin embargo, si una secuencia de estimadores es insesgada y converge a un valor, entonces es consistente, ya que debe converger al valor correcto.

Sesgada pero consistente

(feminine)Alternativamente, un estimador puede ser parcial pero consistente. Por ejemplo, si el medio es estimado por 1n. . xi+1n{displaystyle {1 over n}sum x_{i}+{1 over n} es parcial, pero como n→ → JUEGO JUEGO {displaystyle nrightarrow infty}, se acerca al valor correcto, y por lo tanto es consistente.

Ejemplos importantes incluyen la variación de muestra y la desviación estándar de muestra. Sin la corrección de Bessel (es decir, al utilizar el tamaño de la muestra n{displaystyle n} en lugar de los grados de libertad n− − 1{displaystyle n-1}), estos son ambos factores negativomente sesgados pero consistentes estimadores. Con la corrección, la varianza de muestra corregida es imparcial, mientras que la desviación estándar de la muestra corregida sigue siendo parcial, pero menos así, y ambos siguen siendo consistentes: el factor de corrección converge a 1 a medida que crece el tamaño de la muestra.

Aquí hay otro ejemplo. Vamos. Tn{displaystyle T_{n} ser una secuencia de estimadores para Silencio Silencio {displaystyle theta }.

- Pr()Tn)={}1− − 1/n,si Tn=Silencio Silencio 1/n,si Tn=nδ δ +Silencio Silencio {displaystyle Pr(T_{n})={begin{cases}1-1/n, adult{mbox{if ♪♪♪ \1/n, paciente{mbox{if },T_{n}=ndelta ##########theta end{cases}}}}}

Podemos ver que Tn→pSilencio Silencio {displaystyle T_{n}{xrightarrow {p}theta }, E [Tn]=Silencio Silencio +δ δ {displaystyle operatorname {E} [T_{n]=theta +delta }, y el sesgo no converge a cero.

Contenido relacionado

Conjunto vacío

Historia de la lógica

Ley de los grandes números

![{displaystyle Pr !left[,|T_{n}-mu |geq varepsilon ,right]=Pr !left[{frac {{sqrt {n}},{big |}T_{n}-mu {big |}}{sigma }}geq {sqrt {n}}varepsilon /sigma right]=2left(1-Phi left({frac {{sqrt {n}},varepsilon }{sigma }}right)right)to 0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1427f3a9408cdda24cd8bfd6187fd3159d686ea1)

![{displaystyle Pr !{big [}h(T_{n}-theta)geq varepsilon {big ]}leq {frac {operatorname {E} {big [}h(T_{n}-theta){big ]}}{h(varepsilon)}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2f85b6918244bbc21064136cadbed4a801549fad)

![{displaystyle {frac {1}{n}}sum _{i=1}^{n}g(X_{i}) {xrightarrow {p}} operatorname {E} [,g(X),]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/10b736680a0d0837ea1290104d9acca589aa63f4)

![{displaystyle operatorname {E} [T_{n}]=theta +delta }](https://wikimedia.org/api/rest_v1/media/math/render/svg/88d36066b1ca8f168ef6c72d6650e8eedcf80d22)