Distribución exponencial

Distribución de la probabilidad

En teoría de probabilidad y estadística, la distribución exponencial es la distribución de probabilidad del tiempo entre eventos en un proceso de punto de Poisson, es decir, un proceso en el que los eventos ocurren de forma continua e independiente a una tasa promedio constante. Es un caso particular de la distribución gamma. Es el análogo continuo de la distribución geométrica y tiene la propiedad clave de no tener memoria. Además de ser utilizado para el análisis de los procesos de puntos de Poisson, se encuentra en varios otros contextos.

La distribución exponencial no es lo mismo que la clase de familias de distribuciones exponenciales. Esta es una gran clase de distribuciones de probabilidad que incluye la distribución exponencial como uno de sus miembros, pero también incluye muchas otras distribuciones, como las distribuciones normal, binomial, gamma y de Poisson.

Definiciones

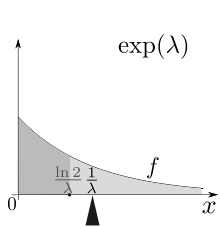

Función de densidad de probabilidad

La función de densidad de probabilidad (pdf) de una distribución exponencial es

- <math alttext="{displaystyle f(x;lambda)={begin{cases}lambda e^{-lambda x}&xgeq 0,\0&xf()x;λ λ )={}λ λ e− − λ λ xx≥ ≥ 0,0x.0.{displaystyle f(x;lambda)={begin{cases}lambda e^{-lambda x} diezxgeq 0, consiguió0.end{cases}}}}<img alt="{displaystyle f(x;lambda)={begin{cases}lambda e^{-lambda x}&xgeq 0,\0&x

Aquí λ > 0 es el parámetro de la distribución, a menudo llamado parámetro de tasa. La distribución se admite en el intervalo [0, ∞). Si una variable aleatoria X tiene esta distribución, escribimos X ~ Exp(λ).

La distribución exponencial exhibe una divisibilidad infinita.

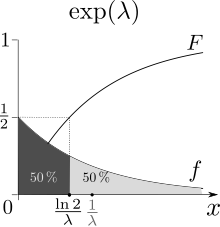

Función de distribución acumulativa

La función de distribución acumulativa viene dada por

- <math alttext="{displaystyle F(x;lambda)={begin{cases}1-e^{-lambda x}&xgeq 0,\0&xF()x;λ λ )={}1− − e− − λ λ xx≥ ≥ 0,0x.0.{displaystyle F(x;lambda)={begin{cases}1-e^{-lambda x} limitxgeq 0, consiguió0.end{cases}}<img alt="F(x;lambda) = begin{cases}

1-e^{-lambda x} & x ge 0, \

0 & x

Parametrización alternativa

La distribución exponencial a veces se parametriza en términos del parámetro de escala β = 1/λ, que también es el significado:

<math alttext="{displaystyle f(x;beta)={begin{cases}{frac {1}{beta }}e^{-x/beta }&xgeq 0,\0&x<0.end{cases}}qquad qquad F(x;beta)={begin{cases}1-e^{-x/beta }&xgeq 0,\0&xf()x;β β )={}1β β e− − x/β β x≥ ≥ 0,0x.0.F()x;β β )={}1− − e− − x/β β x≥ ≥ 0,0x.0.{fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif}}qquad qquad F(x;beta)={} {fnMicrosoft Sans Serif} {}fnMicrosoft Sans Serif} {fnMicrosoft Sans}fnMicrosoft Sans

<img alt="{displaystyle f(x;beta)={begin{cases}{frac {1}{beta }}e^{-x/beta }&xgeq 0,\0&x<0.end{cases}}qquad qquad F(x;beta)={begin{cases}1-e^{-x/beta }&xgeq 0,\0&x

Propiedades

Media, varianza, momentos y mediana

El medio es el centro de masa de probabilidad, es decir, el primer momento.

La mediana es la preimage

F−1(1/2).

El valor medio o esperado de una variable aleatoria distribuida exponencialmente X con parámetro de tasa λ viene dado por

E [X]=1λ λ .{displaystyle operatorname [X]={frac {1}{lambda }}

![{displaystyle operatorname {E} [X]={frac {1}{lambda }}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f9efa3ce3c964c59532609b3d6b8f01ce88f6221)

A la luz de los ejemplos que se dan a continuación, esto tiene sentido: si recibe llamadas telefónicas a una tasa promedio de 2 por hora, entonces puede esperar media hora por cada llamada.

La varianza de X viene dada por

Var [X]=1λ λ 2,{displaystyle operatorname [X]={frac {1}{lambda ^{2}}}

![{displaystyle operatorname {Var} [X]={frac {1}{lambda ^{2}}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3c450db5013b1cfdaf5ea71106c9d13834e02d61)

Los momentos de X, para n▪ ▪ N{displaystyle nin mathbb {N} son dados por

son dados por

E [Xn]=n!λ λ n.{displaystyle operatorname {E} left[X^{n}right]={frac {n!}{lambda ^{n}}}}}

![{displaystyle operatorname {E} left[X^{n}right]={frac {n!}{lambda ^{n}}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5f5d3a82fbcff5a294e5360fb05b1e5f2166ec09)

Los momentos centrales de X, para n▪ ▪ N{displaystyle nin mathbb {N} son dados por

son dados por

μ μ n=!nλ λ n=n!λ λ n.. k=0n()− − 1)kk!.{displaystyle mu _{n}={frac {fn} {fn} {fnK}} {fnMicroc} {n}{lambda ^{n}}sum - ¿Qué?

La mediana de X viene dada por

<math alttext="{displaystyle operatorname {m} [X]={frac {ln(2)}{lambda }}m [X]=In ()2)λ λ .E [X],{displaystyle operatorname {m} [X]={frac {ln(2)}{lambda ♪ ♪ ♪ ♪♪ {E} [X],}

<img alt="{displaystyle operatorname {m} [X]={frac {ln(2)}{lambda }}

<math alttext="{displaystyle left|operatorname {E} left[Xright]-operatorname {m} left[Xright]right|={frac {1-ln(2)}{lambda }}SilencioE [X]− − m [X]Silencio=1− − In ()2)λ λ .1λ λ =σ σ [X],{displaystyle left durableoperatorname {E} left[Xright]-operatorname {m} left[Xright]right WordPress={frac {1-ln(2)}{lambda - No. [X]

<img alt="{displaystyle left|operatorname {E} left[Xright]-operatorname {m} left[Xright]right|={frac {1-ln(2)}{lambda }}

de acuerdo con la desigualdad mediana-media.

Sin memoria

Una variable aleatoria distribuida exponencialmente T obedece a la relación

s+tmid T>sright)=Pr(T>t),qquad forall s,tgeq 0.}" display="block" xmlns="http://www.w3.org/1998/Math/MathML">Pr()T■s+t▪ ▪ T■s)=Pr()T■t),О О s,t≥ ≥ 0.{displaystyle Pr left(T confías+tmid T títulosright)=Pr(T confíat),qquad forall s,tgeq 0.}

![]()

s+tmid T>sright)=Pr(T>t),qquad forall s,tgeq 0.}" aria-hidden="true" class="mwe-math-fallback-image-display" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/1e1301db029bbd255958b4f26e872e38248b5975" style="vertical-align: -0.838ex; width:49.778ex; height:2.843ex;"/>

Esto se puede ver considerando la función de distribución acumulativa complementaria:

s+tmid T>sright)&={frac {Pr left(T>s+tcap T>sright)}{Pr left(T>sright)}}\[4pt]&={frac {Pr left(T>s+tright)}{Pr left(T>sright)}}\[4pt]&={frac {e^{-lambda (s+t)}}{e^{-lambda s}}}\[4pt]&=e^{-lambda t}\[4pt]&=Pr(T>t).end{aligned}}}" display="block" xmlns="http://www.w3.org/1998/Math/MathML">Pr()T■s+t▪ ▪ T■s)=Pr()T■s+t∩ ∩ T■s)Pr()T■s)=Pr()T■s+t)Pr()T■s)=e− − λ λ ()s+t)e− − λ λ s=e− − λ λ t=Pr()T■t).{displaystyle {begin{aligned} Pr left(T confías+tmid T tituladasright) {Prleft {fnMicrosoft Sans]}{Pr left(T títulosright)}[4pt] recur={frac {pr left(T confías+tright)}{pr left(Tr leftsright)}}[4pt] {fnMicrox} {cccccc] {fnMicrosoft Sans Serif}}[4pt] {fnMicrosoft Sans Serif}}}}[4pt]}[4pt]

![]()

s+tmid T>sright)&={frac {Pr left(T>s+tcap T>sright)}{Pr left(T>sright)}}\[4pt]&={frac {Pr left(T>s+tright)}{Pr left(T>sright)}}\[4pt]&={frac {e^{-lambda (s+t)}}{e^{-lambda s}}}\[4pt]&=e^{-lambda t}\[4pt]&=Pr(T>t).end{aligned}}}" aria-hidden="true" class="mwe-math-fallback-image-display" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/126da1213459cde98ae372eae857a18183675f5a" style="vertical-align: -14.171ex; width:49.248ex; height:29.509ex;"/>

Cuando T se interpreta como el tiempo de espera para que ocurra un evento relativo a un tiempo inicial, esta relación implica que, si T está condicionado a la falta de observación el evento durante un período de tiempo inicial s, la distribución del tiempo de espera restante es la misma que la distribución incondicional original. Por ejemplo, si un evento no ha ocurrido después de 30 segundos, la probabilidad condicional de que ocurra al menos 10 segundos más es igual a la probabilidad incondicional de observar el evento más de 10 segundos después del tiempo inicial.

La distribución exponencial y la distribución geométrica son las únicas distribuciones de probabilidad sin memoria.

La distribución exponencial es, en consecuencia, también necesariamente la única distribución de probabilidad continua que tiene una tasa de falla constante.

Cuantiles

Criterios de pavo para anomalías.

La función cuantil (función de distribución acumulativa inversa) para Exp(λ) es

<math alttext="{displaystyle F^{-1}(p;lambda)={frac {-ln(1-p)}{lambda }},qquad 0leq pF− − 1()p;λ λ )=− − In ()1− − p)λ λ ,0≤ ≤ p.1{displaystyle F^{-1}(p;lambda)={frac {-ln(1-p)}{lambda }}}}qquad 0leq p made1}

<img alt="{displaystyle F^{-1}(p;lambda)={frac {-ln(1-p)}{lambda }},qquad 0leq p

Los cuartiles son por lo tanto:

- primer cuartil: ln(4/3)/λ

- median: ln(2)/λ

- tercer cuartil: ln(4)/λ

Y como consecuencia el rango intercuartílico es ln(3)/λ.

Divergencia Kullback-Leibler

La divergencia dirigida Kullback-Leibler en nats de eλ λ {displaystyle e^{lambda } ("aproximadamente" distribución) de eλ λ 0{displaystyle e^{lambda - Sí.

("aproximadamente" distribución) de eλ λ 0{displaystyle e^{lambda - Sí. ('true' distribution) es dada por

('true' distribution) es dada por

Δ Δ ()λ λ 0∥ ∥ λ λ )=Eλ λ 0()log pλ λ 0()x)pλ λ ()x))=Eλ λ 0()log λ λ 0eλ λ 0xλ λ eλ λ x)=log ()λ λ 0)− − log ()λ λ )− − ()λ λ 0− − λ λ )Eλ λ 0()x)=log ()λ λ 0)− − log ()λ λ )+λ λ λ λ 0− − 1.{displaystyle {begin{aligned}Delta (lambda _{0}parallel lambda) {fnMicrosoft Sans Serif} ¿Por qué? {p_{lambda _{0}}(x)}{p_{lambda }right)=mathbb {fnMicrosoft Sans Serif} ¿Por qué? {fnMicrode ¿Qué? ¿Por qué? ♫{lambda - ¿Qué?

Distribución máxima de entropía

Entre todas las distribuciones de probabilidad continuas con soporte [0, ∞) y media μ, la distribución exponencial con λ = 1/μ tiene la mayor entropía diferencial. En otras palabras, es la distribución de probabilidad de máxima entropía para un variable aleatorio X que es mayor o igual a cero y para el cual E[X] es fijo.

Distribución del mínimo de variables aleatorias exponenciales

Sean X1, …, Xn independientes distribuidos exponencialmente variables aleatorias con parámetros de tasa λ1, …, λn. Después

min{}X1,...... ,Xn}{displaystyle min left{X_{1},dotscX_{n}rightright}

λ λ =λ λ 1+⋯ ⋯ +λ λ n.{displaystyle lambda =lambda - ¿Qué? +lambda _{n}

Esto se puede ver considerando la función de distribución acumulativa complementaria:

xright)\={}&Pr left(X_{1}>x,dotscX_{n}>xright)\={}&prod _{i=1}^{n}Pr left(X_{i}>xright)\={}&prod _{i=1}^{n}exp left(-xlambda _{i}right)=exp left(-xsum _{i=1}^{n}lambda _{i}right).end{aligned}}}" display="block" xmlns="http://www.w3.org/1998/Math/MathML">Pr()min{}X1,...... ,Xn}■x)=Pr()X1■x,...... ,Xn■x)=∏ ∏ i=1nPr()Xi■x)=∏ ∏ i=1nexp ()− − xλ λ i)=exp ()− − x.. i=1nλ λ i).{displaystyle {begin{aligned} limitPr left(min{X_{1},dotscX_{n}}}={} {\\\\\\\\\mc]\\\\\\\cH3cH0}]\\cH0}cH0}\\cH3cH004cH009cH004cH004cH3cH00cH00cH004cH00}cH004cH004cH004cH004cH004\\\cH004cH004cH004cH004cH004cH004cH004cH004cH00cH004cH004cH004cH004\ ¿Qué? Pr left(X_{i} títuloxright)={} ################################################################################################################################################################################################################################################################ ¿Por qué? ################################################################################################################################################################################################################################################################ - Bien.

![]()

xright)\={}&Pr left(X_{1}>x,dotscX_{n}>xright)\={}&prod _{i=1}^{n}Pr left(X_{i}>xright)\={}&prod _{i=1}^{n}exp left(-xlambda _{i}right)=exp left(-xsum _{i=1}^{n}lambda _{i}right).end{aligned}}}" aria-hidden="true" class="mwe-math-fallback-image-display" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/03422d2212dc52e00798f1dea70c74d394a3e2b1" style="vertical-align: -9.838ex; width:38.004ex; height:20.843ex;"/>

El índice de la variable que alcanza el mínimo se distribuye según la distribución categórica

Pr()Xk=min{}X1,...... ,Xn})=λ λ kλ λ 1+⋯ ⋯ +λ λ n.{displaystyle Pr left(X_{k}=min{X_{1},dotscX_{n}right)={frac Lambda. - ¿Qué? +lambda - Sí.

Una prueba puede ser vista por dejar I=argmini▪ ▪ {}1,⋯ ⋯ ,n} {}X1,...... ,Xn}{displaystyle I=operatorname {argmin} _{iin {1,dot s ¿Qué? . Entonces,

. Entonces,

x),dx\&=int _{0}^{infty }lambda _{k}e^{-lambda _{k}x}left(prod _{i=1,ineq k}^{n}e^{-lambda _{i}x}right)dx\&=lambda _{k}int _{0}^{infty }e^{-left(lambda _{1}+dotsb +lambda _{n}right)x}dx\&={frac {lambda _{k}}{lambda _{1}+dotsb +lambda _{n}}}.end{aligned}}}" display="block" xmlns="http://www.w3.org/1998/Math/MathML">Pr()I=k)=∫ ∫ 0JUEGO JUEGO Pr()Xk=x)Pr()О О iل ل kXi■x)dx=∫ ∫ 0JUEGO JUEGO λ λ ke− − λ λ kx()∏ ∏ i=1,iل ل kne− − λ λ ix)dx=λ λ k∫ ∫ 0JUEGO JUEGO e− − ()λ λ 1+⋯ ⋯ +λ λ n)xdx=λ λ kλ λ 1+⋯ ⋯ +λ λ n.{displaystyle {begin{aligned}Pr(I=k) ################################################################################################################################################################################################################################################################ ¿Qué? ¿Qué? ¿Por qué? ¿Por qué? ¿Qué? _{1}+dotsb +lambda ¿Por qué? - ¿Qué? "Lambda"

![]()

x),dx\&=int _{0}^{infty }lambda _{k}e^{-lambda _{k}x}left(prod _{i=1,ineq k}^{n}e^{-lambda _{i}x}right)dx\&=lambda _{k}int _{0}^{infty }e^{-left(lambda _{1}+dotsb +lambda _{n}right)x}dx\&={frac {lambda _{k}}{lambda _{1}+dotsb +lambda _{n}}}.end{aligned}}}" aria-hidden="true" class="mwe-math-fallback-image-display" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/93fc47b45174ef5cda3207486f4e47e39ece1763" style="vertical-align: -12.338ex; width:49.109ex; height:25.843ex;"/>

Tenga en cuenta que

max{}X1,...... ,Xn}{displaystyle max{X_{1},dotscX_{n}}}

Momentos conjuntos de i.i.d. estadísticas de orden exponencial

Vamos X1,...... ,Xn{displaystyle X_{1},dotscX_{n} Ser n{displaystyle n}

Ser n{displaystyle n} variables exponenciales aleatorias independientes y distribuidas idénticamente con parámetro de tasa λ.

Vamos X()1),...... ,X()n){displaystyle X_{(1)},dotscX_{(n)}

variables exponenciales aleatorias independientes y distribuidas idénticamente con parámetro de tasa λ.

Vamos X()1),...... ,X()n){displaystyle X_{(1)},dotscX_{(n)} denota las estadísticas correspondientes del orden.

Para <math alttext="{displaystyle ii.j{displaystyle i donej}<img alt="i el momento conjunto E [X()i)X()j)]{displaystyle operatorname {E} left[X_{(i)}X_{(j)}right]}

denota las estadísticas correspondientes del orden.

Para <math alttext="{displaystyle ii.j{displaystyle i donej}<img alt="i el momento conjunto E [X()i)X()j)]{displaystyle operatorname {E} left[X_{(i)}X_{(j)}right]}![{displaystyle operatorname {E} left[X_{(i)}X_{(j)}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7d350557a602c2566c092558fff0aefb0049c7c9) de las estadísticas del orden X()i){displaystyle X_{(i)}

de las estadísticas del orden X()i){displaystyle X_{(i)} y X()j){displaystyle X_{(j)}}

y X()j){displaystyle X_{(j)}} es dado por

es dado por

E [X()i)X()j)]=.. k=0j− − 11()n− − k)λ λ E [X()i)]+E [X()i)2]=.. k=0j− − 11()n− − k)λ λ .. k=0i− − 11()n− − k)λ λ +.. k=0i− − 11()()n− − k)λ λ )2+().. k=0i− − 11()n− − k)λ λ )2.{displaystyle {begin{aligned}operatorname {E} left[X_{(i)}X_{(j)}right=sum ¿Por qué? {1}{(n-k)lambda ♪ ♪ ♪ ♪ ♪ Operadorname {E} left[X_{(i)}right]+operatorname {E} left[X_{(i)}^{2}right]\\bu=sum ¿Por qué? {1}{i-1}{i-1} {fn0}fn0}{i-1} {fn0}fn0} {1}{(n-k)lambda }+sum _{k=0}{i-1}{frac {1}{(n-k)lambda)}{2}}}+left(sum _{k=0}^{i-1}{frac {1}{(n-k)lambda }right)}{2}end{aligned}}}}}}}}}}}}} {1}{2}{y)} {}}}} {}}} {}}}}}}}} {f}}}}} {f}}}}} {f}} {f}} {f}}}}} {f}}}}}}}}}}}}}}}}}}}}} {f}}} {f} {f}} {f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {f}} {f}}}}}}}}}}}}}}}}}}}}

![{displaystyle {begin{aligned}operatorname {E} left[X_{(i)}X_{(j)}right]&=sum _{k=0}^{j-1}{frac {1}{(n-k)lambda }}operatorname {E} left[X_{(i)}right]+operatorname {E} left[X_{(i)}^{2}right]\&=sum _{k=0}^{j-1}{frac {1}{(n-k)lambda }}sum _{k=0}^{i-1}{frac {1}{(n-k)lambda }}+sum _{k=0}^{i-1}{frac {1}{((n-k)lambda)^{2}}}+left(sum _{k=0}^{i-1}{frac {1}{(n-k)lambda }}right)^{2}.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0135f144a56c4b7565f7faa61cc3abb42afe9c0d)

Esto se puede ver invocando la ley de expectativa total y la propiedad sin memoria:

E [X()i)X()j)]=∫ ∫ 0JUEGO JUEGO E [X()i)X()j)▪ ▪ X()i)=x]fX()i)()x)dx=∫ ∫ x=0JUEGO JUEGO xE [X()j)▪ ▪ X()j)≥ ≥ x]fX()i)()x)dx()desde entoncesX()i)=x⟹ ⟹ X()j)≥ ≥ x)=∫ ∫ x=0JUEGO JUEGO x[E [X()j)]+x]fX()i)()x)dx()por la propiedad sin memoria)=.. k=0j− − 11()n− − k)λ λ E [X()i)]+E [X()i)2].{displaystyle {begin{aligned}operatorname {E} left[X_{(i)}X_{(j)}right=int - ¿Qué? {E} left[X_{(i)}X_{(j)}mid X_{(i)}=xright]f_{X_{(i)}}(x)},dx\\\ limit=int ################################################################################################################################################################################################################################################################ {E} left[X_{(j)}mid X_{(j)}geq xright]f_{X_{(i)}(x)},dx ventajaleft({textrm {since}~X_{(i)}=ximplies X_{(j)}geq xright)\\q]\\\\cH0cH00}cH00}cH00}cH00}fnMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMinMientras, mientras ¿Por qué? {E} left[X_{(j)}right]+xright]f_{X_{(i)}(x),dx limitándoseleft({text{by the memoryless property}}right)\iii=sum ¿Por qué? {1}{(n-k)lambda ♪ ♪ ♪ ♪ ♪ Operadorname {E} left[X_{(i)}right]+operatorname {E} left[X_{(i)}^{2}right].end{aligned}}

![{displaystyle {begin{aligned}operatorname {E} left[X_{(i)}X_{(j)}right]&=int _{0}^{infty }operatorname {E} left[X_{(i)}X_{(j)}mid X_{(i)}=xright]f_{X_{(i)}}(x),dx\&=int _{x=0}^{infty }xoperatorname {E} left[X_{(j)}mid X_{(j)}geq xright]f_{X_{(i)}}(x),dx&&left({textrm {since}}~X_{(i)}=ximplies X_{(j)}geq xright)\&=int _{x=0}^{infty }xleft[operatorname {E} left[X_{(j)}right]+xright]f_{X_{(i)}}(x),dx&&left({text{by the memoryless property}}right)\&=sum _{k=0}^{j-1}{frac {1}{(n-k)lambda }}operatorname {E} left[X_{(i)}right]+operatorname {E} left[X_{(i)}^{2}right].end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/be5949313f3639a86ac81484ac8ca7f4f9edb4d4)

La primera ecuación se deriva de la ley de la expectativa total.

La segunda ecuación explota el hecho de que una vez que condicionamos X()i)=x{displaystyle X_{(i)}=x} , debe seguir eso X()j)≥ ≥ x{displaystyle X_{(j)}geq x}

, debe seguir eso X()j)≥ ≥ x{displaystyle X_{(j)}geq x} . La tercera ecuación depende de la propiedad sin memoria para reemplazar E [X()j)▪ ▪ X()j)≥ ≥ x]{displaystyle operatorname {E} left[X_{(j)}mid X_{(j)}geq xright]}

. La tercera ecuación depende de la propiedad sin memoria para reemplazar E [X()j)▪ ▪ X()j)≥ ≥ x]{displaystyle operatorname {E} left[X_{(j)}mid X_{(j)}geq xright]}![{displaystyle operatorname {E} left[X_{(j)}mid X_{(j)}geq xright]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/00169b33907d379235fd4561c63c13d4c51a619a) con E [X()j)]+x{displaystyle operatorname {E} left[X_{(j)}right]+x}

con E [X()j)]+x{displaystyle operatorname {E} left[X_{(j)}right]+x}![{displaystyle operatorname {E} left[X_{(j)}right]+x}](https://wikimedia.org/api/rest_v1/media/math/render/svg/775aa6cfd6c5d2b1e4b70ce3108a17f93f7b0224) .

.

Suma de dos variables aleatorias exponenciales independientes

La función de distribución de probabilidad (PDF) de una suma de dos variables aleatorias independientes es la evolución de sus PDF individuales. Si X1{displaystyle X_{1} y X2{displaystyle X_{2}

y X2{displaystyle X_{2} son variables exponenciales independientes al azar con los respectivos parámetros de velocidad λ λ 1{displaystyle lambda ¿Qué?

son variables exponenciales independientes al azar con los respectivos parámetros de velocidad λ λ 1{displaystyle lambda ¿Qué? y λ λ 2,{displaystyle lambda _{2},}

y λ λ 2,{displaystyle lambda _{2},} entonces la densidad de probabilidad de Z=X1+X2{displaystyle Z=X_{1}+X_{2}

entonces la densidad de probabilidad de Z=X1+X2{displaystyle Z=X_{1}+X_{2} es dado por

es dado por

fZ()z)=∫ ∫ − − JUEGO JUEGO JUEGO JUEGO fX1()x1)fX2()z− − x1)dx1=∫ ∫ 0zλ λ 1e− − λ λ 1x1λ λ 2e− − λ λ 2()z− − x1)dx1=λ λ 1λ λ 2e− − λ λ 2z∫ ∫ 0ze()λ λ 2− − λ λ 1)x1dx1={}λ λ 1λ λ 2λ λ 2− − λ λ 1()e− − λ λ 1z− − e− − λ λ 2z)siλ λ 1ل ل λ λ 2λ λ 2ze− − λ λ zsiλ λ 1=λ λ 2=λ λ .{displaystyle {begin{aligned}f_{Z}(z) limit=int _{-infty }{infty }f_{X_{1}(x_{1})f_{X_{2}(z-x_{1},dx_{1}\\=int ¿Qué? - ¿Qué? # Lambda # ¿Por qué? "Lambda" ¿Qué? - ¿Qué? ¿Qué? ¿Qué? ################################################################################################################################################################################################################################################################ {lambda _{1}lambda ¿Qué? ¿Qué? ¿Qué? ################################################################################################################################################################################################################################################################ - ¿Qué? ################################################################################################################################################################################################################################################################ ¿Qué?

![{displaystyle {begin{aligned}f_{Z}(z)&=int _{-infty }^{infty }f_{X_{1}}(x_{1})f_{X_{2}}(z-x_{1}),dx_{1}\&=int _{0}^{z}lambda _{1}e^{-lambda _{1}x_{1}}lambda _{2}e^{-lambda _{2}(z-x_{1})},dx_{1}\&=lambda _{1}lambda _{2}e^{-lambda _{2}z}int _{0}^{z}e^{(lambda _{2}-lambda _{1})x_{1}},dx_{1}\&={begin{cases}{dfrac {lambda _{1}lambda _{2}}{lambda _{2}-lambda _{1}}}left(e^{-lambda _{1}z}-e^{-lambda _{2}z}right)&{text{ if }}lambda _{1}neq lambda _{2}\[4pt]lambda ^{2}ze^{-lambda z}&{text{ if }}lambda _{1}=lambda _{2}=lambda.end{cases}}end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c2db15dda49fe8482485a68c9d7c9b1c1d46ee95)

![]() lambda _{2}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/3dc9ff31d5f3eff2381c8822914675d766c09771" style="vertical-align: -0.671ex; width:7.917ex; height:2.509ex;"/>

lambda _{2}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/3dc9ff31d5f3eff2381c8822914675d766c09771" style="vertical-align: -0.671ex; width:7.917ex; height:2.509ex;"/>H()Z)=1+γ γ +In ()λ λ 1− − λ λ 2λ λ 1λ λ 2)+↑ ↑ ()λ λ 1λ λ 1− − λ λ 2),{displaystyle {begin{aligned}H(Z) +ln left({frac {lambda ¿Qué? ¿Qué? "Lambda" ##########psileft({frac {lambda ¿Qué? ¿Por qué?

↑ ↑ ()⋅ ⋅ ){displaystyle psi (cdot)}

↑ ↑ ()⋅ ⋅ ){displaystyle psi (cdot)}

En el caso de parámetros de igual tasa, el resultado es una distribución de Erlang con forma 2 y parámetro λ λ ,{displaystyle lambda} que a su vez es un caso especial de distribución gamma.

que a su vez es un caso especial de distribución gamma.

Distribuciones relacionadas

- If X ~ Laplace(μ, β−1), then |X − μ| ~ Exp(β).

- If X ~ Pareto(1, λ), then log(X) ~ Exp(λ).

- If X ~ SkewLogistic(θ), then

log

(

1

+

e

−

X

)

∼

Exp

(

θ

)

{displaystyle log left(1+e^{-X}right)sim operatorname {Exp} (theta)}

.

.

- If Xi ~ U(0, 1) then

lim

n

→

∞

n

min

(

X

1

,

…

,

X

n

)

∼

Exp

(

1

)

{displaystyle lim _{nto infty }nmin left(X_{1},ldotsX_{n}right)sim operatorname {Exp} (1)}

- The exponential distribution is a limit of a scaled beta distribution:

lim

n

→

∞

n

Beta

(

1

,

n

)

=

Exp

(

1

)

.

{displaystyle lim _{nto infty }noperatorname {Beta} (1,n)=operatorname {Exp} (1).}

- Exponential distribution is a special case of type 3 Pearson distribution.

- If X ~ Exp(λ) and Xi ~ Exp(λi) then:

-

k

X

∼

Exp

(

λ

k

)

{displaystyle kXsim operatorname {Exp} left({frac {lambda }{k}}right)}

, closure under scaling by a positive factor.

, closure under scaling by a positive factor.

- 1 + X ~ BenktanderWeibull(λ, 1), which reduces to a truncated exponential distribution.

- keX ~ Pareto(k, λ).

- e−X ~ Beta(λ, 1).

- 1/keX ~ PowerLaw(k, λ)

-

X

∼

Rayleigh

(

1

2

λ

)

{displaystyle {sqrt {X}}sim operatorname {Rayleigh} left({frac {1}{sqrt {2lambda }}}right)}

, the Rayleigh distribution

, the Rayleigh distribution

-

X

∼

Weibull

(

1

λ

,

1

)

{displaystyle Xsim operatorname {Weibull} left({frac {1}{lambda }},1right)}

, the Weibull distribution

, the Weibull distribution

-

X

2

∼

Weibull

(

1

λ

2

,

1

2

)

{displaystyle X^{2}sim operatorname {Weibull} left({frac {1}{lambda ^{2}}},{frac {1}{2}}right)}

- μ − β log(λX) ∼ Gumbel(μ, β).

-

⌊

X

⌋

∼

Geometric

(

1

−

e

−

λ

)

{displaystyle lfloor Xrfloor sim operatorname {Geometric} left(1-e^{-lambda }right)}

, a geometric distribution on 0,1,2,3,...

, a geometric distribution on 0,1,2,3,...

-

⌈

X

⌉

∼

Geometric

(

1

−

e

−

λ

)

{displaystyle lceil Xrceil sim operatorname {Geometric} left(1-e^{-lambda }right)}

, a geometric distribution on 1,2,3,4,...

, a geometric distribution on 1,2,3,4,...

- If also Y ~ Erlang(n, λ) or

Y

∼

Γ

(

n

,

1

λ

)

{displaystyle Ysim Gamma left(n,{frac {1}{lambda }}right)}

then

X

Y

+

1

∼

Pareto

(

1

,

n

)

{displaystyle {frac {X}{Y}}+1sim operatorname {Pareto} (1,n)}

then

X

Y

+

1

∼

Pareto

(

1

,

n

)

{displaystyle {frac {X}{Y}}+1sim operatorname {Pareto} (1,n)}

- If also λ ~ Gamma(k, θ) (shape, scale parametrisation) then the marginal distribution of X is Lomax(k, 1/θ), the gamma mixture

- λ1X1 − λ2Y2 ~ Laplace(0, 1).

- min{X1,..., Xn} ~ Exp(λ1 +... + λn).

- If also λi = λ then:

-

X

1

+

⋯

+

X

k

=

∑

i

X

i

∼

{displaystyle X_{1}+cdots +X_{k}=sum _{i}X_{i}sim }

Erlang(k, λ) = Gamma(k, λ−1) = Gamma(k, λ) (in (k, θ) and (α, β) parametrization, respectively) with an integer shape parameter k.

Erlang(k, λ) = Gamma(k, λ−1) = Gamma(k, λ) (in (k, θ) and (α, β) parametrization, respectively) with an integer shape parameter k.

- Xi − Xj ~ Laplace(0, λ−1).

- If also Xi are independent, then:

-

X

i

X

i

+

X

j

{displaystyle {frac {X_{i}}{X_{i}+X_{j}}}}

~ U(0, 1)

~ U(0, 1)

-

Z

=

λ

i

X

i

λ

j

X

j

{displaystyle Z={frac {lambda _{i}X_{i}}{lambda _{j}X_{j}}}}

has probability density function

f

Z

(

z

)

=

1

(

z

+

1

)

2

{displaystyle f_{Z}(z)={frac {1}{(z+1)^{2}}}}

has probability density function

f

Z

(

z

)

=

1

(

z

+

1

)

2

{displaystyle f_{Z}(z)={frac {1}{(z+1)^{2}}}}

. This can be used to obtain a confidence interval for

λ

i

λ

j

{displaystyle {frac {lambda _{i}}{lambda _{j}}}}

. This can be used to obtain a confidence interval for

λ

i

λ

j

{displaystyle {frac {lambda _{i}}{lambda _{j}}}}

.

.

- If also λ = 1:

-

μ

−

β

log

(

e

−

X

1

−

e

−

X

)

∼

Logistic

(

μ

,

β

)

{displaystyle mu -beta log left({frac {e^{-X}}{1-e^{-X}}}right)sim operatorname {Logistic} (mubeta)}

, the logistic distribution

, the logistic distribution

-

μ

−

β

log

(

X

i

X

j

)

∼

Logistic

(

μ

,

β

)

{displaystyle mu -beta log left({frac {X_{i}}{X_{j}}}right)sim operatorname {Logistic} (mubeta)}

- μ − σ log(X) ~ GEV(μ, σ, 0).

- Further if

Y

∼

Γ

(

α

,

β

α

)

{displaystyle Ysim Gamma left(alpha{frac {beta }{alpha }}right)}

then

X

Y

∼

K

(

α

,

β

)

{displaystyle {sqrt {XY}}sim operatorname {K} (alphabeta)}

then

X

Y

∼

K

(

α

,

β

)

{displaystyle {sqrt {XY}}sim operatorname {K} (alphabeta)}

(K-distribution)

(K-distribution)

- If also λ = 1/2 then X ∼ χ2

2; i.e., X has a chi-squared distribution with 2 degrees of freedom. Hence:

Exp

(

λ

)

=

1

2

λ

Exp

(

1

2

)

∼

1

2

λ

χ

2

2

⇒

∑

i

=

1

n

Exp

(

λ

)

∼

1

2

λ

χ

2

n

2

{displaystyle operatorname {Exp} (lambda)={frac {1}{2lambda }}operatorname {Exp} left({frac {1}{2}}right)sim {frac {1}{2lambda }}chi _{2}^{2}Rightarrow sum _{i=1}^{n}operatorname {Exp} (lambda)sim {frac {1}{2lambda }}chi _{2n}^{2}}

- If

X

∼

Exp

(

1

λ

)

{displaystyle Xsim operatorname {Exp} left({frac {1}{lambda }}right)}

and

Y

∣

X

{displaystyle Ymid X}

and

Y

∣

X

{displaystyle Ymid X}

~ Poisson(X) then

Y

∼

Geometric

(

1

1

+

λ

)

{displaystyle Ysim operatorname {Geometric} left({frac {1}{1+lambda }}right)}

~ Poisson(X) then

Y

∼

Geometric

(

1

1

+

λ

)

{displaystyle Ysim operatorname {Geometric} left({frac {1}{1+lambda }}right)}

(geometric distribution)

(geometric distribution)

- The Hoyt distribution can be obtained from exponential distribution and arcsine distribution

- The exponential distribution is a limit of the κ-exponential distribution in the

κ

=

0

{displaystyle kappa =0}

case.

case.

- Exponential distribution is a limit of the κ-Generalized Gamma distribution in the

α

=

1

{displaystyle alpha =1}

and

ν

=

1

{displaystyle nu =1}

and

ν

=

1

{displaystyle nu =1}

cases:

cases:

-

lim

(

α

,

ν

)

→

(

0

,

1

)

p

κ

(

x

)

=

(

1

+

κ

ν

)

(

2

κ

)

ν

Γ

(

1

2

κ

+

ν

2

)

Γ

(

1

2

κ

−

ν

2

)

α

λ

ν

Γ

(

ν

)

x

α

ν

−

1

exp

κ

(

−

λ

x

α

)

=

λ

e

−

λ

x

{displaystyle lim _{(alphanu)to (0,1)}p_{kappa }(x)=(1+kappa nu)(2kappa)^{nu }{frac {Gamma {Big (}{frac {1}{2kappa }}+{frac {nu }{2}}{Big)}}{Gamma {Big (}{frac {1}{2kappa }}-{frac {nu }{2}}{Big)}}}{frac {alpha lambda ^{nu }}{Gamma (nu)}}x^{alpha nu -1}exp _{kappa }(-lambda x^{alpha })=lambda e^{-lambda x}}

Otras distribuciones relacionadas:

- Distribución hiper-exponencial – la distribución cuya densidad es una suma ponderada de densidades exponenciales.

- Distribución hipoexponencial – distribución de una suma general de variables aleatorias exponenciales.

- exDistribución gaussiana – la suma de una distribución exponencial y una distribución normal.

Inferencia estadística

A continuación, suponga variable aleatoria X se distribuye exponencialmente con parámetro de tasa λ, y x1,...... ,xn{displaystyle x_{1},dotscx_{n} son n muestras independientes de X, con medio de muestra x̄ ̄ {displaystyle {bar {x}}

son n muestras independientes de X, con medio de muestra x̄ ̄ {displaystyle {bar {x}} .

.

Estimación de parámetros

El estimador de máxima verosimilitud para λ se construye de la siguiente manera.

La función de verosimilitud para λ, dada una muestra independiente e idénticamente distribuida x = (x1, …, xn) extraído de la variable, es:

L()λ λ )=∏ ∏ i=1nλ λ exp ()− − λ λ xi)=λ λ nexp ()− − λ λ .. i=1nxi)=λ λ nexp ()− − λ λ nx̄ ̄ ),{displaystyle L(lambda)=prod _{i=1}lambda exp(-lambda x_{i}=lambda ^{n}exp left(-lambda sum ¿Por qué?

donde:

x̄ ̄ =1n.. i=1nxi{displaystyle {fnK}= {fn} {fnK}}} {fn}}} {fn}}} {fn} {fn}}} {fn}}}}} {fn}}}}}} {fn}}} {fn}}}}} {fnfn}}}} {fn}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {fn}}}}}}}}} {f} {f} {fn}}}}}}}}}}} {f}}}} {fn}}}}}}}}}}}}} {fn}}} {fn}}} {fn} {fn}f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} ¿Qué?

La derivada del logaritmo de la función de verosimilitud es:

0,&0<lambda <{frac {1}{overline {x}}},\[8pt]=0,&lambda ={frac {1}{overline {x}}},\[8pt]{frac {1}{overline {x}}}.end{cases}}}" display="block" xmlns="http://www.w3.org/1998/Math/MathML">ddλ λ In L()λ λ )=ddλ λ ()nIn λ λ − − λ λ nx̄ ̄ )=nλ λ − − nx̄ ̄ {}■0,0.λ λ .1x̄ ̄ ,=0,λ λ =1x̄ ̄ ,.0,λ λ ■1x̄ ̄ .{displaystyle {frac}{dlambda ¿Qué? }left(nln lambda - 'lambda n{overline {x}right)={frac {n}{lambda }-n{overline {x} {begin{cases}}}}[8pt]=0, implicalambda ={frac {1}{overline {x}}}}}}\[8pt]=0, implicalambda ={frac {1}{overline {x}}}[8pt]se0, {fnMicroc}{}} {f}} {f}}}}}}}}}\\\\\fnMicroc}}}}}}}}}}}\\\\\\\\\cH00}}}}}}\\\\\\\\\\cH00}}}\\\\cH00}}\\\\\\cH00}}cH00}}\\\\\cH00}}}}\cH

![]()

0,&0<lambda <{frac {1}{overline {x}}},\[8pt]=0,&lambda ={frac {1}{overline {x}}},\[8pt]{frac {1}{overline {x}}}.end{cases}}}" aria-hidden="true" class="mwe-math-fallback-image-display" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/65ec59bc9ccff1952291621e3eccc741ee1341a2" style="vertical-align: -7.005ex; width:64.292ex; height:15.176ex;"/>

En consecuencia, la estimación de máxima verosimilitud para el parámetro de tasa es:

λ λ ^ ^ mle=1x̄ ̄ =n.. ixi{displaystyle {widehat {lambda }_{text{mle}={frac {1}{overline {x}={frac {n} {fn} {fn}} {fn}}} {fn}} {fn}} {fn}}} {fn}} {fn}}}}} {fn} {fn}}}} {fn}}} {fnfnfn}}}}} {f}}}}}}} {f}}}}} {fnfnfnfnfnfnfnfnfnfnfnfnfnfnfnf}}}fnfnfnfnfnfnfn}fnfnfnfnfnfnfnfnfn}fnfn}fn}fnfnfnfnKfnfn}}}}}}fn - Sí.

Esto es no un estimador imparcial de λ λ ,{displaystyle lambda} aunque x̄ ̄ {displaystyle {overline {x}}}

aunque x̄ ̄ {displaystyle {overline {x}}} es un estimador imparcial de MLE 1/λ λ {displaystyle 1/lambda }

es un estimador imparcial de MLE 1/λ λ {displaystyle 1/lambda } y la distribución significa.

y la distribución significa.

El sesgo de λ λ ^ ^ mle{displaystyle {widehat {lambda } es igual a

es igual a

B↑ ↑ E [()λ λ ^ ^ mle− − λ λ )]=λ λ n− − 1{displaystyle Bequiv operatorname {E} left[left({widehat {lambda }_{text{mle}}-lambda right)right]={frac {lambda } {n-1}}

![{displaystyle Bequiv operatorname {E} left[left({widehat {lambda }}_{text{mle}}-lambda right)right]={frac {lambda }{n-1}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e6df9c9d7b6d1a8ffc31748e7cdf0cc750b442e4)

λ λ ^ ^ mleAlternativa Alternativa =λ λ ^ ^ mle− − B.{displaystyle {widehat {lambda } {text{mle} {}={widehat {fnMicrode - Sí.

Se puede encontrar un minimizador aproximado del error cuadrático medio (ver también: equilibrio entre sesgo y varianza), suponiendo un tamaño de muestra mayor que dos, con un factor de corrección para el MLE:

λ λ ^ ^ =()n− − 2n)()1x̄ ̄ )=n− − 2.. ixi{displaystyle {widehat {lambda {fnK}fn} {fn}n}n}}}mfn} {fn2}fn} {fn2}} {fn2} {fn2}}}}fn2}}}}}m}= {fn2} {fn2} {fn}} {fnfn}} {fnfn}}}}fn}}}}}fn}}}fnfnfnfnfnfn}}fnfnfnfnfnfnfnfnfn}}}fnfn}}fn}fn}fn}fn}fn}fnfn}fn}}fn}fn}fn}}fnfn}}fn}}}fn}}}}}}}}} - Sí.

Información del pescador

La información Fisher, denotada I()λ λ ){displaystyle {mathcal {}}(lambda)} , para un estimador del parámetro de tasa λ λ {displaystyle lambda }

, para un estimador del parámetro de tasa λ λ {displaystyle lambda } se da como:

se da como:

I()λ λ )=E [()∂ ∂ ∂ ∂ λ λ log f()x;λ λ ))2Silencioλ λ ]=∫ ∫ ()∂ ∂ ∂ ∂ λ λ log f()x;λ λ ))2f()x;λ λ )dx{fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {f} {fnMicros {fnMicrosoft}fnMicros}fnMicros}cccH00} {ccHFF}ccH00}cH00}ccH0}ccH00}ccccH00}cccccH00}cccH00}cH00}ccH00}cH00cH00}cH00}ccccH00}cH00cH00}cH00}ccH00}cH00cH00cH00}cH00}ccH00}cH00cccH00cH00cH00}cccH

![{displaystyle {mathcal {I}}(lambda)=operatorname {E} left[left.left({frac {partial }{partial lambda }}log f(x;lambda)right)^{2}right|lambda right]=int left({frac {partial }{partial lambda }}log f(x;lambda)right)^{2}f(x;lambda),dx}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2c70bd835b54bb1b7f344dbf1f04d170bd1d4852)

Conectando la distribución y resolviendo da:

I()λ λ )=∫ ∫ 0JUEGO JUEGO ()∂ ∂ ∂ ∂ λ λ log λ λ e− − λ λ x)2λ λ e− − λ λ xdx=∫ ∫ 0JUEGO JUEGO ()1λ λ − − x)2λ λ e− − λ λ xdx=λ λ − − 2.{displaystyle {mathcal {}(lambda)=int _{0}infty }left({frac {partial }{partial lambda }log lambda e^{-lambda x}right)^{2}lambda e^{-lambda x},dx=int ¿Qué? }-xright)}lambda e^{-lambda x},dx=lambda ^{-2}

Esto determina la cantidad de información que cada muestra independiente de una distribución exponencial lleva alrededor del parámetro de tasa desconocida λ λ {displaystyle lambda } .

.

Intervalos de confianza

El intervalo de confianza de 100(1 − α)% para el parámetro de tasa de una distribución exponencial viene dado por:

<math alttext="{displaystyle {frac {2n}{{widehat {lambda }}chi _{1-{frac {alpha }{2}},2n}^{2}}}<{frac {1}{lambda }}2nλ λ ^ ^ χ χ 1− − α α 2,2n2.1λ λ .2nλ λ ^ ^ χ χ α α 2,2n2{fnMicroc} {2n}{widehat {lambda} }chi _{1-{frac {alpha - ¿Qué? ♪♪♪ {2n}{widehat {lambda} }chi _{frac {fnMicrosoft} - ¿Qué?

<img alt="{displaystyle {frac {2n}{{widehat {lambda }}chi _{1-{frac {alpha }{2}},2n}^{2}}}<{frac {1}{lambda }}

<math alttext="{displaystyle {frac {2n{overline {x}}}{chi _{1-{frac {alpha }{2}},2n}^{2}}}<{frac {1}{lambda }}2nx̄ ̄ χ χ 1− − α α 2,2n2.1λ λ .2nx̄ ̄ χ χ α α 2,2n2{displaystyle {frac {2n{overline {x}{chi} _{1-{frac {fnMicrosoft} - ¿Qué? ♪♪♪ {2n{overline {x}{chi} - ¿Qué? {fnMicrosoft} - ¿Qué?

<img alt="{displaystyle {frac {2n{overline {x}}}{chi _{1-{frac {alpha }{2}},2n}^{2}}}<{frac {1}{lambda }}

p,v100(p)vχ2

p,vλ λ inferior=λ λ ^ ^ ()1− − 1.96n)λ λ superior=λ λ ^ ^ ()1+1.96n){displaystyle {begin{aligned}lambda ### {text{lower} {lambda}left(1-{frac {1.96}{sqrt {n}}right)\lambda ################################################################################################################################################################################################################################################################

Esta aproximación puede ser aceptable para muestras que contengan al menos 15 a 20 elementos.

Inferencia bayesiana

El conjugado previo de la distribución exponencial es la distribución gamma (de la cual la distribución exponencial es un caso especial). La siguiente parametrización de la función de densidad de probabilidad gamma es útil:

Gamma ()λ λ ;α α ,β β )=β β α α .. ()α α )λ λ α α − − 1exp ()− − λ λ β β ).{displaystyle operatorname {Gamma} (lambda;alphabeta)={frac {beta ^{alpha }{Gamma (alpha)}lambda ^{alpha -1}exp(-lambda beta).}

La distribución posterior p se puede expresar en términos de la función de probabilidad definida anteriormente y una gamma previa:

p()λ λ )∝ ∝ L()λ λ ).. ()λ λ ;α α ,β β )=λ λ nexp ()− − λ λ nx̄ ̄ )β β α α .. ()α α )λ λ α α − − 1exp ()− − λ λ β β )∝ ∝ λ λ ()α α +n)− − 1exp ()− − λ λ ()β β +nx̄ ̄ )).{displaystyle {begin{aligned}p(lambda) limitepropto L(lambda)Gamma (lambda;alphabeta)\\\lambda ^{n}expleft(-lambda n{overline {x}}right){frac {beta] ^{alpha {}}{Gamma (alpha)}}lambda ^{alpha -1}exp(-lambda beta)\\\propto lambda ^{(alpha +n)-1}exp(-lambda left(beta +n{overline {x}right)}end{aligned}}}}}}}}}}}}}}}}}}}}{

Ahora se ha especificado la densidad posterior p hasta una constante de normalización faltante. Dado que tiene la forma de un pdf gamma, esto se puede completar fácilmente y se obtiene:

p()λ λ )=Gamma ()λ λ ;α α +n,β β +nx̄ ̄ ).{displaystyle p(lambda)=operatorname {Gamma} (lambda;alpha +n,beta +n{overline {x}).}

Aquí, el hiperparámetro α se puede interpretar como el número de observaciones anteriores y β como la suma de las observaciones anteriores.

La media posterior aquí es:

α α +nβ β +nx̄ ̄ .{fnMicroc {fnMicrosoft {fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\\fnMicrosoft {\\fnMicrosoft {\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\ ## ## ## ## ## ## ### ################################################################################################################################################################################################################################################# +n{overline.

Ocurrencia y aplicaciones

Ocurrencia de eventos

La distribución exponencial ocurre naturalmente cuando se describe la duración de los tiempos entre llegadas en un proceso de Poisson homogéneo.

La distribución exponencial puede verse como una contraparte continua de la distribución geométrica, que describe el número de ensayos de Bernoulli necesarios para que un proceso discreto cambie de estado. Por el contrario, la distribución exponencial describe el tiempo que tarda un proceso continuo en cambiar de estado.

En escenarios del mundo real, la suposición de una tasa constante (o probabilidad por unidad de tiempo) rara vez se cumple. Por ejemplo, la tasa de llamadas telefónicas entrantes difiere según la hora del día. Pero si nos enfocamos en un intervalo de tiempo durante el cual la tasa es más o menos constante, como de 2 a 4 p.m. durante los días laborales, la distribución exponencial se puede utilizar como un buen modelo aproximado para el tiempo hasta que llegue la próxima llamada telefónica. Se aplican advertencias similares a los siguientes ejemplos que producen variables distribuidas aproximadamente exponencialmente:

- El tiempo hasta que una partícula radiactiva decae, o el tiempo entre los clics de un contador Geiger

- El tiempo que tarda antes de su próxima llamada telefónica

- El tiempo hasta el incumplimiento (en pago a los titulares de deuda de la empresa) en el modelado de riesgo de crédito de forma reducida

Las variables exponenciales también se pueden usar para modelar situaciones en las que ciertos eventos ocurren con una probabilidad constante por unidad de longitud, como la distancia entre mutaciones en una hebra de ADN o entre atropellos en una carretera determinada.

En la teoría de las colas, los tiempos de servicio de los agentes en un sistema (por ejemplo, cuánto tarda un cajero bancario, etc. en atender a un cliente) a menudo se modelan como variables distribuidas exponencialmente. (La llegada de clientes, por ejemplo, también está modelada por la distribución de Poisson si las llegadas son independientes y se distribuyen de manera idéntica). La duración de un proceso que puede considerarse como una secuencia de varias tareas independientes sigue la distribución de Erlang (que es la distribución de la suma de varias variables independientes distribuidas exponencialmente).

La teoría de la confiabilidad y la ingeniería de confiabilidad también hacen un uso extensivo de la distribución exponencial. Debido a la propiedad memoryless de esta distribución, es adecuada para modelar la porción de tasa de riesgo constante de la curva de la bañera utilizada en la teoría de confiabilidad. También es muy conveniente porque es muy fácil agregar tasas de falla en un modelo de confiabilidad. Sin embargo, la distribución exponencial no es apropiada para modelar la vida útil general de organismos o dispositivos técnicos, porque las "tasas de falla" aquí no son constantes: ocurren más fallas para sistemas muy jóvenes y para sistemas muy antiguos.

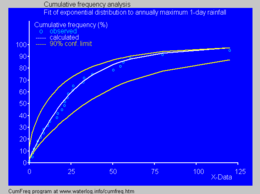

Distribución exponencial acumulativa ajustada a las precipitaciones máximas anuales de 1 día utilizando CumFreq

En física, si observa un gas a una temperatura y presión fijas en un campo gravitacional uniforme, las alturas de las distintas moléculas también siguen una distribución exponencial aproximada, conocida como fórmula barométrica. Esto es una consecuencia de la propiedad de entropía que se menciona a continuación.

En hidrología, la distribución exponencial se utiliza para analizar valores extremos de variables tales como valores máximos mensuales y anuales de lluvia diaria y volúmenes de descarga de ríos.

- El cuadro azul ilustra un ejemplo de equiparar la distribución exponencial para clasificar anualmente las precipitaciones máximas de un día mostrando también el cinturón de confianza del 90% basado en la distribución binomio. Los datos de precipitaciones están representados por posiciones de trama como parte del análisis de frecuencia acumulativa.

En la gestión de quirófanos, la distribución de la duración de la cirugía para una categoría de cirugías sin un contenido de trabajo típico (como en una sala de emergencias, englobando todo tipo de cirugías).

Predicción

Habiendo observado una muestra de n puntos de datos de una distribución exponencial desconocida, una tarea común es usar estas muestras para hacer predicciones sobre datos futuros de la misma fuente. Una distribución predictiva común sobre muestras futuras es la llamada distribución de complemento, formada al conectar una estimación adecuada para el parámetro de velocidad λ en la función de densidad exponencial. Una opción común de estimación es la proporcionada por el principio de máxima verosimilitud, y su uso produce la densidad predictiva sobre una muestra futura xn+1, condicionado a las muestras observadas x = (x1,..., xn) dado por

pML()xn+1▪ ▪ x1,...... ,xn)=()1x̄ ̄ )exp ()− − xn+1x̄ ̄ ){displaystyle p_{rm {}}(x_{n+1}mid x_{1},ldotsx_{n})=left({frac {1}{overline {x}}right)expleft(-{frac {frac}{frac}{n0}}}right) {x_{n+1}{overline {x}}right)}

El enfoque bayesiano proporciona una distribución predictiva que tiene en cuenta la incertidumbre del parámetro estimado, aunque esto puede depender de forma crucial de la elección de la distribución previa.

Una distribución predictiva libre de los problemas de elección de priores que surgen bajo el enfoque subjetivo bayesiano es

pCNML()xn+1▪ ▪ x1,...... ,xn)=nn+1()x̄ ̄ )n()nx̄ ̄ +xn+1)n+1,{fn+1}mid x_{1},ldotsx_{n}={nfn}={frac {nn1}left({overline {x}right)}{n}{n}{n}{n}{n}{n}n}{n{n{n{n}n}n}n}n}n}n}n}n}n}n}}n}}}}}}}}}}}}}}}m}{m}}}}m}}}}}}}}}}{m}{m}{m}{m} {m}}}m} {m}m}{m} {m}}m}}}}}}}}}}}}}m}{m}m}{m}m} {m}}}}}m}}}} {x}+x_{n+1}right)} {n+1}}}}

que se puede considerar como

- una distribución de confianza frecuente, obtenida de la distribución de la cantidad pivotal xn+1/x̄ ̄ {displaystyle {x_{n+1}/{overline {x}}

;

; - una probabilidad predictiva de perfil, obtenida eliminando el parámetro λ de la probabilidad conjunta de xn+ 1 y λ por maximización;

- un objetivo Bayesian predictivo posterior distribución, obtenido utilizando los Jeffreys no-informativos antes 1/λ;

- la distribución predictiva de la probabilidad máxima normalizada condicional (CNML), a partir de consideraciones teóricas de información.

La precisión de una distribución predictiva se puede medir usando la distancia o divergencia entre la distribución exponencial real con parámetro de tasa, λ0, y la distribución predictiva basada en la muestra x. La divergencia de Kullback-Leibler es una medida libre de parametrización de uso común de la diferencia entre dos distribuciones. Si Δ(λ0||p) denota la divergencia de Kullback-Leibler entre una exponencial con parámetro de tasa λ 0 y una distribución predictiva p se puede demostrar que

Eλ λ 0 [Δ Δ ()λ λ 0∥ ∥ pML)]=↑ ↑ ()n)+1n− − 1− − log ()n)Eλ λ 0 [Δ Δ ()λ λ 0∥ ∥ pCNML)]=↑ ↑ ()n)+1n− − log ()n){displaystyle {begin{aligned}operatorname {E} _{lambda _{0}left[Delta (lambda) ################################################################################################################################################################################################################################################################ {E} _{lambda _{0}left[Delta (lambda) ################################################################################################################################################################################################################################################################

![{displaystyle {begin{aligned}operatorname {E} _{lambda _{0}}left[Delta (lambda _{0}parallel p_{rm {ML}})right]&=psi (n)+{frac {1}{n-1}}-log(n)\operatorname {E} _{lambda _{0}}left[Delta (lambda _{0}parallel p_{rm {CNML}})right]&=psi (n)+{frac {1}{n}}-log(n)end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/02702bfd262096d01f27b67eab961ff7ccb512a9)

donde se toma la expectativa con respecto a la distribución exponencial con parámetro de tasa λ0 ∈ (0, ∞), y ψ(·) es la función digamma. Está claro que la distribución predictiva de CNML es estrictamente superior a la distribución complementaria de máxima verosimilitud en términos de divergencia promedio de Kullback-Leibler para todos los tamaños de muestra n > 0.

Generación de variables aleatorias

Un método conceptualmente muy simple para generar variables exponenciales se basa en el muestreo por transformada inversa: Dada una variable aleatoria U extraída de la distribución uniforme en el intervalo unitario (0, 1), la variable

T=F− − 1()U){displaystyle T=F^{-1}(U)}

tiene una distribución exponencial, donde F−1 es la función cuantil, definida por

F− − 1()p)=− − In ()1− − p)λ λ .{displaystyle F^{-1}(p)={frac {-ln(1-p)}{lambda }}

Además, si U es uniforme en (0, 1), entonces también lo es 1 − U. Esto significa que uno puede generar variables exponenciales de la siguiente manera:

T=− − In ()U)λ λ .{displaystyle T={frac {ln(U)}{lambda }}

Knuth y Devroye analizan otros métodos para generar variables exponenciales.

También está disponible un método rápido para generar un conjunto de variables exponenciales ordenadas sin usar una rutina de clasificación.