Valores propios y vectores propios

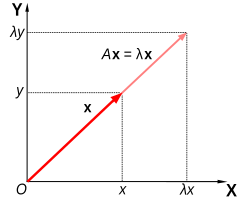

En álgebra lineal, a menudo es importante saber qué vectores tienen sus direcciones sin cambios por una transformación lineal dada. An eigenvector (EYE-grine-) o vector es un vector. Así un eigenvector v{displaystyle mathbf {v} de una transformación lineal T{displaystyle T} es escalada por un factor constante λ λ {displaystyle lambda } cuando la transformación lineal se aplica a ella: Tv=λ λ v{displaystyle Tmathbf {v} =lambda mathbf {v}. El correspondiente eigenvalue, valor característicoo raíz característica es el factor multiplicador λ λ {displaystyle lambda }.

Geométricamente, los vectores son cantidades multidimensionales con magnitud y dirección, a menudo representados como flechas. Una transformación lineal gira, estira o desgarra los vectores sobre los que actúa. Sus eigenvectores son aquellos vectores que sólo se estiran, sin rotación ni esquila. El eigenvalue correspondiente es el factor por el cual un eigenvector es estirado o aplastado. Si el eigenvalue es negativo, la dirección del eigenvector se invierte.

Los vectores propios y valores propios de una transformación sirven para caracterizarla, por lo que desempeñan papeles importantes en todas las áreas donde se aplica el álgebra lineal, desde la geología hasta la mecánica cuántica. En particular, suele darse el caso de que un sistema esté representado por una transformación lineal cuyas salidas se alimentan como entradas a las mismas entradas (retroalimentación). En tal aplicación, el valor propio más grande es de particular importancia, porque gobierna el comportamiento a largo plazo del sistema, después de muchas aplicaciones de la transformación lineal, y el vector propio asociado es el estado estacionario del sistema.

Definición

Si T es una transformación lineal de un espacio vectorial V sobre un campo F en sí mismo y v es un vector distinto de cero en V, luego v es un vector propio de T si T(v) es un múltiplo escalar de v. Esto se puede escribir como

Existe una correspondencia directa entre matrices cuadradas n-por-n y transformaciones lineales de un espacio vectorial n-dimensional en sí mismo, dada cualquier base del espacio vectorial . Por lo tanto, en un espacio vectorial de dimensión finita, es equivalente definir valores propios y vectores propios utilizando el lenguaje de matrices o el lenguaje de transformaciones lineales.

Si V es de dimensión finita, la ecuación anterior es equivalente a

donde A es la representación matricial de T y u es el vector de coordenadas de v.

Descripción general

Los valores propios y los vectores propios ocupan un lugar destacado en el análisis de transformaciones lineales. El prefijo eigen- se adopta de la palabra alemana eigen (similar a la palabra inglesa own) para 'adecuado', 'característica', 'propia'. Los valores propios y los vectores propios, originalmente utilizados para estudiar los ejes principales del movimiento de rotación de cuerpos rígidos, tienen una amplia gama de aplicaciones, por ejemplo, en análisis de estabilidad, análisis de vibraciones, orbitales atómicos, reconocimiento facial y diagonalización de matrices.

En esencia, un vector propio v de una transformación lineal T es un vector distinto de cero que, cuando se le aplica T, no cambia la direccion. La aplicación de T al vector propio solo escala el vector propio según el valor escalar λ, llamado valor propio. Esta condición se puede escribir como la ecuación

Este ejemplo, basado en la Mona Lisa, proporciona una ilustración sencilla. Cada punto de la pintura se puede representar como un vector que apunta desde el centro de la pintura hasta ese punto. La transformación lineal en este ejemplo se llama mapeo de corte. Los puntos de la mitad superior se mueven hacia la derecha y los puntos de la mitad inferior se mueven hacia la izquierda, proporcionalmente a qué tan lejos están del eje horizontal que pasa por el centro de la pintura. Por lo tanto, los vectores que apuntan a cada punto de la imagen original se inclinan hacia la derecha o hacia la izquierda y la transformación los alarga o acorta. Los puntos a lo largo del eje horizontal no se mueven en absoluto cuando se aplica esta transformación. Por lo tanto, cualquier vector que apunte directamente a la derecha o a la izquierda sin componente vertical es un vector propio de esta transformación, porque el mapeo no cambia su dirección. Además, todos estos vectores propios tienen un valor propio igual a uno, porque el mapeo tampoco cambia su longitud.

Las transformaciones lineales pueden tomar muchas formas diferentes, trazando vectores en una variedad de espacios vectoriales, por lo que los eigenvectores también pueden tomar muchas formas. Por ejemplo, la transformación lineal podría ser un operador diferencial como ddx{displaystyle {tfrac {dx}}}, en cuyo caso los eigenvectores son funciones llamadas eigenfunctions que son escaladas por ese operador diferencial, como

Los valores propios y los vectores propios dan lugar a muchos conceptos matemáticos estrechamente relacionados, y el prefijo eigen- se aplica generosamente al nombrarlos:

- El conjunto de todos los eigenvectores de una transformación lineal, cada uno junto con su correspondiente eigenvalue, se llama el eigensystem de esa transformación.

- El conjunto de todos los eigenvectores de T correspondiente al mismo eigenvalue, junto con el vector cero, se llama un eigenspaceo el espacio característico de T asociado con ese eigenvalue.

- Si un conjunto de eigenvectores de T forma una base del dominio de T, entonces esta base se llama eigenbasis.

Historia

Los valores propios a menudo se introducen en el contexto del álgebra lineal o la teoría de matrices. Sin embargo, históricamente surgieron en el estudio de formas cuadráticas y ecuaciones diferenciales.

En el siglo XVIII, Leonhard Euler estudió el movimiento de rotación de un cuerpo rígido y descubrió la importancia de los ejes principales. Joseph-Louis Lagrange se dio cuenta de que los ejes principales son los vectores propios de la matriz de inercia.

A principios del siglo XIX, Augustin-Louis Cauchy vio cómo su trabajo podía usarse para clasificar las superficies cuádricas y lo generalizó a dimensiones arbitrarias. Cauchy también acuñó el término racine caractéristique (raíz característica), para lo que ahora se llama valor propio; su término sobrevive en la ecuación característica.

Más tarde, Joseph Fourier utilizó el trabajo de Lagrange y Pierre-Simon Laplace para resolver la ecuación del calor mediante la separación de variables en su famoso libro de 1822 Théorie analytique de la chaleur. Charles-François Sturm desarrolló aún más las ideas de Fourier y las llamó la atención de Cauchy, quien las combinó con sus propias ideas y llegó al hecho de que las matrices simétricas reales tienen valores propios reales. Charles Hermite amplió esto en 1855 a lo que ahora se llaman matrices hermitianas.

Casi al mismo tiempo, Francesco Brioschi demostró que los valores propios de matrices ortogonales se encuentran en el círculo unitario, y Alfred Clebsch encontró el resultado correspondiente para matrices simétricas sesgadas. Finalmente, Karl Weierstrass aclaró un aspecto importante de la teoría de la estabilidad iniciada por Laplace, al darse cuenta de que las matrices defectuosas pueden causar inestabilidad.

Mientras tanto, Joseph Liouville estudió problemas de valores propios similares a los de Sturm; la disciplina que surgió de su trabajo ahora se llama teoría de Sturm-Liouville. Schwarz estudió el primer valor propio de la ecuación de Laplace en dominios generales hacia finales del siglo XIX, mientras que Poincaré estudió la ecuación de Poisson unos años más tarde.

A principios del siglo XX, David Hilbert estudió los valores propios de los operadores integrales al considerarlos como matrices infinitas. Fue el primero en utilizar la palabra alemana eigen, que significa "propio", para denotar valores propios y vectores propios en 1904, aunque es posible que haya seguido un uso relacionado de Hermann von Helmholtz. . Durante algún tiempo, el término estándar en inglés fue "valor propio", pero el término más distintivo "valor propio" es el estándar hoy.

El primer algoritmo numérico para calcular valores propios y vectores propios apareció en 1929, cuando Richard von Mises publicó el método de la potencia. Uno de los métodos más populares en la actualidad, el algoritmo QR, fue propuesto de forma independiente por John G. F. Francis y Vera Kublanovskaya en 1961.

Valores propios y vectores propios de matrices

Los valores propios y los vectores propios a menudo se presentan a los estudiantes en el contexto de cursos de álgebra lineal centrados en matrices. Además, las transformaciones lineales en un espacio vectorial de dimensión finita se pueden representar mediante matrices, lo cual es especialmente común en aplicaciones numéricas y computacionales.

Considere los vectores n-dimensionales que se forman como una lista de n escalares, como los vectores tridimensionales

Se dice que estos vectores son múltiplos escalares entre sí, o paralelos o colineales, si existe un λ escalar tal eso

En este caso, λ λ =− − 120{displaystyle lambda =-{1}{20}}.

Considere ahora la transformación lineal de vectores n-dimensionales definidos por un n por n matriz A,

Si ocurre que v y w son múltiplos escalares, es decir, si

- Av=w=λ λ v,{displaystyle Amathbf {v} =mathbf {w} =lambda mathbf {v}

()1)

entonces v es un vector propio de la transformación lineal A y el factor de escala λ es el valor propio correspondiente a ese vector propio. La ecuación (1) es la ecuación de valores propios para la matriz A.

La ecuación (1) se puede expresar de manera equivalente como

- ()A− − λ λ I)v=0,{displaystyle left(A-lambda Iright)mathbf {v} =mathbf {0}

()2)

donde I es el n por n matriz de identidad y 0 es el vector cero.

Valores propios y el polinomio característico

La ecuación (2) tiene una solución distinta de cero v si y sólo si el determinante de la matriz (A − λI) es cero. Por lo tanto, los valores propios de A son valores de λ que satisfacen la ecuación

- Det()A− − λ λ I)=0{displaystyle det(A-lambda I)=0}

()3)

Usando la fórmula de Leibniz para los determinantes, el lado izquierdo de la ecuación (3) es una función polinómica de la variable λ y el grado de este polinomio es n, el orden de la matriz A. Sus coeficientes dependen de las entradas de A, excepto que su término de grado n es siempre (−1)nλn. Este polinomio se llama polinomio característico de A. La ecuación (3) se llama ecuación característica o ecuación secular de A.

El teorema fundamental del álgebra implica que el polinomio característico de una matriz n-por-n A, siendo un polinomio de grado n, se puede factorizar en el producto de n términos lineales,

- Det()A− − λ λ I)=()λ λ 1− − λ λ )()λ λ 2− − λ λ )⋯ ⋯ ()λ λ n− − λ λ ),{displaystyle det(A-lambda I)=(lambda _{1}-lambda)(lambda _{2}-lambda)cdots (lambda _{n}-lambda),}

()4)

donde cada λi puede ser real pero en general es un número complejo. Los números λ1, λ2,... λn, que no todos tienen valores distintos, son raíces del polinomio y son los eigenvalues de A.

Como ejemplo breve, que se describe con más detalle en la sección de ejemplos más adelante, considere la matriz

Tomando el determinante de (A − λI), el polinomio característico de A es

Posición del polinomio característico igual a cero, tiene raíces en λ=1 y λ=3, que son los dos eigenvalues A. Los eigenvectores correspondientes a cada eigenvalue se pueden encontrar resolviendo para los componentes de v en la ecuación ()A− − λ λ I)v=0{displaystyle left(A-lambda Iright)mathbf {v} =mathbf {0}. En este ejemplo, los eigenvectores son cualquier múltiple de escalar no cero de

Si las entradas de la matriz A son todas números reales, entonces los coeficientes del polinomio característico también serán números reales, pero los valores propios aún pueden tener partes imaginarias distintas de cero. Por lo tanto, las entradas de los vectores propios correspondientes también pueden tener partes imaginarias distintas de cero. De manera similar, los valores propios pueden ser números irracionales incluso si todas las entradas de A son números racionales o incluso si todas son números enteros. Sin embargo, si las entradas de A son todas números algebraicos, que incluyen los racionales, los valores propios también deben ser números algebraicos (es decir, no pueden convertirse mágicamente en números trascendentales).

Las raíces no reales de un polinomio real con coeficientes reales se pueden agrupar en pares de conjugados complejos, a saber, con los dos miembros de cada par que tienen partes imaginarias que difieren sólo en la señal y la misma parte real. Si el grado es extraño, entonces por el valor intermedio teorema al menos una de las raíces es real. Por lo tanto, cualquier matriz real con orden extraño tiene al menos un valor real, mientras que una matriz real con orden incluso puede no tener ningún valor real. Los eigenvectores asociados a estos complejos eigenvalues también son complejos y también aparecen en pares complejos conjugados.

Multiplicidad algebraica

Sea λi un valor propio de una matriz n por n Un. La multiplicidad algebraica μA(λi) del valor propio es su multiplicidad como raíz del polinomio característico, es decir, el mayor entero k tal que (λ − λi)k divide uniformemente ese polinomio.

Supongamos que una matriz A tiene dimensión n y d ≤ n valores propios distintos. Mientras que la ecuación (4) factoriza el polinomio característico de A en el producto de n términos lineales con algunos términos potencialmente repetidos, el polinomio característico puede en cambio escribirse como el producto de términos d, cada uno de los cuales corresponde a un valor propio distinto y elevado a la potencia de la multiplicidad algebraica,

Si d = n entonces el lado derecho es el producto de n términos lineales y esto es lo mismo que la ecuación (4). El tamaño de la multiplicidad algebraica de cada valor propio está relacionado con la dimensión n como

Si μA(λi) = 1, entonces se dice que λi es un valor propio simple. Si μA(λi) es igual la multiplicidad geométrica de λi, γA(λi), definido en la siguiente sección, entonces λi se dice que es un valor propio semisimple.

Espacios propios, multiplicidad geométrica y bases propias de matrices

Dado un eigenvalue particular λ de la n por n matriz A, definir el conjunto E para ser todos vectores v que satisface la ecuación (2),

Por un lado, este conjunto es precisamente el núcleo o el espacio nulo de la matriz (A − λI). Por otro lado, por definición, cualquier vector no cero que satisfaga esta condición es un eigenvector de A asociado con λ. Entonces, el set E es la unión del vector cero con el conjunto de todos los eigenvectores de A asociado con λ, y E iguala el espacio nulo de (A − λI). E se llama eigenspace o espacio característico de A asociado con λ. En general λ es un número complejo y los eigenvectores son complejos n por 1 matrices. Una propiedad del espacio nulo es que es un subespacio lineal, así que E es un subespacio lineal Cn{displaystyle mathbb {C} {n}}.

Debido a que el espacio propio E es un subespacio lineal, está cerrado bajo suma. Es decir, si dos vectores u y v pertenecen al conjunto E, escrito u, v ∈ E, luego (u + v) ∈ E o equivalentemente A(u + v) = λ(u + v). Esto se puede comprobar utilizando la propiedad distributiva de la multiplicación de matrices. De manera similar, debido a que E es un subespacio lineal, está cerrado bajo multiplicación escalar. Es decir, si v ∈ E y α es un número complejo, (αv) ∈ E o equivalentemente A (αv) = λ(αv). Esto se puede comprobar observando que la multiplicación de matrices complejas por números complejos es conmutativa. Siempre que u + v y αv no sean cero, también son vectores propios de A. asociado con λ.

La dimensión del eigenspace E asociado con λ, o equivalentemente el número máximo de eigenvectores linealmente independientes asociados con λ, se conoce como el eigenvalue multiplicidad geométrica γ γ A()λ λ ){displaystyle gamma _{A}(lambda)}. Porque... E es también el espacio nulo de (A − λI), la multiplicidad geométrica de λ es la dimensión del espacio nulo de (A − λI), también llamado el nulidad of (A − λI), que se refiere a la dimensión y el rango de (A − λIcomo

Debido a la definición de valores propios y vectores propios, la multiplicidad geométrica de un valor propio debe ser al menos uno, es decir, cada valor propio tiene al menos un vector propio asociado. Además, la multiplicidad geométrica de un valor propio no puede exceder su multiplicidad algebraica. Además, recuerde que la multiplicidad algebraica de un valor propio no puede exceder n.

Para demostrar la desigualdad γ γ A()λ λ )≤ ≤ μ μ A()λ λ ){displaystyle gamma _{A}(lambda)leq mu _{A}(lambda)}, considerar cómo la definición de multiplicidad geométrica implica la existencia de γ γ A()λ λ ){displaystyle gamma _{A}(lambda)} eigenvectores ortonormales v1,... ... ,vγ γ A()λ λ ){fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif}, tal que Avk=λ λ vk{displaystyle A{boldsymbol {v}_{k}=lambda {fnMicrosoft Sans Serif}. Por lo tanto, podemos encontrar una matriz (unitaria) V{displaystyle V} cuya primera γ γ A()λ λ ){displaystyle gamma _{A}(lambda)} columnas son estos eigenvectores, y cuyas columnas restantes pueden ser cualquier conjunto ortonormal de n− − γ γ A()λ λ ){displaystyle n-gamma _{A}(lambda)} vectores ortogonales a estos eigenvectores de A{displaystyle A}. Entonces... V{displaystyle V} tiene rango completo y por lo tanto es invertible. Evaluación D:=VTAV{displaystyle D:=V^{T}AV}, tenemos una matriz cuyo bloque superior izquierdo es la matriz diagonal λ λ Iγ γ A()λ λ ){displaystyle lambda I_{gamma ¿Qué?. Esto se puede ver evaluando lo que el lado izquierdo hace a los vectores de base de la primera columna. Reorganizar y agregar − − . . V{displaystyle -xi V} en ambos lados, tenemos ()A− − . . I)V=V()D− − . . I){displaystyle (A-xi I)V=V(D-xi I)} desde entonces I{displaystyle I} comunicaciones con V{displaystyle V}. En otras palabras, A− − . . I{displaystyle A-xi I es similar a D− − . . I{displaystyle D-xi I, y Det()A− − . . I)=Det()D− − . . I){displaystyle det(A-xi I)=det(D-xi I)}. Pero de la definición D{displaystyle D}, sabemos que Det()D− − . . I){displaystyle det(D-xi I)} contiene un factor (). . − − λ λ )γ γ A()λ λ ){displaystyle (xi -lambda)}{gamma _{A}(lambda)}, lo que significa que la multiplicidad algebraica λ λ {displaystyle lambda } debe satisfacer μ μ A()λ λ )≥ ≥ γ γ A()λ λ ){displaystyle mu _{A}(lambda)geq gamma _{A}(lambda)}.

Suppose A{displaystyle A} tiene d≤ ≤ n{displaystyle dleq n} eigenvalues distintos λ λ 1,... ... ,λ λ d{displaystyle lambda _{1},ldotslambda _{d}, donde la multiplicidad geométrica λ λ i{displaystyle lambda _{i} es γ γ A()λ λ i){displaystyle gamma _{A}(lambda _{i})}. La multiplicidad geométrica total A{displaystyle A},

- La suma directa de los eigenspaces de todos A{displaystyle A}'s eigenvalues es todo el espacio vectorial Cn{displaystyle mathbb {C} {n}}.

- Una base de Cn{displaystyle mathbb {C} {n}} se puede formar de n{displaystyle n} eigenvectores linealmente independientes de A{displaystyle A}; tal base se denomina eigenbasis

- Cualquier vector en Cn{displaystyle mathbb {C} {n}} se puede escribir como una combinación lineal de eigenvectores de A{displaystyle A}.

Propiedades adicionales de los valores propios

Vamos. A{displaystyle A} ser arbitraria n× × n{displaystyle ntimes n} matriz de números complejos con eigenvalues λ λ 1,... ... ,λ λ n{displaystyle lambda _{1},ldotslambda ¿Qué?. Cada eigenvalue aparece μ μ A()λ λ i){displaystyle mu _{A}(lambda _{i})} tiempos en esta lista, donde μ μ A()λ λ i){displaystyle mu _{A}(lambda _{i})} es la multiplicidad algebraica del eigenvalue. Las siguientes son propiedades de esta matriz y sus eigenvalues:

- El rastro de A{displaystyle A}, definido como la suma de sus elementos diagonales, es también la suma de todos los eigenvalues,

- tr ()A)=. . i=1naii=. . i=1nλ λ i=λ λ 1+λ λ 2+⋯ ⋯ +λ λ n.{displaystyle operatorname {tr} (A)=sum ##{i=1} {n}a_{ii}=sum ################################################################################################################################################################################################################################################################ ¿Qué? _{1}+lambda _{2}+cdots +lambda _{n}

- El determinante A{displaystyle A} es el producto de todos sus eigenvalues,

- Det()A)=∏ ∏ i=1nλ λ i=λ λ 1λ λ 2⋯ ⋯ λ λ n.{displaystyle det(A)=prod ################################################################################################################################################################################################################################################################ ¿Qué? "Lambda" _{2}cdots lambda _{n}

- Los eigenvalues de los k{displaystyle k}poder de A{displaystyle A}i.e. the eigenvalues of Ak{displaystyle A^{k}, para cualquier entero positivo k{displaystyle k}, son λ λ 1k,... ... ,λ λ nk{displaystyle lambda ################################################################################################################################################################################################################################################################ ¿Qué?.

- La matriz A{displaystyle A} es invertible si y sólo si cada eigenvalue no es cero.

- Si A{displaystyle A} es invertible, entonces los eigenvalues de A− − 1{displaystyle A^{-1} son 1λ λ 1,... ... ,1λ λ n{textstyle {frac {1}{lambda}}ldots{frac {1}{lambda ♪♪ y la multiplicidad geométrica de cada eigenvalue coincide. Además, ya que el polinomio característico del inverso es el polinomio recíproco del original, los eigenvalues comparten la misma multiplicidad algebraica.

- Si A{displaystyle A} es igual a su transpose conyugal AAlternativa Alternativa {displaystyle A^{}, o equivalente si A{displaystyle A} es Hermitian, entonces cada eigenvalue es real. Lo mismo ocurre con cualquier matriz real simétrica.

- Si A{displaystyle A} no es sólo Hermitian sino también positivo-definido, positivo-semidefinito, negativo-definido, o negativo-semidefinito, entonces cada eigenvalue es positivo, no negativo, negativo, o no positivo, respectivamente.

- Si A{displaystyle A} es unitario, cada eigenvalue tiene valor absoluto Silencioλ λ iSilencio=1{displaystyle Silenciolambda _{i} habit=1}.

- Si A{displaystyle A} es un n× × n{displaystyle ntimes n} matriz {}λ λ 1,... ... ,λ λ k}{displaystyle {lambda _{1},ldotslambda ¿Qué? son sus eigenvalues, luego los eigenvalues de la matriz I+A{displaystyle I+A. (donde) I{displaystyle I} es la matriz de identidad) {}λ λ 1+1,... ... ,λ λ k+1}{displaystyle {lambda _{1}+1,ldotslambda ¿Qué?. Además, si α α ▪ ▪ C{displaystyle alpha in mathbb {C}, los eigenvalues de α α I+A{displaystyle alpha I+A} son {}λ λ 1+α α ,... ... ,λ λ k+α α }{displaystyle {lambda _{1}+alphaldotslambda ################################################################################################################################################################################################################################################################ {}}. Más generalmente, para un polinomio P{displaystyle P} los valores de la matriz P()A){displaystyle P(A)} son {}P()λ λ 1),... ... ,P()λ λ k)}{displaystyle {P(lambda _{1}),ldotsP(lambda _{k}}}.

Vectores propios izquierdo y derecho

Muchas disciplinas representan tradicionalmente vectores como matrices con una sola columna en lugar de como matrices con una sola fila. Por eso, la palabra "eigenvector" en el contexto de las matrices casi siempre se refiere a un eigenvector derecho, a saber columna vector que derecho multiplica el n× × n{displaystyle ntimes n} matriz A{displaystyle A} en la ecuación definitoria, ecuación1),

El problema eigenvalue y eigenvector también se puede definir para fila vectores que izquierda multiplica matriz A{displaystyle A}. En esta formulación, la ecuación definitoria es

Donde κ κ {displaystyle kappa } es un cuero cabelludo u{displaystyle u} es un 1× × n{displaystyle 1times n} matriz. Cualquier vector de fila u{displaystyle u} satisfacer esta ecuación se llama izquierda eigenvector de A{displaystyle A} y κ κ {displaystyle kappa } es su eigenvalue asociado. Tomando la transposición de esta ecuación,

Comparando esta ecuación a la ecuación (1), sigue inmediatamente que un eigenvector izquierdo de A{displaystyle A} es el mismo que la transposición de un eigenvector derecho de AT{displaystyle A^{textsf}}, con el mismo eigenvalue. Además, desde el polinomio característico AT{displaystyle A^{textsf}} es el mismo que el polinomio característico A{displaystyle A}, los eigenvectores izquierdo y derecho de A{displaystyle A} están asociados con los mismos eigenvalues.

Diagonalización y autodescomposición

Supongamos que los vectores propios de A forman una base, o equivalentemente, A tiene n vectores propios linealmente independientes v1, v2,..., vn con valores propios asociados λ1, λ2,..., λn. Los valores propios no necesitan ser distintos. Defina una matriz cuadrada Q cuyas columnas sean los n vectores propios linealmente independientes de A,

- Q=[v1v2⋯ ⋯ vn].{displaystyle Q={begin{bmatrix}mathbf {v} _{1} limitmathbf {v} _{2} {cdots > mathbf {v} ¿Qué?

Dado que cada columna de Q es un vector propio de A, multiplicar por la derecha A por Q escala cada columna de Q por su valor propio asociado,

- AQ=[λ λ 1v1λ λ 2v2⋯ ⋯ λ λ nvn].{displaystyle AQ={begin{bmatrix}lambda ¿Qué? ¿Qué? ¿Por qué? ¿Qué?

Con esto en mente, defina una matriz diagonal Λ donde cada elemento diagonal Λii es el valor propio asociado con la iésima columna de Q. Entonces

- AQ=Q▪ ▪ .{displaystyle AQ=QLambda.}

Debido a que las columnas de Q son linealmente independientes, Q es invertible. Multiplicando ambos lados de la ecuación por Q−1,

- A=Q▪ ▪ Q− − 1,{displaystyle A=QLambda Q^{-1}

o, en su lugar, multiplicando ambos lados por la izquierda por Q−1,

- Q− − 1AQ=▪ ▪ .{displaystyle Q^{-1}AQ=Lambda.}

A se puede descomponer en una matriz compuesta por sus vectores propios, una matriz diagonal con sus valores propios a lo largo de la diagonal y la inversa de la matriz de vectores propios. Esto se llama descomposición propia y es una transformación de similitud. Se dice que dicha matriz A es similar a la matriz diagonal Λ o diagonalizable. La matriz Q es la matriz de cambio de base de la transformación de similitud. Esencialmente, las matrices A y Λ representan la misma transformación lineal expresada en dos bases diferentes. Los vectores propios se utilizan como base al representar la transformación lineal como Λ.

Por el contrario, supongamos que una matriz A es diagonalizable. Sea P una matriz cuadrada no singular tal que P−1AP es alguna matriz diagonal D. Izquierda multiplicando ambos por P, AP = PD. Por lo tanto, cada columna de P debe ser un vector propio de A cuyo valor propio es el elemento diagonal correspondiente de D. Dado que las columnas de P deben ser linealmente independientes para que P sea invertible, existen n vectores propios linealmente independientes de A >. Entonces se deduce que los vectores propios de A forman una base si y sólo si A es diagonalizable.

Una matriz que no es diagonalizable se dice que es defectuosa. Para matrices defectuosas, la noción de vectores propios se generaliza a vectores propios generalizados y la matriz diagonal de valores propios se generaliza a la forma normal de Jordan. Sobre un campo algebraicamente cerrado, cualquier matriz A tiene una forma normal de Jordan y por lo tanto admite una base de vectores propios generalizados y una descomposición en espacios propios generalizados.

Caracterización variacional

En el caso Hermitian, los eigenvalues se pueden dar una caracterización varia. El mayor eigenvalue de H{displaystyle H. es el valor máximo de la forma cuadrática xTHx/xTx{displaystyle mathbf {x} {textosf {T}Hmathbf {x} /mathbf {x} {x} {textosf {T}mathbf {x}. Un valor x{displaystyle mathbf {x} que se da cuenta de que el máximo es un eigenvector.

Ejemplos de matrices

Ejemplo de matriz bidimensional

Considere la matriz

La figura de la derecha muestra el efecto de esta transformación en las coordenadas de los puntos en el plano. Los vectores propios v de esta transformación satisfacen la ecuación (1), y los valores de λ para los cuales el determinante de la matriz (A − λI) es igual a cero son los valores propios.

Tomando el determinante para encontrar el polinomio característico de A,

Al establecer el polinomio característico igual a cero, tiene raíces en λ=1 y λ =3, que son los dos valores propios de A.

Para λ=1, la ecuación (2) se convierte en,

Cualquier vector distinto de cero con v1 = −v2 resuelve esta ecuación. Por lo tanto,

Para λ=3, la ecuación (2) se convierte

Cualquier vector distinto de cero con v1 = v2 resuelve esta ecuación. Por lo tanto,

es un vector propio de A correspondiente a λ = 3, al igual que cualquier múltiplo escalar de este vector.

Así, los vectores vλ=1 y vλ=3 son vectores propios de A asociados con los valores propios λ=1 y λ=3, respectivamente.

Ejemplo de matriz tridimensional

Considere la matriz

El polinomio característico de A es

Las raíces del polinomio característico son 2, 1, y 11, que son los únicos tres eigenvalues de A. Estos eigenvalues corresponden a los eigenvectores [100]T{displaystyle {begin{bmatrix}1 ventaja0end{bmatrix}{textsf {T}}, [0− − 21]T{displaystyle {begin{bmatrix}0 tarde-2end{bmatrix}}{textsf {T}}, y [012]T{displaystyle {begin{bmatrix}0 tarde1⁄2end{bmatrix}}{textsf {T}}, o cualquier no cero múltiple.

Ejemplo de matriz tridimensional con valores propios complejos

Considere la matriz de permutación cíclica

Esta matriz desplaza las coordenadas del vector hacia arriba una posición y mueve la primera coordenada hacia abajo. Su polinomio característico es 1 − λ3, cuyas raíces son

Para el valor propio real λ1 = 1, cualquier vector con tres entradas iguales distintas de cero es un vector propio. Por ejemplo,

Para el par conjugado complejo de valores propios imaginarios,

Entonces

Por lo tanto, los otros dos eigenvectores A son complejos y son vλ λ 2=[1λ λ 2λ λ 3]T{displaystyle mathbf {v} _{lambda ################################################################################################################################################################################################################################################################ ################################################################################################################################################################################################################################################################ ################################################################################################################################################################################################################################################################ {T}} y vλ λ 3=[1λ λ 3λ λ 2]T{displaystyle mathbf {v} _{lambda ################################################################################################################################################################################################################################################################ ################################################################################################################################################################################################################################################################ ################################################################################################################################################################################################################################################################ {T}} con eigenvalues λ2 y λ3, respectivamente. Los dos complejos eigenvectores también aparecen en un complejo par conjugado,

Ejemplo de matriz diagonal

Las matrices con entradas sólo a lo largo de la diagonal principal se denominan matrices diagonales. Los valores propios de una matriz diagonal son los propios elementos diagonales. Considere la matriz

El polinomio característico de A es

que tiene las raíces λ1 = 1, λ 2 = 2 y λ3 = 3 . Estas raíces son los elementos diagonales y los valores propios de A.

Cada elemento diagonal corresponde a un vector propio cuyo único componente distinto de cero está en la misma fila que ese elemento diagonal. En el ejemplo, los valores propios corresponden a los vectores propios,

respectivamente, así como múltiplos escalares de estos vectores.

Ejemplo de matriz triangular

Una matriz cuyos elementos encima de la diagonal principal son todos cero se llama matriz triangular inferior, mientras que una matriz cuyos elementos debajo de la diagonal principal son todos cero se llama matriz triangular superior. Al igual que ocurre con las matrices diagonales, los valores propios de las matrices triangulares son los elementos de la diagonal principal.

Considere la matriz triangular inferior,

El polinomio característico de A es

que tiene las raíces λ1 = 1, λ2 = 2, y λ3 = 3. Estas raíces son los elementos diagonales, así como los eigenvalues A.

Estos valores propios corresponden a los vectores propios,

respectivamente, así como múltiplos escalares de estos vectores.

Ejemplo de matriz con valores propios repetidos

Como en el ejemplo anterior, la matriz triangular inferior

Las raíces de este polinomio, y por tanto los valores propios, son 2 y 3. La multiplicidad algebraica de cada valor propio es 2; en otras palabras, ambas son raíces dobles. La suma de las multiplicidades algebraicas de todos los valores propios distintos es μA = 4 = n, el orden de los polinomio característico y la dimensión de A.

Por otro lado, el multiplicidad geométrica el eigenvalue 2 es sólo 1, porque su eigenspace es abarcado por sólo un vector [01− − 11]T{displaystyle {begin{bmatrix}0 tarde1 curva-1end{bmatrix}^{textsf {T}} y por lo tanto es 1-dimensional. Del mismo modo, la multiplicidad geométrica del eigenvalue 3 es 1 porque su eigenspace es abarcado por un solo vector [0001]T{displaystyle {begin{bmatrix}0 ventaja0 limitada01end{bmatrix}^{textsf {T}}. La multiplicidad geométrica total γA es 2, que es el más pequeño que podría ser para una matriz con dos eigenvalues distintos. Las multiplicidades geométricas se definen en una sección posterior.

Identidad de vector propio-valor propio

Para una matriz hermitiana, la norma al cuadrado del jésimo componente de un vector propio normalizado se puede calcular utilizando solo los valores propios de la matriz y los valores propios de la matriz menor correspondiente.

Valores propios y funciones propias de operadores diferenciales

Las definiciones de valor propio y vectores propios de una transformación lineal T siguen siendo válidas incluso si el espacio vectorial subyacente es un espacio de Hilbert o Banach de dimensión infinita. Una clase ampliamente utilizada de transformaciones lineales que actúan en espacios de dimensión infinita son los operadores diferenciales en espacios funcionales. Sea D un operador diferencial lineal en el espacio C∞ de funciones reales infinitamente diferenciables de un argumento real t . La ecuación de valor propio para D es la ecuación diferencial

Las funciones que satisfacen esta ecuación son vectores propios de D y comúnmente se denominan funciones propias.

Ejemplo de operador derivado

Considere el operador derivado ddt{displaystyle {tfrac {dt}} {fnK}} {fn}} {fn}}} {fn}} {fn}} {fn}}}} con ecuación eigenvalue

Esta ecuación diferencial se puede resolver multiplicando ambos lados por dt/f(t) e integrando. Su solución, la función exponencial.

El artículo principal sobre funciones propias ofrece otros ejemplos.

Definición general

El concepto de valores propios y vectores propios se extiende naturalmente a transformaciones lineales arbitrarias en espacios vectoriales arbitrarios. Sea V cualquier espacio vectorial sobre algún campo K de escalares, y sea T una transformación lineal V en V,

Diremos que un vector distinto de cero v ∈ V es un vector propio de T si y sólo si existe un escalar λ ∈ K tal que

- T()v)=λ λ v.{displaystyle T(mathbf {v}=lambda mathbf {v}

()5)

Esta ecuación se llama ecuación de valor propio para T, y el escalar λ es el valor propio de T correspondiente al vector propio v. T(v) es el resultado de aplicar la transformación T al vector v, mientras que λ v es el producto del escalar λ por v.

Espacios propios, multiplicidad geométrica y base propia

Dado un valor propio λ, considere el conjunto

que es la unión del vector cero con el conjunto de todos los vectores propios asociados a λ. E se denomina espacio propio o espacio característico de T asociado con λ.

Por definición de transformación lineal,

para x, y ∈ V y α ∈ K. Por lo tanto, si u y v son vectores propios de T asociados con el valor propio λ, es decir, u, v ∈ E, entonces

Entonces, tanto u + v como αv son cero o vectores propios de T asociados con λ, es decir, u + v, αv ∈ E, y E está cerrado bajo suma y multiplicación escalar. El espacio propio E asociado con λ es, por tanto, un subespacio lineal de V. Si ese subespacio tiene dimensión 1, a veces se le llama línea propia.

La multiplicidad geométrica γT(λ) de un valor propio λ es la dimensión del espacio propio asociado con λ, es decir, el número máximo de vectores propios linealmente independientes asociados con ese valor propio. Según la definición de valores propios y vectores propios, γT(λ) ≥ 1 porque cada valor propio tiene al menos un vector propio.

Los espacios propios de T siempre forman una suma directa. Como consecuencia, los vectores propios de diferentes valores propios son siempre linealmente independientes. Por lo tanto, la suma de las dimensiones de los espacios propios no puede exceder la dimensión n del espacio vectorial en el que opera T, y no puede haber más de n valores propios distintos.

Cualquier subespacio abarcado por vectores propios de T es un subespacio invariante de T, y la restricción de T a dicho subespacio es diagonalizable. Además, si todo el espacio vectorial V puede ser abarcado por los vectores propios de T, o de manera equivalente si la suma directa de los espacios propios asociados con todos los valores propios de T es todo el espacio vectorial V, entonces se puede formar una base de V llamada base propia a partir de vectores propios linealmente independientes de T. Cuando T admite una base propia, T es diagonalizable.

Teoría espectral

Si λ es un valor propio de T, entonces el operador (T − λI) no es uno -a uno, y por lo tanto su inversa (T − λI)−1 no existe. Lo contrario es cierto para espacios vectoriales de dimensión finita, pero no para espacios vectoriales de dimensión infinita. En general, el operador (T − λI) puede no tener inverso incluso si λ no es un valor propio.

Por esta razón, en el análisis funcional los valores propios se pueden generalizar al espectro de un operador lineal T como el conjunto de todos los escalares λ para los cuales el operador (T − λI) no tiene inversa acotada. El espectro de un operador siempre contiene todos sus valores propios pero no se limita a ellos.

Álgebras asociativas y teoría de la representación

Se puede generalizar el objeto algebraico que actúa sobre el espacio vectorial, reemplazando un único operador que actúa sobre un espacio vectorial con una representación algebraica: un álgebra asociativa que actúa sobre un módulo. El estudio de tales acciones es el campo de la teoría de la representación.

El concepto de peso en la teoría de la representación es un análogo de los valores propios, mientras que los vectores de peso y los espacios de peso son análogos de los vectores propios y los espacios propios, respectivamente.

Ecuaciones dinámicas

Las ecuaciones en diferencias más simples tienen la forma

- xt=a1xt− − 1+a2xt− − 2+⋯ ⋯ +akxt− − k.{displaystyle x_{t}=a_{1}x_{t-1}+a_{2}x_{t-2}+cdots - Sí.

La solución de esta ecuación para x en términos de t se encuentra usando su ecuación característica

- λ λ k− − a1λ λ k− − 1− − a2λ λ k− − 2− − ⋯ ⋯ − − ak− − 1λ λ − − ak=0,{displaystyle lambda ^{k}-a_{1}lambda ^{k-1}-a_{2}lambda ^{k-2}-cdots -a_{k-1}lambda -a_{k}=0,}

que se puede encontrar apilando en forma matriz un conjunto de ecuaciones consistentes en la ecuación de diferencia anterior y la k – 1 ecuaciones xt− − 1=xt− − 1, ... ... , xt− − k+1=xt− − k+1,{displaystyle x_{t-1}=x_{t-1}, dots x_{t-k+1}=x_{t-k+1} dando k- sistema dimensional del primer orden en el vector variable apilado [xt⋯ ⋯ xt− − k+1]{displaystyle {begin{bmatrix}x_{t} ¿Qué? en términos de su valor una vez etiquetado, y tomando la ecuación característica de la matriz de este sistema. Esta ecuación da k raíces características λ λ 1,... ... ,λ λ k,{displaystyle lambda _{1},ldots,lambda - ¿Qué? para uso en la ecuación de solución

- xt=c1λ λ 1t+⋯ ⋯ +ckλ λ kt.{displaystyle x_{t}=c_{1}lambda ¿Qué? +c_{k}lambda - ¿Qué?

Se utiliza un procedimiento similar para resolver una ecuación diferencial de la forma

- dkxdtk+ak− − 1dk− − 1xdtk− − 1+⋯ ⋯ +a1dxdt+a0x=0.{displaystyle {frac {f}x}{dt^{k}}+a_{k-1}{f} {f} {f} {d^{k-1}x} {dt^{k-1}}+cdots ¿Qué?

Cálculo

El cálculo de eigenvalues y eigenvectores es un tema donde la teoría, como se presenta en los libros de texto de álgebra lineal elemental, a menudo está muy lejos de la práctica.

Método clásico

El método clásico consiste en encontrar primero los valores propios y luego calcular los vectores propios para cada valor propio. En varios sentidos, no es adecuado para aritméticas no exactas como la coma flotante.

Valores propios

Los eigenvalues de una matriz A{displaystyle A} puede determinarse por encontrar las raíces del polinomio característico. Esto es fácil para 2× × 2{displaystyle 2times 2} matrices, pero la dificultad aumenta rápidamente con el tamaño de la matriz.

En teoría, los coeficientes del polinomio característico se pueden calcular exactamente, ya que son sumas de productos de elementos de matriz; y hay algoritmos que pueden encontrar todas las raíces de un polinomio de grado arbitrario a cualquier precisión necesaria. Sin embargo, este enfoque no es viable en la práctica porque los coeficientes estarían contaminados por errores de redondeo inevitables, y las raíces de un polinomio pueden ser una función extremadamente sensible de los coeficientes (como lo demuestra el polinomio de Wilkinson). Incluso para las matrices cuyos elementos son enteros el cálculo se convierte en notrivial, porque las sumas son muy largas; el término constante es el determinante, que para un n× × n{displaystyle ntimes n} matriz es una suma de n!{displaystyle n!} diferentes productos.

Explicar fórmulas algebraicas para las raíces de un polinomio existen solamente si el grado n{displaystyle n} es 4 o menos. Según el teorema Abel-Ruffini no existe una fórmula algebraica general, explícita y exacta para las raíces de un polinomio con grado 5 o más. (Cuestiones de generalidad porque cualquier polinomio con grado n{displaystyle n} es el polinomio característico de alguna matriz compañera de orden n{displaystyle n}) Por lo tanto, para las matrices del orden 5 o más, los eigenvalues y los eigenvectores no pueden obtenerse por una fórmula algebraica explícita, y por lo tanto deben ser computados por métodos numéricos aproximados. Incluso la fórmula exacta para las raíces de un grado 3 polinomio es numéricamente impráctica.

Vectores propios

Una vez que se conoce el valor (exacto) de un valor propio, los vectores propios correspondientes se pueden encontrar encontrando soluciones distintas de cero de la ecuación de valores propios, que se convierte en un sistema de ecuaciones lineales con coeficientes conocidos. Por ejemplo, una vez que se sabe que 6 es un valor propio de la matriz

podemos encontrar sus eigenvectores resolviendo la ecuación Av=6v{displaystyle Av=6v}, eso es

Esta ecuación matricial es equivalente a dos ecuaciones lineales

Ambas ecuaciones reducen a la ecuación lineal única Sí.=2x{displaystyle y=2x}. Por lo tanto, cualquier vector de la forma [a2a]T{displaystyle {begin{bmatrix}a ventaja2aend{bmatrix}{textsf {T}}, para cualquier número real no cero a{displaystyle a}, es un eigenvector de A{displaystyle A} con eigenvalue λ λ =6{displaystyle lambda =6}.

La matriz A{displaystyle A} arriba tiene otro eigenvalue λ λ =1{displaystyle lambda =1}. Un cálculo similar muestra que los eigenvectores correspondientes son las soluciones no cero de 3x+Sí.=0{displaystyle 3x+y=0}, es decir, cualquier vector de la forma [b− − 3b]T{displaystyle {begin{bmatrix}b sensible-3bend{bmatrix}{textsf {T}}, para cualquier número real no cero b{displaystyle b}.

Métodos iterativos simples

El enfoque contrario, de buscar primero a los eigenvectores y luego determinar cada eigenvalue de su eigenvector, resulta ser mucho más susceptible para las computadoras. El algoritmo más fácil aquí consiste en elegir un vector de arranque arbitrario y luego multiplicarlo repetidamente con la matriz (opcionalmente normalizando el vector para mantener sus elementos de tamaño razonable); esto hace que el vector converge hacia un eigenvector. Una variación es multiplicar el vector por ()A− − μ μ I)− − 1{displaystyle (A-mu I)}{-1}; esto lo hace converger a un eigenvector del valor más cercano a μ μ ▪ ▪ C{displaystyle mu in mathbb {C}.

Si v{displaystyle mathbf {v} es (una buena aproximación de) un eigenvector de A{displaystyle A}, entonces el eigenvalue correspondiente puede ser calculado como

- λ λ =vAlternativa Alternativa AvvAlternativa Alternativa v{displaystyle lambda ={frac {mathbf {v} ¿Qué? }

Donde vAlternativa Alternativa {displaystyle mathbf {v} denota la transposición conyugal de v{displaystyle mathbf {v}.

Métodos modernos

No se conocían métodos eficientes y precisos para calcular valores propios y vectores propios de matrices arbitrarias hasta que se diseñó el algoritmo QR en 1961. La combinación de la transformación de Householder con la descomposición LU da como resultado un algoritmo con mejor convergencia que el algoritmo QR. Para matrices dispersas hermitianas grandes, el algoritmo de Lanczos es un ejemplo de un método iterativo eficiente para calcular valores propios y vectores propios, entre varias otras posibilidades.

La mayoría de los métodos numéricos que calculan los valores propios de una matriz también determinan un conjunto de vectores propios correspondientes como subproducto del cálculo, aunque a veces los implementadores optan por descartar la información del vector propio tan pronto como ya no es necesaria.

Aplicaciones

Transformaciones geométricas

Los vectores propios y los valores propios pueden ser útiles para comprender las transformaciones lineales de formas geométricas. La siguiente tabla presenta algunos ejemplos de transformaciones en el plano junto con sus matrices, valores propios y vectores propios de 2 × 2.

La ecuación característica para una rotación es una ecuación cuadrática con discriminación D=− − 4()pecado Silencio Silencio )2{displaystyle D=-4(sin theta)}{2}, que es un número negativo cada vez Silencio no es un número entero de 180°. Por lo tanto, excepto en estos casos especiales, los dos eigenvalues son números complejos, # Silencio Silencio ± ± ipecado Silencio Silencio {displaystyle cos theta pm isin theta }; y todos los eigenvectores tienen entradas no reales. De hecho, excepto en esos casos especiales, una rotación cambia la dirección de cada vector no cero en el plano.

Una transformación lineal que lleva un cuadrado a un rectángulo de la misma área (un mapeo de compresión) tiene valores propios recíprocos.

Análisis de componentes principales

La descomposición propia de una matriz semidefinida positiva (PSD) simétrica produce una base ortogonal de vectores propios, cada uno de los cuales tiene un valor propio no negativo. La descomposición ortogonal de una matriz PSD se utiliza en análisis multivariado, donde las matrices de covarianza muestrales son PSD. Esta descomposición ortogonal se denomina análisis de componentes principales (PCA) en estadística. PCA estudia relaciones lineales entre variables. El PCA se realiza en la matriz de covarianza o en la matriz de correlación (en la que cada variable se escala para que su varianza muestral sea igual a uno). Para la matriz de covarianza o correlación, los vectores propios corresponden a componentes principales y los valores propios a la varianza explicada por los componentes principales. El análisis de componentes principales de la matriz de correlación proporciona una base ortogonal para el espacio de los datos observados: en esta base, los valores propios más grandes corresponden a los componentes principales que están asociados con la mayor parte de la covariabilidad entre una serie de datos observados.

El análisis de componentes principales se utiliza como medio de reducción de dimensionalidad en el estudio de grandes conjuntos de datos, como los que se encuentran en bioinformática. En la metodología Q, los valores propios de la matriz de correlación determinan el juicio del metodólogo Q sobre la significancia práctica (que difiere de la significancia estadística de la prueba de hipótesis; cf. criterios para determinar el número de factores ). De manera más general, el análisis de componentes principales se puede utilizar como método de análisis factorial en el modelado de ecuaciones estructurales.

Gráficos

En la teoría del gráfico espectral, un eigenvalue de un gráfico se define como un eigenvalue de la matriz de adyacencia del gráfico A{displaystyle A}, o (crecientemente) de la matriz laplaciana del gráfico debido a su discreto operador de Laplace, que es D− − A{displaystyle D-A} (A veces se llama el combinatoria Laplacian) o I− − D− − 1/2AD− − 1/2{displaystyle I-D^{-1/2}AD^{-1/2} (A veces se llama el normalizado Laplacian), donde D{displaystyle D} es una matriz diagonal con Dii{displaystyle D_{ii} igual al grado de vértice vi{displaystyle V_{i}, y en D− − 1/2{displaystyle D^{-1/2}, el i{displaystyle i}la entrada diagonal 1/deg ()vi){textstyle 1/{sqrt {deg}}}. El k{displaystyle k}eigenvector principal de un gráfico se define como el eigenvector correspondiente al k{displaystyle k}mayor o mayor k{displaystyle k}el valor más pequeño del Laplacian. El primer eigenvector principal del gráfico también se conoce como el eigenvector principal.

El vector propio principal se utiliza para medir la centralidad de sus vértices. Un ejemplo es el algoritmo PageRank de Google. El vector propio principal de una matriz de adyacencia modificada del gráfico de la World Wide Web proporciona las clasificaciones de páginas como sus componentes. Este vector corresponde a la distribución estacionaria de la cadena de Markov representada por la matriz de adyacencia normalizada por filas; sin embargo, primero se debe modificar la matriz de adyacencia para garantizar que exista una distribución estacionaria. El segundo vector propio más pequeño se puede utilizar para dividir el gráfico en grupos, mediante agrupación espectral. También hay otros métodos disponibles para la agrupación.

Cadenas de Markov

Una cadena de Markov está representada por una matriz cuyas entradas son las probabilidades de transición entre estados de un sistema. En particular, las entradas no son negativas y cada fila de la matriz suma uno, siendo la suma de las probabilidades de transiciones de un estado a algún otro estado del sistema. El teorema de Perron-Frobenius proporciona condiciones suficientes para que una cadena de Markov tenga un valor propio dominante único, que gobierna la convergencia del sistema a un estado estacionario.

Análisis de vibraciones

Los problemas de valores propios ocurren naturalmente en el análisis de vibraciones de estructuras mecánicas con muchos grados de libertad. Los valores propios son las frecuencias naturales (o frecuencias propias) de la vibración, y los vectores propios son las formas de estos modos vibratorios. En particular, la vibración no amortiguada se rige por

Es decir, la aceleración es proporcional a la posición (es decir, esperamos x{displaystyle x} para ser sinusoidal en el tiempo).

In n{displaystyle n} dimensiones, m{displaystyle m} se convierte en una matriz de masa y k{displaystyle k} una matriz de rigidez. Las soluciones admisibles son entonces una combinación lineal de soluciones al problema eigenvalue generalizado

Esto se puede reducir a un problema de valores propios generalizado mediante manipulación algebraica a costa de resolver un sistema más grande.

Las propiedades de ortogonalidad de los vectores propios permiten el desacoplamiento de las ecuaciones diferenciales para que el sistema pueda representarse como una suma lineal de los vectores propios. El problema de valores propios de estructuras complejas a menudo se resuelve mediante análisis de elementos finitos, pero se generaliza claramente la solución a problemas de vibración con valores escalares.

Tensor de momento de inercia

En mecánica, los vectores propios del tensor de momento de inercia definen los ejes principales de un cuerpo rígido. El tensor de momento de inercia es una cantidad clave necesaria para determinar la rotación de un cuerpo rígido alrededor de su centro de masa.

Tensor de tensión

En mecánica de sólidos, el tensor de tensión es simétrico y, por lo tanto, se puede descomponer en un tensor diagonal con los valores propios en la diagonal y los vectores propios como base. Debido a que es diagonal, en esta orientación, el tensor de tensión no tiene componentes de corte; los componentes que tiene son los componentes principales.

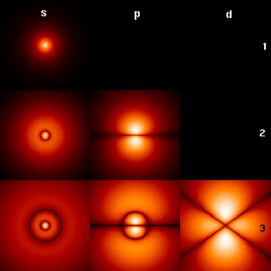

Ecuación de Schrödinger

Un ejemplo de una ecuación eigenvalue donde la transformación T{displaystyle T} está representado en términos de un operador diferencial es la ecuación de Schrödinger independiente en la mecánica cuántica:

- H↑ ↑ E=E↑ ↑ E{displaystyle Hpsi ¿Qué?

Donde H{displaystyle H., el Hamiltonian, es un operador diferencial de segundo orden y ↑ ↑ E{displaystyle psi _{E}, la función de onda, es una de sus funciones eigen correspondientes al eigenvalue E{displaystyle E}, interpretado como su energía.

Sin embargo, en el caso en que uno está interesado sólo en las soluciones de estado consolidado de la ecuación Schrödinger, uno busca ↑ ↑ E{displaystyle psi _{E} dentro del espacio de funciones integradas cuadradas. Dado que este espacio es un espacio Hilbert con un producto de escalar bien definido, se puede introducir una base en la que ↑ ↑ E{displaystyle psi _{E} y H{displaystyle H. puede ser representado como un array unidimensional (es decir, un vector) y una matriz respectivamente. Esto permite representar la ecuación Schrödinger en una forma de matriz.

La notación del sujetador se utiliza a menudo en este contexto. Un vector, que representa un estado del sistema, en el espacio Hilbert de funciones integradas cuadradas está representado por SilencioΨ Ψ E. . {displaystyle Silencio.. En esta notación, la ecuación Schrödinger es:

- HSilencioΨ Ψ E. . =ESilencioΨ Ψ E. . {displaystyle H detainedPsi _{E}rangle =E durablePsi - ¿Qué?

Donde SilencioΨ Ψ E. . {displaystyle Silencio. es un eigenstate de H{displaystyle H. y E{displaystyle E} representa el eigenvalue. H{displaystyle H. es un operador observable auto-adjunto, el analógico infinita de las matrices hermitianas. Como en el caso matriz, en la ecuación anterior HSilencioΨ Ψ E. . {displaystyle H tuberculosis - ¿Qué? es entendido como el vector obtenido por la aplicación de la transformación H{displaystyle H. a SilencioΨ Ψ E. . {displaystyle Silencio..

Transporte de ondas

Luz, ondas acústicas y microondas se dispersan aleatoriamente numerosas veces al atravesar un sistema estático desordenado. Aunque la dispersión múltiple aleatoriza repetidamente las olas, en última instancia el transporte coherente de ondas a través del sistema es un proceso determinista que puede describirse por una matriz de transmisión de campo t{displaystyle mathbf {t}. Los eigenvectores del operador de transmisión t† † t{displaystyle mathbf {t} }mathbf {t} forma un conjunto de ondas de entrada específicas para el trastorno que permiten a las ondas unirse a los eigencanales del sistema desordenado: las rutas independientes pueden recorrer el sistema. Los eigenvalues, τ τ {displaystyle tau }, de t† † t{displaystyle mathbf {t} }mathbf {t} corresponde a la transmisión de intensidad asociada a cada eigencanal. Una de las propiedades notables del operador de transmisión de sistemas difusivos es su distribución bimodal eigenvalue con τ τ max=1{displaystyle tau _{max }=1} y τ τ min=0{displaystyle tau _{min }=0}. Además, una de las propiedades llamativas de los eigencanales abiertos, más allá de la transmisión perfecta, es el perfil espacial estadísticamente robusto de los eigencanales.

Orbitales moleculares

En mecánica cuántica, y en particular en física atómica y molecular, dentro de la teoría de Hartree-Fock, los orbitales atómicos y moleculares pueden definirse mediante los vectores propios del operador de Fock. Los valores propios correspondientes se interpretan como potenciales de ionización mediante el método de Koopmans. teorema. En este caso, el término vector propio se utiliza con un significado algo más general, ya que el operador de Fock depende explícitamente de los orbitales y sus valores propios. Así, si se quiere subrayar este aspecto, se habla de problemas de valores propios no lineales. Estas ecuaciones suelen resolverse mediante un procedimiento de iteración, denominado en este caso método de campos autoconsistentes. En química cuántica, a menudo se representa la ecuación de Hartree-Fock en un conjunto de bases no ortogonales. Esta representación particular es un problema de valores propios generalizado llamado ecuaciones de Roothaan.

Geología y glaciología

En geología, especialmente en el estudio de la formación de glaciares, los vectores propios y los valores propios se utilizan como método mediante el cual se obtiene una masa de información de los constituyentes de un tejido de clastos. La orientación y la inclinación se pueden resumir en un espacio tridimensional mediante seis números. En el campo, un geólogo puede recopilar datos de cientos o miles de clastos en una muestra de suelo, que sólo pueden compararse gráficamente, como en un diagrama Tri-Plot (Sneed y Folk), o como Stereonet en una red Wulff.

La salida para el tensor de orientación está en los tres ejes ortogonales (perpendicular) del espacio. Los tres eigenvectores son ordenados v1,v2,v3{displaystyle mathbf {v} _{1},mathbf {v} ¿Qué? ¿Qué? por sus eigenvalues E1≥ ≥ E2≥ ≥ E3{displaystyle E_{1}gq E_{2}gq E_{3};

v1{displaystyle mathbf {v} ¿Qué? entonces es la orientación/dip primaria de clast, v2{displaystyle mathbf {v} _{2} es la secundaria y v3{displaystyle mathbf {v} ¿Qué? es el terciario, en términos de fuerza. La orientación más estrecha se define como la dirección del eigenvector, en una rosa brújula de 360°. Dip se mide como el eigenvalue, el módulo del tensor: esto se valora de 0° (no dip) a 90° (vertical). Los valores relativos de E1{displaystyle E_{1}, E2{displaystyle E_{2}, y E3{displaystyle E_{3} son dictadas por la naturaleza del tejido del sedimento. Si E1=E2=E3{displaystyle E_{1}=E_{2}=E_{3}, se dice que el tejido es isotrópico. Si E_{3}}" xmlns="http://www.w3.org/1998/Math/MathML">E1=E2■E3{displaystyle E_{1}=E_{2}E_{3}}" aria-hidden="true" class="mwe-math-fallback-image-inline mw-invert" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/9b0d25ff62dc33b187f2b73e39bda3c972724aa2" style="vertical-align: -0.671ex; width:14.505ex; height:2.509ex;"/>Se dice que el tejido es plano. Si E_{2}>E_{3}}" xmlns="http://www.w3.org/1998/Math/MathML">E1■E2■E3{displaystyle E_{1} títuloE_{2}

E_{2}>E_{3}}" aria-hidden="true" class="mwe-math-fallback-image-inline mw-invert" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/215bda2a0fb9f5ccbbb7ada013a2d3fb8d82150c" style="vertical-align: -0.671ex; width:14.505ex; height:2.509ex;"/>Se dice que el tejido es lineal.

Número de reproducción básico

Número de reproducción básica (R0{displaystyle R_{0}) es un número fundamental en el estudio de cómo se propagan las enfermedades infecciosas. Si una persona infecciosa es puesta en una población de personas completamente susceptibles, entonces R0{displaystyle R_{0} es el número promedio de personas que una persona infecciosa típica infectará. El tiempo de generación de una infección es el tiempo, tG{displaystyle T_{G}, de una persona infectándose a la siguiente persona infectándose. En una población heterogénea, la matriz de próxima generación define cuántas personas en la población se infectarán después del tiempo. tG{displaystyle T_{G} ha pasado. El valor R0{displaystyle R_{0} es entonces el mayor eigenvalue de la matriz de próxima generación.

Eigenfaces

En el procesamiento de imágenes, se pueden ver imágenes procesadas de caras como vectores cuyos componentes son los brillos de cada píxel. La dimensión de este espacio vectorial es el número de píxeles. Los eigenvectores de la matriz de covariancia asociada a un gran conjunto de imágenes normalizadas de caras se llaman Eigenfaces; este es un ejemplo del análisis principal de componentes. Son muy útiles para expresar cualquier imagen facial como una combinación lineal de algunos de ellos. En la rama de reconocimiento facial de biometría, los eigenfaces proporcionan un medio de aplicar la compresión de datos a caras con fines de identificación. También se han realizado investigaciones relacionadas con sistemas de visión eigena que determinan los gestos manuales.

De manera similar a este concepto, las voces propias representan la dirección general de la variabilidad en las pronunciaciones humanas de un enunciado particular, como una palabra en un idioma. A partir de una combinación lineal de dichas voces propias se puede construir una nueva pronunciación vocal de la palabra. Estos conceptos han resultado útiles en los sistemas automáticos de reconocimiento de voz para la adaptación del hablante.

Contenido relacionado

Conjunto vacío

Precisión y exactitud

Historia de la lógica

![{displaystyle left[{begin{smallmatrix}2&1\1&2end{smallmatrix}}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/838a30dc9d065ec434dff490bd84061ed569db3b)

![{displaystyle {begin{aligned}det(A-lambda I)&=left|{begin{bmatrix}2&1\1&2end{bmatrix}}-lambda {begin{bmatrix}1&0\0&1end{bmatrix}}right|={begin{vmatrix}2-lambda &1\1&2-lambda end{vmatrix}}\[6pt]&=3-4lambda +lambda ^{2}\[6pt]&=(lambda -3)(lambda -1).end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/852afe30ae1c99b2f2ff91b62e226d28cef2609a)

![{displaystyle {begin{aligned}det(A-lambda I)&=left|{begin{bmatrix}2&0&0\0&3&4\0&4&9end{bmatrix}}-lambda {begin{bmatrix}1&0&0\0&1&0\0&0&1end{bmatrix}}right|={begin{vmatrix}2-lambda &0&0\0&3-lambda &4\0&4&9-lambda end{vmatrix}},\[6pt]&=(2-lambda){bigl [}(3-lambda)(9-lambda)-16{bigr ]}=-lambda ^{3}+14lambda ^{2}-35lambda +22.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bdfec3c58ac4306d8cc19110ac4b2b5bfbea234e)