Distribución logarítmica normal

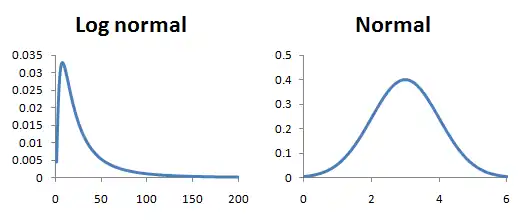

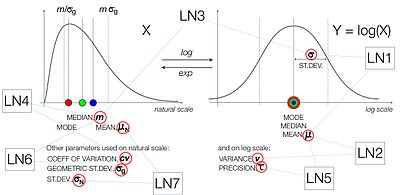

La distribución logarítmica normal o log-normal, es la representación estadística de una variable aleatoria cuya transformación logarítmica sigue una distribución normal. Es decir, si una variable aleatoria X tiene una distribución logarítmica normal, entonces Y = ln(X) tiene una distribución normal. Inversamente, si Y es una variable con distribución normal, entonces la función exponencial Y, X = exp(Y) seguirá una distribución logarítmica normal. Su representación se da en forma de distribución de probabilidad continua.

Este tipo de distribución es exclusiva para valores reales positivos y es conocida también como distribución de Galton, en honor a Francis Galton. La distribución logarítmica normal ha recibido otros nombres a lo largo de la historia, incluyendo McAlister, Gibrat y Cobb-Douglas. Su relevancia se debe a que representa el resultado estadístico de multiplicar muchas variables aleatorias independientes y positivas. Este fenómeno se explica a través del teorema del límite central en el contexto logarítmico, conocido también como la ley de Gibrat.

Por ello se aplica ampliamente en diversas ciencias exactas como las ingenierías, la medicina o la economía, siendo útil para modelar fenómenos que requieren representar valores altamente variables como pueden ser: la energía, concentraciones, longitudes o precios de instrumentos financieros.

Desde un punto de vista de la teoría de la información, la distribución logarítmica normal es particularmente importante. Se la considera como la distribución de probabilidad de máxima entropía para una variable aleatoria X, bajo la condición de que la media y la varianza de ln(X) estén predefinidas. De aquí su utilidad en el análisis estadístico y en la modelización de datos en diversas disciplinas.

HSD

Definiciones

Generación y parámetros

Vamos a considerar como una variable normal. Sea (mu) y > 0 (sigma mayor que cero) dos números reales. Luego, la distribución de la variable aleatoria se define por estos parámetros, donde es la media y es la desviación estándar de la distribución.

Luego, la distribución de la variable aleatoria

- X=eμ μ +σ σ Z{displaystyle X=e^{mu +sigma Z}

Se llama distribución log-normal con parámetros μ μ {displaystyle mu } y σ σ {displaystyle sigma }. Estos son el valor esperado (o medio) y la desviación estándar del logaritmo natural de la variable, no la expectativa y desviación estándar X{displaystyle X} en sí misma.

Esta relación es verdadera independientemente de la base de la función logarítmica o exponencial: si loga ()X){displaystyle log _{a}(X)} se distribuye normalmente, entonces lo es logb ()X){displaystyle log _{b}(X)} para cualquier dos números positivos a,bل ل 1{displaystyle a,bneq 1}. Del mismo modo, si eY{displaystyle e^{Y} está normalmente distribuida, entonces lo es aY{displaystyle a^{Y}, donde <math alttext="{displaystyle 00.aل ل 1{displaystyle 0 madeaneq 1}<img alt="{displaystyle 0.

Para producir una distribución con media deseada μ μ X{displaystyle mu _{X}} y diferencia σ σ X2{displaystyle sigma _{X}{2}}, uno utiliza

μ μ =In ()μ μ X2μ μ X2+σ σ X2){displaystyle mu =ln left({frac {mu {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} ¿Qué? - Sí. y σ σ 2=In ()1+σ σ X2μ μ X2).{displaystyle sigma ^{2}=ln left(1+{frac {sigma ¿Qué? - ¿Sí?

Alternativamente, los parámetros "multiplicativos" o "geométricos" μ μ Alternativa Alternativa =eμ μ {displaystyle mu ^{*}=e^{mu } y σ σ Alternativa Alternativa =eσ σ {displaystyle sigma ^{*}=e^{sigma } se puede utilizar. Tienen una interpretación más directa: μ μ Alternativa Alternativa {displaystyle mu ^{*} es la mediana de la distribución, y σ σ Alternativa Alternativa {displaystyle sigma ^{*} es útil para determinar intervalos de "scatter", ver a continuación.

Función de densidad de probabilidad

Una variable aleatoria positiva X está normalmente distribuida (es decir, X♪ ♪ Normal ()μ μ x,σ σ x2){displaystyle Xsim operatorname {Lognormal} (mu _{x},sigma _{x}^{2}}), si el logaritmo natural de X se distribuye normalmente con media μ μ {displaystyle mu } y diferencia σ σ 2{displaystyle sigma ^{2}:

- In ()X)♪ ♪ N()μ μ ,σ σ 2){displaystyle ln(X)sim {mathcal {N}(musigma ^{2}}

Vamos CCPR CCPR {displaystyle Phi } y φ φ {displaystyle varphi } ser respectivamente la función de distribución de probabilidad acumulativa y la función de densidad de probabilidad de la N(0,1) distribución, entonces tenemos que

- fX()x)=ddxPr()X≤ ≤ x)=ddxPr()In X≤ ≤ In x)=ddxCCPR CCPR ()In x− − μ μ σ σ )=φ φ ()In x− − μ μ σ σ )ddx()In x− − μ μ σ σ )=φ φ ()In x− − μ μ σ σ )1σ σ x=1xσ σ 2π π exp ()− − ()In x− − μ μ )22σ σ 2).{displaystyle {begin{aligned}f_{X}(x={frac {rm} {}{fn} {fnMicrosoft} {fnMicrosoft}} {fnMicrosoft}}} {fn}}} {fn}}} {fn}} {fn}}}} {fn}}}} {\fnf}}}}}} {\fnfn}}}}}}}}}}}}}}} {\\\\\\\\\\\fn\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\fn}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {}x}Pr(Xleq x)={frac {rm {}{fn} {fnMicrosoft} {fnMicrosoft}} {fnMicrosoft}}} {fn}}} {fn}}} {fn}} {fn}}}} {fn}}}} {\fnf}}}}}} {\fnfn}}}}}}}}}}}}}}} {\\\\\\\\\\\fn\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\fn}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {}x}Pr(ln Xleq ln x)={frac {rm {}{fn} {fnMicrosoft} {fnMicrosoft}} {fnMicrosoft}}} {fn}}} {fn}}} {fn}} {fn}}}} {fn}}}} {\fnf}}}}}} {\fnfn}}}}}}}}}}}}}}} {\\\\\\\\\\\fn\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\fn}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {d}x} Phi left({frac {ln x-mu }{sigma }right)[6pt] ¿Qué? {fnn x-mu}sigma}right)=varphi left({frac {ln x-mu }{sigma }}right)=varphi left({frac {ln x-mu }{cc}{c}{c} {c] {ccccccccc}cccccccccccccccH00}ccccccH00}ccH00}ccccccccccH00}ccH00}ccH00}}cH00}cccccH00}cH00}ccH00}ccH00}ccH00}cccc {sqrt {2pi}}}exp left(-{frac {ln x-mu)}{2sigma ^{2}}}derecho).end{aligned}}}}}}

Función de distribución acumulativa

La función de distribución acumulada es

- FX()x)=CCPR CCPR ()()In x)− − μ μ σ σ ){displaystyle F_{X}(x)= Phi left({frac {ln x)-mu }{sigma }right)}

Donde CCPR CCPR {displaystyle Phi } es la función de distribución acumulativa de la distribución normal estándar (es decir, N(0,1)).

Esto también se puede expresar de la siguiente manera:

- 12[1+er ()In x− − μ μ σ σ 2)]=12erfc ()− − In x− − μ μ σ σ 2){fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {f} {f} {f} {f}} {fn} {fn}fn}fnK} {fnf}fn} {fnMicroc {c}}}}fcfc} {fnf}f}f}fnfnfnfnfnf}fnf}f}fnfnfnfnh00}cfnhnhnhnfnhnf}fnh00}f}f}cfnhnhnhnfnhnhnfnfnfnhnhnhnhnhnh00}fnhnhnh00}fnhnhnhnhnhnhnhnhnhnhnh00}}

donde erfc es la función de error complementaria.

Logaritmo normal multivariante

Si X♪ ♪ N()μ μ ,.. ){displaystyle {boldsymbol {X}sim {n}({boldsymbol {mu}},,{boldsymbol {sigma }}}}}}}} es una distribución normal multivariada, entonces Yi=exp ()Xi){displaystyle Sí. tiene una distribución log-normal multivariada. El exponencial se aplica elemento aleatorio al vector aleatorio X{displaystyle {boldsymbol {X}}. La media de Y{displaystyle {bu}}} es

- E [Y]i=eμ μ i+12.. ii,{displaystyle operatorname {E} {Y}_{i}=e^{mu} ¿Por qué? {1}{2}Sigma ¿Qué?

y su matriz de covarianza es

- Var [Y]ij=eμ μ i+μ μ j+12().. ii+.. jj)()e.. ij− − 1).{displaystyle operatorname {Var} [{boldsymbol {Y}_{}=e} {fn} {fnK}} {fnK}} {fn}} {fn}}} {fn}}}f}} {fnfn}fnfnfn}}\fnf}}}\fnfnKf}}}}}\\\\\\\\f}}}}}}}\\\\\\\\\\\\\\\\\\\fn}}}}}}}}}}}}}}\\\\\\\fn}}}}}}\\\\\fn}}}}}}}}}}}}}}}}}}}\\\\\\\\\\\\ ¿Qué? ¿Por qué?

Dado que la distribución logarítmica normal multivariante no se usa mucho, el resto de esta entrada solo se ocupa de la distribución univariante.

Función característica y función generadora de momentos

Todos los momentos de la distribución log-normal existen y

- E [Xn]=enμ μ +n2σ σ 2/2{displaystyle operatorname [X^{n]=e^{nmu] # +n^{2}sigma ^{2}/2}

Esto se puede derivar dejando z=In ()x)− − ()μ μ +nσ σ 2)σ σ {displaystyle z={tfrac {ln(x)-(mu +nsigma ^{2}}{sigma } dentro de la integral. Sin embargo, la distribución log-normal no está determinada por sus momentos. Esto implica que no puede tener una función de generación de momento definida en un barrio de cero. De hecho, el valor esperado E [etX]{displaystyle operatorname {E} [e^{tX}} no se define para ningún valor positivo del argumento t{displaystyle t}, desde las divergencias integrales definidas.

Función característica E [eitX]{displaystyle operatorname {E} [e^{itX}} se define para valores reales de t, pero no se define para ningún valor complejo t que tiene una parte imaginaria negativa, y por lo tanto la función característica no es analítica en el origen. En consecuencia, la función característica de la distribución log-normal no puede ser representada como una serie convergente infinita. En particular, su serie formal de Taylor se divierte:

- .. n=0JUEGO JUEGO ()it)nn!enμ μ +n2σ σ 2/2{displaystyle sum _{n=0} {infty}{frac {(it)^{n}{n}}e^{nmu} # +n^{2}sigma ^{2}/2}

Sin embargo, se han obtenido varias representaciones alternativas de series divergentes.

Una fórmula de forma cerrada para la función característica φ φ ()t){displaystyle varphi (t)} con t{displaystyle t} en el dominio de la convergencia no se conoce. Una fórmula aproximada relativamente simple está disponible en forma cerrada, y es dada por

- φ φ ()t).. exp ()− − W2()− − itσ σ 2eμ μ )+2W()− − itσ σ 2eμ μ )2σ σ 2)1+W()− − itσ σ 2eμ μ ){displaystyle varphi (t)approx {frac {expleft(-{frac {W^{2}(-itsigma ^{2}e^{mu })+2W(-itsigma {2}}} {sqrt {1+W(-itsigma

Donde W{displaystyle W. es la función Lambert W. Esta aproximación se deriva a través de un método asintotico, pero permanece afilada por todo el dominio de convergencia de φ φ {displaystyle varphi }.

Propiedades

Probabilidad en diferentes dominios

El contenido de probabilidad de una distribución logarítmica normal en cualquier dominio arbitrario se puede calcular con la precisión deseada transformando primero la variable en normal y luego integrando numéricamente mediante el método de trazado de rayos. (código de Matlab)

Probabilidades de funciones de una variable log-normal

Dado que la probabilidad de una log-normal se puede calcular en cualquier dominio, esto significa que la cdf (y, en consecuencia, la pdf y la cdf inversa) de cualquier función de una variable log-normal también se puede calcular. (código de Matlab)

Momentos geométricos o multiplicativos

La media geométrica o multiplicativa de la distribución log-normal es MM [X]=eμ μ =μ μ Alternativa Alternativa {displaystyle operatorname {GM} [X]=e^{mu }=mu ^{*}. Es igual a la mediana. La desviación estándar geométrica o multiplicativa es GSD [X]=eσ σ =σ σ Alternativa Alternativa {displaystyle operatorname {GSD} [X]=e^{sigma }=sigma ^{*}.

Por analogía con las estadísticas aritméticas, se puede definir una varianza geométrica, GVar [X]=eσ σ 2{displaystyle operatorname {GVar} [X]=e^{sigma ^{2}}, y un coeficiente geométrico de variación, GCV [X]=eσ σ − − 1{displaystyle operatorname {GCV} [X]=e^{sigma }-1}, se ha propuesto. Este término tenía por objeto análogo al coeficiente de variación, para describir la variación multiplicativa de los datos log-normales, pero esta definición de GCV no tiene base teórica como estimación de CV{displaystyle operatorname {CV} (ver también Coeficiente de variación).

Tenga en cuenta que la media geométrica es más pequeña que la media aritmética. Esto se debe a la desigualdad AM-GM y es consecuencia de que el logaritmo es una función cóncava. De hecho,

- E [X]=eμ μ +12σ σ 2=eμ μ ⋅ ⋅ eσ σ 2=MM [X]⋅ ⋅ GVar [X].{displaystyle operatorname {E} [X]=e^{mu +{frac {1}{2}sigma ^{2}=e^{mu } 'cdot {sqrt {e^{sigma - ¿Qué? {GM} [X]cdot {sqrt {fnMicrosoft Sans Serif}}}}

En finanzas, el término e− − 12σ σ 2{displaystyle e^{-{frac {2}sigma ^{2}} a veces se interpreta como una corrección de convexidad. Desde el punto de vista del cálculo estocástico, este es el mismo término correccional que en la lema de Itō para el movimiento marroniano geométrico.

Momentos aritméticos

Para cualquier número real o complejo n, el n-ésimo momento de una variable con distribución logarítmica normal X está dada por

- E [Xn]=enμ μ +12n2σ σ 2.{displaystyle operatorname [X^{n]=e^{nmu] - ¿Qué?

Específicamente, la media aritmética, el cuadrado esperado, la varianza aritmética y la desviación estándar aritmética de una variable con distribución logarítmica normal X están dadas respectivamente por:

- E [X]=eμ μ +12σ σ 2,E [X2]=e2μ μ +2σ σ 2,Var [X]=E [X2]− − E [X]2=()E [X])2()eσ σ 2− − 1)=e2μ μ +σ σ 2()eσ σ 2− − 1),SD [X]=Var [X]=E [X]eσ σ 2− − 1=eμ μ +12σ σ 2eσ σ 2− − 1,{displaystyle {begin{aligned}operatorname {E} [X] {1}{2}sigma ^{2}},\[4pt]operatorname [X^{2}] [E] [X^{2]] [E] [X]^{2}= {E} [X]} {2}(e^{sigma] ^{2}-1)=e^{2mu +sigma ^{2}(e^{sigma ^{2}-1),\[4pt]operatorname {SD} [X] {Var} [X]}= [X]{sqrt {sigma} ¿Qué? {fnMicroc {2}}sigma }{2} {sqrt {sigma ^{2}}}}}}}}end{aligned}}}

El coeficiente aritmético de variación CV [X]{displaystyle operatorname {CV} [X] es la relación SD [X]E [X]{displaystyle {tfrac {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\fnMicrosoft {fnMicrosoft {fnMicrosoft {\fnMicrosoft {\fnMicrosoft {fnMicrosoft {fnMicrosoft {\\fnMicrosoft {\fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\\fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\\fnMicrosoft {\\\\fnMicrosoft {fnMicrosoft [X] {fnMicrosoft Sans Serif} {E} [X]}}. Para una distribución log-normal es igual a

- CV [X]=eσ σ 2− − 1.{displaystyle operatorname {CV} [X]={sqrt {e^{sigma - Sí.

Esta estimación a veces se denomina "CV geométrico" (GCV), debido a su uso de la varianza geométrica. Al contrario de la desviación estándar aritmética, el coeficiente de variación aritmético es independiente de la media aritmética.

Se pueden obtener los parámetros μ y σ, si se conocen la media aritmética y la varianza aritmética:

- μ μ =In ()E [X]2E [X2])=In ()E [X]2Var [X]+E [X]2),σ σ 2=In ()E [X2]E [X]2)=In ()1+Var [X]E [X]2).{displaystyle {begin{aligned}mu} <ln left({frac {operatorname {E} [X]^{2}{sqrt {fnMicrosoft} {E} [X^{2}}}right)=ln left({frac {operatorname {E} [X]^{2}{sqrt {fnMicrosoft} [X] + 'operadorname {E} [X]^{2}}}derecha),[4pt]sigma ^{2} limit=ln left({frac {operatorname [E] [X^{2]} {fnMiembro del operador {E} [X]^{2}}right)=ln left(1+{frac {operatorname [X] {fnMicrosoft Sans Serif} Bien.

Una distribución de probabilidad no está determinada únicamente por los momentos E[Xn] = enμ + 1/2n2σ2 para n ≥ 1. Es decir, existen otras distribuciones con el mismo conjunto de momentos. De hecho, existe toda una familia de distribuciones con los mismos momentos que la distribución log-normal.

Moda, mediana, cuantiles

El modo es el punto máximo global de la función de densidad de probabilidad. En particular, resolviendo la ecuación ()In f).=0{displaystyle (ln f)'=0}, lo entendemos:

- Modo [X]=eμ μ − − σ σ 2.{displaystyle operatorname {Mode} [X]=e^{mu] - ¿Qué?

Desde la variable traducida por el registro Y=In X{displaystyle Y=ln X} tiene una distribución normal, y los quantiles se conservan bajo transformaciones monotónicas, los quantiles de X{displaystyle X} son

- qX()α α )=eμ μ +σ σ qCCPR CCPR ()α α )=μ μ Alternativa Alternativa ()σ σ Alternativa Alternativa )qCCPR CCPR ()α α ),{displaystyle q_{X}(alpha)=e^{mu ##sigma q_{Phi }=mu ^{*}(sigma ^{*})^{q_{\phi }(alpha)}}}}

Donde qCCPR CCPR ()α α ){displaystyle q_{Phi }(alpha)} es el cuntil de la distribución normal estándar.

Específicamente, la mediana de una distribución logarítmica normal es igual a su media multiplicativa,

- Med [X]=eμ μ =μ μ Alternativa Alternativa .{displaystyle operatorname {Med} [X]=e^{mu }=mu ^{*}

Expectativa parcial

La expectativa parcial de una variable aleatoria X{displaystyle X} con respecto a un umbral k{displaystyle k} se define como

Alternativamente, utilizando la definición de expectativa condicional, se puede escribir como ![{\displaystyle g(k)=\operatorname {E} [X\mid X>k]P(X>k)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dcc597040aafacac51656980faecab241210cd32)

Donde CCPR CCPR {displaystyle Phi } es la función de distribución acumulativa normal. La derivación de la fórmula se proporciona en la página Talk. La fórmula de expectativa parcial tiene aplicaciones en seguros y economía, se utiliza para resolver la ecuación diferencial parcial que conduce a la fórmula Black-Scholes.

Expectativa condicional

La expectativa condicional de una variable aleatoria normal de registro X{displaystyle X}con respecto a un umbral k{displaystyle k}— es su expectativa parcial dividida por la probabilidad acumulativa de estar en ese rango:

- <math alttext="{displaystyle {begin{aligned}E[Xmid XE[X▪ ▪ X.k]=eμ μ +σ σ 22⋅ ⋅ CCPR CCPR [In ()k)− − μ μ − − σ σ 2σ σ ]CCPR CCPR [In ()k)− − μ μ σ σ ]E[X▪ ▪ X⩾ ⩾ k]=eμ μ +σ σ 22⋅ ⋅ CCPR CCPR [μ μ +σ σ 2− − In ()k)σ σ ]1− − CCPR CCPR [In ()k)− − μ μ σ σ ]E[X▪ ▪ X▪ ▪ [k1,k2]]=eμ μ +σ σ 22⋅ ⋅ CCPR CCPR [In ()k2)− − μ μ − − σ σ 2σ σ ]− − CCPR CCPR [In ()k1)− − μ μ − − σ σ 2σ σ ]CCPR CCPR [In ()k2)− − μ μ σ σ ]− − CCPR CCPR [In ()k1)− − μ μ σ σ ]{displaystyle {begin{aligned}E[Xmid Xierek] {fnMicroc {fnK}}cdot {fnfnK}cdot {fnsigma}{sigma} {sigma} {sigma}}sigma}}derecha]}{m}}}{c}} {cH0}}}}}}} {c}}}}} {c}}}}}}}}}} { Phi left[{frac {ln(k)-mu }{sigma }right]}[8pt]E[Xmid Xgeqslant k] {fnMicroc {sigma }{2}}cdot {frac {Phi left[{frac {mu}}}}cdot {frac {fnMicroc {fnMicroc {c}}}}}cdot {cdot {fnMicroc {cccccccccHcHccccHcHcccHcHcHcHcHcHcHcHcHcHcHcHcHsigmacHcHcHcHcHccHcccHcccHccHcHcHcHcHcHcHcHccHcHcHcHcHccH {fnMicrosoft Sans Serif} Phi left [{ln(k_{2})-mu }{sigma }right]-Phi left[{frac {ln(k_{1})-mu }{sigma }right]}}end{aligned}}}}}}}}}}}}<img alt="{displaystyle {begin{aligned}E[Xmid X

Parametrizaciones alternativas

Además de la caracterización por μ μ ,σ σ {displaystyle musigma } o μ μ Alternativa Alternativa ,σ σ Alternativa Alternativa {displaystyle mu ^{*},sigma ^{*}, aquí hay múltiples formas de cómo la distribución normal de registro puede ser parametizada. ProbOnto, la base de conocimientos y la ontología de las distribuciones de probabilidad enumera siete formas:

- LogNormal1(μ,σ) con media, μ, y desviación estándar, σ, ambos en la escala de registro

- P()x;μ μ ,σ σ )=1xσ σ 2π π exp [− − ()In x− − μ μ )22σ σ 2]{fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif}} {fnMicroc {fn}}}} {fnK}}}}}}fnK}}}fnK} {fnK}} {f}}}fnfnfnfnK} {f}} {f}}}}}}}}}}}f}f}}}}f}}}f}f}}f}}f}f}}}f}f}f}f}}fnf}f}f}}}f}f}}f}}f}}fnf}}}}}}}}}f}b}f}f}f}f}}}fnfnfnfnMinMinfnfnKf}fnf}}}}fn

- LogNormal2(μ,you) con media, μ, y varianza, ambos en la escala de registro

- P()x;μ μ ,v)=1xv2π π exp [− − ()In x− − μ μ )22v]{fnMicrosoft Sans Serif} {fnK}} {fnMicroc {fnMicroc {f}{sqrt {f}} {sqrt {2pi}}f}fnfnf} {fnMicroc {f} {fnK}} {f}}}}}}f}}f}f}}}f}f}f}f}}}f}f}f}f}f}}}}}f}f}f}f}f}f}f}f}}f}f}f}f}f}}}f}f}f}}}}}f}}f}f}f}f}f}f}f}}}fnf}f}f}}f}f}}f}}}}}}}fn

- LogNormal3(m,σ) con mediana, m, a escala natural y desviación estándar, σ, en la escala de registro

- P()x;m,σ σ )=1xσ σ 2π π exp [− − In2 ()x/m)2σ σ 2]{fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicroc {}}} {fn} {fnMicroc} {sqrt {2pi}}}}}fnMicroc {m} {fnMicroc {fnMicroc} {fnMicrosoft}}} {f}}}}}}}} {f}}}}}}}}}}f}f}f}}f}f}f}f}f}f}f}fnKf} {f}f}f}f}f}f}f}f}fnKf}}}fnun}f}f}fnun}fnKf}}fnun}fnun}fnun}fnun}fnKfnun}}}}}}}fnMi

- LogNormal4(m,cv) con mediana, m y coeficiente de variación, cv, ambos en la escala natural

- P()x;m,cv)=1xIn ()cv2+1)2π π exp [− − In2 ()x/m)2In ()cv2+1)]{fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif}} {fn} {fn}} {fn}} {fn}}} {fn}}} {fn}}} {fn}} {c}}}} {c} {c}}}}} {m}} {m}}} {c}}}}}} {c}}} {c}}}}}}}}} {c} {c} {c}}}}} {c}}}}}}}}}}}}}}}}}}} {c}}}}}}}}}} {f} {f} {f} {fn}}}}}}}}}} {f}}}}f}f} {f}}}}}}}}}}}f}f}}}}}}}}}f}}}}}}}}}

- LogNormal5(μ,τ) con media, μ, y precisión, τ, ambos en la escala de registro

- P()x;μ μ ,τ τ )=τ τ 2π π 1xexp [− − τ τ 2()In x− − μ μ )2]{displaystyle P(x;{boldsymbol {mu },{boldsymbol {tau }}={sqrt {frac {tau }{2pi {fnK} {fnK} {fnK} {fnMicroc {tau }} {ln x-mu)}}}}} {fnm}}}}}} {fnfnfn}}} {fnfnfnfnfnK}}}}}} {f}}}}fnfnfnfnfnfnfnfnfnfnfnfnfnfnfnKfnfnKfnfnfnKfnfnfnfnKfnfnKfnKfnfn}}fnfnfnfnfnfnfnfnfn}fnfnfnfn}fnKfnfnfn}}}fn

- LogNormal6(m,σg) con mediana, m, y geométrica desviación estándar, σg, ambos en la escala natural

- P()x;m,σ σ g)=1xIn ()σ σ g)2π π exp [− − In2 ()x/m)2In2 ()σ σ g)]{displaystyle P(x;{boldsymbol {m},{boldsymbol {sigma _{}}={frac {1}{xln(sigma _{g}{sqrt {2pi}}}}exp left[-{frac {ln ^{2}(x/m)}{2ln } {sigma}}}} {sigma}}}}}} {sigma}}}}}}}}}}}}} {sigma}}}}}}}}}} {sigma}}}}}}}}}}}}}} {sigma}}}}}}}}}}}}}} {sigma}}}} {g}}}}}}} {sigma}}}} {g}}}} {g}}}}}}}}}}}}}}}}}}}}} {sigma}}}}}}}}}}}}} {sigma}}}}}}

- LogNormal7(μ)NσNCon media, μN, y desviación estándar, σN, ambos en la escala natural

- P()x;μ μ N,σ σ N)=1x2π π In ()1+σ σ N2/μ μ N2)exp ()− − [In x− − In μ μ N1+σ σ N2/μ μ N2]22In ()1+σ σ N2/μ μ N2)){displaystyle P(x;{boldsymbol # ♪♪ {sigma {fn})={fn}{x{sqrt {2pi ln left(1+sigma ¿Por qué? {fn}}}exp left(-{frac {fnK}ln x-ln {fnMic {fnMic {cHFF} {fn}{sqrt {1+sigma ¿Por qué? ¿Qué? Grande. ¿Por qué? - ¿Sí?

Ejemplos de reparametrización

Considere la situación en la que le gustaría ejecutar un modelo utilizando dos herramientas de diseño óptimas diferentes, por ejemplo, PFIM y PopED. El primero soporta la parametrización LN2, el segundo LN7, respectivamente. Por lo tanto, se requiere la reparametrización, de lo contrario, las dos herramientas producirían resultados diferentes.

Para la transición LN2 ()μ μ ,v)→ → LN7 ()μ μ N,σ σ N){displaystyle operatorname {LN2}(muv)to operatorname {LN7} (mu _{N},sigma _{N})} posponer las fórmulas siguientes μ μ N=exp ()μ μ +v/2){textstyle mu _{N}=exp(mu +v/2)} y σ σ N=exp ()μ μ +v/2)exp ()v)− − 1{textstyle sigma ¿Por qué?.

Para la transición LN7 ()μ μ N,σ σ N)→ → LN2 ()μ μ ,v){displaystyle operatorname {LN7} (mu _{N},sigma _{N})to operatorname {LN2} (muv)} posponer las fórmulas siguientes μ μ =In ()μ μ N/1+σ σ N2/μ μ N2){textstyle mu =ln left(mu ¿Por qué? ¿Por qué? ¿Qué? y v=In ()1+σ σ N2/μ μ N2){textstyle v=ln(1+sigma ¿Qué?.

Todas las fórmulas de reparametrización restantes se pueden encontrar en el documento de especificaciones en el sitio web del proyecto.

Múltiple, recíproco, potencia

- Multiplicación por una constante: Si X♪ ♪ Normal ()μ μ ,σ σ 2){displaystyle Xsim operatorname {Lognormal} (musigma ^{2})} entonces aX♪ ♪ Normal ()μ μ +In a,σ σ 2){displaystyle aXsim operatorname {Lognormal} (mu +ln a, sigma ^{2})} para 0.}" xmlns="http://www.w3.org/1998/Math/MathML">a■0.{displaystyle a confiar0.}

0.}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/47586c689085690d15621968c72a61073b32357e" style="vertical-align: -0.338ex; width:6.138ex; height:2.176ex;"/>

- Recíproco: Si X♪ ♪ Normal ()μ μ ,σ σ 2){displaystyle Xsim operatorname {Lognormal} (musigma ^{2})} entonces 1X♪ ♪ Normal ()− − μ μ ,σ σ 2).{fnMicroc} {1}{X}sim operatorname {Lognormal} (-mu sigma ^{2}). }

- Poder: Si X♪ ♪ Normal ()μ μ ,σ σ 2){displaystyle Xsim operatorname {Lognormal} (musigma ^{2})} entonces Xa♪ ♪ Normal ()aμ μ ,a2σ σ 2){displaystyle X^{a}sim operatorname {Lognormal} (amu a^{2}sigma ^{2}} para aل ل 0.{displaystyle aneq 0}

Multiplicación y división de variables aleatorias logarítmicas normales e independientes

Si dos variables independientes, log-normal X1{displaystyle X_{1} y X2{displaystyle X_{2} son multiplicados [divididos], el producto [ratio] es de nuevo log-normal, con parámetros μ μ =μ μ 1+μ μ 2{displaystyle mu =mu _{1}+mu _{2} [μ μ =μ μ 1− − μ μ 2{displaystyle mu =mu ¿Qué? ¿Qué?] y σ σ {displaystyle sigma }, donde σ σ 2=σ σ 12+σ σ 22{displaystyle sigma ^{2}=sigma ¿Qué? ¿Qué?. Esto se generaliza fácilmente al producto de n{displaystyle n} tales variables.

Más generalmente, si Xj♪ ♪ Normal ()μ μ j,σ σ j2){displaystyle X_{j}sim operatorname Lognormal. son n{displaystyle n} variables independientes, normalmente distribuidas por registros, entonces Y=∏ ∏ j=1nXj♪ ♪ Normal ().. j=1nμ μ j,.. j=1nσ σ j2).{displaystyle Y=textstyle prod ################################################################################################################################################################################################################################################################ {Lognormal} {Big (}textstyle sum _{j=1}{n}mu _{j},sum _{j=1}n}sigma _{j}{2}{2}{Big)}

Teorema del límite central multiplicativo

La media geométrica o multiplicativa de n{displaystyle n} variables aleatorias positivas, independientes, distribuidas idénticamente Xi{displaystyle X_{i} espectáculos, para n→ → JUEGO JUEGO {displaystyle nto infty } aproximadamente una distribución log-normal con parámetros μ μ =E[In ()Xi)]{displaystyle mu =E[ln(X_{i})} y σ σ 2=Var[In ()Xi)]/n{displaystyle sigma ^{2}={mbox{var}[ln(X_{i})]/n}, suponiendo σ σ 2{displaystyle sigma ^{2} es finito.

De hecho, las variables aleatorias no tienen que ser distribuidas de forma idéntica. Es suficiente para las distribuciones de In ()Xi){displaystyle ln(X_{i})} a todos tienen varianza finita y satisfacen las otras condiciones de cualquiera de las muchas variantes del teorema límite central.

Esto se conoce comúnmente como la ley de Gibrat.

Otro

Un conjunto de datos que surge de la distribución logarítmica normal tiene una curva de Lorenz simétrica (consulte también el coeficiente de asimetría de Lorenz).

El armónico H{displaystyle H., geométrico G{displaystyle G. y aritmética A{displaystyle A} medios de esta distribución están relacionados; dicha relación se da por

- H=G2A.{displaystyle H={frac {G^{2}{A}}}

Las distribuciones logarítmicas normales son infinitamente divisibles, pero no son distribuciones estables de las que se pueda extraer fácilmente.

Distribuciones relacionadas

- Si X♪ ♪ N()μ μ ,σ σ 2){displaystyle Xsim {mathcal {N}(musigma ^{2}} es una distribución normal, entonces exp ()X)♪ ♪ Normal ()μ μ ,σ σ 2).{displaystyle exp(X)sim operatorname {Lognormal} (musigma ^{2}). }

- Si X♪ ♪ Normal ()μ μ ,σ σ 2){displaystyle Xsim operatorname {Lognormal} (musigma ^{2})} se distribuye tronco-normalmente, luego In ()X)♪ ♪ N()μ μ ,σ σ 2){displaystyle ln(X)sim {mathcal {N}(musigma ^{2}} es una variable aleatoria normal.

- Vamos Xj♪ ♪ Normal ()μ μ j,σ σ j2){displaystyle X_{j}sim operatorname Lognormal. ser variables independientes distribuidas normalmente con posiblemente variable σ σ {displaystyle sigma } y μ μ {displaystyle mu } parámetros y Y=.. j=1nXj{textstyle Y=sum ¿Qué?. La distribución de Y{displaystyle Sí. no tiene expresión de forma cerrada, pero puede ser razonablemente aproximado por otra distribución log-normal Z{displaystyle Z} en la cola derecha. Su función de densidad de probabilidad en el barrio de 0 se ha caracterizado y no se asemeja a ninguna distribución log-normal. Una aproximación comúnmente utilizada por L.F. Fenton (pero previamente declarada por R.I. Wilkinson y matemática justificada por Marlow) se obtiene al igualar la media y varianza de otra distribución log-normal:

σ σ Z2=In[.. e2μ μ j+σ σ j2()eσ σ j2− − 1)().. eμ μ j+σ σ j2/2)2+1],μ μ Z=In[.. eμ μ j+σ σ j2/2]− − σ σ Z22.{displaystyle {begin{aligned}sigma ################################################################################################################################################################################################################################################################ {cHFF} e^{2mu ¿Por qué? _{j}+sigma ¿Por qué? _{j}+sigma ¿Por qué? {fnMicrosoft Sans Serif}

En caso de que todo Xj{displaystyle X_{j} tienen el mismo parámetro de varianza σ σ j=σ σ {displaystyle sigma _{j}=sigma }, estas fórmulas simplifican

σ σ Z2=In[()eσ σ 2− − 1).. e2μ μ j().. eμ μ j)2+1],μ μ Z=In[.. eμ μ j]+σ σ 22− − σ σ Z22.{displaystyle {begin{aligned}sigma ################################################################################################################################################################################################################################################################ {fnK} {fnMicrosoft Sans Serif}\fnMicrosoft Sans Serif],\\mnfncnfnfnfnfnfnfnMicrosoft Sans Serif}m]+{sigma} ¿Qué? {sigma {fnMicrosoft Sans Serif}

Para una aproximación más precisa, se puede utilizar el método de Monte Carlo para estimar la función de distribución acumulativa, la función de densidad de probabilidad y la cola derecha.

La suma de las variables aleatorias correlacionadas con distribución logarítmica normal también se puede aproximar mediante una distribución logarítmica normal

- Si X♪ ♪ Normal ()μ μ ,σ σ 2){displaystyle Xsim operatorname {Lognormal} (musigma ^{2})} entonces X+c{displaystyle X+c} se dice que tiene un Normal de troncos de tres parámetros distribución con apoyo x▪ ▪ ()c,+JUEGO JUEGO ){displaystyle xin (c,+infty)}. E [X+c]=E [X]+c{displaystyle operatorname [E] [X+c]= [X]+c], Var [X+c]=Var [X]{displaystyle operatorname [X+c]= [X].

- La distribución log-normal es un caso especial de la SU-distribución de Johnson semi-boteada.

- Si X▪ ▪ Y♪ ♪ Rayleigh ()Y){displaystyle Xmid Ysim operatorname {Rayleigh} (Y)} con Y♪ ♪ Normal ()μ μ ,σ σ 2){displaystyle Ysim operatorname {Lognormal} (musigma ^{2})}, entonces X♪ ♪ Suzuki ()μ μ ,σ σ ){displaystyle Xsim operatorname {Suzuki} (musigma)} (Distribución Suzuki).

- Un sustituto de lo log-normal cuya integral se puede expresar en términos de funciones más elementales se puede obtener basado en la distribución logística para obtener una aproximación para el CDF

F()x;μ μ ,σ σ )=[()eμ μ x)π π /()σ σ 3)+1]− − 1.{displaystyle F(x;musigma)=left[left({frac {e^{musigma) {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif}} {f}}} {fn}}} {fnK}} {fnMicrosoft}}}}}derecho}derecho)} {fnMientras)}sigma {f}sigma {f}sigma {f}f}sigma}f}f}sigma}f}f}f}sigma}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}fnun}f}f}f}fnMinMinMinun}f}fnun}fnun}fnun}f}f}s}fnun}f}fnMin {3})}+1right]^{-1}

Esta es una distribución logística de troncos.

Inferencia estadística

Estimación de parámetros

Para determinar los estimadores de máxima verosimilitud de los parámetros de distribución log-normal μ y σ, podemos utilizar el mismo procedimiento que para la distribución normal. Tenga en cuenta que

φ φ {displaystyle varphi }N()μ μ ,σ σ 2){displaystyle {mathcal {N}(musigma ^{2}}

Puesto que el primer término es constante con respecto a μ y σ, ambas funciones de probabilidad logarítmica, l l {displaystyle ell } y l l N{displaystyle ell _{N}, alcanzar su máximo con el mismo μ μ {displaystyle mu } y σ σ {displaystyle sigma }. Por lo tanto, los estimadores de probabilidad máxima son idénticos a los para una distribución normal de las observaciones In x1,In x2,...... ,In xn){displaystyle ln x_{1},ln x_{2},dotsln x_{n}},

Para finito n, el estimador μ μ {displaystyle mu } es imparcial, pero el para σ σ {displaystyle sigma } es parcial. En cuanto a la distribución normal, un estimador imparcial para σ σ {displaystyle sigma } puede obtenerse reemplazando el denominador n por n−1 en la ecuación σ σ ^ ^ 2{displaystyle {widehat {sigma } {2}.

Cuando los valores individuales x1,x2,...... ,xn{displaystyle x_{1},x_{2},ldotsx_{n} no están disponibles, pero la media de la muestra x̄ ̄ {displaystyle {bar {x}} y desviación estándar s es, entonces los parámetros correspondientes se determinan por las siguientes fórmulas, obtenidas de la resolución de las ecuaciones para la expectativa E [X]{displaystyle operatorname {E} [X]} y diferencia Var [X]{displaystyle operatorname [X] para μ μ {displaystyle mu } y σ σ {displaystyle sigma }:

Estadísticas

La forma más eficiente de analizar datos con distribución logarítmica normal consiste en aplicar los métodos bien conocidos basados en la distribución normal a datos transformados logarítmicamente y luego transformar los resultados hacia atrás, si corresponde.

Intervalos de dispersión

Un ejemplo básico es dado por intervalos de dispersión: Para la distribución normal, el intervalo [μ μ − − σ σ ,μ μ +σ σ ]{displaystyle [mu -sigmamu +sigma]} contiene aproximadamente dos tercios (68%) de la probabilidad (o de una muestra grande), y [μ μ − − 2σ σ ,μ μ +2σ σ ]{displaystyle [mu -2sigmamu +2sigma]} Contiene el 95%. Por lo tanto, para una distribución log-normal

Intervalo de confianza para μ*

Utilizando el principio, note que un intervalo de confianza μ μ {displaystyle mu } es [μ μ ^ ^ ± ± q⋅ ⋅ se^ ^ ]{displaystyle [{widehat {mu }pm qcdot {widehat {mathop {se}}}}}}, donde se=σ σ ^ ^ /n{displaystyle mathop {se} #{widehat {sigma }/{sqrt {n}} es el error estándar y q es el 97,5% cuntil de una distribución t con n-1 grados de libertad. La transferencia trasera conduce a un intervalo de confianza para μ μ Alternativa Alternativa {displaystyle mu ^{*},

semAlternativa Alternativa =()σ σ ^ ^ Alternativa Alternativa )1/n{displaystyle operatorname {sem}= {sigma}}^{1/{sqrt {}}

Principio de entropía extrema para fijar el parámetro libre σ

En aplicaciones, σ σ {displaystyle sigma } es un parámetro a determinar. Para los procesos crecientes equilibrados por la producción y la disipación, el uso de un principio extremal de la entropía Shannon muestra que

Este valor se puede utilizar para dar alguna relación de escalado entre el punto de inflexión y el punto máximo de la distribución log-normal. Esta relación está determinada por la base del logaritmo natural, e=2.718...... {displaystyle e=2.718ldots}, y exhibe cierta similitud geométrica al principio mínimo de energía superficial.

Estas relaciones de escalado son útiles para predecir una serie de procesos de crecimiento (difusión epidémica, brote de gotas, crecimiento de la población, tasa de agitación de la bañera vortex, distribución de caracteres de lenguaje, perfil de velocidad de turbulencias, etc.).

Por ejemplo, la función log-normal con tal σ σ {displaystyle sigma } encaja bien con el tamaño de gotitas producidos de segunda vez durante el impacto de gotas y la propagación de una enfermedad epidémica.

El valor σ σ =1/6{textstyle sigma =1{big /}{sqrt {6}} se utiliza para proporcionar una solución probabilística para la ecuación de Drake.

Ocurrencia y aplicaciones

La distribución log-normal es importante en la descripción de los fenómenos naturales. Muchos procesos de crecimiento natural son impulsados por la acumulación de muchos pequeños cambios porcentuales que se vuelven aditivos en una escala logarítmica. En condiciones de regularidad apropiadas, la distribución de los cambios acumulados resultantes se aproximará cada vez más mediante un logaritmo normal, como se indica en la sección anterior sobre el "Teorema del límite central multiplicativo". Esto también se conoce como la ley de Gibrat, en honor a Robert Gibrat (1904-1980), quien la formuló para las empresas. Si la tasa de acumulación de estos pequeños cambios no varía con el tiempo, el crecimiento se vuelve independiente del tamaño. Incluso si esta suposición no es cierta, las distribuciones de tamaño a cualquier edad de las cosas que crecen con el tiempo tienden a ser logarítmicamente normales. En consecuencia, los rangos de referencia para las mediciones en individuos sanos se estiman con mayor precisión asumiendo una distribución logarítmica normal que asumiendo una distribución simétrica alrededor de la media.

Una segunda justificación se basa en la observación de que las leyes naturales fundamentales implican multiplicaciones y divisiones de variables positivas. Algunos ejemplos son la simple ley de la gravitación que conecta las masas y la distancia con la fuerza resultante, o la fórmula para las concentraciones de equilibrio de sustancias químicas en una solución que conecta las concentraciones de eductos y productos. Asumir distribuciones logarítmicas normales de las variables involucradas conduce a modelos consistentes en estos casos.

En las siguientes subsecciones se dan ejemplos específicos.

Comportamiento humano

- La longitud de los comentarios publicados en los foros de discusión en Internet sigue una distribución log-normal.

- El tiempo de permanencia de los usuarios en los artículos en línea (juegos, noticias, etc.) sigue una distribución log-normal.

- La longitud de los juegos de ajedrez tiende a seguir una distribución normal de registro.

- Las duraciones de inicio de estímulos de comparación acústica que coinciden con un estímulo estándar siguen una distribución log-normal.

- El Cubo de Rubik soluciona, tanto en general como en persona, parece seguir una distribución log-normal.

Biología y medicina

- Medidas de tamaño del tejido vivo (longitud, área de la piel, peso).

- En el caso de epidemias altamente comunicables, como el SARS en 2003, si se aplican políticas de control de intervención pública, se muestra que el número de casos hospitalizados satisface la distribución normal de registros sin parámetros gratuitos si se asume una entropía y la desviación estándar se determina por el principio de la tasa máxima de producción de entropía.

- La longitud de los apéndices inertes (hair, garras, uñas, dientes) de los especímenes biológicos, en la dirección del crecimiento.

- El recuento normalizado de ARN-Seq para cualquier región genómica puede ser muy aproximado por distribución log-normal.

- La secuenciación de PacBio lee la longitud sigue una distribución normal de troncos.

- Ciertas mediciones fisiológicas, como la presión arterial de los seres humanos adultos (después de la separación en subpoblaciones masculinas/mujeres).

- Varias variables farmacocinéticas, como Cmax, eliminación de la vida media y la tasa de eliminación constante.

- En neurociencia, la distribución de los índices de disparos a través de una población de neuronas es a menudo aproximadamente lógico-normal. Esto se ha observado por primera vez en la corteza y estriato y más tarde en hipocampo y corteza entorrinolarante, y en otras partes del cerebro. Además, las distribuciones de ganancia intrínseca y las distribuciones de peso sináptico también parecen ser logística-normales.

- En la gestión de las salas de operaciones, la distribución de la duración de la cirugía.

- En el tamaño de las avalanchas de fracturas en el citoesqueleto de células vivas, mostrando distribuciones log-normales, con un tamaño significativamente mayor en las células cancerosas que las sanas.

Química

En química, la distribución logarítmica normal se usa para modelar distribuciones de tamaño de partículas y distribuciones de masa molar.

Hidrología

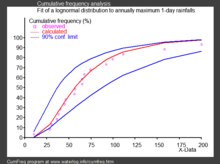

- En la hidrología, se utiliza la distribución log-normal para analizar valores extremos de variables como valores máximos mensuales y anuales de precipitaciones diarias y volúmenes de descarga de ríos.

-

- La imagen de la derecha, realizada con CumFreq, ilustra un ejemplo de equiparación de la distribución log-normal para clasificar anualmente las precipitaciones máximas de un día que muestran también el cinturón de confianza del 90% basado en la distribución binomio.

-

- Los datos de precipitaciones están representados por posiciones de trama como parte de un análisis de frecuencia acumulativa.

Ciencias sociales y demografía

- En economía, hay evidencia de que los ingresos del 97% al 99% de la población se distribuyen de forma normalizada. (La distribución de personas de ingresos superiores sigue una distribución de Pareto).

- Si una distribución de ingresos sigue una distribución log-normal con desviación estándar σ σ {displaystyle sigma }, entonces el coeficiente Gini, comúnmente utilizado para evaluar la desigualdad de ingresos, se puede calcular como G=er ()σ σ 2){displaystyle G=operatorname {erf} left({frac {sigma }{2}right)} Donde er{displaystyle operatorname {erf} es la función de error, ya que G=2CCPR CCPR ()σ σ 2)− − 1{displaystyle G=2Phi left({frac {sigma - Sí., donde CCPR CCPR ()x){displaystyle Phi (x)} es la función de distribución acumulativa de una distribución normal estándar.

- En las finanzas, en particular el modelo Black-Scholes, cambios en el Logarithm de tipos de cambio, índices de precios y índices de mercado de valores se asumen normales (estas variables se comportan como interés compuesto, no como interés simple, y también son multiplicativas). Sin embargo, algunos matemáticos como Benoit Mandelbrot han argumentado que las distribuciones log-Lévy, que poseen colas pesadas, serían un modelo más apropiado, en particular para el análisis de los fallos del mercado de valores. De hecho, las distribuciones de precios de stock suelen exhibir una cola de grasa. La distribución a medida de la grasa de los cambios durante los fallos del mercado de valores invalida las suposiciones del teorema límite central.

- En la simetría, el número de citas a artículos de revistas y patentes sigue una distribución discreta-normal.

- Los tamaños de la ciudad (población) satisfacen la Ley de Gibrat. El proceso de crecimiento de tamaños urbanos es proporcional e invariante con respecto al tamaño. Por lo tanto, desde el teorema límite central, el registro del tamaño de la ciudad se distribuye normalmente.

- El número de parejas sexuales parece ser descrito mejor por una distribución normal de registros.

Tecnología

- En el análisis de confiabilidad, la distribución normal de troncos se utiliza a menudo para modelar tiempos para reparar un sistema de mantenimiento.

- En la comunicación inalámbrica, "la potencia local-medio expresada en valores logarítmicos, como dB o neper, tiene una distribución normal (es decir, gaisiano). Además, la obstrucción aleatoria de las señales de radio debido a grandes edificios y colinas, llamada sombra, a menudo se modela como una distribución tronco-normal.

- Distribución del tamaño de las partículas producidas por la comminución con impactos aleatorios, como en el molino de bolas.

- La distribución del tamaño de archivo de archivos de audio y vídeo disponibles públicamente (tipos de MIME) sigue una distribución log-normal sobre cinco órdenes de magnitud.

- En redes informáticas y análisis de tráfico de Internet, log-normal se muestra como un buen modelo estadístico para representar la cantidad de tráfico por unidad de tiempo. Esto se ha demostrado aplicando un enfoque estadístico sólido en un gran grupo de trazas reales de Internet. En este contexto, la distribución log-normal ha mostrado un buen rendimiento en dos casos de uso principal: (1) predecir la proporción de tráfico de tiempo superará un nivel determinado (para el acuerdo de nivel de servicio o estimación de la capacidad de enlace) es decir, dimensionamiento de enlace basado en la provisión de ancho de banda y (2) predecir 95o precio percentil.

Contenido relacionado

Número de Bernoulli

Pulgada

Axiomas de probabilidad

![{displaystyle {begin{aligned}f_{X}(x)&={frac {rm {d}}{{rm {d}}x}}Pr(Xleq x)={frac {rm {d}}{{rm {d}}x}}Pr(ln Xleq ln x)={frac {rm {d}}{{rm {d}}x}}Phi left({frac {ln x-mu }{sigma }}right)\[6pt]&=varphi left({frac {ln x-mu }{sigma }}right){frac {rm {d}}{{rm {d}}x}}left({frac {ln x-mu }{sigma }}right)=varphi left({frac {ln x-mu }{sigma }}right){frac {1}{sigma x}}\[6pt]&={frac {1}{xsigma {sqrt {2pi ,}}}}exp left(-{frac {(ln x-mu)^{2}}{2sigma ^{2}}}right).end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8543fc457ecf9cb584b82df297462c3e3191cf43)

![{displaystyle {frac {1}{2}}left[1+operatorname {erf} left({frac {ln x-mu }{sigma {sqrt {2}}}}right)right]={frac {1}{2}}operatorname {erfc} left(-{frac {ln x-mu }{sigma {sqrt {2}}}}right)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d7373f66d2a24f5817a8bc2f2f44836941b79118)

![operatorname {E} [{boldsymbol {Y}}]_{i}=e^{mu _{i}+{frac {1}{2}}Sigma _{ii}},](https://wikimedia.org/api/rest_v1/media/math/render/svg/488f8b7b6e5331b3d4b257c87b40752a01ee6293)

![operatorname {Var} [{boldsymbol {Y}}]_{ij}=e^{mu _{i}+mu _{j}+{frac {1}{2}}(Sigma _{ii}+Sigma _{jj})}(e^{Sigma _{ij}}-1).](https://wikimedia.org/api/rest_v1/media/math/render/svg/11b3d9175a3f442f40eb4687f58014c3efdfa7d0)

![{displaystyle operatorname {E} [X^{n}]=e^{nmu +n^{2}sigma ^{2}/2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1ec49bbb5852b6e735f0a6a49468771db326b7bf)

![operatorname {E} [e^{tX}]](https://wikimedia.org/api/rest_v1/media/math/render/svg/0379eb85a8f71d1d2e06107ba42758bc26c355b6)

![operatorname {E} [e^{itX}]](https://wikimedia.org/api/rest_v1/media/math/render/svg/33bdf53bdb972f0154a057c687c9545db5e7ff7d)

![{displaystyle operatorname {GM} [X]=e^{mu }=mu ^{*}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9445c2ca179a4932cdadf4b511c0348c3449a4ea)

![{displaystyle operatorname {GSD} [X]=e^{sigma }=sigma ^{*}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1d39b3e467b86b861d3c19285f10f6d7dc8ec923)

![{displaystyle operatorname {GVar} [X]=e^{sigma ^{2}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3a8446c1bc836c47f03e578df8e5971015871417)

![{displaystyle operatorname {GCV} [X]=e^{sigma }-1}](https://wikimedia.org/api/rest_v1/media/math/render/svg/521d8430003df46e507169d1e2fd3ee976b4105e)

![{displaystyle operatorname {E} [X]=e^{mu +{frac {1}{2}}sigma ^{2}}=e^{mu }cdot {sqrt {e^{sigma ^{2}}}}=operatorname {GM} [X]cdot {sqrt {operatorname {GVar} [X]}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e16c0e50545da50c815d65794d7589b9bf513be4)

![{displaystyle operatorname {E} [X^{n}]=e^{nmu +{frac {1}{2}}n^{2}sigma ^{2}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a4b6efe7347f26a8054654edcdfb03eb8b28bbf1)

![{displaystyle {begin{aligned}operatorname {E} [X]&=e^{mu +{tfrac {1}{2}}sigma ^{2}},\[4pt]operatorname {E} [X^{2}]&=e^{2mu +2sigma ^{2}},\[4pt]operatorname {Var} [X]&=operatorname {E} [X^{2}]-operatorname {E} [X]^{2}=(operatorname {E} [X])^{2}(e^{sigma ^{2}}-1)=e^{2mu +sigma ^{2}}(e^{sigma ^{2}}-1),\[4pt]operatorname {SD} [X]&={sqrt {operatorname {Var} [X]}}=operatorname {E} [X]{sqrt {e^{sigma ^{2}}-1}}=e^{mu +{tfrac {1}{2}}sigma ^{2}}{sqrt {e^{sigma ^{2}}-1}},end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2b59e2bead4a03f70fcf34a610106ae8704959a6)

![{displaystyle operatorname {CV} [X]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/89fe40c7a2788b7bb2797aeda4b90c1f53be8ce0)

![{displaystyle {tfrac {operatorname {SD} [X]}{operatorname {E} [X]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/eb1c3719bd3e6716f973e3ab735e695e19df4a66)

![{displaystyle operatorname {CV} [X]={sqrt {e^{sigma ^{2}}-1}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6cad386f192fe53b9e0525951f5423f46e03e36d)

![{displaystyle {begin{aligned}mu &=ln left({frac {operatorname {E} [X]^{2}}{sqrt {operatorname {E} [X^{2}]}}}right)=ln left({frac {operatorname {E} [X]^{2}}{sqrt {operatorname {Var} [X]+operatorname {E} [X]^{2}}}}right),\[4pt]sigma ^{2}&=ln left({frac {operatorname {E} [X^{2}]}{operatorname {E} [X]^{2}}}right)=ln left(1+{frac {operatorname {Var} [X]}{operatorname {E} [X]^{2}}}right).end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ede6a785b6ed56d35a478e9927963cea65ba96e4)

![{displaystyle operatorname {Mode} [X]=e^{mu -sigma ^{2}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/696ae3ee691abe8666911db6b83228e86d685f85)

![{displaystyle operatorname {Med} [X]=e^{mu }=mu ^{*}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/20824d0df6479d5d425debc8b3646f5ebc87557c)

![{displaystyle P(x;{boldsymbol {mu }},{boldsymbol {sigma }})={frac {1}{xsigma {sqrt {2pi }}}}exp left[-{frac {(ln x-mu)^{2}}{2sigma ^{2}}}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d254929914b40b8fa2329e6a02fa53353ed7fa07)

![{displaystyle P(x;{boldsymbol {mu }},{boldsymbol {v}})={frac {1}{x{sqrt {v}}{sqrt {2pi }}}}exp left[-{frac {(ln x-mu)^{2}}{2v}}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/47756e2ba5dcec56108d985f54ced5802726cb2f)

![{displaystyle P(x;{boldsymbol {m}},{boldsymbol {sigma }})={frac {1}{xsigma {sqrt {2pi }}}}exp left[-{frac {ln ^{2}(x/m)}{2sigma ^{2}}}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f81ab16e30f347597540cda86ccb2702b0be5f85)

![{displaystyle P(x;{boldsymbol {m}},{boldsymbol {cv}})={frac {1}{x{sqrt {ln(cv^{2}+1)}}{sqrt {2pi }}}}exp left[-{frac {ln ^{2}(x/m)}{2ln(cv^{2}+1)}}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/34339307b7039935ae1071b1fb0ca1a04b51e0a2)

![{displaystyle P(x;{boldsymbol {mu }},{boldsymbol {tau }})={sqrt {frac {tau }{2pi }}}{frac {1}{x}}exp left[-{frac {tau }{2}}(ln x-mu)^{2}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9ded50fe9521e9c21996167b6261b45fa2270849)

![{displaystyle P(x;{boldsymbol {m}},{boldsymbol {sigma _{g}}})={frac {1}{xln(sigma _{g}){sqrt {2pi }}}}exp left[-{frac {ln ^{2}(x/m)}{2ln ^{2}(sigma _{g})}}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e5d63692975723d89e040953aefd71ec18822b86)

![{displaystyle P(x;{boldsymbol {mu _{N}}},{boldsymbol {sigma _{N}}})={frac {1}{x{sqrt {2pi ln left(1+sigma _{N}^{2}/mu _{N}^{2}right)}}}}exp left(-{frac {{Big [}ln x-ln {frac {mu _{N}}{sqrt {1+sigma _{N}^{2}/mu _{N}^{2}}}}{Big ]}^{2}}{2ln(1+sigma _{N}^{2}/mu _{N}^{2})}}right)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c50f543829dadcdbc41b007ca74be9029c563e56)

![{displaystyle mu =E[ln(X_{i})]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b2a724b374b7dbb96f1b3a40018c88d0011d859e)

![{displaystyle sigma ^{2}={mbox{var}}[ln(X_{i})]/n}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8cb61e99822586c483b382dd80770ed7df53680d)

![{displaystyle {begin{aligned}sigma _{Z}^{2}&=ln !left[{frac {sum e^{2mu _{j}+sigma _{j}^{2}}(e^{sigma _{j}^{2}}-1)}{(sum e^{mu _{j}+sigma _{j}^{2}/2})^{2}}}+1right],\mu _{Z}&=ln !left[sum e^{mu _{j}+sigma _{j}^{2}/2}right]-{frac {sigma _{Z}^{2}}{2}}.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4fc943ff6dcd032b6a82e022dd853316e4e77307)

![{displaystyle {begin{aligned}sigma _{Z}^{2}&=ln !left[(e^{sigma ^{2}}-1){frac {sum e^{2mu _{j}}}{(sum e^{mu _{j}})^{2}}}+1right],\mu _{Z}&=ln !left[sum e^{mu _{j}}right]+{frac {sigma ^{2}}{2}}-{frac {sigma _{Z}^{2}}{2}}.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4e3403a57bdac83cd433bc61aacd2206067d27bc)

![{displaystyle {begin{aligned}S_{+}&=operatorname {E} left[sum _{i}X_{i}right]=sum _{i}operatorname {E} [X_{i}]=sum _{i}e^{mu _{i}+sigma _{i}^{2}/2}\sigma _{Z}^{2}&=1/S_{+}^{2},sum _{i,j}operatorname {cor} _{ij}sigma _{i}sigma _{j}operatorname {E} [X_{i}]operatorname {E} [X_{j}]=1/S_{+}^{2},sum _{i,j}operatorname {cor} _{ij}sigma _{i}sigma _{j}e^{mu _{i}+sigma _{i}^{2}/2}e^{mu _{j}+sigma _{j}^{2}/2}\mu _{Z}&=ln left(S_{+}right)-sigma _{Z}^{2}/2end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f8ce906d9079b01314fe41adcaab5b630462d164)

![{displaystyle operatorname {E} [X+c]=operatorname {E} [X]+c}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3bccff99c9c6a0829010eafc025c7a24c33fe6e2)

![operatorname {Var} [X+c]=operatorname {Var} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/dc3cc065bfe4de4faaf4facb23f8fa2891ea72c3)

![{displaystyle F(x;musigma)=left[left({frac {e^{mu }}{x}}right)^{pi /(sigma {sqrt {3}})}+1right]^{-1}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e28d7a1ba703b5e772530f62f55f314b9ba007bc)

![operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93)

![{displaystyle operatorname {Var} [X]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b79297a808478243e9aab0b27dd1ab583c0f877d)

![{displaystyle [mu -sigmamu +sigma ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/55c87cf54494c57f8aa41a35e60cf1f4ba837fa8)

![{displaystyle [mu -2sigmamu +2sigma ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1cb2f1b03c720b317b0fcf7e012a9bba1a3f418e)

![{displaystyle [mu ^{*}/sigma ^{*},mu ^{*}cdot sigma ^{*}]=[mu ^{*}{}^{times }!!/sigma ^{*}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/90bfe33d3e1ec78fd21196427394f5f4fe5e1836)

![{displaystyle [mu ^{*}/(sigma ^{*})^{2},mu ^{*}cdot (sigma ^{*})^{2}]=[mu ^{*}{}^{times }!!/(sigma ^{*})^{2}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/721c476ec6cdb74bed626ea73e2e5f44bff32d84)

![{displaystyle [{widehat {mu }}pm qcdot {widehat {mathop {se} }}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/38626a249b1d579a2af15d2d64ec382789448e60)

![{displaystyle [{widehat {mu }}^{*}{}^{times }!!/(operatorname {sem} ^{*})^{q}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7b9c1579089d540825002f6a247b9991d2d87936)