História do hardware de computação

A história do hardware de computação abrange os desenvolvimentos desde os primeiros dispositivos simples para auxiliar no cálculo até os computadores modernos.

Os primeiros auxílios à computação eram dispositivos puramente mecânicos que exigiam que o operador estabelecesse os valores iniciais de uma operação aritmética elementar e então manipulasse o dispositivo para obter o resultado. Mais tarde, os computadores representaram números de forma contínua (por exemplo, distância ao longo de uma escala, rotação de um eixo ou uma voltagem). Os números também podem ser representados na forma de dígitos, manipulados automaticamente por um mecanismo. Embora essa abordagem geralmente exigisse mecanismos mais complexos, ela aumentava muito a precisão dos resultados. O desenvolvimento da tecnologia do transistor e, em seguida, do chip de circuito integrado levou a uma série de avanços, começando com os computadores de transistor e depois os computadores de circuito integrado, fazendo com que os computadores digitais substituíssem em grande parte os computadores analógicos. A integração em larga escala (LSI) do semicondutor de óxido de metal (MOS) permitiu a memória semicondutora e o microprocessador, levando a outro avanço importante, o computador pessoal miniaturizado (PC), na década de 1970. O custo dos computadores tornou-se gradualmente tão baixo que os computadores pessoais na década de 1990 e os computadores móveis (smartphones e tablets) na década de 2000 se tornaram onipresentes.

Dispositivos antigos

Antigo e medieval

Dispositivos têm sido usados para auxiliar a computação por milhares de anos, principalmente usando correspondência um-para-um com os dedos. O dispositivo de contagem mais antigo foi provavelmente uma forma de bastão de contagem. O osso Lebombo das montanhas entre Eswatini e a África do Sul pode ser o mais antigo artefato matemático conhecido. Data de 35.000 aC e consiste em 29 entalhes distintos que foram deliberadamente cortados na fíbula de um babuíno. Auxiliares de manutenção de registros posteriores em todo o Crescente Fértil incluíam cálculos (esferas de argila, cones, etc.) que representavam contagens de itens, provavelmente gado ou grãos, selados em recipientes ocos de argila não cozida. O uso de bastões de contagem é um exemplo. O ábaco foi usado cedo para tarefas aritméticas. O que agora chamamos de ábaco romano foi usado na Babilônia já em c. 2700-2300 aC. Desde então, muitas outras formas de tábuas ou tabelas de cálculo foram inventadas. Em uma casa de contabilidade européia medieval, um pano xadrez era colocado sobre uma mesa e os marcadores se moviam de acordo com certas regras, como uma ajuda para calcular somas de dinheiro.

Vários computadores analógicos foram construídos nos tempos antigos e medievais para realizar cálculos astronômicos. Estes incluíram o mecanismo astrolábio e Antikythera do mundo helenístico (c. 150-100 aC). No Egito romano, o Herói de Alexandria (c. 10–70 DC) fez dispositivos mecânicos, incluindo autômatos e um carrinho programável. Outros dispositivos mecânicos antigos usados para executar um ou outro tipo de cálculo incluem o planisfério e outros dispositivos mecânicos de computação inventados por Al-Biruni (c. AD 1000); o equador e o astrolábio universal independente da latitude por Al-Zarqali (c. 1015 DC); os computadores analógicos astronômicos de outros astrônomos e engenheiros muçulmanos medievais; e a torre do relógio astronômico de Su Song (1094) durante a dinastia Song. O relógio do castelo, um relógio astronômico mecânico hidroalimentado inventado por Ismail al-Jazari em 1206, foi o primeiro computador analógico programável. Ramon Llull inventou o Círculo Lulliano: uma máquina nocional para calcular respostas a questões filosóficas (neste caso, relacionadas ao cristianismo) por meio de lógica combinatória. Essa ideia foi retomada por Leibniz séculos depois e é, portanto, um dos elementos fundadores da computação e da ciência da informação.

Ferramentas de cálculo renascentistas

O matemático e físico escocês John Napier descobriu que a multiplicação e a divisão de números poderiam ser realizadas pela adição e subtração, respectivamente, dos logaritmos desses números. Ao produzir as primeiras tabelas logarítmicas, Napier precisou realizar muitas multiplicações tediosas. Foi nesse ponto que ele projetou seus "ossos de Napier", um dispositivo semelhante a um ábaco que simplificou bastante os cálculos que envolviam multiplicação e divisão.

Como os números reais podem ser representados como distâncias ou intervalos em uma linha, a régua de cálculo foi inventada na década de 1620, logo após o trabalho de Napier, para permitir que operações de multiplicação e divisão fossem realizadas significativamente mais rápido do que anteriormente possível. Edmund Gunter construiu um dispositivo de cálculo com uma única escala logarítmica na Universidade de Oxford. Seu dispositivo simplificou bastante os cálculos aritméticos, incluindo multiplicação e divisão. William Oughtred melhorou muito isso em 1630 com sua régua de cálculo circular. Ele seguiu com a régua de cálculo moderna em 1632, essencialmente uma combinação de duas réguas de Gunter, mantidas juntas com as mãos. As réguas de cálculo foram usadas por gerações de engenheiros e outros trabalhadores profissionais matematicamente envolvidos, até a invenção da calculadora de bolso.

Calculadoras mecânicas

Em 1609 Guidobaldo del Monte fez um multiplicador mecânico para calcular frações de um grau. Com base em um sistema de quatro engrenagens, a rotação de um índice em um quadrante corresponde a 60 rotações de outro índice em um quadrante oposto. Graças a esta máquina, erros no cálculo do primeiro, segundo, terceiro e quarto graus podem ser evitados. Guidobaldo é o primeiro a documentar o uso de engrenagens para cálculos mecânicos.

Wilhelm Schickard, um polímata alemão, projetou uma máquina de calcular em 1623 que combinava uma forma mecanizada de hastes de Napier com a primeira máquina de somar mecânica do mundo embutida na base. Como fazia uso de uma engrenagem de dente único, havia circunstâncias em que seu mecanismo de transporte travava. Um incêndio destruiu pelo menos uma das máquinas em 1624 e acredita-se que Schickard estava muito desanimado para construir outra.

Em 1642, ainda adolescente, Blaise Pascal iniciou alguns trabalhos pioneiros em máquinas de calcular e após três anos de esforço e 50 protótipos inventou uma calculadora mecânica. Ele construiu vinte dessas máquinas (chamadas calculadora de Pascal ou Pascaline) nos dez anos seguintes. Nove Pascalines sobreviveram, a maioria dos quais está em exibição em museus europeus. Existe um debate contínuo sobre se Schickard ou Pascal devem ser considerados o "inventor da calculadora mecânica" e a gama de questões a serem consideradas é discutida em outro lugar.

Gottfried Wilhelm von Leibniz inventou o contador escalonado e seu famoso mecanismo de tambor escalonado por volta de 1672. Ele tentou criar uma máquina que pudesse ser usada não apenas para adição e subtração, mas que usasse um carro móvel para permitir a multiplicação e a divisão. Leibniz disse certa vez: "É indigno de homens excelentes perder horas como escravos no trabalho de cálculo que poderia ser relegado com segurança a qualquer outra pessoa se fossem usadas máquinas". No entanto, Leibniz não incorporou um mecanismo de transporte totalmente bem-sucedido. Leibniz também descreveu o sistema numérico binário, um ingrediente central de todos os computadores modernos. No entanto, até a década de 1940, muitos projetos subsequentes (incluindo as máquinas de Charles Babbage de 1822 e até o ENIAC de 1945) foram baseados no sistema decimal.

Por volta de 1820, Charles Xavier Thomas de Colmar criou o que se tornaria no resto do século a primeira calculadora mecânica de sucesso produzida em massa, o Thomas Arithmometer. Podia ser usado para somar e subtrair, e com uma carruagem móvel o operador também podia multiplicar e dividir por um processo de longa multiplicação e longa divisão. Utilizou um tambor escalonado semelhante em concepção ao inventado por Leibniz. Calculadoras mecânicas permaneceram em uso até a década de 1970.

Processamento de dados de cartão perfurado

Em 1804, o tecelão francês Joseph Marie Jacquard desenvolveu um tear no qual o padrão a ser tecido era controlado por uma fita de papel construída a partir de cartões perfurados. A fita de papel pode ser trocada sem alterar o projeto mecânico do tear. Esta foi uma conquista histórica em programabilidade. Sua máquina era uma melhoria em relação a teares de tecelagem semelhantes. Os cartões perfurados eram precedidos por bandas perfuradas, como na máquina proposta por Basile Bouchon. Essas bandas inspirariam a gravação de informações para pianos automáticos e, mais recentemente, máquinas-ferramentas de controle numérico.

No final da década de 1880, o americano Herman Hollerith inventou o armazenamento de dados em cartões perfurados que podiam ser lidos por uma máquina. Para processar esses cartões perfurados, ele inventou o tabulador e a máquina perfuradora. Suas máquinas usavam relés e contadores eletromecânicos. O método de Hollerith foi usado no Censo dos Estados Unidos de 1890. Esse censo foi processado dois anos mais rápido do que o censo anterior. A empresa de Hollerith acabou se tornando o núcleo da IBM.

Em 1920, as máquinas de tabulação eletromecânicas podiam somar, subtrair e imprimir totais acumulados. As funções da máquina foram direcionadas inserindo dezenas de jumpers de fio em painéis de controle removíveis. Quando os Estados Unidos instituíram a Seguridade Social em 1935, os sistemas de cartões perfurados da IBM foram usados para processar registros de 26 milhões de trabalhadores. Os cartões perfurados tornaram-se onipresentes na indústria e no governo para contabilidade e administração.

Os artigos de Leslie Comrie sobre métodos de cartões perfurados e a publicação de W. J. Eckert de Punched Card Methods in Scientific Computation em 1940, descreviam técnicas de cartões perfurados suficientemente avançadas para resolver alguns equações diferenciais ou realizar multiplicações e divisões usando representações de ponto flutuante, tudo em cartões perfurados e máquinas de registro de unidades. Essas máquinas foram usadas durante a Segunda Guerra Mundial para processamento estatístico criptográfico, bem como para um grande número de usos administrativos. O Astronomical Computing Bureau, da Universidade de Columbia, realizou cálculos astronômicos representando o estado da arte em computação.

Calculadoras

No século 20, calculadoras mecânicas anteriores, caixas registradoras, máquinas de contabilidade e assim por diante foram redesenhadas para usar motores elétricos, com a posição da engrenagem como representação do estado de uma variável. A palavra "computador" era um cargo atribuído principalmente a mulheres que usavam essas calculadoras para realizar cálculos matemáticos. Na década de 1920, o interesse do cientista britânico Lewis Fry Richardson pela previsão do tempo o levou a propor computadores humanos e análises numéricas para modelar o clima; até hoje, os computadores mais poderosos da Terra são necessários para modelar adequadamente seu clima usando as equações de Navier-Stokes.

Empresas como Friden, Marchant Calculator e Monroe fabricaram calculadoras mecânicas de mesa a partir da década de 1930 que podiam somar, subtrair, multiplicar e dividir. Em 1948, o Curta foi introduzido pelo inventor austríaco Curt Herzstark. Era uma pequena calculadora mecânica de manivela e, como tal, descendente do Stepped Reckoner de Gottfried Leibniz e do Thomas de Thomas. Aritmômetro.

A primeira calculadora de mesa totalmente eletrônica do mundo foi a britânica Bell Punch ANITA, lançada em 1961. Ela usava tubos de vácuo, tubos de cátodo frio e Dekatrons em seus circuitos, com 12 catodo frio "Nixie" tubos para sua exibição. A ANITA vendeu bem, pois era a única calculadora eletrônica de mesa disponível e era silenciosa e rápida. A tecnologia de tubo foi substituída em junho de 1963 pelo Friden EC-130 fabricado nos EUA, que tinha um design totalmente transistorizado, uma pilha de quatro números de 13 dígitos exibidos em um CRT de 5 polegadas (13 cm) e introduziu a notação polonesa reversa (RPN).

Primeiro dispositivo de computação de uso geral

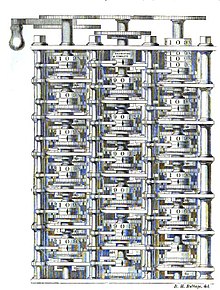

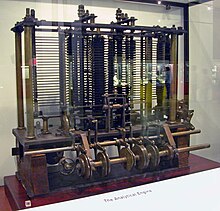

Charles Babbage, um engenheiro mecânico e polímata inglês, originou o conceito de um computador programável. Considerado o "pai do computador", ele conceituou e inventou o primeiro computador mecânico no início do século XIX. Depois de trabalhar em seu revolucionário motor diferencial, projetado para auxiliar nos cálculos de navegação, em 1833 ele percebeu que um projeto muito mais geral, um motor analítico, era possível. A entrada de programas e dados deveria ser fornecida à máquina por meio de cartões perfurados, método usado na época para direcionar teares mecânicos como o tear Jacquard. Para saída, a máquina teria uma impressora, um traçador de curvas e uma campainha. A máquina também seria capaz de perfurar números em cartões para serem lidos posteriormente. Empregava aritmética comum de ponto fixo de base 10.

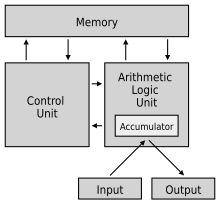

O Engine incorporou uma unidade lógica aritmética, fluxo de controle na forma de ramificações e loops condicionais e memória integrada, tornando-o o primeiro projeto para um computador de propósito geral que poderia ser descrito em termos modernos como Turing-completo.

Deveria haver um armazenamento, ou memória, capaz de armazenar 1.000 números de 40 dígitos decimais cada (cerca de 16,7 kB). Uma unidade aritmética, chamada de "moinho", seria capaz de realizar todas as quatro operações aritméticas, além de comparações e, opcionalmente, raízes quadradas. Inicialmente, foi concebido como um motor de diferença curvado sobre si mesmo, em um layout geralmente circular, com a longa loja saindo para um lado. (Desenhos posteriores representam um layout de grade regularizado.) Como a unidade central de processamento (CPU) em um computador moderno, a fábrica contaria com seus próprios procedimentos internos, aproximadamente equivalentes ao microcódigo em CPUs modernas, a serem armazenados na forma de pinos inseridos em tambores rotativos chamados "barris", para executar algumas das instruções mais complexas que o programa do usuário pode especificar.

A linguagem de programação a ser empregada pelos usuários era semelhante às linguagens de montagem modernas. Loops e ramificações condicionais eram possíveis e, portanto, a linguagem concebida teria sido Turing-completa, conforme definido posteriormente por Alan Turing. Foram utilizados três tipos diferentes de cartões perfurados: um para operações aritméticas, outro para constantes numéricas e outro para operações de carregar e armazenar, transferindo números da loja para a unidade aritmética ou vice-versa. Havia três leitores separados para os três tipos de cartões.

A máquina estava cerca de um século à frente de seu tempo. No entanto, o projeto foi retardado por vários problemas, incluindo disputas com o maquinista-chefe que construía peças para ele. Todas as peças de sua máquina tinham que ser feitas à mão - isso era um grande problema para uma máquina com milhares de peças. Eventualmente, o projeto foi dissolvido com a decisão do governo britânico de cessar o financiamento. O fracasso de Babbage em completar o mecanismo analítico pode ser atribuído principalmente a dificuldades não apenas de política e financiamento, mas também ao seu desejo de desenvolver um computador cada vez mais sofisticado e avançar mais rápido do que qualquer outra pessoa poderia seguir. Ada Lovelace traduziu e adicionou notas ao "Esboço da Máquina Analítica" por Luigi Federico Menabrea. Esta parece ser a primeira descrição publicada de programação, então Ada Lovelace é amplamente considerada a primeira programadora de computador.

Seguindo Babbage, embora a princípio sem saber de seu trabalho anterior, estava Percy Ludgate, funcionário de um comerciante de milho em Dublin, na Irlanda. Ele projetou independentemente um computador mecânico programável, que descreveu em um trabalho publicado em 1909. Dois outros inventores, Leonardo Torres y Quevedo e Vannevar Bush, também seguiram pesquisas baseadas no trabalho de Babbage. Em seus Essays on Automatics (1913), Torres y Quevedo projetou um tipo de máquina de calcular Babbage que usava peças eletromecânicas que incluíam representações numéricas de ponto flutuante e construiu um protótipo inicial em 1920. Artigo de Bush Análise instrumental (1936) discutiu o uso de máquinas de cartões perfurados IBM existentes para implementar o design de Babbage. No mesmo ano iniciou o projeto Rapid Arithmetical Machine para investigar os problemas de construção de um computador eletrônico digital.

Computadores analógicos

Na primeira metade do século 20, os computadores analógicos eram considerados por muitos como o futuro da computação. Esses dispositivos usavam os aspectos continuamente mutáveis de fenômenos físicos, como quantidades elétricas, mecânicas ou hidráulicas, para modelar o problema que estava sendo resolvido, em contraste com os computadores digitais que representavam quantidades variáveis simbolicamente, conforme seus valores numéricos mudavam. Como um computador analógico não usa valores discretos, mas sim valores contínuos, os processos não podem ser repetidos de forma confiável com equivalência exata, como acontece com as máquinas de Turing.

O primeiro computador analógico moderno foi uma máquina de previsão de marés, inventada por Sir William Thomson, mais tarde Lord Kelvin, em 1872. Ele usava um sistema de polias e fios para calcular automaticamente os níveis de maré previstos para um determinado período em um determinado local e foi de grande utilidade para a navegação em águas rasas. Seu dispositivo foi a base para novos desenvolvimentos na computação analógica.

O analisador diferencial, um computador analógico mecânico projetado para resolver equações diferenciais por integração usando mecanismos de roda e disco, foi concebido em 1876 por James Thomson, irmão do mais famoso Lord Kelvin. Ele explorou a possível construção de tais calculadoras, mas foi bloqueado pelo torque de saída limitado dos integradores de bola e disco. Em um analisador diferencial, a saída de um integrador conduz a entrada do próximo integrador, ou uma saída gráfica.

Um avanço importante na computação analógica foi o desenvolvimento dos primeiros sistemas de controle de fogo para tiroteio de navios de longo alcance. Quando o alcance da artilharia aumentou dramaticamente no final do século 19, não era mais uma simples questão de calcular o ponto de mira adequado, dados os tempos de voo dos projéteis. Vários observadores a bordo do navio transmitiriam medidas de distância e observações para uma estação central de plotagem. Lá as equipes de direção de tiro alimentaram a localização, velocidade e direção do navio e seu alvo, bem como vários ajustes para efeito Coriolis, efeitos climáticos no ar e outros ajustes; o computador então produziria uma solução de disparo, que seria alimentada às torres para colocação. Em 1912, o engenheiro britânico Arthur Pollen desenvolveu o primeiro computador analógico mecânico movido a eletricidade (chamado na época de Argo Clock). Foi usado pela Marinha Imperial Russa na Primeira Guerra Mundial. O sistema alternativo de controle de incêndio da Mesa Dreyer foi instalado nos navios capitais britânicos em meados de 1916.

Dispositivos mecânicos também foram usados para auxiliar na precisão do bombardeio aéreo. O Drift Sight foi o primeiro desses auxílios, desenvolvido por Harry Wimperis em 1916 para o Royal Naval Air Service; mediu a velocidade do vento no ar e usou essa medição para calcular os efeitos do vento na trajetória das bombas. O sistema foi posteriormente aprimorado com o Mira de bomba de ajuste de curso e atingiu um clímax com mira de bomba da Segunda Guerra Mundial, mira de bomba Mark XIV (RAF Bomber Command) e Norden (Forças Aéreas do Exército dos Estados Unidos).

A arte da computação analógica mecânica atingiu seu apogeu com o analisador diferencial, construído por H. L. Hazen e Vannevar Bush no MIT a partir de 1927, que se baseou nos integradores mecânicos de James Thomson e nos amplificadores de torque inventados por H. W. Nieman. Uma dúzia desses dispositivos foi construída antes que sua obsolescência se tornasse óbvia; o mais poderoso foi construído na Escola Moore de Engenharia Elétrica da Universidade da Pensilvânia, onde o ENIAC foi construído.

Um computador analógico totalmente eletrônico foi construído por Helmut Hölzer em 1942 no Peenemünde Army Research Center.

Na década de 1950, o sucesso dos computadores eletrônicos digitais significou o fim da maioria das máquinas de computação analógica, mas os computadores analógicos híbridos, controlados pela eletrônica digital, permaneceram em uso substancial nas décadas de 1950 e 1960 e, posteriormente, em algumas aplicações especializadas.

Advento do computador digital

O princípio do computador moderno foi descrito pela primeira vez pelo cientista da computação Alan Turing, que expôs a ideia em seu artigo seminal de 1936, On Computable Numbers. Turing reformulou os resultados de 1931 de Kurt Gödel sobre os limites da prova e da computação, substituindo a linguagem formal baseada na aritmética universal de Gödel pelos dispositivos hipotéticos formais e simples que se tornaram conhecidos como máquinas de Turing. Ele provou que tal máquina seria capaz de realizar qualquer cálculo matemático concebível se fosse representável como um algoritmo. Ele provou que não havia solução para o Entscheidungsproblem mostrando primeiro que o problema da parada para máquinas de Turing é indecidível: em geral, não é possível decidir algoritmicamente se uma dada máquina de Turing nunca parar.

Ele também introduziu a noção de uma "máquina universal" (agora conhecida como máquina de Turing universal), com a ideia de que tal máquina poderia executar as tarefas de qualquer outra máquina, ou seja, é comprovadamente capaz de computar qualquer coisa que seja computável executando um programa armazenado em fita, permitindo a máquina seja programável. Von Neumann reconheceu que o conceito central do computador moderno se deve a esse artigo. As máquinas de Turing são até hoje um objeto central de estudo na teoria da computação. Exceto pelas limitações impostas por seus armazenamentos de memória finitos, os computadores modernos são considerados Turing-completos, ou seja, eles têm capacidade de execução de algoritmo equivalente a uma máquina de Turing universal.

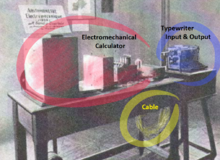

Computadores eletromecânicos

A era da computação moderna começou com uma onda de desenvolvimento antes e durante a Segunda Guerra Mundial. A maioria dos computadores digitais construídos nesse período eram eletromecânicos – interruptores elétricos acionavam relés mecânicos para realizar o cálculo. Esses dispositivos tinham uma velocidade operacional baixa e acabaram sendo substituídos por computadores totalmente elétricos muito mais rápidos, originalmente usando tubos de vácuo.

O Z2 foi um dos primeiros exemplos de um computador de relé eletromecânico e foi criado pelo engenheiro alemão Konrad Zuse em 1940. Foi uma melhoria em seu Z1 anterior; embora usasse a mesma memória mecânica, substituiu a aritmética e a lógica de controle por circuitos de relés elétricos.

No mesmo ano, dispositivos eletromecânicos chamados bombes foram construídos por criptologistas britânicos para ajudar a decifrar mensagens secretas criptografadas pela máquina alemã Enigma durante a Segunda Guerra Mundial. O design inicial da bomba foi criado em 1939 na Escola de Código e Cifras do Governo do Reino Unido (GC&CS) em Bletchley Park por Alan Turing, com um importante refinamento desenvolvido em 1940 por Gordon Welchman. O projeto de engenharia e a construção foram obra de Harold Keen, da British Tabulating Machine Company. Foi um desenvolvimento substancial de um dispositivo que havia sido projetado em 1938 pelo criptologista do Polish Cipher Bureau, Marian Rejewski, e conhecido como a "bomba criptológica" (polonês: "bomba kryptologiczna").

Em 1941, Zuse seguiu sua máquina anterior com o Z3, o primeiro computador digital totalmente automático programável e eletromecânico do mundo. O Z3 foi construído com 2.000 relés, implementando um comprimento de palavra de 22 bits que operava a uma frequência de clock de cerca de 5 a 10 Hz. O código do programa e os dados foram armazenados em filme perfurado. Era bastante semelhante às máquinas modernas em alguns aspectos, sendo pioneira em inúmeros avanços, como números de ponto flutuante. A substituição do sistema decimal de difícil implementação (usado no projeto anterior de Charles Babbage) pelo sistema binário mais simples significava que as máquinas de Zuse eram mais fáceis de construir e potencialmente mais confiáveis, dadas as tecnologias disponíveis naquela época. tempo. O Z3 foi provado como uma máquina Turing-completa em 1998 por Raúl Rojas. Em dois pedidos de patente de 1936, Zuse também antecipou que as instruções da máquina poderiam ser armazenadas no mesmo armazenamento usado para dados - a principal visão do que ficou conhecido como arquitetura von Neumann, implementada pela primeira vez em 1948 na América no IBM eletromecânico SSEC e na Grã-Bretanha no Manchester Baby totalmente eletrônico.

Zuse sofreu reveses durante a Segunda Guerra Mundial, quando algumas de suas máquinas foram destruídas durante as campanhas de bombardeio dos Aliados. Aparentemente, seu trabalho permaneceu amplamente desconhecido para engenheiros no Reino Unido e nos Estados Unidos até muito mais tarde, embora pelo menos a IBM estivesse ciente disso, pois financiou sua empresa iniciante do pós-guerra em 1946 em troca de uma opção nas patentes de Zuse.

Em 1944, o Harvard Mark I foi construído nos laboratórios Endicott da IBM. Era um computador eletromecânico de uso geral semelhante ao Z3, mas não era totalmente Turing-completo.

Cálculo digital

O termo digital foi sugerido pela primeira vez por George Robert Stibitz e refere-se a onde um sinal, como uma tensão, não é usado para representar diretamente um valor (como seria em um computador analógico), mas para codificá-lo. Em novembro de 1937, Stibitz, então trabalhando no Bell Labs (1930–1941), completou uma calculadora baseada em relé que mais tarde apelidou de "Modelo K" (para "kmesa de cozinha", na qual ele a montou), que se tornou o primeiro somador binário. Normalmente, os sinais têm dois estados - baixo (geralmente representando 0) e alto (geralmente representando 1), mas às vezes a lógica de três valores é usada, especialmente na memória de alta densidade. Os computadores modernos geralmente usam lógica binária, mas muitas das primeiras máquinas eram computadores decimais. Nessas máquinas, a unidade básica de dados era o dígito decimal, codificado em um dos vários esquemas, incluindo decimal codificado em binário ou BCD, biquinaria, excesso de 3 e código dois em cinco.

A base matemática da computação digital é a álgebra booleana, desenvolvida pelo matemático britânico George Boole em seu trabalho The Laws of Thought, publicado em 1854. Sua álgebra booleana foi refinada na década de 1860 por William Jevons e Charles Sanders Peirce, e foi apresentado pela primeira vez sistematicamente por Ernst Schröder e A. N. Whitehead. Em 1879, Gottlob Frege desenvolve a abordagem formal da lógica e propõe a primeira linguagem lógica para equações lógicas.

Na década de 1930 e trabalhando de forma independente, o engenheiro eletrônico americano Claude Shannon e o lógico soviético Victor Shestakov mostraram uma correspondência um a um entre os conceitos da lógica booleana e certos circuitos elétricos, agora chamados de portas lógicas, que agora são onipresentes em computadores digitais. Eles mostraram que relés e interruptores eletrônicos podem realizar as expressões da álgebra booleana. Esta tese fundamentou essencialmente o projeto prático de circuitos digitais. Além disso, o artigo de Shannon fornece um diagrama de circuito correto para um somador binário digital de 4 bits.

Processamento eletrônico de dados

Elementos de circuitos puramente eletrônicos logo substituíram seus equivalentes mecânicos e eletromecânicos, ao mesmo tempo em que o cálculo digital substituiu o analógico. Máquinas como o Z3, o Atanasoff-Berry Computer, os computadores Colossus e o ENIAC foram construídos à mão, usando circuitos contendo relés ou válvulas (tubos de vácuo) e frequentemente usavam cartões perfurados ou fita de papel perfurada para entrada e como o principal (não volátil) meio de armazenamento.

O engenheiro Tommy Flowers ingressou no ramo de telecomunicações do General Post Office em 1926. Enquanto trabalhava na estação de pesquisa em Dollis Hill na década de 1930, ele começou a explorar o possível uso de eletrônicos para a central telefônica. Um equipamento experimental que ele construiu em 1934 entrou em operação 5 anos depois, convertendo uma parte da rede da central telefônica em um sistema eletrônico de processamento de dados, usando milhares de tubos a vácuo.

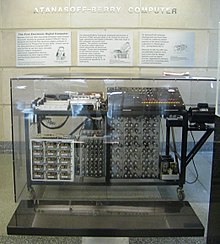

Nos Estados Unidos, em 1940, Arthur Dickinson (IBM) inventou o primeiro computador eletrônico digital. Este dispositivo de cálculo era totalmente eletrônico - controle, cálculos e saída (o primeiro display eletrônico). John Vincent Atanasoff e Clifford E. Berry, da Iowa State University, desenvolveram o Atanasoff-Berry Computer (ABC) em 1942, o primeiro dispositivo de cálculo digital eletrônico binário. Este projeto era semi-eletrônico (controle eletromecânico e cálculos eletrônicos) e usava cerca de 300 tubos de vácuo, com capacitores fixados em um tambor giratório mecânico para memória. No entanto, seu gravador/leitor de cartões de papel não era confiável e o sistema de contato do tambor regenerativo era mecânico. A natureza de finalidade especial da máquina e a falta de programa armazenado e alterável a distinguem dos computadores modernos.

Os computadores cuja lógica foi construída principalmente usando tubos de vácuo são agora conhecidos como computadores de primeira geração.

O computador eletrônico programável

Durante a Segunda Guerra Mundial, os decifradores britânicos em Bletchley Park, 40 milhas (64 km) ao norte de Londres, obtiveram vários sucessos na quebra de comunicações militares inimigas criptografadas. A máquina de criptografia alemã, Enigma, foi atacada pela primeira vez com a ajuda de bombas eletromecânicas. Muitas vezes, as mulheres operavam essas bombas. Eles descartaram possíveis configurações do Enigma realizando cadeias de deduções lógicas implementadas eletricamente. A maioria das possibilidades levava a uma contradição, e as poucas restantes podiam ser testadas à mão.

Os alemães também desenvolveram uma série de sistemas de criptografia de teleimpressoras, bem diferentes da Enigma. A máquina Lorenz SZ 40/42 foi usada para comunicações de alto nível do Exército, com o codinome "Tunny" pelos britânicos. As primeiras interceptações de mensagens de Lorenz começaram em 1941. Como parte de um ataque a Tunny, Max Newman e seus colegas desenvolveram o Heath Robinson, uma máquina de função fixa para auxiliar na quebra de códigos. Tommy Flowers, um engenheiro sênior da Estação de Pesquisa dos Correios, foi recomendado a Max Newman por Alan Turing e passou onze meses desde o início de fevereiro de 1943 projetando e construindo o computador Colossus mais flexível (que substituiu o Heath Robinson). Após um teste funcional em dezembro de 1943, o Colossus foi enviado para Bletchley Park, onde foi entregue em 18 de janeiro de 1944 e atacou sua primeira mensagem em 5 de fevereiro.

O Colossus foi o primeiro computador programável digital eletrônico do mundo. Ele usou um grande número de válvulas (tubos de vácuo). Ele tinha entrada de fita de papel e era capaz de ser configurado para executar uma variedade de operações lógicas booleanas em seus dados, mas não era Turing-completo. A entrada de dados no Colossus foi por leitura fotoelétrica de uma transcrição de fita de papel da mensagem interceptada cifrada. Isso foi organizado em um loop contínuo para que pudesse ser lido e relido várias vezes - não havendo armazenamento interno para os dados. O mecanismo de leitura funcionava a 5.000 caracteres por segundo com a fita de papel movendo-se a 40 pés/s (12,2 m/s; 27,3 mph). O Colossus Mark 1 continha 1.500 válvulas termiônicas (tubos), mas o Mark 2 com 2.400 válvulas e cinco processadores em paralelo era 5 vezes mais rápido e simples de operar do que o Mark 1, acelerando bastante o processo de decodificação. O Mark 2 foi projetado enquanto o Mark 1 estava sendo construído. Allen Coombs assumiu a liderança do projeto Colossus Mark 2 quando Tommy Flowers passou para outros projetos. O primeiro Mark 2 Colossus tornou-se operacional em 1º de junho de 1944, bem a tempo para a invasão aliada da Normandia no Dia D.

A maior parte do uso do Colossus era determinar as posições iniciais dos rotores Tunny para uma mensagem, que era chamada de "ajuste da roda". O Colossus incluiu o primeiro uso de registradores de deslocamento e matrizes sistólicas, permitindo cinco testes simultâneos, cada um envolvendo até 100 cálculos booleanos. Isso permitiu que cinco diferentes posições iniciais possíveis fossem examinadas para um trânsito da fita de papel. Além da configuração da roda, alguns Colossi posteriores incluíram mecanismos destinados a ajudar a determinar os padrões de pinos conhecidos como "quebra da roda". Ambos os modelos eram programáveis usando interruptores e painéis de plugues de uma forma que seus predecessores não eram. Dez Mk 2 Colossi estavam operacionais no final da guerra.

Sem o uso dessas máquinas, os Aliados teriam sido privados da valiosa inteligência obtida a partir da leitura da vasta quantidade de mensagens telegráficas cifradas de alto nível entre o Alto Comando Alemão (OKW) e seus comandos do exército em todo o território ocupado Europa. Detalhes de sua existência, design e uso foram mantidos em segredo até a década de 1970. Winston Churchill emitiu pessoalmente uma ordem para sua destruição em pedaços não maiores que a mão de um homem, para manter em segredo que os britânicos eram capazes de quebrar as cifras Lorenz SZ (de máquinas alemãs de cifra de fluxo de rotor) durante a Guerra Fria que se aproximava. Duas das máquinas foram transferidas para o GCHQ recém-formado e as outras foram destruídas. Como resultado, as máquinas não foram incluídas em muitas histórias da computação. Uma cópia de trabalho reconstruída de uma das máquinas Colossus está agora em exibição no Bletchley Park.

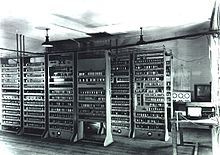

O ENIAC (Electronic Numerical Integrator and Computer) construído nos EUA foi o primeiro computador eletrônico programável construído nos EUA. Embora o ENIAC fosse semelhante ao Colossus, era muito mais rápido e flexível. Era inequivocamente um dispositivo Turing-completo e podia computar qualquer problema que coubesse em sua memória. Como o Colossus, um "programa" no ENIAC foi definido pelos estados de seus cabos e interruptores, muito longe das máquinas eletrônicas de programa armazenado que vieram depois. Depois que um programa era escrito, ele precisava ser inserido mecanicamente na máquina com a reinicialização manual de plugues e interruptores. As programadoras do ENIAC eram mulheres com formação em matemática.

Ele combinou a alta velocidade da eletrônica com a capacidade de ser programado para muitos problemas complexos. Podia somar ou subtrair 5.000 vezes por segundo, mil vezes mais rápido do que qualquer outra máquina. Ele também tinha módulos para multiplicar, dividir e raiz quadrada. A memória de alta velocidade era limitada a 20 palavras (equivalente a cerca de 80 bytes). Construído sob a direção de John Mauchly e J. Presper Eckert na Universidade da Pensilvânia, o desenvolvimento e a construção do ENIAC duraram de 1943 a plena operação no final de 1945. A máquina era enorme, pesando 30 toneladas, usando 200 quilowatts. de energia elétrica e continha mais de 18.000 tubos de vácuo, 1.500 relés e centenas de milhares de resistores, capacitores e indutores. Um de seus maiores feitos de engenharia foi minimizar os efeitos da queima do tubo, que era um problema comum na confiabilidade das máquinas naquela época. A máquina esteve em uso quase constante pelos dez anos seguintes.

Computador com programa armazenado

As primeiras máquinas de computação executavam a sequência definida de etapas, conhecida como "programa", que podia ser alterada alterando as conexões elétricas usando interruptores ou um patch panel (ou plugboard). No entanto, esse processo de "reprogramação" muitas vezes era difícil e demorado, exigindo que os engenheiros criassem fluxogramas e religassem fisicamente as máquinas. Os computadores de programa armazenado, por outro lado, foram projetados para armazenar um conjunto de instruções (um programa) na memória – normalmente a mesma memória dos dados armazenados.

Teoria

A base teórica para o computador de programa armazenado foi proposta por Alan Turing em seu artigo de 1936. Em 1945, Turing ingressou no Laboratório Nacional de Física e começou seu trabalho no desenvolvimento de um computador digital eletrônico com programa armazenado. Seu relatório de 1945 'Calculadora eletrônica proposta' foi a primeira especificação para tal dispositivo.

Enquanto isso, John von Neumann na Moore School of Electrical Engineering, University of Pennsylvania, circulou seu Primeiro Rascunho de um Relatório sobre o EDVAC em 1945. Embora substancialmente semelhante ao projeto de Turing e contendo comparativamente poucos detalhes de engenharia, a arquitetura do computador que ele esboçou tornou-se conhecida como a "arquitetura von Neumann". Turing apresentou um documento mais detalhado ao Comitê Executivo do National Physical Laboratory (NPL) em 1946, dando o primeiro projeto razoavelmente completo de um computador com programa armazenado, um dispositivo que ele chamou de Automatic Computing Engine (ACE). No entanto, o projeto EDVAC mais conhecido de John von Neumann, que conhecia o trabalho teórico de Turing, recebeu mais publicidade, apesar de sua natureza incompleta e questionável falta de atribuição das fontes de algumas das ideias.

Turing pensou que a velocidade e o tamanho da memória do computador eram elementos cruciais, então ele propôs uma memória de alta velocidade do que hoje seria chamada de 25 KB, acessada a uma velocidade de 1 MHz. O ACE implementava chamadas de sub-rotina, enquanto o EDVAC não o fazia, e o ACE também usava Abbreviated Computer Instructions, uma forma inicial de linguagem de programação.

Bebê de Manchester

O Manchester Baby (Small Scale Experimental Machine, SSEM) foi o primeiro computador eletrônico com programa armazenado do mundo. Foi construído na Victoria University of Manchester por Frederic C. Williams, Tom Kilburn e Geoff Tootill, e executou seu primeiro programa em 21 de junho de 1948.

A máquina não foi projetada para ser um computador prático, mas foi projetada como uma plataforma de teste para o tubo de Williams, o primeiro dispositivo de armazenamento digital de acesso aleatório. Inventado por Freddie Williams e Tom Kilburn na Universidade de Manchester em 1946 e 1947, era um tubo de raios catódicos que usava um efeito chamado emissão secundária para armazenar temporariamente dados binários eletrônicos e foi usado com sucesso em vários computadores antigos.

Descrito como pequeno e primitivo em uma retrospectiva de 1998, o Baby foi a primeira máquina funcional a conter todos os elementos essenciais para um computador eletrônico moderno. Assim que demonstrou a viabilidade de seu projeto, um projeto foi iniciado na universidade para desenvolver o projeto em um computador mais utilizável, o Manchester Mark 1. O Mark 1, por sua vez, rapidamente se tornou o protótipo do Ferranti Mark 1, o o primeiro computador de uso geral comercialmente disponível no mundo.

O bebê tinha um comprimento de palavra de 32 bits e uma memória de 32 palavras. Como foi projetado para ser o computador de programa armazenado mais simples possível, as únicas operações aritméticas implementadas no hardware foram a subtração e a negação; outras operações aritméticas foram implementadas em software. O primeiro dos três programas escritos para a máquina encontrou o maior divisor próprio de 218 (262.144), um cálculo que se sabia levaria muito tempo para ser executado - e assim provar a capacidade do computador confiabilidade — testando cada número inteiro de 218 − 1 para baixo, pois a divisão foi implementada pela subtração repetida do divisor. O programa consistia em 17 instruções e era executado por 52 minutos antes de atingir a resposta correta de 131.072, após o Baby ter realizado 3,5 milhões de operações (para uma velocidade efetiva de CPU de 1,1 kIPS). As aproximações sucessivas para a resposta foram exibidas como um padrão de pontos no CRT de saída que espelhava o padrão contido no tubo Williams usado para armazenamento.

Manchester Mark 1

O SSEM levou ao desenvolvimento do Manchester Mark 1 na Universidade de Manchester. O trabalho começou em agosto de 1948 e a primeira versão estava operacional em abril de 1949; um programa escrito para procurar por primos de Mersenne funcionou sem erros por nove horas na noite de 16/17 de junho de 1949. A operação bem-sucedida da máquina foi amplamente divulgada na imprensa britânica, que usou a expressão "cérebro eletrônico" ao descrevê-lo aos seus leitores.

O computador é especialmente significativo historicamente por causa de sua inclusão pioneira de registradores de índice, uma inovação que tornou mais fácil para um programa ler sequencialmente uma série de palavras na memória. Trinta e quatro patentes resultaram do desenvolvimento da máquina, e muitas das ideias por trás de seu design foram incorporadas em produtos comerciais subsequentes, como o IBM 701 e 702, bem como o Ferranti Mark 1. Os projetistas-chefe, Frederic C. Williams e Tom Kilburn, concluíram de suas experiências com o Mark 1 que os computadores seriam usados mais em funções científicas do que em matemática pura. Em 1951, eles iniciaram o trabalho de desenvolvimento do Meg, o sucessor do Mark 1, que incluiria uma unidade de ponto flutuante.

EDSAC

O outro candidato a ser o primeiro computador de programa armazenado digital reconhecidamente moderno foi o EDSAC, projetado e construído por Maurice Wilkes e sua equipe no Laboratório de Matemática da Universidade de Cambridge, na Inglaterra, na Universidade de Cambridge em 1949. A máquina foi inspirado pelo seminal de John von Neumann Primeiro rascunho de um relatório sobre o EDVAC e foi um dos primeiros computadores de programa armazenado eletrônico digital operacional útil.

O EDSAC executou seus primeiros programas em 6 de maio de 1949, quando calculou uma tabela de quadrados e uma lista de números primos. O EDSAC também serviu de base para o primeiro computador aplicado comercialmente, o LEO I, usado por uma empresa de fabricação de alimentos J. Lyons & Co. Ltd. O EDSAC 1 foi finalmente fechado em 11 de julho de 1958, tendo sido substituído pelo EDSAC 2, que permaneceu em uso até 1965.

O "cérebro" [computador] pode um dia descer ao nosso nível [das pessoas comuns] e ajudar com os nossos cálculos de renda e contabilidade. Mas isso é especulação e não há sinal disso até agora.

—Jornal britânico A Estrela em um artigo de notícias de junho de 1949 sobre o computador EDSAC, muito antes da era dos computadores pessoais.

EDVAC

Os inventores do ENIAC, John Mauchly e J. Presper Eckert, propuseram a construção do EDVAC em agosto de 1944, e o trabalho de design para o EDVAC começou na Moore School of Electrical Engineering da Universidade da Pensilvânia, antes que o ENIAC fosse totalmente operacional. O projeto implementou uma série de importantes melhorias arquitetônicas e lógicas concebidas durante a construção do ENIAC e uma memória de acesso serial de alta velocidade. No entanto, Eckert e Mauchly deixaram o projeto e sua construção fracassou.

Finalmente foi entregue ao Laboratório de Pesquisa Balística do Exército dos EUA no Campo de Provas de Aberdeen em agosto de 1949, mas devido a uma série de problemas, o computador só começou a operar em 1951, e apenas de forma limitada.

Computadores comerciais

O primeiro computador comercial foi o Ferranti Mark 1, construído por Ferranti e entregue à Universidade de Manchester em fevereiro de 1951. Ele era baseado no Manchester Mark 1. As principais melhorias em relação ao Manchester Mark 1 estavam no tamanho do computador armazenamento primário (usando tubos Williams de acesso aleatório), armazenamento secundário (usando um tambor magnético), um multiplicador mais rápido e instruções adicionais. O tempo de ciclo básico era de 1,2 milissegundos e uma multiplicação poderia ser concluída em cerca de 2,16 milissegundos. O multiplicador usou quase um quarto dos 4.050 tubos de vácuo (válvulas) da máquina. Uma segunda máquina foi comprada pela Universidade de Toronto, antes que o projeto fosse revisado para o Mark 1 Star. Pelo menos sete dessas máquinas posteriores foram entregues entre 1953 e 1957, uma delas para os laboratórios da Shell em Amsterdã.

Em outubro de 1947, os diretores da J. Lyons & Company, uma empresa de catering britânica famosa pelas suas casas de chá mas com forte interesse em novas técnicas de gestão de escritórios, decidiu assumir um papel activo na promoção do desenvolvimento comercial dos computadores. O computador LEO I (Lyons Electronic Office) tornou-se operacional em abril de 1951 e executou o primeiro trabalho regular de computador de escritório do mundo. Em 17 de novembro de 1951, a empresa J. Lyons iniciou a operação semanal de um trabalho de avaliação de padaria no LEO - o primeiro aplicativo de negócios a entrar em operação em um computador com programa armazenado.

Em junho de 1951, o UNIVAC I (Universal Automatic Computer) foi entregue ao U.S. Census Bureau. A Remington Rand acabou vendendo 46 máquinas por mais de US$ 1 milhão cada (US$ 10,4 milhões em 2023). O UNIVAC foi o primeiro produto "produzido em massa" computador. Ele usou 5.200 tubos de vácuo e consumiu 125 kW de energia. Seu armazenamento primário eram linhas de atraso de mercúrio de acesso serial capazes de armazenar 1.000 palavras de 11 dígitos decimais mais sinal (palavras de 72 bits).

A IBM introduziu um computador menor e mais acessível em 1954, que se mostrou muito popular. O IBM 650 pesava mais de 900 kg, a fonte de alimentação conectada pesava cerca de 1350 kg e ambos foram mantidos em armários separados de aproximadamente 1,5 × 0,9 × 1,8 m. O sistema custou US$ 500.000 (US$ 5,05 milhões em 2023) ou pode ser alugado por US$ 3.500 por mês ($ 40.000 em 2023). Sua memória de bateria era originalmente de 2.000 palavras de dez dígitos, posteriormente expandida para 4.000 palavras. Limitações de memória como essa dominariam a programação por décadas depois. As instruções do programa foram buscadas no tambor giratório enquanto o código rodava. A execução eficiente usando memória de bateria foi fornecida por uma combinação de arquitetura de hardware - o formato da instrução incluía o endereço da próxima instrução - e software: o Symbolic Optimal Assembly Program, SOAP, atribuiu instruções aos endereços ideais (na medida do possível por análise estática do programa fonte). Assim, muitas instruções foram, quando necessárias, localizadas na próxima linha do tambor para serem lidas e o tempo de espera adicional para a rotação do tambor foi reduzido.

Microprogramação

Em 1951, o cientista britânico Maurice Wilkes desenvolveu o conceito de microprogramação a partir da percepção de que a unidade central de processamento de um computador poderia ser controlada por um programa de computador em miniatura altamente especializado em ROM de alta velocidade. A microprogramação permite que o conjunto básico de instruções seja definido ou estendido por programas integrados (agora chamados de firmware ou microcódigo). Este conceito simplificou bastante o desenvolvimento da CPU. Ele descreveu isso pela primeira vez na Conferência Inaugural de Computadores da Universidade de Manchester em 1951, depois publicou de forma expandida no IEEE Spectrum em 1955.

Foi amplamente utilizado nas CPUs e unidades de ponto flutuante de mainframe e outros computadores; foi implementado pela primeira vez no EDSAC 2, que também usava várias "fatias de bits" para simplificar o projeto. Conjuntos de tubos intercambiáveis e substituíveis foram usados para cada bit do processador.

Memória magnética

As memórias de tambores magnéticos foram desenvolvidas para a Marinha dos Estados Unidos durante a Segunda Guerra Mundial, com o trabalho continuando na Engineering Research Associates (ERA) em 1946 e 1947. A ERA, então parte da Univac, incluiu uma memória de tambor em seu 1103, anunciada em fevereiro de 1953 O primeiro computador produzido em massa, o IBM 650, também anunciado em 1953, tinha cerca de 8,5 kilobytes de memória de bateria.

Memória de núcleo magnético patenteada em 1949 com seu primeiro uso demonstrado para o computador Whirlwind em agosto de 1953. A comercialização ocorreu rapidamente. Núcleo magnético foi usado em periféricos do IBM 702 entregue em julho de 1955 e, posteriormente, no próprio 702. O IBM 704 (1955) e o Ferranti Mercury (1957) usavam memória de núcleo magnético. Ele passou a dominar o campo na década de 1970, quando foi substituído por memória semicondutora. O núcleo magnético atingiu o pico de volume por volta de 1975 e declinou em uso e participação de mercado a partir de então.

Até 1980, as máquinas PDP-11/45 usando memória principal de núcleo magnético e tambores para troca ainda estavam em uso em muitos dos locais UNIX originais.

Características dos primeiros computadores digitais

| Nome | Primeira operação | Sistema numérico | Mecanismo de computação | Programação | Turing-completo |

|---|---|---|---|---|---|

| Arthur H. Dickinson IBM (EUA) | Janeiro de 1940 | Decimal | Eletrônica | Não programável | Não. |

| Joseph Desch NCR (EUA) | Março de 1940 | Decimal | Eletrônica | Não programável | Não. |

| Zuse Z3 (Alemanha) | Maio de 1941 | Ponto flutuante binário | Eletromecânica | Programa controlado por perfurado 35 mm estoque de filme (mas nenhum ramo condicional) | Em teoria (1998) |

| Atanasoff–Berry Computer (EUA) | 1942 | Binário | Eletrônica | Não programável — único propósito | Não. |

| Colossus Mark 1 (UK) | Fevereiro 1944 | Binário | Eletrônica | Programa-controlado por cabos de patch e interruptores | Não. |

| Harvard Mark I – IBM ASCC (EUA) | Maio de 1944 | Decimal | Eletromecânica | Controle do programa por fita de papel perfurada de 24 canais (mas sem ramo condicional) | Debatível. |

| Colossus Mark 2 (UK) | Junho de 1944 | Binário | Eletrônica | Programa-controlado por cabos de patch e interruptores | Conjecturas (2011) |

| Zuse Z4 (Alemanha) | Março de 1945 | Ponto flutuante binário | Eletromecânica | Programa controlado por perfurado 35 mm estoque de filme | Em 1950 |

| ENIAC (EUA) | Fevereiro de 1946 | Decimal | Eletrônica | Programa-controlado por cabos de patch e interruptores | Sim. |

| ARC2 (SEC) (UK) | Maio 1948 | Binário | Eletrônica | Programa armazenado em memória de tambor rotativa | Sim. |

| Manchester Baby (UK) | Junho de 1948 | Binário | Eletrônica | Programa armazenado em memória de tubo de catódeo Williams | Sim. |

| ENIAC modificado (EUA) | Setembro 1948 | Decimal | Eletrônica | Mecanismo de programação apenas armazenado usando as tabelas de função como programa ROM | Sim. |

| Manchester Mark 1 (UK) | Abril de 1949 | Binário | Eletrônica | Programa armazenado em memória de tubo de cathode-ray Williams e memória de tambor magnético | Sim. |

| EDSAC (UK) | Maio de 1949 | Binário | Eletrônica | Programa armazenado em memória de delay de mercúrio | Sim. |

| CSIRAC (Austrália) | Novembro de 1949 | Binário | Eletrônica | Programa armazenado em memória de delay de mercúrio | Sim. |

Computadores transistorizados

O transistor bipolar foi inventado em 1947. A partir de 1955, os transistores substituíram os tubos de vácuo em projetos de computador, dando origem à "segunda geração" de computadores. Comparados aos tubos de vácuo, os transistores têm muitas vantagens: eles são menores e requerem menos energia do que os tubos de vácuo, portanto liberam menos calor. Os transistores de junção de silício eram muito mais confiáveis do que os tubos de vácuo e tinham uma vida útil mais longa. Computadores transistorizados podem conter dezenas de milhares de circuitos lógicos binários em um espaço relativamente compacto. Os transistores reduziram bastante a capacidade dos computadores. tamanho, custo inicial e custo operacional. Normalmente, os computadores de segunda geração eram compostos de um grande número de placas de circuito impresso, como o IBM Standard Modular System, cada uma carregando de um a quatro portas lógicas ou flip-flops.

Na Universidade de Manchester, uma equipe sob a liderança de Tom Kilburn projetou e construiu uma máquina usando os recém-desenvolvidos transistores em vez de válvulas. Inicialmente, os únicos dispositivos disponíveis eram transistores de ponto de contato de germânio, menos confiáveis do que as válvulas que eles substituíram, mas que consumiam muito menos energia. Seu primeiro computador transistorizado, e o primeiro do mundo, estava operacional em 1953, e uma segunda versão foi concluída lá em abril de 1955. A versão de 1955 usava 200 transistores, 1.300 diodos de estado sólido e tinha um consumo de energia de 150 watts. No entanto, a máquina fez uso de válvulas para gerar suas formas de onda de relógio de 125 kHz e no circuito para ler e escrever em sua memória de tambor magnético, portanto, não foi o primeiro computador completamente transistorizado.

Essa distinção vai para o Harwell CADET de 1955, construído pela divisão eletrônica do Atomic Energy Research Establishment em Harwell. O projeto apresentava um armazenamento de memória de tambor magnético de 64 kilobytes com várias cabeças móveis que foram projetadas no National Physical Laboratory, no Reino Unido. Em 1953, essa equipe tinha circuitos de transistor operando para ler e escrever em um tambor magnético menor do Royal Radar Establishment. A máquina usava uma velocidade de clock baixa de apenas 58 kHz para evitar o uso de válvulas para gerar as formas de onda do clock.

O CADET usou transistores de contato de 324 pontos fornecidos pela empresa britânica Standard Telephones and Cables; 76 transistores de junção foram usados para os amplificadores de primeiro estágio para dados lidos do tambor, uma vez que os transistores de ponto de contato eram muito barulhentos. A partir de agosto de 1956, o CADET passou a oferecer um serviço de computação regular, durante o qual frequentemente executava execuções contínuas de computação de 80 horas ou mais. Problemas com a confiabilidade dos primeiros lotes de pontos de contato e transistores de junção de liga significavam que o tempo médio da máquina entre falhas era de cerca de 90 minutos, mas isso melhorou quando os transistores de junção bipolar mais confiáveis se tornaram disponíveis.

O design do Computador Transistor da Manchester University foi adotado pela empresa de engenharia local Metropolitan-Vickers em seu Metrovick 950, o primeiro computador comercial a transistor em qualquer lugar. Seis Metrovick 950 foram construídos, o primeiro concluído em 1956. Eles foram implantados com sucesso em vários departamentos da empresa e estiveram em uso por cerca de cinco anos. Um computador de segunda geração, o IBM 1401, capturou cerca de um terço do mercado mundial. A IBM instalou mais de dez mil 1401s entre 1960 e 1964.

Periféricos do transistor

Eletrônica transistorizada melhorou não apenas a CPU (Central Processing Unit), mas também os dispositivos periféricos. As unidades de armazenamento de dados em disco de segunda geração foram capazes de armazenar dezenas de milhões de letras e dígitos. Ao lado das unidades fixas de armazenamento em disco, conectadas à CPU por meio de transmissão de dados em alta velocidade, havia unidades removíveis de armazenamento de dados em disco. Um pacote de disco removível pode ser facilmente trocado por outro pacote em poucos segundos. Mesmo que os discos removíveis' capacidade é menor do que os discos fixos, sua intercambialidade garante uma quantidade quase ilimitada de dados à mão. A fita magnética forneceu capacidade de arquivamento para esses dados, a um custo menor do que o disco.

Muitas CPUs de segunda geração delegam comunicações de dispositivos periféricos a um processador secundário. Por exemplo, enquanto o processador de comunicação controlava a leitura e perfuração do cartão, a CPU principal executava cálculos e instruções de ramificação binária. Um barramento de dados transportaria dados entre a CPU principal e a memória central na taxa de ciclo de busca-execução da CPU, e outros barramentos de dados normalmente atenderiam aos dispositivos periféricos. No PDP-1, o tempo de ciclo da memória central era de 5 microssegundos; consequentemente, a maioria das instruções aritméticas levava 10 microssegundos (100.000 operações por segundo) porque a maioria das operações levava pelo menos dois ciclos de memória; um para a instrução, um para a busca de dados do operando.

Durante a segunda geração, as unidades terminais remotas (muitas vezes na forma de teleimpressoras como um Friden Flexowriter) tiveram um uso muito maior. As conexões telefônicas forneciam velocidade suficiente para os primeiros terminais remotos e permitiam centenas de quilômetros de separação entre os terminais remotos e o centro de computação. Eventualmente, essas redes de computadores independentes seriam generalizadas em uma rede de redes interconectada - a Internet.

Supercomputadores a transistor

O início dos anos 1960 viu o advento da supercomputação. O Atlas foi um desenvolvimento conjunto entre a Universidade de Manchester, Ferranti e Plessey, e foi instalado pela primeira vez na Universidade de Manchester e comissionado oficialmente em 1962 como um dos primeiros supercomputadores do mundo - considerado o computador mais poderoso do mundo. mundo naquela época. Dizia-se que sempre que o Atlas ficava offline, metade da capacidade do computador do Reino Unido era perdida. Era uma máquina de segunda geração, usando transistores de germânio discretos. A Atlas também foi pioneira no Atlas Supervisor, "considerado por muitos como o primeiro sistema operacional moderno reconhecível".

Nos Estados Unidos, uma série de computadores da Control Data Corporation (CDC) foram projetados por Seymour Cray para usar projetos inovadores e paralelismo para alcançar um desempenho computacional superior. O CDC 6600, lançado em 1964, é geralmente considerado o primeiro supercomputador. O CDC 6600 superou seu antecessor, o IBM 7030 Stretch, por cerca de um fator de 3. Com desempenho de cerca de 1 megaFLOPS, o CDC 6600 foi o computador mais rápido do mundo de 1964 a 1969, quando cedeu esse status a seu sucessor, o CDC 7600.

Computadores de circuito integrado

A "terceira geração" dos computadores eletrônicos digitais usavam chips de circuito integrado (IC) como base de sua lógica.

A ideia de um circuito integrado foi concebida por um cientista de radar que trabalhava para o Royal Radar Establishment do Ministério da Defesa, Geoffrey W.A. Dummer.

Os primeiros circuitos integrados funcionais foram inventados por Jack Kilby na Texas Instruments e Robert Noyce na Fairchild Semiconductor. Kilby registrou suas ideias iniciais sobre o circuito integrado em julho de 1958, demonstrando com sucesso o primeiro exemplo integrado funcional em 12 de setembro de 1958. A invenção de Kilby foi um circuito integrado híbrido (híbrido IC). Tinha conexões de fios externos, o que dificultava a produção em massa.

Noyce teve sua própria ideia de um circuito integrado meio ano depois de Kilby. A invenção de Noyce foi um chip monolítico de circuito integrado (IC). Seu chip resolveu muitos problemas práticos que o de Kilby não tinha. Produzido na Fairchild Semiconductor, era feito de silício, enquanto o chip de Kilby era feito de germânio. A base para o CI monolítico de Noyce foi o processo planar de Fairchild, que permitiu que os circuitos integrados fossem dispostos usando os mesmos princípios dos circuitos impressos. O processo planar foi desenvolvido pelo colega de Noyce, Jean Hoerni, no início de 1959, com base no trabalho de Mohamed M. Atalla sobre passivação de superfície de semicondutores por dióxido de silício no Bell Labs no final dos anos 1950.

Os computadores de terceira geração (circuito integrado) apareceram pela primeira vez no início dos anos 1960 em computadores desenvolvidos para fins governamentais e, em seguida, em computadores comerciais a partir de meados dos anos 1960. O primeiro computador IC de silício foi o Apollo Guidance Computer ou AGC. Embora não fosse o computador mais poderoso de sua época, as restrições extremas de tamanho, massa e potência da espaçonave Apollo exigiam que o AGC fosse muito menor e mais denso do que qualquer computador anterior, pesando apenas 70 libras (32 kg). Cada missão de pouso lunar carregava dois AGCs, um em cada um dos módulos de comando e subida lunar.

Memória do semicondutor

O MOSFET (transistor de efeito de campo de metal-óxido-semicondutor, ou transistor MOS) foi inventado por Mohamed M. Atalla e Dawon Kahng no Bell Labs em 1959. Além do processamento de dados, o MOSFET permitiu o uso prático de MOS transistores como elementos de armazenamento de células de memória, uma função anteriormente servida por núcleos magnéticos. A memória semicondutora, também conhecida como memória MOS, era mais barata e consumia menos energia do que a memória de núcleo magnético. A memória de acesso aleatório (RAM) MOS, na forma de RAM estática (SRAM), foi desenvolvida por John Schmidt na Fairchild Semiconductor em 1964. Em 1966, Robert Dennard no IBM Thomas J. Watson Research Center desenvolveu a RAM dinâmica MOS (DRAM). Em 1967, Dawon Kahng e Simon Sze, da Bell Labs, desenvolveram o MOSFET de porta flutuante, a base da memória não volátil MOS, como EPROM, EEPROM e memória flash.

Computadores microprocessados

A "quarta geração" dos computadores eletrônicos digitais usavam microprocessadores como base de sua lógica. O microprocessador tem origem no chip de circuito integrado MOS (MOS IC). Devido ao rápido dimensionamento do MOSFET, os chips MOS IC aumentaram rapidamente em complexidade a uma taxa prevista pela lei de Moore, levando à integração em larga escala (LSI) com centenas de transistores em um único chip MOS no final dos anos 1960. A aplicação de chips MOS LSI à computação foi a base para os primeiros microprocessadores, pois os engenheiros começaram a reconhecer que um processador de computador completo poderia estar contido em um único chip MOS LSI.

O assunto de exatamente qual dispositivo foi o primeiro microprocessador é controverso, em parte devido à falta de acordo sobre a definição exata do termo "microprocessador". Os primeiros microprocessadores multichip foram o Four-Phase Systems AL-1 em 1969 e Garrett AiResearch MP944 em 1970, desenvolvidos com múltiplos chips MOS LSI. O primeiro microprocessador de chip único foi o Intel 4004, desenvolvido em um único chip PMOS LSI. Foi projetado e realizado por Ted Hoff, Federico Faggin, Masatoshi Shima e Stanley Mazor da Intel, e lançado em 1971. Tadashi Sasaki e Masatoshi Shima da Busicom, um fabricante de calculadoras, tiveram a percepção inicial de que a CPU poderia ser um único MOS LSI chip, fornecido pela Intel.

Enquanto os primeiros CIs de microprocessador continham literalmente apenas o processador, ou seja, a unidade central de processamento de um computador, seu desenvolvimento progressivo naturalmente levou a chips contendo a maioria ou todas as partes eletrônicas internas de um computador. O circuito integrado na imagem à direita, por exemplo, um Intel 8742, é um microcontrolador de 8 bits que inclui uma CPU rodando a 12 MHz, 128 bytes de RAM, 2.048 bytes de EPROM e E/S no mesmo chip.

Durante a década de 1960, houve uma sobreposição considerável entre as tecnologias de segunda e terceira geração. A IBM implementou seus módulos IBM Solid Logic Technology em circuitos híbridos para o IBM System/360 em 1964. Ainda em 1975, a Sperry Univac continuou a fabricar máquinas de segunda geração, como o UNIVAC 494. Os grandes sistemas Burroughs, como o B5000, foram empilhar máquinas, o que permitiu uma programação mais simples. Esses autômatos pushdown também foram implementados em minicomputadores e microprocessadores posteriormente, o que influenciou o design da linguagem de programação. Os minicomputadores serviram como centros de computação de baixo custo para a indústria, empresas e universidades. Tornou-se possível simular circuitos analógicos com o programa de simulação com ênfase em circuito integrado, ou SPICE (1971) em minicomputadores, um dos programas para automação de projeto eletrônico (EDA). O microprocessador levou ao desenvolvimento de microcomputadores, computadores pequenos e de baixo custo que podiam ser propriedade de indivíduos e pequenas empresas. Os microcomputadores, o primeiro dos quais apareceu na década de 1970, tornaram-se onipresentes na década de 1980 e além.

Embora seja uma questão de debate qual produto específico é considerado o primeiro sistema de microcomputador, um dos primeiros é o R2E's Micral N (François Gernelle, André Truong) lançado "início de 1973" usando o Intel 8008. O primeiro kit de microcomputador disponível comercialmente foi o Altair 8800 baseado em Intel 8080, anunciado no artigo de capa de janeiro de 1975 da Popular Electronics. No entanto, o Altair 8800 era um sistema extremamente limitado em seus estágios iniciais, tendo apenas 256 bytes de DRAM em seu pacote inicial e nenhuma entrada-saída, exceto suas chaves de alternância e exibição de registro de LED. Apesar disso, foi inicialmente surpreendentemente popular, com várias centenas de vendas no primeiro ano, e a demanda superou rapidamente a oferta. Vários fornecedores terceirizados, como a Cromemco e a Processor Technology, logo começaram a fornecer hardware de barramento S-100 adicional para o Altair 8800.

Em abril de 1975, na Feira de Hannover, a Olivetti apresentou o P6060, o primeiro sistema de computador pessoal completo e pré-montado do mundo. A unidade central de processamento consistia em dois cartões, com os nomes de código PUCE1 e PUCE2, e, ao contrário da maioria dos outros computadores pessoais, era construída com componentes TTL em vez de um microprocessador. Tinha um ou dois 8" unidades de disquete, um display de plasma de 32 caracteres, impressora térmica gráfica de 80 colunas, 48 Kbytes de RAM e linguagem BASIC. Ele pesava 40 kg (88 lb). Como um sistema completo, este foi um passo significativo em relação ao Altair, embora nunca tenha alcançado o mesmo sucesso. Concorreu com um produto similar da IBM que tinha uma unidade de disquete externa.

De 1975 a 1977, a maioria dos microcomputadores, como o MOS Technology KIM-1, o Altair 8800 e algumas versões do Apple I, foram vendidos como kits para bricolage. Os sistemas pré-montados não ganharam muito terreno até 1977, com a introdução do Apple II, do Tandy TRS-80, dos primeiros computadores SWTPC e do Commodore PET. A computação evoluiu com arquiteturas de microcomputadores, com recursos adicionados de seus irmãos maiores, agora dominantes na maioria dos segmentos de mercado.

Um computador NeXT e suas ferramentas e bibliotecas de desenvolvimento orientadas a objetos foram usados por Tim Berners-Lee e Robert Cailliau no CERN para desenvolver o primeiro software de servidor web do mundo, CERN httpd, e também usado para escrever o primeiro navegador da Web, WorldWideWeb.

Sistemas tão complicados quanto os computadores exigem uma confiabilidade muito alta. O ENIAC permaneceu em operação contínua de 1947 a 1955, por oito anos antes de ser desativado. Embora um tubo de vácuo possa falhar, ele seria substituído sem derrubar o sistema. Pela simples estratégia de nunca desligar o ENIAC, as falhas foram drasticamente reduzidas. Os computadores de defesa aérea SAGE de tubo de vácuo tornaram-se notavelmente confiáveis - instalados em pares, um off-line, os tubos com probabilidade de falhar o fizeram quando o computador foi intencionalmente executado com energia reduzida para encontrá-los. Os discos rígidos hot-pluggable, como os tubos de vácuo hot-pluggable do passado, continuam a tradição de reparo durante a operação contínua. Memórias de semicondutores rotineiramente não apresentam erros quando operam, embora sistemas operacionais como o Unix tenham empregado testes de memória na inicialização para detectar falhas de hardware. Hoje, o requisito de desempenho confiável torna-se ainda mais rigoroso quando os farms de servidores são a plataforma de entrega. O Google conseguiu isso usando software tolerante a falhas para se recuperar de falhas de hardware e está até trabalhando no conceito de substituir farms de servidores inteiros durante um evento de serviço.

No século 21, as CPUs multi-core tornaram-se disponíveis comercialmente. A memória endereçável por conteúdo (CAM) tornou-se barata o suficiente para ser usada em redes e é frequentemente usada para memória cache no chip em microprocessadores modernos, embora nenhum sistema de computador tenha implementado CAMs de hardware para uso em linguagens de programação. Atualmente, CAMs (ou matrizes associativas) em software são específicos da linguagem de programação. As matrizes de células de memória semicondutoras são estruturas muito regulares e os fabricantes comprovam seus processos nelas; isso permite reduções de preço em produtos de memória. Durante a década de 1980, as portas lógicas CMOS desenvolveram-se em dispositivos que podiam ser fabricados tão rapidamente quanto outros tipos de circuitos; o consumo de energia do computador pode, portanto, ser reduzido drasticamente. Ao contrário do consumo de corrente contínua de uma porta com base em outros tipos de lógica, uma porta CMOS só consome corrente significativa durante a 'transição' entre estados lógicos, exceto para vazamento.

Circuitos CMOS permitiram que a computação se tornasse uma mercadoria que agora é onipresente, incorporada em muitas formas, desde cartões comemorativos e telefones até satélites. A potência de design térmico que é dissipada durante a operação tornou-se tão essencial quanto a velocidade de operação do computador. Em 2006, os servidores consumiram 1,5% do orçamento total de energia dos EUA. Esperava-se que o consumo de energia dos centros de dados de computadores dobrasse para 3% do consumo mundial até 2011. O SoC (sistema em um chip) comprimiu ainda mais os circuitos integrados em um único chip; Os SoCs estão permitindo que telefones e PCs convergissem em dispositivos móveis sem fio portáteis individuais.

A computação quântica é uma tecnologia emergente no campo da computação. A MIT Technology Review informou em 10 de novembro de 2017 que a IBM criou um computador de 50 qubits; atualmente seu estado quântico dura 50 microssegundos. Os pesquisadores do Google conseguiram estender o limite de tempo de 50 microssegundos, conforme relatado em 14 de julho de 2021 na Nature; a estabilidade foi ampliada 100 vezes, espalhando um único qubit lógico sobre cadeias de qubits de dados para correção de erros quânticos. A Physical Review X relatou uma técnica para 'detecção de porta única como um método de leitura viável para spin qubits' (um estado de rotação singlet-triplet em silício) em 26 de novembro de 2018. Uma equipe do Google conseguiu operar seu chip modulador de pulso de RF a 3 Kelvin, simplificando a criogenia de seu computador de 72 qubits, configurado para operar a 0,3 Kelvin; mas o circuito de leitura e outro driver ainda precisam ser levados para a criogenia. Veja: Supremacia quântica Os sistemas de qubits de silício demonstraram emaranhamento em distâncias não locais.

O hardware de computação e seu software tornaram-se até uma metáfora para a operação do universo.

Epílogo

Uma indicação da rapidez do desenvolvimento deste campo pode ser inferida a partir da história do artigo seminal de 1947 de Burks, Goldstine e von Neumann. No momento em que alguém teve tempo de escrever alguma coisa, já era obsoleto. Depois de 1945, outros leram o Primeiro Rascunho de um Relatório sobre o EDVAC de John von Neumann e imediatamente começaram a implementar seus próprios sistemas. Até hoje, o ritmo acelerado de desenvolvimento continua, em todo o mundo.

Contenido relacionado

Cirix 6x86

AMD K6

Transporte no Kuwait