História da internet

A história da Internet tem sua origem na teoria da informação e nos esforços de cientistas e engenheiros para construir e interconectar redes de computadores. O Internet Protocol Suite, conjunto de regras utilizadas para a comunicação entre redes e dispositivos na Internet, surgiu a partir de pesquisa e desenvolvimento nos Estados Unidos e envolveu colaboração internacional, principalmente com pesquisadores do Reino Unido e da França.

A ciência da computação era uma disciplina emergente no final dos anos 1950 que começou a considerar o compartilhamento de tempo entre usuários de computador e, posteriormente, a possibilidade de alcançá-lo em redes de longa distância. J. C. R. Licklider desenvolveu a ideia de uma rede universal no Escritório de Técnicas de Processamento de Informações (IPTO) da Agência de Projetos de Pesquisa Avançada (ARPA) do Departamento de Defesa dos Estados Unidos (DoD). Independentemente, Paul Baran, da RAND Corporation, propôs uma rede distribuída baseada em dados em blocos de mensagens no início dos anos 1960, e Donald Davies concebeu a comutação de pacotes em 1965 no National Physical Laboratory (NPL), propondo uma rede comercial nacional de dados nos Estados Unidos. Reino.

A ARPA concedeu contratos em 1969 para o desenvolvimento do projeto ARPANET, dirigido por Robert Taylor e gerenciado por Lawrence Roberts. A ARPANET adotou a tecnologia de comutação de pacotes proposta por Davies e Baran, sustentada pelo trabalho matemático no início dos anos 1970 por Leonard Kleinrock na UCLA. A rede foi construída por uma equipe da Bolt, Beranek e Newman, que incluía Bob Kahn.

Várias redes de comutação de pacotes surgiram na década de 1970, que pesquisavam e forneciam redes de dados. Projetos ARPA, grupos de trabalho internacionais e iniciativas comerciais levaram ao desenvolvimento de vários padrões e protocolos para internetworking, nos quais várias redes separadas podem ser unidas em uma rede de redes. Bob Kahn, agora na DARPA, e Vint Cerf, na Universidade de Stanford, publicaram uma pesquisa em 1974 que evoluiu para o Protocolo de Controle de Transmissão (TCP) e o Protocolo de Internet (IP), dois protocolos do conjunto de protocolos da Internet. O projeto incluiu conceitos do projeto francês CYCLADES dirigido por Louis Pouzin.

No início dos anos 80, surgiram redes públicas de dados nacionais e internacionais baseadas no protocolo X.25, cujo desenho contou com o trabalho de Rémi Després. Nos Estados Unidos, a National Science Foundation (NSF) financiou centros nacionais de supercomputação em várias universidades nos Estados Unidos e forneceu interconectividade em 1986 com o projeto NSFNET, criando assim acesso à rede a esses sites de supercomputadores para pesquisa e organizações acadêmicas nos Estados Unidos. Estados. As conexões internacionais com a NSFNET, o surgimento de arquiteturas como o Domain Name System e a adoção do TCP/IP internacionalmente nas redes existentes marcaram o início da Internet. Provedores de serviços de Internet (ISPs) comerciais surgiram em 1989 nos Estados Unidos e na Austrália. A ARPANET foi desativada em 1990. Conexões privadas limitadas a partes da Internet por entidades oficialmente comerciais surgiram em várias cidades americanas no final de 1989 e 1990. O backbone óptico da NSFNET foi desativado em 1995, removendo as últimas restrições ao uso do Internet para transportar tráfego comercial, como tráfego transferido para redes ópticas gerenciadas pela Sprint, MCI e AT&T.

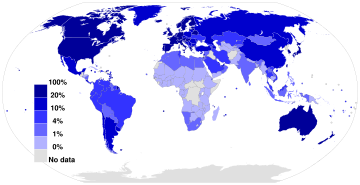

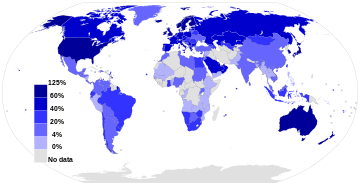

Pesquisas no CERN na Suíça pelo cientista da computação britânico Tim Berners-Lee em 1989–90 resultaram na World Wide Web, ligando documentos de hipertexto em um sistema de informação, acessível de qualquer nó na rede. A dramática expansão da capacidade da Internet com o advento da multiplexação por divisão de onda (WDM) e a implantação dos cabos de fibra ótica em meados da década de 1990 teve um impacto revolucionário na cultura, comércio e tecnologia. Isso possibilitou o surgimento da comunicação quase instantânea por correio eletrônico, mensagens instantâneas, chamadas telefônicas de voz sobre protocolo de Internet (VoIP), bate-papo por vídeo e a World Wide Web com seus fóruns de discussão, blogs, serviços de redes sociais e sites de compras online.. Quantidades crescentes de dados são transmitidas em velocidades cada vez mais altas em redes de fibra óptica operando a 1 Gbit/s, 10 Gbit/s e 800 Gbit/s até 2019. A aquisição da Internet no cenário global de comunicação foi rápida em termos históricos: comunicou apenas 1% da informação que fluiu através de redes bidirecionais de telecomunicações no ano de 1993, 51% em 2000 e mais de 97% da informação telecomunicada em 2007. A Internet continua a crescer, impulsionada por maiores quantidades de informações on-line, comércio, entretenimento e serviços de redes sociais. No entanto, o futuro da rede global pode ser moldado por diferenças regionais.

Fundamentos

Precursores

- Comunicação de dados

O conceito de comunicação de dados – transmissão de dados entre dois lugares diferentes através de um meio eletromagnético, como rádio ou fio elétrico – é anterior à introdução dos primeiros computadores. Tais sistemas de comunicação eram tipicamente limitados à comunicação ponto a ponto entre dois dispositivos finais. Linhas de semáforos, sistemas de telégrafo e máquinas de telex podem ser considerados os primeiros precursores desse tipo de comunicação. O telégrafo no final do século 19 foi o primeiro sistema de comunicação totalmente digital.

- Teoria da informação

O trabalho teórico fundamental sobre a teoria da informação foi desenvolvido por Harry Nyquist e Ralph Hartley na década de 1920. A teoria da informação, conforme enunciada por Claude Shannon, em 1948, forneceu uma base teórica sólida para entender os trade-offs entre relação sinal-ruído, largura de banda e transmissão livre de erros na presença de ruído, na tecnologia de telecomunicações. Este foi um dos três principais desenvolvimentos, juntamente com os avanços na tecnologia de transistores (especificamente transistores MOS) e na tecnologia de laser, que possibilitaram o rápido crescimento da largura de banda de telecomunicações no meio século seguinte.

- Computadores

Os primeiros computadores da década de 1940 tinham uma unidade central de processamento e terminais de usuário. À medida que a tecnologia evoluiu na década de 1950, novos sistemas foram concebidos para permitir a comunicação em distâncias maiores (para terminais) ou com maior velocidade (para interconexão de dispositivos locais) que eram necessários para o modelo de computador mainframe. Essas tecnologias possibilitaram a troca de dados (como arquivos) entre computadores remotos. No entanto, o modelo de comunicação ponto a ponto era limitado, pois não permitia a comunicação direta entre quaisquer dois sistemas arbitrários; era necessário um link físico. A tecnologia também foi considerada vulnerável para uso estratégico e militar porque não havia caminhos alternativos para a comunicação em caso de quebra de link.

Inspiração

Os primeiros computadores eram conectados diretamente a terminais usados por um usuário individual. Christopher Strachey, que se tornou o primeiro professor de computação da Universidade de Oxford, entrou com um pedido de patente para time-sharing em fevereiro de 1959. Em junho daquele ano, ele apresentou um artigo "Time Sharing in Large Fast Computers" na Conferência de Processamento de Informação da UNESCO em Paris, onde passou o conceito para J. C. R. Licklider. Licklider, vice-presidente da Bolt Beranek and Newman, Inc., propôs uma rede de computadores em seu artigo de janeiro de 1960 Man-Computer Symbiosis:

Uma rede de tais centros, conectados uns aos outros por linhas de comunicação de banda larga [...] as funções das bibliotecas atuais, juntamente com avanços antecipados em armazenamento de informação e recuperação e funções simbióticas sugeridas anteriormente neste artigo

Em agosto de 1962, Licklider e Welden Clark publicaram o artigo "On-Line Man-Computer Communication" que foi uma das primeiras descrições de um futuro em rede.

Em outubro de 1962, Licklider foi contratado por Jack Ruina como diretor do recém-criado Escritório de Técnicas de Processamento de Informações (IPTO) dentro da DARPA, com mandato para interconectar os principais computadores do Departamento de Defesa dos Estados Unidos em Cheyenne Mountain, o Pentágono e SAC HQ. Lá ele formou um grupo informal dentro da DARPA para promover a pesquisa de computadores. Ele começou escrevendo memorandos em 1963 descrevendo uma rede distribuída para a equipe do IPTO, a quem chamou de "Membros e Afiliados da Rede Intergaláctica de Computadores".

Embora ele tenha deixado o IPTO em 1964, cinco anos antes de a ARPANET entrar em operação, foi sua visão de rede universal que impulsionou um de seus sucessores, Robert Taylor, a iniciar o desenvolvimento da ARPANET. Licklider mais tarde voltou a liderar o IPTO em 1973 por dois anos.

Comutação de pacotes

A questão de conectar redes físicas separadas para formar uma rede lógica foi o primeiro de muitos problemas. As primeiras redes usavam sistemas de comutação de mensagens que exigiam estruturas de roteamento rígidas, propensas a pontos únicos de falha. Na década de 1960, Paul Baran, da RAND Corporation, produziu um estudo de redes de sobrevivência para os militares dos EUA em caso de guerra nuclear. As informações transmitidas pela rede de Baran seriam divididas no que ele chamou de "blocos de mensagem". De forma independente, Donald Davies (National Physical Laboratory, Reino Unido), propôs e colocou em prática uma rede local baseada no que chamou de comutação de pacotes, termo que viria a ser adotado.

A comutação de pacotes é um design de rede de armazenamento e encaminhamento rápido que divide as mensagens em pacotes arbitrários, com decisões de roteamento feitas por pacote. Ele fornece melhor utilização de largura de banda e tempos de resposta do que a tecnologia tradicional de comutação de circuitos usada para telefonia, particularmente em links de interconexão com recursos limitados.

Redes que levaram à Internet

Rede NPL

Após discussões com J. C. R. Licklider em 1965, Donald Davies se interessou por comunicações de dados para redes de computadores. Mais tarde naquele ano, no Laboratório Nacional de Física do Reino Unido, Davies projetou e propôs uma rede de dados comercial nacional baseada em comutação de pacotes. No ano seguinte, ele descreveu o uso de um "Interface de computador" para atuar como um roteador. A proposta não foi aceita nacionalmente, mas ele produziu um projeto para uma rede local para atender às necessidades da NPL e provar a viabilidade da comutação de pacotes usando transmissão de dados em alta velocidade. Para lidar com permutações de pacotes (devido a preferências de rota atualizadas dinamicamente) e perdas de datagramas (inevitáveis quando fontes rápidas enviam para destinos lentos), ele assumiu que "todos os usuários da rede fornecerão algum tipo de controle de erro& #34;, inventando assim o que veio a ser conhecido como princípio ponta a ponta. Ele e sua equipe foram um dos primeiros a usar o termo 'protocolo' em um contexto de comutação de dados em 1967. O desenvolvimento da rede foi descrito em uma conferência de 1968.

Em 1968, Davies começou a construir a rede de comutação de pacotes Mark I para atender às necessidades do laboratório multidisciplinar e provar a tecnologia em condições operacionais. A rede local NPL e a ARPANET foram as duas primeiras redes do mundo a usar comutação de pacotes, e a rede NPL foi a primeira a usar links de alta velocidade. Muitas outras redes de comutação de pacotes construídas na década de 1970 eram semelhantes "em quase todos os aspectos" para Davies' projeto original de 1965. A equipe da NPL realizou um trabalho de simulação em redes de pacotes, incluindo redes de datagramas, e pesquisas sobre interligação de redes e segurança de redes de computadores. A versão Mark II que operou a partir de 1973 usou uma arquitetura de protocolo em camadas. Em 1976, 12 computadores e 75 dispositivos terminais foram conectados e mais foram adicionados até que a rede foi substituída em 1986.

ARPANET

Robert Taylor foi promovido a chefe do Gabinete de Técnicas de Processamento de Informação (IPTO) na Agência de Projetos de Pesquisa Avançada de Defesa (DARPA) em 1966. Ele pretendia realizar as ideias de Licklider de um sistema de rede interconectado. Como parte do papel do IPTO, três terminais de rede foram instalados: um para a System Development Corporation em Santa Monica, um para o Project Genie na University of California, Berkeley e um para o projeto Compatible Time-Sharing System em Massachusetts. Instituto de Tecnologia (MIT). A necessidade identificada de Taylor por networking tornou-se óbvia pelo desperdício de recursos aparente para ele.

Para cada um desses três terminais, eu tinha três conjuntos diferentes de comandos de usuário. Então, se eu estava falando on-line com alguém na S.D.C. e eu queria falar com alguém que eu conhecia em Berkeley ou M.I.T. sobre isso, eu tive que subir do terminal S.D.C., ir para o outro terminal e entrar em contato com eles... Eu disse, meu, é óbvio o que fazer: Se você tem esses três terminais, deve haver um terminal que vai para qualquer lugar que você quer ir onde você tem computação interativa. Essa ideia é a ARPAnet.

Trazendo Larry Roberts do MIT em janeiro de 1967, ele iniciou um projeto para construir essa rede. Roberts e Thomas Merrill pesquisavam o compartilhamento de tempo de computador em redes de longa distância (WANs). As redes de longa distância surgiram durante a década de 1950 e se estabeleceram durante a década de 1960. No primeiro ACM Symposium on Operating Systems Principles em outubro de 1967, Roberts apresentou uma proposta para a "arpa net", baseada na proposta de Wesley Clark de usar processadores de mensagens de interface para criar uma rede de comutação de mensagens. Na conferência, Roger Scantlebury apresentou Donald Davies' trabalho em comutação de pacotes para comunicações de dados e mencionou o trabalho de Paul Baran na RAND. Roberts incorporou os conceitos de comutação de pacotes no projeto da ARPANET e atualizou a velocidade de comunicação proposta de 2,4 kbps para 50 kbps. Leonard Kleinrock posteriormente desenvolveu a teoria matemática para modelar e medir o desempenho dessa tecnologia, com base em seu trabalho anterior sobre a teoria das filas.

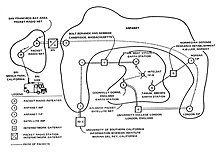

A ARPA concedeu o contrato para construir a rede à Bolt Beranek & Newman, e o primeiro link ARPANET foi estabelecido entre o Network Measurement Center da Universidade da Califórnia, Los Angeles (UCLA) Henry Samueli School of Engineering and Applied Science dirigido por Leonard Kleinrock, e o sistema NLS no Stanford Research Institute (SRI) dirigido por Douglas Engelbart em Menlo Park, Califórnia, às 22h30 de 29 de outubro de 1969.

"Nós estabelecemos uma conexão telefônica entre nós e os caras na SRI...", Kleinrock... disse em uma entrevista: "Nós digitamos o L e pedimos no telefone,

- "Viste o L?"

- "Sim, nós vemos o L", veio a resposta.

- Escrevemos o O, e perguntamos: "Você vê o O."

- "Sim, vemos o O."

- Então digitamos o G, e o sistema caiu...

No entanto, uma revolução tinha começado"....

Em dezembro de 1969, uma rede de quatro nós foi conectada adicionando o Culler-Fried Interactive Mathematics Center na Universidade da Califórnia, Santa Bárbara, seguido pelo Departamento de Gráficos da Universidade de Utah. No mesmo ano, Taylor ajudou a financiar o ALOHAnet, um sistema projetado pelo professor Norman Abramson e outros da Universidade do Havaí em Mānoa que transmitia dados por rádio entre sete computadores em quatro ilhas do Havaí.

Steve Crocker formou um "Grupo de Trabalho de Rede" em 1969 na UCLA. O desenvolvimento da ARPANET foi centrado no processo Request for Comments (RFC), ainda hoje usado para propor e distribuir protocolos e sistemas de Internet. RFC 1, intitulado "Host Software", foi escrito por Steve Crocker e publicado em 7 de abril de 1969. O protocolo para estabelecer links entre sites de rede na ARPANET, o Network Control Protocol (NCP), foi concluído em 1970. Esses primeiros anos foram documentados no filme de 1972, Computer Networks: The Heralds of Resource Sharing.

As primeiras colaborações internacionais na ARPANET eram escassas. As conexões foram feitas em 1973 com o Norwegian Seismic Array (NORSAR), por meio de um link de satélite na Tanum Earth Station, na Suécia, e com o grupo de pesquisa de Peter Kirstein na University College London, que forneceu uma porta de entrada para redes acadêmicas britânicas, formando a primeira rede internacional de compartilhamento de recursos heterogêneos. Em 1981, o número de hosts havia crescido para 213. A ARPANET tornou-se o núcleo técnico do que se tornaria a Internet e uma ferramenta primária no desenvolvimento das tecnologias utilizadas.

Rede de Mérito

A Merit Network foi formada em 1966 como a Tríade de Informações de Pesquisa Educacional de Michigan para explorar redes de computadores entre três das universidades públicas de Michigan como um meio de ajudar o desenvolvimento educacional e econômico do estado. Com suporte inicial do estado de Michigan e da National Science Foundation (NSF), a rede de comutação de pacotes foi demonstrada pela primeira vez em dezembro de 1971, quando uma conexão interativa de host para host foi feita entre os sistemas de computadores mainframe IBM na Universidade de Michigan em Ann Arbor e Wayne State University em Detroit. Em outubro de 1972, as conexões com o mainframe do CDC na Michigan State University em East Lansing completaram a tríade. Nos anos seguintes, além das conexões interativas de host para host, a rede foi aprimorada para oferecer suporte a conexões de terminal para host, conexões de host para host em lote (envio de trabalho remoto, impressão remota, transferência de arquivo em lote), transferência interativa de arquivos, gateways para o Tymnet e redes públicas de dados Telenet, anexos de host X.25, gateways para redes de dados X.25, hosts conectados a Ethernet e, eventualmente, TCP/IP e universidades públicas adicionais em Michigan se juntam à rede. Tudo isso preparou o terreno para o papel de Merit no projeto NSFNET a partir de meados da década de 1980.

CICLADES

A rede de comutação de pacotes CYCLADES foi uma rede de pesquisa francesa projetada e dirigida por Louis Pouzin. Ele desenvolveu a rede para explorar alternativas ao design inicial da ARPANET e para apoiar a pesquisa de internetworking. Demonstrada pela primeira vez em 1973, foi a primeira rede a implementar o princípio ponta a ponta concebido por Donald Davies e tornar os hosts responsáveis pela entrega confiável de dados, em vez da própria rede, usando datagramas não confiáveis. Os conceitos implementados nesta rede influenciaram a arquitetura TCP/IP.

X.25 e redes de dados públicas

Com base em iniciativas de pesquisa internacional, particularmente nas contribuições de Rémi Després, os padrões de rede de comutação de pacotes foram desenvolvidos pelo Comitê Consultivo Internacional de Telégrafos e Telefones (ITU-T) na forma de X.25 e padrões relacionados. X.25 é construído sobre o conceito de circuitos virtuais emulando conexões telefônicas tradicionais. Em 1974, o X.25 formou a base para a rede SERCnet entre sites acadêmicos e de pesquisa britânicos, que mais tarde se tornou JANET, a rede nacional de pesquisa e educação de alta velocidade (NREN) do Reino Unido. O padrão inicial da ITU no X.25 foi aprovado em março de 1976. As redes existentes, como a Telenet nos Estados Unidos, adotaram o X.25, bem como novas redes públicas de dados, como DATAPAC no Canadá e TRANSPAC na França. O X.25 foi complementado pelo protocolo X.75 que permitia o interconexão de redes.

Os correios britânicos, a Western Union International e a Tymnet colaboraram para criar a primeira rede internacional de comutação de pacotes, conhecida como International Packet Switched Service (IPSS), em 1978. Essa rede cresceu da Europa e dos EUA para cobrir o Canadá, Hong Kong e Austrália em 1981. Na década de 1990, forneceu uma infraestrutura de rede mundial.

Ao contrário da ARPANET, o X.25 era comumente disponível para uso comercial. A Telenet oferecia seu serviço de correio eletrônico Telemail, que também era voltado para uso empresarial, em vez do sistema geral de e-mail da ARPANET.

As primeiras redes discadas públicas utilizavam protocolos terminais TTY assíncronos para chegar a um concentrador operado na rede pública. Algumas redes, como Telenet e CompuServe, usaram X.25 para multiplexar as sessões de terminal em seus backbones de comutação de pacotes, enquanto outras, como Tymnet, usaram protocolos proprietários. Em 1979, a CompuServe tornou-se o primeiro serviço a oferecer recursos de correio eletrônico e suporte técnico para usuários de computadores pessoais. A empresa inovou novamente em 1980 como a primeira a oferecer bate-papo em tempo real com seu CB Simulator. Outras grandes redes de discagem foram America Online (AOL) e Prodigy, que também forneciam recursos de comunicação, conteúdo e entretenimento. Muitas redes de sistema de quadro de avisos (BBS) também forneciam acesso on-line, como o FidoNet, que era popular entre usuários de computador amadores, muitos deles hackers e operadores de rádio amadores.

UUCP e Usenet

Em 1979, dois estudantes da Duke University, Tom Truscott e Jim Ellis, originaram a ideia de usar scripts de shell Bourne para transferir notícias e mensagens em uma conexão UUCP de linha serial com a vizinha University of North Carolina em Chapel Hill. Após o lançamento público do software em 1980, a malha de encaminhamento de hosts UUCP nas notícias da Usenet se expandiu rapidamente. UUCPnet, como mais tarde seria nomeado, também criou gateways e links entre FidoNet e hosts BBS dial-up. As redes UUCP se espalharam rapidamente devido aos custos mais baixos envolvidos, capacidade de usar linhas alugadas existentes, links X.25 ou mesmo conexões ARPANET e a falta de políticas de uso rígidas em comparação com redes posteriores como CSNET e Bitnet. Todas as conexões eram locais. Em 1981, o número de hosts UUCP havia crescido para 550, quase dobrando para 940 em 1984.

A Sublink Network, operando desde 1987 e fundada oficialmente na Itália em 1989, baseou sua interconectividade no UUCP para redistribuir mensagens de e-mail e grupos de notícias em todos os seus nós italianos (cerca de 100 na época) de propriedade tanto de particulares quanto de pequenas empresas. A Sublink Network representou possivelmente um dos primeiros exemplos da tecnologia da Internet se tornando um progresso através da difusão popular.

1973–1989: Fusão das redes e criação da Internet

TCP/IP

Com tantos métodos de rede diferentes, algo era necessário para unificá-los. Louis Pouzin iniciou o projeto CYCLADES em 1971, com base no trabalho de Donald Davies. Em seu trabalho, Pouzin cunhou o termo catenet para rede concatenada. Um Grupo de Trabalho de Networking Internacional formado em 1972; membros ativos incluíam Vint Cerf da Universidade de Stanford, Alex McKenzie da BBN, Donald Davies e Roger Scantlebury da NPL e Louis Pouzin e Hubert Zimmermann da IRIA. Mais tarde naquele ano, Bob Kahn da DARPA recrutou Vint Cerf para trabalhar com ele no problema. Bob Metcalfe, da Xerox PARC, delineou a ideia da Ethernet. Em 1973, esses grupos haviam elaborado uma reformulação fundamental, onde as diferenças entre os protocolos de rede eram ocultadas pelo uso de um protocolo comum entre redes e, em vez da rede ser responsável pela confiabilidade, como na ARPANET, os hosts se tornavam responsáveis.

Kahn e Cerf publicaram suas ideias em maio de 1974, incorporando conceitos implementados por Louis Pouzin e Hubert Zimmermann na rede CYCLADES. A especificação do protocolo resultante, o Transmission Control Program, foi publicada como RFC 675 pelo Network Working Group em dezembro de 1974. Ele contém o primeiro uso atestado do termo internet, como uma abreviação de internetwork. Este software foi monolítico em design usando dois canais de comunicação simplex para cada sessão do usuário.

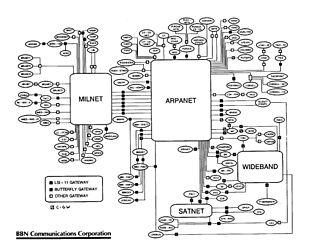

Com o papel da rede reduzido a um núcleo de funcionalidade, tornou-se possível trocar tráfego com outras redes independentemente de suas características detalhadas, resolvendo assim os problemas fundamentais de internetworking. A DARPA concordou em financiar o desenvolvimento do protótipo de software. Os testes começaram em 1975 por meio de implementações simultâneas em Stanford, BBN e University College London (UCL). Após vários anos de trabalho, a primeira demonstração de um gateway entre a rede Packet Radio (PRNET) na área de SF Bay e a ARPANET foi conduzida pelo Stanford Research Institute. Em 22 de novembro de 1977, uma demonstração de três redes foi realizada, incluindo a ARPANET, o SRI's Packet Radio Van na Packet Radio Network e a Atlantic Packet Satellite Network (SATNET), incluindo um nó na UCL.

O software foi redesenhado como uma pilha de protocolo modular, usando canais full-duplex; entre 1976 e 1977, Yogen Dalal e Robert Metcalfe, entre outros, propuseram separar as funções de roteamento e controle de transmissão do TCP em duas camadas distintas, o que levou à divisão do Programa de Controle de Transmissão em Protocolo de Controle de Transmissão (TCP) e o Internet Protocol (IP) na versão 3 em 1978. Originalmente referido como IP/TCP, a versão 4 foi descrita na publicação IETF RFC 791 (setembro de 1981), 792 e 793. Foi instalado no SATNET em 1982 e a ARPANET em janeiro de 1983, depois que o DoD a tornou padrão para todas as redes de computadores militares. Isso resultou em um modelo de rede que ficou conhecido informalmente como TCP/IP. Também foi referido como modelo do Departamento de Defesa (DoD), modelo DARPA ou modelo ARPANET. Cerf credita seus alunos de pós-graduação Yogen Dalal, Carl Sunshine, Judy Estrin, Richard Karp e Gérard Le Lann pelo importante trabalho de design e teste. A DARPA patrocinou ou incentivou o desenvolvimento de implementações de TCP/IP para muitos sistemas operacionais.

De ARPANET para NSFNET

Depois que a ARPANET estava funcionando há vários anos, a ARPA procurou outra agência para transferir a rede; A principal missão da ARPA era financiar pesquisa e desenvolvimento de ponta, não administrar um serviço de comunicações. Eventualmente, em julho de 1975, a rede foi entregue à Agência de Comunicações de Defesa, também parte do Departamento de Defesa. Em 1983, a porção militar dos EUA da ARPANET foi quebrada como uma rede separada, a MILNET. MILNET posteriormente se tornou o NIPRNET não classificado, mas apenas militar, em paralelo com o SIPRNET de nível SECRET e JWICS para TOP SECRET e acima. O NIPRNET possui gateways de segurança controlados para a Internet pública.

As redes baseadas na ARPANET eram financiadas pelo governo e, portanto, restritas a usos não comerciais, como pesquisa; o uso comercial não relacionado era estritamente proibido. Isso inicialmente restringiu as conexões com instalações militares e universidades. Durante a década de 1980, as conexões se expandiram para mais instituições de ensino, que passaram a formar redes de linhas de fibra ótica. Um número crescente de empresas, como a Digital Equipment Corporation e a Hewlett-Packard, que participavam de projetos de pesquisa ou prestavam serviços a quem participava. As velocidades de transmissão de dados dependiam do tipo de conexão, sendo as mais lentas as linhas telefônicas analógicas e as mais rápidas usando a tecnologia de rede óptica.

Vários outros ramos do governo dos EUA, a Administração Nacional de Aeronáutica e Espaço (NASA), a National Science Foundation (NSF) e o Departamento de Energia (DOE) se envolveram fortemente na pesquisa da Internet e iniciaram o desenvolvimento de um sucessor para ARPANET. Em meados da década de 1980, todas essas três ramificações desenvolveram as primeiras redes de longa distância baseadas em TCP/IP. A NASA desenvolveu a NASA Science Network, a NSF desenvolveu a CSNET e a DOE desenvolveu a Energy Sciences Network ou ESNet.

A NASA desenvolveu a NASA Science Network (NSN) baseada em TCP/IP em meados da década de 1980, conectando cientistas espaciais a dados e informações armazenados em qualquer lugar do mundo. Em 1989, o Space Physics Analysis Network (SPAN) baseado em DECnet e o NASA Science Network (NSN) baseado em TCP/IP foram reunidos no NASA Ames Research Center, criando a primeira rede multiprotocolo de área ampla chamada NASA Science Internet, ou NSI. A NSI foi criada para fornecer uma infraestrutura de comunicações totalmente integrada à comunidade científica da NASA para o avanço das ciências terrestres, espaciais e biológicas. Como uma rede internacional multiprotocolo de alta velocidade, a NSI forneceu conectividade para mais de 20.000 cientistas em todos os sete continentes.

Em 1981, a NSF apoiou o desenvolvimento da Computer Science Network (CSNET). O CSNET conectava-se com a ARPANET usando TCP/IP e executava TCP/IP sobre X.25, mas também suportava departamentos sem conexões de rede sofisticadas, usando troca de correspondência dial-up automatizada. A CSNET desempenhou um papel central na popularização da Internet fora da ARPANET.

Em 1986, a NSF criou a NSFNET, um backbone de 56 kbit/s para dar suporte aos centros de supercomputação patrocinados pela NSF. A NSFNET também forneceu suporte para a criação de redes regionais de pesquisa e educação nos Estados Unidos e para a conexão de redes de campus universitários e universitários às redes regionais. O uso da NSFNET e das redes regionais não se limitou a usuários de supercomputadores e a rede de 56 kbit/s rapidamente ficou sobrecarregada. O NSFNET foi atualizado para 1,5 Mbit/s em 1988 sob um acordo cooperativo com a Merit Network em parceria com a IBM, MCI e o estado de Michigan. A existência da NSFNET e a criação de Federal Internet Exchanges (FIXes) permitiram que a ARPANET fosse desativada em 1990.

NSFNET foi expandido e atualizado para fibra dedicada, lasers ópticos e sistemas amplificadores ópticos capazes de fornecer velocidades de inicialização T3 ou 45 Mbit/s em 1991. No entanto, a transição T3 pela MCI demorou mais do que o esperado, permitindo que a Sprint estabelecesse uma serviço de Internet comercial de longa distância costa a costa. Quando a NSFNET foi desativada em 1995, seus backbones de rede óptica foram entregues a vários provedores comerciais de serviços de Internet, incluindo MCI, PSI Net e Sprint. Como resultado, quando a transferência foi concluída, a Sprint e seus pontos de acesso de rede em Washington DC começaram a transportar o tráfego da Internet e, em 1996, a Sprint era a maior operadora mundial de tráfego da Internet.

A comunidade acadêmica e de pesquisa continua a desenvolver e usar redes avançadas como a Internet2 nos Estados Unidos e a JANET no Reino Unido.

Transição para a Internet

O termo "internet" foi refletido no primeiro RFC publicado no protocolo TCP (RFC 675: Internet Transmission Control Program, dezembro de 1974) como uma forma abreviada de internetworking, quando os dois termos eram usados de forma intercambiável. Em geral, uma internet era uma coleção de redes ligadas por um protocolo comum. No período em que a ARPANET foi conectada ao recém-formado projeto NSFNET no final dos anos 1980, o termo era usado como o nome da rede, Internet, sendo a grande e global rede TCP/IP.

Abrir a Internet e o backbone de fibra ótica para empresas e consumidores aumentou a demanda por capacidade de rede. A despesa e o atraso na instalação de novas fibras levaram os provedores a testar uma alternativa de expansão de largura de banda de fibra que foi pioneira no final dos anos 1970 pela Optelecom usando “interações entre luz e matéria, como lasers e dispositivos ópticos usados para amplificação óptica e mistura de ondas”. Essa tecnologia ficou conhecida como multiplexação por divisão de onda (WDM). A Bell Labs implantou um sistema WDM de 4 canais em 1995. Para desenvolver um sistema WDM de capacidade de massa (denso), a Optelecom e seu ex-chefe de pesquisa de sistemas leves, David R. Huber, formaram um novo empreendimento, Ciena Corp., que implantou o mundo& O primeiro sistema WDM denso da #39;na rede de fibra Sprint em junho de 1996. Isso foi referido como o início real da rede óptica.

À medida que o interesse em redes cresceu devido às necessidades de colaboração, troca de dados e acesso a recursos de computação remota, as tecnologias da Internet se espalharam pelo resto do mundo. A abordagem independente de hardware no TCP/IP suportava o uso da infra-estrutura de rede existente, como a rede X.25 do International Packet Switched Service (IPSS), para transportar o tráfego da Internet.

Muitos sites incapazes de se conectar diretamente à Internet criaram gateways simples para a transferência de correio eletrônico, a aplicação mais importante da época. Sites com apenas conexões intermitentes usavam UUCP ou FidoNet e contavam com os gateways entre essas redes e a Internet. Alguns serviços de gateway foram além do simples emparelhamento de correio, como permitir o acesso a sites FTP (File Transfer Protocol) via UUCP ou correio.

Finalmente, tecnologias de roteamento foram desenvolvidas para a Internet para remover os aspectos de roteamento centralizado remanescentes. O Exterior Gateway Protocol (EGP) foi substituído por um novo protocolo, o Border Gateway Protocol (BGP). Isso forneceu uma topologia em malha para a Internet e reduziu a arquitetura centralizada que a ARPANET havia enfatizado. Em 1994, o Classless Inter-Domain Routing (CIDR) foi introduzido para oferecer suporte a uma melhor conservação do espaço de endereço, o que permitia o uso de agregação de rota para diminuir o tamanho das tabelas de roteamento.

Rede óptica

Para atender à necessidade de capacidade de transmissão além da fornecida por rádio, satélite e linhas telefônicas analógicas de cobre, os engenheiros desenvolveram sistemas de comunicação óptica baseados em cabos de fibra óptica alimentados por lasers e técnicas de amplificadores ópticos.

O conceito de laser surgiu de um artigo de 1917 de Albert Einstein, “On the Quantum Theory of Radiation”. Einstein expandiu um diálogo com Max Planck sobre como os átomos absorvem e emitem luz, parte de um processo de pensamento que, com contribuições de Erwin Schrödinger, Werner Heisenberg e outros, deu origem à Mecânica Quântica. Especificamente, em sua teoria quântica, Einstein determinou matematicamente que a luz poderia ser gerada não apenas por emissão espontânea, como a luz emitida por uma luz incandescente ou pelo Sol, mas também por emissão estimulada.

Quarenta anos depois, em 13 de novembro de 1957, o estudante de física da Universidade de Columbia, Gordon Gould, percebeu pela primeira vez como produzir luz por emissão estimulada por meio de um processo de amplificação óptica. Ele cunhou o termo LASER para esta tecnologia – Amplificação de Luz por Emissão Estimulada de Radiação. Usando o método de amplificação de luz de Gould (patenteado como “Amplificador de laser bombeado opticamente”) [1], Theodore Maiman fez o primeiro laser funcional em 16 de maio de 1960.

Gould co-fundou a Optelecom, Inc. em 1973 para comercializar suas invenções em telecomunicações de fibra óptica. assim como a Corning Glass estava produzindo o primeiro cabo de fibra óptica comercial em pequenas quantidades. A Optelecom configurou seus próprios lasers de fibra e amplificadores ópticos nos primeiros sistemas comerciais de comunicação óptica que entregou à Chevron e à Defesa de Mísseis do Exército dos EUA. Três anos depois, a GTE implantou o primeiro sistema de telefonia óptica em 1977 em Long Beach, Califórnia. No início da década de 1980, as redes ópticas alimentadas por lasers, LED e equipamentos amplificadores ópticos fornecidos pela Bell Labs, NTT e Perelli eram usadas por universidades selecionadas e operadoras de telefonia de longa distância.

TCP/IP torna-se global (década de 1980)

CERN e a Internet Europeia

No início de 1982, o NORSAR e o grupo de Peter Kirstein na University College London (UCL) deixaram a ARPANET e começaram a usar TCP/IP sobre SATNET. A UCL continuou a fornecer acesso entre a ARPANET e as redes acadêmicas no Reino Unido, função que desempenhava desde 1973.

Entre 1984 e 1988, o CERN iniciou a instalação e operação do TCP/IP para interconectar seus principais sistemas internos de computadores, estações de trabalho, PCs e um sistema de controle de acelerador. O CERN continuou a operar um sistema autodesenvolvido limitado (CERNET) internamente e vários protocolos de rede incompatíveis (tipicamente proprietários) externamente. Houve uma resistência considerável na Europa em relação ao uso mais difundido do TCP/IP, e as intranets TCP/IP do CERN permaneceram isoladas da Internet até 1989, quando uma conexão transatlântica com a Universidade de Cornell foi estabelecida.

A Computer Science Network (CSNET) começou a operar em 1981 para fornecer conexões de rede para instituições que não podiam se conectar diretamente à ARPANET. Sua primeira conexão internacional foi com Israel em 1984. Logo depois, foram estabelecidas conexões com departamentos de informática no Canadá, França e Alemanha.

Em 1988, as primeiras conexões internacionais com a NSFNET foram estabelecidas pelo INRIA da França e Piet Beertema no Centrum Wiskunde & Informatica (CWI) na Holanda. Daniel Karrenberg, do CWI, visitou Ben Segal, coordenador de TCP/IP do CERN, em busca de conselhos sobre a transição da EUnet, o lado europeu da rede UUCP Usenet (muito da qual funcionava em links X.25), ao longo para TCP/IP. No ano anterior, Segal havia se encontrado com Len Bosack, da então ainda pequena empresa Cisco, sobre a compra de alguns roteadores TCP/IP para o CERN, e Segal pôde aconselhar Karrenberg e encaminhá-lo à Cisco para obter o hardware apropriado. Isso expandiu a porção européia da Internet através das redes UUCP existentes. A conexão NORDUnet com NSFNET foi estabelecida logo depois, fornecendo acesso aberto para estudantes universitários na Dinamarca, Finlândia, Islândia, Noruega e Suécia. Em janeiro de 1989, o CERN abriu suas primeiras conexões TCP/IP externas. Isso coincidiu com a criação da Réseaux IP Européens (RIPE), inicialmente um grupo de administradores de redes IP que se reuniam regularmente para realizar trabalhos de coordenação em conjunto. Mais tarde, em 1992, a RIPE foi formalmente registrada como cooperativa em Amsterdã.

A rede nacional de pesquisa e educação do Reino Unido (NREN), JANET, começou a operar em 1984 usando os protocolos Colored Book do Reino Unido e se conectou à NSFNET em 1989. Em 1991, JANET adotou o protocolo da Internet em a rede existente. No mesmo ano, Dai Davies introduziu a tecnologia da Internet na NREN pan-europeia, EuropaNet, que foi construída sobre o protocolo X.25. A European Academic and Research Network (EARN) e a RARE adotaram o IP na mesma época, e o backbone europeu da Internet EBONE tornou-se operacional em 1992.

No entanto, por um período no final dos anos 1980 e início dos anos 1990, engenheiros, organizações e nações estavam polarizados sobre a questão de qual padrão, o modelo OSI ou o conjunto de protocolos da Internet resultaria nas melhores e mais robustas redes de computadores.

O link para o Pacífico

A Coreia do Sul montou uma rede TCP/IP doméstica de dois nós em 1982, a System Development Network (SDN), acrescentando um terceiro nó no ano seguinte. SDN foi conectado ao resto do mundo em agosto de 1983 usando UUCP (Unix-to-Unix-Copy); conectado à CSNET em dezembro de 1984; e formalmente conectado ao NSFNET em 1990.

O Japão, que havia construído a rede JUNET baseada em UUCP em 1984, conectou-se à CSNET e, posteriormente, à NSFNET em 1989, marcando a expansão da Internet para a Ásia.

Na Austrália, redes ad hoc para ARPA e universidades australianas intermediárias foram formadas no final dos anos 1980, com base em várias tecnologias, como X.25, UUCPNet e via CSNET. Estes eram limitados em sua conexão com as redes globais, devido ao custo de fazer conexões dial-up UUCP internacionais individuais ou conexões X.25. Em 1989, as universidades australianas juntaram-se ao esforço de usar protocolos IP para unificar suas infra-estruturas de rede. A AARNet foi formada em 1989 pelos vice-chanceleres australianos. Comitê e forneceu uma rede dedicada baseada em IP para a Austrália.

A Nova Zelândia adotou os protocolos do livro colorido do Reino Unido como um padrão provisório e estabeleceu sua primeira conexão IP internacional com os EUA em 1989.

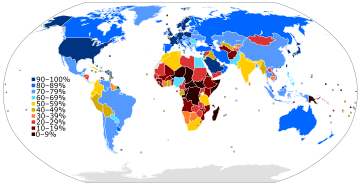

Uma "exclusão digital" surge

Enquanto os países desenvolvidos com infra-estruturas tecnológicas estavam aderindo à Internet, os países em desenvolvimento começaram a experimentar uma divisão digital que os separava da Internet. Em bases essencialmente continentais, construíram organizações para a administração dos recursos da Internet e para o compartilhamento de experiências operacionais, o que permitiu a implantação de mais facilidades de transmissão.

África

No início da década de 1990, os países africanos contavam com links X.25 IPSS e modem UUCP de 2400 baud para comunicações internacionais e inter-redes de computadores.

Em agosto de 1995, a InfoMail Uganda, Ltd., uma empresa privada em Kampala agora conhecida como InfoCom, e a NSN Network Services de Avon, Colorado, vendida em 1997 e agora conhecida como Clear Channel Satellite, estabeleceram a Africa's primeiros serviços nativos de Internet via satélite TCP/IP de alta velocidade. A conexão de dados foi originalmente transportada por um satélite russo RSCC de banda C que conectava os escritórios da InfoMail em Kampala diretamente ao ponto de presença MAE-Oeste da NSN usando uma rede privada da estação terrestre arrendada da NSN em Nova Jersey. A primeira conexão via satélite da InfoCom foi de apenas 64 kbit/s, servindo um computador host da Sun e doze modems dial-up da US Robotics.

Em 1996, um projeto financiado pela USAID, a Iniciativa Leland, começou a trabalhar no desenvolvimento de conectividade total à Internet para o continente. Guiné, Moçambique, Madagascar e Ruanda ganharam estações terrestres de satélite em 1997, seguidas pela Costa do Marfim e Benin em 1998.

A África está construindo uma infraestrutura de Internet. A AFRINIC, com sede nas Maurícias, gere a atribuição de endereços IP para o continente. Assim como as outras regiões da Internet, existe um fórum operacional, a Internet Community of Operational Networking Specialists.

Existem muitos programas para fornecer usinas de transmissão de alto desempenho, e as costas oeste e sul possuem cabos ópticos submarinos. Cabos de alta velocidade unem o Norte da África e o Corno de África aos sistemas de cabos intercontinentais. O desenvolvimento de cabos submarinos é mais lento na África Oriental; o esforço conjunto original entre a Nova Parceria para o Desenvolvimento da África (NEPAD) e o Sistema Submarino da África Oriental (Eassy) foi interrompido e pode se tornar dois esforços.

Ásia e Oceania

O Asia Pacific Network Information Center (APNIC), com sede na Austrália, gerencia a alocação de endereços IP para o continente. O APNIC patrocina um fórum operacional, a Conferência Regional de Internet da Ásia-Pacífico sobre Tecnologias Operacionais (APRICOT).

Na Coréia do Sul, VDSL, uma tecnologia de última milha desenvolvida na década de 1990 pela NextLevel Communications, conectava linhas telefônicas corporativas e de consumo baseadas em cobre à Internet.

A República Popular da China estabeleceu sua primeira rede universitária TCP/IP, a TUNET da Universidade de Tsinghua, em 1991. A RPC fez sua primeira conexão global com a Internet em 1994, entre a Beijing Electro- Spectrometer Collaboration e o Linear Accelerator Center da Universidade de Stanford. No entanto, a China implementou sua própria divisão digital implementando um filtro de conteúdo em todo o país.

O Japão sediou a reunião anual da Internet Society, INET'92, em Kobe. Cingapura desenvolveu a TECHNET em 1990 e a Tailândia ganhou uma conexão global de Internet entre a Universidade Chulalongkorn e a UUNET em 1992.

América Latina

Como em outras regiões, o Registro de Endereços da Internet da América Latina e Caribe (LACNIC) gerencia o espaço de endereços IP e outros recursos de sua área. LACNIC, com sede no Uruguai, opera raiz de DNS, DNS reverso e outros serviços chave.

1990–2003: Ascensão da Internet global, Web 1.0

Inicialmente, como nas redes anteriores, o sistema que evoluiria para a Internet era principalmente para uso do governo e de órgãos governamentais. Embora o uso comercial fosse proibido, a definição exata de uso comercial era obscura e subjetiva. UUCPNet e o X.25 IPSS não tinham tais restrições, o que acabaria por ver a proibição oficial do uso UUCPNet de conexões ARPANET e NSFNET. (Alguns links UUCP ainda permaneceram conectados a essas redes, pois os administradores fecharam os olhos para sua operação.)

Como resultado, no final da década de 1980, foram formadas as primeiras empresas provedoras de serviços de Internet (ISP). Empresas como PSINet, UUNET, Netcom e Portal Software foram formadas para fornecer serviços às redes de pesquisa regionais e fornecer acesso alternativo à rede, e-mail baseado em UUCP e notícias da Usenet ao público. O primeiro ISP de discagem comercial nos Estados Unidos foi o The World, inaugurado em 1989.

Em 1992, o Congresso dos EUA aprovou a Lei Científica e de Tecnologia Avançada, 42 U.S.C. § 1862(g), que permitia que a NSF oferecesse suporte ao acesso das comunidades de pesquisa e educação a redes de computadores que não eram usadas exclusivamente para fins de pesquisa e educação, permitindo assim que a NSFNET se interconectasse com redes comerciais. Isso causou controvérsia na comunidade de pesquisa e educação, que estava preocupada que o uso comercial da rede pudesse levar a uma Internet menos responsiva às suas necessidades, e na comunidade de provedores de redes comerciais, que achavam que os subsídios do governo estavam dando uma vantagem injusta. a algumas organizações.

Em 1990, os objetivos da ARPANET foram cumpridos e as novas tecnologias de rede excederam o escopo original e o projeto chegou ao fim. Novos provedores de serviços de rede, incluindo PSINet, Alternet, CERFNet, ANS CO+RE e muitos outros, ofereciam acesso à rede para clientes comerciais. A NSFNET não era mais o backbone de fato e o ponto de troca da Internet. O Commercial Internet eXchange (CIX), Metropolitan Area Exchanges (MAEs) e, posteriormente, Network Access Points (NAPs) estavam se tornando as principais interconexões entre muitas redes. As restrições finais ao transporte de tráfego comercial terminaram em 30 de abril de 1995, quando a National Science Foundation encerrou seu patrocínio do NSFNET Backbone Service. A NSF forneceu suporte inicial para os NAPs e suporte provisório para ajudar as redes regionais de pesquisa e educação na transição para ISPs comerciais. A NSF também patrocinou o Backbone Network Service (vBNS) de alta velocidade, que continuou a fornecer suporte para centros de supercomputação e pesquisa e educação nos Estados Unidos.

Um evento realizado em 11 de janeiro de 1994, The Superhighway Summit no Royce Hall da UCLA, foi a "primeira conferência pública reunindo todos os principais representantes da indústria, governo e acadêmicos líderes no campo [e] também iniciaram o diálogo nacional sobre a Supervia da Informação e suas implicações".

Uso da Internet na sociedade em geral

A invenção da World Wide Web por Tim Berners-Lee no CERN, como uma aplicação na Internet, trouxe muitos usos sociais e comerciais para o que era, na época, uma rede de redes para instituições acadêmicas e de pesquisa. A Web foi aberta ao público em 1991 e começou a ser usada em geral em 1993-4, quando os sites de uso diário começaram a ficar disponíveis.

Durante aproximadamente a primeira década da Internet pública, as imensas mudanças que ela permitiria nos anos 2000 ainda eram incipientes. Em termos de fornecer contexto para este período, os dispositivos móveis celulares ("smartphones" e outros dispositivos celulares) que hoje fornecem acesso quase universal, foram usados para negócios e não como um item doméstico rotineiro de propriedade de pais e filhos em todo o mundo. A mídia social no sentido moderno ainda não existia, os laptops eram volumosos e a maioria das residências não tinha computadores. As taxas de dados eram lentas e a maioria das pessoas não tinha meios de filmar ou digitalizar vídeos; o armazenamento de mídia estava mudando lentamente de fita analógica para discos ópticos digitais (DVD e, até certo ponto, disquete para CD). Tecnologias habilitantes usadas desde o início dos anos 2000, como PHP, JavaScript moderno e Java, tecnologias como AJAX, HTML 4 (e sua ênfase em CSS) e várias estruturas de software, que permitiram e simplificaram a velocidade do desenvolvimento da Web, invenção amplamente aguardada e seus eventual adoção generalizada.

A Internet era amplamente usada para listas de mala direta, e-mails, comércio eletrônico e as primeiras compras on-line populares (Amazon e eBay, por exemplo), fóruns e quadros de avisos on-line e sites e blogs pessoais, e o uso estava crescendo rapidamente, mas padrões mais modernos, os sistemas usados eram estáticos e careciam de engajamento social generalizado. Aguardou uma série de eventos no início dos anos 2000 para deixar de ser uma tecnologia de comunicação e se transformar gradualmente em uma parte fundamental da infraestrutura da sociedade global.

Elementos típicos de design dessas "Web 1.0" os sites da era incluíam: páginas estáticas em vez de HTML dinâmico; conteúdo servido de sistemas de arquivos em vez de bancos de dados relacionais; páginas construídas usando Server Side Includes ou CGI em vez de um aplicativo da web escrito em uma linguagem de programação dinâmica; Estruturas da era HTML 3.2, como quadros e tabelas para criar layouts de página; livros de visitas online; uso excessivo de botões GIF e pequenos gráficos semelhantes promovendo itens específicos; e formulários HTML enviados por e-mail. (O suporte para scripts do lado do servidor era raro em servidores compartilhados, portanto, o mecanismo de feedback usual era por e-mail, usando formulários mailto e seu programa de e-mail.

Durante o período de 1997 a 2001, ocorreu a primeira bolha de investimento especulativo relacionada à Internet, na qual a "ponto-com" as empresas (referindo-se ao domínio de nível superior ".com" usado pelas empresas) foram impulsionadas a avaliações extremamente altas, à medida que os investidores aumentavam rapidamente os valores das ações, seguidos por uma quebra do mercado; a primeira bolha pontocom. No entanto, isso diminuiu apenas temporariamente o entusiasmo e o crescimento, que rapidamente se recuperaram e continuaram a crescer.

A história da World Wide Web até cerca de 2004 foi retrospectivamente nomeada e descrita por alguns como "Web 1.0".

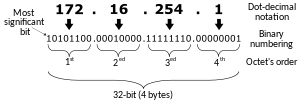

IPv6

O último endereço IPv4 disponível foi atribuído em janeiro de 2011. O IPv4 usa endereços de 32 bits, o que limita o espaço de endereço a 232 endereços, ou seja, 4294967 296 endereços. O IPv4 está sendo substituído por seu sucessor, chamado "IPv6", que usa endereços de 128 bits, fornecendo 2128 endereços, ou seja, 340 282366920 938463463374607431768211456, um espaço de endereço muito maior. Espera-se que a mudança para o IPv6 leve muitos anos, décadas, ou talvez mais, para ser concluída, já que havia quatro bilhões de máquinas com IPv4 quando a mudança começou.

2004–presente: Web 2.0, onipresença global, mídia social

Os rápidos avanços técnicos que colocariam a Internet em seu lugar como um sistema social que transformou completamente a maneira como os humanos interagem uns com os outros ocorreram durante um período relativamente curto de não mais de cinco anos, de cerca de 2005 a 2010, coincidindo com o momento em que os dispositivos IoT ultrapassaram o número de seres humanos vivos em algum momento no final dos anos 2000. Eles incluíram:

- A chamada para "Web 2.0" em 2004 (primeiro sugerido em 1999),

- Acelerando a adoção e a commoditização entre as famílias e a familiaridade com o hardware necessário (como os computadores).

- Acelerando a tecnologia de armazenamento e as velocidades de acesso de dados – discos rígidos surgiram, assumiu de discos disquete muito menores e mais lentos, e cresceu de megabytes a gigabytes (e por volta de 2010, terabytes), RAM de centenas de kilobytes a gigabytes como quantidades típicas em um sistema, e Ethernet, a tecnologia de habilitação para TCP/IP, movido de velocidades comuns de kilobits a dezenas de megabits por segundo,

- Internet de alta velocidade e maior cobertura de conexões de dados, a preços mais baixos, permitindo maiores taxas de tráfego, tráfego mais confiável e tráfego de mais locais,

- A percepção acelerada do potencial de computadores para criar novos meios e abordagens para a comunicação, o surgimento de redes sociais e sites como Twitter e Facebook para sua proeminência posterior, e colaborações globais como a Wikipédia (que existia antes, mas ganhou destaque como resultado),

- A revolução do dispositivo móvel, particularmente com smartphones e computadores tablet se tornando generalizada, que começou a fornecer fácil acesso à Internet para grande parte da sociedade humana de todas as idades, em suas vidas diárias, e permitiu-lhes compartilhar, discutir e atualizar continuamente, perguntar e responder.

- RAM não volátil rapidamente cresceu em tamanho e confiabilidade, e diminuiu no preço, tornando-se uma mercadoria capaz de permitir altos níveis de atividade de computação nestes pequenos dispositivos portáteis, bem como unidades de estado sólido (SSD).

- Uma ênfase no processador e no design de dispositivos eficientes de energia, em vez de poder de processamento puramente elevado; um dos beneficiários deste foi o ARM, uma empresa britânica que tinha se concentrado desde a década de 1980 em microprocessadores simples poderosos, mas de baixo custo. A família de arquitetura ARM rapidamente ganhou domínio no mercado para dispositivos móveis e embarcados.

O termo "Web 2.0" descreve sites que enfatizam o conteúdo gerado pelo usuário (incluindo interação de usuário para usuário), usabilidade e interoperabilidade. Ele apareceu pela primeira vez em um artigo de janeiro de 1999 chamado "Fragmented Future" escrito por Darcy DiNucci, consultora em design de informação eletrônica, onde ela escreveu:

- "A Web que conhecemos agora, que carrega em uma janela do navegador em telas essencialmente estáticas, é apenas um embrião da Web para vir. Os primeiros brilhos da Web 2.0 estão começando a aparecer, e estamos apenas começando a ver como esse embrião pode se desenvolver. A Web será entendida não como screenfuls de texto e gráficos, mas como um mecanismo de transporte, o éter através do qual a interatividade acontece. Ele vai [...] aparecer em sua tela do computador, [...] em seu conjunto de TV [...] seu painel de carro [...] seu telefone celular [...] máquinas de jogo portáteis [...] talvez até mesmo seu forno de microondas."

O termo ressurgiu durante 2002–2004 e ganhou destaque no final de 2004 após as apresentações de Tim O'Reilly e Dale Dougherty na primeira Web 2.0 Conference. Em seus comentários iniciais, John Battelle e Tim O'Reilly delinearam sua definição de "Web como plataforma", onde os aplicativos de software são construídos na Web e não no desktop. O aspecto único dessa migração, eles argumentaram, é que "os clientes estão construindo seu negócio para você". Eles argumentaram que as atividades dos usuários que geram conteúdo (na forma de ideias, texto, vídeos ou imagens) podem ser "aproveitadas" para criar valor.

Web 2.0 não se refere a uma atualização de nenhuma especificação técnica, mas sim a mudanças cumulativas na forma como as páginas da Web são feitas e usadas. A Web 2.0 descreve uma abordagem na qual os sites se concentram substancialmente em permitir que os usuários interajam e colaborem uns com os outros em um diálogo de mídia social como criadores de conteúdo gerado pelo usuário em uma comunidade virtual, em contraste com os sites onde as pessoas estão limitadas ao passivo. visualização de conteúdo. Exemplos de Web 2.0 incluem serviços de redes sociais, blogs, wikis, folksonomias, sites de compartilhamento de vídeo, serviços hospedados, aplicativos da Web e mashups. Terry Flew, em sua 3ª edição de New Media, descreveu o que ele acreditava caracterizar as diferenças entre Web 1.0 e Web 2.0:

- "[O] mover de sites pessoais para blogs e agregação do site do blog, da publicação à participação, do conteúdo web como o resultado de um grande investimento inicial para um processo contínuo e interativo, e de sistemas de gerenciamento de conteúdo para links baseados em tagging (folksonomy)".

Esta era viu vários nomes familiares ganharem destaque por meio de sua operação voltada para a comunidade – YouTube, Twitter, Facebook, Reddit e Wikipedia são alguns exemplos.

A revolução móvel

O processo de mudança que geralmente coincidiu com a "Web 2.0" foi bastante acelerado e transformado pouco tempo depois pelo crescimento crescente dos dispositivos móveis. Essa revolução móvel significou que os computadores na forma de smartphones se tornaram algo que muitas pessoas usavam, levavam consigo para todos os lugares, se comunicavam, eram usados para fotos e vídeos que compartilhavam instantaneamente ou para fazer compras ou buscar informações "em movimento" – e usados socialmente, ao contrário de itens em uma mesa em casa ou usados apenas para o trabalho.

Serviços baseados em localização, serviços que usam localização e outras informações de sensores e crowdsourcing (frequentemente, mas nem sempre baseados em localização) tornaram-se comuns, com postagens marcadas por localização ou sites e serviços que reconhecem a localização. Sites direcionados para dispositivos móveis (como "m.website.com") tornaram-se comuns, projetados especialmente para os novos dispositivos usados. Netbooks, ultrabooks, 4G e Wi-Fi amplamente difundidos e chips móveis capazes ou executando quase com a potência de desktops de não muitos anos antes, com uso de energia muito menor, tornaram-se facilitadores desse estágio de desenvolvimento da Internet, e o termo " Aplicativo" surgiu (abreviação de "Programa de aplicativo" ou "Programa"), assim como a "App store".

Esta "revolução móvel" permitiu que as pessoas tivessem uma quantidade quase ilimitada de informações na ponta dos dedos. Com a capacidade de acessar a internet a partir de telefones celulares, veio uma mudança na forma como consumimos mídia. De fato, olhando para as estatísticas de consumo de mídia, mais da metade do consumo de mídia entre 18 e 34 anos estava usando um smartphone.

Networking no espaço sideral

O primeiro link de Internet na órbita baixa da Terra foi estabelecido em 22 de janeiro de 2010, quando o astronauta T. J. Creamer postou a primeira atualização não assistida em sua conta do Twitter da Estação Espacial Internacional, marcando a extensão da Internet no espaço. (Os astronautas da ISS já haviam usado e-mail e Twitter antes, mas essas mensagens foram retransmitidas para o solo por meio de um link de dados da NASA antes de serem postadas por um proxy humano.) Esse acesso pessoal à Web, que a NASA chama de LAN de suporte à tripulação, usa o link de micro-ondas de banda Ku de alta velocidade da estação espacial. Para navegar na Web, os astronautas podem usar um laptop da estação para controlar um computador de mesa na Terra e podem conversar com suas famílias e amigos na Terra usando equipamentos de Voz sobre IP.

A comunicação com espaçonaves além da órbita da Terra tem sido tradicionalmente por meio de links ponto a ponto através da Deep Space Network. Cada um desses links de dados deve ser agendado e configurado manualmente. No final da década de 1990, a NASA e o Google começaram a trabalhar em um novo protocolo de rede, rede tolerante a atrasos (DTN), que automatiza esse processo, permite a rede de nós de transmissão espacial e leva em consideração o fato de que espaçonaves podem perder contato temporariamente porque se movem para trás. a Lua ou planetas, ou porque o clima espacial interrompe a conexão. Sob tais condições, o DTN retransmite os pacotes de dados em vez de descartá-los, como faz o protocolo de Internet TCP/IP padrão. A NASA realizou o primeiro teste de campo do que chama de "internet do espaço profundo" em novembro de 2008. O teste de comunicações baseadas em DTN entre a Estação Espacial Internacional e a Terra (agora denominado Rede tolerante a interrupções) está em andamento desde março de 2009 e está programado para continuar até março de 2014.

Supõe-se que essa tecnologia de rede permita missões que envolvam várias espaçonaves, nas quais a comunicação confiável entre as naves pode ter precedência sobre os downlinks da nave para a Terra. De acordo com uma declaração de fevereiro de 2011 de Vint Cerf do Google, os chamados "protocolos de pacote" foram enviados para a espaçonave da missão EPOXI da NASA (que está em órbita ao redor do Sol) e a comunicação com a Terra foi testada a uma distância de aproximadamente 80 segundos-luz.

Governança da Internet

Como uma rede distribuída globalmente de redes autônomas interconectadas voluntariamente, a Internet opera sem um órgão governamental central. Cada rede constituinte escolhe as tecnologias e protocolos que implanta a partir dos padrões técnicos desenvolvidos pela Internet Engineering Task Force (IETF). No entanto, a interoperação bem-sucedida de muitas redes requer certos parâmetros que devem ser comuns em toda a rede. Para gerenciar esses parâmetros, a Internet Assigned Numbers Authority (IANA) supervisiona a alocação e atribuição de vários identificadores técnicos. Além disso, a Corporação da Internet para Nomes e Números Atribuídos (ICANN) supervisiona e coordena os dois principais espaços de nomes na Internet, o espaço de endereços do Protocolo da Internet e o Sistema de Nomes de Domínio.

NIC, InterNIC, IANA e ICANN

A função da IANA foi originalmente executada pelo USC Information Sciences Institute (ISI) e delegou partes dessa responsabilidade com relação à rede numérica e identificadores de sistema autônomo ao Network Information Center (NIC) no Stanford Research Institute (SRI International) em Menlo Park, Califórnia. Jonathan Postel, da ISI, gerenciou a IANA, atuou como editor de RFC e desempenhou outras funções importantes até sua morte prematura em 1998.

À medida que a ARPANET inicial crescia, os hosts eram chamados por nomes e um arquivo HOSTS.TXT era distribuído da SRI International para cada host na rede. À medida que a rede crescia, isso se tornava complicado. Uma solução técnica veio na forma do Sistema de Nomes de Domínio, criado por Paul Mockapetris da ISI em 1983. O Defense Data Network—Network Information Center (DDN-NIC) no SRI cuidou de todos os serviços de registro, incluindo o nível superior domínios (TLDs) de.mil,.gov,.edu,.org,.net,.com e.us, administração do servidor de nomes raiz e atribuições de números da Internet sob um contrato do Departamento de Defesa dos Estados Unidos. Em 1991, a Defense Information Systems Agency (DISA) concedeu a administração e manutenção do DDN-NIC (gerenciado pela SRI até este ponto) para a Government Systems, Inc., que a subcontratou para o pequeno setor privado Network Solutions, Inc.

A crescente diversidade cultural da Internet também apresentou desafios administrativos para o gerenciamento centralizado dos endereços IP. Em outubro de 1992, a Internet Engineering Task Force (IETF) publicou a RFC 1366, que descrevia o "crescimento da Internet e sua crescente globalização" e estabeleceu as bases para uma evolução do processo de registro de PI, com base em um modelo de registro distribuído regionalmente. Esse documento enfatizava a necessidade de existir um único registro de números da Internet em cada região geográfica do mundo (que seria de "dimensões continentais"). Os registros seriam "imparciais e amplamente reconhecidos pelos provedores de rede e assinantes" dentro de sua região. O Centro de Coordenação de Rede RIPE (RIPE NCC) foi estabelecido como o primeiro RIR em maio de 1992. O segundo RIR, o Asia Pacific Network Information Center (APNIC), foi estabelecido em Tóquio em 1993, como um projeto piloto do Asia Pacific Networking Group.

Como neste ponto da história a maior parte do crescimento da Internet vinha de fontes não militares, foi decidido que o Departamento de Defesa não financiaria mais os serviços de registro fora do TLD.mil. Em 1993, a US National Science Foundation, após um processo de licitação em 1992, criou o InterNIC para gerenciar as alocações de endereços e o gerenciamento dos bancos de dados de endereços e concedeu o contrato a três organizações. Os Serviços de Registro seriam fornecidos pela Network Solutions; Os serviços de diretório e banco de dados seriam fornecidos pela AT&T; e os Serviços de Informação seriam fornecidos pela General Atomics.

Com o tempo, depois de consultar a IANA, a IETF, RIPE NCC, APNIC e o Federal Networking Council (FNC), foi tomada a decisão de separar o gerenciamento de nomes de domínio do gerenciamento de números IP. Seguindo os exemplos de RIPE NCC e APNIC, foi recomendado que o gerenciamento do espaço de endereço IP então administrado pelo InterNIC deveria estar sob o controle daqueles que o utilizam, especificamente os ISPs, organizações de usuários finais, entidades corporativas, universidades e indivíduos. Como resultado, o American Registry for Internet Numbers (ARIN) foi estabelecido em dezembro de 1997, como uma corporação independente e sem fins lucrativos sob a direção da National Science Foundation e tornou-se o terceiro Registro Regional da Internet.

Em 1998, tanto a IANA quanto as demais funções InterNIC relacionadas ao DNS foram reorganizadas sob o controle da ICANN, uma corporação sem fins lucrativos da Califórnia contratada pelo Departamento de Comércio dos Estados Unidos para gerenciar várias tarefas relacionadas à Internet. Como essas tarefas envolviam a coordenação técnica de dois principais espaços de nomes da Internet (nomes DNS e endereços IP) criados pela IETF, a ICANN também assinou um memorando de entendimento com o IAB para definir o trabalho técnico a ser realizado pela Internet Assigned Numbers Authority. O gerenciamento do espaço de endereço da Internet permaneceu com os registros regionais da Internet, que coletivamente foram definidos como uma organização de apoio dentro da estrutura da ICANN. A ICANN fornece coordenação central para o sistema DNS, incluindo coordenação de políticas para o sistema de registro/registrador dividido, com concorrência entre provedores de serviços de registro para atender a cada domínio de primeiro nível e vários registradores concorrentes que oferecem serviços de DNS aos usuários finais.

Força-Tarefa de Engenharia de Internet

O Internet Engineering Task Force (IETF) é o maior e mais visível de vários grupos ad hoc vagamente relacionados que fornecem orientação técnica para a Internet, incluindo o Internet Architecture Board (IAB), o Internet Engineering Steering Group (IESG) e a Força-Tarefa de Pesquisa da Internet (IRTF).

O IETF é um grupo vagamente auto-organizado de voluntários internacionais que contribuem para a engenharia e evolução das tecnologias da Internet. É o principal órgão envolvido no desenvolvimento de novas especificações de padrões da Internet. Muito do trabalho do IETF é organizado em Grupos de Trabalho. Os esforços de padronização dos Grupos de Trabalho são frequentemente adotados pela comunidade da Internet, mas o IETF não controla ou patrulha a Internet.

O IETF cresceu a partir de reuniões trimestrais com pesquisadores financiados pelo governo dos EUA, começando em janeiro de 1986. Representantes não governamentais foram convidados pela quarta reunião do IETF em outubro de 1986. O conceito de Grupos de Trabalho foi apresentado na quinta reunião em fevereiro 1987. A sétima reunião em julho de 1987 foi a primeira reunião com mais de cem participantes. Em 1992, a Internet Society, uma sociedade de membros profissionais, foi formada e a IETF começou a operar sob ela como um órgão internacional independente de padrões. A primeira reunião da IETF fora dos Estados Unidos foi realizada em Amsterdã, Holanda, em julho de 1993. Hoje, a IETF se reúne três vezes por ano e a frequência chega a ca. 2.000 participantes. Normalmente, uma em cada três reuniões da IETF é realizada na Europa ou na Ásia. O número de participantes fora dos EUA é normalmente ca. 50%, mesmo em reuniões realizadas nos Estados Unidos.

O IETF não é uma entidade legal, não tem conselho de administração, nem membros, nem taxas. O status mais parecido com a associação é estar em uma lista de discussão do IETF ou do Grupo de Trabalho. Os voluntários da IETF vêm de todo o mundo e de muitas partes diferentes da comunidade da Internet. O IETF trabalha de perto e sob a supervisão do Internet Engineering Steering Group (IESG) e do Internet Architecture Board (IAB). A Internet Research Task Force (IRTF) e o Internet Research Steering Group (IRSG), atividades semelhantes ao IETF e ao IESG sob a supervisão geral do IAB, concentram-se em questões de pesquisa de longo prazo.

Pedido de comentários

A solicitação de comentários (RFCs) é a principal documentação para o trabalho do IAB, IESG, IETF e IRTF. O RFC 1, "Host Software", foi escrito por Steve Crocker na UCLA em abril de 1969, bem antes da criação do IETF. Originalmente, eram memorandos técnicos documentando aspectos do desenvolvimento da ARPANET e foram editados por Jon Postel, o primeiro editor RFC.

Os RFCs cobrem uma ampla gama de informações de padrões propostos, rascunhos de padrões, padrões completos, melhores práticas, protocolos experimentais, história e outros tópicos informativos. Os RFCs podem ser escritos por indivíduos ou grupos informais de indivíduos, mas muitos são o produto de um Grupo de Trabalho mais formal. Os rascunhos são enviados ao IESG por indivíduos ou pelo presidente do grupo de trabalho. Um editor RFC, nomeado pelo IAB, separado da IANA e trabalhando em conjunto com o IESG, recebe rascunhos do IESG e os edita, formata e publica. Depois que um RFC é publicado, ele nunca é revisado. Se o padrão que ele descreve mudar ou suas informações se tornarem obsoletas, o padrão revisado ou as informações atualizadas serão publicadas novamente como uma nova RFC que "obsoleta" o original.

A Sociedade da Internet

A Internet Society (ISOC) é uma organização internacional sem fins lucrativos fundada em 1992 "para assegurar o desenvolvimento aberto, a evolução e o uso da Internet para o benefício de todas as pessoas em todo o mundo". Com escritórios perto de Washington, DC, EUA, e em Genebra, Suíça, a ISOC tem uma base de membros composta por mais de 80 organizações e mais de 50.000 membros individuais. Os membros também formam "capítulos" com base na localização geográfica comum ou em interesses especiais. Atualmente, existem mais de 90 capítulos em todo o mundo.

O ISOC fornece suporte financeiro e organizacional e promove o trabalho dos órgãos de definição de padrões dos quais é a sede organizacional: Internet Engineering Task Force (IETF), Internet Architecture Board (IAB), Internet Engineering Steering Group (IESG) e a Força-Tarefa de Pesquisa da Internet (IRTF). A ISOC também promove a compreensão e valorização do modelo da Internet de processos abertos e transparentes e tomada de decisão baseada em consenso.

Globalização e governança da Internet no século 21

Desde a década de 1990, a governança e a organização da Internet têm sido de importância global para governos, comércio, sociedade civil e indivíduos. As organizações que detinham o controle de certos aspectos técnicos da Internet eram as sucessoras da antiga supervisão da ARPANET e os atuais tomadores de decisão nos aspectos técnicos do dia-a-dia da rede. Embora reconhecidos como administradores de certos aspectos da Internet, seus papéis e sua autoridade de tomada de decisão são limitados e sujeitos a crescente escrutínio internacional e crescentes objeções. Essas objeções levaram a ICANN a se retirar do relacionamento com a University of Southern California primeiro em 2000 e, em setembro de 2009, ganhando autonomia do governo dos EUA ao encerrar seus acordos de longa data, embora algumas obrigações contratuais com o Departamento de Comércio dos EUA contínuo. Finalmente, em 1º de outubro de 2016, a ICANN rescindiu seu contrato com a Administração Nacional de Telecomunicações e Informações do Departamento de Comércio dos Estados Unidos (NTIA), permitindo que a supervisão passasse para a comunidade global da Internet.

O IETF, com apoio financeiro e organizacional da Internet Society, continua a servir como órgão ad hoc de padrões da Internet e emite pedidos de comentários.

Em novembro de 2005, a Cúpula Mundial sobre a Sociedade da Informação, realizada em Túnis, convocou um Fórum de Governança da Internet (IGF) a ser convocado pelo Secretário-Geral das Nações Unidas. O IGF abriu uma conversa contínua e não vinculativa entre as partes interessadas que representam governos, o setor privado, a sociedade civil e as comunidades técnica e acadêmica sobre o futuro da governança da Internet. A primeira reunião do IGF foi realizada em outubro/novembro de 2006, com reuniões de acompanhamento anuais a partir de então. Desde a WSIS, o termo "governança da Internet" foi ampliado para além de preocupações técnicas estreitas para incluir uma gama mais ampla de questões políticas relacionadas à Internet.

Tim Berners-Lee, inventor da web, estava ficando preocupado com as ameaças ao futuro da web e em novembro de 2009 no IGF em Washington DC lançou a World Wide Web Foundation (WWWF) para fazer campanha para tornar o web uma ferramenta segura e capacitadora para o bem da humanidade com acesso a todos. Em novembro de 2019, no IGF em Berlim, Berners-Lee e a WWWF lançaram o Contract for the Web, uma iniciativa de campanha para persuadir governos, empresas e cidadãos a se comprometerem com nove princípios para parar e #34;uso indevido" com o aviso "Se não agirmos agora - e agirmos juntos - para evitar que a web seja mal utilizada por aqueles que querem explorar, dividir e minar, corremos o risco de desperdiçar" (seu potencial para o bem).

Politização da Internet

Devido à sua proeminência e imediatismo como meio eficaz de comunicação de massa, a Internet também se tornou mais politizada à medida que crescia. Isso tem levado, por sua vez, a discursos e atividades que outrora ocorreriam de outras formas, migrando para a mediação pela internet.

Os exemplos incluem atividades políticas como protesto público e angariação de apoio e votos, mas também:

- A difusão de ideias e opiniões;

- Recrutamento de seguidores e "juntos" de membros do público, para ideias, produtos e causas;

- Fornecer e distribuir amplamente e compartilhar informações que possam ser consideradas sensíveis ou relacionadas com o assobio (e esforços por países específicos para evitar isso por censura);

- Actividade criminal e terrorismo (e consequente utilização da aplicação da lei, juntamente com a sua facilitação pela vigilância em massa);

- Notícias falsas politicamente motivadas.

Neutralidade da rede

Em 23 de abril de 2014, a Comissão Federal de Comunicações (FCC) estava considerando uma nova regra que permitiria aos provedores de serviços de Internet oferecer aos provedores de conteúdo um caminho mais rápido para enviar conteúdo, revertendo assim sua posição anterior de neutralidade da rede. Uma possível solução para as preocupações com a neutralidade da rede pode ser a banda larga municipal, de acordo com a professora Susan Crawford, especialista em direito e tecnologia da Harvard Law School. Em 15 de maio de 2014, a FCC decidiu considerar duas opções em relação aos serviços de Internet: primeiro, permitir faixas de banda larga rápidas e lentas, comprometendo assim a neutralidade da rede; e segundo, reclassificar a banda larga como um serviço de telecomunicações, preservando assim a neutralidade da rede. Em 10 de novembro de 2014, o presidente Obama recomendou que a FCC reclassificasse o serviço de Internet de banda larga como um serviço de telecomunicações para preservar a neutralidade da rede. Em 16 de janeiro de 2015, os republicanos apresentaram uma legislação, na forma de um projeto de lei para discussão de direitos humanos no Congresso dos EUA, que faz concessões à neutralidade da rede, mas proíbe a FCC de atingir a meta ou promulgar qualquer outra regulamentação que afete os provedores de serviços de Internet (ISPs). Em 31 de janeiro de 2015, a AP News informou que a FCC apresentará a noção de aplicação ("com algumas ressalvas") Título II (transportadora comum) da Lei de Comunicações de 1934 à internet em uma votação esperada para 26 de fevereiro de 2015. A adoção dessa noção reclassificaria o serviço de internet de informação para telecomunicações e, de acordo com Tom Wheeler, presidente da FCC, garantiria a neutralidade da rede. Espera-se que a FCC imponha a neutralidade da rede em seu voto, de acordo com o The New York Times.

Em 26 de fevereiro de 2015, a FCC decidiu a favor da neutralidade da rede aplicando o Título II (transportadora comum) da Lei de Comunicações de 1934 e a Seção 706 da Lei de Telecomunicações de 1996 à Internet. O presidente da FCC, Tom Wheeler, comentou: “Isso não é mais um plano para regular a Internet do que a Primeira Emenda é um plano para regular a liberdade de expressão”. Ambos representam o mesmo conceito."

Em 12 de março de 2015, a FCC divulgou os detalhes específicos das regras de neutralidade da rede. Em 13 de abril de 2015, a FCC publicou a regra final sobre sua nova "Net Neutrality" regulamentos.

Em 14 de dezembro de 2017, a FCC revogou sua decisão de 12 de março de 2015 por 3 votos a 2 em relação às regras de neutralidade da rede.

Uso e cultura

E-mail e Usenet

O e-mail costuma ser considerado o aplicativo matador da Internet. É anterior à Internet e foi uma ferramenta crucial para criá-la. O e-mail começou em 1965 como uma maneira de vários usuários de um computador mainframe de compartilhamento de tempo se comunicarem. Embora a história não esteja documentada, entre os primeiros sistemas a ter tal facilidade estavam o System Development Corporation (SDC) Q32 e o Compatible Time-Sharing System (CTSS) no MIT.

A rede de computadores ARPANET deu uma grande contribuição para a evolução do correio eletrônico. Um inter-sistema experimental transferiu correio na ARPANET logo após sua criação. Em 1971, Ray Tomlinson criou o que se tornaria o formato de endereçamento de correio eletrônico padrão da Internet, usando o sinal @ para separar nomes de caixas de correio de nomes de host.