Entropia

Entropia é um conceito científico, bem como uma propriedade física mensurável, que é mais comumente associada a um estado de desordem, aleatoriedade ou incerteza. O termo e o conceito são usados em diversos campos, desde a termodinâmica clássica, onde foi reconhecido pela primeira vez, até a descrição microscópica da natureza na física estatística e os princípios da teoria da informação. Encontrou aplicações de longo alcance em química e física, em sistemas biológicos e sua relação com a vida, em cosmologia, economia, sociologia, ciência do tempo, mudança climática e sistemas de informação, incluindo a transmissão de informações em telecomunicações.

O conceito termodinâmico foi referido pelo cientista e engenheiro escocês William Rankine em 1850 com os nomes função termodinâmica e potencial de calor. Em 1865, o físico alemão Rudolf Clausius, um dos principais fundadores do campo da termodinâmica, definiu-a como o quociente de uma quantidade infinitesimal de calor para a temperatura instantânea. Ele inicialmente o descreveu como conteúdo de transformação, em alemão Verwandlungsinhalt, e mais tarde cunhou o termo entropia de uma palavra grega para transformação. Referindo-se à constituição e estrutura microscópica, em 1862, Clausius interpretou o conceito como significando desagregação.

Uma consequência da entropia é que certos processos são irreversíveis ou impossíveis, além da exigência de não violar a conservação da energia, esta última expressa na primeira lei da termodinâmica. A entropia é central para a segunda lei da termodinâmica, que afirma que a entropia de sistemas isolados deixados para evolução espontânea não pode diminuir com o tempo, pois eles sempre chegam a um estado de equilíbrio termodinâmico, onde a entropia é mais alta.

O físico austríaco Ludwig Boltzmann explicou a entropia como a medida do número de possíveis arranjos microscópicos ou estados de átomos e moléculas individuais de um sistema que obedecem à condição macroscópica do sistema. Assim, ele introduziu o conceito de desordem estatística e distribuições de probabilidade em um novo campo da termodinâmica, chamado de mecânica estatística, e encontrou a ligação entre as interações microscópicas, que flutuam em torno de uma configuração média, ao comportamento macroscopicamente observável, na forma de um simples logarítmico. lei, com uma constante de proporcionalidade, a constante de Boltzmann, que se tornou uma das constantes universais definidoras do moderno Sistema Internacional de Unidades (SI).

Em 1948, o cientista da Bell Labs Claude Shannon desenvolveu conceitos estatísticos semelhantes de medição de incerteza microscópica e multiplicidade para o problema de perdas aleatórias de informações em sinais de telecomunicações. Por sugestão de John von Neumann, Shannon nomeou essa entidade de informação ausente de maneira análoga ao seu uso na mecânica estatística como entropia e deu origem ao campo da teoria da informação. Esta descrição foi identificada como uma definição universal do conceito de entropia.

História

Em seu artigo de 1803, Princípios Fundamentais de Equilíbrio e Movimento, o matemático francês Lazare Carnot propôs que, em qualquer máquina, as acelerações e choques das partes móveis representam perdas de momento de atividade ; em qualquer processo natural existe uma tendência inerente à dissipação da energia útil. Em 1824, com base nesse trabalho, o filho de Lazare, Sadi Carnot, publicou Reflections on the Motive Power of Fire, que afirmava que em todos os motores térmicos, sempre que "calórico" 34; (o que agora é conhecido como calor) cai através de uma diferença de temperatura, trabalho ou força motriz pode ser produzido a partir das ações de sua queda de um corpo quente para um corpo frio. Ele usou uma analogia de como a água cai em uma roda d'água. Essa foi uma visão inicial da segunda lei da termodinâmica. Carnot baseou suas visões de calor parcialmente na "hipótese newtoniana" que tanto o calor quanto a luz eram tipos de formas indestrutíveis de matéria, que são atraídas e repelidas por outras matérias, e parcialmente nas visões contemporâneas do Conde Rumford, que mostrou em 1789 que o calor poderia ser criado por fricção, como quando os canhões são usinados. Carnot raciocinou que, se o corpo da substância de trabalho, como um corpo de vapor, retornar ao seu estado original no final de um ciclo completo do motor, "nenhuma mudança ocorre na condição do corpo de trabalho".

A primeira lei da termodinâmica, deduzida das experiências de calor e fricção de James Joule em 1843, expressa o conceito de energia e sua conservação em todos os processos; a primeira lei, no entanto, é inadequada para quantificar separadamente os efeitos de atrito e dissipação.

Nas décadas de 1850 e 1860, o físico alemão Rudolf Clausius se opôs à suposição de que nenhuma mudança ocorre no corpo de trabalho e deu a essa mudança uma interpretação matemática, questionando a natureza da perda inerente de calor utilizável quando o trabalho é feito, por exemplo, calor produzido por fricção. Ele descreveu suas observações como um uso dissipativo de energia, resultando em um conteúdo de transformação (Verwandlungsinhalt em alemão), de um sistema termodinâmico ou corpo de trabalho de espécies químicas durante uma mudança do Estado. Isso contrastava com as visões anteriores, baseadas nas teorias de Isaac Newton, de que o calor era uma partícula indestrutível que tinha massa. Clausius descobriu que a energia não utilizável aumenta à medida que o vapor passa da entrada para a exaustão em uma máquina a vapor. Do prefixo en-, como em 'energia', e da palavra grega τροπή [tropē], que é traduzida em um léxico estabelecido como girando ou mudança e que ele traduziu em alemão como Verwandlung, uma palavra frequentemente traduzida para o inglês como transformação, em 1865 Clausius cunhou o nome dessa propriedade como entropia. A palavra foi adotada na língua inglesa em 1868.

Mais tarde, cientistas como Ludwig Boltzmann, Josiah Willard Gibbs e James Clerk Maxwell deram à entropia uma base estatística. Em 1877, Boltzmann visualizou uma maneira probabilística de medir a entropia de um conjunto de partículas de gás ideal, na qual definiu a entropia como proporcional ao logaritmo natural do número de microestados que esse gás poderia ocupar. A constante de proporcionalidade nesta definição, chamada constante de Boltzmann, tornou-se uma das constantes universais definidoras do moderno Sistema Internacional de Unidades (SI). Doravante, o problema essencial em termodinâmica estatística tem sido determinar a distribuição de uma dada quantidade de energia E sobre N sistemas idênticos. Constantin Carathéodory, um matemático grego, ligou a entropia a uma definição matemática de irreversibilidade, em termos de trajetórias e integrabilidade.

Etimologia

Em 1865, Clausius nomeou o conceito de "o diferencial de uma quantidade que depende da configuração do sistema", - Sim. (Entropia) após a palavra grega para «transformação». Ele deu "conteúdo transformacional" (Produtos de plástico) como sinônimo, em paralelo com seu "conteúdo térmico e ergonal" (Wärme- und Werkinhalt) como o nome do UNão., mas preferindo o termo - Sim. como um paralelo próximo da palavra energia, como ele encontrou os conceitos quase "analogous em seu significado físico". Este termo foi formado substituindo a raiz de - Não. ('ergon', 'work') por aquele de O quê? ('tropy', 'transformation').

Com mais detalhes, Clausius explicou sua escolha de "entropia" como um nome da seguinte forma:

Eu prefiro ir para as línguas antigas para os nomes de quantidades científicas importantes, para que eles possam significar a mesma coisa em todas as línguas vivas. Por conseguinte, proponho que convoque S o - Sim. de um corpo, após a palavra grega "transformação". eu tenho inventado a palavra - Sim. para ser semelhante à energia, para essas duas quantidades são tão análogas em seu significado físico, que uma analogia de denominações me parece útil.

Leon Cooper acrescentou que desta forma "conseguiu cunhar uma palavra que significava a mesma coisa para todos: nada."

Definições e descrições

Qualquer método que envolva a noção de entropia, cuja própria existência depende da segunda lei da termodinâmica, sem dúvida parecerá a muitos exagerados, e pode repelir iniciantes como obscuros e difíceis de compreender.

Willard Gibbs, Métodos Gráficos na Termodinâmica dos Fluidos

O conceito de entropia é descrito por duas abordagens principais, a perspectiva macroscópica da termodinâmica clássica e a descrição microscópica central da mecânica estatística. A abordagem clássica define entropia em termos de propriedades físicas mensuráveis macroscopicamente, como massa, volume, pressão e temperatura. A definição estatística de entropia a define em termos das estatísticas dos movimentos dos constituintes microscópicos de um sistema – modelado inicialmente de forma clássica, por exemplo, Partículas newtonianas constituindo um gás, e posteriormente quântico-mecanicamente (fótons, fônons, spins, etc.). As duas abordagens formam uma visão consistente e unificada do mesmo fenômeno expresso na segunda lei da termodinâmica, que encontrou aplicabilidade universal a processos físicos.

Variáveis de estado e funções de estado

Muitas propriedades termodinâmicas são definidas por variáveis físicas que definem um estado de equilíbrio termodinâmico; estas são variáveis de estado. As variáveis de estado dependem apenas da condição de equilíbrio, não do caminho de evolução para esse estado. Variáveis de estado podem ser funções de estado, também chamadas de funções de estado, no sentido de que uma variável de estado é uma função matemática de outras variáveis de estado. Freqüentemente, se algumas propriedades de um sistema são determinadas, elas são suficientes para determinar o estado do sistema e, portanto, outras propriedades' valores. Por exemplo, a temperatura e a pressão de uma determinada quantidade de gás determinam seu estado e, portanto, também seu volume por meio da lei dos gases ideais. Um sistema composto de uma substância pura de uma única fase a uma temperatura e pressão uniformes particulares é determinado e, portanto, é um estado particular e possui não apenas um volume particular, mas também uma entropia específica. O fato de a entropia ser uma função de estado a torna útil. No ciclo de Carnot, o fluido de trabalho retorna ao mesmo estado que tinha no início do ciclo, portanto, a mudança ou integral de linha de qualquer função de estado, como a entropia, ao longo desse ciclo reversível é zero.

Processo reversível

A entropia total pode ser conservada durante um processo reversível. A mudança de entropia DS- Sim. do sistema (não incluindo os arredores) é bem definido como calor δ δ QRevelação- Sim. Q_{text{rev}}} transferido para o sistema dividido pela temperatura do sistema TNão., DS= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =δ δ QRevelaçãoT- Sim. Não. Q_{text{rev}}}{T}}}. Um processo reversível é um quasistatic que se desvia apenas infinitassimalmente do equilíbrio termodinâmico e evita o atrito ou outra dissipação. Qualquer processo que aconteça rapidamente o suficiente para se desviar do equilíbrio térmico não pode ser reversível, a entropia total aumenta, e o potencial para o trabalho máximo a ser feito no processo também é perdido. Por exemplo, no ciclo do Carnot, enquanto o fluxo de calor do reservatório quente para o reservatório frio representa um aumento na entropia, a saída de trabalho, se reversivelmente e perfeitamente armazenado em algum mecanismo de armazenamento de energia, representa uma diminuição na entropia que poderia ser usado para operar o motor de calor em reverso reverso e retornar ao estado anterior; assim o total mudança de entropia ainda pode ser zero em todos os momentos se todo o processo é reversível. Um processo irreversível aumenta a entropia total do sistema e arredores.

Ciclo de Carnot

O conceito de entropia surgiu do estudo de Rudolf Clausius sobre o ciclo de Carnot, que é um ciclo termodinâmico executado por uma máquina térmica de Carnot como uma máquina térmica reversível. Em um ciclo de Carnot, o calor QH é absorvido isotermicamente à temperatura TH de um 'quente' reservatório (no estágio de expansão isotérmica) e liberado isotermicamente como calor QC para um 'frio' 39; reservatório em TC (no estágio de compressão isotérmica). De acordo com o princípio ou teorema de Carnot, o trabalho de uma máquina térmica com dois reservatórios térmicos pode ser produzido apenas quando há uma diferença de temperatura entre esses reservatórios e para motores reversíveis que são mais e igualmente eficientes entre todos os motores térmicos para um dado par de reservatórios térmicos, o trabalho é função das temperaturas dos reservatórios e do calor absorvido pelo motor QH (saída de trabalho do motor térmico = eficiência do motor térmico × calor para o motor, onde a eficiência é uma função das temperaturas do reservatório para motores térmicos reversíveis). Carnot não distinguiu entre QH e Q C, pois ele estava usando a hipótese incorreta de que a teoria calórica era válida e, portanto, o calor era conservado (a suposição incorreta de que QH e QC eram iguais em magnitude) quando, de fato, QH é maior que a magnitude de QC em magnitude. Através dos esforços de Clausius e Kelvin, sabe-se agora que o trabalho realizado por uma máquina térmica reversível é o produto da eficiência de Carnot (é a eficiência de todas as máquinas térmicas reversíveis com os mesmos pares de reservatórios térmicos de acordo com a equação de Carnot's teorema) e o calor absorvido do reservatório quente:

W= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =(TH. H. H.- Sim. - Sim. TCTH. H. H.)QH. H. H.= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =(1- Sim. - Sim. TCTH. H. H.)QH. H. H.{displaystyle W=left({frac {T_{text{H}}-T_{text{C}}}{T_{text{H}}}}right)Q_{text{H}}=left(1-{frac (T_{text{C}}}{T_{text{H}}}}right)Q_{text{H}}}}} | (1) |

Aqui. WNão. W. é trabalho feito pelo motor de calor Carnot, QH. H. H.Não. Q_{text{H}}} é calor para o motor do reservatório quente, e - Sim. - Sim. TCTH. H. H.QH. H. H.{displaystyle -{frac {T_{text{C}}}{T_{text{H}}}}Q_{text{H}}}}} é calor para o reservatório frio do motor. Para derivar o Eficiência do carto, que é 1 - TC/TH. H. H. (um número menor do que um), Kelvin teve que avaliar a proporção da saída de trabalho para o calor absorvido durante a expansão isotérmica com a ajuda da equação Carnot-Clapeyron, que continha uma função desconhecida chamada função Carnot. A possibilidade de que a função Carnot poderia ser a temperatura medida a partir de um ponto zero de temperatura foi sugerida por Joule em uma carta para Kelvin. Isso permitiu que Kelvin estabelecesse sua escala de temperatura absoluta. Também é conhecido que o trabalho líquido W produzido pelo sistema em um ciclo é o calor líquido absorvido, que é a soma (ou diferença das magnitudes) do calor QH. H. H. > 0 absorvido do reservatório quente e do calor residual QC < 0 cedido ao reservatório frio:

W= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =QH. H. H.+QCNão. W=Q_{text{H}}+Q_{text{C}}} | (2) |

Como o último é válido durante todo o ciclo, isso deu a Clausius a dica de que, em cada estágio do ciclo, o trabalho e o calor não seriam iguais, mas sua diferença seria a mudança de uma função de estado que desapareceria após conclusão do ciclo. A função de estado foi chamada de energia interna, que é central para a primeira lei da termodinâmica.

Agora igualando (1) e (2) dá, para o motor por ciclo de Carnot,

QH. H. H./TH. H. H.+QC/TC= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =0Não. Q_{text{H}}/T_{text{H}}+Q_{text{C}}/T_{text{C}}=0} | (3) |

Isso implica que existe uma função de estado cuja mudança é Q/T e essa função de estado é conservada ao longo de um Ciclo de Carnot, como outras funções de estado, como a energia interna. Clausius chamou essa função de estado de entropia. Pode-se ver que a entropia foi descoberta através da matemática e não através de resultados experimentais de laboratório. É uma construção matemática e não tem uma analogia física fácil. Isso torna o conceito um tanto obscuro ou abstrato, semelhante a como surgiu o conceito de energia.

Esta equação mostra que uma variação de entropia por ciclo de Carnot é zero. De fato, uma mudança de entropia em ambos os reservatórios térmicos por ciclo de Carnot também é zero, pois essa mudança é simplesmente expressa invertendo o sinal de cada termo na equação (3) de acordo com o fato de que, para por exemplo, para transferência de calor do reservatório quente para o motor, o motor recebe o calor enquanto o reservatório quente perde a mesma quantidade de calor;

? ? SR, H+? ? SR, C= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. QH. H. H./TH. H. H.- Sim. - Sim. QC/TC= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =0Não. Delta S_{text{r,H}}+Delta S_{text{r,C}}=-Q_{text{H}}/T_{text{H}}-Q_{text{C}}/T_{text{C}}=0} | (4) |

onde denotamos uma variação de entropia para um reservatório térmico por ΔSr,i = - Qi/Ti, para i como H (reservatório quente) ou C (reservatório frio), considerando a convenção de sinal de calor acima mencionada para o motor.

Clausius então perguntou o que aconteceria se menos trabalho fosse produzido pelo sistema do que o previsto pelo princípio de Carnot para o mesmo par de reservatórios térmicos e a mesma transferência de calor do reservatório quente para o motor QH. Nesse caso, o lado direito da equação (1) seria o limite superior do trabalho produzido pelo sistema, e a equação agora seria convertida em uma desigualdade

-Delta S_{text{r,H}}=leftvert Delta S_{text{r,H}}rightvert }" display="block" xmlns="http://www.w3.org/1998/Math/MathML">? ? SR, C>- Sim. - Sim. ? ? SR, H= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =|? ? SR, H|Não. Delta S_{text{r,C}}>- Delta S_{text{r,H}}=leftvert Delta S_{text{r,H}}rightvert } | (5) |

dizendo que a magnitude da entropia ganha pelo reservatório frio é maior do que a entropia perdida pelo reservatório quente. A variação líquida de entropia no motor por seu ciclo termodinâmico é zero, então a variação líquida de entropia no motor e em ambos os reservatórios térmicos por ciclo aumenta se o trabalho produzido pelo motor for menor que o trabalho realizado por um motor de Carnot na equação (1).

O ciclo de Carnot e a eficiência de Carnot, conforme mostrado na equação (1), são úteis porque definem o limite superior da saída de trabalho possível e a eficiência de qualquer máquina térmica termodinâmica clássica. Outros ciclos, como o ciclo Otto, o ciclo Diesel e o ciclo Brayton, podem ser analisados sob a ótica do ciclo de Carnot. Qualquer máquina ou processo cíclico que converta calor em trabalho e produza uma eficiência maior que a eficiência de Carnot não é viável porque viola a segunda lei da termodinâmica.

Para números muito pequenos de partículas no sistema, a termodinâmica estatística deve ser usada. A eficiência de dispositivos como células fotovoltaicas requer uma análise do ponto de vista da mecânica quântica.

Termodinâmica clássica

A definição termodinâmica de entropia foi desenvolvida no início da década de 1850 por Rudolf Clausius e descreve essencialmente como medir a entropia de um sistema isolado em equilíbrio termodinâmico com suas partes. Clausius criou o termo entropia como uma extensa variável termodinâmica que se mostrou útil na caracterização do ciclo de Carnot. A transferência de calor nas etapas isotérmicas (expansão isotérmica e compressão isotérmica) do ciclo de Carnot é proporcional à temperatura de um sistema (conhecida como temperatura absoluta). Essa relação foi expressa em um incremento de entropia que é igual à transferência de calor incremental dividida pela temperatura. Verificou-se que a entropia variava no ciclo termodinâmico, mas eventualmente retornava ao mesmo valor no final de cada ciclo. Assim, descobriu-se que era uma função de estado, especificamente um estado termodinâmico do sistema.

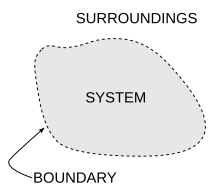

Enquanto Clausius baseou sua definição em um processo reversível, também existem processos irreversíveis que mudam a entropia. Seguindo a segunda lei da termodinâmica, a entropia de um sistema isolado sempre aumenta para processos irreversíveis. A diferença entre um sistema isolado e um sistema fechado é que a energia não pode fluir de e para um sistema isolado, mas o fluxo de energia de e para um sistema fechado é possível. No entanto, tanto para sistemas fechados como isolados e, de fato, também em sistemas abertos, podem ocorrer processos termodinâmicos irreversíveis.

De acordo com a igualdade Clausius, para um processo cíclico reversível: :: δ δ QRevelaçãoT= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =0O que é isso? Q_{text{rev}}}{T}}=0}. Isso significa que a linha integral ∫ ∫ Lδ δ QRevelaçãoT- Sim. _{L}{frac Q_{text{rev}}}{T}}} é independente do caminho.

Então podemos definir uma função estatal S chamado entropia, que satisfaz DS= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =δ δ QRevelaçãoT- Sim. Não. Q_{text{rev}}}{T}}}.

Para encontrar a diferença de entropia entre quaisquer dois estados de um sistema, a integral deve ser calculada para algum caminho reversível entre os estados inicial e final. Como a entropia é uma função de estado, a variação de entropia do sistema para um caminho irreversível é a mesma que para um caminho reversível entre os mesmos dois estados. No entanto, o calor transferido de ou para o ambiente e a variação de entropia do ambiente são diferentes.

Só podemos obter a variação de entropia integrando a fórmula acima. Para obter o valor absoluto da entropia, precisamos da terceira lei da termodinâmica, que afirma que S = 0 no zero absoluto para cristais perfeitos.

De uma perspectiva macroscópica, na termodinâmica clássica, a entropia é interpretada como uma função de estado de um sistema termodinâmico: ou seja, uma propriedade que depende apenas do estado atual do sistema, independente de como esse estado foi alcançado. Em qualquer processo onde o sistema cede energia ΔE, e sua entropia cai em ΔS, uma quantidade pelo menos TR ΔS dessa energia deve ser entregue ao ambiente do sistema como calor (TR é a temperatura do ambiente externo do sistema). Caso contrário, o processo não pode prosseguir. Na termodinâmica clássica, a entropia de um sistema é definida apenas se estiver em equilíbrio termodinâmico físico. (Mas o equilíbrio químico não é necessário: a entropia de uma mistura de dois moles de hidrogênio e um mole de oxigênio a 1 bar de pressão e 298 K é bem definida.)

Mecânica estatística

A definição estatística foi desenvolvida por Ludwig Boltzmann na década de 1870, analisando o comportamento estatístico dos componentes microscópicos do sistema. Boltzmann mostrou que essa definição de entropia era equivalente à entropia termodinâmica dentro de um fator constante conhecido como constante de Boltzmann. Em suma, a definição termodinâmica de entropia fornece a verificação experimental da entropia, enquanto a definição estatística de entropia amplia o conceito, fornecendo uma explicação e uma compreensão mais profunda de sua natureza.

A interpretação da entropia na mecânica estatística é a medida da incerteza, desordem ou mistura na frase de Gibbs, que permanece sobre um sistema após suas propriedades macroscópicas observáveis, como temperatura, pressão e volume, foram levados em consideração. Para um determinado conjunto de variáveis macroscópicas, a entropia mede o grau em que a probabilidade do sistema está espalhada por diferentes microestados possíveis. Em contraste com o macroestado, que caracteriza quantidades médias claramente observáveis, um microestado especifica todos os detalhes moleculares sobre o sistema, incluindo a posição e a velocidade de cada molécula. Quanto mais tais estados estiverem disponíveis para o sistema com probabilidade apreciável, maior será a entropia. Na mecânica estatística, a entropia é uma medida do número de maneiras pelas quais um sistema pode ser organizado, muitas vezes considerada uma medida de "desordem" (quanto maior a entropia, maior a desordem). Esta definição descreve a entropia como sendo proporcional ao logaritmo natural do número de configurações microscópicas possíveis dos átomos e moléculas individuais do sistema (microestados) que poderiam causar o estado macroscópico observado (macroestado) do sistema. A constante de proporcionalidade é a constante de Boltzmann.

A constante de Boltzmann e, portanto, a entropia, têm dimensões de energia dividida pela temperatura, que tem uma unidade de joules por kelvin (J⋅K−1) no Sistema Internacional de Unidades (ou kg ⋅m2⋅s−2⋅K−1 em termos de unidades básicas). A entropia de uma substância geralmente é dada como uma propriedade intensiva - ou entropia por unidade de massa (unidade SI: J⋅K−1⋅kg−1) ou entropia por unidade quantidade de substância (unidade SI: J⋅K−1⋅mol−1).

Especificamente, a entropia é uma medida logarítmica do número de estados do sistema com probabilidade significativa de serem ocupados:

- S= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. kBGerenciamento Gerenciamento Eu...pEu...log pEu...,Não. S=k_ {B} }sum _{i}p_{i}log P_{i},}

(pEu...Não. p_{i}} é a probabilidade de que o sistema esteja Eu...Não.o estado, geralmente dado pela distribuição de Boltzmann; se os estados são definidos de forma contínua, a soma é substituída por uma integral sobre todos os estados possíveis) ou, equivalentemente, o valor esperado do logaritmo da probabilidade de que um microestado é ocupado

- S= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. kB⟨ ⟨ log p)) Não. S=k_ {B} }langle log prangle }

onde kB é a constante de Boltzmann, igual a 1.38065×10−23 J/K. A soma é sobre todos os microestados possíveis do sistema, e pi é a probabilidade de que o sistema esteja no microestado i. Esta definição assume que o conjunto base de estados foi escolhido de forma que não haja informações sobre suas fases relativas. Em um conjunto de base diferente, a expressão mais geral é

- S= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. kBT. (? ? ^ ^ log (? ? ^ ^ )),Não. S=k_ {B} }operatorname {Tr} ({widehat {rho }}log({widehat {rho }}),}

Onde? ? ? ^ ^ - Sim. é a matriz de densidade, T.{displaystyle operatorname} Não. é traço e log- Sim. é o logaritmo da matriz. Esta formulação de matriz de densidade não é necessária em casos de equilíbrio térmico, desde que os estados de base sejam escolhidos para ser eigenstates de energia. Para fins mais práticos, isso pode ser tomado como a definição fundamental de entropia desde todas as outras fórmulas para S pode ser matematicamente derivado dele, mas não vice-versa.

No que tem sido chamado de suposição fundamental da termodinâmica estatística ou postulado fundamental da mecânica estatística, entre os microestados do sistema da mesma energia (microestados degenerados) cada microestado é presumido para ser preenchido com igual probabilidade; esta suposição é geralmente justificada para um sistema isolado em equilíbrio. Então, para um sistema isolado pi = 1/Ω, onde Ω é o número de microestados cuja energia é igual à energia do sistema, e a equação anterior se reduz a

- S= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =kBlog Ω Ω .S=k_{mathrm {B} }log Omega.}

Na termodinâmica, tal sistema é aquele em que o volume, o número de moléculas e a energia interna são fixos (o conjunto microcanônico).

Para um determinado sistema termodinâmico, o excesso de entropia é definido como a entropia menos a de um gás ideal na mesma densidade e temperatura, uma quantidade que é sempre negativa porque um gás ideal é maximamente desordenado. Este conceito desempenha um papel importante na teoria do estado líquido. Por exemplo, o princípio de escala de excesso de entropia de Rosenfeld afirma que os coeficientes de transporte reduzidos em todo o diagrama de fase bidimensional são funções exclusivamente determinadas pelo excesso de entropia.

A interpretação mais geral da entropia é como uma medida da extensão da incerteza sobre um sistema. O estado de equilíbrio de um sistema maximiza a entropia porque não reflete todas as informações sobre as condições iniciais, exceto as variáveis conservadas. Esta incerteza não é do tipo subjetivo quotidiano, mas sim a incerteza inerente ao método experimental e ao modelo interpretativo.

O modelo interpretativo tem um papel central na determinação da entropia. O qualificador "para um determinado conjunto de variáveis macroscópicas" acima tem implicações profundas: se dois observadores usam diferentes conjuntos de variáveis macroscópicas, eles veem diferentes entropias. Por exemplo, se o observador A usa as variáveis U, V e W, e o observador B usa U, V, W, X, então, alterando X, o observador B pode causar um efeito que parece uma violação da segunda lei da termodinâmica ao observador A. Em outras palavras: o conjunto de variáveis macroscópicas que se escolhe deve incluir tudo o que pode mudar no experimento, caso contrário, pode-se ver uma diminuição da entropia.

A entropia pode ser definida para qualquer processo de Markov com dinâmica reversível e a propriedade de equilíbrio detalhado.

Nas Lectures on Gas Theory de Boltzmann, de 1896, ele mostrou que essa expressão fornece uma medida de entropia para sistemas de átomos e moléculas na fase gasosa, fornecendo assim uma medida para a entropia da termodinâmica clássica.

Entropia de um sistema

A entropia surge diretamente do ciclo de Carnot. Também pode ser descrito como o calor reversível dividido pela temperatura. A entropia é uma função fundamental do estado.

Em um sistema termodinâmico, a pressão e a temperatura tendem a se tornar uniformes ao longo do tempo porque o estado de equilíbrio tem maior probabilidade (mais combinações possíveis de microestados) do que qualquer outro estado.

Por exemplo, para um copo de água gelada no ar à temperatura ambiente, a diferença de temperatura entre a sala quente (o ambiente) e o copo frio de gelo e água (o sistema e não parte da sala) diminui à medida que partes da energia térmica do ambiente quente se espalham para o sistema mais frio de gelo e água. Com o tempo, a temperatura do copo e do seu conteúdo e a temperatura da sala igualam-se. Em outras palavras, a entropia da sala diminuiu à medida que parte de sua energia foi dispersada no gelo e na água, dos quais a entropia aumentou.

No entanto, conforme calculado no exemplo, a entropia do sistema de gelo e água aumentou mais do que a entropia da sala ao redor diminuiu. Em um sistema isolado como o quarto e a água gelada juntos, a dispersão de energia do mais quente para o mais frio sempre resulta em um aumento líquido na entropia. Assim, quando o "universo" da sala e o sistema de água gelada atingiu um equilíbrio de temperatura, a variação de entropia do estado inicial é máxima. A entropia do sistema termodinâmico é uma medida de quão longe a equalização progrediu.

A entropia termodinâmica é uma função de estado não conservada de grande importância nas ciências físicas e químicas. Historicamente, o conceito de entropia evoluiu para explicar por que alguns processos (permitidos pelas leis de conservação) ocorrem espontaneamente enquanto suas inversões de tempo (também permitidas pelas leis de conservação) não; os sistemas tendem a progredir na direção do aumento da entropia. Para sistemas isolados, a entropia nunca diminui. Este fato tem várias consequências importantes na ciência: primeiro, ele proíbe o "movimento perpétuo" máquinas; e segundo, implica que a flecha da entropia tem a mesma direção que a flecha do tempo. Aumentos na entropia total do sistema e arredores correspondem a mudanças irreversíveis, porque parte da energia é gasta como calor residual, limitando a quantidade de trabalho que um sistema pode realizar.

Ao contrário de muitas outras funções de estado, a entropia não pode ser observada diretamente, mas deve ser calculada. A entropia molar padrão absoluta de uma substância pode ser calculada a partir da dependência da temperatura medida de sua capacidade de calor. A entropia molar dos íons é obtida como uma diferença de entropia a partir de um estado de referência definido como entropia zero. A segunda lei da termodinâmica afirma que a entropia de um sistema isolado deve aumentar ou permanecer constante. Portanto, a entropia não é uma quantidade conservada: por exemplo, em um sistema isolado com temperatura não uniforme, o calor pode fluir irreversivelmente e a temperatura se tornar mais uniforme de modo que a entropia aumente. As reações químicas causam mudanças na entropia e a entropia do sistema, em conjunto com a entalpia, desempenha um papel importante na determinação da direção em que uma reação química ocorre espontaneamente.

Uma definição de dicionário de entropia é que é "uma medida de energia térmica por unidade de temperatura que não está disponível para trabalho útil" em um processo cíclico. Por exemplo, uma substância em temperatura uniforme está em entropia máxima e não pode acionar um motor térmico. Uma substância em temperatura não uniforme está em uma entropia mais baixa (do que se a distribuição de calor for uniforme) e parte da energia térmica pode acionar um motor térmico.

Um caso especial de aumento de entropia, a entropia de mistura, ocorre quando duas ou mais substâncias diferentes são misturadas. Se as substâncias estiverem na mesma temperatura e pressão, não há troca líquida de calor ou trabalho – a variação de entropia é inteiramente devida à mistura das diferentes substâncias. Em um nível mecânico estatístico, isso ocorre devido à mudança no volume disponível por partícula com a mistura.

Equivalência de definições

Provas de equivalência entre a definição de entropia em mecânica estatística (a fórmula de entropia de Gibbs S= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. kBGerenciamento Gerenciamento Eu...pEu...log pEu...- Sim. {B} }sum _{i}p_{i}log p_{i}}) e em termodinâmica clássica (DS= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =δ δ QRevelaçãoT- Sim. Não. Q_{text{rev}}}{T}}} em conjunto com a relação termodinâmica fundamental) são conhecidos pelo conjunto microcanônico, o conjunto canônico, o grande conjunto canônico e o conjunto isotérmico-isobárico. Essas provas são baseadas na densidade de probabilidade de microestações da distribuição geral de Boltzmann e na identificação da energia interna termodinâmica como a média do conjunto. U= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =⟨EEu...)Não. U=leftlangle E_{i}rightrangle }. As relações termodinâmicas são então empregadas para derivar a conhecida fórmula de entropia de Gibbs. No entanto, a equivalência entre a fórmula de entropia de Gibbs e a definição termodinâmica da entropia não é uma relação termodinâmica fundamental, mas sim uma consequência da forma da distribuição geral de Boltzmann.

Além disso, foi demonstrado que as definições de entropia na mecânica estatística são a única entropia que é equivalente à entropia da termodinâmica clássica sob os seguintes postulados:

- A função de densidade de probabilidade é proporcional a alguma função dos parâmetros conjuntos e variáveis aleatórias.

- Funções do estado termodinâmico são descritas por médias de conjuntos de variáveis aleatórias.

- À temperatura infinita, todos os microestados têm a mesma probabilidade.

Segunda lei da termodinâmica

A segunda lei da termodinâmica exige que, em geral, a entropia total de qualquer sistema não diminua a não ser pelo aumento da entropia de algum outro sistema. Portanto, em um sistema isolado de seu ambiente, a entropia desse sistema tende a não diminuir. Segue-se que o calor não pode fluir de um corpo mais frio para um corpo mais quente sem a aplicação de trabalho ao corpo mais frio. Em segundo lugar, é impossível para qualquer dispositivo operando em um ciclo produzir trabalho líquido a partir de um único reservatório de temperatura; a produção de trabalho líquido requer fluxo de calor de um reservatório mais quente para um reservatório mais frio, ou um único reservatório em expansão passando por resfriamento adiabático, que realiza trabalho adiabático. Como resultado, não há possibilidade de uma máquina de movimento perpétuo. Segue-se que uma redução no aumento da entropia em um processo específico, como uma reação química, significa que ele é energeticamente mais eficiente.

Resulta da segunda lei da termodinâmica que a entropia de um sistema que não é isolado pode diminuir. Um ar condicionado, por exemplo, pode resfriar o ar de uma sala, reduzindo assim a entropia do ar daquele sistema. O calor expelido da sala (sistema), que o ar condicionado transporta e descarrega para o ar exterior, contribui sempre mais para a entropia do ambiente do que a diminuição da entropia do ar desse sistema. Assim, o total de entropia da sala mais a entropia do ambiente aumenta, de acordo com a segunda lei da termodinâmica.

Na mecânica, a segunda lei em conjunto com a relação termodinâmica fundamental coloca limites sobre a capacidade de um sistema de fazer um trabalho útil. A mudança de entropia de um sistema à temperatura TNão. absorvendo uma quantidade infinitasimal de calor δ δ q- Sim. de uma forma reversível, é dada por δ δ q/T- Sim.. Mais explicitamente, uma energia TRSNão. T_{R}S} não está disponível para fazer trabalho útil, onde TRNão. T_{R}} é a temperatura do reservatório mais frio acessível ou dissipador de calor externo ao sistema. Para mais discussão, ver Exercitação.

A mecânica estatística demonstra que a entropia é governada pela probabilidade, permitindo assim uma diminuição da desordem mesmo em um sistema isolado. Embora isso seja possível, tal evento tem uma pequena probabilidade de ocorrer, tornando-o improvável.

A aplicabilidade de uma segunda lei da termodinâmica é limitada a sistemas em ou suficientemente próximo do estado de equilíbrio, de modo que tenham entropia definida. Alguns sistemas não homogêneos fora do equilíbrio termodinâmico ainda satisfazem a hipótese de equilíbrio termodinâmico local, de modo que a densidade de entropia é definida localmente como uma quantidade intensiva. Para tais sistemas, pode ser aplicado um princípio de taxa máxima de tempo de produção de entropia. Ele afirma que tal sistema pode evoluir para um estado estacionário que maximiza sua taxa de tempo de produção de entropia. Isso não significa que tal sistema esteja necessariamente sempre em uma condição de máxima taxa temporal de produção de entropia; isso significa que ele pode evoluir para um estado estacionário.

Aplicativos

A relação termodinâmica fundamental

A entropia de um sistema depende de sua energia interna e seus parâmetros externos, como seu volume. No limite termodinâmico, este fato leva a uma equação relativa à mudança na energia interna UNão. para alterações na entropia e os parâmetros externos. Esta relação é conhecida como relação termodinâmica fundamental. Se a pressão externa pNão. ursos no volume VNão. como o único parâmetro externo, esta relação é:

- DU= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =TDS- Sim. - Sim. pDVNão. DU=T,dS-p,dV}

Uma vez que a energia interna e a entropia são funções monotônicas da temperatura TNão. T., implicando que a energia interna é fixa quando se especifica a entropia e o volume, esta relação é válida mesmo se a mudança de um estado de equilíbrio térmico para outro com infinivelmente maior entropia e volume acontece de uma forma não-quasistatic (por isso, durante esta mudança, o sistema pode estar muito longe de equilíbrio térmico e, em seguida, a entropia, pressão e temperatura do sistema inteiro pode não existir).

A relação termodinâmica fundamental implica muitas identidades termodinâmicas que são válidas em geral, independentemente dos detalhes microscópicos do sistema. Exemplos importantes são as relações de Maxwell e as relações entre capacidades térmicas.

Entropia em termodinâmica química

A entropia termodinâmica é central na termodinâmica química, permitindo que as alterações sejam quantificadas e o resultado das reações previstas. A segunda lei da termodinâmica afirma que a entropia em um sistema isolado - a combinação de um subsistema em estudo e seus arredores - aumenta durante todos os processos químicos e físicos espontâneos. A equação de Clausius δ δ qRevelação/T= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =? ? S{displaystyle delta q_{text{rev}}/T=Delta S. introduz a medição da mudança de entropia, ? ? SNão. Delta S.. A mudança de entropia descreve a direção e quantifica a magnitude de mudanças simples, como a transferência de calor entre sistemas – sempre de mais quente para mais frio espontaneamente.

A entropia termodinâmica tem, portanto, a dimensão de energia dividida pela temperatura, e a unidade joule por kelvin (J/K) no Sistema Internacional de Unidades (SI).

A entropia termodinâmica é uma propriedade extensiva, o que significa que ela escala com o tamanho ou extensão de um sistema. Em muitos processos é útil especificar a entropia como uma propriedade intensiva independente do tamanho, como uma entropia específica característica do tipo de sistema estudado. A entropia específica pode ser expressa em relação a uma unidade de massa, normalmente o quilograma (unidade: J⋅kg−1⋅K−1). Alternativamente, em química, também é referido a um mol de substância, caso em que é chamado de entropia molar com uma unidade de J⋅mol−1⋅K−1.

Assim, quando uma toupeira de substância em aproximadamente 0 K é aquecido por seus arredores para 298 K, a soma dos valores incrementais de qRevelação/T(textstyle q_{text{rev}}/T} constituem a entropia molar padrão de cada elemento ou composto, um indicador da quantidade de energia armazenada por uma substância 298 K. A mudança de entropia também mede a mistura de substâncias como uma soma de suas quantidades relativas na mistura final.

A entropia é igualmente essencial na previsão da extensão e direção de reações químicas complexas. Para tais aplicações, ? ? SNão. Delta S. deve ser incorporado em uma expressão que inclui tanto o sistema e seus arredores, ? ? Suniverso= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =? ? Sarredores+? ? SsistemaNão. Delta S_{text{universo}}= Delta S_{text{surroundings}}+ Delta S_{text{system}}}. Esta expressão torna-se, através de alguns passos, a equação de energia livre de Gibbs para reagentes e produtos no sistema: ? ? GNão. Delta G. [a mudança de energia livre de Gibbs do sistema] = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =? ? H. H. H.Não. =Delta H} [a mudança enthalpy] - Sim. - Sim. T? ? SNão. -T,Delta S} [a mudança de entropia].

Capacidade tecnológica mundial para armazenar e comunicar informações entrópicas

Um estudo de 2011 na Science (revista) estimou a capacidade tecnológica mundial para armazenar e comunicar informações comprimidas de forma otimizada normalizadas nos algoritmos de compressão mais eficazes disponíveis no ano de 2007, estimando assim a entropia das fontes tecnologicamente disponíveis. A estimativa do autor de que a capacidade tecnológica da humanidade para armazenar informações cresceu de 2,6 exabytes (comprimidos entropicamente) em 1986 para 295 exabytes (comprimidos entropicamente) em 2007. A capacidade tecnológica do mundo para receber informações através de redes de transmissão unidirecionais foi de 432 exabytes de informação (comprimida entropicamente) em 1986, para 1,9 zettabytes em 2007. A capacidade efetiva do mundo para trocar informações através de redes de telecomunicações bidirecionais foi de 281 petabytes de informação (comprimida entropicamente) em 1986, para 65 exabytes (comprimidos entropicamente) em 2007.

Equação de equilíbrio de entropia para sistemas abertos

Na engenharia química, os princípios da termodinâmica são comumente aplicados a "sistemas abertos", ou seja, aqueles em que o calor, o trabalho e o fluxo de massa através do limite do sistema. Fluxos de ambos os calores (Q:: - Não.) e trabalho, i.e. W:: S{displaystyle {dot {W}}_{text{S}}}}}} (trabalho rápido) e P(DV/D)){displaystyle P(dV/dt)} (trabalho de pressão-volume), através dos limites do sistema, em geral causa mudanças na entropia do sistema. Transferência como calor envolve transferência de entropia Q:: /T{displaystyle {dot {Q}}/T}, onde TNão. T. é a temperatura termodinâmica absoluta do sistema no ponto do fluxo de calor. Se houver fluxos de massa através dos limites do sistema, eles também influenciam a entropia total do sistema. Esta conta, em termos de calor e trabalho, é válida apenas para casos em que o trabalho e transferências de calor são por caminhos fisicamente distintos dos caminhos de entrada e saída da matéria do sistema.

Para derivar uma equação equilibrada entropia generalizada, começamos com a equação de equilíbrio geral para a mudança em qualquer quantidade extensa θ θ - Sim. em um sistema termodinâmico, uma quantidade que pode ser conservada, como a energia, ou não conservada, como a entropia. A expressão básica do equilíbrio genérico afirma que Dθ θ /D)Não., ou seja, a taxa de mudança de θ θ - Sim. no sistema, equivale à taxa em que θ θ - Sim. entra no sistema nos limites, menos a taxa em que θ θ - Sim. deixa o sistema através dos limites do sistema, além da taxa em que θ θ - Sim. é gerado dentro do sistema. Para um sistema termodinâmico aberto em que o calor e o trabalho são transferidos por caminhos separados dos caminhos para a transferência da matéria, usando esta equação de equilíbrio genérica, com respeito à taxa de mudança com o tempo )Não. da entropia de quantidade extensa SNão. S., a equação do equilíbrio de entropia é:

- DSD)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =Gerenciamento Gerenciamento k= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1KKM:: kS^ ^ k+Q:: T+S:: gen(dS){dt}}=sum _{k=1}^{K}{dot {M}} {S}}_{k}+{frac {dot {Q}}{T}}+{dot {S}}_{text{gen}}}

onde

- Gerenciamento Gerenciamento k= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1KKM:: kS^ ^ k- Sim. _{k=1}^{K}{dot {M}} {S}}_{k}} é a taxa líquida de fluxo de entropia devido aos fluxos de massa dentro e fora do sistema (onde S^ ^ (S}}} é entropia por unidade de massa).

- Q:: T- Sim. {Q}}{T}}} é a taxa de fluxo de entropia devido ao fluxo de calor através do limite do sistema.

- S:: gen- Sim. {S}}_{text{gen}}} é a taxa de produção de entropia dentro do sistema. Esta produção de entropia surge a partir de processos dentro do sistema, incluindo reações químicas, difusão de matéria interna, transferência de calor interna e efeitos de atrito, como a viscosidade que ocorre dentro do sistema, desde a transferência de trabalho mecânico até ou do sistema.

Se houver vários fluxos de calor, o termo Q:: /T{displaystyle {dot {Q}}/T} é substituído por Gerenciamento Gerenciamento Q:: JJ/TJJ,- Sim. {Q}}_{j}/T_{j},} Onde? Q:: JJ{displaystyle {dot {Q}}_{j}} é o fluxo de calor e TJJNão. T_{j}} é a temperatura na JJNão.a porta de fluxo de calor no sistema.

Note que a nomenclatura "equilíbrio excessivo" é enganosa e muitas vezes considerada inadequada porque a entropia não é uma quantidade conservada. Em outras palavras, o termo S:: gen{displaystyle {dot {S}}_{text{gen}}}}}} nunca é uma quantidade conhecida, mas sempre uma derivada baseada na expressão acima. Portanto, a versão do sistema aberto da segunda lei é mais apropriadamente descrita como a "equação de geração de energia" uma vez que especifica que S:: gen≥ ≥ 0{displaystyle {dot {S}}_{text{gen}}geq} 0, com zero para processos reversíveis ou superiores a zero para processos irreversíveis.

Fórmulas de alteração de entropia para processos simples

Para certas transformações simples em sistemas de composição constante, as variações de entropia são dadas por fórmulas simples.

Expansão isotérmica ou compressão de um gás ideal

Para a expansão (ou compressão) de um gás ideal de um volume inicial V0Não. V_{0}} e pressão P0Não. P_{0}} para um volume final VNão. e pressão PNão. P. a qualquer temperatura constante, a mudança na entropia é dada por:

- ? ? S= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =nRI VV0= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. nRI PP0.Não. Delta S=nRln {V}{V_{0}}}=n Rln {P}{P_{0}}}}

Aqui. nNão. é a quantidade de gás (em toupeiras) e RNão. R. é a constante de gás ideal. Estas equações também se aplicam para a expansão em um vácuo finito ou um processo de aceleração, onde a temperatura, a energia interna e a enthalpy para um gás ideal permanecem constantes.

Refrigeração e aquecimento

Para aquecimento puro ou resfriamento de qualquer sistema (gás, líquido ou sólido) a pressão constante de uma temperatura inicial T0Não. T_{0}} a uma temperatura final TNão. T., a mudança de entropia é

- ? ? S= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =nCPI TT0.Não. Delta S=nC_{P}ln {frac {T}{T_{0}}}}

desde que a capacidade de calor molar de pressão constante (ou calor específico) CP seja constante e que nenhuma transição de fase ocorra neste intervalo de temperatura.

Da mesma forma a volume constante, a variação de entropia é

- ? ? S= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =nCvI TT0,Não. Delta S=nC_{v}ln {frac {T}{T_{0}}},}

onde a capacidade térmica molar de volume constante Cv é constante e não há mudança de fase.

Em baixas temperaturas perto do zero absoluto, as capacidades de calor dos sólidos caem rapidamente para perto de zero, então a suposição de capacidade de calor constante não se aplica.

Como a entropia é uma função de estado, a variação de entropia de qualquer processo em que a temperatura e o volume variam é a mesma de um caminho dividido em duas etapas – aquecimento a volume constante e expansão a temperatura constante. Para um gás ideal, a variação total de entropia é

- ? ? S= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =nCvI TT0+nRI VV0.Não. Delta S=nC_{v}ln {frac {T}{T_{0}}}+nRln {frac {V}{V_{0}}}.}

Da mesma forma, se a temperatura e a pressão de um gás ideal variam,

- ? ? S= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =nCPI TT0- Sim. - Sim. nRI PP0.Não. Delta S=nC_{P}ln {frac {T}{T_{0}}}-nRln {P}{P_{0}}}}

Transições de fase

As transições de fase reversíveis ocorrem a temperatura e pressão constantes. O calor reversível é a variação de entalpia para a transição, e a variação de entropia é a variação de entalpia dividida pela temperatura termodinâmica. Para fusão (fusão) de um sólido para um líquido no ponto de fusão Tm, a entropia de fusão é

- ? ? S- Sim.= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =? ? H. H. H.- Sim.Tm.Não. Delta S_{text{fus}}={frac Delta H_{text{fus}}}{T_{text{m}}}}}

Da mesma forma, para a vaporização de um líquido para um gás no ponto de ebulição Tb, a entropia de vaporização é

- ? ? SVap= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =? ? H. H. H.VapTb).Não. Delta S_{text{vap}}={frac Delta H_{text{vap}}}{T_{text{b}}}}}

Abordagens para entender a entropia

Como um aspecto fundamental da termodinâmica e da física, várias abordagens diferentes da entropia além daquela de Clausius e Boltzmann são válidas.

Definições padrão de livros didáticos

A seguir está uma lista de definições adicionais de entropia de uma coleção de livros didáticos:

- uma medida de dispersão de energia a uma temperatura específica.

- uma medida de desordem no universo ou da disponibilidade da energia em um sistema para fazer o trabalho.

- uma medida da energia térmica de um sistema por temperatura unitária que não está disponível para fazer um trabalho útil.

Na análise de Boltzmann em termos de partículas constituintes, a entropia é uma medida do número de possíveis estados microscópicos (ou microestados) de um sistema em equilíbrio termodinâmico.

Ordem e desordem

A entropia é geralmente vagamente associada à quantidade de ordem ou desordem, ou de caos, em um sistema termodinâmico. A descrição qualitativa tradicional da entropia é que ela se refere a mudanças no status quo do sistema e é uma medida de "desordem molecular" e a quantidade de energia desperdiçada em uma transformação de energia dinâmica de um estado ou forma para outro. Nessa direção, vários autores recentes derivaram fórmulas exatas de entropia para explicar e medir a desordem e a ordem nas montagens atômicas e moleculares. Uma das fórmulas de ordem/desordem de entropia mais simples é a derivada em 1984 pelo físico termodinâmico Peter Landsberg, baseada em uma combinação de argumentos de termodinâmica e teoria da informação. Ele argumenta que, quando as restrições operam em um sistema, de modo que ele seja impedido de entrar em um ou mais de seus estados possíveis ou permitidos, em contraste com seus estados proibidos, a medida da quantidade total de "desordem" no sistema é dada por:

- Transtorno= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =CDCEu....{displaystyle {text{Disorder}}={C_{text{D}} over C_{text{I}}}.,}

Da mesma forma, o valor total do "pedido" no sistema é dada por:

- Ordem= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1- Sim. - Sim. COCEu....{displaystyle {text{Order}}=1-{C_{text{O}} over C_{text{I}}}.,}

Em que CD é o "distúrbio" capacidade do sistema, que é a entropia das partes contidas no conjunto permitido, CI é a "informação" capacidade do sistema, uma expressão semelhante à capacidade do canal de Shannon, e CO é a "ordem" capacidade do sistema.

Dispersão de energia

O conceito de entropia pode ser descrito qualitativamente como uma medida de dispersão de energia a uma temperatura específica. Termos semelhantes têm sido usados desde o início da história da termodinâmica clássica e, com o desenvolvimento da termodinâmica estatística e da teoria quântica, as mudanças de entropia foram descritas em termos de mistura ou "espalhamento" da energia total de cada constituinte de um sistema sobre seus níveis de energia quantizados particulares.

Ambigüidades nos termos desordem e caos, que geralmente têm significados diretamente opostos ao equilíbrio, contribuem para a confusão generalizada e dificultam a compreensão da entropia para a maioria dos alunos. Como mostra a segunda lei da termodinâmica, em um sistema isolado, porções internas em diferentes temperaturas tendem a se ajustar a uma única temperatura uniforme e, assim, produzir equilíbrio. Uma abordagem educacional desenvolvida recentemente evita termos ambíguos e descreve tal espalhamento de energia como dispersão, o que leva à perda dos diferenciais necessários para o trabalho, mesmo que a energia total permaneça constante de acordo com a primeira lei da termodinâmica (compare a discussão na próxima seção). O físico-químico Peter Atkins, em seu livro Physical Chemistry, introduz a entropia com a afirmação de que "mudanças espontâneas são sempre acompanhadas por uma dispersão de energia ou matéria e frequentemente de ambos".

Relacionando a entropia com a utilidade da energia

É possível (em um contexto térmico) considerar a baixa entropia como uma medida da eficácia ou utilidade de uma determinada quantidade de energia. A energia fornecida a uma temperatura mais alta (ou seja, com baixa entropia) tende a ser mais útil do que a mesma quantidade de energia disponível a uma temperatura mais baixa. A mistura de uma parcela quente de um fluido com uma fria produz uma parcela de temperatura intermediária, na qual o aumento geral da entropia representa uma "perda" que nunca pode ser substituído.

Como a entropia do universo está aumentando constantemente, sua energia total está se tornando menos útil. Eventualmente, isso leva à morte térmica do universo.

Entropia e acessibilidade adiabática

Uma definição de entropia baseada inteiramente na relação de acessibilidade adiabática entre estados de equilíbrio foi dada por E.H.Lieb e J. Yngvason em 1999. Esta abordagem tem vários predecessores, incluindo o trabalho pioneiro de Constantin Carathéodory de 1909 e a monografia de R. Giles. Na definição de Lieb e Yngvason um começa por escolher, para uma quantidade unitária da substância em consideração, dois estados de referência X0Não. X_{0}} e X1{displaystyle X_{1}} tal que este último é adiabaticamente acessível do primeiro, mas não vice-versa. Definir as entropias dos estados de referência para ser 0 e 1 respectivamente a entropia de um estado X- Sim. é definido como o maior número λ λ - Sim. tal que X- Sim. é adiabaticamente acessível a partir de um estado composto que consiste em uma quantidade λ λ - Sim. no estado X1{displaystyle X_{1}} e uma quantidade complementar, (1- Sim. - Sim. λ λ ){displaystyle (1-lambda)}, no estado X0Não. X_{0}}. Um resultado simples, mas importante nesta configuração é que a entropia é exclusivamente determinada, além de uma escolha de unidade e uma constante aditiva para cada elemento químico, pelas seguintes propriedades: É monotônico com relação à relação de acessibilidade adiabática, aditivo em sistemas compósitos e extensa sob escala.

Entropia na mecânica quântica

Na mecânica estatística quântica, o conceito de entropia foi desenvolvido por John von Neumann e é geralmente referido como "entropia de von Neumann",

- S= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. kBT. (? ? log ? ? ),Não. S=k_ {B} }operatorname {Tr} (rho log rho),}

onde ρ é a matriz de densidade e Tr é o operador de rastreamento.

Isso mantém o princípio da correspondência, porque no limite clássico, quando as fases entre os estados de base usados para as probabilidades clássicas são puramente aleatórias, essa expressão é equivalente à familiar definição clássica de entropia,

- S= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. kBGerenciamento Gerenciamento Eu...pEu...logpEu...,Não. S=k_ {B} }sum _{i}p_{i},log ,p_{i},}

ou seja em tal base, a matriz de densidade é diagonal.

Von Neumann estabeleceu uma estrutura matemática rigorosa para a mecânica quântica com seu trabalho Mathematische Grundlagen der Quantenmechanik. Ele forneceu neste trabalho uma teoria de medição, onde a noção usual de colapso da função de onda é descrita como um processo irreversível (o chamado von Neumann ou medição projetiva). Usando esse conceito, em conjunto com a matriz de densidade, ele estendeu o conceito clássico de entropia para o domínio quântico.

Teoria da informação

Pensei em chamá-lo de "informação", mas a palavra foi usada excessivamente, então decidi chamá-la de "incerteza". [...] Von Neumann disse-me: "Deves chamar-lhe entropia, por duas razões. Em primeiro lugar, sua função de incerteza foi usada em mecânica estatística sob esse nome, então ele já tem um nome. Em segundo lugar, e mais importante, ninguém sabe o que a entropia realmente é, então em um debate você sempre terá a vantagem."

Conversa entre Claude Shannon e John von Neumann sobre que nome dar à atenuação em sinais de linha telefônica

Quando visto em termos de teoria da informação, a função estado entropia é a quantidade de informação no sistema que é necessário para especificar totalmente o microestado do sistema. Entropia é a medida da quantidade de informação ausente antes da recepção. Muitas vezes chamado Entropia de Shannon, foi originalmente concebido por Claude Shannon em 1948 para estudar o tamanho da informação de uma mensagem transmitida. A definição de entropia de informação é expressa em termos de um conjunto discreto de probabilidades pEu...Não. p_{i}} assim

- H. H. H.(X)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. Gerenciamento Gerenciamento Eu...= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1np(xEu...)log p(xEu...).{displaystyle H(X)=-sum _{i=1}^{n}p(x_{i})log p(x_{i}).}

No caso de mensagens transmitidas, essas probabilidades eram as probabilidades de que uma determinada mensagem fosse realmente transmitida, e a entropia do sistema de mensagens era uma medida do tamanho médio das informações de uma mensagem. Para o caso de probabilidades iguais (ou seja, cada mensagem é igualmente provável), a entropia de Shannon (em bits) é apenas o número de questões binárias necessárias para determinar o conteúdo da mensagem.

A maioria dos pesquisadores considera a entropia da informação e a entropia termodinâmica diretamente ligada ao mesmo conceito, enquanto outros argumentam que eles são distintos. Ambas as expressões são matematicamente semelhantes. Se WNão. W. é o número de microestados que podem produzir um dado macroestado, e cada microestado tem o mesmo a priori probabilidade, então essa probabilidade é p= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1/WNão. P=1/W. A entropia de Shannon (em nats) é: