Valor singular de descomposición

- Top: La acción de M, indicado por su efecto en el disco de unidad D y los dos vectores de unidad canónica e1 y e2.

- Izquierda: La acción de V⁎, una rotación, en D, e1, y e2.

- Tema: La acción de ., un escalado por los valores singulares σ1 horizontal y σ2 verticalmente.

- Bien. La acción de UOtra rotación.

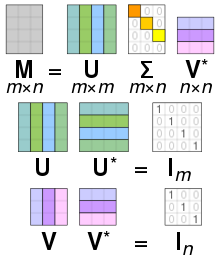

En álgebra lineal, el singular valor descomposición ()SVD) es una factorización de una matriz real o compleja. Generaliza la eigendecomposición de una matriz normal cuadrada con una eigenbasis ortonormal a cualquier m× × n{displaystyle mtimes n} matriz. Está relacionado con la descomposición polar.

Específicamente, la descomposición de valor singular de m× × n{displaystyle mtimes n} matriz compleja M es una factorización de la forma M=U.. VAlternativa Alternativa ,{displaystyle mathbf {M} =mathbf {USigma V^{*}} Donde U es un m× × m{displaystyle mtimes m} compleja matriz unitaria, .. {displaystyle 'mathbf {Sigma } } es un m× × n{displaystyle mtimes n} matriz diagonal rectangular con números reales no negativos en el diagonal, V es un n× × n{displaystyle ntimes n} compleja matriz unitaria, y VAlternativa Alternativa {displaystyle \mathbf {f}} {f}} {f}}} {f}}} {f}}}}} {f} es la transposición conyugal V. Tal descomposición siempre existe para cualquier matriz compleja. Si M es real, entonces U y V puede ser garantizado para ser matrices ortogonales reales; en tales contextos, el SVD es a menudo denotado U.. VT.{displaystyle \mathbf {USigma V} {fnMithsf}.}

Las entradas diagonales σ σ i=.. ii{displaystyle sigma _{i}= Sigma de .. {displaystyle 'mathbf {Sigma } } están determinados por M y son conocidos como los valores singulares M. El número de valores no individuales es igual al rango de M. Las columnas de U y las columnas de V son llamados vectores de izquierda-singular y vectores de derecha-singular de M, respectivamente. Forman dos conjuntos de bases ortonormales u1,... um y v1,... vn, y si están ordenados para que los valores singulares σ σ i{displaystyle sigma _{i} } con valor cero están todos en las columnas más numeradas (o filas), la descomposición de valor singular se puede escribir como M=.. i=1rσ σ iuiviAlternativa Alternativa ,{displaystyle mathbf {M} =sum - ¿Qué? ¿Qué? ¿Qué? Donde r≤ ≤ min{}m,n}{displaystyle rleq min{m,n} es el rango de M.

El SVD no es único. Siempre es posible elegir la descomposición para que los valores singulares .. ii{displaystyle Sigma _{ii} están en orden descendente. En este caso, .. {displaystyle mathbf {Sigma} (pero no U y V) es determinado por M.

El término a veces se refiere a compacto SVD, una descomposición similar M=U.. VAlternativa Alternativa {displaystyle mathbf {M} =mathbf {USigma V^{*} {f}} en que .. {displaystyle 'mathbf {Sigma } } es diagonal cuadrado de tamaño r× × r{displaystyle rtimes r}, donde r≤ ≤ min{}m,n}{displaystyle rleq min{m,n} es el rango de M, y tiene sólo los valores no cero singulares. En esta variante, U es un m× × r{displaystyle mtimes r} matriz semiunitaria y V{displaystyle 'mathbf {V} } es un n× × r{displaystyle ntimes r} matriz semiunitaria, tal que UAlternativa Alternativa U=VAlternativa Alternativa V=Ir.{fnMitbf {fnMitbf {fnMitbf {fnMicrosoft} =mnMitbf {f}cHFF}

Las aplicaciones matemáticas del SVD incluyen el cálculo de la pseudoinversa, la aproximación de matrices y la determinación del rango, el rango y el espacio nulo de una matriz. El SVD también es extremadamente útil en todas las áreas de la ciencia, la ingeniería y las estadísticas, como el procesamiento de señales, el ajuste de datos por mínimos cuadrados y el control de procesos.

Interpretaciones intuitivas

Rotación, escalado de coordenadas y reflexión

En el caso especial cuando M es un m × m matriz cuadrada real, las matrices U y V⁎ puede ser elegido para ser real m × m Las matrices también. En ese caso, "uniario" es el mismo que "ortogonal". Luego, interpretando tanto matrices unitarias como la matriz diagonal, resumido aquí como A, como una transformación lineal x ↦ Ax del espacio Rm, las matrices U y V⁎ representan rotaciones o reflexión del espacio, mientras .. {displaystyle mathbf {Sigma} representa el escalado de cada coordenadas xi por el factor σi. Así la descomposición SVD descompone cualquier transformación lineal Rm en una composición de tres transformaciones geométricas: una rotación o reflexión (V⁎), seguido de un escalado coordinado (.. {displaystyle mathbf {Sigma}), seguido de otra rotación o reflexión (U).

En particular, si M tiene un determinante positivo, entonces U y V⁎ se pueden elegir para que sean ambas rotaciones con reflejos o ambas rotaciones sin reflejos. Si el determinante es negativo, exactamente uno de ellos tendrá un reflejo. Si el determinante es cero, cada uno puede elegirse independientemente para que sea de cualquier tipo.

Si la matriz M es real pero no cuadrada, m×n con m ل n, se puede interpretar como una transformación lineal de Rn a Rm. Entonces... U y V⁎ puede ser elegido para ser rotaciones/reflexiones de Rm y Rn, respectivamente; y .. {displaystyle mathbf {Sigma}, además de escalar el primero min{}m,n}{displaystyle min{m,n} coordenadas, también extiende el vector con ceros, es decir, elimina las coordenadas de seguimiento, para girar Rn en Rm.

Valores singulares como semiejes de una elipse o elipsoide

Como se muestra en la figura, los valores singulares se pueden interpretar como la magnitud de los semiejes de una elipse en 2D. Este concepto se puede generalizar al espacio euclidiano de n-dimensionales, con los valores singulares de cualquier n × n matriz cuadrada vista como la magnitud del semieje de una n-dimensional. De manera similar, los valores singulares de cualquier matriz m × n pueden verse como la magnitud del semieje de una n-elipsoide dimensional en m -espacio dimensional, por ejemplo como una elipse en un plano 2D (inclinado) en un espacio 3D. Los valores singulares codifican la magnitud del semieje, mientras que los vectores singulares codifican la dirección. Consulte a continuación para obtener más detalles.

Las columnas de U y V son bases ortonormales

Desde U y V⁎ son unitarios, las columnas de cada uno de ellos forman un conjunto de vectores ortonormales, que pueden considerarse vectores de base. La matriz M mapas la base vector Vi al vector de unidad estirada σi Ui. Por la definición de una matriz unitaria, lo mismo es cierto para sus transposos conjugados U⁎ y V, excepto la interpretación geométrica de los valores singulares como estiramientos se pierde. En resumen, las columnas de U, U⁎, V, y V⁎ son bases ortonormales. Cuando M{displaystyle mathbf {M} es una matriz hermitiana positiva, U y V ambos son iguales a la matriz unitaria utilizada para diagonalizar M{displaystyle mathbf {M}. Sin embargo, cuando M{displaystyle mathbf {M} no es positivo-semidefinito y Hermitian pero todavía diagonalizable, su eigendecomposición y descomposición de valor singular son distintos.

Significado geométrico

Debido a que U y V son unitarios, sabemos que las columnas U1,..., Um de U produce una base ortonormal de Km y las columnas V1,..., Vn de V producen una ortonormal base de Kn (con respecto a los productos escalares estándar en estos espacios).

La transformación lineal

- T:: {}Kn→ → Kmx↦ ↦ Mx{displaystyle Tcolon left{begin{aligned}K^{n} Bien.

tiene una descripción particularmente simple con respecto a estas bases ortonormales: tenemos

- T()Vi)=σ σ iUi,i=1,...... ,min()m,n),{displaystyle T(mathbf {V} _{i}=sigma ¿Por qué?

Donde σi es i-la entrada diagonal .. {displaystyle mathbf {Sigma}, y T()Vi) = 0 para i Ø min(m,n).

El contenido geométrico del teorema SVD se puede resumir así: para todo mapa lineal T: Kn → Km uno puede encontrar bases ortonormales de Kn y Km tales que T mapea el i-th vector base de Kn a un múltiplo no negativo de i-ésimo vector base de Km , y envía los vectores base sobrantes a cero. Con respecto a estas bases, el mapa T se representa por tanto mediante una matriz diagonal con entradas diagonales reales no negativas.

Para obtener una idea más visual de los valores singulares y la factorización SVD, al menos cuando se trabaja en espacios vectoriales reales, considere la esfera S de radio uno en Rn. El mapa lineal T asigna esta esfera a un elipsoide en R m. Los valores singulares distintos de cero son simplemente las longitudes de los semiejes de este elipsoide. Especialmente cuando n = m, y todos los valores singulares son distintos y distintos de cero, el SVD del mapa lineal T se puede analizar fácilmente como una sucesión de tres movimientos consecutivos: considere el elipsoide T(S) y específicamente sus ejes; luego considere las instrucciones en Rn enviadas por T en estos ejes. Estas direcciones resultan ser mutuamente ortogonales. Aplique primero una isometría V⁎ enviando estas direcciones a los ejes de coordenadas de Rn. En un segundo movimiento, aplique un endomorfismo D diagonalizado a lo largo de los ejes de coordenadas y alargando o encogiendo en cada dirección, usando las longitudes de los semiejes de T(S) como coeficientes de estiramiento. La composición D ∘ V⁎ luego envía la esfera unitaria a un elipsoide isométrico para T(S). Para definir el tercer y último movimiento, aplique una isometría U a este elipsoide para obtener T(S). Como se puede comprobar fácilmente, la composición U ∘ D ∘ V⁎ coincide con T.

Ejemplo

Considere la matriz 4 × 5

- M=[10002003000000002000]{displaystyle mathbf {M} ={begin{bmatrix}1 tendría0 una relación0 igual2 tarde0 limitada0 implica0 igual0 limitada0 implica0 implica0 implica0 implica2 cada vez0 implica0 coincide0end{bmatrix}}}}}}

Una descomposición en valores singulares de esta matriz viene dada por UΣV⁎

- U=[0− − 100− − 1000000− − 100− − 10].. =[30000050000020000000]VAlternativa Alternativa =[00− − 100− − 0.2000− − 0,80− − 100000010− − 0,80000.2]{displaystyle {begin{aligned}mathbf {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans}0}0}0}0}0}0\\cH0}0}0cH0}0cH0}0BlueBlueb}0cH0cH0cH00} {Sigma {begin{bmatrix}3 ventaja0 limitada0 {Gray}{sqrt}} {5} {fn} {fnMitit} {fnMitit} {fnK}}} {fnK}}}}}}} {0}}}}}}} {0}} âTMa {Red}mathbf {0}color {Gray}{mathit {0}end{bmatrix}}[6pt]mathbf {V} {0} {0} {0} {0}}begin{bmatrix}color {Violet}0color {Violet}0}0color {Violet}1⁄color {Violet}0 {Violet}0color {Violet}0\color}0\color}0\\color}0\ {}} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif}

La matriz de escalado .. {displaystyle mathbf {Sigma} es cero fuera de la diagonal (variedad gris) y un elemento diagonal es cero (rojo negrita, azul claro audaz en modo oscuro). Además, porque las matrices U y V⁎ son unitarios, multiplicando por sus respectivos transpos conjugados produce matrices de identidad, como se muestra a continuación. En este caso, porque U y V⁎ son valorados reales, cada una es una matriz ortogonal.

- UUAlternativa Alternativa =[1000010000100001]=I4VVAlternativa Alternativa =[1000001000001000001000001]=I5{displaystyle {begin{aligned}mathbf {U} mathbf {U} ^{*} {begin{bmatrix}1 tendrían una relación0} tendrían una relación0}=}=m0} {I} _{4}[6pt]mathbf {V}mathbf {V} ^{*} limit={begin{bmatrix}1 punto0 correspond0}0 implica0 implica0 igual0 igual0 igual0 simultáneamente0 implica0 igual0 fr=0 {I} {5}end{aligned}}

Esta descomposición de valor particular no es única. Elegir V{displaystyle mathbf {V} tales que

- VAlternativa Alternativa =[01000001000.20000,80,4000.5− − 0.1− − 0,4000.50.1]{displaystyle mathbf {V} {begin{bmatrix}color} {Violet}0 sensible {}0color}0}0color {clu}0}0}0}0color {color}0}0\\\color {clu}0}0}0}0}0}0}0}mientras se acuestas en el mundo {Magenta}{sqrt {0.8}\\\\\\sqrt {0.4} {color {Orchid}0}0}color {Orchid}0} {Orchid} {Orchid}{sqrt {0.5} {sqrt} {0}}}}}}}} {\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\ {Orchid}-{sqrt {0.1}\\\f} {Purple}-{sqrt {0.4}} {Purple}0 ventajacolor {Purple}0 âcolor {Purple}{sqrt {0.5}}} {Purple}{sqrt {0.1}end{bmatrix}}

también es una descomposición de valor singular válida.

SVD y descomposición espectral

Valores singulares, vectores singulares y su relación con el SVD

Un número real no negativo σ es un Valor singular para M si y sólo si existen vectores de longitud unitaria u{displaystyle mathbf {u} dentro Km y v{displaystyle mathbf {v} dentro Kn tales que

- Mv=σ σ uyMAlternativa Alternativa u=σ σ v.{displaystyle mathbf {Mv} =sigma mathbf {u} ,{text{ and }}mathbf {M} ^{*}mathbf {u} =sigma mathbf {v}

Los vectores u{displaystyle mathbf {u} y v{displaystyle mathbf {v} se llaman izquierda-singular y vectores de derecha-singular para σ, respectivamente.

En cualquier descomposición de valores singulares

- M=U.. VAlternativa Alternativa {displaystyle mathbf {M} =mathbf {U} {boldsymbol {Sigma}Mathbf [V]

las entradas diagonales de .. {displaystyle mathbf {Sigma} son iguales a los valores singulares M. La primera p = min(m, n) columnas de U y V son, respectivamente, vectores de izquierda y derecha-singular para los valores singulares correspondientes. En consecuencia, el teorema anterior implica que:

- An m × n matriz M tiene p valores singulares distintos.

- Siempre es posible encontrar una base unitaria U para Km con un subconjunto de vectores de base que abarcan los vectores izquierdistas de cada valor singular de M.

- Siempre es posible encontrar una base unitaria V para Kn con un subconjunto de vectores de base que abarcan los vectores de derecha-singulares de cada valor singular de M.

Un valor singular para el cual podemos encontrar dos vectores singulares izquierda (o derecha) que son linealmente independientes se llama degenerado. Si u1{displaystyle mathbf {u} ¿Qué? y u2{displaystyle mathbf {u} _{2} son dos vectores izquierdistas que ambos corresponden al valor singular σ, entonces cualquier combinación lineal normalizada de los dos vectores es también un vector izquierdista correspondiente al valor singular σ. La declaración similar es verdadera para los vectores de derecha-singular. El número de vectores independientes de izquierda y derecha-singular coincide, y estos vectores singulares aparecen en las mismas columnas de U y V correspondiente a elementos diagonales .. {displaystyle mathbf {Sigma} todos con el mismo valor σ.

Como excepción, los vectores singulares izquierdo y derecho de valor singular 0 comprenden todos los vectores unitarios en el cokernel y el kernel, respectivamente, de M, que por el teorema de rango-nulidad no puede tener la misma dimensión si m ≠ n. Incluso si todos los valores singulares son distintos de cero, si m > n entonces el cokernel no es trivial, en cuyo caso U se rellena con m − n vectores ortogonales del cokernel. Por el contrario, si m < n, luego V se rellena con n − m vectores ortogonales del núcleo. Sin embargo, si existe el valor singular de 0, las columnas adicionales de U o V ya aparecen como vectores singulares izquierdo o derecho.

Los valores singulares no degenerados siempre tienen vectores singulares izquierdo y derecho únicos, hasta la multiplicación por un factor de fase unitaria ei φ (para el caso real hasta una señal). En consecuencia, si todos los valores singulares de una matriz cuadrada M son no degenerados y distintos de cero, entonces su descomposición de valor singular es única, hasta la multiplicación de una columna de U por un factor de fase unitaria y multiplicación simultánea de la columna correspondiente de V por el mismo factor de unidad de fase. En general, el SVD es único hasta transformaciones unitarias arbitrarias aplicadas uniformemente a los vectores de columna de U y V que abarca los subespacios de cada valor singular, y hasta transformaciones unitarias arbitrarias en vectores de U y V que abarca el kernel y el cokernel, respectivamente, de M.

Relación con la descomposición de valores propios

La descomposición en valores singulares es muy general en el sentido de que se puede aplicar a cualquier matriz m × n, mientras que la descomposición de valores propios solo se puede aplicar a matrices diagonalizables. Sin embargo, las dos descomposiciones están relacionadas.

Dado un SVD de M, como se describe arriba, se cumplen las siguientes dos relaciones:

- MAlternativa Alternativa M=V.. Alternativa Alternativa UAlternativa Alternativa U.. VAlternativa Alternativa =V().. Alternativa Alternativa .. )VAlternativa Alternativa MMAlternativa Alternativa =U.. VAlternativa Alternativa V.. Alternativa Alternativa UAlternativa Alternativa =U().. .. Alternativa Alternativa )UAlternativa Alternativa {displaystyle {begin{aligned}mathbf {fnMicrosoft} {M} {V} {boldsymbol {Sigma} {fnMitbf} Oh, Dios mío. {U} {boldsymbol {Sigma}Mathbf {\fnK} {fnK} {fnK} {fnh} {fnh} {fnh} {f}}} {fn}} {fnK}} {fnK}}} {fnK}}} {fnK}}}} {fnK}}}}} {\f}}}}}}}}}}}}}}}}}}}\\\mmmmmmmmmmmmmmmmmmmmmm}m}mmm}m}m}mmmmmmmmmm}m}mmmmmmmmm}m}m}m}m}m}m}m}mm}m}mmm}m}mm}m}m}m}m} Mathbf {M} mathbf {fnMicrosoft} {U} {boldsymbol {Sigma}Mathbf {fnMicrosoft Sans Serif} {V} {boldsymbol {Sigma} {fnMitbf} {fnMicrosoft} {fnMicrosoft} }{boldsymbol {fnK} {fnMitbf} {f}fnK}f} {fnK}}}

Los lados derechos de estas relaciones describen las descomposiciones de valores propios de los lados izquierdos. Como consecuencia:

- Las columnas de V (vectores fijos) son eigenvectores de M⁎M.

- Las columnas de U (left-singular vectores) son eigenvectores de MM⁎.

- Los elementos no cero de .. {displaystyle mathbf {Sigma} (valores no cero singulares) son las raíces cuadradas de los valores no cero de los M⁎M o MM⁎.

En el caso especial de que M sea una matriz normal, que por definición debe ser cuadrada, el teorema espectral dice que se puede diagonalizar unitariamente utilizando una base de vectores propios, de modo que se puede escribir M = UDU⁎ para una matriz unitaria U y una matriz diagonal D con elementos complejos σi a lo largo de la diagonal. Cuando M es positivo semidefinido, σ i serán números reales no negativos para que la descomposición M = UDU⁎ también es una descomposición de valores singulares. De lo contrario, se puede reformular como SVD moviendo la fase eiφ de cada σi a su correspondiente Vi o Ui. La conexión natural de la SVD con matrices no normales es a través del teorema de descomposición polar: M = SR, donde S = UΣU⁎ es semidefinido positivo y normal, y R = UV⁎ es unitario.

Así, excepto las matrices semidefinidas positivas, la descomposición eigenvalue y el SVD de M, mientras está relacionado, difieren: la descomposición de eigenvalue es M = UDU−1, donde U no es necesariamente unitario y D no es necesariamente positivo semi-definido, mientras que el SVD es M = U ElisabethV⁎, donde .. {displaystyle mathbf {Sigma} es diagonal y positivo semi-definido, y U y V son matrices unitarias que no están necesariamente relacionadas excepto a través de la matriz M. Aunque sólo las matrices cuadradas no defectuosas tienen una descomposición de valor eigen, cualquier m× × n{displaystyle mtimes n} matriz tiene un SVD.

Aplicaciones de la SVD

Pseudoinversa

La descomposición en valores singulares se puede utilizar para calcular la pseudoinversa de una matriz. (Varios autores usan una notación diferente para la pseudoinversa; aquí usamos †). De hecho, la pseudoinversa de la matriz M con descomposición en valores singulares M = UΣV⁎ es

- M† = V .† U⁎

donde Σ† es el pseudoinverso de Σ, que se forma reemplazando cada entrada diagonal distinta de cero por su recíproco y transponiendo la matriz resultante. La pseudoinversa es una forma de resolver problemas de mínimos cuadrados lineales.

Resolver ecuaciones lineales homogéneas

Un conjunto de ecuaciones lineales homogéneas se puede escribir como Ax = 0 para una matriz A y el vector x. Una situación típica es que se conoce A y x se va a determinar cuál satisface la ecuación. Tal x pertenece a A's nulo space y a veces se le llama vector nulo (derecho) de A. El vector x se puede caracterizar como un vector singular derecho correspondiente a un valor singular de A que es cero. Esta observación significa que si A es una matriz cuadrada y no tiene un valor singular que se desvanece, la ecuación no tiene ningún x como solución. También significa que si hay varios valores singulares que desaparecen, cualquier combinación lineal de los vectores singulares rectos correspondientes es una solución válida. Análogamente a la definición de un vector nulo (derecho), un x distinto de cero que satisface x⁎A = 0, con x ⁎ que denota la transposición conjugada de x, se denomina vector nulo izquierdo de A.

Minimización de mínimos cuadrados totales

Un problema de mínimos cuadrados totales busca el vector x que minimiza la norma 2 de un vector Ax bajo la restricción ||x|| = 1. La solución resulta ser el vector singular derecho de A correspondiente al valor singular más pequeño.

Rango, espacio nulo y rango

Otra aplicación del SVD es que proporciona una representación explícita del rango y el espacio nulo de una matriz M. Los vectores singulares a la derecha correspondientes a los valores singulares que desaparecen de M abarcan el espacio nulo de M y los vectores singulares a la izquierda correspondientes a los valores singulares distintos de cero de M abarcan el rango de M. Por ejemplo, en el ejemplo anterior, el espacio nulo está dividido por las dos últimas filas de V⁎ y el rango es abarcado por las tres primeras columnas de U.

Como consecuencia, el rango de M igual al número de valores no singulares cero que es el mismo que el número de elementos diagonales no cero en .. {displaystyle mathbf {Sigma}. En álgebra lineal numérica los valores singulares se pueden utilizar para determinar rango efectivo de una matriz, ya que el error de redondeo puede llevar a valores pequeños pero no cero singulares en una matriz deficiente de rango. Se supone que los valores singulares más allá de una brecha significativa equivalen numéricamente a cero.

Aproximación de matriz de rango bajo

Algunas aplicaciones prácticas necesitan resolver el problema de aproximar una matriz M con otra matriz M~ ~ {displaystyle {fnMicrosoft {fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\\fnMicrosoft {\\\fnMicrosoft {\\fnMicrosoft {\\\\\\\fnMicrosoft {\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\ {M}}, dijo ser truncado, que tiene un rango específico r. En el caso de que la aproximación se base en minimizar la norma Frobenius de la diferencia entre M y M~ ~ {displaystyle {fnMicrosoft {fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\\fnMicrosoft {\\\fnMicrosoft {\\fnMicrosoft {\\\\\\\fnMicrosoft {\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\ {M}} en virtud de la limitación rango ()M~ ~ )=r{displaystyle operatorname {rank} left({tilde {mathbf {M}}right)=r}, resulta que la solución es dada por el SVD de M, a saber

- M~ ~ =U.. ~ ~ VAlternativa Alternativa ,{displaystyle {fnMicrosoft {fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\\fnMicrosoft {\\\fnMicrosoft {\fnMicrosoft {\\\fnMicrosoft {\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\ {fnMicrosoft} {fnMicrosoft} {fnMicrosoft} {fnMicrosoft} {f} {f} {fnMicrosoft} {fnMicrosoft}} {f}fnMitbf} {f} {f} {f}fnMitbf} {f} {f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}\f}f}f}\fnMitbhfnMitbhnMitbh}f}f}fnMitbhf}f}f}f}f}f}fnMitbh}f}f}f}f}\f}fn Mathbf {}

Donde .. ~ ~ {displaystyle {tilde {boldsymbol {Sigma } es la misma matriz .. {displaystyle mathbf {Sigma} excepto que contiene sólo r valores singulares más grandes (los otros valores singulares son reemplazados por cero). Esto es conocido como Eckart-Young theorem, como fue probado por esos dos autores en 1936 (aunque se descubrió que posteriormente se conocía a autores anteriores; véase Stewart 1993).

Modelos separables

El SVD puede ser pensado como descomponer una matriz en una suma ponderada y ordenada de matrices separables. Por separado, queremos decir que una matriz A puede ser escrito como un producto exterior de dos vectores A = u ⊗ v, o, en coordenadas, Aij=uivj{displaystyle A_{ij}=u_{i}v_{j}. Específicamente, la matriz M puede ser descompuesto

- M=.. iAi=.. iσ σ iUi⊗ ⊗ Vi.{displaystyle mathbf {M} =sum _{i}mathbf {A}{i}=sum ¿Qué? ♪♪Mathbf {U} _{i}otimes mathbf {V} _{i}

Aquí Ui y Vi son las i-ésimas columnas de las matrices SVD correspondientes, σi son los valores singulares ordenados, y cada Ai es separable. El SVD se puede utilizar para encontrar la descomposición de un filtro de procesamiento de imágenes en filtros horizontales y verticales separables. Tenga en cuenta que el número de σi distintos de cero es exactamente el rango de la matriz.

Los modelos separables a menudo surgen en los sistemas biológicos, y la factorización SVD es útil para analizar tales sistemas. Por ejemplo, algunas celdas simples del área visual V1' los campos receptivos pueden describirse bien mediante un filtro Gabor en el dominio del espacio multiplicado por una función de modulación en el dominio del tiempo. Por lo tanto, dado un filtro lineal evaluado a través de, por ejemplo, correlación inversa, se pueden reorganizar las dos dimensiones espaciales en una dimensión, produciendo así un filtro bidimensional (espacio, tiempo) que se puede descomponer a través de SVD. La primera columna de U en la factorización SVD es entonces un Gabor mientras que la primera columna de V representa la modulación del tiempo (o viceversa). Entonces se puede definir un índice de separabilidad

- α α =σ σ 12.. iσ σ i2,{displaystyle alpha ={frac {sigma ¿Qué? ¿Qué? ¿Qué?

que es la fracción de la potencia en la matriz M que se explica por la primera matriz separable en la descomposición.

Matriz ortogonal más cercana

Es posible utilizar el SVD de una matriz cuadrada A para determinar la matriz ortogonal O más cercano a A. La proximidad del ajuste se mide por la norma de Frobenius de O − A. La solución es el producto UV⁎. Esto intuitivamente tiene sentido porque una matriz ortogonal tendría la descomposición UIV⁎ donde I es la matriz identidad, de modo que si A = UΣV⁎ entonces el producto A = UV⁎ equivale a reemplazar el valores singulares con unos. De manera equivalente, la solución es la matriz unitaria R = UV⁎ de la Descomposición Polar M = RP = P'R en cualquier orden de estiramiento y rotación, como se describe anteriormente.

Un problema similar, con aplicaciones interesantes en el análisis de formas, es el problema de Procrustes ortogonal, que consiste en encontrar una matriz ortogonal O que más se aproxime asigna A a B. Específicamente,

- O=argminΩ Ω .. AΩ Ω − − B.. Fsujeto aΩ Ω TΩ Ω =I,{displaystyle mathbf {fnMicrosoft Sans Serif} ################################################################################################################################################################################################################################################################ {argmin}fnMithbf {A} {boldsymbol - Mathbf {fnK}f}fnh}fnh}fnhfnfnh}fnfnf}\fnf}fn\fnfnK}f}fnfnf}\fnf}f}fnfnf}f}fnf}f}f}f}f}fn\fn\f}fn\f}f}f}fn\\\f}fnfn\fnfnfn\\\\fn\\\\\fnfnfnfn\fnf}fnfnfnf}\\\\\fnfnfn\\\\\\\\\f}\ {Omega } {textosf {T}{boldsymbol {fnMiga}=fnh}

Donde .. ⋅ ⋅ .. F{displaystylefncdot "Antes" denota la norma Frobenius.

Este problema es equivalente a encontrar la matriz ortogonal más cercana a una matriz dada M = ATB.

El algoritmo de Kabsch

El algoritmo de Kabsch (llamado problema de Wahba en otros campos) usa SVD para calcular la rotación óptima (con respecto a la minimización de mínimos cuadrados) que alineará un conjunto de puntos con un conjunto de puntos correspondiente. Se utiliza, entre otras aplicaciones, para comparar las estructuras de las moléculas.

Procesamiento de señales

La SVD y la pseudoinversa se han aplicado con éxito al procesamiento de señales, procesamiento de imágenes y big data (por ejemplo, en el procesamiento de señales genómicas).

Astrodinámica

En astrodinámica, el SVD y sus variantes se utilizan como una opción para determinar las direcciones de maniobra adecuadas para el diseño de trayectorias de transferencia y el mantenimiento de la posición orbital.

Otros ejemplos

El SVD también se aplica ampliamente al estudio de problemas lineales inversos y es útil en el análisis de métodos de regularización como el de Tikhonov. Es ampliamente utilizado en estadística, donde se relaciona con el análisis de componentes principales y el análisis de correspondencias, y en el procesamiento de señales y el reconocimiento de patrones. También se utiliza en el análisis modal de solo salida, donde las formas de modo no escaladas se pueden determinar a partir de los vectores singulares. Otro uso más es la indexación semántica latente en el procesamiento de texto en lenguaje natural.

En general, la computación numérica que implica sistemas lineales o linealizados, existe una constante universal que caracteriza la regularidad o singularidad de un problema, que es el "número de condición" del sistema κ κ :=σ σ max/σ σ min{displaystyle kappa:=sigma _{text{max}/sigma ¿Qué?. A menudo controla la tasa de error o la tasa de convergencia de un determinado esquema computacional en dichos sistemas.

El SVD también desempeña un papel crucial en el campo de la información cuántica, en un formulario a menudo denominado descomposición Schmidt. A través de ella, los estados de dos sistemas cuánticos están naturalmente descompuestos, proporcionando una condición necesaria y suficiente para que sean enredados: si el rango de la .. {displaystyle mathbf {Sigma} matriz es mayor que una.

Una aplicación de SVD a matrices bastante grandes es en la predicción meteorológica numérica, donde los métodos de Lanczos se utilizan para estimar las pocas perturbaciones de crecimiento más lineal y rápido en la predicción meteorológica numérica central durante un período de tiempo inicial dado; es decir, los vectores singulares correspondientes a los valores singulares más grandes del propagador linealizado para el clima global durante ese intervalo de tiempo. Los vectores singulares de salida en este caso son sistemas meteorológicos completos. Luego, estas perturbaciones se ejecutan a través del modelo no lineal completo para generar un pronóstico de conjunto, lo que permite controlar parte de la incertidumbre que debe permitirse en torno a la predicción central actual.

SVD también se ha aplicado al modelado de orden reducido. El objetivo del modelado de orden reducido es reducir el número de grados de libertad en un sistema complejo que se va a modelar. SVD se combinó con funciones de base radial para interpolar soluciones a problemas tridimensionales de flujo no estacionario.

Curiosamente, SVD se ha utilizado para mejorar el modelado de formas de ondas gravitacionales mediante el interferómetro de ondas gravitacionales basado en tierra aLIGO. SVD puede ayudar a aumentar la precisión y la velocidad de la generación de formas de onda para respaldar las búsquedas de ondas gravitacionales y actualizar dos modelos de formas de onda diferentes.

La descomposición de valores singulares se utiliza en los sistemas de recomendación para predecir las calificaciones de elementos de las personas. Se han desarrollado algoritmos distribuidos con el fin de calcular el SVD en grupos de máquinas comerciales.

Se ha aplicado SVD de rango bajo para la detección de puntos críticos a partir de datos espaciotemporales con aplicación a la detección de brotes de enfermedades. También se ha aplicado una combinación de SVD y SVD de orden superior para la detección de eventos en tiempo real a partir de flujos de datos complejos (datos multivariados con dimensiones de espacio y tiempo) en la vigilancia de enfermedades.

Prueba de existencia

Un valor propio λ de una matriz M se caracteriza por la relación algebraica Mu = λu. Cuando M es hermitiano, también está disponible una caracterización variacional. Sea M un n × n matriz simétrica. Definir

- {}f:Rn→ → Rf:x↦ ↦ xTMx{displaystyle {begin{cases}f:mathbb {R} ^{n}to mathbb {R} \f:mathbf {x} mapsto mathbf {x} ^{textsf {T}mathbf {M} mathbf {x}end{cases}}}

Por el teorema del valor extremo, esta función continua alcanza un máximo en alguna u cuando se restringe a la esfera unitaria {||x|| = 1}. Por el teorema de los multiplicadores de Lagrange, u satisface necesariamente

- Silencio Silencio uTMu− − λ λ ⋅ ⋅ Silencio Silencio uTu=0{displaystyle nabla mathbf {u} ^{textsf {T}mathbf {M} mathbf {u} -lambda cdot nabla mathbf {u} ^{textsf {T}mathbf {u}} {u}} =0}

para algún número real λ. El símbolo nabla, ∇, es el operador del (diferenciación con respecto a x). Usando la simetría de M obtenemos

- Silencio Silencio xTMx− − λ λ ⋅ ⋅ Silencio Silencio xTx=2()M− − λ λ I)x.{displaystyle nabla mathbf {x} ^{textsf {T}mathbf {M} mathbf {x} -lambda cdot nabla mathbf {x} ^{textsf {T}mathbf {x} =2(mathbf {M} -lambda mathbf {I})mathbf {x}

Por lo tanto Mu = λu, entonces u es un vector propio de longitud unitaria de M. Para cada vector propio de longitud unitaria v de M su valor propio es f(v ), por lo que λ es el mayor valor propio de M. El mismo cálculo realizado en el complemento ortogonal de u da el siguiente valor propio más grande y así sucesivamente. El complejo caso hermitiano es similar; hay f(x) = x* M x es una función de valor real de 2n variables reales.

Los valores singulares son similares en el sentido de que se pueden describir algebraicamente oa partir de principios variacionales. Aunque, a diferencia del caso de valores propios, la hermiticidad o simetría de M ya no es necesaria.

Esta sección brinda estos dos argumentos para la existencia de la descomposición en valores singulares.

Basado en el teorema espectral

Vamos M{displaystyle mathbf {M} ser un m × n matriz compleja. Desde MAlternativa Alternativa M{displaystyle mathbf {f} {fnMitbf} {M} es semi-definido positivo y Hermitian, por el teorema espectral, existe un n × n matriz unitaria V{displaystyle mathbf {V} tales que

- VAlternativa Alternativa MAlternativa Alternativa MV=D̄ ̄ =[D000],{displaystyle mathbf {fnMicrosoft} {M} mathbf {V} ={bar {mathbf} }={begin{bmatrix}mathbf {D}end{bmatrix}}}}

Donde D{displaystyle mathbf {D} es diagonal y positivo definido, de dimensión l l × × l l {displaystyle ell times ell }, con l l {displaystyle ell } el número de eigenvalues no cero de MAlternativa Alternativa M{displaystyle mathbf {f} {fnMitbf} {M} (que se puede mostrar para verificar l l ≤ ≤ min()n,m){displaystyle ell leq min(n,m)}). Note que V{displaystyle mathbf {V} está aquí por definición una matriz cuya i{displaystyle i}- la columna es i{displaystyle i}- el eigenvector de MAlternativa Alternativa M{displaystyle mathbf {f} {fnMitbf} {M}, correspondiente al eigenvalue D̄ ̄ ii{displaystyle {bar {Mathbf} }_{ii}. Moreover, the j{displaystyle j}-a columna de V{displaystyle mathbf {V}, para ell }" xmlns="http://www.w3.org/1998/Math/MathML">j■l l {displaystyle j]ell }" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/0561f8fcda12fc3725caaa6cd797040d73578c53" style="vertical-align: -0.671ex; margin-left: -0.027ex; width:5.053ex; height:2.509ex;"/>, es un eigenvector de MAlternativa Alternativa M{displaystyle mathbf {f} {fnMitbf} {M} con eigenvalue D̄ ̄ jj=0{displaystyle {bar {Mathbf} }_{jj}=0}. Esto se puede expresar por escrito V{displaystyle mathbf {V} como V=[V1V2]{displaystyle mathbf {V} ={begin{bmatrix}mathbf [V] _{1} {cHFF} {cHFF}}}, donde las columnas de V1{displaystyle mathbf [V] _{1} y V2{displaystyle mathbf [V] _{2} por lo tanto contienen los eigenvectores de MAlternativa Alternativa M{displaystyle mathbf {f} {fnMitbf} {M} correspondiente a valores no cero y cero eigenvalues, respectivamente. Usando esta reescritura V{displaystyle mathbf {V}, la ecuación se convierte en:

- [V1Alternativa Alternativa V2Alternativa Alternativa ]MAlternativa Alternativa M[V1V2]=[V1Alternativa Alternativa MAlternativa Alternativa MV1V1Alternativa Alternativa MAlternativa Alternativa MV2V2Alternativa Alternativa MAlternativa Alternativa MV1V2Alternativa Alternativa MAlternativa Alternativa MV2]=[D000].{displaystyle {begin{bmatrix}mathbf {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft} [V] _{1} {fnMicrosoft Sans Serif}={begin{bmatrix}mathbf {fnMicrosoft Sans Serif} {fnMicrosoft} {M} mathbf [V] _{1} {fnMicrosoft Sans Serif} {fnMicrosoft} {M} mathbf {V} {cH00}\\\fnMicrosoft} {fnMicrosoft Sans Serif} {fnMicrosoft} {M} mathbf [V] _{1} {fnMicrosoft Sans Serif} {fnMicrosoft} {M} mathbf {fnMicrosoft Sans Serif}={begin{bmatrix}mathbf {D}.

Esto implica que

- V1Alternativa Alternativa MAlternativa Alternativa MV1=D,V2Alternativa Alternativa MAlternativa Alternativa MV2=0.{displaystyle mathbf {fnMicrosoft Sans Serif} {fnMicrosoft} {M} mathbf {V} {fn}=fnMitbf {D}quad mathbf {fnMicrosoft Sans Serif} {fnMicrosoft} {M} mathbf {cHFF} {cHFF}cHFF} {0}

Además, la segunda ecuación implica MV2=0{displaystyle mathbf {M} mathbf {cHFF} {cHFF}cHFF} {0}. Finalmente, el carácter unitario V{displaystyle mathbf {V} traduce, en términos de V1{displaystyle mathbf [V] _{1} y V2{displaystyle mathbf [V] _{2}, en las siguientes condiciones:

- V1Alternativa Alternativa V1=I1,V2Alternativa Alternativa V2=I2,V1V1Alternativa Alternativa +V2V2Alternativa Alternativa =I12,{displaystyle {begin{aligned}mathbf {fnMicrosoft Sans Serif} [V] _{1} {I} _{1},\\\\fnMitbf {fnMicrosoft Sans Serif} [V] _{2} {I} _{2},\\\\fnMitbf {V} {cHFF} {fnMicrosoft} {fnMicrosoft} {cHFF} {cH00}} {cH00}} {cH00}} {cH00}}}

donde los subíndices de las matrices de identidad se utilizan para señalar que son de diferentes dimensiones.

Vamos a definir ahora

- U1=MV1D− − 12.{displaystyle mathbf {U} {fn}=fnMitbf {M} mathbf {V} {cHFF} {fnMicroc} {1} {2}}}}

Entonces,

- U1D12V1Alternativa Alternativa =MV1D− − 12D12V1Alternativa Alternativa =M()I− − V2V2Alternativa Alternativa )=M− − ()MV2)V2Alternativa Alternativa =M,{displaystyle mathbf {U} {cHFF} {fnMicroc} {1}{2}mathbf {fnMicrosoft} {M} mathbf {V} {cHFF} {fnMicroc} Mathbf {1}{2}mathbf {fnMicrosoft} Mathbf [V] _{2}=mathbf {M} {V} _{2})mathbf {fnMicrosoft} {M}

desde entonces MV2=0.{displaystyle mathbf {M} mathbf {cHFF} {cHFF}cHFF} {0} Esto también puede considerarse como consecuencia inmediata del hecho de que MV1V1Alternativa Alternativa =M{displaystyle mathbf {M} mathbf {V} {cHFF} {fnMicrosoft} {M}. Esto equivale a la observación de que si {}vi}i=1l l {displaystyle ##### ########################################################################################################################################################################################################################################################### {fnMicrosoft Sans Serif} es el conjunto de eigenvectores de MAlternativa Alternativa M{displaystyle mathbf {f} {fnMitbf} {M} correspondiente a los eigenvalues no-vanishing {}λ λ i}i=1l l {displaystyle {lambda ¿Qué?, entonces {}Mvi}i=1l l {displaystyle {mathbf {} {boldsymbol {fnMicrosoft Sans Serif} es un conjunto de vectores ortogonales, y {}λ λ i− − 1/2Mvi}i=1l l {displaystyle {lambda ¿Qué? {M} {boldsymbol {fnMicrosoft Sans Serif} es un conjunto (generalmente no completo) ortonormal vectores. Esto coincide con el formalismo de matriz utilizado anteriormente denotando con V1{displaystyle mathbf [V] _{1} la matriz cuyas columnas son {}vi}i=1l l {displaystyle ##### ########################################################################################################################################################################################################################################################### {fnMicrosoft Sans Serif}, con V2{displaystyle mathbf [V] _{2} la matriz cuyas columnas son los eigenvectores de MAlternativa Alternativa M{displaystyle mathbf {f} {fnMitbf} {M} con el eigenvalue desaparecido, y U1{displaystyle mathbf {U} _{1} la matriz cuyas columnas son los vectores {}λ λ i− − 1/2Mvi}i=1l l {displaystyle {lambda ¿Qué? {M} {boldsymbol {fnMicrosoft Sans Serif}.

Vemos que este es casi el resultado deseado, excepto que U1{displaystyle mathbf {U} _{1} y V1{displaystyle mathbf [V] _{1} son en general no unitarios, ya que podrían no ser cuadrados. Sin embargo, sabemos que el número de filas de U1{displaystyle mathbf {U} _{1} no es menor que el número de columnas, ya que las dimensiones de D{displaystyle mathbf {D} no es mayor que m{displaystyle m} y n{displaystyle n}. También, desde

- U1Alternativa Alternativa U1=D− − 12V1Alternativa Alternativa MAlternativa Alternativa MV1D− − 12=D− − 12DD− − 12=I1,{displaystyle mathbf {fnMicrosoft} {U} {fn}=fnMitbf {fnMicroc} {1}{2}mathbf {fnMicrosoft Sans Serif} {fnMicrosoft} {M} mathbf {V} {cHFF} {fnMicroc} {1}{2}=mathbf {fnMicroc} {1}{2}mathbf {D} mathbf {fnMicroc} {1}{2}=mathbf {I_{1}}

las columnas en U1{displaystyle mathbf {U} _{1} son ortonormales y pueden extenderse a una base ortonormal. Esto significa que podemos elegir U2{displaystyle mathbf {fnK} tales que U=[U1U2]{displaystyle mathbf {U} ={begin{bmatrix}mathbf {U}{1} {cHFF} {fnK}}} es unitario.

Para V1 ya tenemos V2 para hacerlo unitario. Ahora, define

- .. =[[D12000]0],{displaystyle {boldsymbol {Sigma {begin{begin{begin{bmatrix}mathbf {fnMicroc} {1}{2} {0}end{bmatrix}end{bmatrix}}}}}

donde hay cero filas adicionales o eliminado para hacer el número de cero filas igual al número de columnas de U2, y por consiguiente las dimensiones generales .. {displaystyle {boldsymbol {Sigma } iguales m× × n{displaystyle mtimes n}. Entonces...

- [U1U2][[D12000]0][V1V2]Alternativa Alternativa =[U1U2][D12V1Alternativa Alternativa 0]=U1D12V1Alternativa Alternativa =M,{displaystyle {begin{bmatrix}mathbf {fn} {fn} {fnK} {fn}}} {begin{bmatrix}{begin{bmatrix}m}mtbf {f} {fn}} {fnf}} {fncip}} {f}}fn}}}}}} {f}f}}}}}}}}}}}}}}}}}}}}}}f} {f} {f}}f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}p}p}}}}}}p}p}p}p}p}f}f}p}p}f}f}} {1}{2} {0}end{bmatrix}end{bmatrix}{begin{bmatrix}mathbf [V] _{1} {fnMicrosoft Sans Serif} {begin{bmatrix}mathbf {fnK} {f} {fnK} {fn}}} {begin{bmatrix}mathbf {fnMicroc} {1}{2}mathbf {cHFF}=Mathbf {U} {cHFF} {fnMicroc} {1}{2}mathbf {fnMicrosoft} {M}

cuál es el resultado deseado:

- M=U.. VAlternativa Alternativa .{displaystyle mathbf {M} =mathbf {U} {boldsymbol Mathbf.

Observe que el argumento podría comenzar con la diagonalización de MM⁎ en lugar de M⁎M (Esto muestra directamente que MM ⁎ y M⁎M tienen el mismo no -valores propios cero).

Basado en caracterización variacional

Los valores singulares también se pueden caracterizar como los máximos de u TMv , considerado como una función de u y v, sobre subespacios particulares. Los vectores singulares son los valores de u y v donde estos se alcanzan los máximos.

Vamos M denote an m × n matriz con entradas reales. Vamos Sk−1 ser la unidad ()k− − 1){displaystyle (k-1)}- Esfera en Rk{displaystyle mathbb {R} {cH00}, y definir σ σ ()u,v)=uTMv,u▪ ▪ Sm− − 1,v▪ ▪ Sn− − 1.{displaystyle sigma (mathbf {u}mathbf {v}=mathbf {u} ^{textsf {T}mathbf {M}mathbf {v}mathbf {u} in S^{m-1},mathbf {v} in S^{n-1}}}

Considere la función σ restringida a S<sup m−1 × Sn−1. Dado que tanto Sm−1 como Sn−1 son conjuntos compactos, su producto también es compacto. Además, dado que σ es continuo, alcanza un valor máximo para al menos un par de vectores u ∈ Sm−1 y v ∈ Sn−1. Este valor mayor se denota σ1 y los vectores correspondientes se denotan u1 y v1. Dado que σ1 es el mayor valor de σ (u, v) debe ser no negativo. Si fuera negativo, cambiando el signo de u1 o v1 lo haría positivo y por lo tanto más grande.

Declaración. u1, v1 son vectores singulares izquierdo y derecho de M con el valor singular correspondiente σ 1.

Prueba. Similar al caso de los valores propios, por suposición, los dos vectores satisfacen la ecuación del multiplicador de Lagrange:

- Silencio Silencio σ σ =Silencio Silencio uTMv− − λ λ 1⋅ ⋅ Silencio Silencio uTu− − λ λ 2⋅ ⋅ Silencio Silencio vTv{displaystyle nabla sigma =nabla mathbf {u} ^{textsf {T}mathbf {M} mathbf {v} -lambda _{1}cdot nablaf {u} ^{textsf {T}Mathbf {u} -lambda _{2}cdot nabla mathbf {v} {textsf {T}mathbf {v}

Después de un poco de álgebra, esto se convierte en

- Mv1=2λ λ 1u1+0MTu1=0+2λ λ 2v1{displaystyle {begin{aligned}mathbf {M} mathbf {v} ################################################################################################################################################################################################################################################################ ¿Qué? - ¿Qué? {M} {textosf {T}Mathbf {u} _{1}=0+2lambda _{2}mathbf {v} _{1}end{aligned}

Multiplicando la primera ecuación de izquierda por u1T{displaystyle mathbf {u} ¿Qué? y la segunda ecuación de izquierda por v1T{displaystyle mathbf {v} ¿Qué? y tomar SilenciouTENIDO ANTERIOR: SilenciovANTERITORIO en cuenta

- σ σ 1=2λ λ 1=2λ λ 2.{displaystyle sigma ###{1}=2lambda ###{1}=2lambda _{2}.

Reemplazando esto en el par de ecuaciones de arriba, tenemos

- Mv1=σ σ 1u1MTu1=σ σ 1v1{displaystyle {begin{aligned}mathbf {M} mathbf {v} - ¿Qué? ¿Qué? ¿Qué? {M} {textosf {T}Mathbf {u} - ¿Qué? ¿Qué?

Esto prueba la afirmación.

Se pueden encontrar más vectores singulares y valores singulares maximizando σ(u, v) sobre u, v normalizados que son ortogonales a u 1 y v1, respectivamente.

El paso de real a complejo es similar al caso del valor propio.

Calcular la SVD

(feminine)La descomposición en valores singulares se puede calcular usando las siguientes observaciones:

- Los vectores izquierdistas de M son un conjunto de eigenvectores ortonormales de MM⁎.

- Los vectores de línea derecha de M son un conjunto de eigenvectores ortonormales de M⁎M.

- Los valores no cero singulares de M (encontrado en las entradas diagonales de .. {displaystyle mathbf {Sigma}) son las raíces cuadradas de los eigenvalues no cero de ambos M⁎M y MM⁎.

Enfoque numérico

La SVD de una matriz M normalmente se calcula mediante un procedimiento de dos pasos. En el primer paso, la matriz se reduce a una matriz bidiagonal. Esto toma O(mn2) operaciones de punto flotante (flop), suponiendo que m ≥ n. El segundo paso es calcular la SVD de la matriz bidiagonal. Este paso solo se puede realizar con un método iterativo (como con los algoritmos de valores propios). Sin embargo, en la práctica es suficiente calcular el SVD hasta cierta precisión, como la máquina épsilon. Si esta precisión se considera constante, entonces el segundo paso toma O(n) iteraciones, cada una de las cuales cuesta O(n) fracasos. Por lo tanto, el primer paso es más costoso y el costo total es O(mn2) fracasos (Trefethen & Bau III 1997, Lecture 31).

El primer paso se puede realizar utilizando los reflejos del amo de casa por un costo de 4mn2 − 4n3/3 flops, suponiendo que solo se necesitan los valores singulares y no los vectores singulares. Si m es mucho mayor que n entonces es ventajoso reducir primero la matriz M a una matriz triangular con la descomposición QR y luego use reflexiones de Houseer para reducir aún más la matriz a la forma bidiagonal; el costo combinado es 2mn2 + 2n3 flops (Trethethen & Bau III 1997, Lecture 31).

El segundo paso se puede realizar mediante una variante del algoritmo QR para el cálculo de valores propios, que fue descrito por primera vez por Golub & Kanan (1965). La subrutina DBDSQR de LAPACK implementa este método iterativo, con algunas modificaciones para cubrir el caso donde los valores singulares son muy pequeños (Demmel & Kahan 1990). Junto con un primer paso que utiliza reflexiones de Householder y, si corresponde, descomposición QR, esto forma la rutina DGESVD para el cálculo de la descomposición de valor singular.

El mismo algoritmo se implementa en la Biblioteca científica GNU (GSL). El GSL también ofrece un método alternativo que utiliza una ortogonalización de Jacobi unilateral en el paso 2 (GSL Team 2007). Este método calcula la SVD de la matriz bidiagonal resolviendo una secuencia de problemas SVD de 2 × 2, similar a cómo el algoritmo de valores propios de Jacobi resuelve una secuencia de métodos de valores propios de 2 × 2 (Golub & Van Loan 1996, §8.6.3). Otro método más para el paso 2 utiliza la idea de algoritmos de valores propios de divide y vencerás (Trefethen & Bau III 1997, Lecture 31).

Hay una forma alternativa que no usa explícitamente la descomposición de valores propios. Por lo general, el problema de valor singular de una matriz M se convierte en un problema de valor propio simétrico equivalente como M M ⁎, M⁎M, o

- [OMMAlternativa Alternativa O].{displaystyle {begin{bmatrix}mathbf {O} > Mathbf {M} \Mathbf {fnMicrosoft} {O} end{bmatrix}}}

Los enfoques que utilizan descomposiciones de valores propios se basan en el algoritmo QR, que está bien desarrollado para ser estable y rápido. Tenga en cuenta que los valores singulares son reales y que los vectores singulares derecho e izquierdo no son necesarios para formar transformaciones de similitud. Se puede alternar iterativamente entre la descomposición QR y la descomposición LQ para encontrar las matrices hermitianas diagonales reales. La descomposición QR da M ⇒ Q R y la descomposición LQ de R da R ⇒ L P⁎. Por lo tanto, en cada iteración, tenemos M ⇒ Q L P⁎, actualizar M ⇐ L y repite las ortogonalizaciones. Eventualmente, esta iteración entre la descomposición QR y la descomposición LQ produce matrices singulares unitarias izquierda y derecha. Este enfoque no se puede acelerar fácilmente, como lo hace el algoritmo QR con cambios espectrales o deflación. Esto se debe a que el método de cambio no se define fácilmente sin usar transformaciones de similitud. Sin embargo, este enfoque iterativo es muy simple de implementar, por lo que es una buena opción cuando la velocidad no importa. Este método también proporciona información sobre cómo las transformaciones puramente ortogonales/unitarias pueden obtener la SVD.

Resultado analítico de 2 × 2 SVD

Los valores singulares de una matriz 2 × 2 se pueden encontrar analíticamente. Que la matriz sea M=z0I+z1σ σ 1+z2σ σ 2+z3σ σ 3{displaystyle mathbf {M} =z_{0}mathbf {I} +z_{1}sigma _{1}+z_{2}sigma _{2}+z_{3}sigma ¿Qué?

Donde zi▪ ▪ C{displaystyle z_{i}in mathbb {C} son números complejos que parametizan la matriz, I es la matriz de identidad, y σ σ i{displaystyle sigma _{i} denota las matrices Pauli. Entonces sus dos valores singulares son dados por

- σ σ ± ± =Silencioz0Silencio2+Silencioz1Silencio2+Silencioz2Silencio2+Silencioz3Silencio2± ± ()Silencioz0Silencio2+Silencioz1Silencio2+Silencioz2Silencio2+Silencioz3Silencio2)2− − Silencioz02− − z12− − z22− − z32Silencio2=Silencioz0Silencio2+Silencioz1Silencio2+Silencioz2Silencio2+Silencioz3Silencio2± ± 2()Re z0z1Alternativa Alternativa )2+()Re z0z2Alternativa Alternativa )2+()Re z0z3Alternativa Alternativa )2+()Im z1z2Alternativa Alternativa )2+()Im z2z3Alternativa Alternativa )2+()Im z3z1Alternativa Alternativa )2{displaystyle {begin{aligned}sigma ################################################################################################################################################################################################################################################################ Oh, Dios mío. {fnK} {f}fnK}f}fnK}f}fnh}fnK}f}f}cH30}}cfnK}fn9}fnK}cH9}ccH0} {c}c}c}c}c}}c}c}c}c}c}}}}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}c}}}c}c} Oh, Dios mío. 2{sqrt {fnMiembro de operador {Re} z_{0}z_{1}}{2}+(operatorname {Re} z_{0}z_{2}{*})^{2}+(operatorname {Re} z_{0}z_{3}{*})^{2}+(operatorname {Im} z_{1}z_{2}{*})^{2}+(operatorname {Im} z_{2}z_{3}{*})^{2}+(operatorname {Im} {fnK}} {fnK}}} {fnK}}}}} {fnK}}}}}} {f}}}}}} {f}}}}}} {fn}}}}} {fn}}}}}

SVD reducidos

En las aplicaciones, es bastante inusual que se requiera el SVD completo, incluida una descomposición unitaria completa del espacio nulo de la matriz. En cambio, a menudo es suficiente (así como más rápido y más económico para el almacenamiento) calcular una versión reducida del SVD. Se puede distinguir lo siguiente para una matriz m×n M de rango r:

SVD fino

El SVD delgado, o de tamaño económico, de una matriz M viene dado por

- M=Uk.. kVkAlternativa Alternativa ,{displaystyle mathbf {M} =mathbf {U}{k}{boldsymbol {Sigma ♪♪♪♪♪Mathbf {fnMicrosoft Sans Serif}

dónde

- k=min ()m,n){displaystyle k=operatorname {min} (m,n)},

las matrices Uk y Vk contienen solo las primeras columnas k de U y V, y Σk contiene solo los primeros k valores singulares de Σ. La matriz Uk es entonces m×k, Σk es k×k diagonal, y Vk* es k×n.

El SVD delgado usa significativamente menos espacio y tiempo de cálculo si k ≪ max(m, n). La primera etapa de su cálculo suele ser una descomposición QR de M, que puede hacer que el cálculo sea significativamente más rápido en este caso.

SVD compacta

(feminine)- M=Ur.. rVrAlternativa Alternativa {displaystyle mathbf {M} =mathbf {U}{r}{boldsymbol {Sigma ♪♪♪♪ {fnMicrosoft Sans Serif}

Solo los vectores columna r de U y los vectores fila r de V* correspondientes a los vectores no Se calculan los valores cero singulares Σr. Los vectores restantes de U y V* no se calculan. Esto es más rápido y económico que el SVD delgado si r ≪ min(m, n). La matriz Ur es entonces m×r, Σr es r×r diagonal, y Vr* es r×n.

SVD truncada

(feminine)En muchas aplicaciones el número r de los valores no cero singulares es grande haciendo incluso el compacto SVD poco práctico para calcular. En tales casos, los valores singulares más pequeños pueden necesitar ser truncados sólo para calcular t≪r valores no singulares. El SVD truncado ya no es una descomposición exacta de la matriz original M, pero más bien proporciona la aproximación óptima de la matriz de bajo rango M~ ~ {displaystyle {fnMicrosoft {fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\\fnMicrosoft {\\\fnMicrosoft {\\fnMicrosoft {\\\\\\\fnMicrosoft {\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\ {M}} por cualquier matriz de un rango fijot

- M~ ~ =Ut.. tVtAlternativa Alternativa {displaystyle {fnMicrosoft {fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\\fnMicrosoft {\\\fnMicrosoft {\fnMicrosoft {\\\fnMicrosoft {\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\ {M}=mathbf {U}{t}{}{boldsymbol {Sigma ♪♪♪♪ {fnMicrosoft Sans Serif},

donde la matriz Ut es m×t, Σ<sub t es t×t diagonal, y Vt* es t×n. Solo los vectores columna t de U y los vectores fila t de V* correspondientes a la t se calculan los valores singulares más grandes Σt. Esto puede ser mucho más rápido y económico que el SVD compacto si t≪r, pero requiere un conjunto de herramientas completamente diferente de solucionadores numéricos.

En aplicaciones que requieren una aproximación a la inversa de Moore-Penrose de la matriz M, son de interés los valores singulares más pequeños de M, que son más difíciles de calcular en comparación con los más grandes.

La SVD truncada se emplea en la indexación semántica latente.

Normas

Normas de Ky Fan

La suma de los k valores singulares más grandes de M es una norma matricial, la norma Ky Fan k de M .

La primera de las normas Ky Fan, la norma Ky Fan 1, es la misma que la norma del operador de M como operador lineal con respecto a las normas euclidianas de Km y Kn. En otras palabras, la norma Ky Fan 1 es la norma del operador inducida por el producto interno euclidiano ℓ2 estándar. Por esta razón, también se le llama operador 2-norma. Uno puede verificar fácilmente la relación entre la norma Ky Fan 1 y los valores singulares. Es cierto en general, para un operador acotado M en espacios de Hilbert (posiblemente de dimensión infinita)

- .. M.. =.. MAlternativa Alternativa M.. 12{displaystylef}mathbf {f}fnfnfnfnh} {M} {fnMicroc} {1}{2}}}

Pero, en el caso de la matriz, (M* M)1/2 es una matriz normal, entonces ||M* M ||1/2 es el mayor valor propio de (M* M)1/2, es decir, el mayor valor singular de M .

La última de las normas de Ky Fan, la suma de todos los valores singulares, es la norma traza (también conocida como la 'norma nuclear'), definida por ||M || = Tr[(M* M)1/2] (los valores propios de M* M son los cuadrados de los valores singulares).

Norma de Hilbert-Schmidt

Los valores singulares están relacionados con otra norma sobre el espacio de operadores. Considere el producto interno de Hilbert-Schmidt en las matrices n × n, definidas por

- .. M,N.. =tr ()NAlternativa Alternativa M).{displaystyle langle mathbf {M}mathbf {N} rangle =operatorname {tr} left(mathbf {N} ^{*}mathbf {M} right). }

Entonces la norma inducida es

- .. M.. =.. M,M.. =tr ()MAlternativa Alternativa M).{displaystylefnMitbf} "Primathbf" {M}Mathbf {M} rangle }={sqrt {operatorname {tr} left(mathbf {M} }mathbf {M}}}}

Dado que la traza es invariante bajo equivalencia unitaria, esto muestra

- .. M.. =.. iσ σ i2{displaystylefnMitbf} "Principal" ¿Qué? ¿Qué?

donde σi son los valores singulares de M. Esto se denomina norma Frobenius, norma Schatten 2 o norma Hilbert-Schmidt de M. El cálculo directo muestra que la norma de Frobenius de M = (mij) coincide con:

- .. ijSilenciomijSilencio2.{displaystyle {sqrt {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {f {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {f {fnMicrosoft {f}fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {f}f}fnMicrosoft {fnMicrosoft {f}f}f}\f}fnfnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {f}fnMicrosoft {fnMicrosoft {\fnf}\fnMicrosoft {f}fn - ¿Qué?

Además, la norma de Frobenius y la norma de trazas (la norma nuclear) son casos especiales de la norma de Schatten.

Variaciones y generalizaciones

Representación de modo-k

M=USVT{displaystyle M=USV^{textsf {T}} puede ser representado mediante la multiplicación de modo-k de matriz S{displaystyle S. aplicación × × 1U{displaystyle times _{1}U} entonces × × 2V{displaystyle times _{2}V} sobre el resultado; M=S× × 1U× × 2V{displaystyle M=Stimes ¿Qué?.

Tensor SVD

Existen dos tipos de descomposiciones tensoriales, que generalizan la SVD a arreglos multidireccionales. Uno de ellos descompone un tensor en una suma de tensores de rango 1, lo que se denomina descomposición de rango de tensores. El segundo tipo de descomposición calcula los subespacios ortonormales asociados con los diferentes factores que aparecen en el producto tensorial de espacios vectoriales en los que vive el tensor. Esta descomposición se denomina en la literatura SVD de orden superior (HOSVD) o Tucker3/TuckerM. Además, el análisis de componentes principales multilineal en el aprendizaje subespacial multilineal implica las mismas operaciones matemáticas que la descomposición de Tucker, y se utiliza en un contexto diferente de reducción de dimensionalidad.

SVD de escala invariable

Los valores singulares de una matriz A están definidos de forma única y son invariantes con respecto a las transformaciones unitarias izquierda y/o derecha de A. En otras palabras, los valores singulares de UAV, para U y V unitarios, son iguales a los valores singulares de A. Esta es una propiedad importante para aplicaciones en las que es necesario preservar las distancias euclidianas y la invariancia con respecto a las rotaciones.

La SVD invariante de escala, o SI-SVD, es análoga a la SVD convencional excepto que sus valores singulares determinados de forma única son invariantes con respecto a las transformaciones diagonales de A. En otras palabras, los valores singulares de DAE, para matrices diagonales invertibles D y E, son iguales a los valores singulares de A . Esta es una propiedad importante para las aplicaciones en las que se necesita invariancia en la elección de unidades en las variables (por ejemplo, unidades métricas frente a unidades imperiales).

SVD de funciones de orden superior (HOSVD)

La transformación del modelo de producto tensorial (TP) reconstruye numéricamente el HOSVD de las funciones. Para más detalles por favor visite:

- Transformación del modelo de producto de tensor

- Forma canónica basada en HOSVD de funciones TP y modelos qLPV

- Transformación modelo TP en la teoría del control

Operadores acotados en espacios de Hilbert

La factorización M = UΣV⁎ se puede extender a un operador acotado M en un espacio separable de Hilbert H. Es decir, para cualquier operador acotado M, existe una isometría parcial U, una V unitaria, un espacio de medida (X, μ), y una f medible no negativa tal que

- M=UTfVAlternativa Alternativa {displaystyle mathbf {M} =mathbf {U} T_{f}mathbf [V]

Donde Tf{displaystyle T_{f} es la multiplicación por f encendido L2()X, μ).

Esto se puede demostrar imitando el argumento algebraico lineal para el caso matricial anterior. VTfV* es la única raíz cuadrada positiva de M*M, como lo da el cálculo funcional de Borel para operadores autoadjuntos. La razón por la cual U no necesita ser unitario es porque, a diferencia del caso de dimensión finita, dada una isometría U1 con kernel no trivial, un adecuado U2 no se puede encontrar tal que

- [U1U2]{displaystyle {begin{bmatrix}U_{1}U_{2}end{bmatrix}}}

es un operador unitario.

En cuanto a las matrices, la factorización de valores singulares es equivalente a la descomposición polar para operadores: simplemente podemos escribir

- M=UVAlternativa Alternativa ⋅ ⋅ VTfVAlternativa Alternativa {displaystyle mathbf {M} =mathbf {U} mathbf {V}cdot mathbf {V} T_{f}mathbf [V]

y observe que U V* sigue siendo una isometría parcial mientras que VTfV* es positivo.

Valores singulares y operadores compactos

La noción de valores singulares y vectores singulares izquierdo/derecho se puede extender al operador compacto en el espacio de Hilbert, ya que tienen un espectro discreto. Si T es compacto, cada λ en su espectro es un valor propio. Además, un operador autoadjunto compacto puede ser diagonalizado por sus vectores propios. Si M es compacto, también lo es M⁎ M. Aplicando el resultado de la diagonalización, la imagen unitaria de su raíz cuadrada positiva Tf tiene un conjunto de ortonormales vectores propios {ei} correspondientes a valores propios estrictamente positivos {σi}. Para cualquier ψ ∈ H,

- M↑ ↑ =UTfVAlternativa Alternativa ↑ ↑ =.. i.UTfVAlternativa Alternativa ↑ ↑ ,Uei.Uei=.. iσ σ i.↑ ↑ ,Vei.Uei,{displaystyle mathbf {M} psi =mathbf {U} T_{f}mathbf {fnMicrosoft Sans Serif} = ¿Por qué? {fnMicrosoft} {U} e_{i}rangle mathbf {U} e_{i}=sum ¿Qué? ¿Por qué? {V} e_{i}rangle mathbf {U} e_{i}

donde la serie converge en la topología normal en H. Observe cómo esto se parece a la expresión del caso de dimensión finita. σi son los valores singulares de M . {Uei} (resp. { Vei}) pueden considerarse los vectores del singular a la izquierda (resp. al singular a la derecha) de M.

Los operadores compactos en un espacio de Hilbert son el cierre de operadores de rango finito en la topología de operadores uniformes. La expresión de la serie anterior da una representación explícita de este tipo. Una consecuencia inmediata de esto es:

- Teorema. M es compacto si y sólo si M⁎M es compacto.

Historia

La descomposición en valores singulares fue desarrollada originalmente por geómetras diferenciales, que deseaban determinar si una forma bilineal real podía igualarse a otra mediante transformaciones ortogonales independientes de los dos espacios sobre los que actúa. Eugenio Beltrami y Camille Jordan descubrieron de forma independiente, en 1873 y 1874 respectivamente, que los valores singulares de las formas bilineales, representados como una matriz, forman un conjunto completo de invariantes para formas bilineales bajo sustituciones ortogonales. James Joseph Sylvester también llegó a la descomposición en valores singulares para matrices cuadradas reales en 1889, aparentemente independientemente tanto de Beltrami como de Jordan. Sylvester llamó a los valores singulares los multiplicadores canónicos de la matriz A. El cuarto matemático en descubrir la descomposición en valores singulares de forma independiente es Autonne en 1915, quien llegó a ella a través de la descomposición polar. La primera prueba de la descomposición en valores singulares para matrices rectangulares y complejas parece ser de Carl Eckart y Gale J. Young en 1936; lo vieron como una generalización de la transformación del eje principal para matrices hermitianas.

En 1907, Erhard Schmidt definió un analógico de valores singulares para los operadores integrales (que son compactos, bajo algunas suposiciones técnicas débiles); parece que no tenía conocimiento del trabajo paralelo sobre valores singulares de matrices finitas. Esta teoría fue desarrollada por Émile Picard en 1910, quien es el primero en llamar a los números σ σ k{displaystyle sigma _{k} Valores singulares (o en francés, valeurs singulières).

Los métodos prácticos para calcular el SVD se remontan a Kogbetliantz en 1954-1955 y Hestenes en 1958, y se asemejan mucho al algoritmo de valor propio de Jacobi, que usa rotaciones planas o rotaciones de Givens. Sin embargo, estos fueron reemplazados por el método de Gene Golub y William Kahan publicado en 1965, que utiliza transformaciones o reflejos de Householder. En 1970, Golub y Christian Reinsch publicaron una variante del algoritmo Golub/Kahan que sigue siendo el más utilizado en la actualidad.

Contenido relacionado

Esteban Cook

Análisis reales

Homomorfismo de grupo

![{displaystyle {begin{aligned}mathbf {U} &={begin{bmatrix}color {Green}0&color {Blue}-1&color {Cyan}0&color {Emerald}0\color {Green}-1&color {Blue}0&color {Cyan}0&color {Emerald}0\color {Green}0&color {Blue}0&color {Cyan}0&color {Emerald}-1\color {Green}0&color {Blue}0&color {Cyan}-1&color {Emerald}0end{bmatrix}}\[6pt]{boldsymbol {Sigma }}&={begin{bmatrix}3&0&0&0&color {Gray}{mathit {0}}\0&{sqrt {5}}&0&0&color {Gray}{mathit {0}}\0&0&2&0&color {Gray}{mathit {0}}\0&0&0&color {Red}mathbf {0} &color {Gray}{mathit {0}}end{bmatrix}}\[6pt]mathbf {V} ^{*}&={begin{bmatrix}color {Violet}0&color {Violet}0&color {Violet}-1&color {Violet}0&color {Violet}0\color {Plum}-{sqrt {0.2}}&color {Plum}0&color {Plum}0&color {Plum}0&color {Plum}-{sqrt {0.8}}\color {Magenta}0&color {Magenta}-1&color {Magenta}0&color {Magenta}0&color {Magenta}0\color {Orchid}0&color {Orchid}0&color {Orchid}0&color {Orchid}1&color {Orchid}0\color {Purple}-{sqrt {0.8}}&color {Purple}0&color {Purple}0&color {Purple}0&color {Purple}{sqrt {0.2}}end{bmatrix}}end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/452662baa2e3386f81d938a5c93828dbcbd095df)

![{displaystyle {begin{aligned}mathbf {U} mathbf {U} ^{*}&={begin{bmatrix}1&0&0&0\0&1&0&0\0&0&1&0\0&0&0&1end{bmatrix}}=mathbf {I} _{4}\[6pt]mathbf {V} mathbf {V} ^{*}&={begin{bmatrix}1&0&0&0&0\0&1&0&0&0\0&0&1&0&0\0&0&0&1&0\0&0&0&0&1end{bmatrix}}=mathbf {I} _{5}end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/47909bf34c8f6bf555462da282152e537800e0b2)