Teoría de control

Teoría de control es un campo de las matemáticas que se ocupa del control de sistemas dinámicos en procesos y máquinas de ingeniería. El objetivo es desarrollar un modelo o algoritmo que gobierne la aplicación de las entradas del sistema para conducir el sistema a un estado deseado, mientras se minimiza cualquier retraso, sobreimpulso o constante -estado de error y asegurando un nivel de estabilidad de control; a menudo con el objetivo de lograr un grado de optimización.

Para hacer esto, se requiere un controlador con el comportamiento correctivo requerido. Este controlador monitorea la variable de proceso controlada (PV) y la compara con la referencia o el punto de ajuste (SP). La diferencia entre el valor real y el deseado de la variable de proceso, llamada señal de error, o error SP-PV, se aplica como retroalimentación para generar una acción de control para llevar la variable de proceso controlada al mismo valor que el punto de ajuste Otros aspectos que también se estudian son la controlabilidad y la observabilidad. La teoría de control se utiliza en la ingeniería de sistemas de control para diseñar la automatización que ha revolucionado la fabricación, la aviación, las comunicaciones y otras industrias, y ha creado nuevos campos como la robótica.

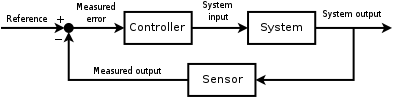

Por lo general, se hace un uso extensivo de un estilo de diagrama conocido como diagrama de bloques. En él, la función de transferencia, también conocida como función de sistema o función de red, es un modelo matemático de la relación entre la entrada y la salida basado en las ecuaciones diferenciales que describen el sistema.

La teoría del control data del siglo XIX, cuando James Clerk Maxwell describió por primera vez la base teórica para el funcionamiento de los gobernadores. La teoría del control fue avanzada por Edward Routh en 1874, Charles Sturm y en 1895 Adolf Hurwitz, quienes contribuyeron al establecimiento de los criterios de estabilidad del control; ya partir de 1922, el desarrollo de la teoría de control PID por Nicolas Minorsky. Aunque una de las principales aplicaciones de la teoría del control matemático se encuentra en la ingeniería de sistemas de control, que se ocupa del diseño de sistemas de control de procesos para la industria, otras aplicaciones van mucho más allá. Como teoría general de los sistemas de retroalimentación, la teoría de control es útil dondequiera que ocurra la retroalimentación; por lo tanto, la teoría de control también tiene aplicaciones en las ciencias de la vida, la ingeniería informática, la sociología y la investigación de operaciones.

Historia

Aunque los sistemas de control de varios tipos se remontan a la antigüedad, un análisis más formal del campo comenzó con un análisis dinámico del gobernador centrífugo, realizado por el físico James Clerk Maxwell en 1868, titulado Sobre los gobernadores. Ya se usaba un gobernador centrífugo para regular la velocidad de los molinos de viento. Maxwell describió y analizó el fenómeno de la autooscilación, en el que los retrasos en el sistema pueden provocar una sobrecompensación y un comportamiento inestable. Esto generó un gran interés en el tema, durante el cual el compañero de clase de Maxwell, Edward John Routh, resumió los resultados de Maxwell para la clase general de sistemas lineales. Independientemente, Adolf Hurwitz analizó la estabilidad del sistema utilizando ecuaciones diferenciales en 1877, lo que resultó en lo que ahora se conoce como el teorema de Routh-Hurwitz.

Una aplicación notable del control dinámico fue en el área de vuelo tripulado. Los hermanos Wright realizaron sus primeros vuelos de prueba exitosos el 17 de diciembre de 1903 y se distinguieron por su capacidad para controlar sus vuelos durante períodos sustanciales (más que la capacidad de producir sustentación desde un perfil aerodinámico, que se conocía). Era necesario un control continuo y confiable del avión para vuelos que duraban más de unos pocos segundos.

Para la Segunda Guerra Mundial, la teoría del control se estaba convirtiendo en un área importante de investigación. Irmgard Flügge-Lotz desarrolló la teoría de los sistemas de control automático discontinuos y aplicó el principio bang-bang al desarrollo de equipos de control de vuelo automático para aeronaves. Otras áreas de aplicación para controles discontinuos incluyeron sistemas de control de incendios, sistemas de guía y electrónica.

A veces, se utilizan métodos mecánicos para mejorar la estabilidad de los sistemas. Por ejemplo, los estabilizadores de barcos son aletas montadas debajo de la línea de flotación y que emergen lateralmente. En los barcos contemporáneos, pueden ser aletas activas controladas giroscópicamente, que tienen la capacidad de cambiar su ángulo de ataque para contrarrestar el balanceo causado por el viento o las olas que actúan sobre el barco.

La carrera espacial también dependía del control preciso de las naves espaciales, y la teoría del control también se ha utilizado cada vez más en campos como la economía y la inteligencia artificial. Aquí, se podría decir que el objetivo es encontrar un modelo interno que obedezca el teorema del buen regulador. Así, por ejemplo, en economía, cuanto más exactamente represente un modelo de comercio (de acciones o materias primas) las acciones del mercado, más fácilmente podrá controlar ese mercado (y extraer 'trabajo útil' (beneficios) de eso). En IA, un ejemplo podría ser un chatbot que modele el estado del discurso de los humanos: cuanto más exactamente pueda modelar el estado humano (p. ej., en una línea telefónica directa de soporte de voz), mejor podrá manipular al humano (p. ej., para realizar las acciones correctivas). para resolver el problema que provocó la llamada telefónica a la línea de ayuda). Estos dos últimos ejemplos toman la estrecha interpretación histórica de la teoría de control como un conjunto de ecuaciones diferenciales que modelan y regulan el movimiento cinético, y la amplían a una amplia generalización de un regulador que interactúa con una planta.

Control de circuito abierto y circuito cerrado (retroalimentación)

Fundamentalmente, hay dos tipos de lazos de control: control de lazo abierto y control de lazo cerrado (retroalimentación).

En el control de bucle abierto, la acción de control del controlador es independiente de la "salida del proceso" (o "variable de proceso controlado" - PV). Un buen ejemplo de esto es una caldera de calefacción central controlada únicamente por un temporizador, de modo que se aplica calor durante un tiempo constante, independientemente de la temperatura del edificio. La acción de control es el encendido/apagado temporizado de la caldera, la variable de proceso es la temperatura del edificio, pero ninguna está vinculada.

En el control de bucle cerrado, la acción de control del controlador depende de la retroalimentación del proceso en forma de valor de la variable de proceso (PV). En el caso de la analogía de la caldera, un circuito cerrado incluiría un termostato para comparar la temperatura del edificio (PV) con la temperatura establecida en el termostato (el punto de ajuste - SP). Esto genera una salida del controlador para mantener el edificio a la temperatura deseada encendiendo y apagando la caldera. Un controlador de lazo cerrado, por lo tanto, tiene un lazo de retroalimentación que asegura que el controlador ejerza una acción de control para manipular la variable del proceso para que sea igual a la "Entrada de referencia" o "punto de ajuste". Por esta razón, los controladores de lazo cerrado también se denominan controladores de retroalimentación.

La definición de un sistema de control de circuito cerrado según la British Standard Institution es "un sistema de control que posee retroalimentación de monitoreo, la señal de desviación formada como resultado de esta retroalimentación se usa para controlar la acción de un elemento de control final de tal manera que tienda a reducir la desviación a cero."

Del mismo modo; "Un Sistema de control de retroalimentación es un sistema que tiende a mantener una relación prescrita de una variable del sistema con otra mediante la comparación de funciones de estas variables y el uso de la diferencia como medio de control."

Otros ejemplos

Un ejemplo de un sistema de control es el control de crucero de un automóvil, que es un dispositivo diseñado para mantener la velocidad del vehículo a una velocidad constante deseada o de referencia proporcionada por el conductor El controlador es el control de crucero, la planta es el automóvil y el sistema es el automóvil y el control de crucero. La salida del sistema es la velocidad del automóvil, y el control en sí mismo es la posición del acelerador del motor que determina cuánta potencia entrega el motor.

Una forma primitiva de implementar el control de crucero es simplemente bloquear la posición del acelerador cuando el conductor activa el control de crucero. Sin embargo, si el control de crucero está activado en un tramo de carretera no llana, entonces el automóvil viajará más lento cuesta arriba y más rápido cuesta abajo. Este tipo de controlador se llama controlador de bucle abierto porque no hay retroalimentación; no se usa ninguna medición de la salida del sistema (la velocidad del automóvil) para alterar el control (la posición del acelerador). Como resultado, el controlador no puede compensar los cambios que actúan sobre el automóvil, como un cambio en la pendiente del camino.

En un sistema de control de circuito cerrado, los datos de un sensor que monitorea la velocidad del automóvil (la salida del sistema) ingresan a un controlador que compara continuamente la cantidad que representa la velocidad con la cantidad de referencia que representa la velocidad deseada. La diferencia, llamada error, determina la posición del acelerador (el control). El resultado es hacer coincidir la velocidad del automóvil con la velocidad de referencia (mantener la salida del sistema deseada). Ahora, cuando el automóvil va cuesta arriba, la diferencia entre la entrada (la velocidad detectada) y la referencia determina continuamente la posición del acelerador. A medida que la velocidad detectada cae por debajo de la referencia, la diferencia aumenta, se abre el acelerador y aumenta la potencia del motor, acelerando el vehículo. De esta forma, el controlador contrarresta dinámicamente los cambios en la velocidad del automóvil. La idea central de estos sistemas de control es el bucle de retroalimentación, el controlador afecta la salida del sistema, que a su vez se mide y retroalimenta al controlador.

Teoría clásica del control

Para superar las limitaciones del controlador de bucle abierto, la teoría de control introduce la retroalimentación. Un controlador de lazo cerrado usa retroalimentación para controlar estados o salidas de un sistema dinámico. Su nombre proviene de la ruta de información en el sistema: las entradas del proceso (por ejemplo, el voltaje aplicado a un motor eléctrico) tienen un efecto sobre las salidas del proceso (por ejemplo, la velocidad o el par del motor), que se mide con sensores y procesa por el controlador; el resultado (la señal de control) es "retroalimentado" como entrada al proceso, cerrando el ciclo.

Los controladores de lazo cerrado tienen las siguientes ventajas sobre los controladores de lazo abierto:

- rechazo de la perturbación (como colinas en el ejemplo de control de cruceros arriba)

- rendimiento garantizado incluso con incertidumbres modelo, cuando la estructura modelo no coincide perfectamente con el proceso real y los parámetros modelo no son exactos

- procesos inestables pueden estabilizarse

- menor sensibilidad a variaciones de parámetros

- Mejora del desempeño en el seguimiento de las referencias

En algunos sistemas, el control de bucle cerrado y de bucle abierto se utilizan simultáneamente. En tales sistemas, el control de bucle abierto se denomina alimentación directa y sirve para mejorar aún más el rendimiento del seguimiento de referencia.

Una arquitectura de controlador de circuito cerrado común es el controlador PID.

Función de transferencia de circuito cerrado

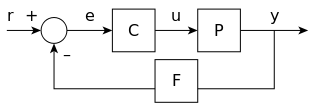

La salida del sistema y(t) se retroalimenta a través de un sensor de medición F a una comparación con el valor de referencia r(t). El controlador C luego toma el error e (diferencia) entre la referencia y la salida para cambiar las entradas u al sistema bajo control P. Esto se muestra en la figura. Este tipo de controlador es un controlador de circuito cerrado o controlador de retroalimentación.

Esto se denomina sistema de control de entrada única, salida única (SISO); Los sistemas MIMO (es decir, Multi-Input-Multi-Output), con más de una entrada/salida, son comunes. En tales casos, las variables se representan a través de vectores en lugar de simples valores escalares. Para algunos sistemas de parámetros distribuidos, los vectores pueden ser de dimensión infinita (típicamente funciones).

Si asumimos que el controlador C, la planta P y el sensor F son lineales e invariantes en el tiempo (es decir, elementos de su función de transferencia C(s), P(s) y F (s) no dependen del tiempo), los sistemas anteriores se pueden analizar utilizando la transformada de Laplace en las variables. Esto da las siguientes relaciones:

- Y()s)=P()s)U()s){displaystyle Y(s)=P(s)U(s)}

- U()s)=C()s)E()s){displaystyle U(s)=C(s)E(s)}

- E()s)=R()s)− − F()s)Y()s).{displaystyle E(s)=R(s)-F(s)Y(s). }

Resolviendo Y(s) en términos de R(s) da

- Y()s)=()P()s)C()s)1+P()s)C()s)F()s))R()s)=H()s)R()s).{displaystyle Y(s)=left({frac {P(s)C(s)}{1+P(s)C(s)F(s)}right)R(s)=H(s)R(s). }

La expresión H()s)=P()s)C()s)1+F()s)P()s)C()s){displaystyle H(s)={frac {P(s)C(s)}{1+F(s)P(s)C(s)}}} se conoce como el función de transferencia cerrada del sistema. El numerador es la ganancia de avance (abierto-abierta) r a Sí., y el denominador es uno más la ganancia en ir alrededor del bucle de retroalimentación, la llamada ganancia de bucle. Si SilencioP()s)C()s)Silencio≫ ≫ 1{displaystyle SilencioP(s)C(s), es decir, tiene una norma grande con cada valor s, y si SilencioF()s)Silencio.. 1{displaystyle Silencioso, entonces Y()s) es aproximadamente igual a R()s) y la salida rastrea atentamente la entrada de referencia.

Control de retroalimentación PID

Un controlador proporcional-integral-derivativo (controlador PID) es una técnica de control de mecanismo de retroalimentación de bucle de control ampliamente utilizada en sistemas de control.

Un controlador PID calcula continuamente un valor de error e(t) como el diferencia entre un punto de ajuste deseado y una variable de proceso medida y aplica una corrección basada en términos proporcionales, integrales y derivados. PID es una sigla de Proporcional-Integral-Derivativo, que se refiere a los tres términos que operan en la señal de error para producir una señal de control.

La comprensión teórica y la aplicación datan de la década de 1920 y se implementan en casi todos los sistemas de control analógicos; originalmente en controladores mecánicos, y luego usando electrónica discreta y más tarde en computadoras de procesos industriales. El controlador PID es probablemente el diseño de control de retroalimentación más utilizado.

Si u(t) es la señal de control enviada al sistema, <span class="texhtml" y(t) es la salida medida y r(t) es la salida deseada, y e(t) = r(t) − y(t) es el error de seguimiento, un controlador PID tiene la forma general

- u()t)=KPe()t)+KI∫ ∫ te()τ τ )dτ τ +KDde()t)dt.{displaystyle u(t)=K_{P}e(t)+K_{I}int ^{t}e(tau){text{d}tau ¿Qué?

La dinámica de bucle cerrado deseada se obtiene ajustando los tres parámetros KP, KI y KD, a menudo iterativamente "ajustando" y sin conocimiento específico de un modelo de planta. A menudo, la estabilidad se puede asegurar usando solo el término proporcional. El término integral permite el rechazo de una perturbación de paso (a menudo una especificación llamativa en el control de procesos). El término derivado se usa para amortiguar o dar forma a la respuesta. Los controladores PID son la clase de sistemas de control mejor establecida: sin embargo, no se pueden usar en varios casos más complicados, especialmente si se consideran los sistemas MIMO.

La aplicación de la transformación de Laplace da como resultado la ecuación del controlador PID transformado

- u()s)=KPe()s)+KI1se()s)+KDse()s){fnMicrosoft Sans Serif},e(s)+K_{I},{frac {1}{s},e(s)+K_{D},s,e(s)}

- u()s)=()KP+KI1s+KDs)e()s){displaystyle u(s)=left(K_{P}+K_{I},{frac {1} {fnMicrosoft Sans Serif}

con la función de transferencia del controlador PID

- C()s)=()KP+KI1s+KDs).{displaystyle C(s)=left (K_{P}+K_{I},{frac {1} {}}+K_{D},sright).}

Como ejemplo de ajuste de un controlador PID en el sistema de circuito cerrado H(s), considere un planta de 1er orden dada por

- P()s)=A1+sTP{displaystyle P(s)={frac {A}{1+sT_{P}}

donde A y TP son algunas constantes. La salida de la planta se retroalimenta a través de

- F()s)=11+sTF{displaystyle F(s)={frac {1}{1+sT_{F}}

Donde TF es también una constante. Ahora si nos fijamos KP=K()1+TDTI){displaystyle K_{P}=Kleft(1+{frac {T_{D}{T_}}derecha)}, KD = KTD, y KI=KTI{displaystyle K_{I}={frac {K}{T_{I}}}, podemos expresar la función de transferencia del controlador PID en forma de serie

- C()s)=K()1+1sTI)()1+sTD){displaystyle C(s)=Kleft(1+{frac {1}{sT_{I}}right)(1+sT_{D}}

Conectando P(s), F(s), y C(s) en el cerrado -función de transferencia de bucle H(s), encontramos que al configurar

- K=1A,TI=TF,TD=TP{displaystyle K={frac {1}{I},T_{I}=T_{F},T_{D}=T_{P}

H(s) = 1. Con este ajuste en este ejemplo, la salida del sistema sigue exactamente la entrada de referencia.

Sin embargo, en la práctica, un diferenciador puro no es físicamente realizable ni deseable debido a la amplificación del ruido y los modos resonantes en el sistema. Por lo tanto, se utiliza en su lugar un enfoque de tipo compensador de adelanto de fase o un diferenciador con caída de paso bajo.

Teoría de control lineal y no lineal

El campo de la teoría del control se puede dividir en dos ramas:

- Teoría de control lineal – Esto se aplica a los sistemas hechos de dispositivos que obedecen al principio de superposición, lo que significa aproximadamente que la salida es proporcional a la entrada. Se rigen por ecuaciones diferenciales lineales. Una subclase importante es sistemas que además tienen parámetros que no cambian con el tiempo, llamados tiempo lineal invariante Sistemas (LTI). Estos sistemas son amenables a potentes técnicas matemáticas de dominio de frecuencia de gran generalidad, como la transformación de Laplace, Fourier transforma, Z transforma, Bode plot, root locus y criterio de estabilidad de Nyquist. Estos conducen a una descripción del sistema usando términos como ancho de banda, respuesta de frecuencias, eigenvalues, ganancia, frecuencias resonantes, ceros y polos, que dan soluciones para técnicas de respuesta del sistema y diseño para la mayoría de los sistemas de interés.

- Teoría de control no lineal – Esto cubre una clase más amplia de sistemas que no obedecen al principio de la superposición, y se aplica a sistemas más reales porque todos los sistemas de control reales no son lineales. Estos sistemas se rigen a menudo por ecuaciones diferenciales no lineales. Las pocas técnicas matemáticas que se han desarrollado para manejarlas son más difíciles y mucho menos generales, a menudo aplicando sólo a categorías estrechas de sistemas. Estos incluyen la teoría del ciclo límite, mapas de Poincaré, teorema de estabilidad de Lyapunov, y funciones de descripción. Los sistemas no lineales se analizan a menudo utilizando métodos numéricos en las computadoras, por ejemplo simulando su operación utilizando un lenguaje de simulación. Si sólo las soluciones cercanas a un punto estable son de interés, los sistemas no lineales a menudo pueden ser linealizados aproximándolos por un sistema lineal usando la teoría de la perturbación, y se pueden utilizar técnicas lineales.

Técnicas de análisis - dominio de la frecuencia y dominio del tiempo

Las técnicas matemáticas para analizar y diseñar sistemas de control se dividen en dos categorías diferentes:

- Dominio de frecuencia – En este tipo los valores de las variables estatales, las variables matemáticas que representan la entrada, salida y retroalimentación del sistema están representadas como funciones de frecuencia. La señal de entrada y la función de transferencia del sistema se convierten de funciones temporales a funciones de frecuencia por una transformación como la transformación Fourier, Laplace transform o Z. La ventaja de esta técnica es que resulta en una simplificación de las matemáticas; la ecuaciones diferenciales que representan el sistema son reemplazados por ecuaciones algebraicas en el dominio de frecuencia que es mucho más simple de resolver. Sin embargo, las técnicas de dominio de frecuencia sólo pueden utilizarse con sistemas lineales, como se mencionó anteriormente.

- Representación espacial del estado del tiempo – En este tipo los valores de las variables estatales están representados como funciones de tiempo. Con este modelo, el sistema analizado está representado por una o más ecuaciones diferenciales. Dado que las técnicas de dominio de frecuencia se limitan a los sistemas lineales, el dominio del tiempo es ampliamente utilizado para analizar los sistemas no lineales del mundo real. Aunque son más difíciles de resolver, las técnicas modernas de simulación de ordenador, como los idiomas de simulación, han hecho su rutina de análisis.

En contraste con el análisis de dominio de frecuencia de la teoría de control clásica, la teoría de control moderna utiliza la representación de espacio de estado de dominio de tiempo, un modelo matemático de un sistema físico como un conjunto de variables de entrada, salida y estado relacionadas por primer orden. ecuaciones diferenciales. Para abstraer del número de entradas, salidas y estados, las variables se expresan como vectores y las ecuaciones diferenciales y algebraicas se escriben en forma matricial (esta última sólo es posible cuando el sistema dinámico es lineal). La representación de espacio de estado (también conocida como "enfoque de dominio de tiempo") proporciona una forma cómoda y compacta de modelar y analizar sistemas con múltiples entradas y salidas. Con entradas y salidas, de lo contrario tendríamos que escribir transformadas de Laplace para codificar toda la información sobre un sistema. A diferencia del enfoque en el dominio de la frecuencia, el uso de la representación del espacio de estados no se limita a sistemas con componentes lineales y condiciones iniciales cero. "Espacio de estado" se refiere al espacio cuyos ejes son las variables de estado. El estado del sistema se puede representar como un punto dentro de ese espacio.

Interfaz del sistema - SISO & MIMO

Los sistemas de control se pueden dividir en diferentes categorías según el número de entradas y salidas.

- Salida única (SISO) – Este es el tipo más simple y común, en el que una salida es controlada por una señal de control. Ejemplos son el ejemplo de control de cruceros arriba, o un sistema de audio, en el que la entrada de control es la señal de audio de entrada y la salida son las ondas de sonido del altavoz.

- Multiple-input multiple-output (MIMO) – Estos se encuentran en sistemas más complicados. Por ejemplo, los telescopios grandes modernos como el Keck y MMT tienen espejos compuestos por muchos segmentos separados cada uno controlado por un actuador. La forma de todo el espejo se ajusta constantemente por un sistema de control activo de óptica MIMO utilizando entrada de múltiples sensores en el plano focal, para compensar los cambios en la forma del espejo debido a la expansión térmica, la contracción, destaca como se gira y la distorsión del frente de onda debido a la turbulencia en la atmósfera. Los sistemas complicados, como los reactores nucleares y las células humanas, son simulados por un ordenador como grandes sistemas de control MIMO.

Temas de la teoría del control

Estabilidad

La estabilidad de un sistema dinámico general sin entrada se puede describir con los criterios de estabilidad de Lyapunov.

- Un sistema lineal se llama consolidado-output (BIBO) estable si su salida se mantendrá atado para cualquier entrada atada.

- Estabilidad para sistemas no lineales que toman una entrada es la estabilidad de entrada a estado (ISS), que combina la estabilidad de Lyapunov y una noción similar a la estabilidad de BIBO.

Para simplificar, las siguientes descripciones se centran en sistemas lineales de tiempo continuo y de tiempo discreto.

Matemáticamente, esto significa que para que un sistema lineal causal sea estable, todos los polos de su función de transferencia deben tener valores reales negativos, es decir, la parte real de cada polo debe ser menor que cero. En términos prácticos, la estabilidad requiere que los polos complejos de la función de transferencia residan

- en la parte izquierda abierta del plano complejo por tiempo continuo, cuando la transformación de Laplace se utiliza para obtener la función de transferencia.

- dentro del círculo de unidad por tiempo discreto, cuando se utiliza la Z-transform.

La diferencia entre los dos casos se debe simplemente al método tradicional de trazar tiempo continuo contra funciones discretas de transferencia de tiempo. El continuo Laplace transforma es en coordenadas cartesianas donde el x{displaystyle x} axis es el eje real y la discreta Z-transform es en coordenadas circulares donde el *** *** {displaystyle rho } El eje es el eje real.

Cuando se cumplen las condiciones apropiadas anteriores, se dice que un sistema es asintóticamente estable; las variables de un sistema de control asintóticamente estable siempre decrecen desde su valor inicial y no muestran oscilaciones permanentes. Las oscilaciones permanentes ocurren cuando un polo tiene una parte real exactamente igual a cero (en el caso de tiempo continuo) o un módulo igual a uno (en el caso de tiempo discreto). Si la respuesta de un sistema simplemente estable no decae ni crece con el tiempo, y no tiene oscilaciones, es marginalmente estable; en este caso, la función de transferencia del sistema tiene polos no repetidos en el origen del plano complejo (es decir, su componente real y complejo es cero en el caso de tiempo continuo). Las oscilaciones están presentes cuando los polos con parte real igual a cero tienen una parte imaginaria distinta de cero.

Si un sistema en cuestión tiene una respuesta de impulso de

- x[n]=0.5nu[n]{displaystyle x[n]=0.5^{n}u[n]}

entonces la transformada Z (ver este ejemplo), viene dada por

- X()z)=11− − 0.5z− − 1{displaystyle X(z)={frac {1}{1-0.5z^{-1}}

que tiene un poste en z=0.5{displaystyle z=0.5} (parte imaginaria). Este sistema es estable BIBO (asintóticamente) ya que el polo es dentro el círculo de la unidad.

Sin embargo, si la respuesta al impulso fuera

- x[n]=1,5nu[n]{displaystyle x[n]=1.5^{n}u[n]}

entonces la transformada Z es

- X()z)=11− − 1,5z− − 1{displaystyle X(z)={frac {1}{1-1.5z^{-1}}}

que tiene un poste en z=1,5{displaystyle z=1.5} y no es estable BIBO ya que el polo tiene un módulo estrictamente mayor que uno.

Existen numerosas herramientas para el análisis de los polos de un sistema. Estos incluyen sistemas gráficos como el lugar geométrico de las raíces, diagramas de Bode o diagramas de Nyquist.

Los cambios mecánicos pueden hacer que los equipos (y los sistemas de control) sean más estables. Los marineros añaden lastre para mejorar la estabilidad de los barcos. Los cruceros usan aletas antivuelco que se extienden transversalmente desde el costado del barco por quizás 30 pies (10 m) y giran continuamente sobre sus ejes para desarrollar fuerzas que se oponen al balanceo.

Controlabilidad y observabilidad

La controlabilidad y la observabilidad son temas principales en el análisis de un sistema antes de decidir la mejor estrategia de control a aplicar, o incluso si es posible controlar o estabilizar el sistema. La controlabilidad está relacionada con la posibilidad de forzar al sistema a un estado particular mediante el uso de una señal de control adecuada. Si un estado no es controlable, entonces ninguna señal podrá controlar el estado. Si un estado no es controlable, pero su dinámica es estable, entonces el estado se denomina estabilizable. La observabilidad en cambio está relacionada con la posibilidad de observar, a través de medidas de salida, el estado de un sistema. Si un estado no es observable, el controlador nunca podrá determinar el comportamiento de un estado no observable y, por lo tanto, no podrá usarlo para estabilizar el sistema. Sin embargo, de manera similar a la condición de estabilización anterior, si no se puede observar un estado, aún podría ser detectable.

Desde un punto de vista geométrico, mirando los estados de cada variable del sistema a controlar, cada "malo" El estado de estas variables debe ser controlable y observable para asegurar un buen comportamiento en el sistema de lazo cerrado. Es decir, si uno de los valores propios del sistema no es tanto controlable como observable, esta parte de la dinámica permanecerá intacta en el sistema de lazo cerrado. Si dicho valor propio no es estable, la dinámica de este valor propio estará presente en el sistema de bucle cerrado que, por lo tanto, será inestable. Los polos no observables no están presentes en la realización de la función de transferencia de una representación de espacio de estado, por lo que a veces se prefiere esta última en el análisis de sistemas dinámicos.

Las soluciones a los problemas de un sistema incontrolable o no observable incluyen agregar actuadores y sensores.

Especificación de control

En los últimos años se han ideado varias estrategias de control diferentes. Estos varían desde los extremadamente generales (controlador PID), hasta otros dedicados a clases de sistemas muy particulares (especialmente robótica o control de crucero de aeronaves).

Un problema de control puede tener varias especificaciones. La estabilidad, por supuesto, siempre está presente. El controlador debe asegurarse de que el sistema de cierre cerrado es estable, independientemente de la estabilidad abierta. Una mala elección del controlador puede empeorar aún más la estabilidad del sistema abierto, que normalmente debe evitarse. A veces se desea obtener dinámicas particulares en el bucle cerrado: es decir, que los polos tienen <math alttext="{displaystyle Re[lambda ]Re[λ λ ].− − λ λ ̄ ̄ {displaystyle Re[lambda] }<img alt="Re[lambda ], donde λ λ ̄ ̄ {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\fnMicrosoft {\\fnMicrosoft {\fnMicrosoft {\\\fnMicrosoft {\\\\\\\fnMicrosoft\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\ } es un valor fijo estrictamente mayor que cero, en lugar de preguntar simplemente <math alttext="{displaystyle Re[lambda ]Re[λ λ ].0{displaystyle Re[lambda]<img alt="Re[lambda ].

Otra especificación típica es el rechazo de una perturbación escalonada; incluir un integrador en la cadena de bucle abierto (es decir, directamente antes del sistema bajo control) lo logra fácilmente. Otras clases de perturbaciones necesitan que se incluyan diferentes tipos de subsistemas.

Otros "clásicos" Las especificaciones de la teoría de control se refieren al tiempo de respuesta del sistema de circuito cerrado. Estos incluyen el tiempo de subida (el tiempo que necesita el sistema de control para alcanzar el valor deseado después de una perturbación), el sobreimpulso de pico (el valor más alto alcanzado por la respuesta antes de alcanzar el valor deseado) y otros (tiempo de establecimiento, cuarto de caída). Las especificaciones del dominio de frecuencia generalmente están relacionadas con la robustez (ver más adelante).

Las evaluaciones de rendimiento modernas utilizan alguna variación del error de seguimiento integrado (IAE, ISA, CQI).

Identificación y robustez del modelo

Un sistema de control siempre debe tener alguna propiedad de robustez. Un controlador robusto es aquel que sus propiedades no cambian mucho si se aplica a un sistema ligeramente diferente del matemático utilizado para su síntesis. Este requisito es importante, ya que ningún sistema físico real se comporta realmente como la serie de ecuaciones diferenciales utilizadas para representarlo matemáticamente. Por lo general, se elige un modelo matemático más simple para simplificar los cálculos; de lo contrario, la verdadera dinámica del sistema puede ser tan complicada que un modelo completo es imposible.

- Identificación del sistema

El proceso de determinación de las ecuaciones que rigen la dinámica del modelo se llama identificación del sistema. Esto se puede hacer fuera de línea: por ejemplo, ejecutar una serie de medidas desde las cuales calcular un modelo matemático aproximado, típicamente su función de transferencia o matriz. Sin embargo, esa identificación de la producción no puede tener en cuenta la dinámica inalcanzable. A veces el modelo se construye directamente a partir de las ecuaciones físicas conocidas, por ejemplo, en el caso de un sistema de amortiguamiento de masa sabemos que mx.. ()t)=− − Kx()t)− − BxÍ Í ()t){displaystyle m{ddot {x}(t)=-Kx(t)-mathrm {B} {dot {x}(t)}. Incluso asumiendo que un modelo "completo" se utiliza en el diseño del controlador, todos los parámetros incluidos en estas ecuaciones (llamados "parámetros nominales") nunca se conocen con precisión absoluta; el sistema de control tendrá que comportarse correctamente incluso cuando se conecta a un sistema físico con valores de parámetro verdaderos lejos de valores nominales.

Algunas técnicas de control avanzadas incluyen un control "en línea" proceso de identificación (ver más adelante). Los parámetros del modelo se calculan ("identifican") mientras el propio controlador se está ejecutando. De esta forma, si se produce una variación drástica de los parámetros, por ejemplo, si el brazo del robot suelta un peso, el controlador se ajustará en consecuencia para garantizar el correcto funcionamiento.

- Análisis

El análisis de la robustez de un sistema de control SISO (entrada única salida única) se puede realizar en el dominio de la frecuencia, considerando la función de transferencia del sistema y utilizando los diagramas de Nyquist y Bode. Los temas incluyen ganancia y margen de fase y margen de amplitud. Para MIMO (multi-input multi-output) y, en general, sistemas de control más complicados, se deben considerar los resultados teóricos ideados para cada técnica de control (ver siguiente apartado). Es decir, si se necesitan cualidades de robustez particulares, el ingeniero debe cambiar su atención a una técnica de control al incluir estas cualidades en sus propiedades.

- Limitaciones

Un problema particular de robustez es el requisito de que un sistema de control funcione correctamente en presencia de restricciones de entrada y de estado. En el mundo físico cada señal es limitada. Puede suceder que un controlador envíe señales de control que el sistema físico no puede seguir, por ejemplo, tratando de girar una válvula a una velocidad excesiva. Esto puede producir un comportamiento no deseado del sistema de circuito cerrado, o incluso dañar o romper actuadores u otros subsistemas. Se dispone de técnicas de control específicas para resolver el problema: control predictivo de modelos (ver más adelante) y sistemas anti-wind up. Este último consiste en un bloque de control adicional que asegura que la señal de control nunca exceda un umbral dado.

Clasificaciones del sistema

Control de sistemas lineales

Para los sistemas MIMO, la colocación de polos se puede realizar matemáticamente utilizando una representación de espacio de estado del sistema de bucle abierto y calculando una matriz de retroalimentación que asigna polos en las posiciones deseadas. En sistemas complicados, esto puede requerir capacidades de cálculo asistido por computadora y no siempre puede garantizar la solidez. Además, todos los estados del sistema no se miden en general, por lo que los observadores deben incluirse e incorporarse en el diseño de ubicación de polos.

Control de sistemas no lineales

Los procesos en industrias como la robótica y la industria aeroespacial suelen tener una fuerte dinámica no lineal. En la teoría de control, a veces es posible linealizar tales clases de sistemas y aplicar técnicas lineales, pero en muchos casos puede ser necesario idear teorías desde cero que permitan el control de sistemas no lineales. Estos, por ejemplo, linealización de retroalimentación, retroceso, control de modo deslizante, control de linealización de trayectoria normalmente aprovechan los resultados basados en la teoría de Lyapunov. La geometría diferencial se ha utilizado ampliamente como una herramienta para generalizar conceptos de control lineal bien conocidos al caso no lineal, así como para mostrar las sutilezas que lo convierten en un problema más desafiante. La teoría del control también se ha utilizado para descifrar el mecanismo neuronal que dirige los estados cognitivos.

Control de sistemas descentralizados

Cuando el sistema está controlado por varios controladores, el problema es el control descentralizado. La descentralización es útil de muchas maneras, por ejemplo, ayuda a los sistemas de control a operar en un área geográfica más grande. Los agentes en los sistemas de control descentralizados pueden interactuar utilizando canales de comunicación y coordinar sus acciones.

Control de sistemas determinísticos y estocásticos

Un problema de control estocástico es aquel en el que la evolución de las variables de estado está sujeta a choques aleatorios desde fuera del sistema. Un problema de control determinista no está sujeto a choques aleatorios externos.

Principales estrategias de control

Todo sistema de control debe garantizar primero la estabilidad del comportamiento en lazo cerrado. Para sistemas lineales, esto se puede obtener colocando directamente los polos. Los sistemas de control no lineal utilizan teorías específicas (normalmente basadas en la teoría de Aleksandr Lyapunov) para garantizar la estabilidad sin tener en cuenta la dinámica interna del sistema. La posibilidad de cumplir con diferentes especificaciones varía según el modelo considerado y la estrategia de control elegida.

- Lista de las principales técnicas de control

- El control adaptativo utiliza la identificación on-line de los parámetros del proceso, o la modificación de las ganancias del controlador, obteniendo así fuertes propiedades de robustez. Los controles adaptativos se aplicaron por primera vez en la industria aeroespacial en la década de 1950, y han encontrado un éxito particular en ese campo.

- Un sistema de control jerárquico es un tipo de sistema de control en el que se organiza un conjunto de dispositivos y software de gobierno en un árbol jerárquico. Cuando los enlaces en el árbol son implementados por una red informática, entonces ese sistema de control jerárquico es también una forma de sistema de control en red.

- El control inteligente utiliza varios enfoques informáticos como redes neuronales artificiales, probabilidad Bayesiana, lógica borrosa, aprendizaje automático, computación evolutiva y algoritmos genéticos o una combinación de estos métodos, como algoritmos neuro-fuzzy, para controlar un sistema dinámico.

- El control óptimo es una técnica de control particular en la que la señal de control optimiza un determinado "índice de costos": por ejemplo, en el caso de un satélite, los empujes de chorro necesarios para llevarlo a la trayectoria deseada que consume la menor cantidad de combustible. Dos métodos de diseño de control óptimos han sido ampliamente utilizados en aplicaciones industriales, ya que se ha demostrado que pueden garantizar la estabilidad de cierre cerrado. Estos son Control Predictivo Modelo (MPC) y control lineal-quadratic-Gaussian (LQG). La primera puede tener en cuenta más explícitamente las limitaciones en las señales del sistema, que es una característica importante en muchos procesos industriales. Sin embargo, la estructura de "control óptimo" en MPC es sólo un medio para lograr tal resultado, ya que no optimiza un verdadero índice de rendimiento del sistema de control de circuito cerrado. Junto con los controladores PID, los sistemas MPC son la técnica de control más utilizada en el control de procesos.

- El control robusto se ocupa explícitamente de la incertidumbre en su enfoque del diseño del controlador. Controladores diseñados usando control robusto los métodos tienden a ser capaces de hacer frente a pequeñas diferencias entre el verdadero sistema y el modelo nominal utilizado para el diseño. Los primeros métodos de Bode y otros fueron bastante robustos; los métodos del espacio-estado inventados en los años 1960 y 1970 se encontraron a veces sin robustez. Ejemplos de técnicas de control robustas modernas incluyen H-infinity loop-shaping desarrollado por Duncan McFarlane y Keith Glover, Sliding mode control (SMC) desarrollado por Vadim Utkin, y protocolos seguros diseñados para el control de grandes poblaciones heterogéneas de cargas eléctricas en aplicaciones Smart Power Grid. Los métodos robustos tienen como objetivo lograr un rendimiento sólido y/o estabilidad en presencia de pequeños errores de modelado.

- El control estocástico trata con el diseño de control con incertidumbre en el modelo. En problemas típicos de control estocástico, se supone que existen ruidos y perturbaciones aleatorias en el modelo y el controlador, y el diseño de control debe tener en cuenta estas desviaciones aleatorias.

- El control de la crítica autoorganizado puede definirse como intentos de interferir en los procesos por los que el sistema autoorganizado disipa la energía.

Personas en sistemas y control

Muchas figuras activas e históricas hicieron contribuciones significativas a la teoría del control, incluyendo

- Pierre-Simon Laplace inventó el Z-transform en su trabajo sobre la teoría de la probabilidad, ahora utilizado para resolver problemas de la teoría del control discreto-time. El Z-transform es un equivalente discreto de tiempo de la transformación de Laplace que se llama después de él.

- Irmgard Flugge-Lotz desarrolló la teoría del control automático discontinua y la aplicó a sistemas de control automático de aeronaves.

- Alexander Lyapunov en los años 1890 marca el comienzo de la teoría de la estabilidad.

- Harold S. Black inventó el concepto de amplificadores de retroalimentación negativa en 1927. Consiguió desarrollar amplificadores de retroalimentación negativos estables en los años 1930.

- Harry Nyquist desarrolló el criterio de estabilidad de Nyquist para sistemas de retroalimentación en la década de 1930.

- Richard Bellman desarrolló una programación dinámica en la década de 1940.

- Warren E. Dixon, teorista de control y profesor

- Andrey Kolmogorov codesarrolló el filtro Wiener-Kolmogorov en 1941.

- Norbert Wiener codesarrolló el filtro Wiener-Kolmogorov y acuñó el término cibernético en la década de 1940.

- John R. Ragazzini introdujo el control digital y el uso de Z-transform en la teoría del control (invenido por Laplace) en los años 50.

- Lev Pontryagin introdujo el principio máximo y el principio de la explosión.

- Pierre-Louis Lions desarrolló soluciones de viscosidad en control estocástico y métodos de control óptimos.

- Rudolf E. Kálmán fue pionero en el enfoque estatal-espacial de sistemas y control. Introdujo las nociones de control y observabilidad. Desarrolló el filtro Kalman para la estimación lineal.

- Ali H. Nayfeh, quien fue uno de los principales contribuyentes a la teoría del control no lineal y publicó muchos libros sobre métodos de perturbación

- Jan C. Willems Introdujo el concepto de dissipatividad, como una generalización de la función Lyapunov para los sistemas de entrada/estado/salida. La construcción de la función de almacenamiento, como se llama la analogía de una función de Lyapunov, condujo al estudio de la desigualdad de matriz lineal (LMI) en la teoría de control. Fue pionero en el enfoque conductual de la teoría de sistemas matemáticos.

Contenido relacionado

Fenómeno de runge

Número (lingüística)

Rizo (matemáticas)

![x[n]=0.5^{n}u[n]](https://wikimedia.org/api/rest_v1/media/math/render/svg/c3fe9bf89c5cffaf461081935fd41745dc768063)

![x[n]=1.5^{n}u[n]](https://wikimedia.org/api/rest_v1/media/math/render/svg/b769b726a2a55b9fc5e5c8d800187d7715cf84cd)