Teoría cuántica de campos

En física teórica, la teoría cuántica de campos (QFT) es un marco teórico que combina la teoría clásica de campos, la relatividad especial y la mecánica cuántica. QFT se utiliza en física de partículas para construir modelos físicos de partículas subatómicas y en física de materia condensada para construir modelos de cuasipartículas.

QFT trata a las partículas como estados excitados (también llamados cuantos) de sus campos cuánticos subyacentes, que son más fundamentales que las partículas. La ecuación de movimiento de la partícula está determinada por la minimización del Lagrangiano, un funcional de campos asociados con la partícula. Las interacciones entre partículas se describen mediante términos de interacción en el Lagrangiano que involucran sus campos cuánticos correspondientes. Cada interacción se puede representar visualmente mediante diagramas de Feynman de acuerdo con la teoría de la perturbación en la mecánica cuántica.

Historia

La teoría cuántica de campos surgió del trabajo de generaciones de físicos teóricos durante gran parte del siglo XX. Su desarrollo comenzó en la década de 1920 con la descripción de las interacciones entre la luz y los electrones, culminando en la primera teoría cuántica de campos: la electrodinámica cuántica. Pronto siguió un gran obstáculo teórico con la aparición y persistencia de varios infinitos en los cálculos perturbativos, un problema que solo se resolvió en la década de 1950 con la invención del procedimiento de renormalización. Una segunda barrera importante surgió con la aparente incapacidad de QFT para describir las interacciones débiles y fuertes, hasta el punto en que algunos teóricos pidieron el abandono del enfoque teórico de campo. El desarrollo de la teoría de calibre y la finalización del modelo estándar en la década de 1970 llevaron a un renacimiento de la teoría cuántica de campos.

Antecedentes teóricos

La teoría cuántica de campos resulta de la combinación de la teoría clásica de campos, la mecánica cuántica y la relatividad especial. A continuación se presenta una breve descripción de estos precursores teóricos.

La primera teoría clásica exitosa de campos es la que surgió de la ley de gravitación universal de Newton, a pesar de la ausencia total del concepto de campos en su tratado de 1687 Philosophiæ Naturalis Principia Mathematica. La fuerza de la gravedad, tal como la describe Newton, es una "acción a distancia"; sus efectos sobre los objetos lejanos son instantáneos, sin importar la distancia. Sin embargo, en un intercambio de cartas con Richard Bentley, Newton afirmó que "es inconcebible que la materia bruta inanimada, sin la mediación de otra cosa que no es material, opere y afecte a otra materia sin contacto mutuo". 34; No fue sino hasta el siglo XVIII que los físicos matemáticos descubrieron una descripción conveniente de la gravedad basada en campos: una cantidad numérica (un vector en el caso del campo gravitatorio) asignada a cada punto en el espacio que indica la acción de la gravedad sobre cualquier partícula en ese punto.. Sin embargo, esto se consideró simplemente un truco matemático.

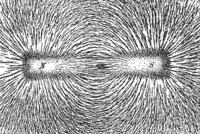

Los campos comenzaron a adquirir existencia propia con el desarrollo del electromagnetismo en el siglo XIX. Michael Faraday acuñó el término inglés "field" en 1845. Introdujo los campos como propiedades del espacio (incluso cuando está desprovisto de materia) que tienen efectos físicos. Argumentó en contra de la 'acción a distancia' y propuso que las interacciones entre los objetos ocurren a través de 'líneas de fuerza' que llenan el espacio. Esta descripción de los campos se mantiene hasta el día de hoy.

La teoría del electromagnetismo clásico se completó en 1864 con las ecuaciones de Maxwell, que describían la relación entre el campo eléctrico, el campo magnético, la corriente eléctrica y la carga eléctrica. Las ecuaciones de Maxwell implicaban la existencia de ondas electromagnéticas, un fenómeno por el cual los campos eléctricos y magnéticos se propagan de un punto espacial a otro a una velocidad finita, que resulta ser la velocidad de la luz. La acción a distancia fue así refutada de manera concluyente.

A pesar del enorme éxito del electromagnetismo clásico, no pudo explicar las líneas discretas en los espectros atómicos, ni la distribución de la radiación del cuerpo negro en diferentes longitudes de onda. El estudio de Max Planck sobre la radiación del cuerpo negro marcó el comienzo de la mecánica cuántica. Trató a los átomos, que absorben y emiten radiación electromagnética, como pequeños osciladores con la propiedad crucial de que sus energías solo pueden tomar una serie de valores discretos, en lugar de continuos. Estos se conocen como osciladores armónicos cuánticos. Este proceso de restricción de energías a valores discretos se denomina cuantización. Sobre la base de esta idea, Albert Einstein propuso en 1905 una explicación para el efecto fotoeléctrico, que la luz se compone de paquetes individuales de energía llamados fotones (los cuantos de luz). Esto implicaba que la radiación electromagnética, al ser ondas en el campo electromagnético clásico, también existe en forma de partículas.

En 1913, Niels Bohr introdujo el modelo de estructura atómica de Bohr, en el que los electrones dentro de los átomos solo pueden asumir una serie de energías discretas, en lugar de continuas. Este es otro ejemplo de cuantización. El modelo de Bohr explicó con éxito la naturaleza discreta de las líneas espectrales atómicas. En 1924, Louis de Broglie propuso la hipótesis de la dualidad onda-partícula, que las partículas microscópicas exhiben propiedades tanto ondulatorias como corpusculares en diferentes circunstancias. Uniendo estas ideas dispersas, se formuló una disciplina coherente, la mecánica cuántica, entre 1925 y 1926, con importantes contribuciones de Max Planck, Louis de Broglie, Werner Heisenberg, Max Born, Erwin Schrödinger, Paul Dirac y Wolfgang Pauli.

El mismo año que su artículo sobre el efecto fotoeléctrico, Einstein publicó su teoría de la relatividad especial, basada en el electromagnetismo de Maxwell. Se dieron nuevas reglas, llamadas transformaciones de Lorentz, para la forma en que las coordenadas de tiempo y espacio de un evento cambian bajo cambios en la velocidad del observador, y la distinción entre tiempo y espacio se desdibujó. Se propuso que todas las leyes físicas deben ser las mismas para los observadores a diferentes velocidades, es decir, que las leyes físicas sean invariantes bajo las transformaciones de Lorentz.

Quedaban dos dificultades. Desde el punto de vista de la observación, la ecuación de Schrödinger que subyace a la mecánica cuántica podría explicar la emisión estimulada de radiación de los átomos, donde un electrón emite un nuevo fotón bajo la acción de un campo electromagnético externo, pero no pudo explicar la emisión espontánea, donde la energía de un electrón disminuye espontáneamente. y emite un fotón incluso sin la acción de un campo electromagnético externo. Teóricamente, la ecuación de Schrödinger no podía describir los fotones y era inconsistente con los principios de la relatividad especial: trata el tiempo como un número ordinario mientras promueve las coordenadas espaciales a operadores lineales.

Electrodinámica cuántica

La teoría cuántica de campos comenzó naturalmente con el estudio de las interacciones electromagnéticas, ya que el campo electromagnético era el único campo clásico conocido en la década de 1920.

A través de los trabajos de Born, Heisenberg y Pascual Jordan en 1925-1926, se desarrolló una teoría cuántica del campo electromagnético libre (uno sin interacciones con la materia) a través de la cuantización canónica al tratar el campo electromagnético como un conjunto de campos cuánticos osciladores armónicos. Sin embargo, con la exclusión de las interacciones, tal teoría aún era incapaz de hacer predicciones cuantitativas sobre el mundo real.

En su artículo seminal de 1927 La teoría cuántica de la emisión y absorción de radiación, Dirac acuñó el término electrodinámica cuántica (QED), una teoría que añade a los términos que describen el campo electromagnético libre un término de interacción entre la densidad de corriente eléctrica y el vector potencial electromagnético. Usando la teoría de la perturbación de primer orden, explicó con éxito el fenómeno de la emisión espontánea. De acuerdo con el principio de incertidumbre de la mecánica cuántica, los osciladores armónicos cuánticos no pueden permanecer estacionarios, pero tienen una energía mínima distinta de cero y siempre deben estar oscilando, incluso en el estado de energía más bajo (el estado fundamental). Por lo tanto, incluso en un vacío perfecto, permanece un campo electromagnético oscilante que tiene energía de punto cero. Es esta fluctuación cuántica de campos electromagnéticos en el vacío lo que "estimula" la emisión espontánea de radiación por electrones en los átomos. La teoría de Dirac fue un gran éxito al explicar tanto la emisión como la absorción de radiación por parte de los átomos; al aplicar la teoría de la perturbación de segundo orden, pudo explicar la dispersión de fotones, la fluorescencia de resonancia y la dispersión Compton no relativista. No obstante, la aplicación de la teoría de perturbaciones de orden superior estuvo plagada de infinitos problemáticos en los cálculos.

En 1928, Dirac escribió una ecuación de onda que describía los electrones relativistas: la ecuación de Dirac. Tuvo las siguientes consecuencias importantes: el espín de un electrón es 1/2; el factor g de electrones es 2; condujo a la fórmula correcta de Sommerfeld para la estructura fina del átomo de hidrógeno; y podría usarse para derivar la fórmula de Klein-Nishina para la dispersión relativista de Compton. Aunque los resultados fueron fructíferos, la teoría aparentemente también implicaba la existencia de estados de energía negativa, lo que haría que los átomos fueran inestables, ya que siempre podrían decaer a estados de menor energía por la emisión de radiación.

La opinión predominante en ese momento era que el mundo estaba compuesto por dos ingredientes muy diferentes: partículas materiales (como los electrones) y campos cuánticos (como los fotones). Las partículas materiales se consideraban eternas, con su estado físico descrito por las probabilidades de encontrar cada partícula en cualquier región dada del espacio o rango de velocidades. Por otro lado, los fotones se consideraban simplemente los estados excitados del campo electromagnético cuantificado subyacente, y podían crearse o destruirse libremente. Fue entre 1928 y 1930 cuando Jordan, Eugene Wigner, Heisenberg, Pauli y Enrico Fermi descubrieron que las partículas materiales también podían verse como estados excitados de campos cuánticos. Así como los fotones son estados excitados del campo electromagnético cuantizado, cada tipo de partícula tenía su campo cuántico correspondiente: un campo de electrones, un campo de protones, etc. Dada la energía suficiente, ahora sería posible crear partículas materiales. Sobre la base de esta idea, Fermi propuso en 1932 una explicación para la desintegración beta conocida como interacción de Fermi. Los núcleos atómicos no contienen electrones per se, pero en el proceso de desintegración, se crea un electrón a partir del campo de electrones circundante, de forma análoga al fotón creado a partir del campo electromagnético circundante en la desintegración radiativa de un átomo excitado.

Dirac y otros se dieron cuenta en 1929 de que los estados de energía negativa implícitos en la ecuación de Dirac podían eliminarse asumiendo la existencia de partículas con la misma masa que los electrones pero con carga eléctrica opuesta. Esto no solo aseguró la estabilidad de los átomos, sino que también fue la primera propuesta de la existencia de la antimateria. De hecho, la evidencia de positrones fue descubierta en 1932 por Carl David Anderson en rayos cósmicos. Con suficiente energía, como al absorber un fotón, se podría crear un par electrón-positrón, un proceso llamado producción de pares; el proceso inverso, la aniquilación, también podría ocurrir con la emisión de un fotón. Esto demostró que los números de partículas no necesitan ser fijos durante una interacción. Históricamente, sin embargo, los positrones se consideraban al principio como "agujeros" en un mar infinito de electrones, en lugar de un nuevo tipo de partícula, y esta teoría se denominó teoría del agujero de Dirac. QFT naturalmente incorporó antipartículas en su formalismo.

Infinitos y renormalización

Robert Oppenheimer demostró en 1930 que los cálculos perturbativos de orden superior en QED siempre daban como resultado cantidades infinitas, como la energía propia del electrón y la energía del punto cero del vacío de los campos de electrones y fotones, lo que sugiere que los métodos computacionales en el el tiempo no podía manejar adecuadamente las interacciones que involucraban fotones con momentos extremadamente altos. No fue sino hasta 20 años después que se desarrolló un enfoque sistemático para eliminar tales infinitos.

Ernst Stueckelberg publicó una serie de artículos entre 1934 y 1938 que establecieron una formulación relativistamente invariante de QFT. En 1947, Stueckelberg también desarrolló de forma independiente un procedimiento de renormalización completo. Desafortunadamente, tales logros no fueron comprendidos ni reconocidos por la comunidad teórica.

Ante estos infinitos, John Archibald Wheeler y Heisenberg propusieron, en 1937 y 1943 respectivamente, suplantar la problemática QFT por la denominada teoría de la matriz S. Dado que los detalles específicos de las interacciones microscópicas son inaccesibles para las observaciones, la teoría solo debe intentar describir las relaciones entre un pequeño número de observables (por ejemplo, la energía de un átomo) en una interacción, en lugar de preocuparse con las minucias microscópicas de la interacción. En 1945, Richard Feynman y Wheeler sugirieron audazmente abandonar QFT por completo y propusieron la acción a distancia como el mecanismo de interacción de partículas.

En 1947, Willis Lamb y Robert Retherford midieron la diferencia de minutos en 2S1/2 y 2P1/2 niveles de energía del átomo de hidrógeno, también llamado cambio Lamb. Al ignorar la contribución de los fotones cuya energía excede la masa del electrón, Hans Bethe estimó con éxito el valor numérico del cambio de Lamb. Posteriormente, Norman Myles Kroll, Lamb, James Bruce French y Victor Weisskopf volvieron a confirmar este valor utilizando un enfoque en el que los infinitos cancelaban otros infinitos para dar como resultado cantidades finitas. Sin embargo, este método era torpe y poco fiable y no podía generalizarse a otros cálculos.

El gran avance finalmente se produjo alrededor de 1950 cuando Julian Schwinger, Richard Feynman, Freeman Dyson y Shinichiro Tomonaga desarrollaron un método más sólido para eliminar infinitos. La idea principal es reemplazar los valores calculados de masa y carga, por infinitos que sean, por sus valores medidos finitos. Este procedimiento computacional sistemático se conoce como renormalización y se puede aplicar a un orden arbitrario en la teoría de perturbaciones. Como dijo Tomonaga en su discurso del Nobel:

Puesto que esas partes de la masa modificada y carga debido a las reacciones de campo [se vuelven infinitas], es imposible calcularlas por la teoría. Sin embargo, la masa y la carga observadas en experimentos no son la masa y carga original, sino la masa y la carga modificada por reacciones de campo, y son finitas. Por otro lado, la masa y la carga que aparece en la teoría son... los valores modificados por reacciones de campo. Puesto que esto es así, y sobre todo porque la teoría no puede calcular la masa modificada y la carga, podemos adoptar el procedimiento de sustitución de valores experimentales para ellos fenomenológicamente... Este procedimiento se llama la renormalización de masa y carga... Después de cálculos largos y laboriosos, menos hábiles que Schwinger, obtuvimos un resultado... que estaba de acuerdo con [los] estadounidenses.

Al aplicar el procedimiento de renormalización, finalmente se realizaron cálculos para explicar el momento magnético anómalo del electrón (la desviación del factor g del electrón de 2) y la polarización del vacío. Estos resultados coincidieron con las mediciones experimentales en un grado notable, marcando así el final de una 'guerra contra los infinitos'.

Al mismo tiempo, Feynman introdujo la formulación de la integral de trayectoria de la mecánica cuántica y los diagramas de Feynman. Este último se puede utilizar para organizar visual e intuitivamente y para ayudar a calcular términos en la expansión perturbativa. Cada diagrama se puede interpretar como trayectorias de partículas en una interacción, con cada vértice y línea teniendo una expresión matemática correspondiente, y el producto de estas expresiones da la amplitud de dispersión de la interacción representada por el diagrama.

Fue con la invención del procedimiento de renormalización y los diagramas de Feynman que QFT finalmente surgió como un marco teórico completo.

No renormalizabilidad

Dado el tremendo éxito de QED, muchos teóricos creyeron, en los pocos años posteriores a 1949, que QFT pronto podría proporcionar una comprensión de todos los fenómenos microscópicos, no solo las interacciones entre fotones, electrones y positrones. Contrariamente a este optimismo, QFT entró en otro período de depresión que duró casi dos décadas.

El primer obstáculo fue la aplicabilidad limitada del procedimiento de renormalización. En los cálculos perturbativos en QED, todas las cantidades infinitas podrían eliminarse redefiniendo un número pequeño (finito) de cantidades físicas (a saber, la masa y la carga del electrón). Dyson demostró en 1949 que esto solo es posible para una pequeña clase de teorías llamadas "teorías renormalizables", de las cuales QED es un ejemplo. Sin embargo, la mayoría de las teorías, incluida la teoría de Fermi de la interacción débil, son "no renormalizables". Cualquier cálculo perturbativo en estas teorías más allá del primer orden daría como resultado infinitos que no podrían eliminarse redefiniendo un número finito de cantidades físicas.

El segundo gran problema surgió de la validez limitada del método del diagrama de Feynman, que se basa en una expansión en serie en la teoría de perturbaciones. Para que la serie converja y los cálculos de bajo orden sean una buena aproximación, la constante de acoplamiento, en la que se expande la serie, debe ser un número suficientemente pequeño. La constante de acoplamiento en QED es la constante de estructura fina α ≈ 1/137, que es lo suficientemente pequeña como para que solo los diagramas de Feynman más simples y de menor orden deben ser considerados en cálculos realistas. Por el contrario, la constante de acoplamiento en la interacción fuerte es aproximadamente del orden de uno, lo que hace que los diagramas de Feynman complicados y de orden superior sean tan importantes como los simples. Por lo tanto, no había forma de derivar predicciones cuantitativas confiables para la interacción fuerte utilizando métodos QFT perturbativos.

Con estas dificultades inminentes, muchos teóricos comenzaron a alejarse de QFT. Algunos se centraron en los principios de simetría y las leyes de conservación, mientras que otros recogieron la antigua teoría de la matriz S de Wheeler y Heisenberg. QFT se usó heurísticamente como principios rectores, pero no como base para cálculos cuantitativos.

Schwinger, sin embargo, tomó una ruta diferente. Durante más de una década, él y sus alumnos habían sido casi los únicos exponentes de la teoría de campos, pero en 1966 encontró una solución al problema de los infinitos con un nuevo método que denominó teoría de fuentes. Los avances en la física de piones, en los que se aplicó con mayor éxito el nuevo punto de vista, lo convencieron de las grandes ventajas de la simplicidad matemática y la claridad conceptual que otorgaba su uso.

En la teoría de las fuentes no hay divergencias ni renormalización. Puede considerarse como la herramienta de cálculo de la teoría de campos, pero es más general. Usando la teoría de la fuente, Schwinger pudo calcular el momento magnético anómalo del electrón, lo que había hecho en 1947, pero esta vez sin "observaciones que distraían" sobre cantidades infinitas.

Schwinger también aplicó la teoría de la fuente a su teoría QFT de la gravedad, y pudo reproducir los cuatro resultados clásicos de Einstein: corrimiento hacia el rojo gravitacional, desviación y desaceleración de la luz por la gravedad, y la precesión del perihelio de Mercurio. El descuido de la teoría de fuentes por parte de la comunidad física fue una gran decepción para Schwinger:

La falta de apreciación de estos hechos por otros fue deprimente, pero comprensible. -J. Schwinger

Modelo estándar

En 1954, Yang Chen-Ning y Robert Mills generalizaron la simetría local de QED, lo que condujo a teorías de calibre no abelianas (también conocidas como teorías de Yang-Mills), que se basan en grupos de simetría local más complicados. En QED, las partículas cargadas (eléctricamente) interactúan a través del intercambio de fotones, mientras que en la teoría de calibre no abeliana, las partículas que llevan un nuevo tipo de 'carga' interactúan a través del intercambio de bosones de calibre sin masa. A diferencia de los fotones, estos bosones de calibre llevan carga.

Sheldon Glashow desarrolló una teoría de calibre no abeliana que unificó las interacciones electromagnética y débil en 1960. En 1964, Abdus Salam y John Clive Ward llegaron a la misma teoría por un camino diferente. Esta teoría, sin embargo, era no renormalizable.

Peter Higgs, Robert Brout, François Englert, Gerald Guralnik, Carl Hagen y Tom Kibble propusieron en sus famosos artículos de Physical Review Letters que la simetría de calibre en las teorías de Yang-Mills podría romperse mediante un mecanismo llamado ruptura de simetría espontánea, a través de que originalmente los bosones de calibre sin masa podrían adquirir masa.

Al combinar la teoría anterior de Glashow, Salam y Ward con la idea de la ruptura espontánea de la simetría, Steven Weinberg escribió en 1967 una teoría que describe las interacciones electrodébiles entre todos los leptones y los efectos del bosón de Higgs. Al principio, su teoría fue mayormente ignorada, hasta que volvió a salir a la luz en 1971 con la demostración de Gerard 't Hooft' de que las teorías de calibre no abelianas son renormalizables. La teoría electrodébil de Weinberg y Salam fue ampliada de los leptones a los quarks en 1970 por Glashow, John Iliopoulos y Luciano Maiani, lo que marcó su finalización.

Harald Fritzsch, Murray Gell-Mann y Heinrich Leutwyler descubrieron en 1971 que ciertos fenómenos relacionados con la interacción fuerte también podrían explicarse mediante la teoría de calibre no abeliana. Nació la cromodinámica cuántica (QCD). En 1973, David Gross, Frank Wilczek y Hugh David Politzer demostraron que las teorías de calibre no abelianas son "asintóticamente libres", lo que significa que, bajo la renormalización, la constante de acoplamiento de la interacción fuerte disminuye a medida que aumenta la energía de interacción. (Descubrimientos similares se habían hecho numerosas veces anteriormente, pero se habían ignorado en gran medida). Por lo tanto, al menos en las interacciones de alta energía, la constante de acoplamiento en QCD se vuelve lo suficientemente pequeña como para justificar una expansión de la serie perturbativa, haciendo predicciones cuantitativas para la interacción fuerte posible.

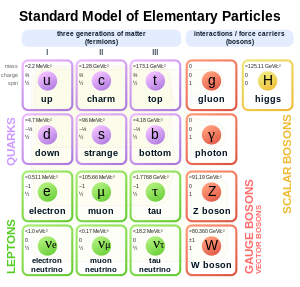

Estos avances teóricos provocaron un renacimiento en QFT. La teoría completa, que incluye la teoría electrodébil y la cromodinámica, se conoce hoy como el modelo estándar de partículas elementales. El modelo estándar describe con éxito todas las interacciones fundamentales excepto la gravedad, y sus muchas predicciones se han cumplido con una notable confirmación experimental en las décadas posteriores. El bosón de Higgs, fundamental para el mecanismo de ruptura espontánea de la simetría, finalmente se detectó en 2012 en el CERN, lo que marcó la verificación completa de la existencia de todos los constituyentes del modelo estándar.

Otros desarrollos

La década de 1970 vio el desarrollo de métodos no perturbativos en teorías de norma no abelianas. El monopolo 't Hooft-Polyakov fue descubierto teóricamente por 't Hooft y Alexander Polyakov, los tubos de flujo por Holger Bech Nielsen y Poul Olesen, y los instantons por Polyakov y sus coautores. Estos objetos son inaccesibles a través de la teoría de perturbaciones.

La supersimetría también apareció en el mismo período. El primer QFT supersimétrico en cuatro dimensiones fue construido por Yuri Golfand y Evgeny Likhtman en 1970, pero su resultado no logró generar un interés generalizado debido al Telón de Acero. La supersimetría solo despegó en la comunidad teórica después del trabajo de Julius Wess y Bruno Zumino en 1973.

Entre las cuatro interacciones fundamentales, la gravedad sigue siendo la única que carece de una descripción QFT coherente. Varios intentos de una teoría de la gravedad cuántica condujeron al desarrollo de la teoría de cuerdas, en sí misma un tipo de QFT bidimensional con simetría conforme. Joël Scherk y John Schwarz propusieron por primera vez en 1974 que la teoría de cuerdas podría ser la teoría cuántica de la gravedad.

Física-de-la-materia-condensada

Aunque la teoría cuántica de campos surgió del estudio de las interacciones entre partículas elementales, se ha aplicado con éxito a otros sistemas físicos, en particular a los sistemas de muchos cuerpos en la física de la materia condensada.

Históricamente, el mecanismo de Higgs de ruptura espontánea de la simetría fue el resultado de la aplicación de la teoría de superconductores de Yoichiro Nambu a las partículas elementales, mientras que el concepto de renormalización surgió del estudio de las transiciones de fase de segundo orden en la materia.

Poco después de la introducción de los fotones, Einstein realizó el procedimiento de cuantificación de las vibraciones en un cristal, lo que condujo a las primeras cuasipartículas: los fonones. Lev Landau afirmó que las excitaciones de baja energía en muchos sistemas de materia condensada podrían describirse en términos de interacciones entre un conjunto de cuasipartículas. El método del diagrama de Feynman de QFT era naturalmente muy adecuado para el análisis de varios fenómenos en sistemas de materia condensada.

La teoría de calibre se utiliza para describir la cuantificación del flujo magnético en los superconductores, la resistividad en el efecto Hall cuántico, así como la relación entre la frecuencia y el voltaje en el efecto AC Josephson.

Principios

Para simplificar, las unidades naturales se utilizan en las siguientes secciones, en las que la constante de Planck reducida ħ y la velocidad de la luz c ambos están establecidos en uno.

Campos clásicos

Un campo clásico es una función de coordenadas espaciales y temporales. Los ejemplos incluyen el campo gravitacional en la gravedad newtoniana g(x, t) y el campo eléctrico campo E(x, t) y campo magnético B(x, t) en electromagnetismo clásico. Se puede pensar en un campo clásico como una cantidad numérica asignada a cada punto en el espacio que cambia en el tiempo. Por lo tanto, tiene infinitos grados de libertad.

Muchos fenómenos que exhiben propiedades mecánicas cuánticas no pueden explicarse solo con campos clásicos. Fenómenos como el efecto fotoeléctrico se explican mejor por partículas discretas (fotones), en lugar de un campo espacialmente continuo. El objetivo de la teoría cuántica de campos es describir varios fenómenos mecánicos cuánticos utilizando un concepto modificado de campos.

La cuantificación canónica y las integrales de ruta son dos formulaciones comunes de QFT. Para motivar los fundamentos de QFT, sigue una descripción general de la teoría de campo clásica.

El campo clásico más simple es un campo de escalar real — un número real en cada punto del espacio que cambia el tiempo. Se denota como φ()x, t), donde x es el vector de posición, y t es el momento. Supongamos que el Lagrangiano del campo, L{displaystyle L., es

- L=∫ ∫ d3xL=∫ ∫ d3x[12φ φ Í Í 2− − 12()Silencio Silencio φ φ )2− − 12m2φ φ 2],{fnMitcal {fnMitcal}=int d^{3}x,left [{frac {1}{2}}{dot {f} {fnMicroc {c}}} {fnMicroc {c}}}} {f}}}}}} {fnf}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}fnKfnfnKfnfnf}fnf}fnfnfnfnKfnKfnfnf}fnfnfnfnfnfnfnfnfnKfnfnfnfnfnKfnKfnf}fn ## {2}-{2} {2} {2} {2}nablaphi)} {2}-{frac {1} {2}}m^{2}phi ^{2}right]

Donde L{displaystyle {fnMithcal}} es la densidad lagrangiana, φ φ Í Í {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\\fnMicrosoft {fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\\fnMicrosoft\\\\\\\\\\\\\\\\\\\fn\\\\\\\\\\\\\\\\\\\\\\fn\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\fnMin } es el tiempo-derivativo del campo, Silencio es el operador de gradiente, y m es un parámetro real (la "masa" del campo). Aplicando la ecuación Euler-Lagrange en el Lagrangiano:

- ∂ ∂ ∂ ∂ t[∂ ∂ L∂ ∂ ()∂ ∂ φ φ /∂ ∂ t)]+.. i=13∂ ∂ ∂ ∂ xi[∂ ∂ L∂ ∂ ()∂ ∂ φ φ /∂ ∂ xi)]− − ∂ ∂ L∂ ∂ φ φ =0,{displaystyle {frac {partial }{partial t}left[{frac {partial {mathcal {}}{partial phi /partial t)}right]+sum {fnK} {fnMicroc {fnK} {fnMicrosoft} {fnMicroc {f}}{partial {f} {f}}{partial (partial phi /partial x^{i}}}}}}derecha]-{fnMithcal {}} {}}}}}}}}} {} {f}}}}}}f} {f}}f}}}}} {f} {f} {f}f}}}}f}}}f}f}f}f}}}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}

obtenemos las ecuaciones de movimiento del campo, que describen la forma en que varía en el tiempo y el espacio:

- ()∂ ∂ 2∂ ∂ t2− − Silencio Silencio 2+m2)φ φ =0.{displaystyle left({frac {partial ^{2}{partial. ^{2}+m^{2}right)phi =0.}

Esto se conoce como la ecuación de Klein-Gordon.

La ecuación de Klein-Gordon es una ecuación de onda, por lo que sus soluciones se pueden expresar como una suma de modos normales (obtenida a través de la transformada de Fourier) de la siguiente manera:

- φ φ ()x,t)=∫ ∫ d3p()2π π )312⋅ ⋅ p()ape− − i⋅ ⋅ pt+ip⋅ ⋅ x+apAlternativa Alternativa ei⋅ ⋅ pt− − ip⋅ ⋅ x),{displaystyle phi (mathbf {x}t)=int {frac {}p}{(2pi)^{3}}}{frac {1}{sqrt {2omega _{mathbf {}}}left(a_{mathbf {p}e^{-iomega) ¿Qué? }+a_{mathbf {} {} {*}e^{iomega ¿Qué? }t-imathbf {p} cdot mathbf {x}right),}

donde a es un número complejo (normalizado por convención), * denota una conjugación compleja, y ωp es la frecuencia del modo normal:

- ⋅ ⋅ p=SilenciopSilencio2+m2.{displaystyle omega _{mathbf {p} }={sqrt { Anteriormathbf {p} Silencio.

Así, cada modo normal correspondiente a un solo p puede verse como un oscilador armónico clásico con frecuencia ωp.

Cuantificación canónica

El procedimiento de cuantificación del campo clásico anterior a un campo de operador cuántico es análogo a la promoción de un oscilador armónico clásico a un oscilador armónico cuántico.

El desplazamiento de un oscilador armónico clásico se describe mediante

- x()t)=12⋅ ⋅ ae− − i⋅ ⋅ t+12⋅ ⋅ aAlternativa Alternativa ei⋅ ⋅ t,{fnK}ae^{-iomega t}+{frac {1} {sqrt {2omega}}a^{*}e^{iomega t}

donde a es un número complejo (normalizado por convención), y ω es la frecuencia del oscilador. Tenga en cuenta que x es el desplazamiento de una partícula en movimiento armónico simple desde la posición de equilibrio, que no debe confundirse con la etiqueta espacial x de un campo cuántico.

Para un oscilador armónico cuántico, x()t) es promovido a un operador lineal x^ ^ ()t){displaystyle {hat {x}(t)}:

- x^ ^ ()t)=12⋅ ⋅ a^ ^ e− − i⋅ ⋅ t+12⋅ ⋅ a^ ^ † † ei⋅ ⋅ t.{fnK} {fnK} {fnK} {fn0}}} {fnh}} {f}}} {fnfnfn9}} {fnfn9}}} {fnfn9}}} {fnfnfnh00fnH00}fnfnfnH00}}}}}}}}}}}}}}}fn9fn9fn9fnfnfnfnH00fnh00fn9fn9fnfnH00fnfnfnfn9fnfn9fn9fnh00}}}fnfnfnh00fnfnh00}}}}}}}fnfnh00fnfnfnfnfnh00}}}}}}}} t}+{frac {1}{sqrt {2omega } {fn} {fnK} {fnK} {fnK}}}} {fn}} {fn}} {fnfn}}}}} {fnfn}}} {fnfn}}} {fnf}} {fnfnfnf}}}}} {f}}}}}}} {f}}}}} {f}}}}}}}}}} {f} {f} {f} {f} {f} {f}}}}}}}}}f}}}}}}}}} {f} {f} {f} {fnf}}}}}}}}}}}}} {f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {f} {f} t}

Números complejos a y a* son reemplazados por el operador de aniquilación a^ ^ {displaystyle {hat {}}} y el operador de creación a^ ^ † † {displaystyle {hat {fn} {fnK} {fnMicrosoft}}} {fnMicrosoft}}} {fnMicrosoft}}}, respectivamente, donde † denota conjugación hermitiana. La relación de conmutación entre los dos es

- [a^ ^ ,a^ ^ † † ]=1.{displaystyle left [{hat {hat {ha} {d} {dgger }right]=1.}

El hamiltoniano del oscilador armónico simple se puede escribir como

- H^ ^ =▪ ▪ ⋅ ⋅ a^ ^ † † a^ ^ +12▪ ▪ ⋅ ⋅ .{displaystyle {hat {f}=hbar omega {hat {f}{dgger} {f}} {f}}}hbar omega {f} {f} {f}f} {fnf}}}} {f}f}}f}f}f}f}f}f}}}}}}}}\hbarhbarhbarhbarhbarf}}} {f}} {f}}f}}} {f} {f} {f} {f}f}f}f}}}f}}}}}}}}hbarhbarf} {f}}} {f} {f}}}}f} {f}f} {f}f}}}}}}}}}f}}}}}}f}}}}}}f}}}}}}} {hbar omega}

El estado de vacío Silencio0.. {displaystyle Silencioso, que es el estado de energía más bajo, se define por

- a^ ^ Silencio0.. =0{displaystyle {hat {fnh} =0}

y tiene energía 12▪ ▪ ⋅ ⋅ {displaystyle {frac {2}hbar omega }Uno puede comprobar fácilmente que [H^ ^ ,a^ ^ † † ]=▪ ▪ ⋅ ⋅ ,{displaystyle [{hat {H},{hat {dgger}=hbar omega} que implica a^ ^ † † {displaystyle {hat {fn} {fnK} {fnMicrosoft}}} {fnMicrosoft}}} {fnMicrosoft}}} aumenta la energía del oscilador armónico simple por ▪ ▪ ⋅ ⋅ {displaystyle hbar omega }. Por ejemplo, el estado a^ ^ † † Silencio0.. {displaystyle {hat {ha} {dgger }Sobreviv0rangle } es un eigenstat de energía 3▪ ▪ ⋅ ⋅ /2{displaystyle 3hbar omega /2}. Cualquier estado de energía eigenstat de un único oscilador armónico se puede obtener de Silencio0.. {displaystyle Silencioso aplicando sucesivamente el operador de creación a^ ^ † † {displaystyle {hat {fn} {fnK} {fnMicrosoft}}} {fnMicrosoft}}} {fnMicrosoft}}}: y cualquier estado del sistema se puede expresar como una combinación lineal de los estados

- Silencion.. ∝ ∝ ()a^ ^ † † )nSilencio0.. .{displaystyle TENIDOrangle propto left({hat {a}{dagger }right)^{n}Antes0rangle.}

Un procedimiento similar se puede aplicar al campo de escalar real φ, al promoverlo a un operador de campo cuántico φ φ ^ ^ {displaystyle {hat {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {f}fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {f}fnMicrosoft {\fnMicrosoft {fnMicrosoft {fnMicrosoft {f}f}f}\fnMicrosoft {\fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\\\fn\\\\\fnfn\\\fnfnMicrosoft {\\\fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\\fnMicrosoft {\\\\fnMicrosoft {\fnMin }, mientras el operador de aniquilación a^ ^ p{displaystyle {hat {f} {fnMitbf}} {f}} {f}} {f}} {f}} {fn}}}}}} {fn}}}}}}} {fnf}}}}}, el operador de creación a^ ^ p† † {displaystyle {hat {fnh} {fnh} {fnh} {fnh} {fn}} {\fnK}}}} {fnfnK}}}} {fnfn}}} y la frecuencia angular wp{displaystyle w_{mathbf {}}son ahora para un particular p:

- φ φ ^ ^ ()x,t)=∫ ∫ d3p()2π π )312⋅ ⋅ p()a^ ^ pe− − i⋅ ⋅ pt+ip⋅ ⋅ x+a^ ^ p† † ei⋅ ⋅ pt− − ip⋅ ⋅ x).{fnh} {fnh} {fnh}} {fnh}} {fnh}} {fnh}} {fnh}} {fn} {fnh} {fnh} {fn}} {f}f} {f} {f}f}f} {f}f}f} {f}f}f}f}f}}f}f}}f}f}f}}f}}}}}}f} {f}f}}}}}}f}f} {f}}f}}}}}}f} {f} {f}f}f} {f}f} {f}f}}f}f}}}f}}}}}}}}}}f}}}}}}}}}}}}}}}}}}}}}}}}} ¿Qué? - ¿Qué? ¿Qué? }t-imathbf {p} cdot mathbf {x}right).}

Sus relaciones de conmutación son:

- [a^ ^ p,a^ ^ q† † ]=()2π π )3δ δ ()p− − q),[a^ ^ p,a^ ^ q]=[a^ ^ p† † ,a^ ^ q† † ]=0,{fnMicrosoft} {fnMicrosoft} {fnMicrosoft} {f} {f} {f} {f} {f} {f}f} {f} {f} {f}f}f} {f}f} {f}f}f}f}f}f}f}f} {f}f} {f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f} {fnMitbf} {fnMitbf} {fnMitbf} {fnMitbf {f} {\fnMitbf} {\fnMicrosoft}fnMicrosoft,}

Donde δ es la función Dirac delta. El estado de vacío Silencio0.. {displaystyle Silencioso se define por

- a^ ^ pSilencio0.. =0,para todosp.{displaystyle {hat {f} {fnMitbf} =0,quad {text{for all }mathbf {p}

Cualquier estado cuántico del campo se puede obtener de Silencio0.. {displaystyle Silencioso por operadores de creación sucesivamente a^ ^ p† † {displaystyle {hat {fnh} {fnh} {fnh} {fnh} {fn}} {\fnK}}}} {fnfnK}}}} {fnfn}}} (o por una combinación lineal de tales estados), por ejemplo.

- ()a^ ^ p3† † )3a^ ^ p2† † ()a^ ^ p1† † )2Silencio0.. .{displaystyle left {fnh}_{mhbf {fnK} {fnMicrosoft Sans Serif} {fnK} {fnK} {fnK} {fnK}f}fnh}\\fn\fnh}\\fn}\\fnK}fnK}f}\\fn\\fnh9}\fnKfnKfnK}}\\\\\\fnK}\\\\\\\\\\fnH0}\fnK\\\fnK\\\\\fnK\\\\\\\\\\\fnKfnK\fnK\\\fnKfnK\\fnK\\fn}\fn}\\\\\\\\\\\ Oh, Dios mío.

Mientras que el espacio de estado de un solo oscilador armónico cuántico contiene todos los estados de energía discretos de una partícula oscilante, el espacio de estado de un campo cuántico contiene los niveles de energía discretos de un número arbitrario de partículas. Este último espacio se conoce como espacio de Fock, lo que puede explicar el hecho de que los números de partículas no son fijos en los sistemas cuánticos relativistas. El proceso de cuantificar un número arbitrario de partículas en lugar de una sola partícula a menudo también se denomina segunda cuantificación.

El procedimiento anterior es una aplicación directa de la mecánica cuántica no relativista y se puede utilizar para cuantificar campos escalares (complejos), campos de Dirac, campos vectoriales (por ejemplo, el campo electromagnético) e incluso cadenas. Sin embargo, los operadores de creación y aniquilación solo están bien definidos en las teorías más simples que no contienen interacciones (la llamada teoría libre). En el caso del campo escalar real, la existencia de estos operadores fue consecuencia de la descomposición de las soluciones de las ecuaciones clásicas del movimiento en una suma de modos normales. Para realizar cálculos sobre cualquier teoría de interacción realista, sería necesaria la teoría de la perturbación.

El lagrangiano de cualquier campo cuántico en la naturaleza contendría términos de interacción además de los términos de la teoría libre. Por ejemplo, se podría introducir un término de interacción cuartica al Lagrangiano del campo escalar real:

- L=12()∂ ∂ μ μ φ φ )()∂ ∂ μ μ φ φ )− − 12m2φ φ 2− − λ λ 4!φ φ 4,{displaystyle {mathcal {}={frac {1}{2} {partial _{mu }phi)left(partial ^{mu }phi right)-{frac {1}{2}m^{2}phi ^{2}-{2}-{frac {lambda } {4}phi ^{4}

Donde μ es un índice espacial, ∂ ∂ 0=∂ ∂ /∂ ∂ t,∂ ∂ 1=∂ ∂ /∂ ∂ x1{displaystyle partial _{0}=partial /partial t, ¿Por qué?, etc. La suma sobre el índice μ ha sido omitido siguiendo la notación de Einstein. Si el parámetro λ es suficientemente pequeña, entonces la teoría de interacción descrita por el Lagrangiano anterior puede ser considerada como una pequeña perturbación de la teoría libre.

Integrales de trayectoria

La formulación integral de QFT se refiere a la computación directa de la amplitud dispersa de un determinado proceso de interacción, en lugar del establecimiento de operadores y espacios estatales. Para calcular la amplitud de probabilidad de un sistema para evolucionar desde un estado inicial Silencioφ φ I.. {displaystyle Silenciophi _{I}rangle } a la vez t = 0 a algún estado final Silencioφ φ F.. {displaystyle Silenciophi _{F}rangle } a t = T, el tiempo total T se divide en N pequeños intervalos. La amplitud general es el producto de la amplitud de la evolución dentro de cada intervalo, integrado en todos los estados intermedios. Vamos H ser el Hamiltonian (i.e. generador de la evolución del tiempo), entonces

- .. φ φ FSilencioe− − iHTSilencioφ φ I.. =∫ ∫ dφ φ 1∫ ∫ dφ φ 2⋯ ⋯ ∫ ∫ dφ φ N− − 1.. φ φ FSilencioe− − iHT/NSilencioφ φ N− − 1.. ⋯ ⋯ .. φ φ 2Silencioe− − iHT/NSilencioφ φ 1.. .. φ φ 1Silencioe− − iHT/NSilencioφ φ I.. .{displaystyle langle phi - Hola. _{I}rangle =int dphi _{1}int dphi _{2}cdots int dphi _{N-1},langle phi _{F} vivene^{-iHT/N} _{N-1}rangle cdots langle phi _{2} WordPress{-iHT/N} ################################################################################################################################################################################################################################################################ ¿Qué?

Tomando el límite N → ∞, el producto de integrales anterior se convierte en la integral de trayectoria de Feynman:

- .. φ φ FSilencioe− − iHTSilencioφ φ I.. =∫ ∫ Dφ φ ()t)exp {}i∫ ∫ 0TdtL},{displaystyle langle phi - Hola. ¿Por qué? Lright},}

donde L es el Lagrangiano que involucra ϕ y su derivadas con respecto a las coordenadas espaciales y temporales, obtenidas del hamiltoniano H a través de la transformación de Legendre. Las condiciones inicial y final de la integral de trayectoria son respectivamente

- φ φ ()0)=φ φ I,φ φ ()T)=φ φ F.{displaystyle phi (0)=phi {I},quad phi (T)=phi _{F}

En otras palabras, la amplitud general es la suma de la amplitud de todos los caminos posibles entre los estados inicial y final, donde la amplitud de un camino viene dada por la exponencial en el integrando.

Función de correlación de dos puntos

En los cálculos, a menudo se encuentran expresiones como

La función libre de dos puntos, también conocida como propagador de Feynman, se puede encontrar para el campo escalar real mediante cuantificación canónica o integrales de trayectoria para ser

- .. 0SilencioT{}φ φ ()x)φ φ ()Sí.)}Silencio0.. ↑ ↑ DF()x− − Sí.)=limε ε → → 0∫ ∫ d4p()2π π )4ipμ μ pμ μ − − m2+iε ε e− − ipμ μ ()xμ μ − − Sí.μ μ ).{displaystyle langle 0 impert{phi (x)phi (y)} arrest0rangle equiv D_{F}(x-y)=lim _{epsilonto 0}int {frac {fnK} {fnMicrosoft Sans Serif} {fnMicroc}} {fnMicroc} {fnK} {fnK} {fnK} {f}} {f}} {fn}} {fn}} {fn}}} {fn}} {fn}} {fnfn}} {f}}} {fn}}}}} {fnf}}}} {f}}}} {f}}}} {\\\\\\\\\\\fnfnfnfn\\fn\\fn\\fnf}}}\\fn\\\\\\\\fnh}}}}}}\\\\\fn}}}\\fnfn}}}}\\\\\\\\fn}}}}}}fn. }-m^{2}+iepsilon Oh, Dios.

En una teoría de interacción, donde el lagrangiano o Hamiltoniano contiene términos LI()t){displaystyle L_{I}(t)} o HI()t){displaystyle H_{I}(t)} que describen interacciones, la función de dos puntos es más difícil de definir. Sin embargo, a través de la formulación canónica de cuantificación y la formulación integral del camino, es posible expresarlo a través de una serie infinita de perturbaciones de la gratis función de dos puntos.

En la cuantificación canónica, la función de correlación de dos puntos se puede escribir como:

- .. Ω Ω SilencioT{}φ φ ()x)φ φ ()Sí.)}SilencioΩ Ω .. =limT→ → JUEGO JUEGO ()1− − iε ε ).0SilencioT{}φ φ I()x)φ φ I()Sí.)exp [− − i∫ ∫ − − TTdtHI()t)]}Silencio0..0SilencioT{}exp [− − i∫ ∫ − − TTdtHI()t)]}Silencio0.,{displaystyle langle Omega SilencioT{phi (x)phi (y)} AnteriorOmega rangle =lim _{Tto infty (1-iepsilon)}{frac {leftlangle 0left durableTleft{phi _{I}(x)phi _{I}(y)displaystylei} {i} {langlei} {langlelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelanglelangle ¿Por qué? }{leftlangle 0left ¿Por qué?

Donde ε es un número infinitesimal y φI es el operador de campo bajo la teoría libre. Aquí, el exponencial debe ser entendido como su expansión de la serie de potencia. Por ejemplo, en φ φ 4{displaystyle phi ^{4}-teoría, el término de interacción del Hamiltonian es HI()t)=∫ ∫ d3xλ λ 4!φ φ I()x)4{textstyle H_{I}(t)=int d^{3}x,{frac {lambda } {4}}phi _{I}(x)^{4}, y la expansión del correlator de dos puntos en términos de λ λ {displaystyle lambda } se convierte en

En la formulación de la integral de trayectoria, la función de correlación de dos puntos se puede escribir

- .. Ω Ω SilencioT{}φ φ ()x)φ φ ()Sí.)}SilencioΩ Ω .. =limT→ → JUEGO JUEGO ()1− − iε ε )∫ ∫ Dφ φ φ φ ()x)φ φ ()Sí.)exp [i∫ ∫ − − TTd4zL]∫ ∫ Dφ φ exp [i∫ ∫ − − TTd4zL],{displaystyle langle Omega tenciónT{phi (x)phi (y)} AnteriorOmega rangle =lim _{Tto infty (1-iepsilon)}{frac {int {in {mathcal {D}phi ,phi (x)phi (y)expleft[iint {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMitcal] {D}phi ,exp left[iint ¿Qué? }

Donde L{displaystyle {fnMithcal}} es la densidad lagrangiana. Como en el párrafo anterior, el exponencial puede ampliarse como una serie λ, reduciendo la función de dos puntos de interacción a las cantidades en la teoría libre.

El teorema de Wick reduce aún más cualquier función de correlación de n puntos en la teoría libre a una suma de productos de correlación de dos puntos funciones Por ejemplo,

- .. 0SilencioT{}φ φ ()x1)φ φ ()x2)φ φ ()x3)φ φ ()x4)}Silencio0.. =.. 0SilencioT{}φ φ ()x1)φ φ ()x2)}Silencio0.. .. 0SilencioT{}φ φ ()x3)φ φ ()x4)}Silencio0.. +.. 0SilencioT{}φ φ ()x1)φ φ ()x3)}Silencio0.. .. 0SilencioT{}φ φ ()x2)φ φ ()x4)}Silencio0.. +.. 0SilencioT{}φ φ ()x1)φ φ ()x4)}Silencio0.. .. 0SilencioT{}φ φ ()x2)φ φ ()x3)}Silencio0.. .################################################################################################################################################################################################################################################################

Dado que las funciones de correlación que interactúan se pueden expresar en términos de funciones de correlación libres, solo es necesario evaluar estas últimas para calcular todas las cantidades físicas en la teoría de interacción (perturbativa). Esto convierte al propagador de Feynman en una de las magnitudes más importantes de la teoría cuántica de campos.

Diagrama de Feynman

Las funciones de correlación en la teoría de interacción se pueden escribir como una serie de perturbaciones. Cada término de la serie es un producto de los propagadores de Feynman en la teoría libre y puede representarse visualmente mediante un diagrama de Feynman. Por ejemplo, el término λ1 en la función de correlación de dos puntos en el La teoría ϕ4 es

- − − iλ λ 4!∫ ∫ d4z.. 0SilencioT{}φ φ ()x)φ φ ()Sí.)φ φ ()z)φ φ ()z)φ φ ()z)φ φ ()z)}Silencio0.. .{displaystyle {frac {-ilambda }{4!}int d^{4}z,langle 0 privacyT{phi (x)phi (y)phi (z)phi (z)phi (z)phi (z)phi (z)phi (z)}

Después de aplicar el teorema de Wick, uno de los términos es

- 12⋅ ⋅ − − iλ λ 4!∫ ∫ d4zDF()x− − z)DF()Sí.− − z)DF()z− − z).{displaystyle 12cdot {fnMicroc {-ilambda {4}}int d^{4}z,D_{F}(x-z)D_{F}(y-z)D_{F}(z-z). }

En cambio, este término se puede obtener del diagrama de Feynman

El diagrama consta de

- vértices externos conectado con un borde y representado por puntos (aquí etiquetados x{displaystyle x} y Sí.{displaystyle y}).

- vértices internos conectado con cuatro bordes y representado por puntos (aquí etiquetados z{displaystyle z}).

- bordes conectando los vértices y representados por líneas.

Cada vértice corresponde a un solo φ φ {displaystyle phi } factor de campo en el punto correspondiente en tiempo espacial, mientras que los bordes corresponden a los propagadores entre los puntos de tiempo espacial. El término en la serie de perturbaciones correspondiente al diagrama se obtiene escribiendo la expresión que sigue de las llamadas reglas de Feynman:

- Por cada vértice interior zi{displaystyle z_{i}, escriba un factor − − iλ λ ∫ ∫ d4zi{textstyle -ilambda int d^{4}z_{i}.

- Por cada borde que conecta dos vértices zi{displaystyle z_{i} y zj{displaystyle z_{j}, escriba un factor DF()zi− − zj){displaystyle D_{F} (z_{i}-z_{j})}.

- Divide por el factor de simetría del diagrama.

Con el factor de simetría 2{displaystyle 2}, siguiendo estas reglas produce exactamente la expresión anterior. Mediante Fourier transformando el propagador, las reglas Feynman pueden ser reformuladas desde el espacio de posición hasta el espacio de impulso.

Para calcular la función de correlación de n-punto a k -ésimo orden, enumere todos los diagramas de Feynman válidos con n puntos externos y k o menos vértices y luego use las reglas de Feynman para obtener la expresión de cada término. Para ser preciso,

- .. Ω Ω SilencioT{}φ φ ()x1)⋯ ⋯ φ φ ()xn)}SilencioΩ Ω .. {displaystyle langle Omega tenciónT{phi (x_{1})cdots phi (x_{n}}

es igual a la suma de (expresiones correspondientes a) todos los diagramas conectados con n puntos externos. (Los diagramas conectados son aquellos en los que cada vértice está conectado a un punto externo a través de líneas. Los componentes que están totalmente desconectados de las líneas externas a veces se denominan "burbujas de vacío"). En el Según la teoría de interacción ϕ4 discutida anteriormente, cada vértice debe tener cuatro patas.

En aplicaciones realistas, la amplitud de dispersión de una determinada interacción o la tasa de decaimiento de una partícula se pueden calcular a partir de la matriz S, que a su vez se puede encontrar mediante el método del diagrama de Feynman.

Los diagramas de Feynman sin "bucles" se llaman diagramas de nivel de árbol, que describen los procesos de interacción de orden más bajo; aquellos que contienen bucles n se conocen como diagramas de bucle n, que describen contribuciones de orden superior, o correcciones radiativas, a la interacción. Las líneas cuyos extremos son vértices pueden considerarse como la propagación de partículas virtuales.

Renormalización

Las reglas de Feynman se pueden usar para evaluar directamente los diagramas de nivel de árbol. Sin embargo, el cálculo ingenuo de diagramas de bucle como el que se muestra arriba dará como resultado integrales de momento divergentes, lo que parece implicar que casi todos los términos en la expansión perturbativa son infinitos. El procedimiento de renormalización es un proceso sistemático para eliminar dichos infinitos.

Parámetros que aparecen en el Lagrangiano, como la masa m y la constante de acoplamiento λ, no tienen significado físico: m, λ , y la intensidad de campo ϕ no son cantidades medibles experimentalmente y se denominan aquí masa desnuda, constante de acoplamiento desnuda y campo, respectivamente. La masa física y la constante de acoplamiento se miden en algún proceso de interacción y generalmente son diferentes de las cantidades básicas. Mientras se calculan las cantidades físicas de este proceso de interacción, se puede limitar el dominio de las integrales de momento divergentes para que esté por debajo de un límite de momento Λ, obtener expresiones para las cantidades físicas y luego tomar el límite Λ → ∞. Este es un ejemplo de regularización, una clase de métodos para tratar divergencias en QFT, siendo Λ el regulador.

El enfoque ilustrado anteriormente se denomina teoría de la perturbación simple, ya que los cálculos involucran solo las cantidades básicas, como la masa y la constante de acoplamiento. Un enfoque diferente, llamado teoría de la perturbación renormalizada, consiste en utilizar cantidades físicamente significativas desde el principio. En el caso de la teoría ϕ4, la intensidad del campo se redefine primero:

- φ φ =Z1/2φ φ r,{displaystyle phi ¿Qué?

donde ϕ es el campo desnudo, ϕr es el campo renormalizado y Z es una constante a determinar. La densidad lagrangiana se convierte en:

- L=12()∂ ∂ μ μ φ φ r)()∂ ∂ μ μ φ φ r)− − 12mr2φ φ r2− − λ λ r4!φ φ r4+12δ δ Z()∂ ∂ μ μ φ φ r)()∂ ∂ μ μ φ φ r)− − 12δ δ mφ φ r2− − δ δ λ λ 4!φ φ r4,{displaystyle {mathcal {}={frac {1}{2} {partial _{mu }phi _{r})(partial ^{mu }phi _{r})-{frac} {1}{2}m_{2}phi} ¿Qué? {fnMicrode ¡Fi! ¿Qué? {1}{2}delta ¿Por qué? ################################################################################################################################################################################################################################################################ ¿Qué? {delta _{lambda ### {4}phi _{4}}} {4}

donde mr y λr son las constantes de acoplamiento y masa medibles experimentalmente, renormalizadas, respectivamente, y

- δ δ Z=Z− − 1,δ δ m=m2Z− − mr2,δ δ λ λ =λ λ Z2− − λ λ r{displaystyle delta Z-1, quad delta # {m}=m^{2}Z-m_{2}quad delta _{lambda }=lambda Z^{2}-lambda ¿Qué?

son constantes por determinar. Los primeros tres términos son la ϕ4 densidad lagrangiana escrita en términos de las cantidades renormalizadas, mientras que los últimos tres términos son denominados "contratérminos". Como el lagrangiano ahora contiene más términos, los diagramas de Feynman deberían incluir elementos adicionales, cada uno con sus propias reglas de Feynman. El procedimiento se describe a continuación. Primero seleccione un esquema de regularización (como la regularización de corte presentada anteriormente o la regularización dimensional); llame al regulador Λ. Calcule los diagramas de Feynman, en los que los términos divergentes dependerán de Λ. Luego, defina δZ, δm, y δλ tales que los diagramas de Feynman para los contratérminos cancelarán exactamente los términos divergentes en los diagramas normales de Feynman cuando se toma el límite Λ → ∞. De esta manera, se obtienen cantidades finitas significativas.

Solo es posible eliminar todos los infinitos para obtener un resultado finito en teorías renormalizables, mientras que en teorías no renormalizables los infinitos no pueden eliminarse mediante la redefinición de un pequeño número de parámetros. El modelo estándar de partículas elementales es un QFT renormalizable, mientras que la gravedad cuántica no es renormalizable.

Grupo de renormalización

El grupo de renormalización, desarrollado por Kenneth Wilson, es un aparato matemático que se utiliza para estudiar los cambios en los parámetros físicos (coeficientes en el Lagrangiano) a medida que el sistema se ve en diferentes escalas. La forma en que cada parámetro cambia con la escala se describe mediante su función β. Las funciones de correlación, que subyacen a las predicciones físicas cuantitativas, cambian con la escala según la ecuación de Callan-Symanzik.

Como ejemplo, la constante de acoplamiento en QED, es decir, la carga elemental e, tiene la siguiente función β:

- β β ()e)↑ ↑ 1▪ ▪ ded▪ ▪ =e312π π 2+O()e5),{displaystyle beta (e)equiv {frac {1}{ Lambda {de}{d Lambda }={frac {fnK} {fnMicrosoft Sans Serif} }

donde Λ es la escala de energía bajo la cual se realiza la medición de e. Esta ecuación diferencial implica que la carga elemental observada aumenta a medida que aumenta la escala. La constante de acoplamiento renormalizada, que cambia con la escala de energía, también se denomina constante de acoplamiento en funcionamiento.

La constante de acoplamiento g en la cromodinámica cuántica, una teoría de calibre no abeliana basada en el grupo de simetría SU (3), tiene la siguiente función β:

- β β ()g)↑ ↑ 1▪ ▪ dgd▪ ▪ =g316π π 2()− − 11+23Nf)+O()g5),{displaystyle beta (g)equiv {frac {1}{ Lambda. Lambda. }

donde Nf es el número de sabores de quark. En el caso de que Nf ≤ 16 (el modelo estándar tiene Nf = 6), la constante de acoplamiento g disminuye a medida que aumenta la escala de energía. Por lo tanto, mientras que la interacción fuerte es fuerte a bajas energías, se vuelve muy débil en interacciones de alta energía, un fenómeno conocido como libertad asintótica.

Las teorías de campos conformes (CFT) son QFT especiales que admiten simetría conforme. Son insensibles a los cambios en la escala, ya que todas sus constantes de acoplamiento tienen función de fuga β. (Sin embargo, lo contrario no es cierto: la desaparición de todas las funciones β no implica simetría conforme de la teoría). Los ejemplos incluyen la teoría de cuerdas y la teoría de Yang-Mills N = 4 supersimétrica.

Según la imagen de Wilson, cada QFT está acompañado fundamentalmente por su corte de energía Λ, es decir que la teoría no es válido a energías superiores a Λ, y se deben omitir todos los grados de libertad por encima de la escala Λ. Por ejemplo, el corte podría ser el inverso del espaciado atómico en un sistema de materia condensada, y en la física de partículas elementales podría estar asociado con la "granulosidad" del espacio-tiempo causado por fluctuaciones cuánticas en la gravedad. La escala de corte de las teorías de las interacciones de partículas se encuentra mucho más allá de los experimentos actuales. Incluso si la teoría fuera muy complicada a esa escala, siempre que sus acoplamientos sean lo suficientemente débiles, debe describirse a bajas energías mediante una teoría de campo efectivo renormalizable. La diferencia entre las teorías renormalizables y no renormalizables es que las primeras son insensibles a los detalles a altas energías, mientras que las segundas sí dependen de ellos. De acuerdo con este punto de vista, las teorías no renormalizables deben verse como teorías efectivas de baja energía de una teoría más fundamental. El hecho de que no se elimine el límite Λ de los cálculos en dicha teoría simplemente indica que aparecen nuevos fenómenos físicos en escalas superiores a Λ, donde es necesaria una nueva teoría.

Otras teorías

Los procedimientos de cuantificación y renormalización descritos en las secciones anteriores se realizan para la teoría libre y la teoría ϕ4 del campo escalar real. Se puede realizar un proceso similar para otros tipos de campos, incluido el campo escalar complejo, el campo vectorial y el campo de Dirac, así como otros tipos de términos de interacción, incluida la interacción electromagnética y la interacción de Yukawa.

Como ejemplo, la electrodinámica cuántica contiene un campo de Dirac ψ que representa el campo de electrones y un campo vectorial Aμ que representa el campo electromagnético (campo de fotones). (A pesar de su nombre, el 'campo' electromagnético cuántico en realidad corresponde a los cuatro potenciales electromagnéticos clásicos, en lugar de a los campos eléctricos y magnéticos clásicos). La densidad QED Lagrangiana completa es:

- L=↑ ↑ ̄ ̄ ()iγ γ μ μ ∂ ∂ μ μ − − m)↑ ↑ − − 14Fμ μ .. Fμ μ .. − − e↑ ↑ ̄ ̄ γ γ μ μ ↑ ↑ Aμ μ ,{displaystyle {mathcal {}={bar {psi}left(igamma ^{mu}partial _{mu} }-mright)psi -{frac {1} {4}F_{munu }F^{munu }-e{bar {psi }gamma ^{mu }psi A_{mu }}

Donde γμ son matrices Dirac, ↑ ↑ ̄ ̄ =↑ ↑ † † γ γ 0{displaystyle {bar {fnfnfnMicrosoft {fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\fnMicrosoft {fnMicrosoft {\fnMicrosoft {\\fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\\\\fnMicrosoft {\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\fnMin., y Fμ μ .. =∂ ∂ μ μ A.. − − ∂ ∂ .. Aμ μ {displaystyle F_{munu }=partial _{mu }A_{nu }-partial _{nu }A_{mu } es la fuerza del campo electromagnético. Los parámetros de esta teoría son la masa de electrones (bare) m y el cargo elemental e. Los términos primero y segundo en la densidad lagrangiana corresponden al campo libre Dirac y los campos vectoriales libres, respectivamente. El último término describe la interacción entre los campos de electrones y fotones, que se trata como una perturbación de las teorías libres.

Arriba se muestra un ejemplo de un diagrama de Feynman a nivel de árbol en QED. Describe un electrón y un positrón que se aniquilan, crean un fotón fuera de la capa y luego se descomponen en un nuevo par de electrones y positrones. El tiempo corre de izquierda a derecha. Las flechas que apuntan hacia adelante en el tiempo representan la propagación de positrones, mientras que las que apuntan hacia atrás en el tiempo representan la propagación de electrones. Una línea ondulada representa la propagación de un fotón. Cada vértice en los diagramas QED de Feynman debe tener una pata de fermión (positrón/electrón) entrante y saliente, así como una pata de fotón.

Simetría de calibre

Si la siguiente transformación a los campos se realiza en cada punto del espacio-tiempo x (una transformación local), entonces el QED Lagrangian permanece sin cambios, o invariante:

- ↑ ↑ ()x)→ → eiα α ()x)↑ ↑ ()x),Aμ μ ()x)→ → Aμ μ ()x)+ie− − 1e− − iα α ()x)∂ ∂ μ μ eiα α ()x),{displaystyle psi (x)to e^{ialpha (x)}psi (x),quad A_{mu }(x)to A_{mu }(x)+ie^{-1}e^{-ialpha (x)}partial _{mu }e^{ialpha (x)}

Donde α()x) es cualquier función de las coordenadas espacio-tiempo. Si el Lagrangiano de una teoría (o más precisamente la acción) es invariante bajo una determinada transformación local, entonces la transformación se denomina simetría de calibre de la teoría. Las simetrías de Gauge forman un grupo en cada punto espacial. En el caso de QED, la sucesiva aplicación de dos transformaciones de simetría local diferentes eiα α ()x){displaystyle e^{ialpha (x)} y eiα α .()x){displaystyle e^{ialpha '(x)} es otra transformación simetría ei[α α ()x)+α α .()x)]{displaystyle e^{i[alpha (x)+alpha '(x)}}. Para cualquier α()x), eiα α ()x){displaystyle e^{ialpha (x)} es un elemento del U(1) grupo, por lo tanto se dice que QED U(1) Simetría de calibre. El campo de fotones Aμ puede ser referido como U(1) Gauge boson.

U(1) es un grupo abeliano, lo que significa que el resultado es el mismo independientemente del orden en que se apliquen sus elementos. Los QFT también se pueden construir en grupos no abelianos, lo que da lugar a teorías de calibre no abelianas (también conocidas como teorías de Yang-Mills). La cromodinámica cuántica, que describe la interacción fuerte, es una teoría de calibre no abeliana con una simetría de calibre SU(3). Contiene tres campos de Dirac ψi, i = 1,2,3 que representan quark así como ocho campos vectoriales Aa,μ, a = 1,...,8 que representan campos de gluones, que son los bosones de calibre SU(3). La densidad lagrangiana QCD es:

- L=i↑ ↑ ̄ ̄ iγ γ μ μ ()Dμ μ )ij↑ ↑ j− − 14Fμ μ .. aFa,μ μ .. − − m↑ ↑ ̄ ̄ i↑ ↑ i,{displaystyle {mathcal {}=i{bi}} {i}gamma ^{mu }(D_{mu })}} {i}i} {i} {i}f}f} {1}{4}F_{munu } {a} {c} {c} {c} {c} {c} {c} {c}} {c}}} {c}} {c}} {c}} {c} {c} {c} {c}} {c} {c}}}}}} {c} {c}}} {c}}}}} {c} {cc}}}}}}c}}c}}} {cccccccccccccccccccccccccccccccccccccccccc}}}}}cc}}}}cccccccc}} ¿Qué?

donde Dμ es la derivada covariante de medida:

- Dμ μ =∂ ∂ μ μ − − igAμ μ ata,{displaystyle D_{mu }=partial _{mu ¿Qué?

donde g es la constante de acoplamiento, ta son los ocho generadores de SU(3) en la representación fundamental (matrices 3×3),

- Fμ μ .. a=∂ ∂ μ μ A.. a− − ∂ ∂ .. Aμ μ a+gfabcAμ μ bA.. c,{displaystyle ¿Por qué? }A_{nu ¿Qué? }

y fabc son las constantes de estructura de SU(3). Los índices repetidos i,j,a se suman implícitamente siguiendo la notación de Einstein. Este Lagrangiano es invariante bajo la transformación:

- ↑ ↑ i()x)→ → Uij()x)↑ ↑ j()x),Aμ μ a()x)ta→ → U()x)[Aμ μ a()x)ta+ig− − 1∂ ∂ μ μ ]U† † ()x),{displaystyle psi ^{i}(x)to U^{ij}(x)psi ^{j}(x),quad A_{mu }{a}(x)t^{a}to U(x)left[A_{mu } {x)t^{a}{-1}partial _{gger

donde U(x) es un elemento de SU(3) en cada punto del espacio-tiempo x:

- U()x)=eiα α ()x)ata.{displaystyle U(x)=e^{ialpha (x)}{a}t^{a}}

La discusión anterior de las simetrías está en el nivel del lagrangiano. En otras palabras, son simetrías "clásicas". Después de la cuantificación, algunas teorías ya no exhibirán sus simetrías clásicas, un fenómeno llamado anomalía. Por ejemplo, en el camino formulación integral, a pesar de la invariancia de la densidad lagrangiana L[φ φ ,∂ ∂ μ μ φ φ ]{displaystyle {mathcal {}[phipartial _{mu }phi] bajo cierta transformación local de los campos, la medida ∫ ∫ Dφ φ {textstyle int {mathcal {}phi } de la ruta integral puede cambiar. Para que una teoría que describa la naturaleza sea consistente, no debe contener ninguna anomalía en su simetría de calibre. El modelo estándar de partículas elementales es una teoría de calibre basada en el grupo SU(3) × SU(2) × U(1), en la que todas las anomalías cancelan exactamente.

La base teórica de la relatividad general, el principio de equivalencia, también puede entenderse como una forma de simetría de calibre, lo que convierte a la relatividad general en una teoría de calibre basada en el grupo de Lorentz.

El teorema de Noether establece que toda simetría continua, es decir, el parámetro en la transformación de simetría es continuo en lugar de discreto, conduce a una ley de conservación correspondiente. Por ejemplo, la simetría U(1) de QED implica la conservación de la carga.

Las transformaciones de calibre no relacionan estados cuánticos distintos. Más bien, relaciona dos descripciones matemáticas equivalentes del mismo estado cuántico. Como ejemplo, el campo de fotones Aμ, al ser un cuatro vector, tiene cuatro grados de libertad aparentes, pero el estado real de un fotón se describe por sus dos grados de libertad correspondientes a la polarización. Se dice que los dos grados de libertad restantes son "redundantes" — formas aparentemente diferentes de escribir Aμ se pueden relacionar entre sí mediante una transformación de calibre y, de hecho, describen lo mismo estado del campo de fotones. En este sentido, la invariancia de calibre no es un "real" simetría, sino un reflejo de la "redundancia" de la descripción matemática elegida.

Para tener en cuenta la redundancia de calibre en la formulación de la integral de trayectoria, se debe realizar el llamado procedimiento de fijación de calibre de Faddeev-Popov. En las teorías de norma no abeliana, este procedimiento introduce nuevos campos llamados "fantasmas". Las partículas correspondientes a los campos fantasma se denominan partículas fantasma, que no pueden detectarse externamente. La cuantificación BRST proporciona una generalización más rigurosa del procedimiento de Faddeev-Popov.

Rotura de simetría espontánea

La ruptura espontánea de la simetría es un mecanismo por el cual la simetría del Lagrangiano es violada por el sistema descrito por este.

Para ilustrar el mecanismo, considere un modelo sigma lineal que contenga N campos escalares reales, descritos por la densidad lagrangiana:

- L=12()∂ ∂ μ μ φ φ i)()∂ ∂ μ μ φ φ i)+12μ μ 2φ φ iφ φ i− − λ λ 4()φ φ iφ φ i)2,{fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif}

donde μ y λ son parámetros reales. La teoría admite una simetría global O(N):

- φ φ i→ → Rijφ φ j,R▪ ▪ O()N).{displaystyle phi ^{i}to ################################################################################################################################################################################################################################################################ Rin mathrm {O} (N). }

El estado de energía más bajo (estado fundamental o estado de vacío) de la teoría clásica es cualquier campo uniforme ϕ0 satisfactorio

- φ φ 0iφ φ 0i=μ μ 2λ λ .{displaystyle phi _{0} {fn}fnK} ¿Por qué? }}

Sin pérdida de generalidad, permita que el estado fundamental esté en la dirección N-ésima:

- φ φ 0i=()0,⋯ ⋯ ,0,μ μ λ λ ).{displaystyle phi _{0}=left(0,cdots0,{frac {mu }{sqrt {lambda}}}right). }

Los campos N originales se pueden reescribir como:

- φ φ i()x)=()π π 1()x),⋯ ⋯ ,π π N− − 1()x),μ μ λ λ +σ σ ()x)),{displaystyle phi ^{i}(x)=left(pi ^{1}(x),cdotspi ^{N-1}(x),{frac {mu }{sqrt {lambda - Sí.

y la densidad lagrangiana original como:

- L=12()∂ ∂ μ μ π π k)()∂ ∂ μ μ π π k)+12()∂ ∂ μ μ σ σ )()∂ ∂ μ μ σ σ )− − 12()2μ μ 2)σ σ 2− − λ λ μ μ σ σ 3− − λ λ μ μ π π kπ π kσ σ − − λ λ 2π π kπ π kσ σ 2− − λ λ 4()π π kπ π k)2,{fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicros {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif}f}}}}}fnMicros}fnMicroc}f}fnMicrosigual}fnMicros}}f}f} {fnMicrob}}fnMicros}f}}f}fnMicrocf}}fnMicrossssssssssssigual}}fnun}fnMicroc}fnMicros}fnMicrosigual}f}fnMicroc}fnMinun}f}fnMi }sigma right)-{2}left(2mu ^{2}sigma ^{2}-{2}-{sqrt {lambda }mu sigma ^{3}-{sqrt {lambda }}mu ################################################################################################################################################################################################################################################################ - ¿Qué? } {2}pi ^{k}sigma ^{2}-{frac {lambda } {4}left(pi ^{k}pi }right)^{2}

donde k = 1,..., N − 1. La simetría global O(N) original ya no se manifiesta, dejando solo el subgrupo O(N − 1). Se dice que la simetría más grande antes de la ruptura espontánea de la simetría está 'oculta'. o se rompe espontáneamente.

El teorema de Goldstone establece que, en caso de ruptura espontánea de la simetría, toda simetría global continua rota conduce a un campo sin masa llamado bosón de Goldstone. En el ejemplo anterior, O(N) tiene N(N − 1)/2 simetrías continuas (la dimensión de su álgebra de Lie), mientras que O(N − 1) tiene (N − 1)(N − 2)/2. El número de simetrías rotas es su diferencia, N − 1, que corresponde a N − 1 campos sin masa πk.

Por otro lado, cuando una simetría de calibre (a diferencia de la global) se rompe espontáneamente, el bosón de Goldstone resultante se "come" por el bosón de calibre correspondiente convirtiéndose en un grado de libertad adicional para el bosón de calibre. El teorema de equivalencia del bosón de Goldstone establece que a alta energía, la amplitud de emisión o absorción de un bosón de calibre masivo polarizado longitudinalmente se vuelve igual a la amplitud de emisión o absorción del bosón de Goldstone que fue devorado por el bosón de calibre.

En la QFT del ferromagnetismo, la ruptura espontánea de la simetría puede explicar la alineación de los dipolos magnéticos a bajas temperaturas. En el modelo estándar de partículas elementales, los bosones W y Z, que de otro modo no tendrían masa como resultado de la simetría de calibre, adquieren masa a través de la ruptura espontánea de la simetría del bosón de Higgs, un proceso llamado mecanismo de Higgs.

Supersimetría

Todas las simetrías conocidas experimentalmente en la naturaleza relacionan bosones con bosones y fermiones con fermiones. Los teóricos han planteado la hipótesis de la existencia de un tipo de simetría, llamada supersimetría, que relaciona bosones y fermiones.

El Modelo Estándar obedece a la simetría de Poincaré, cuyos generadores son las traslaciones del espacio-tiempo Pμ y las transformaciones de Lorentz Jμν. Además de estos generadores, la supersimetría en dimensiones (3+1) incluye generadores adicionales Qα, llamados supercargas, que a su vez se transforman en fermiones de Weyl. El grupo de simetría generado por todos estos generadores se conoce como grupo de super-Poincaré. En general, puede haber más de un conjunto de generadores de supersimetría, QαI, I = 1,..., N, que generan el correspondiente N = 1 supersimetría, N = 2 supersimetría, etc. La supersimetría también se puede construir en otras dimensiones, sobre todo en (1+1) dimensiones para su aplicación en la teoría de supercuerdas.

El Lagrangiano de una teoría supersimétrica debe ser invariante bajo la acción del grupo super-Poincaré. Los ejemplos de tales teorías incluyen: Modelo estándar mínimo supersimétrico (MSSM), N = 4 teoría supersimétrica de Yang-Mills y teoría de supercuerdas. En una teoría supersimétrica, cada fermión tiene un supercompañero bosónico y viceversa.

Si la supersimetría se promueve a una simetría local, entonces la teoría de calibre resultante es una extensión de la relatividad general llamada supergravedad.

La supersimetría es una solución potencial para muchos problemas actuales de la física. Por ejemplo, el problema de la jerarquía del modelo estándar (por qué la masa del bosón de Higgs no se corrige radiativamente (bajo renormalización) a una escala muy alta, como la gran escala unificada o la escala de Planck) puede resolverse relacionando el campo de Higgs y su súper socio, el Higgsino. Las correcciones radiativas debidas a los bucles del bosón de Higgs en los diagramas de Feynman se cancelan con los correspondientes bucles de Higgsino. La supersimetría también ofrece respuestas a la gran unificación de todas las constantes de acoplamiento de calibre en el modelo estándar, así como a la naturaleza de la materia oscura.

Sin embargo, a partir de 2018, los experimentos aún tienen que proporcionar evidencia de la existencia de partículas supersimétricas. Si la supersimetría fuera una verdadera simetría de la naturaleza, entonces debe ser una simetría rota, y la energía de la ruptura de la simetría debe ser mayor que la que se puede lograr con los experimentos actuales.

Otros espaciotiempos

La teoría ϕ4, QED, QCD, así como todo el modelo estándar asumen un (3 +1) espacio de Minkowski dimensional (3 dimensiones espaciales y 1 temporal) como fondo sobre el que se definen los campos cuánticos. Sin embargo, QFT a priori no impone ninguna restricción en el número de dimensiones ni en la geometría del espacio-tiempo.

En la física de la materia condensada, QFT se usa para describir gases de electrones (2+1) dimensionales. En la física de altas energías, la teoría de cuerdas es un tipo de QFT (1+1) dimensional, mientras que la teoría de Kaluza-Klein usa la gravedad en dimensiones adicionales para producir teorías de calibre en dimensiones más bajas.

En el espacio de Minkowski, la métrica plana ημν se usa para aumentar y disminuir los índices del espacio-tiempo en el Lagrangiano, por ejemplo

- Aμ μ Aμ μ =.. μ μ .. Aμ μ A.. ,∂ ∂ μ μ φ φ ∂ ∂ μ μ φ φ =.. μ μ .. ∂ ∂ μ μ φ φ ∂ ∂ .. φ φ ,{displaystyle ¿Qué? }phi partial _{nu }phi}

donde ημν es el inverso de ημν satisfaciendo ημρηρν = δμν. Para QFT en espacio-tiempo curvo, por otro lado, se utiliza una métrica general (como la métrica de Schwarzschild que describe un agujero negro):

- Aμ μ Aμ μ =gμ μ .. Aμ μ A.. ,∂ ∂ μ μ φ φ ∂ ∂ μ μ φ φ =gμ μ .. ∂ ∂ μ μ φ φ ∂ ∂ .. φ φ ,{displaystyle A_{mu }A^{mu }=g_{munu }A^{mu }A^{nu },quad partial _{mu }phi partial ^{mu }phi =g^{munu }partial _{mumu } }phi partial _{nu }phi}

donde gμν es el inverso de gμν. Para un campo escalar real, la densidad lagrangiana en un fondo de espacio-tiempo general es

- L=SilenciogSilencio()12gμ μ .. Silencio Silencio μ μ φ φ Silencio Silencio .. φ φ − − 12m2φ φ 2),{displaystyle {mathcal {fnh}={sqrt {fnh}left({frac {1}{2}}}g^{munu }nabla _{mumu} }phi nabla _{nu }phi -{frac {1} {2}m^{2}phi ^{2}right),}

donde g = det(gμν), y ∇μ denota la derivada covariante. El lagrangiano de una QFT, por lo tanto, sus resultados de cálculo y predicciones físicas, depende de la geometría del fondo del espacio-tiempo.

Teoría topológica cuántica de campos

Las funciones de correlación y las predicciones físicas de un QFT dependen de la métrica del espacio-tiempo gμν. Para una clase especial de QFT llamadas teorías topológicas cuánticas de campo (TQFT), todas las funciones de correlación son independientes de los cambios continuos en la métrica del espacio-tiempo. Los QFT en el espacio-tiempo curvo generalmente cambian de acuerdo con la geometría (estructura local) del fondo del espacio-tiempo, mientras que los TQFT son invariantes bajo los difeomorfismos del espacio-tiempo pero son sensibles a la topología (estructura global) del espaciotiempo. Esto significa que todos los resultados de cálculo de TQFT son invariantes topológicos del espacio-tiempo subyacente. La teoría de Chern-Simons es un ejemplo de TQFT y se ha utilizado para construir modelos de gravedad cuántica. Las aplicaciones de TQFT incluyen el efecto Hall cuántico fraccional y las computadoras cuánticas topológicas. La trayectoria de línea universal de partículas fraccionadas (conocidas como anyons) puede formar una configuración de enlace en el espacio-tiempo, que relaciona las estadísticas de trenzado de anyons en física con la Invariantes de enlace en matemáticas. Las teorías de campos cuánticos topológicos (TQFT) aplicables a la investigación de frontera de asuntos cuánticos topológicos incluyen las teorías de calibre de Chern-Simons-Witten en dimensiones de espacio-tiempo 2+1, otras nuevas TQFT exóticas en dimensiones de espacio-tiempo 3+1 y más allá.

Métodos perturbativos y no perturbativos

Usando la teoría de la perturbación, el efecto total de un término de interacción pequeño se puede aproximar orden por orden mediante una serie de expansión en el número de partículas virtuales que participan en la interacción. Cada término en la expansión puede entenderse como una posible forma en que las partículas (físicas) interactúan entre sí a través de partículas virtuales, expresadas visualmente mediante un diagrama de Feynman. La fuerza electromagnética entre dos electrones en QED está representada (a primer orden en la teoría de perturbaciones) por la propagación de un fotón virtual. De manera similar, los bosones W y Z llevan la interacción débil, mientras que los gluones llevan la interacción fuerte. La interpretación de una interacción como una suma de estados intermedios que involucran el intercambio de varias partículas virtuales solo tiene sentido en el marco de la teoría de perturbaciones. En contraste, los métodos no perturbativos en QFT tratan al Lagrangiano interactivo como un todo sin ninguna expansión en serie. En lugar de partículas que llevan interacciones, estos métodos han generado conceptos tales como monopolo de 't Hooft-Polyakov, pared de dominio, tubo de flujo e instanton. Los ejemplos de QFT que se pueden resolver completamente sin perturbaciones incluyen modelos mínimos de teoría de campos conformes y el modelo de Thirring.

Rigor matemático

A pesar de su éxito abrumador en física de partículas y física de materia condensada, QFT en sí mismo carece de una base matemática formal. Por ejemplo, de acuerdo con el teorema de Haag, no existe una imagen de interacción bien definida para QFT, lo que implica que la teoría de perturbaciones de QFT, que subyace a todo el método del diagrama de Feynman, está fundamentalmente mal definida.

Sin embargo, la teoría cuántica de campo perturbativa, que solo requiere que las cantidades sean computables como una serie de potencias formales sin ningún requisito de convergencia, puede recibir un tratamiento matemático riguroso. En particular, la monografía de Kevin Costello Renormalización y teoría del campo efectivo proporciona una formulación rigurosa de la renormalización perturbativa que combina los enfoques de la teoría del campo efectivo de Kadanoff, Wilson y Polchinski, junto con el método de Batalin. -Aproximación de Vilkovisky a la cuantificación de teorías gauge. Además, a los métodos perturbativos de integrales de trayectoria, típicamente entendidos como métodos computacionales formales inspirados en la teoría de integración de dimensión finita, se les puede dar una interpretación matemática sólida a partir de sus análogos de dimensión finita.

Desde la década de 1950, físicos teóricos y matemáticos han intentado organizar todas las QFT en un conjunto de axiomas, para establecer la existencia de modelos concretos de QFT relativista de forma matemáticamente rigurosa y estudiar sus propiedades. Esta línea de estudio se llama teoría cuántica constructiva de campos, un subcampo de la física matemática, que ha llevado a resultados como el teorema CPT, el teorema de la estadística de espín y el teorema de Goldstone, y también a construcciones matemáticamente rigurosas de muchas QFT que interactúan. en dos y tres dimensiones del espacio-tiempo, p. las teorías de campos escalares bidimensionales con interacciones polinómicas arbitrarias, las teorías de campos escalares tridimensionales con una interacción cuártica, etc.