Teorema del límite central

En la teoría de la probabilidad, el teorema del límite central (CLT) establece que, en muchas situaciones, cuando se suman variables aleatorias independientes, su suma correctamente normalizada tiende hacia una distribución normal incluso si las variables originales en sí mismas no se distribuyen normalmente.

El teorema es un concepto clave en la teoría de la probabilidad porque implica que los métodos probabilísticos y estadísticos que funcionan para distribuciones normales pueden aplicarse a muchos problemas que involucran otros tipos de distribuciones.

Este teorema ha experimentado muchos cambios durante el desarrollo formal de la teoría de la probabilidad. Las versiones anteriores del teorema se remontan a 1811, pero en su forma general moderna, este resultado fundamental en la teoría de la probabilidad se estableció con precisión en 1920, sirviendo así como puente entre la teoría de la probabilidad clásica y la moderna.

Si X1,X2,...... ,Xn,...... {textstyle X_{1},X_{2},dots ¿Qué? son muestras aleatorias extraídas de una población con media general μ μ {textstyle mu } y varianza finita σ σ 2{textstyle sigma ^{2}, y si X̄ ̄ n{fnK} es la media muestra de la primera n{textstyle n} muestras, luego la forma de limitar la distribución, Z=limn→ → JUEGO JUEGO ()X̄ ̄ n− − μ μ σ σ X̄ ̄ ){textstyle Z=lim _{ntoinfty }{left({frac {bar {X}_{n}-mu} - Sí., con σ σ X̄ ̄ =σ σ /n{displaystyle sigma _{bar {X}=sigma /{sqrt {n}}, es una distribución normal estándar.

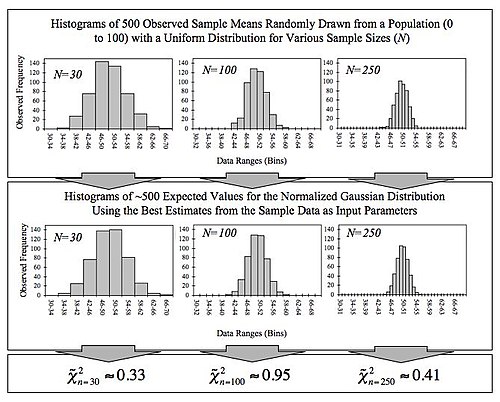

Por ejemplo, suponga que se obtiene una muestra que contiene muchas observaciones, cada observación se genera aleatoriamente de manera que no depende de los valores de las otras observaciones, y que se calcula la media aritmética de los valores observados. Si este procedimiento se realiza muchas veces, el teorema del límite central dice que la distribución de probabilidad del promedio se aproximará mucho a una distribución normal.

El teorema del límite central tiene varias variantes. En su forma común, las variables aleatorias deben ser independientes e idénticamente distribuidas (i.i.d.). En variantes, la convergencia de la media a la distribución normal también ocurre para distribuciones no idénticas o para observaciones no independientes, si cumplen con ciertas condiciones.

La primera versión de este teorema, que la distribución normal puede usarse como una aproximación a la distribución binomial, es el teorema de Moivre-Laplace.

Secuencias independientes

CLT clásica

(feminine)Vamos {}X1,...... ,Xn}{textstyle {X_{1},ldotsX_{n}} ser una secuencia de muestras aleatorias —es decir, una secuencia de variables aleatorias i.i.d extraídas de una distribución de valor esperado dada por μ μ {textstyle mu } y la varianza finita dada por σ σ 2{textstyle sigma ^{2}. Supongamos que estamos interesados en el promedio de la muestra

Por ley de grandes números, los promedios de la muestra convergen casi seguramente (y por lo tanto también convergen en probabilidad) al valor esperado μ μ {textstyle mu } como n→ → JUEGO JUEGO {textstyle nto infty }.

El teorema del límite central clásico describe el tamaño y la forma distributiva de las fluctuaciones estocásticas alrededor del número determinístico μ μ {textstyle mu } durante esta convergencia. Más precisamente, afirma que n{textstyle n} se hace más grande, la distribución de la diferencia entre el promedio de la muestra X̄ ̄ n{fnK} y su límite μ μ {textstyle mu }, cuando se multiplica por el factor n{fnK} ()eso es n()X̄ ̄ n− − μ μ ){fn} {fn} {fn}m}mu}}) aproxima la distribución normal con media 0 y varianza σ σ 2{textstyle sigma ^{2}. Para lo suficientemente grande n, la distribución de X̄ ̄ n{fnK} se acerca arbitrariamente a la distribución normal con media μ μ {textstyle mu } y diferencia σ σ 2/n{textstyle sigma ^{2}/n}.

La utilidad del teorema es que la distribución de n()X̄ ̄ n− − μ μ ){fn} {fn} {fn}m}mu}} enfoques normalidad independientemente de la forma de la distribución del individuo Xi{textstyle X_{i}. Formalmente, el teorema puede ser declarado como sigue:

Lindeberg-Lévy CLT—Suppose {}X1,...... ,Xn,...... }{textstyle {X_{1},ldotsX_{n},ldots } es una secuencia de i.i.d. variables aleatorias con E[Xi]=μ μ {textstyle mathbb {E} [X_{i}=mu} y <math alttext="{textstyle operatorname {Var} [X_{i}]=sigma ^{2}Var [Xi]=σ σ 2.JUEGO JUEGO {textstyle operatorname [X_{i}=sigma<img alt="{textstyle operatorname {Var} [X_{i}]=sigma ^{2}. Entonces n{textstyle n} aborda el infinito, las variables aleatorias n()X̄ ̄ n− − μ μ ){fn} {fn} {fn}m}mu}} converger en la distribución a una normalidad N()0,σ σ 2){fnMitcal {fn}(0,sigma ^{2}}:

En el caso 0}" xmlns="http://www.w3.org/1998/Math/MathML">σ σ ■0{textstyle sigma }0}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/bcd94143f46ebd8bd6cd1c495f5f3ba89e5aae0f" style="vertical-align: -0.338ex; width:5.591ex; height:2.176ex;"/>, convergencia en la distribución significa que las funciones de distribución acumulativa n()X̄ ̄ n− − μ μ ){fn} {fn} {fn}m}mu}} converger punto a punto al cdf del N()0,σ σ 2){fnMitcal {fn}(0,sigma ^{2}} distribución: para cada real Número z{textstyle z},

Liapunov CLT

El teorema es nombrado después del matemático ruso Aleksandr Lyapunov. En esta variante del límite central teorema las variables aleatorias Xi{textstyle X_{i} debe ser independiente, pero no necesariamente distribuido de forma idéntica. El teorema también requiere que variables aleatorias SilencioXiSilencio{textstyle left habitX_{i}right sometida} tener momentos de algún orden ()2+δ δ ){style (2+delta)}, y que la tasa de crecimiento de estos momentos está limitada por la condición Lyapunov dada abajo.

Lyapunov CLT—Suppose {}X1,...... ,Xn,...... }{textstyle {X_{1},ldotsX_{n},ldots } es una secuencia de variables aleatorias independientes, cada una con valor esperado finito μ μ i{textstyle mu _{i}} y diferencia σ σ i2{textstyle sigma ¿Qué?. Define

Si para algunos 0}" xmlns="http://www.w3.org/1998/Math/MathML">δ δ ■0{textstyle delta }0}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/e503a231ad333c0bd9a2dc7d48d8848076423356" style="vertical-align: -0.338ex; width:5.31ex; height:2.343ex;"/>, La condición de Lyapunov

En la práctica es generalmente más fácil comprobar la condición de Lyapunov para δ δ =1{textstyle delta =1}.

Si una secuencia de variables aleatorias satisface la condición de Lyapunov, entonces también satisface la condición de Lindeberg. La implicación inversa, sin embargo, no se sostiene.

Lindeberg CLT

En el mismo escenario y con la misma notación que arriba, la condición de Lyapunov puede ser reemplazada por la siguiente más débil (de Lindeberg en 1920).

Supongamos eso por cada 0}" xmlns="http://www.w3.org/1998/Math/MathML">ε ε ■0{textstyle varepsilon }0}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/e73828dc02cc2d6974733344381d188455ab3d55" style="vertical-align: -0.338ex; width:5.344ex; height:2.176ex;"/>

CLT multidimensional

Pruebas que utilizan funciones características se pueden ampliar a casos en que cada individuo Xi{textstyle mathbf {X} es un vector aleatorio en Rk{textstyle mathbb {R} {K}}, con vector medio μ μ =E[Xi]{textstyle {boldsymbol} }=Mathbb [Mathbf {X} y matriz de covariancia .. {textstyle mathbf {Sigma} (entre los componentes del vector), y estos vectores aleatorios son independientes y distribuidos de forma idéntica. Summation of these vectors is being done component-wise. El teorema multidimensional del límite central establece que cuando se escala, las sumas convergen a una distribución normal multivariada.

Dejar

El teorema del límite central multivariado establece que

La tasa de convergencia viene dada por el siguiente resultado tipo Berry-Esseen:

Theorem—Vamos X1,...... ,Xn,...... {displaystyle X_{1},dotsX_{n},dots } ser independiente Rd{displaystyle mathbb {R}- valorados vectores aleatorios, cada uno tiene cero. Escriba S=.. i=1nXi{displaystyle S=sum ¿Qué? y asumir .. =Cov [S]{displaystyle Sigma = 'operatorname {Cov} [S] es invertible. Vamos Z♪ ♪ N()0,.. ){displaystyle Zsim {mathcal {N}(0,Sigma)} ser un d{displaystyle d}-dimensional Gaussian con la misma matriz de covariancia media y misma S{displaystyle S.. Entonces para todos los juegos de convex U⊆ ⊆ Rd{displaystyle Usubseteq mathbb {R} {d},

Se desconoce si el factor d1/4{textstyle d^{1/4} es necesario.

Teorema generalizado

El teorema límite central establece que la suma de una serie de variables aleatorias independientes y distribuidas idénticamente con varianzas finitas tenderá a una distribución normal a medida que crezca el número de variables. Una generalización debida a Gnedenko y Kolmogorov afirma que la suma de una serie de variables aleatorias con una cola de suegro (la cola pareciana) las distribuciones disminuyen como SilencioxSilencio− − α α − − 1{fnMicrosoftware {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} -1} Donde <math alttext="{textstyle 0<alpha 0.α α .2{textstyle 0 0 0 0.<img alt="{textstyle 0<alpha (y por lo tanto tener varianza infinita) tenderá a una distribución estable f()x;α α ,0,c,0){textstyle f(x;alpha0,c,0)} a medida que crece el número de sumos. Si 2}" xmlns="http://www.w3.org/1998/Math/MathML">α α ■2{textstyle alpha #2}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/f96f18a84500fc9dd0f3dd5a921da13a09d4e851" style="vertical-align: -0.338ex; width:5.749ex; height:2.176ex;"/> entonces la suma converge a una distribución estable con parámetro de estabilidad igual a 2, es decir, una distribución gausiana.

Procesos dependientes

CLT bajo dependencia débil

Una generalización útil de una secuencia de variables aleatorias independientes y distribuidas idénticamente es un proceso de mezcla aleatoria en tiempo discreto; "mixing" significa, aproximadamente, que las variables aleatorias temporalmente lejos de las otras son casi independientes. Varios tipos de mezcla se utilizan en teoría ergodic y teoría de probabilidad. Ver mezcla especialmente fuerte (también llamado α-mixing) definido por α α ()n)→ → 0{textstyle alpha (n)to 0} Donde α α ()n){textstyle alpha (n)} es el denominado coeficiente de mezcla fuerte.

Una formulación simplificada del teorema del límite central bajo mezcla fuerte es:

Theorem—Supongamos que {}X1,...... ,Xn,...... }{textstyle {X_{1},ldotsX_{n},ldots } es estacionario y α α {displaystyle alpha }- mezclando con α α n=O()n− − 5){textstyle alpha ¿Qué? y eso E[Xn]=0{textstyle mathbb {E} [X_{n]=0} y <math alttext="{textstyle mathbb {E} [{X_{n}}^{12}]E[Xn12].JUEGO JUEGO {textstyle mathbb {E} [{X_{n}} {12}]<img alt="{textstyle mathbb {E} [{X_{n}}^{12}]. Denote Sn=X1+⋯ ⋯ +Xn{textstyle S_{n}=X_{1}+cdots #, entonces el límite

De hecho,

Suposición σ σ ل ل 0{textstyle sigma neq 0} no se puede omitir, ya que la normalidad asintotica falla Xn=Yn− − Yn− − 1{fn9} {fn9}}}} Donde Yn{textstyle Y... son otra secuencia estacionaria.

Hay una versión más fuerte del teorema: la suposición <math alttext="{textstyle mathbb {E} left[{X_{n}}^{12}right]E[Xn12].JUEGO JUEGO {textstyle mathbb {E} left [{X_{n}} {12}right] Se hizo 'infty }<img alt="{textstyle mathbb {E} left[{X_{n}}^{12}right] es reemplazado por <math alttext="{textstyle mathbb {E} left[{left|X_{n}right|}^{2+delta }right]E[SilencioXnSilencio2+δ δ ].JUEGO JUEGO {textstyle mathbb {E} left[{left habitX_{n}right sometida}{2+delta ♪ ♪ ♪ ♪ ♪ ♪ ♪ ♪ ♪♪<img alt="{textstyle mathbb {E} left[{left|X_{n}right|}^{2+delta }right], y la hipótesis α α n=O()n− − 5){textstyle alpha ¿Qué? es reemplazado por

Existencia de tal 0}" xmlns="http://www.w3.org/1998/Math/MathML">δ δ ■0{textstyle delta }0}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/e503a231ad333c0bd9a2dc7d48d8848076423356" style="vertical-align: -0.338ex; width:5.31ex; height:2.343ex;"/> asegura la conclusión. Para el tratamiento enciclopédico de teoremas límite en condiciones de mezcla véase (Bradley 2007).

Diferencia de martingala CLT

Theorem—Deja un martingale Mn{textstyle M_{n} satisfacer satisfacción

- 1n.. k=1nE[()Mk− − Mk− − 1)2SilencioM1,...... ,Mk− − 1]→ → 1{displaystyle {frac {fn} {fnK}}}}}sum ¿Qué? {E} left[left(M_{k}-M_{k-1}right)^{2}SobrevivirM_{1},dotsM_{k-1}right]to 1} en la probabilidad como n →,

- para todos ε ■ 0, varepsilon {sqrt {n}}right]right]}to 0}" xmlns="http://www.w3.org/1998/Math/MathML">1n.. k=1nE[()Mk− − Mk− − 1)21[SilencioMk− − Mk− − 1Silencio■ε ε n]]→ → 0{displaystyle {frac {fn} {fnK}}}}}sum ¿Qué? {E} left[left(M_{k}-M_{k-1}right)^{2}mathbf {1} left[ suyaM_{k}-M_{k-1} [sqrt {n}right]to] 0}

varepsilon {sqrt {n}}right]right]}to 0}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/1d1472d6d4a4f31b01758cdb2bf14d6c34c72110" style="vertical-align: -3.005ex; width:53.209ex; height:6.843ex;"/> como n →,

entonces Mnn{textstyle {frac {fn} {fn}} {fn}} {fn}}} {fn}}}} {fn}}}}} {fn}}}} {fn}} {fn}}}} {fn}}}}}}}}}}}}}}} {fn}}}}}}}}}}}}}}} { convergencias en la distribución a N()0,1){textstyle N(0,1)} como n→ → JUEGO JUEGO {textstyle nto infty }.

Observaciones

Prueba de CLT clásica

(feminine)El teorema del límite central tiene una demostración usando funciones características. Es similar a la demostración de la ley (débil) de los grandes números.

Assume {}X1,...... ,Xn,...... }{textstyle {X_{1},ldotsX_{n},ldots } son variables aleatorias independientes y distribuidas idénticamente, cada una con media μ μ {textstyle mu } y varianza finita σ σ 2{textstyle sigma ^{2}. La suma X1+⋯ ⋯ +Xn{textstyle X_{1}+cdots # tiene sentido nμ μ {textstyle nmu} y diferencia nσ σ 2{textstyle nsigma ^{2}. Considere la variable aleatoria

Todos los términos de orden superior desaparecen en el límite n→ → JUEGO JUEGO {textstyle nto infty }. El lado derecho equivale a la función característica de una distribución normal estándar N()0,1){textstyle N(0,1)}, lo que implica a través del teorema de continuidad de Lévy que la distribución de Zn{textstyle Z_{n} enfoque N()0,1){textstyle N(0,1)} como n→ → JUEGO JUEGO {textstyle nto infty }. Por lo tanto, el promedio de la muestra

Convergencia al límite

El teorema del límite central da solo una distribución asintótica. Como aproximación para un número finito de observaciones, proporciona una aproximación razonable solo cuando está cerca del pico de la distribución normal; requiere una gran cantidad de observaciones para extenderse hasta las colas.

La convergencia en el teorema límite central es uniforme porque la función de distribución acumulativa límite es continua. Si el tercer momento central E [()X1− − μ μ )3]{textstyle operatorname {E} left [(X_{1}-mu)^{3}right] existe y es finito, entonces la velocidad de convergencia es al menos en el orden 1/n{textstyle 1/{sqrt {n}} (ver teorema de Berry-Esseen). El método de Stein se puede utilizar no sólo para probar el teorema límite central, sino también para proporcionar límites a las tasas de convergencia para las métricas seleccionadas.

La convergencia a la distribución normal es monotónica, en el sentido de que la entropía Zn{textstyle Z_{n} aumenta monotonicamente a la de la distribución normal.

El teorema del límite central se aplica en particular a las sumas de variables aleatorias discretas independientes e idénticamente distribuidas. Una suma de variables aleatorias discretas sigue siendo una variable aleatoria discreta, por lo que nos enfrentamos a una secuencia de variables aleatorias discretas cuya función de distribución de probabilidad acumulada converge hacia una función de distribución de probabilidad acumulada correspondiente a una variable continua (es decir, la de distribución normal). Esto significa que si construimos un histograma de las realizaciones de la suma de n variables discretas independientes idénticas, la curva que une los centros de las caras superiores de los rectángulos que forman el histograma converge hacia una curva gaussiana cuando n tiende a infinito, esta relación se conoce como de Moivre –Teorema de Laplace. El artículo de distribución binomial detalla tal aplicación del teorema del límite central en el caso simple de una variable discreta que toma solo dos valores posibles.

Relación con la ley de los grandes números

La ley de los grandes números, así como el teorema del límite central, son soluciones parciales a un problema general: "¿Cuál es el comportamiento límite de Sn como n se aproxima al infinito?" En el análisis matemático, las series asintóticas son una de las herramientas más populares empleadas para abordar tales cuestiones.

Supongamos que tenemos una expansión asintotica f()n){textstyle f(n)}:

Dividiendo ambas partes por φ1(n) y tomando el límite producir a1, el coeficiente del término de mayor orden en la expansión, que representa la tasa a la que f(n) cambia en su término principal.

Informalmente, uno puede decir: "f(n) crece aproximadamente como a1φ1(n) ". Tomando la diferencia entre f(n) y su aproximación y luego dividiendo por el siguiente término en la expansión, llegamos en una declaración más refinada sobre f(n):

Aquí se puede decir que la diferencia entre la función y su aproximación crece aproximadamente como a2φ2(n). La idea es que dividir la función por funciones de normalización apropiadas y observar el comportamiento limitante del resultado puede decirnos mucho sobre el comportamiento limitante de la función original en sí.

Informalmente, algo similar sucede cuando la suma, Sn, de independientes idénticamente variables aleatorias distribuidas, X1,..., Xn, se estudia en la teoría clásica de la probabilidad. Si cada Xi tiene una media finita μ, luego por la ley de los grandes números, Sn/n → μ. Si además cada Xi tiene una varianza finita σ2, entonces por el teorema del límite central,

En el caso de que las Xi no tengan media o varianza finitas, la convergencia de la suma desplazada y reescalada también puede ocurrir con diferentes factores de centrado y escala:

Las distribuciones Ξ que pueden surgir de esta forma se denominan estables. Claramente, la distribución normal es estable, pero también existen otras distribuciones estables, como la distribución de Cauchy, para las que no se define la media o la varianza. El factor de escala bn puede ser proporcional a nc, para cualquier c ≥ 1/2 ; también se puede multiplicar por una función de variación lenta de n.

La ley del logaritmo iterado especifica lo que sucede "entre" la ley de los grandes números y el teorema del límite central. Específicamente dice que la función de normalización √n log log n, de tamaño intermedio entre n de la ley de los grandes números y √ n del teorema del límite central, proporciona un comportamiento límite no trivial.

Enunciados alternativos del teorema

Funciones de densidad

La densidad de la suma de dos o más variables independientes es la convolución de sus densidades (si estas densidades existen). Por lo tanto, el teorema del límite central puede interpretarse como una declaración sobre las propiedades de las funciones de densidad bajo convolución: la convolución de varias funciones de densidad tiende a la densidad normal a medida que el número de funciones de densidad aumenta sin límite. Estos teoremas requieren hipótesis más fuertes que las formas del teorema del límite central dado anteriormente. Los teoremas de este tipo a menudo se denominan teoremas del límite local. Ver Petrov para un teorema de límite local particular para sumas de variables aleatorias independientes e idénticamente distribuidas.

Funciones características

Dado que la función característica de una convolución es el producto de las funciones características de las densidades involucradas, el teorema del límite central tiene otra reformulación: el producto de las funciones características de un número de funciones de densidad se acerca a la función característica de la densidad normal a medida que el número de funciones de densidad aumenta sin límite, en las condiciones establecidas anteriormente. Específicamente, se debe aplicar un factor de escala apropiado al argumento de la función característica.

Se puede hacer una declaración equivalente sobre las transformadas de Fourier, ya que la función característica es esencialmente una transformada de Fourier.

Cálculo de la varianza

Sea Sn la suma de n variables aleatorias. Muchos teoremas del límite central proporcionan condiciones tales que Sn/√Var(S n) converge en distribución a N(0,1) (la distribución normal con media 0, varianza 1) como n → ∞ . En algunos casos, es posible encontrar una constante σ2 y función f(n) tal que Sn/(σ√n⋅f(n)) converge en distribución a N(0,1) como n→ ∞.

Lemma—Suppose X1,X2,...... {displaystyle X_{1},X_{2},dots } es una secuencia de variables aleatorias de valor real y estrictamente estacionarias con E()Xi)=0{displaystyle mathbb {E} (X_{i}=0} para todos i{displaystyle i}, g:[0,1]→ → R{displaystyle g:[0,1]to mathbb {R}, y Sn=.. i=1ng()in)Xi{displaystyle S_{n}=sum ¿Por qué? - Sí.. Construct

- Si .. i=1JUEGO JUEGO E()X1X1+i){displaystyle sum _{i=1}{infty }mathbb {E} (X_{1}X_{1+i})} es absolutamente convergente, <math alttext="{displaystyle left|int _{0}^{1}g(x)g'(x),dxright|Silencio∫ ∫ 01g()x)g.()x)dxSilencio.JUEGO JUEGO {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif}<img alt="{displaystyle left|int _{0}^{1}g(x)g'(x),dxright|, y <math alttext="{displaystyle 0<int _{0}^{1}(g(x))^{2}dx0.∫ ∫ 01()g()x))2dx.JUEGO JUEGO {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif}<img alt="{displaystyle 0<int _{0}^{1}(g(x))^{2}dx entonces Var()Sn)/()nγ γ n)→ → σ σ 2{displaystyle mathrm {Var} (S_{n})/(ngamma _{n})to sigma ^{2} como n→ → JUEGO JUEGO {displaystyle nto infty } Donde γ γ n=1n.. i=1n()g()in))2{displaystyle gamma _{n}={frac {1}{n}sum ¿Por qué? {fn}derecha)} {2}}.

- Si además 0}" xmlns="http://www.w3.org/1998/Math/MathML">σ σ ■0{displaystyle sigma œ0}

0" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/762ecd0f0905dd0d4d7a07f80fa8bfb324b9b021" style="vertical-align: -0.338ex; width:5.591ex; height:2.176ex;"/> y Sn/Var()Sn){displaystyle S_{n}/{sqrt {mathrm {Var}}} convergencias en la distribución a N()0,1){displaystyle {Mathcal {N}(0,1)} como n→ → JUEGO JUEGO {displaystyle nto infty } entonces Sn/()σ σ nγ γ n){displaystyle S_{n}/(sigma {sqrt {ngamma _{n}}}}} también converge en la distribución a N()0,1){displaystyle {Mathcal {N}(0,1)} como n→ → JUEGO JUEGO {displaystyle nto infty }.

Extensiones

Productos de variables aleatorias positivas

El logaritmo de un producto es simplemente la suma de los logaritmos de los factores. Por lo tanto, cuando el logaritmo de un producto de variables aleatorias que toman solo valores positivos se aproxima a una distribución normal, el producto en sí se aproxima a una distribución logarítmica normal. Muchas cantidades físicas (especialmente la masa o la longitud, que son una cuestión de escala y no pueden ser negativas) son productos de diferentes factores aleatorios, por lo que siguen una distribución logarítmica normal. Esta versión multiplicativa del teorema del límite central a veces se denomina ley de Gibrat.

Mientras que el teorema del límite central para sumas de variables aleatorias requiere la condición de varianza finita, el teorema correspondiente para productos requiere la condición correspondiente de que la función de densidad sea integrable al cuadrado.

Más allá del marco clásico

La normalidad asintótica, es decir, la convergencia a la distribución normal después de un desplazamiento y un cambio de escala apropiados, es un fenómeno mucho más general que el marco clásico tratado anteriormente, es decir, sumas de variables aleatorias independientes (o vectores). De vez en cuando se revelan nuevos marcos; ningún marco unificador único está disponible por ahora.

Cuerpo convexo

Theorem—Existe una secuencia εn ↓ 0 para lo cual se sostiene lo siguiente. Vamos n ≥ 1, y dejar variables aleatorias X1,... Xn Tener una densidad de articulación de log-concave f tales que f()x1,... xn) f(en inglés)x1Silencio,...xnSilencio para todos x1,... xn, y E(E)X2

k) = 1 para todos k = 1,... n. Luego la distribución de

Estas dos distribuciones εn-close tienen densidades (de hecho, densidades log-cóncavas), por lo tanto, la distancia de varianza total entre ellos es la integral del valor absoluto de la diferencia entre las densidades. La convergencia en la variación total es más fuerte que la convergencia débil.

Un ejemplo importante de una densidad logarítmica cóncava es una función constante dentro de un cuerpo convexo dado y que desaparece fuera; corresponde a la distribución uniforme en el cuerpo convexo, lo que explica el término "teorema del límite central para cuerpos convexos".

Otro ejemplo: f(x1,..., xn) = const · exp(−(|x1|α + ⋯ + |xn|α)β) donde α > 1 y αβ > 1. Si β = 1 entonces f(x1,..., xn) se factoriza en const · exp (−|x1|α) … exp(−|x n|α), que significa X1,..., Xn son independientes. En general, sin embargo, son dependientes.

La condición f(x1,..., x n) = f(| x1|,..., | xn|) asegura que X1,..., Xn son de media cero y no correlacionados; aún así, no necesitan ser independientes, ni siquiera independientes por pares. Por cierto, la independencia por pares no puede reemplazar la independencia en el teorema del límite central clásico.

Este es un resultado tipo Berry-Esseen.

Theorem—Vamos X1,... Xn satisfacer las suposiciones del teorema anterior, entonces

1 + ⋯ + c2

n = 1,

La distribución de X1 + ⋯ + Xn/√n no necesita ser aproximadamente normal (de hecho, puede ser uniforme). Sin embargo, la distribución de c1X1 + ⋯ + cnXn está cerca de N(0,1) (en la distancia de variación total) para la mayoría de los vectores (c1,..., cn) según la distribución uniforme en la esfera c2

1 + ⋯ + c2

n = 1.

Serie trigonométrica lagunar

Teorema (Salem–Zygmund)—Vamos U ser una variable aleatoria distribuida uniformemente (0,2π), y Xk = rk Porque...nkU + ak), donde

- nk satisfacer la condición de la lacunaridad: existe q ■ 1 tales que nk + 1 ≥ qnk para todos k,

- rk son tales r12+r22+⋯ ⋯ =JUEGO JUEGO yrk2r12+⋯ ⋯ +rk2→ → 0,{displaystyle r_{1}{2}+r_{2}{2}+cdots # Infty quad {text{ and }quad {frac {fnMicrosoft Sans Serif} A 0,

- 0 ≤ ak No..

Entonces...

Polítopos gaussianos

Theorem—Vamos A1,... An ser puntos aleatorios independientes en el avión R2 cada uno tiene la distribución normal bidimensional. Vamos Kn ser el casco convexo de estos puntos, y Xn la zona de Kn Entonces...

Lo mismo vale para todas las dimensiones mayores que 2.

El politopo Kn se denomina politopo aleatorio gaussiano.

Un resultado similar es válido para el número de vértices (del politopo gaussiano), el número de aristas y, de hecho, caras de todas las dimensiones.

Funciones lineales de matrices ortogonales

Una función lineal de una matriz M es una combinación lineal de sus elementos (con coeficientes dados), M ↦ tr(AM) donde A es la matriz de coeficientes; ver Trace (álgebra lineal) # Producto interno.

Se dice que una matriz ortogonal aleatoria se distribuye uniformemente, si su distribución es la medida de Haar normalizada en el grupo ortogonal O(n,R); consulte Matriz de rotación # Matrices de rotación aleatoria uniforme.

Theorem—Vamos M ser una ortogonal aleatoria n × n matriz distribuida uniformemente, y A fija n × n matriz tal que tr(AA* = n, y dejar X = tr(AM). Luego la distribución de X está cerca N(0,1) en la variación total métrica hasta 2√3/n − 1.

Subsecuencias

Theorem—Dejar variables aleatorias X1, X2,... L2(Ω) ser tal Xn → 0 débilmente L2(Ω) y X

n → 1 débilmente L1(Ω). Entonces existen enteros n1. n2 < tales que

Paseo aleatorio sobre una red cristalina

El teorema del límite central se puede establecer para la caminata aleatoria simple en una red cristalina (un gráfico de cobertura abeliano de infinitos pliegues sobre un gráfico finito) y se utiliza para el diseño de estructuras cristalinas.

Aplicaciones y ejemplos

Un ejemplo simple del teorema del límite central es lanzar muchos dados idénticos e imparciales. La distribución de la suma (o promedio) de los números rodados se aproximará bien a una distribución normal. Dado que las cantidades del mundo real suelen ser la suma equilibrada de muchos eventos aleatorios no observados, el teorema del límite central también proporciona una explicación parcial de la prevalencia de la distribución de probabilidad normal. También justifica la aproximación de estadísticas de muestras grandes a la distribución normal en experimentos controlados.

Regresión

El análisis de regresión y, en particular, los mínimos cuadrados ordinarios especifican que una variable dependiente depende según alguna función de una o más variables independientes, con un término de error aditivo. Varios tipos de inferencia estadística sobre la regresión asumen que el término de error se distribuye normalmente. Esta suposición se puede justificar suponiendo que el término de error es en realidad la suma de muchos términos de error independientes; incluso si los términos de error individuales no se distribuyen normalmente, por el teorema del límite central su suma puede aproximarse bien mediante una distribución normal.

Otras ilustraciones

Dada su importancia para las estadísticas, hay varios artículos y paquetes de computadora disponibles que demuestran la convergencia involucrada en el teorema del límite central.

Historia

El matemático holandés Henk Tijms escribe:

El teorema límite central tiene una historia interesante. La primera versión de este teorema fue postulada por el matemático francés Abraham de Moivre, quien, en un notable artículo publicado en 1733, utilizó la distribución normal para aproximar la distribución del número de cabezas resultantes de muchos tonos de una moneda justa. Este hallazgo estaba muy por delante de su tiempo, y estaba casi olvidado hasta que el famoso matemático francés Pierre-Simon Laplace lo rescató de la oscuridad en su monumental obra Théorie analytique des probabilités, que se publicó en 1812. Laplace amplió el hallazgo de De Moivre aproximando la distribución binomial con la distribución normal. Pero como con De Moivre, el hallazgo de Laplace recibió poca atención en su propio tiempo. No fue hasta que el siglo XIX fue un final que la importancia del teorema límite central fue discernida, cuando, en 1901, el matemático ruso Aleksandr Lyapunov lo definió en términos generales y demostró precisamente cómo funcionó matemáticamente. Hoy en día, el teorema límite central es considerado como el soberano no oficial de la teoría de la probabilidad.

Sir Francis Galton describió el Teorema del Límite Central de esta manera:

Conozco apenas algo tan apto para impresionar la imaginación como la maravillosa forma de orden cósmico expresada por el "Ley de Frecuencia de Error". The law would have been personified by the Greeks and deified, if they had known of it. reina con serenidad y en completo auto-eficacia, en medio de la confusión más salvaje. Cuanto más grande es la multitud, y cuanto mayor es la anarquía aparente, más perfecta es su camino. Es la ley suprema de Unreason. Cada vez que una gran muestra de elementos caóticos se toman a mano y se marshalan en el orden de su magnitud, una forma insospechada y más bella de regularidad demuestra haber sido latente todo el tiempo.

El término real "teorema del límite central" (en alemán: "zentraler Grenzwertsatz") fue utilizado por primera vez por George Pólya en 1920 en el título de un artículo. Pólya se refirió al teorema como "central" debido a su importancia en la teoría de la probabilidad. Según Le Cam, la escuela francesa de probabilidad interpreta la palabra central en el sentido de que "describe el comportamiento del centro de la distribución en oposición a sus colas". El resumen del artículo Sobre el teorema del límite central del cálculo de probabilidad y el problema de los momentos de Pólya en 1920 se traduce de la siguiente manera.

La ocurrencia de la densidad de probabilidad gausiana 1 = e−x2 en experimentos repetidos, en errores de mediciones, que resultan en la combinación de errores elementales muy numerosos y muy pequeños, en procesos de difusión, etc., se puede explicar, como es bien conocido, por el mismo termorema límite, que desempeña un papel central en el cálculo de probabilidad. El verdadero descubridor de este teorema límite debe ser llamado Laplace; es probable que su prueba rigurosa fue dada por primera vez por Tschebyscheff y su formulación más aguda se puede encontrar, en lo que estoy consciente de, en un artículo de Liapounoff....

Hald proporciona un relato completo de la historia del teorema, que detalla el trabajo fundacional de Laplace, así como las contribuciones de Cauchy, Bessel y Poisson.. Hans Fischer ofrece dos relatos históricos, uno que cubre el desarrollo de Laplace a Cauchy, el segundo, las contribuciones de von Mises, Pólya, Lindeberg, Lévy y Cramér durante la década de 1920. Le Cam describe un período alrededor de 1935. Bernstein presenta una discusión histórica centrada en el trabajo de Pafnuty Chebyshev y sus alumnos Andrey Markov y Aleksandr Lyapunov que condujo a las primeras pruebas de la CLT en un entorno general.

Una curiosa nota al pie de la historia del teorema del límite central es que una prueba de un resultado similar al Lindeberg CLT de 1922 fue el tema de la tesis de beca de 1934 de Alan Turing para el King's College de la Universidad. de Cambridge. Solo después de enviar el trabajo, Turing se enteró de que ya se había probado. En consecuencia, la disertación de Turing no fue publicada.

Contenido relacionado

Magma (sistema de álgebra computacional)

WT Tutte

Asociación Actuarial Internacional

![{textstyle mathbb {E} [X_{i}]=mu }](https://wikimedia.org/api/rest_v1/media/math/render/svg/72ca6904a07544cb510973b19c644024f7e15a4a)

![{displaystyle lim _{nto infty }mathbb {P} left[{sqrt {n}}({bar {X}}_{n}-mu)leq zright]=lim _{nto infty }mathbb {P} left[{frac {{sqrt {n}}({bar {X}}_{n}-mu)}{sigma }}leq {frac {z}{sigma }}right]=Phi left({frac {z}{sigma }}right),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/defd4cf70972fa6a76a8570fee6551f4cb7d70b8)

![{displaystyle lim _{nto infty };sup _{zin mathbb {R} };left|mathbb {P} left[{sqrt {n}}({bar {X}}_{n}-mu)leq zright]-Phi left({frac {z}{sigma }}right)right|=0~,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/835addcb3ec37594d1e9a6a78c0373a5e7b2eddc)

![{displaystyle lim _{nto infty };{frac {1}{s_{n}^{2+delta }}},sum _{i=1}^{n}mathbb {E} left[left|X_{i}-mu _{i}right|^{2+delta }right]=0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/94a9702c705f509d1e7c582a0e9fcf5415d667aa)

![{textstyle {boldsymbol {mu }}=mathbb {E} [mathbf {X} _{i}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6244dc64b15d110166d68121979554959b73c907)

![{displaystyle {begin{bmatrix}X_{1(1)}\vdots \X_{1(k)}end{bmatrix}}+{begin{bmatrix}X_{2(1)}\vdots \X_{2(k)}end{bmatrix}}+cdots +{begin{bmatrix}X_{n(1)}\vdots \X_{n(k)}end{bmatrix}}={begin{bmatrix}sum _{i=1}^{n}left[X_{i(1)}right]\vdots \sum _{i=1}^{n}left[X_{i(k)}right]end{bmatrix}}=sum _{i=1}^{n}mathbf {X} _{i}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e0aec2e3895f5d517973d01b48f22a9ae94296cc)

![{displaystyle {frac {1}{sqrt {n}}}sum _{i=1}^{n}left[mathbf {X} _{i}-mathbb {E} left(X_{i}right)right]={frac {1}{sqrt {n}}}sum _{i=1}^{n}(mathbf {X} _{i}-{boldsymbol {mu }})={sqrt {n}}left({overline {mathbf {X} }}_{n}-{boldsymbol {mu }}right)~.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/04cd4a073edaf3e3a0ddb8fdabe603e016be039f)

![{displaystyle Sigma =operatorname {Cov} [S]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6bbdd46ff8928b02fc4e37a7fc14c51ceaf58b40)

![{displaystyle left|mathbb {P} [Sin U]-mathbb {P} [Zin U]right|leq C,d^{1/4}gamma ~,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6c26c26cb1dedbb0db401fd2ebfb479ec45fb4cc)

![{displaystyle gamma =sum _{i=1}^{n}mathbb {E} left[left|Sigma ^{-1/2}X_{i}right|_{2}^{3}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/84812af63e8f6578d530dae6334daab92c838f1e)

![{textstyle mathbb {E} [X_{n}]=0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9fcb1c7905f404857da94b55b6d27ffdbe4403ee)

![{displaystyle {frac {1}{n}}sum _{k=1}^{n}mathbb {E} left[left(M_{k}-M_{k-1}right)^{2}|M_{1},dotsM_{k-1}right]to 1}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7a14df227d6a9d49d219a7468a62dadb55efb136)

![{displaystyle varphi _{Z_{n}}!(t)=varphi _{sum _{i=1}^{n}{{frac {1}{sqrt {n}}}Y_{i}}}!(t) = varphi _{Y_{1}}!!left({frac {t}{sqrt {n}}}right)varphi _{Y_{2}}!!left({frac {t}{sqrt {n}}}right)cdots varphi _{Y_{n}}!!left({frac {t}{sqrt {n}}}right) = left[varphi _{Y_{1}}!!left({frac {t}{sqrt {n}}}right)right]^{n},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/412edc029b680d1254078fd2c5727db6cf30ea76)

![{textstyle operatorname {E} left[(X_{1}-mu)^{3}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/389b355cd56db15cdf7e88c8b0aff830a381726f)

![{displaystyle g:[0,1]to mathbb {R} }](https://wikimedia.org/api/rest_v1/media/math/render/svg/26aef45c20ce13e8d53e79e068df9b5804c5c170)