Teorema de Cayley-Hamilton

Hamilton demostró que para una función lineal de las cuaterniones existe una cierta ecuación, dependiendo de la función lineal, que está satisfecha por la propia función lineal.

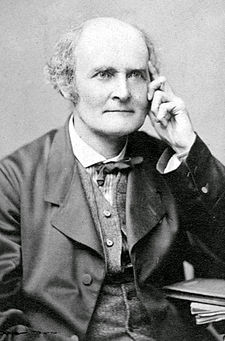

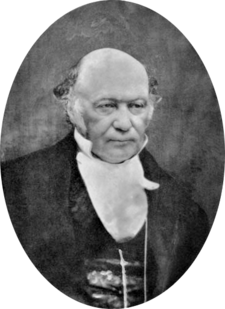

En álgebra lineal, el teorema de Cayley-Hamilton (llamado así por los matemáticos Arthur Cayley y William Rowan Hamilton) establece que toda matriz cuadrada sobre un anillo conmutativo (como los números reales o complejos o el números enteros) satisface su propia ecuación característica.

Si A es una n×n matriz In es n×n matriz de identidad, luego el polinomio característico A se define como pA()λ λ )=Det()λ λ In− − A){displaystyle p_{A}(lambda)=det(lambda) I_{n}-A)}, donde Det es la operación determinante y λ es una variable para un elemento escalar del anillo base. Desde las entradas de la matriz ()λ λ In− − A){displaystyle (lambda I_{n}-A)} son (linear o constante) polinomios en λ, el determinante es también un grado-n polinomio monico en λ, pA()λ λ )=λ λ n+cn− − 1λ λ n− − 1+⋯ ⋯ +c1λ λ +c0.{displaystyle p_{A}(lambda)=lambda ^{n}+c_{n-1}lambda ^{n-1}+cdots +c_{1}lambda +c_{0}~} Uno puede crear un polinomio análogo pA()A){displaystyle p_{A}(A)} en la matriz A en lugar de la variable escalar λ, definido como pA()A)=An+cn− − 1An− − 1+⋯ ⋯ +c1A+c0In.{displaystyle p_{A}(A)= A^{n}+c_{n-1}A^{n-1}+cdots - Sí. El teorema de Cayley-Hamilton establece que esta expresión polinomio es igual a la matriz cero, que es decir que pA()A)=0{displaystyle p_{A}(A)=mathbf {0}. El teorema permite An para ser expresada como una combinación lineal de los poderes de matriz inferiores A. Cuando el anillo es un campo, el teorema de Cayley-Hamilton es equivalente a la afirmación de que el polinomio mínimo de una matriz cuadrada divide su polinomio característico. El teorema se probó por primera vez en 1853 en términos de inversos de funciones lineales de quaternions, un anillo no conmutativo, por Hamilton. Esto corresponde al caso especial de ciertos 4 × 4 real o real 2 × 2 matrices complejas. El teorema sostiene para matrices cuaternónicas generales. Cayley en 1858 lo declaró 3 × 3 y matrices más pequeñas, pero sólo publicó una prueba para 2 × 2 caso. El caso general fue probado por primera vez por Ferdinand Frobenius en 1878.

Ejemplos

Matrices 1 × 1

Para una matriz 1 × 1 A = (a), el polinomio característico viene dado por p(λ) = λ − a, y así p(A) = (a) − a(1) = 0 es trivial.

2 × 2 matrices

Como ejemplo concreto, dejemos

- A=()1234).{displaystyle A={begin{pmatrix}1 tarde23 curva4end{pmatrix}}

Su polinomio característico viene dado por

- p()λ λ )=Det()λ λ I2− − A)=Det()λ λ − − 1− − 2− − 3λ λ − − 4)=()λ λ − − 1)()λ λ − − 4)− − ()− − 2)()− − 3)=λ λ 2− − 5λ λ − − 2.{displaystyle {begin{aligned}p(lambda) I_{2}-A)=det {begin{pmatrix}lambda -1⁄2\3lambda -4end{pmatrix}\\cMicrosoft Sans Serif} -1)(lambda -4)-(-2)(-3)=lambda ^{2}-5lambda -2.end{aligned}}

El teorema de Cayley-Hamilton afirma que, si definimos

- p()X)=X2− − 5X− − 2I2,{displaystyle p(X)=X^{2}-5X-2I_{2}

entonces

- p()A)=A2− − 5A− − 2I2=()0000).{displaystyle p(A)=A^{2}-5A-2I_{2}={begin{pmatrix}0 limit0 {0\\\end{pmatrix}}}

Podemos verificar por cálculo que, de hecho,

- A2− − 5A− − 2I2=()7101522)− − ()5101520)− − ()2002)=()0000).{displaystyle A^{2}-5A-2I_{2}={begin{pmatrix}7 limit1015,22\end{pmatrix}}-{begin{pmatrix}5 limit101515end{pmatrix}-{0trix}2}= {0trix} {0trix}{0}{0trix} {0}}{0trix} {}{0}}}=0}{0trix}{0}{0}{0trix}}}}}} {trix} {}}}}}}{0}{0}}}}}{0trix}}}}}}}}}}}}}}}}}} {trix}trix}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}

Para una matriz genérica 2 × 2,

- A=()abcd),{displaystyle A={begin{pmatrix}a golpeb\c implicad\\end{pmatrix}}}

el polinomio característico viene dado por p(λ) = λ2 − (a + d)λ + (ad − bc) , por lo que el teorema de Cayley-Hamilton establece que

- p()A)=A2− − ()a+d)A+()ad− − bc)I2=()0000);{displaystyle p(A)=A^{2}-(a+d)A+(ad-bc)I_{2}={begin{pmatrix}0 {0}}end{pmatrix};}

que es siempre el caso, evidente al calcular las entradas de A2.

Prueba |

|---|

A2− − ()a+d)A+()ad− − bc)I2{displaystyle A^{2}-(a+d)A+(ad-bc)I_{2} |

Aplicaciones

Determinante y matriz inversa

Para una matriz invertible general n × n A, es decir, uno con determinante distinto de cero, A−1 puede escribirse como una expresión polinomial de orden (n − 1)-th en A: como se indica, el teorema de Cayley-Hamilton equivale a la identidad

p()A)=An+cn− − 1An− − 1+⋯ ⋯ +c1A+()− − 1)nDet()A)In=0.{displaystyle p(A)=A^{n}+c_{n-1}A^{n-1}+cdots +c_{1}A+(-1)^{n}det(A)I_{n}=0.}

Los coeficientes ci están dados por los polinomios simétricos elementales de los valores propios de A. Usando las identidades de Newton, los polinomios simétricos elementales pueden a su vez expresarse en términos de polinomios simétricos de suma de potencias de los valores propios:

- sk=.. i=1nλ λ ik=tr ()Ak),{displaystyle S_{k}=sum ################################################################################################################################################################################################################################################################ ¿Por qué?

donde tr(Ak) es la traza de la matriz Ak. Por lo tanto, podemos expresar ci en términos de la traza de potencias de A.

En general, la fórmula para los coeficientes ci se da en términos de polinomios de Bell exponenciales completos como

- cn− − k=()− − 1)kk!Bk()s1,− − 1!s2,2!s3,...... ,()− − 1)k− − 1()k− − 1)!sk).{displaystyle ¡No!

En particular, el determinante de A es igual a (−1)nc0. Por lo tanto, el determinante se puede escribir como la identidad de la traza:

- Det()A)=1n!Bn()s1,− − 1!s2,2!s3,...... ,()− − 1)n− − 1()n− − 1)!sn).{displaystyle det(A)={frac {1} {n!}B_{n}(s_{1},-1!s_{2},2!s_{3},ldots(-1)^{n-1}(n-1)!s_{n}).}

Del mismo modo, el polinomio característico se puede escribir como

- − − ()− − 1)nDet()A)In=A()An− − 1+cn− − 1An− − 2+⋯ ⋯ +c1In),{displaystyle -(-1)^{n}det(A)I_{n}=A(A^{n-1}+c_{n-1}A^{n-2}+cdots - Sí.

y, al multiplicar ambos lados por A−1 (nota − (−1)n = (−1)n−1), uno es dirigido a una expresión para el inverso de A como una identidad de seguimiento,

- A− − 1=()− − 1)n− − 1DetA()An− − 1+cn− − 1An− − 2+⋯ ⋯ +c1In),=1DetA.. k=0n− − 1()− − 1)n+k− − 1An− − k− − 1k!Bk()s1,− − 1!s2,2!s3,...... ,()− − 1)k− − 1()k− − 1)!sk).{displaystyle {begin{aligned}A^{-1} {frac {fn1}{det A}(A^{n-1}+c_{n-1}A^{n-2}+cdots {fn1}fn}fn9}fn1}sum _{k=0}{n-1}(-1)^{n+k-1}{frac=0}{n=0}{n-1}{fn+k-1}{frac_=0} {A^{n-k-1}}} {k} {k}(s_{1},-1!s_{2},2!s_{3},ldots(-1)^{k-1}(k-1)!s_{k}).end{aligned}}}}}}}}}}}}}}}}}}

Otro método para obtener estos coeficientes ck para una n × n matriz, siempre que ninguna raíz sea cero, se basa en la siguiente expresión alternativa para el determinante,

- p()λ λ )=Det()λ λ In− − A)=λ λ nexp ()tr ()log ()In− − A/λ λ ))).{displaystyle p(lambda)=det(lambda) I_{n}-A)=lambda ^{n}exp(operatorname {tr} (log(I_{n}-A/lambda))). }

Por lo tanto, en virtud de la serie de Mercator,

- p()λ λ )=λ λ nexp ()− − tr .. m=1JUEGO JUEGO ()Aλ λ )mm),{displaystyle p(lambda)=lambda ^{n}expleft(-operatorname {tr} sum _{m=1}infty }{({A over lambda })^{m}over m}right),}}

donde el exponencial solo necesita expandirse para ordenar λ−n, ya que p(λ) es de orden n, las potencias netas negativas de λ desaparecen automáticamente por el teorema C–H. (Nuevamente, esto requiere un anillo que contenga los números racionales). La diferenciación de esta expresión con respecto a λ permite expresar los coeficientes del polinomio característico para n generales como determinantes de m × matrices m,

- cn− − m=()− − 1)mm!Silenciotr Am− − 10⋯ ⋯ tr A2tr Am− − 2⋯ ⋯ ⋮ ⋮ ⋮ ⋮ ⋮ ⋮ tr Am− − 1tr Am− − 2⋯ ⋯ ⋯ ⋯ 1tr Amtr Am− − 1⋯ ⋯ ⋯ ⋯ tr ASilencio.{displaystyle c_{n-m}={frac {(-1)^{m} {m}}{begin{vmatrix}operatorname {tr} Un pacientem-1 implica0 ventajacdots \\operatorname {tr} A^{2}vdots &vdots &vdots < } > } > A^{2} A^{m-1} limitadaoperatorname {tr} A^{m-2} limitcdots 'cdots &1\\\\operatorname {tr} A^{m} limitadacdots > operatorname {tr} Aend{vmatrix}~}

- Ejemplos

Por ejemplo, los primeros polinomios de Bell son B0 = 1, B1(x1) = x1, B2(x1, x2) = x2

1 + x2, y B3(x1, x2, x3) = x3

1 + 3 x1x2 + x 3.

Usar estos para especificar los coeficientes ci del polinomio característico de un 2 × 2

- c2=B0=1,c1=− − 11!B1()s1)=− − s1=− − tr ()A),c0=12!B2()s1,− − 1!s2)=12()s12− − s2)=12()()tr ()A))2− − tr ()A2)).{displaystyle {begin{aligned}c_{2}=B_{0}=1,[4pt]c_{1}={frac {-1}{1}}B_{1}(s_{1}=-s_{1}=-operatorname {tr} (A),[4pt]c_{0}={ {1}{2} {2} {2}(s_{1},-1!s_{2}={2} {2} {2} {2}} {2} {2} {2}-s_{2})=frac {1}{2}} {2}} {fnuncio} {2} {fnun} {fnun} {fnun}}} {fnun} {fnun}fnun}fnun}fnun}fnun}fnun}fnun} {fnun} {fnun}fnun}fnun}fnun} {fnun}fnun}fnun}fnun}fnun} {fnun}fnunfnun}fnun}fnun}fnunfnun}fnun} {fnun}fnunfnun}fnun}}

El coeficiente c0 da el determinante de 2 × 2 matriz, c1 menos su traza, mientras que su inversa viene dada por

- A− − 1=− − 1DetA()A+c1I2)=− − 2()A− − tr ()A)I2)()tr ()A))2− − tr ()A2).{displaystyle A^{-1}={frac {-1}{det A}}(A+c_{1}I_{2})={frac {-2(A-operatorname {tr} (A)I_{2})}{(operatorname {tr} (A))} {2}-operatorname {tr} {tr}}}}}}}} {}}}}}}}}}}}}} {}}}}}}}}}}}} {}}}}}}} {}}}}}}}} {}}}}}}}} {}}}}}}}}}}}}}}}} {}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {

Es evidente a partir de la fórmula general para cn−k, expresada en términos de polinomios de Bell, que las expresiones

- − − tr ()A)y12()tr ()A)2− − tr ()A2)){displaystyle -operatorname {tr} (A)quad {text{and}quad {tfrac {1}{2}}(operatorname {tr} (A)^{2}-operatorname {tr} (A^{2})})}}

siempre da los coeficientes cn−1 de λn−1 y cn−2 de λn−2 en el polinomio característico de cualquier matriz n × n, respectivamente. Entonces, para una matriz 3 × 3 A, la declaración de Cayley –El teorema de Hamilton también se puede escribir como

- A3− − ()tr A)A2+12()()tr A)2− − tr ()A2))A− − Det()A)I3=O,{displaystyle A^{3}-(operatorname {tr} A)A^{2}+{frac {1}{2}left(operatorname {tr} A)^{2}-operatorname {tr} (A^{2})right)A-det(A)I_{3}=O,}

donde el lado derecho designa una matriz 3 × 3 con todas las entradas reducidas a cero. Asimismo, este determinante en el caso n = 3, ahora es

- Det()A)=13!B3()s1,− − 1!s2,2!s3)=16()s13+3s1()− − s2)+2s3)=16()()tr A)3− − 3tr ()A2)()tr A)+2tr ()A3)).{displaystyle {begin{aligned}det(A) {1}{3}}B_{3}(s_{1},-1!s_{2},2!s_{3})={frac {1}{6} {3} {3} {3} {3} {2})+2s_{3})[5pt]

Esta expresión da el negativo del coeficiente cn−3 de λn−3 en el caso general, como se ve a continuación.

Del mismo modo, se puede escribir para una matriz 4 × 4 A,

- A4− − ()tr A)A3+12()()tr A)2− − tr ()A2))A2− − 16()()tr A)3− − 3tr ()A2)()tr A)+2tr ()A3))A+Det()A)I4=O,{displaystyle A^{4}-(operatorname {tr} A)A^{3}+{tfrac {1}{2}{bigl (operatorname {tr} A)^{2}-operatorname {tr} (A^{2}){bigr)}A^{2}-{tfrac {1}{6}{bigl (operatorname {tr} A)^{3}-3operatorname {tr}(A^{2})(operatorname {tr} A)+2operatorname {tr} (A^{3}){bigr)}A+det(A)I_{4}=O,}

donde, ahora, el determinante es cn−4,

- 124()()tr A)4− − 6tr ()A2)()tr A)2+3()tr ()A2))2+8tr ()A3)tr ()A)− − 6tr ()A4)),{fnMicrosoft ] {fnMicrosoft ] {fnMicrosoft ] {fnMicrosoft ] {fnMicrosoft ] {fnMicrosoft ] {fnMicrosoft ] {fnMicrosoft ] {fnMicrosoft ] {fnMicrosoft ]

y así sucesivamente para matrices más grandes. Las expresiones cada vez más complejas para los coeficientes ck son deducibles de Newton's identidades o el algoritmo de Faddeev-LeVerrier.

N-ésima potencia de matriz

El teorema de Cayley-Hamilton siempre proporciona una relación entre las potencias de A (aunque no siempre la más simple), que permite simplificar expresiones que implican dichas potencias y evaluarlas sin tener que calcular la potencia An o cualquier potencia superior a A.

Como ejemplo, para A=()1234){displaystyle A={begin{pmatrix}1 tarde23 diez4end{pmatrix}} el teorema da

- A2=5A+2I2.{displaystyle A^{2}=5A+2I_{2},}

Entonces, para calcular A4, observa

- A3=()5A+2I2)A=5A2+2A=5()5A+2I2)+2A=27A+10I2,{displaystyle A^{3}=(5A+2I_{2})A=5A^{2}+2A=5(5A+2I_{2})+2A=27A+10I_{2}}

- A4=A3A=()27A+10I2)A=27A2+10A=27()5A+2I2)+10A=145A+54I2.{displaystyle A^{4}=A^{3}A=(27A+10I_{2})A=27A^{2}+10A=27(5A+2I_{2})+10A=145A+54I_{2},}

Del mismo modo,

- A− − 1=A− − 5I22.{displaystyle ¿Qué?

- A− − 2=A− − 1A− − 1=A2− − 10A+25I24=()5A+2I2)− − 10A+25I24=− − 5A+27I24.{displaystyle A^{-2}=A^{-1}={-1}={frac {2}-10A+25I_{2}{4}}={frac {5A+2I_{2})-10A+25I_{2}{4}={4}={frac {-5A+27I_{2}}{4}}}~}}{4}}}}}}}{4}}}}}}}}{4}}}}}}}{4}}}}}{4}}}}}}}}}}}} {}{4}}}}}}}}}}}}}}}}}}}}}}}{4}}}}} {} {}}{4}{4} {}}}}}}}}}}}}}} {} {}}}}}}}}}}}}}}}}}}}{}}}}}{}}}}}}}}}}}}}}}}}}}}}}}}{

Observe que hemos podido escribir la potencia de la matriz como la suma de dos términos. De hecho, la potencia matricial de cualquier orden k se puede escribir como un polinomio matricial de grado máximo n − 1, donde n es el tamaño de una matriz cuadrada. Este es un ejemplo en el que se puede utilizar el teorema de Cayley-Hamilton para expresar una función matricial, que analizaremos sistemáticamente a continuación.

Funciones matriciales

Dada una función analítica

- f()x)=.. k=0JUEGO JUEGO akxk{displaystyle f(x)=sum _{k=0}{infty }a_{k}x^{k}

y el polinomio característico p(x) de grado n de una matriz n × n estilo A, la función se puede expresar mediante división larga como

- f()x)=q()x)p()x)+r()x),{displaystyle f(x)=q(x)p(x)+r(x),}

donde q(x) es un polinomio cociente y r(x) es un polinomio de resto tal que 0 ≤ grado r(x) < n.

Por el teorema de Cayley–Hamilton, reemplazando x por la matriz A da p(A) = 0, entonces uno tiene

- f()A)=r()A).{displaystyle f(A)=r(A). }

Por lo tanto, la función analítica de la matriz A se puede expresar como un polinomio matricial de grado menor que n.

Sea el resto del polinomio

- r()x)=c0+c1x+⋯ ⋯ +cn− − 1xn− − 1.{displaystyle r(x)=c_{0}+c_{1}x+cdots +c_{n-1}x^{n-1}

Dado que p(λ) = 0, evaluando la función f(x) en los n valores propios de A produce

- f()λ λ i)=r()λ λ i)=c0+c1λ λ i+⋯ ⋯ +cn− − 1λ λ in− − 1,parai=1,2,...,n.{displaystyle f(lambda _{i})=r(lambda) ¿Qué? ¿Qué? +c_{n-1}lambda ################################################################################################################################################################################################################################################################

Esto equivale a un sistema de n ecuaciones lineales, que se pueden resolver para determinar los coeficientes ci. Así, uno tiene

- f()A)=.. k=0n− − 1ckAk.{displaystyle f(A)=sum ¿Qué?

Cuando los valores propios se repiten, eso es λi = λj para algunas i ≠ j, dos o más ecuaciones son idénticas; y por lo tanto, las ecuaciones lineales no se pueden resolver de manera única. Para tales casos, para un valor propio λ con multiplicidad m, las primeras m – 1 derivadas de p(x) desaparecen en el valor propio. Este conduce a las m – 1 adicionales soluciones linealmente independientes

- dkf()x)dxkSilenciox=λ λ =dkr()x)dxkSilenciox=λ λ parak=1,2,...... ,m− − 1,{displaystyle {frac {mathrm} {f}{k}f(x)}{mathrm {d} ¿Qué? Grandes vidas }={frac {mathrm {d} {k}r(x)}{mathrm {d} ¿Qué? Grandes vidas }qquad {text{for }k=1,2,ldotsm-1,}

que, combinado con otros, produce las n ecuaciones requeridas para resolver ci.

Encontrar un polinomio que pase por los puntos (λi, f (λ i)) es esencialmente un problema de interpolación y se puede resolver usando las técnicas de interpolación de Lagrange o Newton, lo que lleva a la fórmula de Sylvester.

Por ejemplo, suponga que la tarea es encontrar la representación polinomial de

- f()A)=eAtwhereA=()1203).{displaystyle f(A)=e^{At}qquad mathrm {where} qquad A={begin{pmatrix}1 tendría2 diez3end{pmatrix}}

El polinomio característico es p(x) = (x − 1)( x − 3) = x2 − 4x + 3, y los valores propios son λ = 1, 3. Sea r(x) = c0 + c1x. Evaluando f(λ) = r(λ) en los valores propios, se obtienen dos ecuaciones lineales, et = c 0 + c1 y e3 t = c0 + 3c1.

Resolviendo las ecuaciones se obtiene c0 = (3et − e3t)/2 y c1 = (e3t − et)/2. Así, se sigue que

- eAt=c0I2+c1A=()c0+c12c10c0+3c1)=()ete3t− − et0e3t).{displaystyle e^{0}=c_{0}= {0}={0}={0}= {0}== {0}=== {0} {0} {0}} {0}}}}}}}}= {0}= {0} {}} {0} {0}}}}}}} {0}}}} {0}}}}}}}} {}}}} {}}}}}}}}}}}}}}}}}} {} {}}}}} {}}}}} {}}}}}}}} {}}}}}}}}}}}} {}}}}}}}}}}}}}} {}}}}}}}}}} {}}}}}}}} {}}}}}} {}}}}}}}}}}}}} {}}}}}}}}}}}}}}} {}}}}}}}}}}}}}}}

Si, en cambio, la función fuera f(A) = sin At, entonces los coeficientes habrían sido c0 = (3 sin t − sin 3t )/2 y c1 = (sin 3t − sin t)/2; por eso

- pecado ()At)=c0I2+c1A=()pecado tpecado 3t− − pecado t0pecado 3t).{displaystyle sin(At)=c_{0}I_{2}+c_{1}A={begin{pmatrix}sin.

Como otro ejemplo, al considerar

- f()A)=eAtwhereA=()01− − 10),{displaystyle f(A)=e^{At}qquad mathrm {where} qquad A={begin{pmatrix}0 tarde111}}

entonces el polinomio característico es p(x) = x2 + 1, y los valores propios son λ = ±i.

Como antes, evaluar la función en los valores propios nos da las ecuaciones lineales eit = c0 + i c1 y e−it = c0 − ic1; cuya solución da, c0 = (eit + e−it)/2 = cos t y c1 = (eeso − e−it)/2i = sin t. Así, para este caso,

- eAt=()# t)I2+()pecado t)A=()# tpecado t− − pecado t# t),{displaystyle e^{At}=(cos t)I_{2}+(sin t)A={begin{pmatrix}cos t limitsin t\\-sin t limitcos tend{pmatrix}}}

que es una matriz de rotación.

Ejemplos estándar de tal uso es el mapa exponencial del álgebra de Lie de un grupo de matriz de Lie en el grupo. Está dada por una matriz exponencial,

- exp:g→ → G;tX↦ ↦ etX=.. n=0JUEGO JUEGO tnXnn!=I+tX+t2X22+⋯ ⋯ ,t▪ ▪ R,X▪ ▪ g.{displaystyle exp:{mathfrak {g}rightarrow G;qquad tXmapsto e^{tX}=sum ¡No! {cH00}cdotstin Mathbb {R}Xin {Mathfrak {g}}

Tales expresiones se conocen desde hace mucho tiempo para SU(2),

- ei()Silencio Silencio /2)()n^ ^ ⋅ ⋅ σ σ )=I2# Silencio Silencio /2+i()n^ ^ ⋅ ⋅ σ σ )pecado Silencio Silencio /2,{displaystyle e^{i(theta /2)({hat {n}cdot sigma)}=I_{2}cos theta /2+i({hat {n}cdot sigma)sin theta /2,}}

donde σ son las matrices de Pauli y para SO(3),

- eiSilencio Silencio ()n^ ^ ⋅ ⋅ J)=I3+i()n^ ^ ⋅ ⋅ J)pecado Silencio Silencio +()n^ ^ ⋅ ⋅ J)2()# Silencio Silencio − − 1),{displaystyle e^{itheta ({hat {n}cdot mathbf {J})}=I_{3}+i({hat {n}cdot mathbf {J})sin theta +({hat {n}cdot mathbf {J})^{2}(cos thetata -1),}

que es Rodrigues' fórmula de rotación Para la notación, consulte el grupo de rotación 3D # Una nota sobre álgebras de Lie.

Más recientemente, han aparecido expresiones para otros grupos, como el grupo de Lorentz SO(3, 1), O(4, 2) y SU(2, 2), así como GL(n, R ). El grupo O(4, 2) es el grupo conforme del espacio-tiempo, SU(2, 2) su cubierta simplemente conectada (para ser precisos, la cubierta simplemente conectada del componente conectado SO+(4, 2) de O(4, 2)). Las expresiones obtenidas se aplican a la representación estándar de estos grupos. Requieren conocimiento de (algunos de) los valores propios de la matriz para exponenciar. Para SU(2) (y por lo tanto para SO(3)), se han obtenido expresiones cerradas para todas representaciones irreductibles, es decir, de cualquier espín.

Teoría algebraica de números

El teorema de Cayley-Hamilton es una herramienta eficaz para calcular el mínimo polinomio de los enteros algebraicos. Por ejemplo, dada una extensión finita Q[α α 1,...... ,α α k]{displaystyle mathbb {Q} [alpha _{1},ldotsalpha _{k}} de Q{displaystyle mathbb {Q} y un entero algebraico α α ▪ ▪ Q[α α 1,...... ,α α k]{displaystyle alpha in mathbb {Q} [alpha _{1},ldotsalpha _{k}} que es una combinación no lineal de la α α 1n1⋯ ⋯ α α knk{displaystyle alpha ¿Qué? alpha ¿Qué? podemos calcular el mínimo polinomio de α α {displaystyle alpha } encontrando una matriz que representa Q{displaystyle mathbb {Q}- Transformación lineal

- ⋅ ⋅ α α :Q[α α 1,...... ,α α k]→ → Q[α α 1,...... ,α α k]{displaystyle cdot alpha:mathbb {Q} [alpha _{1},ldotsalpha _{k}to mathbb {Q} [alpha _{1},ldotsalpha _{k}}

Si llamamos a esta matriz de transformación A{displaystyle A}, entonces podemos encontrar el mínimo polinomio aplicando el teorema de Cayley-Hamilton a A{displaystyle A}.

Pruebas

El teorema de Cayley-Hamilton es una consecuencia inmediata de la existencia de la forma normal de Jordan para matrices sobre campos algebraicamente cerrados, consulte Forma normal de Jordan § Teorema de Cayley-Hamilton. En esta sección se presentan pruebas directas.

Como muestran los ejemplos anteriores, obtener el enunciado del teorema de Cayley–Hamilton para una matriz n × n

- A=()aij)i,j=1n{displaystyle A=(a_{ij}_{i,j=1}{n}

requiere dos pasos: primero los coeficientes ci del polinomio característico son determinado por el desarrollo como un polinomio en t del determinante

- p()t)=Det()tIn− − A)=Silenciot− − a1,1− − a1,2⋯ ⋯ − − a1,n− − a2,1t− − a2,2⋯ ⋯ − − a2,n⋮ ⋮ ⋮ ⋮ ⋱ ⋱ ⋮ ⋮ − − an,1− − an,2⋯ ⋯ t− − an,nSilencio=tn+cn− − 1tn− − 1+⋯ ⋯ +c1t+c0,{displaystyle {begin{aligned}p(t) limit=det(tI_{n}-A)={begin{vmatrix}t-a_{1,1} limit-a_{1,2} limitcdots - ¿Qué? " a_{2,n}\vdots ", 'a_{n,1} {fnMicrosoft Sans Serif} - No.

y luego estos coeficientes se usan en una combinación lineal de potencias de A que se iguala a n × n matriz cero:

- An+cn− − 1An− − 1+⋯ ⋯ +c1A+c0In=()0⋯ ⋯ 0⋮ ⋮ ⋱ ⋱ ⋮ ⋮ 0⋯ ⋯ 0).{displaystyle A^{n}+c_{n-1}A^{n-1}+cdots +c_{1}A+c_{0}I_{n}={begin{pmatrix}0 limitcdots > 'vdots > 'vdots \0 palcdots &0end{pmatrix}}

El lado izquierdo se puede resolver en una matriz n × n cuyas entradas son (enormes) expresiones polinómicas en el conjunto de entradas ai,j de A, por lo que el teorema de Cayley-Hamilton establece que cada uno de estos n 2 expresiones equivalen a 0. Para cualquier valor fijo de n, estas identidades se pueden obtener mediante manipulaciones algebraicas tediosas pero sencillas. Sin embargo, ninguno de estos cálculos puede mostrar por qué el teorema de Cayley-Hamilton debería ser válido para matrices de todos los tamaños posibles n, por lo que una prueba uniforme para todos los n son necesarios.

Preliminares

Si un vector v de tamaño n es un vector propio de A con valor propio λ, en otras palabras si A⋅v = λv, entonces

- p()A)⋅ ⋅ v=An⋅ ⋅ v+cn− − 1An− − 1⋅ ⋅ v+⋯ ⋯ +c1A⋅ ⋅ v+c0In⋅ ⋅ v=λ λ nv+cn− − 1λ λ n− − 1v+⋯ ⋯ +c1λ λ v+c0v=p()λ λ )v,{displaystyle {begin{aligned}p(A)cdot viéndose=A^{n}cdot v+c_{n-1}A^{n-1}cdot v+cdots +c_{1}Acdot v+c_{0}I_{n}cdot v[6pt] ^{n}v+c_{n-1}lambda ^{n-1}v+cdots +c_{1}lambda v+c_{0}v=p(lambda)v,end{aligned}}

que es el vector cero desde p(λ) = 0 (los valores propios de A son precisamente las raíces de p(t)). Esto es válido para todos los valores propios posibles λ, por lo que las dos matrices equiparadas por el teorema ciertamente dan el mismo resultado (nulo) cuando se aplican a cualquier vector propio. Ahora bien, si A admite una base de vectores propios, en otras palabras, si A es diagonalizable, entonces el teorema de Cayley-Hamilton debe cumplirse para A, ya que dos matrices que dan los mismos valores cuando se aplican a cada elemento de un la base debe ser igual.

- A=XDX− − 1,D=diag ()λ λ i),i=1,2,...,n{displaystyle A=XDX^{-1},quad D=operatorname {diag} (lambda _{i}),quad i=1,2,...,n}

- pA()λ λ )=Silencioλ λ I− − ASilencio=∏ ∏ i=1n()λ λ − − λ λ i)↑ ↑ .. k=0nckλ λ k{displaystyle p_{A}(lambda)= sufrimientolambda I-A habit=prod _{i=1} {n}(lambda -lambda _{i})equiv sum ################################################################################################################################################################################################################################################################ ^{k}

- pA()A)=.. ckAk=XpA()D)X− − 1=XCX− − 1{displaystyle p_{A}(A)=sum - Sí.

- Cii=.. k=0nckλ λ ik=∏ ∏ j=1n()λ λ i− − λ λ j)=0,Ci,jل ل i=0{displaystyle C_{ii}=sum ################################################################################################################################################################################################################################################################ ¿Qué? ################################################################################################################################################################################################################################################################ ¿Por qué?

- ▪ ▪ pA()A)=XCX− − 1=O.{displaystyle therefore p_{A}(A)=XCX^{-1}=O.}

Considere ahora la función e:: Mn→ → Mn{displaystyle ecolon M_{n}to M_{n} que mapas n×n matrices a n×n matrices dadas por la fórmula e()A)=pA()A){displaystyle e(A)=p_{A}(A)}, es decir, que toma una matriz A{displaystyle A} y lo conecta a su propio polinomio característico. No todas las matrices son diagonalizables, pero para matrices con coeficientes complejos muchos de ellos son: el conjunto D{displaystyle D} de matrices cuadradas complejas diagonalizables de un tamaño determinado es denso en el conjunto de todas estas matrices cuadradas (para que una matriz sea diagonalizable basta, por ejemplo, que su polinomio característico no tiene ninguna raíz múltiple). Ahora vista como una función e:: Cn2→ → Cn2{displaystyle ecolon mathbb {C} {fn}to mathbb {C}(ya que las matrices tienen n2{displaystyle n^{2}entradas) vemos que esta función es continua. Esto es cierto porque las entradas de la imagen de una matriz son dadas por los polinomios en las entradas de la matriz. Desde

e()D)={}()0⋯ ⋯ 0⋮ ⋮ ⋱ ⋱ ⋮ ⋮ 0⋯ ⋯ 0)}{displaystyle e(D)=left{begin{pmatrix}0 limitcdots "0\vdots > 'vdots \0 âcdots &0end{pmatrix}right}

y desde el set D{displaystyle D} es denso, por continuidad esta función debe mapear todo el conjunto de n×n matrices a la matriz cero. Por lo tanto, el teorema de Cayley-Hamilton es verdadero para números complejos, y por lo tanto también debe mantener para Q{displaystyle mathbb {Q}- o R{displaystyle mathbb {R}- matrices valoradas.

Si bien esto proporciona una prueba válida, el argumento no es muy satisfactorio, ya que las identidades representadas por el teorema no dependen de ninguna manera de la naturaleza de la matriz (diagonalizable o no), ni del tipo de entradas permitidas (para matrices con entradas reales, las diagonalizables no forman un conjunto denso, y parece extraño que uno tenga que considerar matrices complejas para ver que el teorema de Cayley-Hamilton se cumple para ellas). Por lo tanto, ahora consideraremos solo los argumentos que prueban el teorema directamente para cualquier matriz usando solo manipulaciones algebraicas; estos también tienen la ventaja de trabajar para matrices con entradas en cualquier anillo conmutativo.

Existe una gran variedad de tales demostraciones del teorema de Cayley-Hamilton, de las cuales se darán varias aquí. Varían en la cantidad de nociones algebraicas abstractas requeridas para comprender la demostración. Las demostraciones más sencillas utilizan sólo las nociones necesarias para formular el teorema (matrices, polinomios con entradas numéricas, determinantes), pero implican cálculos técnicos que hacen algo misterioso el hecho de que conduzcan precisamente a la conclusión correcta. Es posible evitar tales detalles, pero al precio de involucrar nociones algebraicas más sutiles: polinomios con coeficientes en un anillo no conmutativo, o matrices con tipos de entradas inusuales.

Matrices conjugadas

Todas las pruebas a continuación usan la noción de la matriz adjunta adj(M) de un n × n matriz M, la transpuesta de su matriz cofactor. Esta es una matriz cuyos coeficientes vienen dados por expresiones polinómicas en los coeficientes de M (de hecho, por ciertos (n − 1) × (n − 1) determinantes), de tal forma que se cumplen las siguientes relaciones fundamentales,

- adj ()M)⋅ ⋅ M=Det()M)In=M⋅ ⋅ adj ()M).{displaystyle operatorname {adj} (M)cdot M=det(M)I_{n}=Mcdot operatorname {adj} (M)~.}

Estas relaciones son una consecuencia directa de las propiedades básicas de los determinantes: evaluación de la (i, j) la entrada del producto de matrices a la izquierda da la expansión por columna j del determinante de la matriz obtenido de M reemplazando la columna i por una copia de la columna j, que es det(M) si i = j y cero en caso contrario; el producto matricial de la derecha es similar, pero para expansiones por filas.

Siendo una consecuencia de la manipulación de expresiones algebraicas, estas relaciones son válidas para matrices con entradas en cualquier anillo conmutativo (en primer lugar, se debe asumir la conmutatividad para que los determinantes se definan). Es importante tener esto en cuenta aquí, porque estas relaciones se aplicarán a continuación para matrices con entradas no numéricas, como polinomios.

Una demostración algebraica directa

Esta demostración utiliza exactamente el tipo de objetos necesarios para formular el teorema de Cayley-Hamilton: matrices con polinomios como entradas. La matriz t In − A cuyo determinante es el polinomio característico de A es una matriz de este tipo, y dado que los polinomios forman un anillo conmutativo, tiene un adjunto

- B=adj ()tIn− − A).{displaystyle B=operatorname {adj} (tI_{n}-A).}

Entonces, de acuerdo con la relación fundamental de la mano derecha del adjunto, uno tiene

- ()tIn− − A)B=Det()tIn− − A)In=p()t)In.{displaystyle (tI_{n}-A)B=det(tI_{n}-A)I_{n}=p(t)I_{n}

Dado que B también es una matriz con polinomios en t como entradas, uno puede, para cada i, recolectar los coeficientes de t i en cada entrada para formar una matriz Bi de números, tales que uno tiene

- B=.. i=0n− − 1tiBi.{displaystyle B=sum ¿Qué?

(La forma en que se definen las entradas de B deja claro que no hay poderes superiores a t n−1 ocurren). Si bien esto parece un polinomio con matrices como coeficientes, no consideraremos tal noción; es solo una forma de escribir una matriz con entradas de polinomios como una combinación lineal de n matrices constantes y el coeficiente t i se ha escrito a la izquierda de la matriz para enfatizar este punto de vista.

Ahora, uno puede expandir el producto de matriz en nuestra ecuación por bilinealidad:

- p()t)In=()tIn− − A)B=()tIn− − A).. i=0n− − 1tiBi=.. i=0n− − 1tIn⋅ ⋅ tiBi− − .. i=0n− − 1A⋅ ⋅ tiBi=.. i=0n− − 1ti+1Bi− − .. i=0n− − 1tiABi=tnBn− − 1+.. i=1n− − 1ti()Bi− − 1− − ABi)− − AB0.{displaystyle {begin{aligned}p(t)I_{n} limit=(tI_{n}-A)B\\cH00=(tI_{n}-A)sum ¿Por qué? ¿Qué? T^{i}B_{i}-sum ¿Por qué? ¿Por qué? ¿Por qué? ¿Por qué?

Escribir

- p()t)In=tnIn+tn− − 1cn− − 1In+⋯ ⋯ +tc1In+c0In,{displaystyle p(t)I_{n}I_{n}+t^{n-1}c_{n-1}I_{n}+cdots Yo...

se obtiene una igualdad de dos matrices con entradas polinómicas, escritas como combinaciones lineales de matrices constantes con potencias de t como coeficientes.

Tal igualdad solo se puede cumplir si en cualquier posición de la matriz la entrada que se multiplica por una potencia dada t i es igual en ambos lados; se sigue que las matrices constantes con coeficiente t i en ambas expresiones deben ser iguales. Escribiendo estas ecuaciones para i desde n hasta 0, uno encuentra

- Bn− − 1=In,Bi− − 1− − ABi=ciInpara1≤ ≤ i≤ ≤ n− − 1,− − AB0=c0In.{displaystyle B_{n-1}=I_{n},qquad B_{i-1}-AB_{i}=c_{i}I_{n}quad {text{for }1leq ileq n-1,qquad - ¿Qué?

Finalmente, multiplica la ecuación de los coeficientes de t i desde la izquierda por Ai, y resuma:

AnBn− − 1+.. i=1n− − 1()AiBi− − 1− − Ai+1Bi)− − AB0=An+cn− − 1An− − 1+⋯ ⋯ +c1A+c0In.{textstyle A^{n}B_{n-1}+sum limits ¿Por qué?. - Sí.

Los lados de la mano izquierda forman una suma telescópica y cancelan completamente; los lados de la mano derecha se suman a p()A){displaystyle p(A)}:

- 0=p()A).{displaystyle 0=p(A).}

Esto completa la prueba.

Una prueba usando polinomios con coeficientes de matriz

Esta prueba es similar a la primera, pero intenta dar sentido a la noción de polinomio con coeficientes matriciales que sugerían las expresiones que aparecen en esa prueba. Esto requiere un cuidado considerable, ya que es algo inusual considerar polinomios con coeficientes en un anillo no conmutativo, y no todos los razonamientos que son válidos para polinomios conmutativos se pueden aplicar en esta configuración.

Notablemente, mientras que la aritmética de polinomios sobre un anillo conmutativo modela la aritmética de funciones polinómicas, este no es el caso sobre un anillo no conmutativo (de hecho, no hay una noción obvia de función polinomial en este caso que se cierra bajo la multiplicación). Entonces, al considerar polinomios en t con coeficientes de matriz, la variable t no debe considerarse como un "desconocido", sino como un símbolo formal que debe manipularse de acuerdo con reglas dadas; en particular, uno no puede simplemente establecer t en un valor específico.

- ()f+g)()x)=.. i()fi+gi)xi=.. ifixi+.. igixi=f()x)+g()x).{displaystyle (f+g)(x)=sum _{i}left(f_{i}+g_{i}right)x^{i}=sum ¿Por qué? _{i}{i}x}=f(x)+g(x). }

Vamos M()n,R){displaystyle M(n,R)} ser el anillo de n×n matrices con entradas en algún anillo R (como los números reales o complejos) que tiene A como elemento. Matrices con coeficientes de polinomios en t, como tIn− − A{displaystyle TI_{n}-A} o su adyugue B en la primera prueba, son elementos de M()n,R[t]){displaystyle M(n,R[t]}.

Coleccionando como poderes t, tales matrices se pueden escribir como "polinomios" en t con matrices constantes como coeficientes; escriba M()n,R)[t]{displaystyle M(n,R)[t] para el conjunto de tales polinomios. Puesto que este conjunto está en bijección con M()n,R[t]){displaystyle M(n,R[t]}, uno define las operaciones aritméticas en él correspondientemente, en particular la multiplicación se da por

- ().. iMiti)().. jNjtj)=.. i,j()MiNj)ti+j,{displaystyle left(sum ¿Qué? ¿Qué? ¿Qué?

respetando el orden de las matrices de coeficientes de los dos operandos; obviamente esto da una multiplicación no conmutativa.

Así, la identidad

- ()tIn− − A)B=p()t)In.{displaystyle (tI_{n}-A)B=p(t)I_{n}

de la primera prueba se puede ver como uno que implica una multiplicación de elementos en M()n,R)[t]{displaystyle M(n,R)[t].

En este punto, es tentador simplemente establecer t igual a la matriz A, que hace que el primer factor de la izquierda sea igual a la matriz cero, y el lado derecho igual a p()A); sin embargo, esto no es una operación permitida cuando los coeficientes no se comunican. Es posible definir un mapa de evaluación correctaA: M[t] → M, que reemplaza cada uno ti por el poder de la matriz Ai de A, donde se estipula que el poder siempre debe ser multiplicado en el derecho al coeficiente correspondiente. Pero este mapa no es un homomorfismo de anillo: la valoración correcta de un producto difiere en general del producto de las valoraciones correctas. Esto es así porque la multiplicación de polinomios con coeficientes de matriz no modela la multiplicación de expresiones que contienen desconocidos: un producto MtiNtj=()M⋅ ⋅ N)ti+j{displaystyle Mt^{i} Nt^{j}=(Mcdot N)t^{i+j} se define suponiendo que t comunicaciones con N, pero esto puede fallar si t es reemplazado por la matriz A.

Se puede solucionar esta dificultad en la situación particular en cuestión, ya que el mapa de evaluación a la derecha anterior se convierte en un homomorfismo de anillo si la matriz A está en el centro del anillo de coeficientes, por lo que conmuta con todos los coeficientes de los polinomios (el argumento que prueba esto es sencillo, exactamente porque conmuta t con coeficientes ahora se justifica después de la evaluación).

Ahora, A no siempre está en el centro de M, pero podemos reemplazar M con un anillo más pequeño siempre que contenga todos los coeficientes de los polinomios en cuestión: In{displaystyle I_{n}, A, y los coeficientes Bi{displaystyle B_{i} del polinomio B. La opción obvia para tal subring es el centralizador Z de A, el subing de todas las matrices que se comunican con A; por definición A está en el centro de Z.

Este centralizador obviamente contiene In{displaystyle I_{n}, y A, pero hay que demostrar que contiene las matrices Bi{displaystyle B_{i}. Para ello, se combinan las dos relaciones fundamentales para los ayugos, escribiendo el adyugue B como polinomio:

- ().. i=0mBiti)()tIn− − A)=()tIn− − A).. i=0mBiti.. i=0mBiti+1− − .. i=0mBiAti=.. i=0mBiti+1− − .. i=0mABiti.. i=0mBiAti=.. i=0mABiti.{displaystyle {begin{aligned}left(sum) ¡No! ¿Por qué? ¿Por qué? ¿Qué? ¿Por qué? ¿Qué? ¿Qué? ¿Por qué?

Equipar los coeficientes muestra que para cada i, tenemos ABi = Bi A como desee. Habiendo encontrado la configuración adecuada en la que evA es de hecho un homomorfismo de anillos, uno puede completar el prueba como se sugirió anteriormente:

- evA ()p()t)In)=evA ()()tIn− − A)B)p()A)=evA ()tIn− − A)⋅ ⋅ evA ()B)p()A)=()AIn− − A)⋅ ⋅ evA ()B)=O⋅ ⋅ evA ()B)=O.{displaystyle {begin{aligned}operatorname {ev} _{A}left(p(t)I_{n}right) limit=operatorname {ev} _{A}(tI_{n}-A)B)[5pt]p(A) indulge=operatorname {ev} ¿Por qué? ¿Por qué?

Esto completa la prueba.

Una síntesis de las dos primeras demostraciones

En la primera demostración, se pudieron determinar los coeficientes Bi de B basado en la relación fundamental de la mano derecha para el adjunto solamente. De hecho, las primeras n ecuaciones derivadas pueden interpretarse como determinantes del cociente B de la división euclidiana del polinomio p(t)In a la izquierda por el polinomio mónico Int − A, mientras que la ecuación final expresa el hecho de que el resto es cero. Esta división se realiza en el anillo de polinomios con coeficientes matriciales. De hecho, incluso sobre un anillo no conmutativo, la división euclidiana por un polinomio mónico P está definida y siempre produce un único cociente y resto con el mismo condición de grado como en el caso conmutativo, siempre que se especifique en qué lado se desea que P sea un factor (aquí está a la izquierda).

Para ver que el cociente y el resto son únicos (que es la parte importante de la declaración aquí), basta escribir PQ+r=PQ.+r.{displaystyle PQ+r=PQ'+r' como P()Q− − Q.)=r.− − r{displaystyle P(Q-Q')=r'-r y observar eso desde entonces P es monic, P()Q−Q′) no puede tener un grado menos que el de P, a menos que Q = Q..

Pero el dividendo p(t)In y el divisor Int − A usados aquí, ambos se encuentran en el subanillo (R[A])[t], donde <span class="texhtml" R[A] es el subanillo del anillo matriz M( n, R) generado por A: el R-intervalo lineal de todas las potencias de A. Por lo tanto, la división euclidiana de hecho se puede realizar dentro de ese anillo polinomial conmutativo y, por supuesto, da el mismo cociente B y resto 0 como en el anillo más grande; en particular, esto muestra que B de hecho se encuentra en (R[ A])[t].

Pero, en esta configuración conmutativa, es válido establecer t en A en la ecuación

- p()t)In=()tIn− − A)B;{displaystyle p(t)I_{n}=(tI_{n}-A)B;}

en otras palabras, para aplicar el mapa de evaluación

- evA:()R[A])[t]→ → R[A]{displaystyle operatorname {ev} _{A}:(R[A])[t]to R[A]}

que es un homomorfismo de anillos, dando

- p()A)=0⋅ ⋅ evA ()B)=0{displaystyle p(A)=0cdot operatorname {ev} _{A}(B)=0}

al igual que en la segunda prueba, como se desee.

Además de probar el teorema, el argumento anterior nos dice que los coeficientes Bi de B son polinomios en A, mientras que de la segunda prueba solo sabíamos que se encuentran en el centralizador Z de A; en general Z es un subanillo más grande que R[A], y no necesariamente conmutativa. En particular, el término constante B0 = adj(−A) se encuentra en R[A]. Dado que A es una matriz cuadrada arbitraria, esto prueba que adj(A) siempre se puede expresar como un polinomio en A (con coeficientes que dependen de A).

De hecho, las ecuaciones encontradas en la primera prueba permiten expresar sucesivamente Bn− − 1,...... ,B1,B0{displaystyle B_{n-1},ldotsB_{1},B_{0} como polinomios en A, que conduce a la identidad

adj ()− − A)=.. i=1nciAi− − 1,{displaystyle operatorname {adj} (-A)=sum ¿Qué?

válido para todas las matrices n × n, donde

- p()t)=tn+cn− − 1tn− − 1+⋯ ⋯ +c1t+c0{displaystyle p(t)=t^{n}+c_{n-1}t^{n-1}+cdots +c_{1}t+c_{0}

es el polinomio característico de A.

Tenga en cuenta que esta identidad también implica el enunciado del teorema de Cayley-Hamilton: uno puede mover adj(−A) al lado derecho, multiplique la ecuación resultante (a la izquierda o a la derecha) por A y use el hecho de que

- − − A⋅ ⋅ adj ()− − A)=adj ()− − A)⋅ ⋅ ()− − A)=Det()− − A)In=c0In.{displaystyle -Acdot operatorname {adj} (-A)=operatorname {adj} (-A)cdot (-A)=det(-A)I_{n}=c_{0}I_{n}

Una prueba usando matrices de endomorfismos

Como se mencionó anteriormente, la matriz p()A) en la declaración del teorema se obtiene evaluando primero el determinante y luego sustitución de la matriz A para t; hacer esa sustitución en la matriz tIn− − A{displaystyle TI_{n}-A} antes de evaluar el determinante no es significativo. Sin embargo, es posible dar una interpretación cuando p()A) se obtiene directamente como el valor de un determinado determinante, pero esto requiere un ajuste más complicado, una de matrices sobre un anillo en el que se puede interpretar ambas entradas Ai,j{displaystyle A_{i,j} de A, y todo A en sí mismo. Uno podría tomar para esto el anillo M()n, R) de n×n matrices sobre R, donde la entrada Ai,j{displaystyle A_{i,j} se realiza como Ai,jIn{displaystyle A_{i,j}I_{n}, y A como ella misma. Pero considerar matrices con matrices como entradas puede causar confusión con matrices de bloque, que no se pretende, ya que eso da la noción equivocada de determinante (reconozca que el determinante de una matriz se define como una suma de productos de sus entradas, y en el caso de una matriz de bloques esto generalmente no es el mismo que la suma correspondiente de productos de sus bloques!). Es más claro distinguir A del endomorfismo φ of an n-dimensional espacio vectorial V (o libre R-module si R no es un campo) definido por él en una base e1,...... ,en{displaystyle e_{1},ldotse_{n}, y tomar matrices sobre el anillo Fin(VDe todos esos endomorfismos. Entonces... φ ¬V) es una posible entrada de matriz, mientras A designa el elemento de M()n, End(V) cuyo) i,j entrada es endomorfismo de la multiplicación del escalar por Ai,j{displaystyle A_{i,j}; de manera similar In{displaystyle I_{n} se interpretará como elemento M()n, End(V)). Sin embargo, desde End(V) no es un anillo conmutativo, ningún determinante se define en M()n, End(V)); esto sólo se puede hacer para matrices sobre una subringe conmutativa de End(V). Ahora las entradas de la matriz φ φ In− − A{displaystyle varphi I_{n}-A} todas las mentiras en el subring R[φ] generado por la identidad y φ, que es comunicativo. Entonces un mapa determinante M()n, R[φ]) → R[φ] se define, y Det()φ φ In− − A){displaystyle det(varphi I_{n}-A)} evalúa al valor p()φ) del polinomio característico de A a φ (esto mantiene independientemente de la relación entre A y φ); el teorema de Cayley-Hamilton declara que p()φ) es el endomorfismo nulo.

De esta forma, la siguiente prueba se puede obtener de la de (Atiyah & MacDonald 1969, Prop. 2.4) (que de hecho es la afirmación más general relacionada con el lema de Nakayama; se toma como ideal en esa proposición todo el anillo R). El hecho de que A sea la matriz de φ en la base e1,..., en significa que

- φ φ ()ei)=.. j=1nAj,iejparai=1,...... ,n.{displaystyle varphi (e_{i})=sum ¿Por qué?

Uno puede interpretarlos como n componentes de una ecuación en Vn, cuyos miembros pueden ser escritos usando el producto matriz-vector M()n, End(V) × Vn → Vn que se define como de costumbre, pero con entradas individuales ↑ ¬V) y v dentro V siendo "multiplicado" formando ↑ ↑ ()v){displaystyle psi (v)}; esto da:

- φ φ In⋅ ⋅ E=Atr⋅ ⋅ E,{displaystyle varphi I_{n}cdot E=A^{operatorname {tr}cdot E,}

Donde E▪ ▪ Vn{displaystyle Ein V^{n} es el elemento cuyo componente i es ei (en otras palabras es la base e1,... en de V escrito como columna de vectores). Escribir esta ecuación como

- ()φ φ In− − Atr)⋅ ⋅ E=0▪ ▪ Vn{displaystyle (varphi I_{n}-A^{operatorname {tr})cdot E=0in V^{n}

uno reconoce la transposición de la matriz φ φ In− − A{displaystyle varphi I_{n}-A} considerado anteriormente, y su determinante (como elemento M()n, R[φ]) es también p()φ). Para derivar de esta ecuación que p()φ) = 0.V), una izquierda-multiplies por la matriz adyugada de φ φ In− − Atr{displaystyle varphi Yo..., que se define en el anillo de matriz M()n, R[φ]), dar

- 0=adj ()φ φ In− − Atr)⋅ ⋅ ()()φ φ In− − Atr)⋅ ⋅ E)=()adj ()φ φ In− − Atr)⋅ ⋅ ()φ φ In− − Atr))⋅ ⋅ E=()Det()φ φ In− − Atr)In)⋅ ⋅ E=()p()φ φ )In)⋅ ⋅ E;{displaystyle {begin{aligned}0 ventaja=operatorname {adj} (varphi I_{n}-A^{operatorname {tr})cdot (varphi I_{n}-A^{operatorname {tr})cdot E)\\cdot=(operatorname {adj} (varphi I_{n}-A^{operatorname {tr})cdot (varphi I_{n}-A^{operatorname {tr}))cdot E\\cdot=(det(varphi I_{n}-A^{operatorname {tr})I_{n})cdot E\ Pulse=(varphi)I_{n})cdot E;end{aligned}}}

la asociatividad de la multiplicación matriz-matriz y matriz-vector utilizada en el primer paso es una propiedad puramente formal de esas operaciones, independientemente de la naturaleza de las entradas. Ahora el componente i de esta ecuación dice que p(φ)(ei) = 0 ∈ V; así p(φ) desaparece en todos los ei, y dado que estos elementos generar V se sigue que p(φ) = 0 ∈ End(V), completando la demostración.

Un hecho adicional que se desprende de esta prueba es que la matriz A cuyo polinomio característico se toma no necesita ser idéntica al valor φ sustituido en ese polinomio; basta que φ sea un endomorfismo de V que satisfaga las ecuaciones iniciales

- φ φ ()ei)=.. jAj,iej{displaystyle varphi (e_{i})=sum ¿Qué?

para alguna secuencia de elementos e1,..., e n que generan V (cuyo espacio puede tener menor dimensión que n, o en caso de que el anillo R sea no es un campo, puede que no sea un módulo gratuito).

Una 'prueba' falsa: p(A) = det(AIn − A) = det(A − A) = 0

Un argumento persistente elemental pero incorrecto para el teorema es "simplemente" toma la definición

- p()λ λ )=Det()λ λ In− − A){displaystyle p(lambda)=det(lambda) I_{n}-A)}

y sustituya A por λ , obteniendo

- p()A)=Det()AIn− − A)=Det()A− − A)=Det()0)=0.{displaystyle p(A)=det(AI_{n}-A)=det(A-A)=det(mathbf {0})=0.}

Hay muchas maneras de ver por qué este argumento es incorrecto. Primero, en el teorema de Cayley-Hamilton, p()A) es un n × n matriz. Sin embargo, el lado derecho de la ecuación anterior es el valor de un determinante, que es un scalar. Así que no pueden equipararse a menos que n= 1 (es decir. A es sólo un escalar). Segundo, en la expresión Det()λ λ In− − A){displaystyle det(lambda I_{n}-A)}, la variable λ realmente ocurre en las entradas diagonales de la matriz λ λ In− − A{displaystyle lambda Yo.... Para ilustrar, considere el polinomio característico en el ejemplo anterior de nuevo:

- Det()λ λ − − 1− − 2− − 3λ λ − − 4).{displaystyle det !{begin{pmatrix}lambda -1⁄2 3lambda -4end{pmatrix}}

Si se sustituye la matriz completa A por λ en esas posiciones, se obtiene

- Det()()1234)− − 1− − 2− − 3()1234)− − 4),{displaystyle det !{begin{pmatrix}{begin{pmatrix}1 tendría2334end{pmatrix}}}}}=-1 limit-2\\ 3 implica {begin{pmatrix}1 limit23 simultáneamente4end{pmatrix}}

en el que la "matriz" la expresión simplemente no es válida. Tenga en cuenta, sin embargo, que si múltiplos escalares de matrices de identidad en lugar de escalares se restan en lo anterior, es decir, si la sustitución se realiza como

- Det()()1234)− − I2− − 2I2− − 3I2()1234)− − 4I2),{displaystyle det !{begin{pmatrix}{begin{pmatrix}1⁄23 limitada4end{pmatrix}}}-I_{2} {2}3I_{2}3I_{2} {begin{pmatrix}1}23}} {pmatrix} {i}} {i}} {i}}}}}}}} {i} {i} {i} {i}} {i}}}} {i}}i}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {i} {i} {i} {i}}}} {i}}}}}}}i}}i}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}

entonces el determinante es de hecho cero, pero la matriz expandida en cuestión no evalúa AIn− − A{displaystyle - ¿Sí?; ni su determinante (un escalar) puede compararse con p()A) (una matriz). Así que el argumento de que p()A)=Det()AIn− − A)=0{displaystyle p(A)=det(AI_{n}-A)=0} todavía no se aplica.

En realidad, si tal argumento sostiene, también debe sostener cuando se utilizan otras formas multilineales en lugar de determinante. Por ejemplo, si consideramos la función permanente y define q()λ λ )=perm ()λ λ In− − A){displaystyle q(lambda)=operatorname {perm} (lambda I_{n}-A)}, entonces por el mismo argumento, debemos ser capaces de "probar" que q()A) = 0. Pero esta afirmación es manifiestamente errónea: en el caso 2-dimensional, por ejemplo, el permanente de una matriz es dado por

- perm()abcd)=ad+bc.{displaystyle operatorname {perm} {begin{pmatrix}a trob\cnciadend{pmatrix}=ad+bc.}

Entonces, para la matriz A del ejemplo anterior,

- q()λ λ )=perm ()λ λ I2− − A)=perm()λ λ − − 1− − 2− − 3λ λ − − 4)=()λ λ − − 1)()λ λ − − 4)+()− − 2)()− − 3)=λ λ 2− − 5λ λ +10.{displaystyle {begin{aligned}q(lambda) limit=operatorname {perm} (lambda) I_{2}-A)=operatorname {perm} !{begin{pmatrix}lambda -1⁄2\3lambda -4end{pmatrix}[6pt] -1)(lambda -4)+(-2)(-3)=lambda ^{2}-5lambda +10.

Sin embargo, uno puede verificar que

- q()A)=A2− − 5A+10I2=12I2ل0.{displaystyle q(A)=A^{2}-5A+10I_{2}=12I_{2}not =0.}

Una de las pruebas para el teorema de Cayley-Hamilton arriba tiene cierta similitud con el argumento de que p()A)=Det()AIn− − A)=0{displaystyle p(A)=det(AI_{n}-A)=0}. Al introducir una matriz con coeficientes no numéricos, se puede permitir A vivir dentro de una entrada de matriz, pero luego AIn{displaystyle ¿Sí? no es igual a A, y la conclusión se alcanza de manera diferente.

Pruebas usando métodos de álgebra abstracta

Propiedades básicas de las derivaciones Hasse–Schmidt en el álgebra exterior A=⋀ ⋀ M{displaystyle A=bigwedge M} de algunos B- Mobiliario M (debido a ser libre y de rango finito) han sido utilizados por Gatto & Salehyan (2016, §4) para probar el teorema Cayley-Hamilton. Vea también Gatto & Scherbak (2015).

Abstracción y generalizaciones

Las demostraciones anteriores muestran que el teorema de Cayley-Hamilton se cumple para matrices con entradas en cualquier anillo conmutativo R, y que p(φ) = 0 siempre que φ sea un endomorfismo de un módulo R generado por los elementos e1,...,en que satisface

- φ φ ()ej)=.. aijei,j=1,...... ,n.{displaystyle varphi (e_{j})=sum a_{ij}e_{i},qquad j=1,ldotsn.}

Esta versión más general del teorema es la fuente del célebre lema de Nakayama en álgebra conmutativa y geometría algebraica.

Observaciones

- ^ Debido a la naturaleza no recíproca de la operación de multiplicación para las cuaternidades y construcciones conexas, es necesario tener cuidado con definiciones, sobre todo en este contexto, para el determinante. El teorema sostiene también para las cuadrillas ligeramente menos bien transformadas, véase Alagös, Oral & Yüce (2012). Los anillos de las cuaterniones y las cuaterniones divididas pueden ser representados por ciertos 2 × 2 matrices complejas. (Cuando se restringen a la norma unitaria, estos son los grupos SU(2) y SU(1,1) respectivamente.) Por lo tanto no es sorprendente que el teorema sostiene.

No existe tal representación matriz para las octoniones, ya que la operación de multiplicación no es asociativa en este caso. Sin embargo, un teorema de Cayley-Hamilton modificado todavía mantiene para las octoniones, ver Tian (2000). - ^ Una expresión explícita para estos coeficientes es

- ci=.. k1,k2,...... ,kn∏ ∏ l=1n()− − 1)kl+1lklkl!tr ()Al)kl,{displaystyle C_{i}=sum ¿Qué? ¿Por qué?

- .. l=1nlkl=n− − i.{displaystyle sum _{l=1}{n}lk_{l}=n-i.}

- ^ Véase, p. 54 de Brown 1994, que resuelve la fórmula de Jacobi,

- ∂ ∂ p()λ λ )/∂ ∂ λ λ =p()λ λ ).. m=0JUEGO JUEGO λ λ − − ()m+1)tr Am=p()λ λ )tr Iλ λ I− − A↑ ↑ tr B,{displaystyle partial p(lambda)/partial lambda =p(lambda)sum _{m=0}^{infty }lambda ^{-(m+1)}operatorname {tr} A^{m}=p(lambda)~operatorname {tr} {frac}{lambda I-A}equiv operatorname {tr} B~,}

- M0↑ ↑ Ocn=1()k=0)Mk↑ ↑ AMk− − 1− − 1k− − 1()tr ()AMk− − 1))Icn− − k=− − 1ktr ()AMk)k=1,...... ,n.{displaystyle {begin{aligned}M_{0} O,c_{n} limit=1qquad >[5pt]M_{k} limitequiv AM_{k-1}-{frac {1} {operatorname {tr} (AM_{k-1}) Iqquad qquad - ¿Qué? {1}{k}operatorname {tr} (AM_{k})qquad &k=1,ldotsn~.end{aligned}}}

- λ λ p.− − np=tr ()AB),{displaystyle lambda p'-np=operatorname {tr} (AB)~,} (Hou 1998), y las recursiones anteriores, a su vez.

Contenido relacionado

Integracion numerica

Grupo de simetría

♯P

![{displaystyle {begin{aligned}A^{-1}&={frac {(-1)^{n-1}}{det A}}(A^{n-1}+c_{n-1}A^{n-2}+cdots +c_{1}I_{n}),\[5pt]&={frac {1}{det A}}sum _{k=0}^{n-1}(-1)^{n+k-1}{frac {A^{n-k-1}}{k!}}B_{k}(s_{1},-1!s_{2},2!s_{3},ldots(-1)^{k-1}(k-1)!s_{k}).end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d829693b70a4ff6f4d2987aff56755dd9cbc3f41)

![{displaystyle {begin{aligned}c_{2}=B_{0}=1,\[4pt]c_{1}={frac {-1}{1!}}B_{1}(s_{1})=-s_{1}=-operatorname {tr} (A),\[4pt]c_{0}={frac {1}{2!}}B_{2}(s_{1},-1!s_{2})={frac {1}{2}}(s_{1}^{2}-s_{2})={frac {1}{2}}((operatorname {tr} (A))^{2}-operatorname {tr} (A^{2})).end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8dc8d4c3385c920546fb29869d5462c9a956cbe3)

![{displaystyle {begin{aligned}det(A)&={frac {1}{3!}}B_{3}(s_{1},-1!s_{2},2!s_{3})={frac {1}{6}}(s_{1}^{3}+3s_{1}(-s_{2})+2s_{3})\[5pt]&={tfrac {1}{6}}left((operatorname {tr} A)^{3}-3operatorname {tr} (A^{2})(operatorname {tr} A)+2operatorname {tr} (A^{3})right).end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/32f9dcc24ba00f606bfb96884a54aac9fa52367c)

![{displaystyle mathbb {Q} [alpha _{1},ldotsalpha _{k}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c4b2735f38d917ea281077f90aafb09b57048c9f)

![{displaystyle alpha in mathbb {Q} [alpha _{1},ldotsalpha _{k}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/94b33007a417d58d288a3329d6a9fd41bbb62374)

![{displaystyle cdot alpha:mathbb {Q} [alpha _{1},ldotsalpha _{k}]to mathbb {Q} [alpha _{1},ldotsalpha _{k}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6c9eb4efaa6c235fa328c36417f488d08b3de328)

![{displaystyle {begin{aligned}p(t)&=det(tI_{n}-A)={begin{vmatrix}t-a_{1,1}&-a_{1,2}&cdots &-a_{1,n}\-a_{2,1}&t-a_{2,2}&cdots &-a_{2,n}\vdots &vdots &ddots &vdots \-a_{n,1}&-a_{n,2}&cdots &t-a_{n,n}end{vmatrix}}\[5pt]&=t^{n}+c_{n-1}t^{n-1}+cdots +c_{1}t+c_{0},end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/93ae9a358221f8217accfeafbb4be81cefb39e64)

![{displaystyle {begin{aligned}p(A)cdot v&=A^{n}cdot v+c_{n-1}A^{n-1}cdot v+cdots +c_{1}Acdot v+c_{0}I_{n}cdot v\[6pt]&=lambda ^{n}v+c_{n-1}lambda ^{n-1}v+cdots +c_{1}lambda v+c_{0}v=p(lambda)v,end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5bb423807c1f1495837f788d327dd38269ecc76d)

![{displaystyle M(n,R[t])}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c12294e2bbfae7a6371e0fe046062e13e8551665)

![{displaystyle M(n,R)[t]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/64a0ef8fa32aee2d525034794f4bd05c0cf9d86e)

![{displaystyle {begin{aligned}operatorname {ev} _{A}left(p(t)I_{n}right)&=operatorname {ev} _{A}((tI_{n}-A)B)\[5pt]p(A)&=operatorname {ev} _{A}(tI_{n}-A)cdot operatorname {ev} _{A}(B)\[5pt]p(A)&=(AI_{n}-A)cdot operatorname {ev} _{A}(B)=Ocdot operatorname {ev} _{A}(B)=O.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1ddb718ff8f185b8c413771059d34851851aaa03)

![operatorname {ev} _{A}:(R[A])[t]to R[A]](https://wikimedia.org/api/rest_v1/media/math/render/svg/34daccdfc45884e2d8db35f36235f9fd83709aa0)

![{displaystyle {begin{aligned}q(lambda)&=operatorname {perm} (lambda I_{2}-A)=operatorname {perm} !{begin{pmatrix}lambda -1&-2\-3&lambda -4end{pmatrix}}\[6pt]&=(lambda -1)(lambda -4)+(-2)(-3)=lambda ^{2}-5lambda +10.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6345280571b5d465ee0e9d4c8403f0ead580e806)

![{displaystyle {begin{aligned}M_{0}&equiv O&c_{n}&=1qquad &(k=0)\[5pt]M_{k}&equiv AM_{k-1}-{frac {1}{k-1}}(operatorname {tr} (AM_{k-1}))Iqquad qquad &c_{n-k}&=-{frac {1}{k}}operatorname {tr} (AM_{k})qquad &k=1,ldotsn~.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/14ee340d1fd2cbc359cd844e75cc1bb8b3284a3b)