Relación antisimétrica

(leer más)

En teoría de probabilidad y estadística, el teorema de Bayes (alternativamente ley de Bayes o regla de Bayes; recientemente teorema de Bayes-Price), llamado así por Thomas Bayes, describe la probabilidad de un evento, basado en el conocimiento previo de las condiciones que podrían estar relacionadas con el evento. Por ejemplo, si se sabe que el riesgo de desarrollar problemas de salud aumenta con la edad, el teorema de Bayes permite que el riesgo de un individuo de una edad conocida se evalúe con mayor precisión (condicionándolo a su edad) que simplemente asumiendo que el individuo es típico de la población en su conjunto.

Una de las muchas aplicaciones del teorema de Bayes es la inferencia bayesiana, un enfoque particular de la inferencia estadística. Cuando se aplican, las probabilidades involucradas en el teorema pueden tener diferentes interpretaciones de probabilidad. Con la interpretación de probabilidad bayesiana, el teorema expresa cómo un grado de creencia, expresado como probabilidad, debería cambiar racionalmente para dar cuenta de la disponibilidad de evidencia relacionada. La inferencia bayesiana es fundamental para las estadísticas bayesianas.

El teorema de Bayes se expresa matemáticamente como la siguiente ecuación:

donde

es una probabilidad condicional: la probabilidad de que

es una probabilidad condicional: la probabilidad de que  ocurra un evento dado que

ocurra un evento dado que  es verdadero. También se le llama probabilidad posterior de

es verdadero. También se le llama probabilidad posterior de  dado

dado  .

. es también una probabilidad condicional: la probabilidad de que

es también una probabilidad condicional: la probabilidad de que  ocurra un evento dado que

ocurra un evento dado que  es cierto. También se puede interpretar como la probabilidad de dado un porque

es cierto. También se puede interpretar como la probabilidad de dado un porque  fijo.

fijo.

y

y  son las probabilidades de observar

son las probabilidades de observar  y

y  respectivamente sin ninguna condición dada; se les conoce como probabilidad marginal o probabilidad previa.

respectivamente sin ninguna condición dada; se les conoce como probabilidad marginal o probabilidad previa. y

y  deben ser eventos diferentes.

deben ser eventos diferentes.El teorema de Bayes puede derivarse de la definición de probabilidad condicional:

donde

Resolviendo

Para dos variables aleatorias continuas X e Y, el teorema de Bayes puede derivarse análogamente de la definición de densidad condicional:

Por lo tanto,

La regla de Bayes y el cálculo de probabilidades condicionales proporcionan un método de solución para una serie de acertijos populares, como el problema de los tres prisioneros, el problema de Monty Hall, el problema de los dos niños y el problema de los dos sobres.

Supongamos que una prueba particular para determinar si alguien ha estado usando cannabis tiene una sensibilidad del 90 %, lo que significa que la tasa de verdaderos positivos (TPR) = 0,90. Por lo tanto, conduce a un 90% de resultados positivos verdaderos (identificación correcta del consumo de drogas) para los consumidores de cannabis.

La prueba también tiene una especificidad del 80 %, lo que significa una tasa de verdaderos negativos (TNR) = 0,80. Por lo tanto, la prueba identifica correctamente el 80 % de la falta de uso para los no usuarios, pero también genera un 20 % de falsos positivos, o tasa de falsos positivos (FPR) = 0,20, para los no usuarios.

Suponiendo una prevalencia de 0,05, lo que significa que el 5 % de las personas consumen cannabis, ¿cuál es la probabilidad de que una persona aleatoria que dé positivo sea realmente un consumidor de cannabis?

El valor predictivo positivo (VPP) de una prueba es la proporción de personas que realmente son positivas de todas las que dieron positivo, y se puede calcular a partir de una muestra como:VPP = Verdadero positivo / Probado positivo

Si se conocen la sensibilidad, la especificidad y la prevalencia, el VPP se puede calcular mediante el teorema de Bayes. Digamos

El hecho de que

En otras palabras, incluso si alguien da positivo, la probabilidad de que sea un consumidor de cannabis es solo del 19%, esto se debe a que en este grupo, solo el 5% de las personas son usuarios, y la mayoría de los positivos son falsos positivos provenientes del 95% restante..

Si se hiciera la prueba a 1000 personas:

Las 1.000 personas arrojan así 235 pruebas positivas, de las cuales sólo 45 son auténticos consumidores de drogas, alrededor del 19%. Consulte la Figura 1 para ver una ilustración que usa un cuadro de frecuencia y observe cuán pequeña es el área rosa de los verdaderos positivos en comparación con el área azul de los falsos positivos.

La importancia de la especificidad se puede ver al mostrar que incluso si la sensibilidad se eleva al 100 % y la especificidad se mantiene en el 80 %, la probabilidad de que alguien que dé positivo sea realmente un consumidor de cannabis solo aumenta del 19 % al 21 %, pero si la sensibilidad es mantenida en 90% y la especificidad aumenta a 95%, la probabilidad aumenta a 49%.

| PruebaActual | Positivo | Negativo | Total | |

|---|---|---|---|---|

| Usuario | 45 | 5 | 50 | |

| No usuario | 190 | 760 | 950 | |

| Total | 235 | 765 | 1000 | |

| 90% sensible, 80% específico, VPP=45/235 ≈ 19% |

| PruebaActual | Positivo | Negativo | Total | |

|---|---|---|---|---|

| Usuario | 50 | 0 | 50 | |

| No usuario | 190 | 760 | 950 | |

| Total | 240 | 760 | 1000 | |

| 100% sensible, 80% específico, VPP=50/240 ≈ 21% |

| PruebaActual | Positivo | Negativo | Total | |

|---|---|---|---|---|

| Usuario | 45 | 5 | 50 | |

| No usuario | 47 | 903 | 950 | |

| Total | 92 | 908 | 1000 | |

| 90% sensible, 95% específico, VPP=45/92 ≈ 49% |

Incluso si el 100 % de los pacientes con cáncer de páncreas tienen un síntoma determinado, cuando alguien tiene el mismo síntoma, no significa que esa persona tenga un 100 % de posibilidades de contraer cáncer de páncreas. Suponiendo que la tasa de incidencia de cáncer de páncreas es 1/100000, mientras que 10/99999 personas sanas tienen los mismos síntomas en todo el mundo, la probabilidad de tener cáncer de páncreas dados los síntomas es solo del 9,1 %, y el otro 90,9 % podrían ser "falsos positivos" (es decir, se dice falsamente que tiene cáncer; "positivo" es un término confuso cuando, como aquí, la prueba da malas noticias).

Con base en la tasa de incidencia, la siguiente tabla presenta los números correspondientes por cada 100.000 personas.

| SíntomaCáncer | Sí | No | Total | |

|---|---|---|---|---|

| Sí | 1 | 0 | 1 | |

| No | 10 | 99989 | 99999 | |

| Total | 11 | 99989 | 100000 |

Que luego se puede usar para calcular la probabilidad de tener cáncer cuando tiene los síntomas:

| CondiciónMáquina | Defectuoso | Impecable | Total | |

|---|---|---|---|---|

| UN | 10 | 190 | 200 | |

| B | 9 | 291 | 300 | |

| C | 5 | 495 | 500 | |

| Total | 24 | 976 | 1000 |

Una fábrica produce un artículo utilizando tres máquinas, A, B y C, que representan el 20 %, 30 % y 50 % de su producción, respectivamente. De los artículos producidos por la máquina A, el 5% son defectuosos; De manera similar, el 3% de los elementos de la máquina B y el 1% de los de la máquina C están defectuosos. Si un artículo seleccionado al azar es defectuoso, ¿cuál es la probabilidad de que haya sido producido por la máquina C?

Una vez más, se puede llegar a la respuesta sin utilizar la fórmula aplicando las condiciones a un número hipotético de casos. Por ejemplo, si la fábrica produce 1,000 artículos, la Máquina A producirá 200, la Máquina B 300 y la Máquina C 500. La Máquina A producirá 5% × 200 = 10 artículos defectuosos, la Máquina B 3% × 300 = 9, y Máquina C 1% × 500 = 5, para un total de 24. Por lo tanto, la probabilidad de que la máquina C produzca un artículo defectuoso seleccionado al azar es 5/24 (~20,83%).

Este problema también se puede resolver utilizando el teorema de Bayes: Sea X i el evento de que la máquina i elaboró un elemento elegido al azar (para i = A,B,C). Sea Y el evento de que un artículo elegido al azar sea defectuoso. Entonces, se nos da la siguiente información:

Si el artículo fue fabricado por la primera máquina, entonces la probabilidad de que esté defectuoso es 0.05; es decir, P (Y | X A) = 0,05. En general, tenemos

Para responder a la pregunta original, primero encontramos P (Y). Eso se puede hacer de la siguiente manera:

Por lo tanto, el 2,4% de la producción total es defectuosa.

Sabemos que ha ocurrido Y, y queremos calcular la probabilidad condicional de X C. Por el teorema de Bayes,

Dado que el artículo es defectuoso, la probabilidad de que haya sido fabricado por la máquina C es 5/24. Aunque la máquina C produce la mitad de la producción total, produce una fracción mucho menor de los artículos defectuosos. Por lo tanto, el conocimiento de que el elemento seleccionado era defectuoso nos permite reemplazar la probabilidad anterior P (X C) = 1/2 por la probabilidad posterior más pequeña P (X C | Y) = 5/24.

La interpretación de la regla de Bayes depende de la interpretación de la probabilidad atribuida a los términos. Las dos interpretaciones principales se describen a continuación. La figura 2 muestra una visualización geométrica similar a la figura 1. Gerd Gigerenzer y sus coautores se han esforzado mucho por enseñar la regla de Bayes de esta manera, con especial énfasis en enseñarla a los médicos. Un ejemplo es la página web de Will Kurt, "Teorema de Bayes con Lego", que luego se convirtió en el libro Bayesian Statistics the Fun Way: Understanding Statistics and Probability with Star Wars, LEGO, and Rubber Ducks. Zhu y Gigerenzer encontraron en 2006 que mientras que el 0 % de los alumnos de 4.°, 5.° y 6.° grado podían resolver problemas verbales después de que se les enseñara con fórmulas, el 19 %, 39 % y 53 % podían hacerlo después de que se les enseñara con cuadros de frecuencia.

En la interpretación bayesiana (o epistemológica), la probabilidad mide un "grado de creencia". El teorema de Bayes vincula el grado de creencia en una proposición antes y después de dar cuenta de la evidencia. Por ejemplo, supongamos que se cree con un 50% de certeza que una moneda tiene el doble de probabilidades de salir cara que cruz. Si se lanza la moneda varias veces y se observan los resultados, ese grado de creencia probablemente aumentará o disminuirá, pero incluso podría permanecer igual, según los resultados. Para la proposición A y la evidencia B,

Para obtener más información sobre la aplicación del teorema de Bayes bajo la interpretación bayesiana de la probabilidad, consulte Inferencia bayesiana.

En la interpretación frecuentista, la probabilidad mide una "proporción de resultados". Por ejemplo, supongamos que un experimento se realiza muchas veces. P (A) es la proporción de resultados con la propiedad A (la previa) y P (B) es la proporción con la propiedad B. P (B | A) es la proporción de resultados con la propiedad B de los resultados con la propiedad A, y P (A | B) es la proporción de los que tienen A de los que tienen B(el posterior).

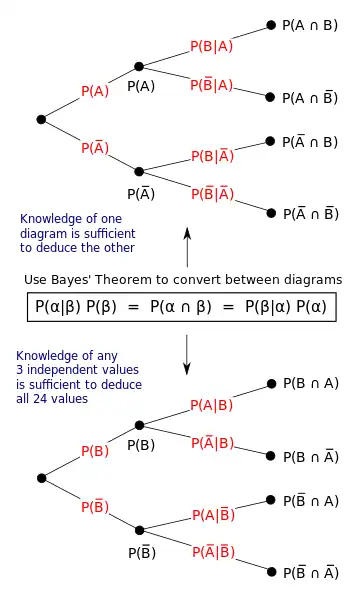

El papel del teorema de Bayes se visualiza mejor con diagramas de árbol como el de la Figura 3. Los dos diagramas dividen los mismos resultados por A y B en órdenes opuestos, para obtener las probabilidades inversas. El teorema de Bayes vincula las diferentes particiones.

Un entomólogo detecta lo que podría ser, debido al patrón en su espalda, una rara subespecie de escarabajo. Un 98 % de los miembros de las subespecies raras tienen el patrón, por lo que P (Patrón | Raro) = 98 %. Solo el 5% de los miembros de la subespecie común tienen el patrón. La subespecie rara es el 0,1% de la población total. ¿Qué probabilidad hay de que el escarabajo que tiene el patrón sea raro: qué es P (Raro | Patrón)?

De la forma extendida del teorema de Bayes (dado que cualquier escarabajo es raro o común),

Para los eventos A y B, siempre que P (B) ≠ 0,

En muchas aplicaciones, por ejemplo en la inferencia bayesiana, el evento B está fijo en la discusión y deseamos considerar el impacto de haberlo observado en nuestra creencia en varios eventos A posibles. En tal situación, el denominador de la última expresión, la probabilidad de la evidencia B dada, es fijo; lo que queremos variar es A. El teorema de Bayes muestra entonces que las probabilidades posteriores son proporcionales al numerador, por lo que la última ecuación se convierte en:

En palabras, el posterior es proporcional al anterior por la probabilidad.

Si los eventos A 1, A 2,..., son mutuamente excluyentes y exhaustivos, es decir, es seguro que uno de ellos ocurrirá pero no pueden ocurrir dos juntos, podemos determinar la constante de proporcionalidad utilizando el hecho de que sus probabilidades deben sumarse a uno. Por ejemplo, para un evento A dado, el evento A mismo y su complemento ¬A son exclusivos y exhaustivos. Denotando la constante de proporcionalidad por c tenemos

Sumando estas dos fórmulas deducimos que

o

| FondoProposición | B | ¬B(no B) | Total | |

|---|---|---|---|---|

| UN | P(B|A)·P(A)= P(A|B)·P(B) | P(¬B|A)·P(A)= P(A|¬B)·P(¬B) | PENSILVANIA) | |

| ¬A(no A) | P(B|¬A)·P(¬A)= P(¬A|B)·P(B) | P(¬B|¬A)·P(¬A)= P(¬A|¬B)·P(¬B) | P(¬A) =1−P(A) | |

| Total | P(B) | P(¬B) = 1−P(B) | 1 |

Otra forma del teorema de Bayes para dos declaraciones o hipótesis en competencia es:

Para una interpretación epistemológica:

Para la proposición A y la evidencia o antecedentes B,

es la probabilidad previa, el grado inicial de creencia en A.

es la probabilidad previa, el grado inicial de creencia en A. es el correspondiente grado inicial de creencia en no-A, que A es falso, donde

es el correspondiente grado inicial de creencia en no-A, que A es falso, donde

es la probabilidad condicional o verosimilitud, el grado de creencia en B dado que la proposición A es verdadera.

es la probabilidad condicional o verosimilitud, el grado de creencia en B dado que la proposición A es verdadera. es la probabilidad condicional o verosimilitud, el grado de creencia en B dado que la proposición A es falsa.

es la probabilidad condicional o verosimilitud, el grado de creencia en B dado que la proposición A es falsa. es la probabilidad posterior, la probabilidad de A después de tener en cuenta B.

es la probabilidad posterior, la probabilidad de A después de tener en cuenta B.A menudo, para alguna partición { A j } del espacio muestral, el espacio de eventos se da en términos de P (A j) y P (B | A j). Entonces es útil calcular P (B) usando la ley de probabilidad total:

En el caso especial donde A es una variable binaria:

Considere un espacio muestral Ω generado por dos variables aleatorias X e Y. En principio, el teorema de Bayes se aplica a los eventos A = { X = x } y B = { Y = y }.

Sin embargo, los términos se vuelven 0 en los puntos donde cualquiera de las variables tiene una densidad de probabilidad finita. Para seguir siendo útil, el teorema de Bayes debe formularse en términos de las densidades relevantes (ver Derivación).

Si X es continuo e Y es discreto,

donde cada uno

Si X es discreto e Y es continuo,

Si tanto X como Y son continuos,

Un espacio de eventos continuo a menudo se conceptualiza en términos de los términos del numerador. Entonces es útil eliminar el denominador usando la ley de probabilidad total. Para f Y (y), esto se convierte en una integral:

El teorema de Bayes en forma de probabilidades es:

donde

recibe el nombre de factor de Bayes o razón de verosimilitud. La probabilidad entre dos eventos es simplemente la relación de las probabilidades de los dos eventos. Por lo tanto

Por lo tanto, la regla dice que las probabilidades posteriores son las probabilidades anteriores multiplicadas por el factor de Bayes, o en otras palabras, la posterior es proporcional a la probabilidad anterior multiplicada por la probabilidad.

En el caso especial de que

o, en palabras, las probabilidades posteriores de son

Por ejemplo, si una prueba médica tiene una sensibilidad del 90% y una especificidad del 91%, entonces el factor de Bayes positivo es

El ejemplo anterior también se puede entender con números más sólidos: suponga que el paciente que se hace la prueba pertenece a un grupo de 1000 personas, donde 91 de ellas tienen la enfermedad (prevalencia del 9,1%). Si todas estas 1000 personas se hacen la prueba médica, 82 de las que padecen la enfermedad obtendrán un resultado positivo verdadero (sensibilidad del 90,1 %), 9 de las que padecen la enfermedad obtendrán un resultado falso negativo (tasa de falso negativo del 9,9 %), 827 de los que no tienen la enfermedad obtendrán un resultado negativo verdadero (especificidad del 91,0 %) y 82 de los que no tienen la enfermedad obtendrán un resultado falso positivo (tasa de falso positivo del 9,0 %). Antes de realizar cualquier prueba, la probabilidad de que el paciente tenga la enfermedad es de 91:909. Después de recibir un resultado positivo, la probabilidad de que el paciente tenga la enfermedad es

lo cual es consistente con el hecho de que hay 82 verdaderos positivos y 82 falsos positivos en el grupo de 1000 personas.

Usando

cuando

En palabras: Si ciertamente

Nótese que en esta relación entre implicaciones, las posiciones de

La fórmula correspondiente en términos de cálculo de probabilidad es el teorema de Bayes, que en su forma expandida que involucra la probabilidad previa/tasa base

El teorema de Bayes representa un caso especial de derivación de opiniones condicionales invertidas en lógica subjetiva expresada como:

donde

Por lo tanto, el teorema subjetivo de Bayes representa una generalización del teorema de Bayes.

Una versión condicionada del teorema de Bayes resulta de la adición de un tercer evento

Usando la regla de la cadena

Y, por otro lado

El resultado deseado se obtiene identificando ambas expresiones y resolviendo para

En el caso de 3 eventos, A, B y C, se puede demostrar que:

Prueba

![{displaystyle {begin{alineado}P(Amid B,C)&={frac {P(A,B,C)}{P(B,C)}}\[1ex]&={ frac {P(Bmid A,C),P(A,C)}{P(B,C)}}\[1ex]&={frac {P(Bmid A,C) ,P(Amid C),P(C)}{P(B,C)}}\[1ex]&={frac {P(Bmid A,C),P(A mid C)P(C)}{P(Bmid C)P(C)}}\[1ex]&={frac {P(Bmid A,C);P(Amid C)}{P(Bmid C)}}end{alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ddebefba390af111ae5d0cf7dd41f4c38b1ba519)

El teorema de Bayes lleva el nombre del reverendo Thomas Bayes (/ b eɪ z /; c. 1701 - 1761), quien usó por primera vez la probabilidad condicional para proporcionar un algoritmo (su Proposición 9) que usa evidencia para calcular límites en un parámetro desconocido, publicado como Ensayo para resolver un problema en la doctrina de las posibilidades (1763). Estudió cómo calcular una distribución para el parámetro de probabilidad de una distribución binomial (en terminología moderna). A la muerte de Bayes, su familia transfirió sus documentos a su viejo amigo, Richard Price (1723-1791), quien durante un período de dos años editó significativamente el manuscrito inédito, antes de enviárselo a un amigo que lo leyó en voz alta en la Royal Society el 23 de diciembre. 1763. Precio editadoEl trabajo principal de Bayes "Un ensayo para resolver un problema en la doctrina de las posibilidades" (1763), que apareció en Philosophical Transactions y contiene el teorema de Bayes. Price escribió una introducción al artículo que proporciona algunas de las bases filosóficas de las estadísticas bayesianas y eligió una de las dos soluciones ofrecidas por Bayes. En 1765, Price fue elegido miembro de la Royal Society en reconocimiento a su trabajo sobre el legado de Bayes. El 27 de abril, se leyó en la Royal Society una carta enviada a su amigo Benjamin Franklin, y luego se publicó, donde Price aplica este trabajo a la población y al cálculo de las "rentas vitalicias".

Independientemente de Bayes, Pierre-Simon Laplace en 1774, y más tarde en su Théorie analytique des probabilités de 1812, utilizó la probabilidad condicional para formular la relación de una probabilidad posterior actualizada a partir de una probabilidad anterior, dada la evidencia. Reprodujo y amplió los resultados de Bayes en 1774, aparentemente sin conocer el trabajo de Bayes. La interpretación bayesiana de la probabilidad fue desarrollada principalmente por Laplace.

Sir Harold Jeffreys puso el algoritmo de Bayes y la formulación de Laplace sobre una base axiomática, escribiendo que el teorema de Bayes "es para la teoría de la probabilidad lo que el teorema de Pitágoras es para la geometría".

Stephen Stigler usó un argumento bayesiano para concluir que el teorema de Bayes fue descubierto por Nicholas Saunderson, un matemático inglés ciego, algún tiempo antes que Bayes; esa interpretación, sin embargo, ha sido discutida. Martyn Hooper y Sharon McGrayne han argumentado que la contribución de Richard Price fue sustancial:

Según los estándares modernos, deberíamos referirnos a la regla de Bayes-Price. Price descubrió el trabajo de Bayes, reconoció su importancia, lo corrigió, contribuyó al artículo y le encontró un uso. La convención moderna de emplear solo el nombre de Bayes es injusta pero está tan arraigada que cualquier otra cosa tiene poco sentido.

En genética, el teorema de Bayes se puede utilizar para calcular la probabilidad de que un individuo tenga un genotipo específico. Muchas personas buscan aproximarse a sus posibilidades de verse afectados por una enfermedad genética o su probabilidad de ser portadores de un gen recesivo de interés. Se puede realizar un análisis bayesiano basado en antecedentes familiares o pruebas genéticas, para predecir si un individuo desarrollará una enfermedad o se la transmitirá a sus hijos. Las pruebas y predicciones genéticas son una práctica común entre las parejas que planean tener hijos pero les preocupa que ambos puedan ser portadores de una enfermedad, especialmente en comunidades con baja variación genética.

El primer paso en el análisis bayesiano para la genética es proponer hipótesis mutuamente excluyentes: para un alelo específico, un individuo es o no es portador. A continuación, se calculan cuatro probabilidades: Probabilidad Previa (la probabilidad de que cada hipótesis considere información como antecedentes familiares o predicciones basadas en la Herencia Mendeliana), Probabilidad Condicional (de un resultado determinado), Probabilidad Conjunta (producto de las dos primeras) y Posterior Probabilidad (un producto ponderado calculado dividiendo la Probabilidad Conjunta de cada hipótesis por la suma de ambas probabilidades conjuntas). Este tipo de análisis se puede realizar basándose únicamente en los antecedentes familiares de una afección o junto con pruebas genéticas.

| Hipótesis | Hipótesis 1: El paciente es portador | Hipótesis 2: El paciente no es portador |

|---|---|---|

| probabilidad previa | 1/2 | 1/2 |

| Probabilidad condicional de que los cuatro descendientes no se vean afectados | (1/2) · (1/2) · (1/2) · (1/2) = 1/16 | Alrededor de 1 |

| Probabilidad conjunta | (1/2) · (1/16) = 1/32 | (1/2) · 1 = 1/2 |

| Probabilidad posterior | (1/32) / (1/32 + 1/2) = 1/17 | (1/2) / (1/32 + 1/2) = 16/17 |

Ejemplo de una tabla de análisis bayesiano para el riesgo de una mujer de padecer una enfermedad basada en el conocimiento de que la enfermedad está presente en sus hermanos pero no en sus padres ni en ninguno de sus cuatro hijos. Basándose únicamente en el estado de los hermanos y padres del sujeto, es igualmente probable que sea portadora que no portadora (esta probabilidad se indica mediante la hipótesis previa). Sin embargo, la probabilidad de que los cuatro hijos del sujeto no se vean afectados es 1/16 (½·½·½·½) si ella es portadora, aproximadamente 1 si no es portadora (esta es la probabilidad condicional). La probabilidad conjunta reconcilia estas dos predicciones multiplicándolas juntas. La última línea (la Probabilidad Posterior) se calcula dividiendo la Probabilidad Conjunta de cada hipótesis por la suma de ambas probabilidades conjuntas.

Las pruebas genéticas de los padres pueden detectar alrededor del 90 % de los alelos de enfermedades conocidas en los padres que pueden conducir a un estado de portador o afectado en su hijo. La fibrosis quística es una enfermedad hereditaria causada por una mutación autosómica recesiva en el gen CFTR, ubicado en el brazo q del cromosoma 7.

Análisis bayesiano de una paciente con antecedentes familiares de fibrosis quística (FQ), que dio negativo en la prueba de FQ, lo que demuestra cómo se utilizó este método para determinar su riesgo de tener un hijo con FQ:

Debido a que la paciente no está afectada, es homocigota para el alelo de tipo salvaje o heterocigota. Para establecer probabilidades previas se utiliza un cuadro de Punnett, basado en el conocimiento de que ninguno de los padres estaba afectado por la enfermedad pero ambos podrían haber sido portadores:

| MadrePadre | WHomocigoto para elalelo de tipo salvaje (un no portador) | METROHeterocigoto(un portador de FQ) |

|---|---|---|

| WHomocigoto para elalelo de tipo salvaje (un no portador) | WW | megavatios |

| METROHeterocigoto (un portador de FQ) | megavatios | milímetro(afectado por fibrosis quística) |

Dado que el paciente no está afectado, solo hay tres posibilidades. Dentro de estos tres, existen dos escenarios en los que el paciente porta el alelo mutante. Así, las probabilidades previas son ⅔ y ⅓.

A continuación, el paciente se somete a pruebas genéticas y da negativo para fibrosis quística. Esta prueba tiene una tasa de detección del 90%, por lo que las probabilidades condicionales de una prueba negativa son 1/10 y 1. Finalmente, las probabilidades conjunta y posterior se calculan como antes.

| Hipótesis | Hipótesis 1: El paciente es portador | Hipótesis 2: El paciente no es portador |

|---|---|---|

| probabilidad previa | 2/3 | 1/3 |

| Probabilidad condicional de una prueba negativa | 1/10 | 1 |

| Probabilidad conjunta | 1/15 | 1/3 |

| Probabilidad posterior | 1/6 | 5/6 |

Después de realizar el mismo análisis en la pareja masculina de la paciente (con un resultado de prueba negativo), las posibilidades de que su hijo se vea afectado es igual al producto de las respectivas probabilidades posteriores de los padres de ser portadores por las posibilidades de que dos portadores produzcan un descendencia afectada (¼).

El análisis bayesiano se puede realizar utilizando información fenotípica asociada con una condición genética, y cuando se combina con pruebas genéticas, este análisis se vuelve mucho más complicado. La fibrosis quística, por ejemplo, se puede identificar en un feto a través de una ecografía en busca de un intestino ecogénico, lo que significa que aparece más brillante de lo normal en una exploración2. Esta no es una prueba infalible, ya que un intestino ecogénico puede estar presente en un feto perfectamente sano. Las pruebas genéticas de los padres son muy influyentes en este caso, donde una faceta fenotípica puede ser demasiado influyente en el cálculo de probabilidad. En el caso de un feto con intestino ecogénico, con una madre que ha sido examinada y se sabe que es portadora de FQ, la probabilidad posterior de que el feto realmente tenga la enfermedad es muy alta (0,64). Sin embargo, una vez que el padre ha dado negativo en la prueba de FQ,

El cálculo de los factores de riesgo es una herramienta poderosa en el asesoramiento genético y la planificación reproductiva, pero no puede tratarse como el único factor importante a considerar. Como se indicó anteriormente, las pruebas incompletas pueden generar una probabilidad falsamente alta de ser portador, y las pruebas pueden ser financieramente inaccesibles o inviables cuando uno de los padres no está presente.

(leer más)

En matemáticas, una medida de probabilidad o medición de probabilidades es una función de valor real definida en un conjunto de eventos en un espacio de... (leer más)

(leer más)