Recuperación de información

Recuperación de información (IR) en informática y ciencias de la información es el proceso de obtener recursos del sistema de información que son relevantes para una necesidad de información a partir de una colección de esos recursos. Las búsquedas se pueden basar en el texto completo o en otra indexación basada en el contenido. La recuperación de información es la ciencia de buscar información en un documento, buscar los propios documentos y también buscar los metadatos que describen los datos y las bases de datos de textos, imágenes o sonidos.

Los sistemas automatizados de recuperación de información se utilizan para reducir lo que se ha denominado sobrecarga de información. Un sistema IR es un sistema de software que brinda acceso a libros, revistas y otros documentos; almacena y administra esos documentos. Los motores de búsqueda web son las aplicaciones IR más visibles.

Resumen

Un proceso de recuperación de información comienza cuando un usuario o buscador ingresa una consulta al sistema. Las consultas son declaraciones formales de necesidades de información, por ejemplo, cadenas de búsqueda en motores de búsqueda web. En la recuperación de información, una consulta no identifica de manera única un solo objeto en la colección. En su lugar, varios objetos pueden coincidir con la consulta, quizás con diferentes grados de relevancia.

Un objeto es una entidad representada por información en una colección de contenido o base de datos. Las consultas de los usuarios se comparan con la información de la base de datos. Sin embargo, a diferencia de las consultas SQL clásicas de una base de datos, en la recuperación de información, los resultados devueltos pueden o no coincidir con la consulta, por lo que los resultados generalmente se clasifican. Esta clasificación de resultados es una diferencia clave de la búsqueda de recuperación de información en comparación con la búsqueda en bases de datos.

Dependiendo de la aplicación, los objetos de datos pueden ser, por ejemplo, documentos de texto, imágenes, audio, mapas mentales o videos. A menudo, los documentos en sí mismos no se guardan o almacenan directamente en el sistema IR, sino que se representan en el sistema mediante sustitutos de documentos o metadatos.

La mayoría de los sistemas de IR calculan una puntuación numérica sobre qué tan bien cada objeto en la base de datos coincide con la consulta y clasifican los objetos de acuerdo con este valor. A continuación, se muestran al usuario los objetos de mayor rango. Luego, el proceso puede iterarse si el usuario desea refinar la consulta.

Historia

hay... una máquina llamada Univac... por la que las letras y figuras se codifican como un patrón de manchas magnéticas en una cinta de acero larga. Por ello, el texto de un documento, precedido por su símbolo de código de sujeto, puede ser grabado... la máquina... selecciona automáticamente y escribe las referencias que se han codificado de cualquier manera deseada a una velocidad de 120 palabras por minuto

—J. E. Holmstrom, 1948

La idea de usar computadoras para buscar información relevante se popularizó en el artículo As We May Think de Vannevar Bush en 1945. Parece que Bush se inspiró en las patentes de un &# 39;máquina estadística' - presentado por Emanuel Goldberg en las décadas de 1920 y 30 - que buscaba documentos almacenados en películas. La primera descripción de una computadora que busca información fue descrita por Holmstrom en 1948, detallando una mención temprana de la computadora Univac. Los sistemas automatizados de recuperación de información se introdujeron en la década de 1950: uno incluso apareció en la comedia romántica de 1957, Desk Set. En la década de 1960, Gerard Salton formó en Cornell el primer gran grupo de investigación de recuperación de información. En la década de 1970, se había demostrado que varias técnicas de recuperación diferentes funcionaban bien en corpus de texto pequeños, como la colección Cranfield (varios miles de documentos). Los sistemas de recuperación a gran escala, como el sistema Lockheed Dialog, comenzaron a usarse a principios de la década de 1970.

En 1992, el Departamento de Defensa de EE. UU. junto con el Instituto Nacional de Estándares y Tecnología (NIST), copatrocinaron la Conferencia de recuperación de texto (TREC) como parte del programa de texto TIPSTER. El objetivo de esto era buscar en la comunidad de recuperación de información proporcionando la infraestructura que se necesitaba para la evaluación de metodologías de recuperación de texto en una colección de texto muy grande. Esto catalizó la investigación sobre métodos que escalan a grandes corpus. La introducción de los motores de búsqueda web ha aumentado aún más la necesidad de sistemas de recuperación a gran escala.

Aplicaciones

Las áreas donde se emplean técnicas de recuperación de información incluyen (las entradas están en orden alfabético dentro de cada categoría):

Aplicaciones generales

- Bibliotecas digitales

- Filtro de información

- Sistemas de recomendación

- Búsqueda de medios

- Búsqueda de blogs

- Recuperación de imágenes

- Recuperación 3D

- Retrieval de música

- Búsqueda de noticias

- Retrieval

- Recuperación de vídeo

- Motores de búsqueda

- Búsqueda del sitio

- Búsqueda de escritorio

- Búsqueda de empresas

- Búsqueda federada

- Búsqueda móvil

- Búsqueda social

- Búsqueda web

Aplicaciones específicas de dominio

- Búsqueda de expertos

- Recuperación de información genómica

- Recuperación de información geográfica

- Recuperación de información para estructuras químicas

- Recuperación de información en ingeniería de software

- Recuperación de información legal

- Búsqueda vertical

Otros métodos de recuperación

Los métodos/técnicas en los que se emplean técnicas de recuperación de información incluyen:

- Recuperación de información adversarial

- Resumiendo automático

- Resumen de documentos múltiples

- Compound term processing

- Retrieval multilingüe

- Clasificación de documentos

- Filtro de repuesto

- Respuesta a la pregunta

Tipos de modelos

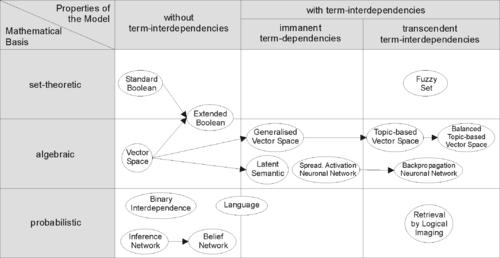

Para recuperar documentos relevantes de manera efectiva mediante estrategias de IR, los documentos generalmente se transforman en una representación adecuada. Cada estrategia de recuperación incorpora un modelo específico para sus propósitos de representación de documentos. La imagen de la derecha ilustra la relación de algunos modelos comunes. En la imagen, los modelos se clasifican según dos dimensiones: la base matemática y las propiedades del modelo.

Primera dimensión: base matemática

- Set-theoretic los modelos representan documentos como conjuntos de palabras o frases. Las similitudes se derivan generalmente de las operaciones teóricas de conjunto en esos conjuntos. Los modelos comunes son:

- Modelo Booleano estándar

- Modelo Booleano extendido

- Fuzzy Retrieval

- Modelos algebraicos representan documentos y consultas generalmente como vectores, matrices o tuples. La similitud del vector de búsqueda y vector de documentos está representada como un valor escalar.

- Modelo espacial vectorial

- Modelo de espacio vectorial generalizado

- (Mejorada) Modelo Vector Space basado en temas

- Modelo Booleano extendido

- Latent semantic indexing a.k.a. latent semantic analysis

- Modelos probabilísticos tratar el proceso de recuperación de documentos como una inferencia probabilística. Las similitudes se calculan como probabilidades de que un documento es relevante para una determinada consulta. Los teoremas probabilistas como el teorema de Bayes se utilizan a menudo en estos modelos.

- Independencia binaria Modelo

- Modelo de relevancia probabilista en el que se basa la función de relevancia okapi (BM25)

- Inferencia incierta

- Modelos de idioma

- Modelo de Divergence-from-randomness

- Latent Dirichlet allocation

- Modelos de recuperación basados en objetos ver documentos como vectores de valores de funciones (o simplemente características) y buscar la mejor manera de combinar estas características en una sola puntuación de relevancia, típicamente aprendiendo a los métodos de rango. Las funciones de función son funciones arbitrarias de documento y consulta, y como tal pueden incorporar fácilmente casi cualquier otro modelo de recuperación como simplemente otra característica.

Segunda dimensión: propiedades del modelo

- Modelos sin independencia de término tratar diferentes términos/palabras como independientes. Este hecho suele estar representado en modelos espaciales vectoriales por la asunción ortogonal de vectores de término o en modelos probabilísticos por una suposición de independencia para variables de término.

- Modelos con interdependencias de término inmanente permitir una representación de las interdependencias entre términos. Sin embargo, el grado de la interdependencia entre dos términos se define por el propio modelo. Generalmente se deriva directa o indirectamente (por ejemplo, por reducción dimensional) de la co-occurrencia de esos términos en todo el conjunto de documentos.

- Modelos con interdependencias trascendentales permiten una representación de las interdependencias entre términos, pero no alegan cómo se define la interdependencia entre dos términos. Ellos dependen de una fuente externa para el grado de interdependencia entre dos términos. (Por ejemplo, un algoritmo humano o sofisticado.)

Medidas de rendimiento y corrección

La evaluación de un sistema de recuperación de información' Es el proceso de evaluar qué tan bien un sistema satisface las necesidades de información de sus usuarios. En general, la medición considera una colección de documentos a buscar y una consulta de búsqueda. Las métricas de evaluación tradicionales, diseñadas para la recuperación booleana o la recuperación top-k, incluyen precisión y recuperación. Todas las medidas asumen una noción de relevancia básica: se sabe que cada documento es relevante o no relevante para una consulta en particular. En la práctica, las consultas pueden estar mal planteadas y puede haber diferentes matices de relevancia.

Cronología

- Antes 1900s

- 1801: Joseph Marie Jacquard inventa el telar de Jacquard, la primera máquina para usar tarjetas perforadas para controlar una secuencia de operaciones.

- 1880s: Herman Hollerith inventa un tabulador de datos electromecánico utilizando tarjetas de punzón como medio legible por máquina.

- 1890 Las tarjetas Hollerith, keypunches y tabulatores solían procesar los datos del censo estadounidense de 1890.

- 1920s-1930s

- Emanuel Goldberg presenta patentes para su "Máquina Estética" un motor de búsqueda de documentos que utilizó células fotoeléctricas y reconocimiento de patrones para buscar los metadatos en rollos de documentos microfilmados.

- 1940-1950

- finales de 1940: Los militares estadounidenses enfrentaron problemas de indexación y recuperación de documentos de investigación científica de tiempos de guerra capturados de alemanes.

- 1945Vannevar Bush Como podemos pensar aparecieron Atlantic Monthly.

- 1947: Hans Peter Luhn (ingeniero de investigación en IBM desde 1941) comenzó a trabajar en un sistema mecanizado de tarjetas de golpe para la búsqueda de compuestos químicos.

- 1950s: La creciente preocupación en los EE.UU. por una "salida científica" con la URSS motivó, alentó la financiación y proporcionó un telón de fondo para los sistemas de búsqueda de literatura mecanizada (Allen Kent) et al.) y la invención del índice de citación por Eugene Garfield.

- 1950: El término "retrieval de información" fue acuñado por Calvin Mooers.

- 1951: Philip Bagley realizó el primer experimento en la recuperación de documentos computadorizados en una tesis maestra en el MIT.

- 1955: Allen Kent se unió a Case Western Reserve University, y finalmente se convirtió en director asociado del Centro de Documentación e Investigación de Comunicaciones. Ese mismo año, Kent y colegas publicaron un documento en American Documentation que describía las medidas de precisión y retiro, así como detallando un "framework" propuesto para evaluar un sistema de IR que incluía métodos de muestreo estadístico para determinar el número de documentos pertinentes no recuperados.

- 1958: Conferencia Internacional de Información Científica Washington DC incluyó el examen de los sistemas IR como solución a los problemas identificados. Véase: Proceedings of the International Conference on Scientific Information, 1958 (Academia Nacional de Ciencias, Washington, DC, 1959)

- 1959: Hans Peter Luhn publicó "Codificación automática de documentos para la recuperación de información".

- finales de 1940: Los militares estadounidenses enfrentaron problemas de indexación y recuperación de documentos de investigación científica de tiempos de guerra capturados de alemanes.

- 1960s:

- principios de 1960: Gerard Salton comenzó a trabajar en IR en Harvard, más tarde se trasladó a Cornell.

- 1960: Melvin Earl Maron y John Lary Kuhns publicados "Sobre la relevancia, la indexación probabilística y la recuperación de información" en el Diario del ACM 7(3):216–244, julio 1960.

- 1962:

- Cyril W. Cleverdon publicó los primeros resultados de los estudios de Cranfield, desarrollando un modelo para la evaluación del sistema IR. Véase: Cyril W. Cleverdon, "Informe sobre el Testing and Analysis of an Investigation into the Comparative Efficiency of Indexing Systems". Cranfield Collection of Aeronautics, Cranfield, Inglaterra, 1962.

- Kent publicó Análisis de la información y recuperación.

- 1963:

- El informe de Weinberg "Science, Government and Information" dio una articulación completa de la idea de una "crisis de la información científica". El informe fue nombrado por el Dr. Alvin Weinberg.

- Joseph Becker y Robert M. Hayes publicaron texto sobre recuperación de información. Becker, Joseph; Hayes, Robert Mayo. Almacenamiento de información y recuperación: herramientas, elementos, teorías. Nueva York, Wiley (1963).

- 1964:

- Karen Spärck Jones terminó su tesis en Cambridge, Sinónimo y Clasificación Semántica, y trabajo continuo sobre lingüística computacional como se aplica a IR.

- La Oficina Nacional de Normas patrocinó un simposio titulado "Statistical Association Methods for Mechanized Documentation". Varios documentos altamente significativos, incluyendo la primera referencia publicada por G. Salton (creemos) al sistema SMART.

- mediados de 1960:

- Biblioteca Nacional de Medicina MEDLARS Medical Literature Analysis and Retrieval System, la primera principal base de datos legible por máquina y sistema de recuperación por lotes.

- Proyecto Intrex en el MIT.

- 1965J. C. R. Licklider publicado Bibliotecas del futuro.

- 1966: Don Swanson participó en estudios en la Universidad de Chicago sobre Requisitos para catálogos futuros.

- finales de 1960: F. Wilfrid Lancaster completó estudios de evaluación del sistema MEDLARS y publicó la primera edición de su texto sobre recuperación de información.

- 1968:

- Gerard Salton publicó Organización y recuperación de información automática.

- John W. Sammon, la RADC de Jr. Informe técnico "Some Mathematics of Information Storage and Retrieval..." delineó el modelo vectorial.

- 1969: Sammon's "A nonlinear mapping for data structure analysis Archived 2017-08-08 at the Wayback Machine" (IEEE Transactions on Computers) fue la primera propuesta para la interfaz de visualización a un sistema IR.

- 1970s

- principios de 1970:

- Primeros sistemas en línea: AIM-TWX de NLM, MEDLINE; Dialog de Lockheed; ORBIT de SDC.

- Theodor Nelson promoviendo el concepto de hipertexto, publicado Máquinas de Lib/Dream.

- 1971: Nicholas Jardine y Cornelis J. van Rijsbergen publicaron "El uso de agrupaciones jerárquicas en recuperación de información", que articularon la "hipótesis decluster".

- 1975: Tres publicaciones altamente influyentes de Salton articularon plenamente su marco de procesamiento vectorial y modelo de discriminación a plazo:

- Una Teoría de Indización (Sociedad para las matemáticas industriales y aplicadas)

- Una Teoría de Importancia Termal en Análisis de Textos Automáticos (JASIS c. 26)

- Un modelo de espacio vectorial para la indexación automática (CACM 18:11)

- 1978: Primera conferencia ACM SIGIR.

- 1979: C. J. van Rijsbergen publicado Information Retrieval (Butterworths). Gran énfasis en modelos probabilísticos.

- 1979: Tamas Doszkocs implementó la interfaz de usuario de lenguaje natural CITE para MEDLINE en la Biblioteca Nacional de Medicina. El sistema CITE apoyó la entrada de consultas de forma libre, la salida clasificada y la retroalimentación relevante.

- principios de 1970:

- 1980

- 1980: Primera conferencia internacional ACM SIGIR, junto con el grupo IR British Computer Society en Cambridge.

- 1982: Nicholas J. Belkin, Robert N. Oddy y Helen M. Brooks propusieron el punto de vista ASK (Anomalous State of Knowledge) para la recuperación de información. Este era un concepto importante, aunque su herramienta de análisis automatizada resultó finalmente decepcionante.

- 1983: Salton (y Michael J. McGill) publicado Introducción a la recuperación de información moderna (McGraw-Hill), con gran énfasis en los modelos vectoriales.

- 1985: David Blair y Bill Maron publican: Una evaluación de la eficacia de la recuperación para un sistema completo de recuperación de documentos

- mediados de 1980: Esfuerzos para desarrollar versiones de usuarios finales de sistemas IR comerciales.

- 1985–1993: Documentos clave en y sistemas experimentales para interfaces de visualización.

- Trabajo de Donald B. Crouch, Robert R. Korfhage, Matthew Chalmers, Anselm Spoerri y otros.

- 1989: Primeras propuestas World Wide Web de Tim Berners-Lee en CERN.

- 1990s

- 1992: Primera conferencia TREC.

- 1997: Publicación de Korfhage Almacenamiento de información y recuperación con énfasis en sistemas de visualización y puntos de referencia.

- 1999: Publicación de Ricardo Baeza-Yates y Berthier Ribeiro-Neto Modern Information Retrieval por Addison Wesley, el primer libro que intenta cubrir todo IR.

- finales de 1990: Los motores de búsqueda web implementan muchas características encontradas anteriormente sólo en sistemas experimentales IR. Los motores de búsqueda se convierten en la más común y quizás la mejor instantánea de los modelos IR.

Grandes conferencias

- SIGIR: Conference on Research and Development in Information Retrieval

- ECIR: European Conference on Information Retrieval

- CIKM: Conferencia sobre Gestión de la Información y el Conocimiento

- WWW: International World Wide Web Conference

- WSDM: Conference on Web Search and Data Mining

- ICTIR: Conferencia Internacional sobre Teoría de la Recuperación de la Información

Premios en el campo

- Premio Tony Kent Strix

- Gerard Salton Premio

- Premio Karen Spärck Jones

Contenido relacionado

EPROM

Algoritmo fonético

Jpeg