Realidad aumentada

La realidad aumentada (AR) es una experiencia interactiva que combina el mundo real y el contenido generado por computadora. El contenido puede abarcar múltiples modalidades sensoriales, incluidas la visual, auditiva, háptica, somatosensorial y olfativa. AR se puede definir como un sistema que incorpora tres características básicas: una combinación de mundos reales y virtuales, interacción en tiempo real y registro 3D preciso de objetos virtuales y reales. La información sensorial superpuesta puede ser constructiva (es decir, que se suma al entorno natural) o destructiva (es decir, que enmascara el entorno natural). Esta experiencia se entrelaza a la perfección con el mundo físico, de modo que se percibe como un aspecto inmersivo del entorno real. De esta manera, la realidad aumentada altera la percepción actual de un entorno del mundo real, mientras que la realidad virtual reemplaza por completo el entorno del mundo real del usuario con uno simulado.

La realidad aumentada es en gran medida sinónimo de realidad mixta. También existe una superposición en la terminología con la realidad extendida y la realidad mediada por computadora.

El valor principal de la realidad aumentada es la manera en que los componentes del mundo digital se mezclan con la percepción del mundo real de una persona, no como una simple visualización de datos, sino a través de la integración de sensaciones inmersivas, que se perciben como partes naturales de un entorno. Los primeros sistemas funcionales de realidad aumentada que proporcionaron experiencias inmersivas de realidad mixta para los usuarios se inventaron a principios de la década de 1990, comenzando con el sistema Virtual Fixtures desarrollado en el Laboratorio Armstrong de la Fuerza Aérea de los EE. UU. en 1992. Las experiencias comerciales de realidad aumentada se introdujeron por primera vez en el entretenimiento. y negocios de juegos. Posteriormente, las aplicaciones de realidad aumentada han abarcado industrias comerciales como la educación, las comunicaciones, la medicina y el entretenimiento. En educación, se puede acceder al contenido escaneando o viendo una imagen con un dispositivo móvil o usando técnicas AR sin marcadores.

La realidad aumentada se utiliza para mejorar entornos o situaciones naturales y ofrecer experiencias perceptualmente enriquecidas. Con la ayuda de tecnologías AR avanzadas (por ejemplo, agregar visión por computadora, incorporar cámaras AR en aplicaciones de teléfonos inteligentes y reconocimiento de objetos), la información sobre el mundo real que rodea al usuario se vuelve interactiva y manipulada digitalmente. La información sobre el entorno y sus objetos se superpone al mundo real. Esta información puede ser virtual. La Realidad Aumentada es cualquier experiencia artificial que se suma a la realidad ya existente. o real, p. ver otra información real medida o detectada, como ondas de radio electromagnéticas superpuestas en alineación exacta con el lugar en el que realmente se encuentran en el espacio. La realidad aumentada también tiene mucho potencial en la recopilación y el intercambio de conocimientos tácitos. Las técnicas de aumento generalmente se realizan en tiempo real y en contextos semánticos con elementos ambientales. La información perceptual inmersiva a veces se combina con información complementaria, como puntajes en una transmisión de video en vivo de un evento deportivo. Esto combina los beneficios de la tecnología de realidad aumentada y la tecnología de visualización frontal (HUD).

Comparación con la realidad virtual

En la realidad virtual (VR), los usuarios' la percepción de la realidad está completamente basada en información virtual. En la realidad aumentada (AR), el usuario recibe información adicional generada por computadora dentro de los datos recopilados de la vida real que mejora su percepción de la realidad. Por ejemplo, en arquitectura, la realidad virtual se puede utilizar para crear una simulación de recorrido del interior de un nuevo edificio; y AR se puede usar para mostrar las estructuras y los sistemas de un edificio superpuestos en una vista de la vida real. Otro ejemplo es mediante el uso de aplicaciones de utilidad. Algunas aplicaciones AR, como Augment, permiten a los usuarios aplicar objetos digitales en entornos reales, lo que permite a las empresas utilizar dispositivos de realidad aumentada como una forma de obtener una vista previa de sus productos en el mundo real. Del mismo modo, también se puede utilizar para demostrar cómo se verían los productos en un entorno para los clientes, como lo demuestran empresas como Mountain Equipment Co-op o Lowe's, que utilizan la realidad aumentada para permitir a los clientes obtener una vista previa de lo que podrían ser sus productos. lucir como en casa mediante el uso de modelos 3D.

La realidad aumentada (AR) difiere de la realidad virtual (VR) en el sentido de que en AR parte del entorno circundante es 'real' y simplemente agregando capas de objetos virtuales al entorno real. Por otro lado, en VR el entorno circundante es completamente virtual y generado por computadora. Se puede ver una demostración de cómo AR superpone objetos en el mundo real con juegos de realidad aumentada. WallaMe es una aplicación de juego de realidad aumentada que permite a los usuarios ocultar mensajes en entornos reales, utilizando tecnología de geolocalización para que los usuarios puedan ocultar mensajes en cualquier parte del mundo que deseen. Tales aplicaciones tienen muchos usos en el mundo, incluso en el activismo y la expresión artística.

Tecnología

Hardware

Los componentes de hardware para la realidad aumentada son: un procesador, una pantalla, sensores y dispositivos de entrada. Los dispositivos informáticos móviles modernos, como los teléfonos inteligentes y las tabletas, contienen estos elementos, que a menudo incluyen una cámara y sensores de sistemas microelectromecánicos (MEMS), como un acelerómetro, GPS y una brújula de estado sólido, lo que los convierte en plataformas AR adecuadas. Hay dos tecnologías utilizadas en la realidad aumentada: guías de ondas difractivas y guías de ondas reflectantes.

Pantalla

Se utilizan varias tecnologías en la representación de realidad aumentada, incluidos los sistemas de proyección óptica, monitores, dispositivos portátiles y sistemas de visualización, que se usan en el cuerpo humano.

Una pantalla montada en la cabeza (HMD) es un dispositivo de visualización que se usa en la frente, como un arnés o un casco. Los HMD colocan imágenes tanto del mundo físico como de objetos virtuales sobre el campo de visión del usuario. Los HMD modernos a menudo emplean sensores para el monitoreo de seis grados de libertad que permiten que el sistema alinee la información virtual con el mundo físico y se ajuste de acuerdo con los movimientos de la cabeza del usuario. Los HMD pueden proporcionar a los usuarios de realidad virtual experiencias móviles y colaborativas. Proveedores específicos, como uSens y Gestigon, incluyen controles de gestos para una inmersión virtual completa.

Gafas

Las pantallas AR se pueden renderizar en dispositivos que se asemejan a anteojos. Las versiones incluyen anteojos que emplean cámaras para interceptar la vista del mundo real y volver a mostrar su vista aumentada a través de los oculares y dispositivos en los que las imágenes AR se proyectan o reflejan en las superficies de las lentes de los anteojos.

HUD

Una pantalla de visualización frontal (HUD) es una pantalla transparente que presenta datos sin que los usuarios tengan que apartar la vista de sus puntos de vista habituales. Una tecnología precursora de la realidad aumentada, las pantallas de visualización frontal se desarrollaron por primera vez para los pilotos en la década de 1950, proyectando datos de vuelo simples en su línea de visión, lo que les permitía mantener la "cabeza erguida" y no mirar hacia abajo a los instrumentos. Los dispositivos de realidad aumentada cercanos al ojo se pueden usar como pantallas portátiles de visualización frontal, ya que pueden mostrar datos, información e imágenes mientras el usuario ve el mundo real. Muchas definiciones de realidad aumentada solo la definen como superposición de información. Esto es básicamente lo que hace una pantalla de visualización frontal; sin embargo, en términos prácticos, se espera que la realidad aumentada incluya registro y seguimiento entre las percepciones, sensaciones, información, datos e imágenes superpuestas y una parte del mundo real.

Lentes de contacto

Se están desarrollando lentes de contacto que muestran imágenes AR. Estos lentes de contacto biónicos pueden contener los elementos de visualización incrustados en el lente, incluidos los circuitos integrados, los LED y una antena para la comunicación inalámbrica. La primera pantalla de lentes de contacto fue patentada en 1999 por Steve Mann y estaba destinada a funcionar en combinación con anteojos AR, pero el proyecto se abandonó, luego de 11 años, en 2010-2011. Otra versión de lentes de contacto, en desarrollo para el ejército de los EE. UU., está diseñada para funcionar con anteojos AR, lo que permite a los soldados enfocarse en imágenes AR cercanas al ojo en los anteojos y objetos distantes del mundo real al mismo tiempo.

En CES 2013, una empresa llamada Innovega también presentó lentes de contacto similares que requerían combinarse con anteojos AR para funcionar.

El cortometraje futurista Sight presenta dispositivos de realidad aumentada similares a lentes de contacto.

Muchos científicos han estado trabajando en lentes de contacto capaces de diferentes proezas tecnológicas. Una patente presentada por Samsung describe una lente de contacto AR que, cuando esté terminada, incluirá una cámara integrada en la lente. El diseño está destinado a controlar su interfaz parpadeando. También está diseñado para vincularse con el teléfono inteligente del usuario para revisar el metraje y controlarlo por separado. Cuando tenga éxito, la lente contará con una cámara o un sensor en su interior. Se dice que podría ser cualquier cosa, desde un sensor de luz hasta un sensor de temperatura.

Mojo Vision desarrolló el primer prototipo funcional presentado públicamente de una lente de contacto AR que no requiere el uso de anteojos, y se anunció y mostró en CES 2020.

Pantalla de retina virtual

Una pantalla de retina virtual (VRD) es un dispositivo de visualización personal que se está desarrollando en el Laboratorio de Tecnología de Interfaz Humana de la Universidad de Washington bajo la dirección del Dr. Thomas A. Furness III. Con esta tecnología, una pantalla se escanea directamente en la retina del ojo del espectador. Esto da como resultado imágenes brillantes con alta resolución y alto contraste. El espectador ve lo que parece ser una pantalla convencional flotando en el espacio.

Se realizaron varias pruebas para analizar la seguridad del VRD. En una prueba, se seleccionó a pacientes con pérdida parcial de la visión, que tenían degeneración macular (una enfermedad que degenera la retina) o queratocono, para ver imágenes usando la tecnología. En el grupo de degeneración macular, cinco de ocho sujetos prefirieron las imágenes VRD al tubo de rayos catódicos (CRT) o imágenes en papel y pensaron que eran mejores y más brillantes y podían ver niveles de resolución iguales o mejores. Todos los pacientes con queratocono pudieron resolver las líneas más pequeñas en varias pruebas de línea utilizando el VRD en lugar de su propia corrección. También encontraron que las imágenes VRD eran más fáciles de ver y más nítidas. Como resultado de estas diversas pruebas, la visualización retinal virtual se considera una tecnología segura.

La visualización retinal virtual crea imágenes que se pueden ver a la luz del día y de la habitación. El VRD se considera un candidato preferido para usar en una pantalla quirúrgica debido a su combinación de alta resolución y alto contraste y brillo. Pruebas adicionales muestran un alto potencial para que VRD se use como tecnología de visualización para pacientes con baja visión.

Golpe de ojo

El EyeTap (también conocido como Generation-2 Glass) captura los rayos de luz que, de otro modo, atravesarían el centro de la lente del ojo del usuario y sustituye cada rayo de luz real por luz sintética controlada por computadora..

El Generation-4 Glass (Laser EyeTap) es similar al VRD (es decir, utiliza una fuente de luz láser controlada por computadora), excepto que también tiene una profundidad de enfoque infinita y hace que el ojo mismo, en efecto, funcione como tanto una cámara como una pantalla a través de la alineación exacta con el ojo y la resíntesis (en luz láser) de los rayos de luz que ingresan al ojo.

Portátil

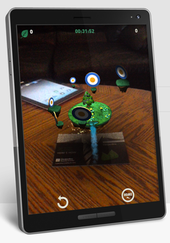

Una pantalla portátil emplea una pantalla pequeña que cabe en la mano del usuario. Todas las soluciones AR portátiles hasta la fecha optan por la transparencia del video. Inicialmente, AR de mano empleaba marcadores fiduciales y, más tarde, unidades GPS y sensores MEMS, como brújulas digitales y acelerómetro-giroscopio de seis grados de libertad. Hoy en día, los rastreadores sin marcadores de localización y mapeo simultáneos (SLAM) como PTAM (seguimiento y mapeo en paralelo) están comenzando a usarse. La realidad aumentada portátil promete ser el primer éxito comercial de las tecnologías de realidad aumentada. Las dos principales ventajas de la RA portátil son la naturaleza portátil de los dispositivos portátiles y la naturaleza omnipresente de los teléfonos con cámara. Las desventajas son las limitaciones físicas del usuario que tiene que sostener el dispositivo de mano frente a él en todo momento, así como el efecto distorsionador de las cámaras clásicas de teléfonos móviles de gran angular en comparación con el mundo real visto a través del ojo.

Juegos como Pokémon Go e Ingress utilizan una interfaz de mapa vinculado a imágenes (ILM), donde las ubicaciones geoetiquetadas aprobadas aparecen en un mapa estilizado para que el usuario interactúe.

Mapeo de proyección

El mapeo de proyección aumenta los objetos y escenas del mundo real, sin el uso de pantallas especiales como monitores, pantallas montadas en la cabeza o dispositivos portátiles. El mapeo de proyección utiliza proyectores digitales para mostrar información gráfica en objetos físicos. La diferencia clave en el mapeo de proyección es que la pantalla está separada de los usuarios del sistema. Dado que las pantallas no están asociadas con cada usuario, el mapeo de proyección se escala de forma natural a grupos de usuarios, lo que permite la colaboración conjunta entre usuarios.

Los ejemplos incluyen lámparas de sombreado, proyectores móviles, mesas virtuales y proyectores inteligentes. Las lámparas Shader imitan y aumentan la realidad al proyectar imágenes en objetos neutrales. Esto brinda la oportunidad de mejorar la apariencia del objeto con materiales de una unidad simple: un proyector, una cámara y un sensor.

Otras aplicaciones incluyen proyecciones de mesa y pared. Una innovación, la mesa virtual extendida, separa lo virtual de lo real al incluir espejos divisores de haz unidos al techo en un ángulo ajustable. Las vitrinas virtuales, que emplean espejos divisores de haz junto con múltiples pantallas gráficas, brindan un medio interactivo para relacionarse simultáneamente con lo virtual y lo real. Muchas más implementaciones y configuraciones hacen que la visualización de realidad aumentada espacial sea una alternativa interactiva cada vez más atractiva.

Un sistema de mapeo de proyección puede mostrarse en cualquier cantidad de superficies en un entorno interior a la vez. El mapeo de proyección admite tanto una visualización gráfica como una sensación háptica pasiva para los usuarios finales. Los usuarios pueden tocar objetos físicos en un proceso que proporciona una sensación háptica pasiva.

Seguimiento

Los sistemas móviles modernos de realidad aumentada utilizan una o más de las siguientes tecnologías de seguimiento de movimiento: cámaras digitales u otros sensores ópticos, acelerómetros, GPS, giroscopios, brújulas de estado sólido, identificación por radiofrecuencia (RFID). Estas tecnologías ofrecen diferentes niveles de exactitud y precisión. Estas tecnologías se implementan en la API ARKit de Apple y la API ARCore de Google para permitir el seguimiento de sus respectivas plataformas de dispositivos móviles.

Redes

Las aplicaciones móviles de realidad aumentada están ganando popularidad debido a la amplia adopción de dispositivos móviles y, en especial, portátiles. Sin embargo, a menudo se basan en algoritmos de visión artificial computacionalmente intensivos con requisitos de latencia extremos. Para compensar la falta de poder de cómputo, a menudo se desea descargar el procesamiento de datos a una máquina distante. La descarga de computación introduce nuevas restricciones en las aplicaciones, especialmente en términos de latencia y ancho de banda. Aunque hay una plétora de protocolos de transporte multimedia en tiempo real, también se necesita soporte de la infraestructura de red.

Dispositivos de entrada

Las técnicas incluyen sistemas de reconocimiento de voz que traducen las palabras habladas de un usuario en instrucciones informáticas y sistemas de reconocimiento de gestos que interpretan los movimientos del cuerpo de un usuario mediante detección visual o mediante sensores integrados en un dispositivo periférico, como un varita, lápiz óptico, puntero, guante u otra prenda corporal. Los productos que intentan servir como controlador de auriculares AR incluyen Wave de Seebright Inc. y Nimble de Intugine Technologies.

Ordenador

La computadora analiza los datos visuales detectados y otros datos para sintetizar y posicionar los aumentos. Las computadoras son responsables de los gráficos que acompañan a la realidad aumentada. La realidad aumentada utiliza una imagen generada por computadora que tiene un efecto sorprendente en la forma en que se muestra el mundo real. Con la mejora de la tecnología y las computadoras, la realidad aumentada conducirá a un cambio drástico en la perspectiva del mundo real. Según Time, en unos 15 a 20 años se prevé que la realidad aumentada y la realidad virtual se convertirán en el uso principal para las interacciones informáticas. Las computadoras están mejorando a un ritmo muy rápido, lo que lleva a nuevas formas de mejorar otras tecnologías. Cuanto más progresen las computadoras, la realidad aumentada se volverá más flexible y más común en la sociedad. Las computadoras son el núcleo de la realidad aumentada. La computadora recibe datos de los sensores que determinan la posición relativa de un objeto. superficie. Esto se traduce en una entrada a la computadora que luego se envía a los usuarios al agregar algo que de otro modo no estaría allí. La computadora comprende memoria y un procesador. La computadora toma el entorno escaneado, luego genera imágenes o un video y lo coloca en el receptor para que el observador lo vea. Las marcas fijas en la superficie de un objeto se almacenan en la memoria de una computadora. La computadora también se retira de su memoria para presentar imágenes de manera realista al espectador. El mejor ejemplo de esto es el Pepsi Max AR Bus Shelter.

Proyector

Los proyectores también se pueden usar para mostrar contenidos AR. El proyector puede lanzar un objeto virtual en una pantalla de proyección y el espectador puede interactuar con este objeto virtual. Las superficies de proyección pueden ser muchos objetos, como paredes o paneles de vidrio.

Software y algoritmos

Una medida clave de los sistemas AR es la forma realista en que integran los aumentos con el mundo real. El software debe derivar coordenadas del mundo real, independientemente de la cámara y las imágenes de la cámara. Ese proceso se llama registro de imágenes y utiliza diferentes métodos de visión por computadora, en su mayoría relacionados con el seguimiento de video. Muchos métodos de visión artificial de realidad aumentada se heredan de la odometría visual. Un augograma es una imagen generada por computadora que se utiliza para crear AR. Augografía es la ciencia y la práctica de software de hacer augogramas para AR.

Por lo general, esos métodos constan de dos partes. La primera etapa es detectar puntos de interés, marcadores de referencia o flujo óptico en las imágenes de la cámara. Este paso puede usar métodos de detección de características como detección de esquinas, detección de manchas, detección de bordes o umbrales y otros métodos de procesamiento de imágenes. La segunda etapa restaura un sistema de coordenadas del mundo real a partir de los datos obtenidos en la primera etapa. Algunos métodos asumen que en la escena hay objetos con geometría conocida (o marcadores de referencia). En algunos de esos casos, la estructura 3D de la escena debe calcularse de antemano. Si se desconoce parte de la escena, la localización y el mapeo simultáneos (SLAM) pueden mapear posiciones relativas. Si no hay información disponible sobre la geometría de la escena, se utilizan métodos de estructura a partir de movimiento, como el ajuste de paquetes. Los métodos matemáticos utilizados en la segunda etapa incluyen: geometría proyectiva (epipolar), álgebra geométrica, representación de rotación con mapa exponencial, kalman y filtros de partículas, optimización no lineal, estadísticas robustas.

En la realidad aumentada, se distingue entre dos modos distintos de seguimiento, conocidos como marcador y sin marcador. Los marcadores son señales visuales que desencadenan la visualización de la información virtual. Se puede utilizar una hoja de papel con algunas geometrías distintas. La cámara reconoce las geometrías identificando puntos específicos en el dibujo. El seguimiento sin marcadores, también llamado seguimiento instantáneo, no utiliza marcadores. En cambio, el usuario coloca el objeto en la vista de la cámara preferiblemente en un plano horizontal. Utiliza sensores en dispositivos móviles para detectar con precisión el entorno del mundo real, como la ubicación de las paredes y los puntos de intersección.

El lenguaje de marcado de realidad aumentada (ARML) es un estándar de datos desarrollado dentro del Open Geospatial Consortium (OGC), que consiste en la gramática del lenguaje de marcado extensible (XML) para describir la ubicación y apariencia de los objetos virtuales en la escena, así como Enlaces ECMAScript para permitir el acceso dinámico a las propiedades de los objetos virtuales.

Para permitir el desarrollo rápido de aplicaciones de realidad aumentada, se lanzaron algunas aplicaciones de desarrollo de software como Lens Studio de Snapchat y Spark AR de Facebook, incluidos los kits de desarrollo de software (SDK) de Apple y Google.

Desarrollo

La implementación de la realidad aumentada en productos de consumo requiere considerar el diseño de las aplicaciones y las limitaciones relacionadas de la plataforma tecnológica. Dado que los sistemas AR dependen en gran medida de la inmersión del usuario y la interacción entre el usuario y el sistema, el diseño puede facilitar la adopción de la virtualidad. Para la mayoría de los sistemas de realidad aumentada, se puede seguir una guía de diseño similar. A continuación se enumeran algunas consideraciones para el diseño de aplicaciones de realidad aumentada:

Diseño ambiental/de contexto

El diseño de contexto se centra en el entorno físico, el espacio espacial y la accesibilidad del usuario final que pueden desempeñar un papel al usar el sistema AR. Los diseñadores deben ser conscientes de los posibles escenarios físicos en los que puede encontrarse el usuario final, tales como:

- Público, en el que los usuarios utilizan todo su cuerpo para interactuar con el software

- Personal, en el que el usuario utiliza un smartphone en un espacio público

- Intima, en la que el usuario está sentado con un escritorio y no se mueve realmente

- Privado, en el que el usuario tiene un desgaste.

Al evaluar cada escenario físico, se pueden evitar posibles riesgos de seguridad y se pueden realizar cambios para mejorar aún más la inmersión del usuario final. Los diseñadores de UX tendrán que definir los viajes de los usuarios para los escenarios físicos relevantes y definir cómo reacciona la interfaz a cada uno.

Otro aspecto del diseño de contexto implica el diseño de la funcionalidad del sistema y su capacidad para adaptarse a las preferencias del usuario. Si bien las herramientas de accesibilidad son comunes en el diseño de aplicaciones básicas, se debe tener en cuenta el diseño de avisos de tiempo limitado (para evitar operaciones no intencionales), señales de audio y tiempo de participación general. Es importante tener en cuenta que, en algunas situaciones, la funcionalidad de la aplicación puede dificultar la capacidad del usuario. Por ejemplo, las aplicaciones que se usan para conducir deben reducir la cantidad de interacción del usuario y usar señales de audio en su lugar.

Diseño de interacción

El diseño de interacción en la tecnología de realidad aumentada se centra en la interacción del usuario con el producto final para mejorar la experiencia y el disfrute general del usuario. El propósito del diseño de interacción es evitar alienar o confundir al usuario organizando la información presentada. Dado que la interacción del usuario depende de la entrada del usuario, los diseñadores deben hacer que los controles del sistema sean más fáciles de entender y accesibles. Una técnica común para mejorar la usabilidad de las aplicaciones de realidad aumentada es descubrir las áreas de acceso frecuente en la pantalla táctil del dispositivo y diseñar la aplicación para que coincida con esas áreas de control. También es importante estructurar los mapas de viaje del usuario y el flujo de información presentado, lo que reduce la carga cognitiva general del sistema y mejora en gran medida la curva de aprendizaje de la aplicación.

En el diseño de interacción, es importante que los desarrolladores utilicen tecnología de realidad aumentada que complemente la función o el propósito del sistema. Por ejemplo, la utilización de emocionantes filtros AR y el diseño de la plataforma única para compartir en Snapchat permite a los usuarios aumentar sus interacciones sociales en la aplicación. En otras aplicaciones que requieren que los usuarios entiendan el enfoque y la intención, los diseñadores pueden emplear una retícula o emisión de rayos desde el dispositivo.

Diseño visual

En general, el diseño visual es la apariencia de la aplicación en desarrollo que atrae al usuario. Para mejorar los elementos de la interfaz gráfica y la interacción del usuario, los desarrolladores pueden usar señales visuales para informar al usuario con qué elementos de la interfaz de usuario están diseñados para interactuar y cómo interactuar con ellos. Dado que navegar en una aplicación AR puede parecer difícil y frustrante, el diseño de señales visuales puede hacer que las interacciones parezcan más naturales.

En algunas aplicaciones de realidad aumentada que utilizan un dispositivo 2D como superficie interactiva, el entorno de control 2D no se traduce bien en el espacio 3D, lo que hace que los usuarios duden en explorar su entorno. Para resolver este problema, los diseñadores deben aplicar señales visuales para ayudar y alentar a los usuarios a explorar su entorno.

Es importante tener en cuenta los dos objetos principales en AR al desarrollar aplicaciones de VR: objetos volumétricos 3D que se manipulan e interactúan de manera realista con luces y sombras; e imágenes de medios animadas, como imágenes y videos, que en su mayoría son medios 2D tradicionales representados en un nuevo contexto para la realidad aumentada. Cuando los objetos virtuales se proyectan en un entorno real, es un desafío para los diseñadores de aplicaciones de realidad aumentada garantizar una integración perfecta en relación con el entorno del mundo real, especialmente con objetos 2D. Como tal, los diseñadores pueden agregar peso a los objetos, usar mapas de profundidad y elegir diferentes propiedades de materiales que resalten la presencia del objeto en el mundo real. Otro diseño visual que se puede aplicar es usar diferentes técnicas de iluminación o proyectar sombras para mejorar el juicio general de profundidad. Por ejemplo, una técnica de iluminación común es simplemente colocar una fuente de luz en la posición de las 12 en punto para crear sombras en los objetos virtuales.

Posibles aplicaciones

La realidad aumentada se ha explorado para muchas aplicaciones, desde juegos y entretenimiento hasta medicina, educación y negocios. Las áreas de aplicación de ejemplo que se describen a continuación incluyen arqueología, arquitectura, comercio y educación. Algunos de los primeros ejemplos citados incluyen la realidad aumentada utilizada para apoyar la cirugía al proporcionar superposiciones virtuales para guiar a los médicos, a contenido AR para astronomía y soldadura.

Arqueología

AR se ha utilizado para ayudar a la investigación arqueológica. Al aumentar las características arqueológicas en el paisaje moderno, AR permite a los arqueólogos formular posibles configuraciones de sitios a partir de estructuras existentes. Los modelos generados por computadora de ruinas, edificios, paisajes o incluso personas antiguas se han reciclado en las primeras aplicaciones arqueológicas de realidad aumentada. Por ejemplo, implementar un sistema como VITA (herramienta de interacción visual para arqueología) permitirá a los usuarios imaginar e investigar resultados de excavación instantáneos sin salir de casa. Cada usuario puede colaborar "navegando, buscando y viendo datos" mutuamente. Hrvoje Benko, investigador del departamento de informática de la Universidad de Columbia, señala que estos sistemas en particular y otros similares pueden proporcionar "imágenes panorámicas en 3D y modelos en 3D del sitio mismo en diferentes etapas de excavación" al tiempo que organiza gran parte de los datos de una manera colaborativa que es fácil de usar. Los sistemas de RA colaborativos proporcionan interacciones multimodales que combinan el mundo real con imágenes virtuales de ambos entornos.

Arquitectura

AR puede ayudar a visualizar proyectos de construcción. Las imágenes generadas por computadora de una estructura se pueden superponer a una vista local de la vida real de una propiedad antes de que se construya allí el edificio físico; esto fue demostrado públicamente por Trimble Navigation en 2004. AR también se puede emplear dentro del espacio de trabajo de un arquitecto, renderizando visualizaciones animadas en 3D de sus dibujos en 2D. La vista de la arquitectura se puede mejorar con aplicaciones AR, lo que permite a los usuarios ver el exterior de un edificio para ver virtualmente a través de sus paredes, ver sus objetos interiores y su diseño.

Con las continuas mejoras en la precisión del GPS, las empresas pueden utilizar la realidad aumentada para visualizar modelos georreferenciados de sitios de construcción, estructuras subterráneas, cables y tuberías mediante dispositivos móviles. La realidad aumentada se aplica para presentar nuevos proyectos, resolver desafíos de construcción en el sitio y mejorar los materiales promocionales. Los ejemplos incluyen el Daqri Smart Helmet, un casco con Android que se usa para crear realidad aumentada para el trabajador industrial, incluidas instrucciones visuales, alertas en tiempo real y mapeo 3D.

Tras el terremoto de Christchurch, la Universidad de Canterbury lanzó CityViewAR, que permitió a los ingenieros y urbanistas visualizar los edificios que habían sido destruidos. Esto no solo proporcionó a los planificadores herramientas para hacer referencia al paisaje urbano anterior, sino que también sirvió como un recordatorio de la magnitud de la devastación resultante, ya que se habían demolido edificios enteros.

Diseño y planificación urbana

Los sistemas AR se utilizan como herramientas de colaboración para el diseño y la planificación en el entorno construido. Por ejemplo, AR se puede usar para crear mapas de realidad aumentada, edificios y fuentes de datos proyectados en mesas para que los profesionales del entorno construido puedan verlos en colaboración. Outdoor AR promete que los diseños y los planes se pueden superponer en el mundo real, redefiniendo el ámbito de estas profesiones para incorporar el diseño in situ en su proceso. Las opciones de diseño se pueden articular en el sitio y parecen más cercanas a la realidad que los mecanismos de escritorio tradicionales, como mapas 2D y modelos 3D.

El concepto de ciudad inteligente también utiliza sistemas de TIC que incluyen AR para presentar información a los ciudadanos, mejorar la eficiencia operativa y, en última instancia, mejorar la calidad de los servicios públicos. Algunos desarrolladores urbanos han comenzado a tomar medidas instalando sistemas inteligentes para la recolección de desechos, monitoreando la seguridad pública a través de tecnologías de monitoreo AR y mejorando el turismo a través de tecnologías interactivas.

Educación

En entornos educativos, AR se ha utilizado para complementar un plan de estudios estándar. El texto, los gráficos, el video y el audio se pueden superponer en el entorno en tiempo real de un estudiante. Los libros de texto, tarjetas didácticas y otros materiales de lectura educativos pueden contener "marcadores" o disparadores que, cuando son escaneados por un dispositivo AR, producen información complementaria para el estudiante presentada en un formato multimedia. La Realidad Virtual, Aumentada y Mixta de 2015: 7ª Conferencia Internacional mencionó Google Glass como un ejemplo de realidad aumentada que puede reemplazar el aula física. En primer lugar, las tecnologías AR ayudan a los alumnos a participar en una exploración auténtica del mundo real, y los objetos virtuales, como textos, videos e imágenes, son elementos complementarios para que los alumnos realicen investigaciones del entorno del mundo real.

A medida que evoluciona AR, los estudiantes pueden participar de forma interactiva e interactuar con el conocimiento de manera más auténtica. En lugar de permanecer como receptores pasivos, los estudiantes pueden convertirse en aprendices activos, capaces de interactuar con su entorno de aprendizaje. Las simulaciones de eventos históricos generadas por computadora permiten a los estudiantes explorar y aprender detalles de cada área significativa del sitio del evento.

En la educación superior, Construct3D, un sistema de Studierstube, permite a los estudiantes aprender conceptos de ingeniería mecánica, matemáticas o geometría. Las aplicaciones de Química AR permiten a los estudiantes visualizar e interactuar con la estructura espacial de una molécula usando un objeto marcador sostenido en la mano. Otros han usado HP Reveal, una aplicación gratuita, para crear tarjetas de notas AR para estudiar mecanismos de química orgánica o para crear demostraciones virtuales de cómo usar la instrumentación de laboratorio. Los estudiantes de anatomía pueden visualizar diferentes sistemas del cuerpo humano en tres dimensiones. Se ha demostrado que el uso de AR como una herramienta para aprender estructuras anatómicas aumenta el conocimiento del alumno y brinda beneficios intrínsecos, como una mayor participación e inmersión del alumno.

Fabricación industrial

AR se utiliza para sustituir los manuales en papel por instrucciones digitales que se superponen en el campo de visión del operador de fabricación, lo que reduce el esfuerzo mental necesario para operar. AR hace que el mantenimiento de la máquina sea eficiente porque brinda a los operadores acceso directo al historial de mantenimiento de una máquina. Los manuales virtuales ayudan a los fabricantes a adaptarse a los diseños de productos que cambian rápidamente, ya que las instrucciones digitales se editan y distribuyen más fácilmente en comparación con los manuales físicos.

Las instrucciones digitales aumentan la seguridad del operador al eliminar la necesidad de que los operadores miren una pantalla o un manual lejos del área de trabajo, lo que puede ser peligroso. En su lugar, las instrucciones se superponen en el área de trabajo. El uso de AR puede aumentar los operadores' Sensación de seguridad al trabajar cerca de maquinaria industrial de alta carga al brindar a los operadores información adicional sobre el estado de la máquina y las funciones de seguridad, así como las áreas peligrosas del espacio de trabajo.

Comercio

AR se utiliza para integrar el marketing impreso y de video. El material de marketing impreso se puede diseñar con cierto "disparador" imágenes que, cuando son escaneadas por un dispositivo habilitado para AR usando reconocimiento de imágenes, activan una versión de video del material promocional. Una diferencia importante entre la realidad aumentada y el reconocimiento directo de imágenes es que uno puede superponer varios medios al mismo tiempo en la pantalla de visualización, como los botones para compartir en las redes sociales, el video en la página, incluso el audio y los objetos 3D. Las publicaciones tradicionales solo impresas están utilizando la realidad aumentada para conectar diferentes tipos de medios.

AR puede mejorar las vistas previas de los productos, como permitir que un cliente vea lo que hay dentro del empaque de un producto sin abrirlo. AR también se puede utilizar como ayuda para seleccionar productos de un catálogo o a través de un quiosco. Las imágenes escaneadas de productos pueden activar vistas de contenido adicional, como opciones de personalización e imágenes adicionales del producto en su uso.

Para 2010, se habían desarrollado vestidores virtuales para el comercio electrónico.

En 2012, una casa de la moneda usó técnicas de realidad aumentada para comercializar una moneda conmemorativa de Aruba. La moneda en sí se usó como disparador de AR, y cuando se sostuvo frente a un dispositivo habilitado para AR, reveló objetos adicionales y capas de información que no eran visibles sin el dispositivo.

En 2018, Apple anunció la compatibilidad con archivos USDZ AR para iPhone y iPad con iOS12. Apple ha creado una galería AR QuickLook que permite a las masas experimentar la realidad aumentada en su propio dispositivo Apple.

En 2018, Shopify, la empresa canadiense de comercio electrónico, anunció la integración de AR Quick Look. Sus comerciantes podrán cargar modelos 3D de sus productos y sus usuarios podrán tocar los modelos dentro del navegador Safari en sus dispositivos iOS para verlos en sus entornos del mundo real.

En 2018, Twinkl lanzó una aplicación AR gratuita para el aula. Los alumnos pueden ver cómo era York hace más de 1.900 años. Twinkl lanzó el primer juego AR multijugador, Little Red y tiene más de 100 modelos educativos AR gratuitos.

La realidad aumentada se usa cada vez más para la publicidad en línea. Los minoristas ofrecen la posibilidad de cargar una imagen en su sitio web y "probarse" varias prendas que se superponen en la imagen. Aún más, empresas como Bodymetrics instalan cabinas para vestirse en grandes almacenes que ofrecen escaneo de cuerpo completo. Estas cabinas representan un modelo tridimensional del usuario, lo que les permite a los consumidores ver diferentes atuendos en sí mismos sin la necesidad de cambiarse de ropa físicamente. Por ejemplo, JC Penney y Bloomingdale's usan "vestidores virtuales" que permiten a los clientes verse vestidos sin probárselos. Otra tienda que usa AR para comercializar ropa a sus clientes es Neiman Marcus. Neiman Marcus ofrece a los consumidores la posibilidad de ver sus atuendos en una vista de 360 grados con su 'espejo de memoria'. Las tiendas de maquillaje como L'Oreal, Sephora, Charlotte Tilbury y Rimmel también tienen aplicaciones que utilizan AR. Estas aplicaciones permiten a los consumidores ver cómo les quedará el maquillaje. Según Greg Jones, director de AR y VR en Google, la realidad aumentada "reconectará el comercio minorista físico y digital".

La tecnología AR también es utilizada por minoristas de muebles como IKEA, Houzz y Wayfair. Estos minoristas ofrecen aplicaciones que permiten a los consumidores ver sus productos en su hogar antes de comprar nada. En 2017, Ikea anunció la aplicación Ikea Place. Contiene un catálogo de más de 2000 productos, casi la colección completa de sofás, sillones, mesas de centro y unidades de almacenamiento de la empresa que se pueden colocar en cualquier lugar de una habitación con el teléfono. La aplicación hizo posible tener modelos de muebles en 3D y a escala real en el espacio vital del cliente. IKEA se dio cuenta de que sus clientes ya no compran en las tiendas con tanta frecuencia ni realizan compras directas. La adquisición de Primer por parte de Shopify, una aplicación de RA, tiene como objetivo impulsar a los vendedores pequeños y medianos hacia las compras de RA interactivas con una integración de RA fácil de usar y una experiencia de usuario tanto para comerciantes como para consumidores. AR ayuda a la industria minorista a reducir los costos operativos. Los comerciantes cargan la información del producto en el sistema AR y los consumidores pueden usar terminales móviles para buscar y generar mapas en 3D.

Literatura

La primera descripción de AR como se conoce hoy fue en Virtual Light, la novela de 1994 de William Gibson. En 2011, ni ka de Sekai Camera en Tokio, Japón, mezcló AR con poesía. La prosa de estos poemas AR proviene de Paul Celan, Die Niemandsrose, y expresa las secuelas del terremoto y tsunami de Tōhoku de 2011.

Artes visuales

La RA aplicada en las artes visuales permite que objetos o lugares desencadenen experiencias artísticas multidimensionales e interpretaciones de la realidad.

La realidad aumentada puede ayudar en la progresión del arte visual en los museos al permitir que los visitantes del museo vean las obras de arte en las galerías de una manera multidimensional a través de las pantallas de sus teléfonos. El Museo de Arte Moderno de Nueva York ha creado una exhibición en su museo de arte que muestra características de AR que los espectadores pueden ver usando una aplicación en su teléfono inteligente. El museo ha desarrollado su aplicación personal, llamada MoMAR Gallery, que los visitantes del museo pueden descargar y usar en la galería especializada en realidad aumentada para ver las pinturas del museo de una manera diferente. Esto permite a las personas ver aspectos ocultos e información sobre las pinturas, y también poder tener una experiencia tecnológica interactiva con las obras de arte.

La tecnología AR también se usó en "Margin of Error" de Nancy Baker Cahill. y "Revoluciones," las dos piezas de arte público que creó para la exposición Desert X de 2019.

La tecnología AR ayudó al desarrollo de la tecnología de seguimiento ocular para traducir los movimientos oculares de una persona discapacitada en dibujos en una pantalla.

La tecnología AR también se puede utilizar para colocar objetos en el entorno del usuario. Un artista danés, Olafur Eliasson, está colocando objetos como soles ardientes, rocas extraterrestres y animales raros en el entorno del usuario.

Ejercicios

El hardware y el software de RA para uso en fitness incluyen gafas inteligentes diseñadas para andar en bicicleta y correr, con análisis de rendimiento y navegación de mapas proyectados en el campo de visión del usuario, y boxeo, artes marciales y tenis, donde los usuarios permanecen. conscientes de su entorno físico para la seguridad. Los juegos y el software relacionados con la actividad física incluyen Pokémon Go y Jurassic World Alive.

Interacción humano-computadora

La interacción humano-computadora (HCI) es un área interdisciplinaria de la informática que se ocupa del diseño y la implementación de sistemas que interactúan con las personas. Los investigadores de HCI provienen de varias disciplinas, incluidas las ciencias de la computación, la ingeniería, el diseño, el factor humano y las ciencias sociales, con el objetivo compartido de resolver problemas en el diseño y el uso de la tecnología para que pueda usarse de manera más fácil y efectiva., de manera eficiente, segura y con satisfacción.

Colaboración remota

Los niños de primaria aprenden fácilmente a partir de experiencias interactivas. Como ejemplo, las constelaciones astronómicas y los movimientos de los objetos en el sistema solar se orientaron en 3D y se superpusieron en la dirección en que se sostuvo el dispositivo, y se expandieron con información de video adicional. Las ilustraciones de libros de ciencia en papel parecen cobrar vida en forma de video sin que el niño tenga que navegar por los materiales basados en la web.

En 2013, se lanzó un proyecto en Kickstarter para enseñar sobre electrónica con un juguete educativo que permitía a los niños escanear su circuito con un iPad y ver la corriente eléctrica circulando. Si bien algunas aplicaciones educativas estaban disponibles para AR en 2016, no se usaba ampliamente. Las aplicaciones que aprovechan la realidad aumentada para ayudar en el aprendizaje incluyen SkyView para estudiar astronomía, AR Circuits para construir circuitos eléctricos simples y SketchAr para dibujar.

AR también sería una forma para que los padres y maestros logren sus objetivos para la educación moderna, que podría incluir proporcionar un aprendizaje más individualizado y flexible, establecer conexiones más estrechas entre lo que se enseña en la escuela y el mundo real, y ayudar a los estudiantes a convertirse en más comprometidos con su propio aprendizaje.

Gestión de emergencias/búsqueda y rescate

Los sistemas de realidad aumentada se utilizan en situaciones de seguridad pública, desde súper tormentas hasta sospechosos en libertad.

Ya en 2009, dos artículos de Gestión de emergencias analizaban la tecnología AR para la gestión de emergencias. El primero fue 'Realidad aumentada: tecnología emergente para la gestión de emergencias', de Gerald Baron. Según Adam Crow: "Tecnologías como la realidad aumentada (por ejemplo, Google Glass) y la creciente expectativa del público seguirán obligando a los administradores de emergencias profesionales a cambiar radicalmente cuándo, dónde y cómo se implementa la tecnología antes, durante, y después de los desastres."

Otro ejemplo temprano fue un avión de búsqueda que buscaba a un excursionista perdido en un terreno montañoso accidentado. Los sistemas de realidad aumentada proporcionaron a los operadores de cámaras aéreas un conocimiento geográfico de los nombres y ubicaciones de los caminos forestales combinados con el video de la cámara. El operador de la cámara pudo buscar mejor al excursionista conociendo el contexto geográfico de la imagen de la cámara. Una vez ubicado, el operador podía dirigir a los rescatistas de manera más eficiente a la ubicación del excursionista porque la posición geográfica y los puntos de referencia estaban claramente etiquetados.

Interacción social

AR se puede utilizar para facilitar la interacción social. Un marco de red social de realidad aumentada llamado Talk2Me permite a las personas difundir información y ver a otros. información anunciada de forma de realidad aumentada. Las funcionalidades de intercambio y visualización de información oportuna y dinámica de Talk2Me ayudan a iniciar conversaciones y hacer amigos para los usuarios con personas en las proximidades físicas. Sin embargo, el uso de un auricular AR puede inhibir la calidad de una interacción entre dos personas si una no está usando uno si el auricular se convierte en una distracción.

La realidad aumentada también brinda a los usuarios la capacidad de practicar diferentes formas de interacción social con otras personas en un entorno seguro y sin riesgos. Hannes Kauffman, profesor asociado de realidad virtual en la Universidad Técnica de Viena, dice: "En la realidad aumentada colaborativa, varios usuarios pueden acceder a un espacio compartido poblado por objetos virtuales, mientras permanecen anclados en el mundo real". Esta técnica es particularmente poderosa para fines educativos cuando los usuarios están ubicados y pueden usar medios naturales de comunicación (habla, gestos, etc.), pero también se puede combinar con éxito con VR inmersiva o colaboración remota." Hannes cita la educación como un uso potencial de esta tecnología.

Videojuegos

La industria del juego adoptó la tecnología AR. Se desarrollaron varios juegos para entornos interiores preparados, como air hockey AR, Titans of Space, combate colaborativo contra enemigos virtuales y juegos de mesa de billar mejorados con AR.

En 2010, Ogmento se convirtió en la primera startup de juegos de realidad aumentada en recibir fondos de capital de riesgo. La compañía pasó a producir los primeros juegos AR basados en la ubicación para títulos como Paranormal Activity: Sanctuary, NBA: King of the Court y Halo: King of the Hill. La tecnología de visión por computadora de la compañía finalmente se volvió a empaquetar y se vendió a Apple, y se convirtió en una importante contribución a ARKit.

La realidad aumentada permitió a los jugadores de videojuegos experimentar el juego digital en un entorno del mundo real. Niantic lanzó el juego móvil de realidad aumentada Pokémon Go. Disney se asoció con Lenovo para crear el juego de realidad aumentada Star Wars: Jedi Challenges que funciona con un auricular Lenovo Mirage AR, un sensor de seguimiento y un controlador de sable de luz, cuyo lanzamiento está programado para diciembre de 2017.

Los juegos de realidad aumentada (ARG) también se utilizan para comercializar propiedades de entretenimiento de cine y televisión. El 16 de marzo de 2011, BitTorrent promocionó una versión con licencia abierta del largometraje Zenith en los Estados Unidos. También se animó a los usuarios que descargaron el software cliente BitTorrent a descargar y compartir la primera parte de las tres partes de la película. El 4 de mayo de 2011, la segunda parte de la película estuvo disponible en VODO. El lanzamiento episódico de la película, complementado por una campaña de marketing transmedia de ARG, creó un efecto viral y más de un millón de usuarios descargaron la película.

Diseño industrial

AR permite a los diseñadores industriales experimentar el diseño y el funcionamiento de un producto antes de su finalización. Volkswagen ha utilizado AR para comparar imágenes de pruebas de choque calculadas y reales. AR se ha utilizado para visualizar y modificar la estructura de la carrocería y el diseño del motor. También se ha utilizado para comparar maquetas digitales con maquetas físicas para encontrar discrepancias entre ellas.

Planificación, práctica y educación sanitaria

Una de las primeras aplicaciones de la realidad aumentada fue en el cuidado de la salud, particularmente para respaldar la planificación, práctica y capacitación de procedimientos quirúrgicos. Ya en 1992, mejorar el rendimiento humano durante la cirugía era un objetivo declarado formalmente cuando se construían los primeros sistemas de realidad aumentada en los laboratorios de la Fuerza Aérea de EE. UU. Desde 2005, se ha utilizado para localizar venas un dispositivo llamado buscador de venas de infrarrojo cercano que filma las venas subcutáneas, procesa y proyecta la imagen de las venas sobre la piel. AR proporciona a los cirujanos datos de seguimiento de pacientes al estilo de la pantalla de visualización frontal de un piloto de combate, y permite acceder y superponer registros de imágenes de pacientes, incluidos videos funcionales. Los ejemplos incluyen una vista virtual de rayos X basada en tomografías anteriores o en imágenes en tiempo real de sondas de ultrasonido y microscopía confocal, visualización de la posición de un tumor en el video de un endoscopio o riesgos de exposición a la radiación de dispositivos de imágenes de rayos X. AR puede mejorar la visualización de un feto dentro del útero de una madre. Siemens, Karl Storz e IRCAD han desarrollado un sistema para cirugía hepática laparoscópica que usa AR para ver tumores y vasos debajo de la superficie. AR se ha utilizado para el tratamiento de la fobia a las cucarachas y para reducir el miedo a las arañas. Se puede recordar a los pacientes que usan gafas de realidad aumentada que tomen medicamentos. La realidad aumentada puede ser de gran ayuda en el campo de la medicina. Podría usarse para proporcionar información crucial a un médico o cirujano sin que dejen de mirar al paciente. El 30 de abril de 2015, Microsoft anunció Microsoft HoloLens, su primer intento de realidad aumentada. HoloLens ha avanzado a lo largo de los años y es capaz de proyectar hologramas para cirugía guiada por imágenes basada en fluorescencia infrarroja cercana. A medida que avanza la realidad aumentada, encuentra cada vez más aplicaciones en el cuidado de la salud. La realidad aumentada y otras utilidades informáticas similares se utilizan para formar a los profesionales médicos. En el cuidado de la salud, la RA se puede utilizar para brindar orientación durante las intervenciones diagnósticas y terapéuticas, p. durante la cirugía. Magee et al. por ejemplo, describa el uso de la realidad aumentada para la capacitación médica en la simulación de la colocación de agujas guiada por ultrasonido. Un estudio muy reciente realizado por Akçayır, Akçayır, Pektaş y Ocak (2016) reveló que la tecnología AR mejora la experiencia de los estudiantes universitarios. habilidades de laboratorio y les ayuda a desarrollar actitudes positivas relacionadas con el trabajo de laboratorio de física. Recientemente, la realidad aumentada comenzó a adoptarse en la neurocirugía, un campo que requiere una gran cantidad de imágenes antes de los procedimientos.

Visualizaciones de conjuntos de Big Data en realidad aumentada

Con diferentes métodos de visualización para procesar conjuntos de Big Data en realidad aumentada y virtual, Gautam Siwach et al, exploraron la implementación de métodos estadísticos y técnicas de modelado en Big Data en Metaverse, es decir, utilizando algoritmos de aprendizaje automático e inteligencia artificial.

Inmersión espacial e interacción

Las aplicaciones de realidad aumentada, que se ejecutan en dispositivos portátiles utilizados como cascos de realidad virtual, también pueden digitalizar la presencia humana en el espacio y proporcionar un modelo generado por computadora de ellos, en un espacio virtual donde pueden interactuar y realizar diversas acciones. Dichas capacidades se demuestran en Project Anywhere, desarrollado por un estudiante de posgrado en ETH Zurich, que se denominó como una "experiencia fuera del cuerpo".

Entrenamiento de vuelo

Basándose en décadas de investigación perceptivo-motora en psicología experimental, los investigadores del Laboratorio de Investigación de Aviación de la Universidad de Illinois en Urbana–Champaign utilizaron la realidad aumentada en forma de trayectoria de vuelo en el cielo para enseñar a los estudiantes de vuelo cómo aterrizar. un avión usando un simulador de vuelo. Un horario adaptativo aumentado en el que a los estudiantes se les mostró el aumento solo cuando se apartaron de la ruta de vuelo demostró ser una intervención de entrenamiento más efectiva que un horario constante. Los estudiantes de vuelo a los que se les enseñó a aterrizar en el simulador con el aumento adaptativo aprendieron a aterrizar una avioneta más rápidamente que los estudiantes con la misma cantidad de entrenamiento de aterrizaje en el simulador pero con aumento constante o sin ningún aumento.

Militar

Una aplicación temprana interesante de AR ocurrió cuando Rockwell International creó superposiciones de mapas de video de satélites y pistas de escombros orbitales para ayudar en las observaciones espaciales en Air Force Maui Optical System. En su artículo de 1993 "Debris Correlation Using the Rockwell WorldView System" los autores describen el uso de superposiciones de mapas aplicadas al video de los telescopios de vigilancia espacial. Las superposiciones de mapas indicaron las trayectorias de varios objetos en coordenadas geográficas. Esto permitió a los operadores de telescopios identificar satélites y también identificar y catalogar desechos espaciales potencialmente peligrosos.

A partir de 2003, el ejército de EE. UU. integró el sistema de realidad aumentada SmartCam3D en el sistema aéreo no tripulado Shadow para ayudar a los operadores de sensores que utilizan cámaras telescópicas a localizar personas o puntos de interés. El sistema combinó información geográfica fija, incluidos nombres de calles, puntos de interés, aeropuertos y vías férreas, con video en vivo del sistema de cámaras. El sistema ofrecía una "imagen en imagen" modo que le permite mostrar una vista sintética del área que rodea el campo de visión de la cámara. Esto ayuda a resolver un problema en el que el campo de visión es tan estrecho que excluye un contexto importante, como si "mirara a través de una pajilla de refresco". El sistema muestra marcadores de ubicación de amigos/enemigos/neutrales en tiempo real combinados con video en vivo, lo que brinda al operador una mejor conciencia de la situación.

A partir de 2010, los investigadores coreanos buscan implementar robots detectores de minas en el ejército. El diseño propuesto para un robot de este tipo incluye una plataforma móvil que es como una pista que podría cubrir distancias irregulares, incluidas las escaleras. El sensor de detección de minas del robot incluiría una combinación de detectores de metales y un radar de penetración en el suelo para localizar minas o artefactos explosivos improvisados. Este diseño único sería de gran ayuda para salvar vidas de soldados coreanos.

Los investigadores del laboratorio de investigación de la USAF (Calhoun, Draper et al.) encontraron un aumento de aproximadamente el doble en la velocidad a la que los operadores de sensores de UAV encontraron puntos de interés utilizando esta tecnología. Esta capacidad de mantener la conciencia geográfica mejora cuantitativamente la eficiencia de la misión. El sistema está en uso en los sistemas aéreos no tripulados RQ-7 Shadow y MQ-1C Gray Eagle del Ejército de EE. UU.

En combate, AR puede servir como un sistema de comunicación en red que brinda datos útiles del campo de batalla en las gafas de un soldado en tiempo real. Desde el punto de vista del soldado, las personas y diversos objetos se pueden marcar con indicadores especiales para advertir sobre posibles peligros. Los mapas virtuales y las imágenes de la cámara de vista de 360° también se pueden representar para ayudar a la navegación de un soldado y la perspectiva del campo de batalla, y esto se puede transmitir a los líderes militares en un centro de comando remoto. La combinación de visualización de cámaras de visión de 360° y AR se puede utilizar a bordo de vehículos de combate y tanques como sistema de revisión circular.

AR puede ser una herramienta eficaz para mapear virtualmente las topologías 3D de los almacenamientos de municiones en el terreno, con la elección de la combinación de municiones en pilas y distancias entre ellas con una visualización de áreas de riesgo. El alcance de las aplicaciones AR también incluye la visualización de datos de sensores de monitoreo de municiones integrados.

Navegación

El NASA X-38 voló usando un sistema híbrido de visión sintética que superpuso datos de mapas en video para proporcionar una navegación mejorada para la nave espacial durante las pruebas de vuelo de 1998 a 2002. Usó el software LandForm, que fue útil en momentos de visibilidad limitada., incluida una instancia en la que la ventana de la cámara de video se congeló y los astronautas tuvieron que depender de las superposiciones de mapas. El software LandForm también se probó en vuelo en el campo de pruebas Army Yuma en 1999. En la foto de la derecha, se pueden ver los marcadores del mapa que indican las pistas, la torre de control de tráfico aéreo, las calles de rodaje y los hangares superpuestos en el video.

AR puede aumentar la eficacia de los dispositivos de navegación. La información se puede mostrar en el parabrisas de un automóvil que indica las direcciones de destino y el medidor, el clima, el terreno, las condiciones de la carretera y la información del tráfico, así como alertas sobre posibles peligros en su camino. Desde 2012, una empresa con sede en Suiza, WayRay, ha estado desarrollando sistemas de navegación AR holográficos que utilizan elementos ópticos holográficos para proyectar toda la información relacionada con la ruta, incluidas direcciones, notificaciones importantes y puntos de interés directamente en los conductores. línea de visión y muy por delante del vehículo. A bordo de embarcaciones marítimas, AR puede permitir que los vigilantes del puente monitoreen continuamente información importante, como el rumbo y la velocidad de un barco, mientras se mueven por el puente o realizan otras tareas.

Lugar de trabajo

La realidad aumentada puede tener un impacto positivo en la colaboración laboral, ya que las personas pueden estar inclinadas a interactuar más activamente con su entorno de aprendizaje. También puede fomentar la renovación del conocimiento tácito que hace que las empresas sean más competitivas. AR se utilizó para facilitar la colaboración entre los miembros del equipo distribuido a través de conferencias con participantes locales y virtuales. Las tareas de RA incluyeron lluvia de ideas y reuniones de discusión utilizando visualización común a través de mesas de pantalla táctil, pizarras digitales interactivas, espacios de diseño compartidos y salas de control distribuidas.

En entornos industriales, la realidad aumentada está demostrando tener un impacto sustancial con más y más casos de uso que surgen en todos los aspectos del ciclo de vida del producto, desde el diseño del producto y la introducción de nuevos productos (NPI) hasta la fabricación, el servicio y el mantenimiento, para manejo y distribución de materiales. Por ejemplo, se exhibieron etiquetas en partes de un sistema para aclarar las instrucciones de operación para un mecánico que realiza el mantenimiento de un sistema. Las líneas de montaje se beneficiaron del uso de AR. Además de Boeing, BMW y Volkswagen se destacaron por incorporar esta tecnología en las líneas de ensamblaje para monitorear las mejoras en los procesos. Las máquinas grandes son difíciles de mantener debido a sus múltiples capas o estructuras. AR permite a las personas mirar a través de la máquina como si fuera una radiografía, señalándoles el problema de inmediato.

A medida que la tecnología AR ha evolucionado y los dispositivos AR de segunda y tercera generación llegan al mercado, el impacto de AR en la empresa sigue creciendo. En Harvard Business Review, Magid Abraham y Marco Annunziata analizan cómo los dispositivos AR ahora se utilizan para "impulsar a los trabajadores' productividad en una variedad de tareas la primera vez que se usan, incluso sin capacitación previa. Sostienen que "estas tecnologías aumentan la productividad al hacer que los trabajadores sean más calificados y eficientes y, por lo tanto, tienen el potencial de generar más crecimiento económico y mejores empleos".

Transmisión y eventos en vivo

Las visualizaciones meteorológicas fueron la primera aplicación de realidad aumentada en televisión. Ahora se ha vuelto común en la proyección del clima mostrar video de movimiento completo de imágenes capturadas en tiempo real desde múltiples cámaras y otros dispositivos de imágenes. Junto con símbolos gráficos en 3D y asignados a un modelo geoespacial virtual común, estas visualizaciones animadas constituyen la primera aplicación real de AR a la televisión.

AR se ha vuelto común en la transmisión de deportes. Los lugares de deportes y entretenimiento cuentan con aumento de transparencia y superposición a través de transmisiones de cámaras rastreadas para una mejor visualización por parte de la audiencia. Los ejemplos incluyen el amarillo "primer down" línea que se ve en transmisiones de televisión de partidos de fútbol americano que muestra la línea que el equipo ofensivo debe cruzar para recibir un primer intento. AR también se utiliza en asociación con el fútbol y otros eventos deportivos para mostrar anuncios comerciales superpuestos a la vista del área de juego. Las secciones de los campos de rugby y de cricket también muestran imágenes patrocinadas. Las transmisiones por televisión de natación a menudo agregan una línea a través de los carriles para indicar la posición del poseedor del récord actual a medida que avanza una carrera para permitir a los espectadores comparar la carrera actual con la mejor actuación. Otros ejemplos incluyen el seguimiento del disco de hockey y las anotaciones del rendimiento de los autos de carreras y las trayectorias de las bolas de billar.

AR se ha utilizado para mejorar los conciertos y las representaciones teatrales. Por ejemplo, los artistas permiten a los oyentes aumentar su experiencia auditiva agregando su interpretación a la de otras bandas/grupos de usuarios.

Turismo y turismo

Los viajeros pueden usar AR para acceder a pantallas de información en tiempo real sobre una ubicación, sus características y comentarios o contenido proporcionado por visitantes anteriores. Las aplicaciones AR avanzadas incluyen simulaciones de eventos históricos, lugares y objetos representados en el paisaje.

Las aplicaciones de realidad aumentada vinculadas a ubicaciones geográficas presentan información de ubicación por audio y anuncian características de interés en un sitio en particular a medida que se vuelven visibles para el usuario.

Traducción

Los sistemas AR, como Word Lens, pueden interpretar el texto extranjero en letreros y menús y, en la vista aumentada de un usuario, volver a mostrar el texto en el idioma del usuario. Las palabras habladas de un idioma extranjero se pueden traducir y mostrar en la vista de un usuario como subtítulos impresos.

Música

Se ha sugerido que la realidad aumentada puede usarse en nuevos métodos de producción, mezcla, control y visualización de música.

Se ha conceptualizado una herramienta para la creación de música en 3D en clubes que, además de las funciones regulares de mezcla de sonido, permite al DJ reproducir docenas de muestras de sonido, ubicadas en cualquier lugar del espacio 3D.

Los equipos de Leeds College of Music han desarrollado una aplicación AR que se puede usar con las mesas Audient y permite a los estudiantes usar su teléfono inteligente o tableta para poner capas de información o interactividad encima de una mesa de mezclas Audient.

ARmony es un paquete de software que utiliza la realidad aumentada para ayudar a las personas a aprender a tocar un instrumento.

En un proyecto de prueba de concepto, Ian Sterling, un estudiante de diseño de interacción en la Facultad de Artes de California, y el ingeniero de software Swaroop Pal demostraron una aplicación de HoloLens cuyo objetivo principal es proporcionar una interfaz de usuario espacial 3D para dispositivos multiplataforma: la aplicación Android Music Player y el ventilador y la luz controlados por Arduino, y también permiten la interacción mediante el control de la mirada y los gestos.

AR Mixer es una aplicación que permite seleccionar y mezclar canciones mediante la manipulación de objetos, como cambiar la orientación de una botella o lata.

En un video, Uriel Yehezkel demuestra el uso del controlador Leap Motion y GECO MIDI para controlar Ableton Live con gestos con las manos y afirma que con este método pudo controlar más de 10 parámetros simultáneamente con ambas manos y tomar control total sobre el construcción del canto, emoción y energía.

Se ha propuesto un instrumento musical novedoso que permite a los novatos tocar composiciones musicales electrónicas, remezclando y modulando sus elementos de forma interactiva, mediante la manipulación de objetos físicos simples.

Se ha desarrollado un sistema que utiliza gestos explícitos y movimientos de baile implícitos para controlar los aumentos visuales de una actuación de música en vivo que permite actuaciones más dinámicas y espontáneas y, en combinación con la realidad aumentada indirecta, que conduce a una interacción más intensa entre el artista y el público. sugirió.

La investigación realizada por miembros de CRIStAL en la Universidad de Lille hace uso de la realidad aumentada para enriquecer la interpretación musical. El proyecto ControllAR permite a los músicos aumentar sus superficies de control MIDI con las interfaces gráficas de usuario remezcladas del software de música. El proyecto Rouages propone aumentar los instrumentos musicales digitales para revelar sus mecanismos a la audiencia y así mejorar la vivacidad percibida. Reflets es una pantalla de realidad aumentada novedosa dedicada a las actuaciones musicales en las que el público actúa como una pantalla 3D al revelar contenido virtual en el escenario, que también se puede utilizar para la interacción y colaboración musical en 3D.

Snapchat

Los usuarios de Snapchat tienen acceso a la realidad aumentada en la aplicación de mensajería instantánea de la empresa mediante el uso de filtros de cámara. En septiembre de 2017, Snapchat actualizó su aplicación para incluir un filtro de cámara que permitía a los usuarios renderizar una versión animada de dibujos animados de sí mismos llamada "Bitmoji". Estos avatares animados se proyectarían en el mundo real a través de la cámara y se pueden fotografiar o grabar en video. En el mismo mes, Snapchat también anunció una nueva característica llamada "Sky Filters" que estará disponible en su aplicación. Esta nueva característica hace uso de la realidad aumentada para alterar el aspecto de una imagen tomada del cielo, de forma muy similar a cómo los usuarios pueden aplicar los filtros de la aplicación a otras imágenes. Los usuarios pueden elegir entre filtros de cielo como noche estrellada, nubes tormentosas, hermosas puestas de sol y arcoíris.

Preocupaciones

Modificaciones de la realidad

En un artículo titulado 'Muerte por Pokémon GO', los investigadores de la Krannert School of Management de la Universidad de Purdue afirman que el juego provocó 'un aumento desproporcionado de accidentes vehiculares y daños vehiculares asociados, lesiones personales y muertes en las inmediaciones de los lugares, llamados PokéStops, donde los usuarios pueden jugar mientras conducen." Utilizando datos de un municipio, el documento extrapola lo que eso podría significar a nivel nacional y concluyó que "el aumento de accidentes atribuible a la introducción de Pokémon GO es 145 632 con un aumento asociado en el número de lesiones de 29 370 y un aumento asociado en el número de muertes de 256 durante el período del 6 de julio de 2016 al 30 de noviembre de 2016." Los autores extrapolaron el costo de esos choques y muertes entre $ 2 mil millones y $ 7,3 mil millones para el mismo período. Además, a más de uno de cada tres usuarios avanzados de Internet encuestados le gustaría editar elementos perturbadores a su alrededor, como basura o graffiti. Les gustaría incluso modificar su entorno borrando letreros de calles, anuncios publicitarios y escaparates de tiendas poco interesantes. Entonces, parece que AR es tanto una amenaza para las empresas como una oportunidad. Aunque esto podría ser una pesadilla para numerosas marcas que no logran capturar la imaginación de los consumidores, también crea el riesgo de que los usuarios de gafas de realidad aumentada no se den cuenta de los peligros circundantes. Los consumidores quieren usar gafas de realidad aumentada para cambiar su entorno en algo que refleje sus propias opiniones personales. Alrededor de dos de cada cinco quieren cambiar la apariencia de su entorno e incluso la forma en que las personas se ven ante ellos.

A continuación, además de los posibles problemas de privacidad que se describen a continuación, los problemas de sobrecarga y exceso de confianza son el mayor peligro de AR. Para el desarrollo de nuevos productos relacionados con AR, esto implica que la interfaz de usuario debe seguir ciertas pautas para no sobrecargar al usuario con información y al mismo tiempo evitar que el usuario confíe demasiado en el sistema AR, de modo que las señales importantes del entorno sean omitido. Esto se llama la clave aumentada virtualmente. Una vez que se ignora la clave, es posible que las personas ya no deseen el mundo real.

Problemas de privacidad

El concepto de realidad aumentada moderna depende de la capacidad del dispositivo para registrar y analizar el entorno en tiempo real. Debido a esto, existen posibles preocupaciones legales sobre la privacidad. Si bien la Primera Enmienda de la Constitución de los Estados Unidos permite dicha grabación en nombre del interés público, la grabación constante de un dispositivo AR dificulta hacerlo sin grabar también fuera del dominio público. Se encontrarían complicaciones legales en áreas donde se espera un derecho a una cierta cantidad de privacidad o donde se muestran medios protegidos por derechos de autor.

En términos de privacidad individual, existe la facilidad de acceso a la información que uno no debería poseer fácilmente sobre una persona determinada. Esto se logra a través de la tecnología de reconocimiento facial. Suponiendo que AR pasa automáticamente información sobre las personas que ve el usuario, podría verse cualquier cosa de las redes sociales, antecedentes penales y estado civil.

El Código de Ética sobre Aumento Humano, que fue presentado originalmente por Steve Mann en 2004 y refinado con Ray Kurzweil y Marvin Minsky en 2013, finalmente fue ratificado en la conferencia de realidad virtual de Toronto el 25 de junio de 2017.

Derecho inmobiliario

La interacción de la realidad aumentada ligada a la ubicación con la ley de propiedad es en gran parte indefinida. Se han analizado varios modelos sobre cómo se puede resolver esta interacción en un contexto de derecho consuetudinario: una extensión de los derechos de propiedad real para cubrir también los aumentos en o cerca de la propiedad con una fuerte noción de traspaso, prohibiendo los aumentos a menos que lo permita el propietario; un 'campo abierto' sistema, donde los aumentos están permitidos a menos que lo prohíba el propietario; y una 'libertad para vagar' sistema, donde los propietarios de bienes inmuebles no tienen control sobre los aumentos no disruptivos.

Un problema experimentado durante la locura de Pokémon Go fue que los jugadores del juego molestaban a los propietarios de propiedades privadas mientras visitaban los aumentos cercanos a la ubicación, que pueden haber estado en las propiedades o las propiedades pueden haber estado en camino . Los términos de servicio de Pokémon Go renuncian explícitamente a la responsabilidad de los jugadores' acciones, que pueden limitar (pero no extinguir totalmente) la responsabilidad de su productor, Niantic, en caso de que un jugador invada mientras juega: según el argumento de Niantic, el jugador es el que comete la infracción, mientras que Niantic simplemente se ha comprometido con la libertad de expresión permitida. Una teoría presentada en las demandas presentadas contra Niantic es que la colocación de los elementos del juego en lugares que conducirán a la intrusión o a un flujo excepcionalmente grande de visitantes puede constituir una molestia, a pesar de que cada intrusión o visita individual solo es provocada tenuemente por Niantic.

Otro reclamo presentado contra Niantic es que la colocación de elementos de juegos rentables en un terreno sin el permiso de los propietarios del terreno es un enriquecimiento injusto. Más hipotéticamente, una propiedad puede ser aumentada con publicidad o contenido desagradable en contra de los deseos de su propietario. Bajo la ley estadounidense, es poco probable que estas situaciones sean vistas como una violación de los derechos de propiedad real por parte de los tribunales sin una expansión de esos derechos para incluir la realidad aumentada (de manera similar a cómo el derecho consuetudinario inglés llegó a reconocer los derechos aéreos).

Un artículo en Michigan Telecommunications and Technology Law Review argumenta que hay tres bases para esta extensión, comenzando con varios entendimientos de propiedad. Se afirma que la teoría de la propiedad de la personalidad, esbozada por Margaret Radin, respalda la extensión de los derechos de propiedad debido a la íntima conexión entre la personalidad y la propiedad de la propiedad; sin embargo, su punto de vista no es compartido universalmente por los teóricos del derecho. Según la teoría utilitarista de la propiedad, los beneficios de evitar los daños a los propietarios de bienes inmuebles causados por los aumentos y la tragedia de los bienes comunes, y la reducción de los costos de transacción al facilitar el descubrimiento de la propiedad, se evaluaron como justificación para reconocer los derechos de propiedad real como cobertura. aumentos vinculados a la ubicación, aunque sigue existiendo la posibilidad de una tragedia de los anticomunes al tener que negociar con los propietarios que ralentizan la innovación. Finalmente, siguiendo la 'propiedad como ley de las cosas' identificación tal como lo respaldan Thomas Merrill y Henry E Smith, el aumento basado en la ubicación se identifica naturalmente como una "cosa" y, mientras que la naturaleza efímera y no rival de los objetos digitales presenta dificultades para la vertiente de exclusión de la definición, el artículo argumenta que esto no es insuperable.

Se han realizado algunos intentos de regulación legislativa en los Estados Unidos. El condado de Milwaukee, Wisconsin, intentó regular los juegos de realidad aumentada que se juegan en sus parques, requiriendo la emisión previa de un permiso, pero un juez federal criticó esto por motivos de libertad de expresión; e Illinois consideró exigir un aviso y un procedimiento de eliminación para los aumentos con límite de ubicación.