Predicción de terremotos

La predicción de terremotos es una rama de la ciencia de la sismología que se ocupa de la especificación de la hora, la ubicación y la magnitud de futuros terremotos dentro de los límites establecidos y, en particular, "la determinación de parámetros para el próximo terremoto fuerte que ocurrirá en una región. La predicción de terremotos a veces se distingue de la pronóstica de terremotos, que se puede definir como la evaluación probabilística del peligro general de terremotos, incluida la frecuencia y la magnitud de los terremotos dañinos en un área determinada a lo largo de los años. o décadas. No todos los científicos distinguen "predicción" y "pronóstico", pero la distinción es útil.

La predicción se puede distinguir aún más de los sistemas de alerta de terremotos, que, al detectar un terremoto, brindan una advertencia en tiempo real de segundos a las regiones vecinas que podrían verse afectadas.

En la década de 1970, los científicos estaban optimistas de que pronto se encontraría un método práctico para predecir terremotos, pero en la década de 1990, el continuo fracaso llevó a muchos a preguntarse si era posible. No se han producido predicciones demostrablemente exitosas de grandes terremotos, y las pocas afirmaciones de éxito son controvertidas. Por ejemplo, la afirmación más famosa de una predicción exitosa es la del terremoto de Haicheng de 1975. Un estudio posterior dijo que no había una predicción válida a corto plazo. Las búsquedas exhaustivas han informado muchos posibles precursores de terremotos, pero, hasta ahora, dichos precursores no se han identificado de manera confiable en escalas espaciales y temporales significativas. Si bien parte de la comunidad científica sostiene que, teniendo en cuenta los precursores no sísmicos y con suficientes recursos para estudiarlos en profundidad, la predicción podría ser posible, la mayoría de los científicos son pesimistas y algunos sostienen que la predicción de terremotos es inherentemente imposible.

Evaluación de predicciones de terremotos

Las predicciones se consideran significativas si se puede demostrar que tienen éxito más allá del azar. Por lo tanto, los métodos de prueba de hipótesis estadística se utilizan para determinar la probabilidad de que ocurra un terremoto como el que se predice (la hipótesis nula). Luego, las predicciones se evalúan probando si se correlacionan con los terremotos reales mejor que la hipótesis nula.

En muchos casos, sin embargo, la naturaleza estadística de la ocurrencia de terremotos no es simplemente homogénea. La agrupación se produce tanto en el espacio como en el tiempo. En el sur de California, alrededor del 6 % de los terremotos M≥3.0 son "seguidos de un terremoto de mayor magnitud dentro de los 5 días y 10 km". En el centro de Italia, el 9,5 % de los terremotos M≥3,0 son seguidos por un evento mayor en 48 horas y 30 km. Si bien tales estadísticas no son satisfactorias para fines de predicción (dando de diez a veinte falsas alarmas por cada predicción exitosa), distorsionarán los resultados de cualquier análisis que suponga que los terremotos ocurren aleatoriamente en el tiempo, por ejemplo, según lo observado a partir de un proceso de Poisson. Se ha demostrado que un "ingenuo" el método basado únicamente en la agrupación puede predecir con éxito alrededor del 5% de los terremotos; "mucho mejor que 'oportunidad'".

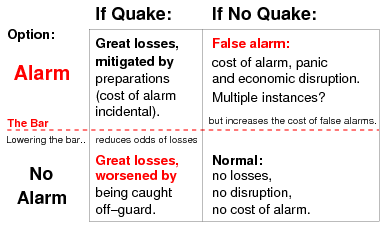

Como el propósito de la predicción a corto plazo es habilitar medidas de emergencia para reducir la muerte y la destrucción, la falta de advertencia de un gran terremoto que ocurra, o al menos una evaluación adecuada del peligro, puede resultar en responsabilidad legal, o incluso depuración política. Por ejemplo, se informó que los miembros de la Academia de Ciencias de China fueron purgados por "haber ignorado las predicciones científicas del desastroso terremoto de Tangshan del verano de 1976". Tras el terremoto de L'Aquila de 2009, siete científicos y técnicos en Italia fueron condenados por homicidio involuntario, pero no tanto por no predecir el terremoto, en el que murieron unas 300 personas, como por dar garantías indebidas a la población: una víctima lo llamó "anestesia" – que no habría un terremoto grave, y por lo tanto no hay necesidad de tomar precauciones. Pero la advertencia de un terremoto que no ocurre también incurre en un costo: no solo el costo de las medidas de emergencia en sí, sino también el de la perturbación civil y económica. Las falsas alarmas, incluidas las que se cancelan, también socavan la credibilidad y, por lo tanto, la eficacia de las advertencias futuras. En 1999, se informó que China estaba introduciendo "regulaciones estrictas destinadas a acabar con las advertencias de terremotos 'falsas', para evitar el pánico y la evacuación masiva de ciudades provocada por pronósticos de grandes temblores". Esto fue provocado por "más de 30 advertencias no oficiales de terremotos... en los últimos tres años, ninguna de las cuales ha sido precisa". La compensación aceptable entre terremotos perdidos y falsas alarmas depende de la valoración social de estos resultados. La tasa de ocurrencia de ambos debe tenerse en cuenta al evaluar cualquier método de predicción.

En un estudio de 1997 sobre la relación costo-beneficio de la investigación de predicción de terremotos en Grecia, Stathis Stiros sugirió que incluso un método de predicción excelente (hipotético) sería de utilidad social cuestionable, porque "la evacuación organizada de los centros urbanos es es poco probable que se logre con éxito", mientras que "el pánico y otros efectos secundarios indeseables también pueden anticiparse". Descubrió que los terremotos matan a menos de diez personas por año en Grecia (en promedio) y que la mayoría de esas muertes ocurrieron en grandes edificios con problemas estructurales identificables. Por lo tanto, Stiros afirmó que sería mucho más rentable concentrar los esfuerzos en identificar y mejorar los edificios inseguros. Dado que el número de muertos en las carreteras griegas es de más de 2300 por año en promedio, argumentó que también se salvarían más vidas si todo el presupuesto de Grecia para la predicción de terremotos se hubiera utilizado para la seguridad de las calles y carreteras.

Métodos de predicción

La predicción de terremotos es una ciencia inmadura: aún no ha conducido a una predicción exitosa de un terremoto a partir de los primeros principios físicos. Por lo tanto, la investigación sobre métodos de predicción se centra en el análisis empírico, con dos enfoques generales: ya sea identificando precursores distintivos de los terremotos, o identificando algún tipo de tendencia geofísica o patrón en la sismicidad que podría preceder a un gran terremoto. Los métodos precursores se buscan en gran parte debido a su utilidad potencial para la predicción o el pronóstico de terremotos a corto plazo, mientras que la 'tendencia' En general, se cree que los métodos son útiles para la predicción, la predicción a largo plazo (escala de tiempo de 10 a 100 años) o la predicción a plazo intermedio (escala de tiempo de 1 a 10 años).

Precursores

Un precursor de un terremoto es un fenómeno anómalo que podría dar una advertencia efectiva de un terremoto inminente. Los informes de estos, aunque generalmente reconocidos como tales solo después del evento, se cuentan por miles, algunos se remontan a la antigüedad. Ha habido alrededor de 400 informes de posibles precursores en la literatura científica, de aproximadamente veinte tipos diferentes, que van desde la aeronomía hasta la zoología. No se ha encontrado que ninguno sea confiable a los efectos de la predicción de terremotos.

A principios de 1990, la IASPEI solicitó nominaciones para una Lista preliminar de precursores significativos. Se hicieron cuarenta nominaciones, de las cuales cinco fueron seleccionadas como posibles precursores significativos, dos de ellas basadas en una sola observación cada una.

Después de una revisión crítica de la literatura científica, la Comisión Internacional de Pronóstico de Terremotos para Protección Civil (ICEF) concluyó en 2011 que había "un margen considerable para mejoras metodológicas en este tipo de investigación." En particular, muchos casos de precursores informados son contradictorios, carecen de una medida de amplitud o generalmente no son adecuados para una evaluación estadística rigurosa. Los resultados publicados están sesgados hacia los resultados positivos, por lo que la tasa de falsos negativos (terremoto pero sin señal precursora) no está clara.

Comportamiento animal

Después de que ya ha comenzado un terremoto, las ondas de presión (ondas P) viajan el doble de rápido que las ondas de corte más dañinas (ondas s). Por lo general, los humanos no los notan, pero algunos animales pueden notar las vibraciones más pequeñas que llegan entre unas pocas docenas de segundos antes del temblor principal y alarmarse o exhibir otro comportamiento inusual. Los sismómetros también pueden detectar ondas P, y los sistemas electrónicos de alerta de terremotos aprovechan la diferencia de tiempo para proporcionar a los humanos unos segundos para trasladarse a un lugar más seguro.

Una revisión de los estudios científicos disponibles a partir de 2018 que abarcan más de 130 especies no encontró evidencia suficiente para demostrar que los animales podrían advertir sobre terremotos con horas, días o semanas de anticipación. Las correlaciones estadísticas sugieren que algunos comportamientos animales inusuales informados se deben a terremotos más pequeños (pedacitos) que a veces preceden a un gran terremoto, que si es lo suficientemente pequeño puede pasar desapercibido para las personas. Los temblores previos también pueden causar cambios en las aguas subterráneas o liberar gases que los animales pueden detectar. Los sismómetros también detectan las sacudidas preliminares y se han estudiado durante mucho tiempo como predictores potenciales, pero sin éxito (ver #Patrones de sismicidad). Los sismólogos no han encontrado evidencia de cambios físicos o químicos a mediano plazo que predigan terremotos que los animales puedan sentir.

Durante miles de años se han registrado informes anecdóticos de extraños comportamientos animales antes de los terremotos. Algunos comportamientos animales inusuales pueden atribuirse erróneamente a un terremoto en un futuro cercano. El efecto de memoria flash hace que los detalles anodinos se vuelvan más memorables y significativos cuando se asocian con un evento emocionalmente poderoso, como un terremoto. Incluso la gran mayoría de los informes científicos en la revisión de 2018 no incluyeron observaciones que mostraran que los animales no actuaron de manera inusual cuando no estaba a punto de ocurrir un terremoto, lo que significa que el comportamiento era no establecido para ser predictivo.

La mayoría de los investigadores que investigan la predicción animal de terremotos se encuentran en China y Japón. La mayoría de las observaciones científicas provienen del terremoto de Canterbury de 2010 en Nueva Zelanda, el terremoto de Otaki de 1984 en Japón y el terremoto de L'Aquila de 2009 en Italia.

Los animales que se sabe que son magnetorreceptivos podrían detectar ondas electromagnéticas en los rangos de frecuencia ultra baja y extremadamente baja que alcanzan la superficie de la Tierra antes de un terremoto, lo que provoca un comportamiento extraño. Estas ondas electromagnéticas también podrían causar ionización del aire, oxidación del agua y posible intoxicación por agua que otros animales podrían detectar.

Dilatancia-difusión

En la década de 1970, la hipótesis de la dilatancia-difusión era muy apreciada por proporcionar una base física para varios fenómenos considerados como posibles precursores de terremotos. Se basó en "evidencia sólida y repetible" a partir de experimentos de laboratorio, la roca cristalina altamente estresada experimentó un cambio de volumen, o dilatancia, lo que provoca cambios en otras características, como la velocidad sísmica y la resistividad eléctrica, e incluso levantamientos topográficos a gran escala. Se creía que esto sucedió en una 'fase preparatoria' justo antes del terremoto, y que un seguimiento adecuado podría, por lo tanto, advertir de un terremoto inminente.

La detección de variaciones en las velocidades relativas de las ondas sísmicas primarias y secundarias, expresadas como Vp/Vs, a medida que pasaban por una determinada zona fue la base para predecir el Blue Mountain Lake de 1973 (NY) y el Riverside de 1974 (CA) terremoto. Aunque estas predicciones eran informales e incluso triviales, su aparente éxito fue visto como una confirmación tanto de la dilatación como de la existencia de un proceso preparatorio, que condujo a lo que posteriormente se denominó "declaraciones excesivamente optimistas" que la predicción exitosa de terremotos 'parece estar al borde de la realidad práctica'.

Sin embargo, muchos estudios cuestionaron estos resultados y la hipótesis finalmente languideció. Un estudio posterior mostró que "falló por varias razones, en gran parte asociadas con la validez de las suposiciones en las que se basa", incluida la suposición de que los resultados de laboratorio se pueden escalar al mundo real. Otro factor fue el sesgo de la selección retrospectiva de criterios. Otros estudios han demostrado que la dilatación es tan insignificante que Main et al. 2012 concluyó: "El concepto de una 'zona de preparación' indicando la magnitud probable de un evento futuro, permanece tan etéreo como el éter que pasó desapercibido en el experimento de Michelson-Morley."

Cambios en Vp/Vs

Vp es el símbolo de la velocidad de una "P" sísmica; (primaria o de presión) que pasa a través de la roca, mientras que Vs es el símbolo de la velocidad de la "S" onda (secundaria o cortante). Experimentos de laboratorio a pequeña escala han demostrado que la relación de estas dos velocidades, representada como Vp/Vs – cambia cuando la roca está cerca del punto de fractura. En la década de 1970 se consideró un avance probable cuando los sismólogos rusos informaron haber observado tales cambios (luego descartados) en la región de un terremoto posterior. Este efecto, así como otros posibles precursores, se ha atribuido a la dilatancia, donde la roca estresada hasta cerca de su punto de ruptura se expande (dilata) ligeramente.

El estudio de este fenómeno cerca del lago Blue Mountain en el estado de Nueva York condujo a una predicción exitosa, aunque informal, en 1973, y se le atribuyó la predicción del terremoto de Riverside (CA) en 1974. Sin embargo, no se han seguido éxitos adicionales, y se ha sugerido que estas predicciones fueron una casualidad. Una anomalía Vp/Vs fue la base de una predicción de 1976 de un terremoto M 5.5 a 6.5 cerca de Los Ángeles, que no se produjo. Otros estudios que se basaron en explosiones de canteras (más precisas y repetibles) no encontraron tales variaciones, mientras que un análisis de dos terremotos en California encontró que las variaciones reportadas probablemente fueron causadas por otros factores, incluida la selección retrospectiva de datos. Geller (1997) señaló que los informes de cambios de velocidad significativos han cesado desde alrededor de 1980.

Emisiones de radón

La mayoría de las rocas contienen pequeñas cantidades de gases que se pueden distinguir isotópicamente de los gases atmosféricos normales. Hay informes de picos en las concentraciones de dichos gases antes de un gran terremoto; esto se ha atribuido a la liberación debido a la tensión presísmica o al fracturamiento de la roca. Uno de estos gases es el radón, producido por la desintegración radiactiva de las trazas de uranio presentes en la mayoría de las rocas. El radón es potencialmente útil como predictor de terremotos porque es radiactivo y, por lo tanto, se detecta fácilmente, y su corta vida media (3,8 días) hace que los niveles de radón sean sensibles a las fluctuaciones a corto plazo.

Una compilación de 2009 enumeró 125 informes de cambios en las emisiones de radón antes de 86 terremotos desde 1966. Sin embargo, la Comisión Internacional de Pronósticos de Terremotos para Protección Civil (ICEF) encontró en su revisión crítica de 2011 que los terremotos con los que estos cambios supuestamente están relacionados estuvieron hasta a mil kilómetros de distancia, meses después, y en todas las magnitudes. En algunos casos, las anomalías se observaron en un sitio distante, pero no en sitios más cercanos. El ICEF no encontró 'ninguna correlación significativa'.

Anomalías electromagnéticas

Las observaciones de perturbaciones electromagnéticas y su atribución al proceso de falla sísmica se remontan al Gran Terremoto de Lisboa de 1755, pero prácticamente todas esas observaciones anteriores a mediados de la década de 1960 no son válidas porque los instrumentos utilizados eran sensibles al movimiento físico. Desde entonces, varios fenómenos eléctricos, electrorresistivos y magnéticos anómalos se han atribuido a cambios precursores de tensión y deformación que preceden a los terremotos, lo que genera esperanzas de encontrar un precursor de terremotos fiable. Si bien un puñado de investigadores ha ganado mucha atención con teorías de cómo se podrían generar tales fenómenos, afirmaciones de haber observado tales fenómenos antes de un terremoto, no se ha demostrado que tales fenómenos sean un precursor real.

Una revisión de 2011 realizada por la Comisión Internacional de Pronóstico de Terremotos para la Protección Civil (ICEF, por sus siglas en inglés) encontró que el "más convincente" precursores electromagnéticos como anomalías magnéticas de ultra baja frecuencia, como el evento de Corralitos (discutido a continuación) registrado antes del terremoto de Loma Prieta en 1989. Sin embargo, ahora se cree que la observación fue un mal funcionamiento del sistema. El estudio del terremoto de Parkfield de 2004 monitoreado de cerca no encontró evidencia de señales electromagnéticas precursoras de ningún tipo; un estudio posterior mostró que los terremotos con magnitudes inferiores a 5 no producen señales transitorias significativas. La ICEF consideró que la búsqueda de precursores útiles no había tenido éxito.

Señales eléctricas sísmicas VAN

La afirmación más promocionada y más criticada de un precursor electromagnético es el método VAN de los profesores de física Panayiotis Varotsos, Kessar Alexopoulos y Konstantine Nomicos (VAN) de la Universidad de Atenas. En un artículo de 1981, afirmaron que al medir los voltajes geoeléctricos, lo que llamaron "señales eléctricas sísmicas" (SES) – podían predecir terremotos.

En 1984, afirmaron que había una "correspondencia uno a uno" entre SES y terremotos, es decir, que "cada EQ considerable está precedido por un SES e inversamente cada SES siempre está seguido por un EQ la magnitud y el epicentro de los cuales se puede predecir de forma fiable" – el SES que aparece entre 6 y 115 horas antes del terremoto. Como prueba de su método afirmaron una serie de predicciones exitosas.

Aunque su informe fue "alabado por algunos como un gran avance", entre los sismólogos fue recibido por una "ola de escepticismo generalizado". En 1996, un artículo que VAN envió a la revista Geophysical Research Letters recibió una revisión pública sin precedentes por parte de un amplio grupo de revisores, y el artículo y las revisiones se publicaron en una edición especial; la mayoría de los revisores encontraron que los métodos de VAN eran defectuosos. Se plantearon críticas adicionales el mismo año en un debate público entre algunos de los directores.

Una crítica principal fue que el método es geofísicamente inverosímil y científicamente erróneo. Las objeciones adicionales incluyeron la falsedad demostrable de la supuesta relación uno a uno de los terremotos y SES, la improbabilidad de un proceso precursor que genere señales más fuertes que las observadas en los terremotos reales, y la gran probabilidad de que las señales fueran hechas por el hombre. El trabajo adicional en Grecia ha rastreado "señales eléctricas transitorias anómalas" de vuelta a fuentes humanas específicas, y descubrió que tales señales no están excluidas por los criterios utilizados por VAN para identificar SES. Un trabajo más reciente, mediante el empleo de métodos modernos de física estadística, es decir, análisis de fluctuación sin tendencia (DFA), DFA multifractal y transformada wavelet, reveló que SES se distinguen claramente de las señales producidas por fuentes artificiales.

La validez del método VAN y, por lo tanto, la importancia predictiva de SES, se basó principalmente en la afirmación empírica del éxito predictivo demostrado. Se han descubierto numerosas debilidades en la metodología VAN, y en 2011 la Comisión Internacional de Pronóstico de Terremotos para Protección Civil concluyó que la capacidad de predicción reclamada por VAN no podía validarse. La mayoría de los sismólogos consideran que VAN ha sido "rotundamente desacreditado". Por otro lado, la Sección "Precursores de Terremotos y Predicción" de la "Enciclopedia de la geofísica de la Tierra Sólida: parte de la "Serie de la Enciclopedia de las Ciencias de la Tierra" (Springer 2011) termina de la siguiente manera (justo antes de su resumen): "recientemente se ha demostrado que mediante el análisis de series de tiempo en un dominio de tiempo recientemente introducido "tiempo natural", el enfoque de la crítica estado puede identificarse claramente [Sarlis et al. 2008]. De esta manera, parecen haber logrado acortar el tiempo de anticipación de la predicción de VAN a solo unos pocos días [Uyeda y Kamogawa 2008]. Esto significa que los datos sísmicos pueden desempeñar un papel sorprendente como precursores a corto plazo cuando se combinan con los datos SES.

Desde 2001, el grupo VAN ha introducido un concepto que denominan "tiempo natural", aplicado al análisis de sus precursores. Inicialmente se aplica sobre SES para distinguirlos del ruido y relacionarlos con un posible terremoto inminente. En caso de verificación (clasificación como "actividad SES"), el análisis de tiempo natural se aplica adicionalmente a la sismicidad posterior general del área asociada con la actividad SES, para mejorar el parámetro de tiempo de la predicción. El método trata el inicio de un terremoto como un fenómeno crítico. Una revisión del método VAN actualizado en 2020 dice que adolece de una gran cantidad de falsos positivos y, por lo tanto, no se puede utilizar como protocolo de predicción. El grupo VAN respondió señalando malentendidos en el razonamiento específico.

Anomalía de Corralitos

Probablemente el evento sismo-electromagnético más célebre de la historia, y uno de los ejemplos más citados de un posible precursor de un terremoto, es la anomalía de Corralitos de 1989. En el mes anterior al terremoto de Loma Prieta de 1989, las mediciones del campo magnético terrestre en frecuencias ultrabajas realizadas por un magnetómetro en Corralitos, California, a solo 7 km del epicentro del inminente terremoto, comenzaron a mostrar aumentos anómalos en amplitud. Apenas tres horas antes del terremoto, las mediciones se dispararon unas treinta veces más de lo normal, y las amplitudes disminuyeron después del terremoto. No se habían visto tales amplitudes en dos años de operación, ni en un instrumento similar ubicado a 54 km de distancia. Para muchas personas, esa aparente localidad en el tiempo y el espacio sugería una asociación con el terremoto.

Posteriormente, se desplegaron magnetómetros adicionales en el norte y el sur de California, pero después de diez años y varios grandes terremotos, no se han observado señales similares. Estudios más recientes han puesto en duda la conexión, atribuyendo las señales de Corralitos a perturbaciones magnéticas no relacionadas o, más simplemente, al mal funcionamiento del sistema de sensores.

Física de Freund

En sus investigaciones de física cristalina, Friedemann Freund descubrió que las moléculas de agua incrustadas en la roca pueden disociarse en iones si la roca está bajo un estrés intenso. Los portadores de carga resultantes pueden generar corrientes de batería bajo ciertas condiciones. Freund sugirió que quizás estas corrientes podrían ser responsables de los precursores de los terremotos, como la radiación electromagnética, las luces de los terremotos y las perturbaciones del plasma en la ionosfera. El estudio de tales corrientes e interacciones se conoce como "física de Freund".

La mayoría de los sismólogos rechazan la sugerencia de Freund de que las señales generadas por el estrés pueden detectarse y usarse como precursores, por varias razones. Primero, se cree que la tensión no se acumula rápidamente antes de un gran terremoto y, por lo tanto, no hay razón para esperar que se generen rápidamente grandes corrientes. En segundo lugar, los sismólogos han buscado extensamente precursores eléctricos estadísticamente confiables, utilizando instrumentación sofisticada, y no han identificado ninguno de esos precursores. Y en tercer lugar, el agua en la corteza terrestre haría que las corrientes generadas fueran absorbidas antes de llegar a la superficie.

Perturbación del ciclo diario de la ionosfera

La ionosfera suele desarrollar su capa D inferior durante el día, mientras que por la noche esta capa desaparece a medida que el plasma se convierte en gas. Durante la noche, la capa F de la ionosfera permanece formada, a mayor altura que la capa D. Durante la noche se forma una guía de ondas para frecuencias de radio de HF bajas de hasta 10 MHz (propagación de ondas ionosféricas) a medida que la capa F refleja estas ondas de regreso a la Tierra. La onda ionosférica se pierde durante el día, ya que la capa D absorbe estas ondas.

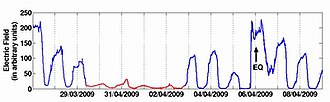

Se afirma que las tensiones tectónicas en la corteza terrestre provocan ondas de cargas eléctricas que viajan a la superficie de la Tierra y afectan la ionosfera. Los registros ULF* del ciclo diario de la ionosfera indican que el ciclo habitual podría verse alterado unos días antes de un fuerte terremoto poco profundo. Cuando se produce la perturbación, se observa que la capa D se pierde durante el día, lo que provoca la elevación de la ionosfera y la formación de ondas ionosféricas, o la capa D aparece durante la noche, lo que provoca una disminución de la ionosfera y, por tanto, la ausencia de ondas ionosféricas.

Los centros científicos han desarrollado una red de transmisores y receptores VLF a escala mundial que detectan cambios en la onda ionosférica. Cada receptor también es un transmisor de margarita para distancias de 1000 a 10 000 kilómetros y opera a diferentes frecuencias dentro de la red. El área general bajo excitación se puede determinar dependiendo de la densidad de la red. Se demostró por otro lado que eventos extremos globales como tormentas magnéticas o erupciones solares y eventos extremos locales en la misma trayectoria VLF como otro terremoto o erupción volcánica que ocurren en un tiempo cercano al terremoto bajo evaluación dificultan o imposibilitan la relación. cambios en la onda ionosférica al terremoto de interés.

En 2017, un artículo en el Journal of Geophysical Research mostró que la relación entre las anomalías ionosféricas y los grandes eventos sísmicos (M≥6.0) que ocurrieron globalmente entre 2000 y 2014 se basó en la presencia de energía solar clima. Cuando los datos solares se eliminan de la serie temporal, la correlación deja de ser estadísticamente significativa. Un artículo posterior en Physics of the Earth and Planetary Interiors en 2020 muestra que el clima solar y las perturbaciones ionosféricas son una causa potencial para desencadenar grandes terremotos según esta relación estadística. El mecanismo propuesto es la inducción electromagnética desde la ionosfera hasta la zona de falla. Los fluidos de falla son conductores y pueden producir corrientes telúricas en profundidad. El cambio resultante en el campo magnético local en la falla desencadena la disolución de minerales y debilita la roca, al tiempo que también cambia potencialmente la química y el nivel del agua subterránea. Después del evento sísmico, pueden precipitarse diferentes minerales, cambiando así la química y el nivel del agua subterránea nuevamente. Este proceso de disolución y precipitación de minerales antes y después de un terremoto se ha observado en Islandia. Este modelo da sentido a los datos ionosféricos, sísmicos y de aguas subterráneas.

Observación satelital de la declinación esperada de la temperatura del suelo

Una forma de detectar la movilidad de las tensiones tectónicas es detectar temperaturas localmente elevadas en la superficie de la corteza medidas por satélites. Durante el proceso de evaluación, se elimina el fondo de la variación diaria y el ruido debido a las perturbaciones atmosféricas y las actividades humanas antes de visualizar la concentración de tendencias en el área más amplia de una falla. Este método ha sido aplicado experimentalmente desde 1995.

En un enfoque más nuevo para explicar el fenómeno, Friedmann Freund de la NASA ha propuesto que la radiación infrarroja captada por los satélites no se debe a un aumento real de la temperatura superficial de la corteza. Según esta versión, la emisión es el resultado de la excitación cuántica que se produce en el reenlace químico de los portadores de carga positiva (agujeros) que viajan desde las capas más profundas hasta la superficie de la corteza a una velocidad de 200 metros por segundo. La carga eléctrica surge como resultado del aumento de las tensiones tectónicas a medida que se acerca el momento del terremoto. Esta emisión se extiende superficialmente hasta 500 x 500 kilómetros cuadrados para eventos muy grandes y se detiene casi inmediatamente después del terremoto.

Tendencias

En lugar de observar fenómenos anómalos que podrían ser signos precursores de un terremoto inminente, otros enfoques para predecir terremotos buscan tendencias o patrones que conducen a un terremoto. Como estas tendencias pueden ser complejas e involucrar muchas variables, a menudo se necesitan técnicas estadísticas avanzadas para comprenderlas, por lo que a veces se denominan métodos estadísticos. Estos enfoques también tienden a ser más probabilísticos y a tener períodos de tiempo más largos, por lo que se fusionan con el pronóstico de terremotos.

Predicción inmediata

El pronóstico inmediato de terremotos, sugerido en 2016, es la estimación del estado dinámico actual de un sistema sismológico, basado en el tiempo natural introducido en 2001. Se diferencia del pronóstico que tiene como objetivo estimar la probabilidad de un evento futuro, pero también se considera un base potencial para el pronóstico. Los cálculos de predicción inmediata producen la "puntuación potencial del terremoto", una estimación del nivel actual de progreso sísmico. Las aplicaciones típicas son: grandes terremotos y tsunamis globales, réplicas y sismicidad inducida, sismicidad inducida en campos de gas, riesgo sísmico para megaciudades globales, estudio de agrupamiento de grandes terremotos globales, etc.

Rebote elástico

Incluso la roca más rígida no es perfectamente rígida. Dada una gran fuerza (como entre dos inmensas placas tectónicas que se mueven una al lado de la otra), la corteza terrestre se doblará o deformará. De acuerdo con la teoría del rebote elástico de Reid (1910), eventualmente la deformación (esfuerzo) se vuelve lo suficientemente grande como para que algo se rompa, generalmente en una falla existente. El deslizamiento a lo largo de la ruptura (un terremoto) permite que la roca de cada lado rebote a un estado menos deformado. En el proceso, la energía se libera en varias formas, incluidas las ondas sísmicas. Luego se repite el ciclo de fuerza tectónica que se acumula en deformación elástica y se libera en un rebote repentino. Como el desplazamiento de un solo terremoto varía de menos de un metro a alrededor de 10 metros (para un terremoto M 8), la existencia demostrada de grandes desplazamientos de deslizamiento de cientos de millas muestra la existencia de un ciclo de terremotos de larga duración.

Terremotos característicos

Las fallas sísmicas más estudiadas (como la megacorrección de Nankai, la falla de Wasatch y la falla de San Andrés) parecen tener segmentos distintos. El modelo de sismo característico postula que los terremotos generalmente están restringidos dentro de estos segmentos. Como las longitudes y otras propiedades de los segmentos son fijas, los terremotos que rompen toda la falla deberían tener características similares. Estos incluyen la magnitud máxima (que está limitada por la longitud de la ruptura) y la cantidad de tensión acumulada necesaria para romper el segmento de falla. Dado que los movimientos continuos de las placas hacen que la deformación se acumule constantemente, la actividad sísmica en un segmento dado debe estar dominada por terremotos de características similares que se repiten a intervalos algo regulares. Para un segmento de falla dado, la identificación de estos terremotos característicos y el tiempo de su tasa de recurrencia (o, por el contrario, el período de retorno) debería informarnos sobre la próxima ruptura; este es el enfoque generalmente utilizado para pronosticar el peligro sísmico. UCERF3 es un ejemplo notable de tal pronóstico, preparado para el estado de California. Los períodos de retorno también se utilizan para pronosticar otros eventos raros, como ciclones e inundaciones, y asumen que la frecuencia futura será similar a la frecuencia observada hasta la fecha.

La idea de los terremotos característicos fue la base de la predicción de Parkfield: terremotos bastante similares en 1857, 1881, 1901, 1922, 1934 y 1966 sugirieron un patrón de rupturas cada 21,9 años, con una desviación estándar de ±3,1 años. La extrapolación del evento de 1966 condujo a una predicción de un terremoto alrededor de 1988, o antes de 1993 a más tardar (en el intervalo de confianza del 95%). El atractivo de tal método es que la predicción se deriva completamente de la tendencia, que supuestamente explica la física del terremoto desconocida y posiblemente incognoscible y los parámetros de falla. Sin embargo, en el caso de Parkfield, el terremoto previsto no se produjo hasta 2004, con una década de retraso. Esto socava seriamente la afirmación de que los terremotos en Parkfield son casi periódicos y sugiere que los eventos individuales difieren lo suficiente en otros aspectos como para cuestionar si tienen características distintas en común.

El fracaso de la predicción de Parkfield ha suscitado dudas sobre la validez del propio modelo característico del terremoto. Algunos estudios han cuestionado las diversas suposiciones, incluida la clave de que los terremotos están restringidos dentro de los segmentos, y sugirieron que los "terremotos característicos" puede ser un artefacto del sesgo de selección y la brevedad de los registros sismológicos (en relación con los ciclos de terremotos). Otros estudios han considerado si es necesario considerar otros factores, como la antigüedad de la falla. Ya sea que las rupturas sísmicas estén más restringidas dentro de un segmento (como se ve a menudo) o rompan los límites del segmento (también se ve), tiene una relación directa con el grado de peligro sísmico: los terremotos son más grandes donde se rompen varios segmentos, pero al aliviar más tensión que sucederán con menos frecuencia.

Huecos sísmicos

En el contacto donde dos placas tectónicas se deslizan entre sí, cada sección debe eventualmente deslizarse, ya que (a largo plazo) ninguna se queda atrás. Pero no todos resbalan al mismo tiempo; diferentes secciones estarán en diferentes etapas en el ciclo de acumulación de tensión (deformación) y rebote repentino. En el modelo de brecha sísmica, el "próximo gran terremoto" debe esperarse no en los segmentos donde la sismicidad reciente ha aliviado la deformación, sino en los espacios intermedios donde la deformación no aliviada es mayor. Este modelo tiene un atractivo intuitivo; se utiliza en pronósticos a largo plazo y fue la base de una serie de pronósticos circunpacíficos (la cuenca del Pacífico) en 1979 y 1989–1991.

Sin embargo, ahora se sabe que algunas suposiciones subyacentes sobre las brechas sísmicas son incorrectas. Un examen minucioso sugiere que "es posible que no haya información en las brechas sísmicas sobre el momento en que ocurrió o la magnitud del próximo gran evento en la región"; Las pruebas estadísticas de los pronósticos circunpacíficos muestran que el modelo de brecha sísmica "no pronosticó bien los grandes terremotos". Otro estudio concluyó que un largo período de calma no aumentó el potencial sísmico.

Patrones de sismicidad

Se han desarrollado varios algoritmos derivados heurísticamente para predecir terremotos. Probablemente el más conocido sea la familia de algoritmos M8 (incluido el método RTP) desarrollado bajo la dirección de Vladimir Keilis-Borok. M8 emite un "Tiempo de mayor probabilidad" (TIP) alarma para un gran terremoto de una magnitud específica al observar ciertos patrones de terremotos más pequeños. Los TIP generalmente cubren grandes áreas (hasta mil kilómetros de ancho) por hasta cinco años. Parámetros tan grandes han hecho que M8 sea controvertido, ya que es difícil determinar si los golpes que ocurrieron se predijeron hábilmente o solo fueron el resultado de la casualidad.

M8 llamó mucho la atención cuando los terremotos de San Simeón y Hokkaido de 2003 ocurrieron dentro de un PIT. En 1999, el grupo de Keilis-Borok publicó una afirmación de haber logrado resultados a medio plazo estadísticamente significativos utilizando sus modelos M8 y MSc, en lo que respecta a grandes terremotos en todo el mundo. Sin embargo, Geller et al. son escépticos de las afirmaciones de predicción sobre cualquier período inferior a 30 años. Un TIP ampliamente publicitado para un terremoto M 6.4 en el sur de California en 2004 no se cumplió, ni tampoco otros dos TIP menos conocidos. Un estudio profundo del método RTP en 2008 encontró que de una veintena de alarmas, solo dos podían considerarse aciertos (y una de ellas tenía un 60% de posibilidades de ocurrir de todos modos). Llegó a la conclusión de que "RTP no es significativamente diferente de un método ingenuo de adivinación basado en las tasas históricas [de] sismicidad".

Liberación de momento acelerado (AMR, "momento" es una medida de energía sísmica), también conocido como análisis de tiempo hasta la falla, o liberación acelerada del momento sísmico (ASMR, por sus siglas en inglés), se basa en observaciones de que la actividad previa a un gran terremoto no solo aumentó, sino que aumentó a un ritmo exponencial. En otras palabras, una gráfica del número acumulado de sismos preliminares se vuelve más empinada justo antes del sismo principal.

Después de la formulación de Bowman et al. (1998) en una hipótesis comprobable y una serie de informes positivos, AMR parecía prometedor a pesar de varios problemas. Los problemas conocidos incluían no ser detectados para todas las ubicaciones y eventos, y la dificultad de proyectar un tiempo de ocurrencia preciso cuando el final de la curva se vuelve pronunciado. Pero pruebas rigurosas han demostrado que las tendencias aparentes de AMR probablemente se deban a la forma en que se ajustan los datos y al no tener en cuenta la agrupación espaciotemporal de los terremotos. Las tendencias de AMR son, por lo tanto, estadísticamente insignificantes. El interés en AMR (a juzgar por la cantidad de artículos revisados por pares) ha disminuido desde 2004.

Aprendizaje automático

Rouet-Leduc et al. (2019) informaron haber entrenado con éxito un bosque aleatorio de regresión en datos de series temporales acústicas capaces de identificar una señal emitida desde zonas de falla que pronostica fallas por falla. Rouet-Leduc et al. (2019) sugirieron que la señal identificada, que anteriormente se suponía que era ruido estadístico, refleja la emisión creciente de energía antes de su liberación repentina durante un evento de deslizamiento. Rouet-Leduc et al. (2019) postularon además que su enfoque podría limitar los tiempos de falla de fallas y conducir a la identificación de otras señales desconocidas. Debido a la rareza de los terremotos más catastróficos, la adquisición de datos representativos sigue siendo problemática. En respuesta, Rouet-Leduc et al. (2019) han conjeturado que su modelo no necesitaría entrenarse con datos de terremotos catastróficos, ya que investigaciones posteriores han demostrado que los patrones sísmicos de interés son similares en terremotos más pequeños.

El aprendizaje profundo también se ha aplicado a la predicción de terremotos. Aunque la ley de Bath y la ley de Omori describen la magnitud de las réplicas de los terremotos y sus propiedades variables en el tiempo, la predicción de la 'distribución espacial de las réplicas' sigue siendo un problema de investigación abierto. Usando las bibliotecas de software Theano y TensorFlow, DeVries et al. (2018) entrenaron una red neuronal que logró una mayor precisión en la predicción de distribuciones espaciales de réplicas de terremotos que la metodología previamente establecida de cambio de tensión de falla de Coulomb. En particular, DeVries et al. (2018) informaron que su modelo no hizo "suposiciones sobre la orientación o la geometría del plano del receptor" y fuertemente ponderado el cambio en el esfuerzo cortante, "suma de los valores absolutos de los componentes independientes del tensor de cambio de esfuerzo," y el criterio de rendimiento de von Mises. De Vries et al. (2018) postularon que la confianza de su modelo en estas cantidades físicas indicaba que podrían "controlar la activación de terremotos durante la parte más activa del ciclo sísmico". Para las pruebas de validación, DeVries et al. (2018) reservó el 10% de muestras de datos de terremotos de entrenamiento positivo y una cantidad igual de muestras negativas elegidas al azar.

Arnaud Mignan y Marco Broccardo han analizado de manera similar la aplicación de redes neuronales artificiales a la predicción de terremotos. Descubrieron en una revisión de la literatura que la investigación de predicción de terremotos que utiliza redes neuronales artificiales ha gravitado hacia modelos más sofisticados en medio de un mayor interés en el área. También descubrieron que las redes neuronales utilizadas en la predicción de terremotos con notables tasas de éxito tenían un rendimiento igualado por modelos más simples. Además, abordaron los problemas de la adquisición de datos apropiados para entrenar redes neuronales para predecir terremotos, y escribieron que la "naturaleza estructurada y tabulada de los catálogos de terremotos" hace que los modelos transparentes de aprendizaje automático sean más deseables que las redes neuronales artificiales.

Sismicidad inducida por EMP

Los pulsos electromagnéticos de alta energía pueden inducir terremotos dentro de los 2 a 6 días posteriores a la emisión de los generadores EMP. Se ha propuesto que fuertes impactos EM podrían controlar la sismicidad, ya que la dinámica de la sismicidad que sigue parece ser mucho más regular de lo habitual.

Predicciones notables

Estas son predicciones, o afirmaciones de predicciones, que son notables científicamente o debido a la notoriedad pública, y reclaman una base científica o casi científica. Dado que muchas predicciones se mantienen de forma confidencial o se publican en lugares oscuros, y se vuelven notables solo cuando se afirman, puede haber un sesgo de selección en el sentido de que los aciertos reciben más atención que los errores. Las predicciones enumeradas aquí se analizan en el libro de Hough y en el artículo de Geller.

1975: Haicheng, China

El terremoto M 7.3 de Haicheng de 1975 es el "éxito" de predicción de terremotos. La historia ostensible es que el estudio de la actividad sísmica en la región llevó a las autoridades chinas a emitir una predicción a mediano plazo en junio de 1974 y, por lo tanto, las autoridades políticas ordenaron que se tomaran varias medidas, incluida la evacuación forzada de viviendas, la construcción de "simples estructuras al aire libre y proyección de películas al aire libre. El sismo, que se produjo a las 19:36, fue lo suficientemente potente como para destruir o dañar gravemente aproximadamente la mitad de las viviendas. Sin embargo, las "medidas preventivas efectivas tomadas" Se dijo que mantuvieron el número de muertos por debajo de 300 en un área con una población de alrededor de 1,6 millones, donde de otro modo se podrían haber esperado decenas de miles de muertes.

Sin embargo, aunque ocurrió un gran terremoto, ha habido cierto escepticismo sobre la narrativa de las medidas tomadas sobre la base de una predicción oportuna. Este evento ocurrió durante la Revolución Cultural, cuando "creer en la predicción de terremotos se convirtió en un elemento de ortodoxia ideológica que distinguía a los verdaderos defensores de los partidos de los desviacionistas de derecha". El mantenimiento de registros estaba desordenado, lo que dificultaba la verificación de los detalles, incluso si se había ordenado una evacuación. No se ha especificado el método utilizado para las predicciones a mediano o corto plazo (aparte de la 'línea revolucionaria del presidente Mao'). La evacuación pudo haber sido espontánea, tras el fuerte (M 4,7) antebrazo ocurrido el día anterior.

Un estudio de 2006 que tuvo acceso a una amplia gama de registros encontró que las predicciones eran erróneas. "En particular, no hubo una predicción oficial a corto plazo, aunque tal predicción fue hecha por científicos individuales". Además: "fueron solo los temblores preliminares los que desencadenaron las decisiones finales de advertencia y evacuación". Estimaron que se perdieron 2.041 vidas. El hecho de que no murieran más se atribuyó a una serie de circunstancias fortuitas, incluida la educación sobre terremotos en los meses anteriores (impulsada por una elevada actividad sísmica), la iniciativa local, el tiempo (que ocurrió cuando la gente no estaba trabajando ni durmiendo) y el estilo local de construcción. Los autores concluyen que, si bien no fue una predicción satisfactoria, "fue un intento de predecir un gran terremoto que, por primera vez, no resultó en un fracaso práctico".

1981: Lima, Perú (Brady)

En 1976, Brian Brady, físico, entonces en la Oficina de Minas de EE. UU., donde había estudiado cómo se fracturan las rocas, "concluyó una serie de cuatro artículos sobre la teoría de los terremotos con la deducción de que la tensión se acumula en la zona de subducción [costa afuera de Perú] podría resultar en un terremoto de gran magnitud dentro de un período de siete a catorce años a partir de mediados de noviembre de 1974." En un memorando interno escrito en junio de 1978, redujo la ventana de tiempo a 'octubre a noviembre de 1981', con un choque principal en el rango de 9,2±0,2. En un memorando de 1980, se informó que especificaba "mediados de septiembre de 1980". Esto se discutió en un seminario científico en San Juan, Argentina, en octubre de 1980, donde el colega de Brady, W. Spence, presentó un artículo. Brady y Spence luego se reunieron con funcionarios gubernamentales de los EE. UU. y Perú el 29 de octubre y "pronosticaron una serie de terremotos de gran magnitud en la segunda mitad de 1981". Esta predicción se hizo ampliamente conocida en Perú, luego de lo que la embajada de EE. UU. describió como "titulares de primera página sensacionalistas publicados en la mayoría de los diarios de Lima" el 26 de enero de 1981.

El 27 de enero de 1981, después de revisar la predicción de Brady-Spence, el Consejo Nacional de Evaluación de Predicciones de Terremotos de EE. UU. (NEPEC) anunció que "no estaba convencido de la validez científica" de la predicción, y no se había 'mostrado nada en los datos de sismicidad observados, o en la teoría en la medida en que se presentó, que brinde sustancia a los tiempos, ubicaciones y magnitudes pronosticados de los terremotos'. Continuó diciendo que si bien había una probabilidad de grandes terremotos en los momentos previstos, esa probabilidad era baja, y recomendó que "no se considere seriamente la predicción".

Sin inmutarse, Brady revisó posteriormente su pronóstico e indicó que habría al menos tres terremotos alrededor del 6 de julio, el 18 de agosto y el 24 de septiembre de 1981, lo que llevó a un funcionario del USGS a quejarse: "Si se le permite continuar para jugar este juego... eventualmente obtendrá un éxito y sus teorías serán consideradas válidas por muchos."

El 28 de junio (fecha más ampliamente tomada como la fecha del primer sismo pronosticado), se informó que: "la población limeña pasó un domingo tranquilo". El titular de un periódico peruano: "NO PASO NADA" ("No pasa nada").

En julio, Brady retiró formalmente su predicción con el argumento de que no se había producido la actividad sísmica necesaria. Las pérdidas económicas debidas a la reducción del turismo durante este episodio se han estimado aproximadamente en cien millones de dólares.

1985–1993: Parkfield, EE. UU. (Bakun-Lindh)

El "experimento de predicción de terremotos de Parkfield" fue la predicción científica de terremotos más anunciada de la historia. Se basó en una observación de que el segmento de Parkfield de la falla de San Andrés se rompe regularmente con un terremoto moderado de alrededor de M 6 cada varias décadas: 1857, 1881, 1901, 1922, 1934 y 1966. Más particularmente, Bakun & Lindh (1985) señaló que, si se excluye el sismo de 1934, estos ocurren cada 22 años, ±4.3 años. Contando desde 1966, predijeron un 95% de posibilidades de que el próximo terremoto se produjera alrededor de 1988 o 1993 a más tardar. El Consejo Nacional de Evaluación de Predicción de Terremotos (NEPEC) evaluó esto y estuvo de acuerdo. Por lo tanto, el Servicio Geológico de EE. UU. y el estado de California establecieron una de las "redes de instrumentos de monitoreo más sofisticadas y densas del mundo", en parte para identificar cualquier precursor cuando se produjo el terremoto. La confianza era lo suficientemente alta como para que se hicieran planes detallados para alertar a las autoridades de emergencia si había señales de que un terremoto era inminente. En palabras de The Economist: "nunca se ha tendido una emboscada con más cuidado para tal evento."

El año 1993 vino, y pasó, sin cumplirse. Finalmente, hubo un terremoto M 6.0 en el segmento de la falla de Parkfield, el 28 de septiembre de 2004, pero sin previo aviso ni precursores obvios. Si bien muchos científicos consideran que el experimento para detectar un terremoto fue exitoso, la predicción no tuvo éxito porque el eventual evento se retrasó una década.

1983–1995: Grecia (VAN)

En 1981, la "VAN" El grupo, encabezado por Panayiotis Varotsos, dijo que encontraron una relación entre los terremotos y las 'señales eléctricas sísmicas' (SE). En 1984 presentaron una tabla de 23 terremotos del 19 de enero de 1983 al 19 de septiembre de 1983, de los cuales afirmaron haber pronosticado con éxito 18 terremotos. Siguieron otras listas, como su afirmación de 1991 de predecir seis de siete terremotos con Ms ≥ 5,5 en el período del 1 de abril de 1987 al 10 de agosto de 1989, o cinco de siete terremotos con Ms ≥ 5,3 en el período superpuesto del 15 de mayo de 1988 al 10 de agosto de 1989, En 1996 publicaron un "Resumen de todas las Predicciones emitidas desde el 1 de enero de 1987 al 15 de junio de 1995", que asciende a a 94 predicciones. Haciendo coincidir esto con una lista de "Todos los terremotos con MS(ATH)" y dentro de los límites geográficos que incluyen la mayor parte de Grecia, elaboran una lista de 14 terremotos que deberían haber predicho. Aquí reclaman diez éxitos, para una tasa de éxito del 70%.

Las predicciones de VAN han sido criticadas por varios motivos, entre ellos, ser geofísicamente inverosímiles, "vagos y ambiguos", no cumplir con los criterios de predicción y el ajuste retroactivo de parámetros. Una revisión crítica de 14 casos en los que VAN reclamó 10 éxitos mostró solo un caso en el que ocurrió un terremoto dentro de los parámetros de predicción. Las predicciones de VAN no solo fallan en ser mejores que la casualidad, sino que muestran 'una asociación mucho mejor con los eventos que ocurrieron antes de ellas', según Mulargia y Gasperini. Otras revisiones anteriores encontraron que los resultados de VAN, cuando se evaluaron mediante parámetros definidos, fueron estadísticamente significativos. Tanto las opiniones positivas como las negativas sobre las predicciones de VAN de este período se resumieron en el libro de 1996 "A Critical Review of VAN" editado por Sir James Lighthill y en un tema de debate presentado por la revista Geophysical Research Letters que se centró en la importancia estadística del método VAN. VAN tuvo la oportunidad de responder a sus críticos en esas publicaciones de revisión. En 2011, la ICEF revisó el debate de 1996 y concluyó que la capacidad de predicción optimista de SES reclamada por VAN no podía validarse. En 2013, se encontró que las actividades de SES coincidían con los mínimos de las fluctuaciones del parámetro de orden de la sismicidad, que han demostrado ser precursores estadísticamente significativos al emplear el análisis de coincidencia de eventos.

Un problema crucial son los parámetros grandes y, a menudo, indeterminados de las predicciones, de modo que algunos críticos dicen que no son predicciones y que no deben reconocerse como tales. Gran parte de la controversia con VAN surge de esta falta de especificación adecuada de estos parámetros. Algunos de sus telegramas incluyen predicciones de dos eventos sísmicos distintos, como (típicamente) un terremoto pronosticado a 300 km "NW" de Atenas, y otra a 240 km "W", "con magnitudes [sic] 5,3 y 5,8", sin límite de tiempo. La estimación de parámetros temporales se introdujo en el Método VAN por medio del tiempo natural en 2001. VAN ha cuestionado el 'pesimista' conclusiones de sus críticos, pero los críticos no han cedido. Se sugirió que VAN no tuvo en cuenta la agrupación de terremotos, o que interpretó sus datos de manera diferente durante los períodos de mayor actividad sísmica.

VAN ha sido criticado en varias ocasiones por causar pánico público y disturbios generalizados. Esto se ha visto exacerbado por la amplitud de sus predicciones, que cubren grandes áreas de Grecia (hasta 240 kilómetros de ancho y, a menudo, pares de áreas), mucho más grandes que las áreas realmente afectadas por terremotos de las magnitudes pronosticadas (generalmente varias decenas de kilómetros). al otro lado de). Las magnitudes son igualmente amplias: una magnitud prevista de "6.0" representa un rango desde una magnitud benigna de 5.3 hasta una ampliamente destructiva de 6.7. Junto con ventanas de tiempo indeterminadas de un mes o más, tales predicciones "no se pueden utilizar en la práctica" para determinar un nivel apropiado de preparación, ya sea para restringir el funcionamiento social habitual o incluso para emitir advertencias públicas.

2008: Grecia (VAN)

Después de 2006, VAN afirma que todas las alarmas relacionadas con la actividad de SES se han hecho públicas publicándolas en arxiv.org. Dicha actividad SES se evalúa utilizando un nuevo método que ellos llaman 'tiempo natural'. Uno de esos informes se publicó el 1 de febrero de 2008, dos semanas antes del terremoto más fuerte en Grecia durante el período 1983–2011. Este sismo ocurrió el 14 de febrero de 2008, con magnitud (Mw) 6,9. El informe de VAN también se describió en un artículo del periódico Ethnos el 10 de febrero de 2008. Sin embargo, Gerassimos Papadopoulos comentó que los informes de VAN eran confusos y ambiguos, y que "ninguna de las afirmaciones de VAN exitoso las predicciones están justificadas." En el mismo número se publicó una respuesta a este comentario, que insistía en la exactitud de la predicción.

1989: Loma Prieta, Estados Unidos

El terremoto de Loma Prieta de 1989 (epicentro en las montañas de Santa Cruz al noroeste de San Juan Bautista, California) causó daños significativos en el Área de la Bahía de San Francisco en California. Según los informes, el Servicio Geológico de EE. UU. (USGS) afirmó, doce horas después del evento, que había "pronosticado" este terremoto en un informe del año anterior. Posteriormente, el personal del USGS afirmó que este terremoto había sido "anticipado"; También se han hecho varias otras afirmaciones de predicción.

Ruth Harris (Harris (1998)) revisó 18 artículos (con 26 pronósticos) que datan de 1910 "que ofrecen o se relacionan de diversas maneras con pronósticos científicos del terremoto de Loma Prieta de 1989". (En este caso, no se hace distinción entre un pronóstico, que se limita a una estimación probabilística de un terremoto que ocurrirá durante un período de tiempo, y una predicción más específica). Ninguna de estos pronósticos pueden probarse rigurosamente debido a la falta de especificidad, y cuando un pronóstico sí incluye la hora y la ubicación correctas, la ventana era tan amplia (por ejemplo, cubrió la mayor parte de California durante cinco años) que perdió cualquier valor como pronóstico. predicción. Las predicciones que se acercaron (pero con una probabilidad de solo el 30%) tenían ventanas de diez o veinte años.

Una predicción debatida provino del algoritmo M8 utilizado por Keilis-Borok y asociados en cuatro pronósticos. El primero de estos pronósticos falló tanto en magnitud (M 7.5) como en tiempo (una ventana de cinco años desde el 1 de enero de 1984 hasta el 31 de diciembre de 1988). Consiguieron la ubicación, al incluir la mayor parte de California y la mitad de Nevada. Una revisión posterior, presentada al NEPEC, extendió la ventana de tiempo hasta el 1 de julio de 1992 y redujo la ubicación solo al centro de California; la magnitud siguió siendo la misma. Una cifra que presentaron tenía dos revisiones más, para sismos M ≥ 7.0 en el centro de California. La ventana de tiempo de cinco años para uno terminó en julio de 1989, por lo que se perdió el evento de Loma Prieta; la segunda revisión se extendió hasta 1990, y así incluyó a Loma Prieta.

Al discutir el éxito o el fracaso de la predicción del terremoto de Loma Prieta, algunos científicos argumentan que no ocurrió en la falla de San Andrés (el foco de la mayoría de los pronósticos) e involucró un movimiento de deslizamiento (vertical) en lugar de movimiento de deslizamiento (horizontal), por lo que no se predijo.

Otros científicos argumentan que ocurrió en la zona de la falla de San Andrés, y liberó gran parte de la tensión acumulada desde el terremoto de San Francisco de 1906; por lo tanto, varios de los pronósticos fueron correctos. Hough afirma que "la mayoría de los sismólogos" no crea que este terremoto fue predicho "per se". En un sentido estricto, no hubo predicciones, solo pronósticos, que solo tuvieron un éxito parcial.

Iben Browning afirmó haber predicho el evento de Loma Prieta, pero (como se verá en la siguiente sección) esta afirmación ha sido rechazada.

1990: Nuevo Madrid, EE. UU. (Browning)

Iben Browning (científico con un doctorado en zoología y formación como biofísico, pero sin experiencia en geología, geofísica o sismología) era un "asesor empresarial independiente" que pronostican tendencias climáticas a largo plazo para las empresas. Apoyó la idea (no probada científicamente) de que es más probable que se desencadenen volcanes y terremotos cuando la fuerza de las mareas del sol y la luna coinciden para ejercer la máxima tensión en la corteza terrestre (syzygy). Habiendo calculado cuándo se maximizan estas fuerzas de marea, Browning luego 'proyectó' qué áreas estaban en mayor riesgo de un gran terremoto. Un área que mencionó con frecuencia fue la Zona Sísmica de Nuevo Madrid en la esquina sureste del estado de Missouri, el sitio de tres terremotos muy grandes en 1811–12, que combinó con la fecha del 3 de diciembre de 1990.

La reputación y la credibilidad percibida de Browning aumentaron cuando afirmó en varios folletos promocionales y anuncios haber predicho (entre varios otros eventos) el terremoto de Loma Prieta del 17 de octubre de 1989. El Consejo Nacional de Evaluación de Predicción de Terremotos (NEPEC) formó un Grupo de Trabajo Ad Hoc (AHWG) para evaluar la predicción de Browning. Su informe (emitido el 18 de octubre de 1990) rechazó específicamente la afirmación de una predicción exitosa del terremoto de Loma Prieta. Una transcripción de su charla en San Francisco el 10 de octubre mostró que había dicho: "Probablemente habrá varios terremotos en todo el mundo, Richter 6+, y puede haber un volcán o dos". – que, a escala global, es aproximadamente el promedio de una semana – sin mencionar ningún terremoto en California.

Aunque el informe del AHWG refutó las afirmaciones de éxito anterior de Browning y la base de su 'proyección', tuvo poco impacto después de un año de continuas afirmaciones de una predicción exitosa. La predicción de Browning recibió el apoyo del geofísico David Stewart y el respaldo tácito de muchas autoridades públicas en sus preparativos para un gran desastre, todo lo cual fue amplificado por la exposición masiva en los medios de comunicación. No pasó nada el 3 de diciembre y Browning murió de un infarto siete meses después.

2004 y amp; 2005: Sur de California, EE. UU. (Keilis-Borok)

El algoritmo M8 (desarrollado bajo la dirección de Vladimir Keilis-Borok en UCLA) ganó respeto por las predicciones aparentemente exitosas de los terremotos de San Simeón y Hokkaido de 2003. Por lo tanto, generó gran interés la predicción a principios de 2004 de un terremoto M ≥ 6.4 que ocurriría en algún lugar dentro de un área del sur de California de aproximadamente 12,000 millas cuadradas, el 5 de septiembre de 2004 o antes. Al evaluar esta predicción, el Consejo de Evaluación de Predicción de Terremotos de California (CEPEC) señaló que este método aún no había hecho suficientes predicciones para la validación estadística y era sensible a los supuestos de entrada. Por lo tanto, concluyó que ninguna "actuación especial de política pública" estaban justificados, aunque les recordó a todos los californianos "los peligros sísmicos significativos en todo el estado". El terremoto previsto no se produjo.

Se hizo una predicción muy similar para un terremoto el 14 de agosto de 2005 o antes, aproximadamente en la misma área del sur de California. La evaluación y recomendación del CEPEC fueron esencialmente las mismas, esta vez señalando que la predicción anterior y otras dos no se habían cumplido. Esta predicción también falló.

2009: L'Aquila, Italia (Giuliani)

A las 03:32 del 6 de abril de 2009, la región de Abruzzo, en el centro de Italia, fue sacudida por un terremoto de magnitud M 6,3. En la ciudad de L'Aquila y sus alrededores, alrededor de 60.000 edificios se derrumbaron o resultaron gravemente dañados, lo que provocó 308 muertos y 67.500 personas sin hogar. Casi al mismo tiempo, se informó que Giampaolo Giuliani había predicho el terremoto, había tratado de advertir al público, pero el gobierno italiano lo había amordazado.

Giampaolo Giuliani era técnico de laboratorio en el Laboratori Nazionali del Gran Sasso. Como pasatiempo, durante algunos años había estado monitoreando el radón usando instrumentos que había diseñado y construido. Antes del terremoto de L'Aquila, era un desconocido para la comunidad científica y no había publicado ningún trabajo científico. Había sido entrevistado el 24 de marzo por un blog en italiano, Donne Democratiche, sobre un enjambre de terremotos de bajo nivel en la región de Abruzzo que había comenzado el diciembre anterior. Dijo que este enjambre era normal y disminuiría a fines de marzo. El 30 de marzo, L'Aquila fue golpeada por un temblor de magnitud 4.0, el más grande hasta la fecha.

El 27 de marzo, Giuliani advirtió al alcalde de L'Aquila que podría haber un terremoto en 24 horas, y ocurrió un terremoto M~2.3. El 29 de marzo hizo una segunda predicción. Llamó por teléfono al alcalde de la ciudad de Sulmona, a unos 55 kilómetros al sureste de L'Aquila, para esperar un "dañino" – o incluso "catastrófico" – terremoto dentro de 6 a 24 horas. Se utilizaron camionetas con altavoz para advertir a los habitantes de Sulmona que evacuaran, con el consiguiente pánico. No se produjo ningún terremoto y Giuliano fue citado por incitar la alarma pública y se le prohibió hacer futuras predicciones públicas.

Después del evento de L'Aquila, Giuliani afirmó que apenas unas horas antes había encontrado aumentos alarmantes en los niveles de radón. Dijo que había advertido a familiares, amigos y colegas la noche anterior al terremoto. Posteriormente fue entrevistado por la Comisión Internacional de Previsión de Terremotos para Protección Civil, que descubrió que Giuliani no había transmitido una predicción válida del sismo principal a las autoridades civiles antes de que ocurriera.

Dificultad o imposibilidad

Como muestran los ejemplos anteriores, el historial de predicción de terremotos ha sido decepcionante. El optimismo de la década de 1970 de que la predicción rutinaria de los terremotos sería "pronto", tal vez dentro de diez años, se estaba quedando decepcionantemente corto en la década de 1990, y muchos científicos comenzaron a preguntarse por qué. En 1997 se afirmó positivamente que los terremotos no se pueden predecir, lo que condujo a un notable debate en 1999 sobre si la predicción de terremotos individuales es un objetivo científico realista.

La predicción de terremotos puede haber fallado solo porque es "diabólicamente difícil" y aún más allá de la competencia actual de la ciencia. A pesar del confiado anuncio hace cuatro décadas de que la sismología estaba "al borde" de hacer predicciones confiables, todavía puede haber una subestimación de las dificultades. Ya en 1978 se informó que la ruptura del terremoto podría complicarse por la "distribución heterogénea de las propiedades mecánicas a lo largo de la falla", y en 1986 que las irregularidades geométricas en la superficie de la falla "parecen ejercer controles importantes sobre el inicio y parada de rupturas". Otro estudio atribuyó diferencias significativas en el comportamiento de fallas a la madurez de la falla. Este tipo de complejidades no se reflejan en los métodos de predicción actuales.

La sismología aún puede carecer de una comprensión adecuada de su concepto más central, la teoría del rebote elástico. Una simulación que exploró los supuestos relacionados con la distribución del deslizamiento encontró resultados "que no concuerdan con la visión clásica de la teoría del rebote elástico". (Esto se atribuyó a detalles de heterogeneidad de fallas que no se tuvieron en cuenta en la teoría).

La predicción de terremotos puede ser intrínsecamente imposible. En 1997, se argumentó que la Tierra se encuentra en un estado de criticidad autoorganizada 'donde cualquier pequeño terremoto tiene alguna probabilidad de convertirse en un gran evento'. También se ha argumentado sobre la base de la teoría de decisiones que "la predicción de grandes terremotos es, en cualquier sentido práctico, imposible". En 2021, una multitud de autores de una variedad de universidades e institutos de investigación que estudian el satélite sismoelectromagnético de China informaron que las afirmaciones basadas en la criticidad autoorganizada que afirman que en cualquier momento cualquier pequeño terremoto puede convertirse en cascada en un gran evento, no destacan a la vista de los resultados obtenidos hasta la fecha por el análisis del tiempo natural.

Se ha discutido fuertemente que la predicción de terremotos podría ser intrínsecamente imposible, pero la mejor prueba de la imposibilidad, la predicción efectiva de terremotos, aún no se ha demostrado.

Lectura adicional

- Robbins, Stuart (1 de septiembre de 2012). "Torremotos lúdicos: ¿Causas Causa terremotos?". Exposing PseudoAstronomía Podcast. – discutir por qué la afirmación de que se pueden predecir terremotos es falsa.

- Evaluación de riesgo de terremotos a corto plazo para la falla de San Andreas en el sur de California (PDF) (Informe). U.S. Geological Survey. 1991. Open-File Report 91-32.

- Hough, Susan Elizabeth (2007). Escala de Richter: Medición de un terremoto, Medición de un hombre. Princeton University Press. ISBN 978-0-691-12807-8.

- Langer, James S. (2008). "Escala de Richter: Medición de un terremoto, Medición de un hombre Susan Elizabeth Hough Princeton U. Press, Princeton, NJ, 2007. (335 pp.). ISBN 978-0-691-12807-8". Física Hoy. 61 (1): 60–62. Código:2008PhT....61a..60H. doi:10.1063/1.2835157.

- G.-P. Ostermeyer, V.L. Popov, E. Shilko, O. Vasiljeva (2021). Multiscale Biomecánica y Tribología de Sistemas Inorgánicos y Orgánicos. En memoria del profesor Sergey Psakhie. Springer Int. Publ. doi:10.1007/978-3-030-60124-9

Contenido relacionado

Concepción, Chile

Londres, Ohio

Patógeno humano