Oblicuidad

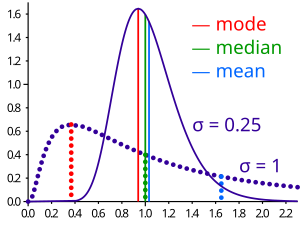

En teoría de probabilidad y estadística, sesgo es una medida de la asimetría de la distribución de probabilidad de una variable aleatoria de valor real con respecto a su media. El valor de asimetría puede ser positivo, cero, negativo o indefinido.

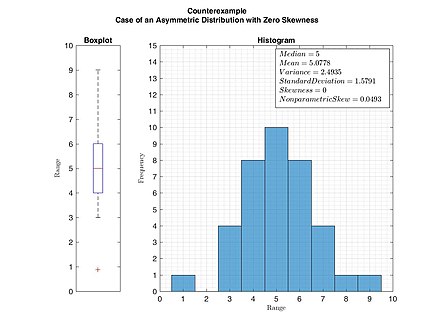

Para una distribución unimodal, el sesgo negativo comúnmente indica que la cola está en el lado izquierdo de la distribución, y el sesgo positivo indica que la cola está en el lado derecho. En los casos en que una cola es larga pero la otra cola es gorda, la asimetría no obedece a una regla simple. Por ejemplo, un valor cero significa que las colas a ambos lados de la media se equilibran en general; este es el caso de una distribución simétrica, pero también puede ser cierto para una distribución asimétrica donde una cola es larga y delgada, y la otra es corta pero gruesa.

Introducción

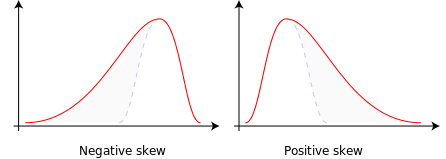

Considere las dos distribuciones en la figura justo debajo. Dentro de cada gráfico, los valores del lado derecho de la distribución se estrechan de manera diferente a los valores del lado izquierdo. Estos lados que se estrechan se denominan colas y proporcionan un medio visual para determinar cuál de los dos tipos de asimetría tiene una distribución:

- negativo: La cola izquierda es más larga; la masa de la distribución se concentra en la derecha de la figura. Se dice que la distribución es zurdo, de cola izquierda, o a la izquierda, a pesar de que la curva en sí parece ser inclinada o inclinada a la derecha; izquierda en cambio se refiere a la cola izquierda que se está dibujando y, a menudo, el medio que se está haciendo a la izquierda de un centro típico de los datos. Una distribución hecha a la izquierda generalmente aparece como derechista curva.

- positivo: La cola derecha es más larga; la masa de la distribución se concentra en la izquierda de la figura. Se dice que la distribución es derecha-skewed, derechos, o a la derecha, a pesar de que la curva en sí parece ser inclinada o inclinada a la izquierda; derecho en cambio se refiere a la cola derecha que se está dibujando y, a menudo, la media que se está haciendo a la derecha de un centro típico de los datos. Una distribución adecuada generalmente aparece como izquierda curva.

A veces se puede observar la aspereza en una serie de datos no sólo gráficamente sino mediante una simple inspección de los valores. Por ejemplo, considere la secuencia numérica (49, 50, 51), cuyos valores se distribuyen uniformemente alrededor de un valor central de 50. Podemos transformar esta secuencia en una distribución desgastada negativamente añadiendo un valor muy por debajo de la media, que es probablemente un outlier negativo, por ejemplo (40, 49, 50, 51). Por lo tanto, la media de la secuencia se convierte en 47.5, y la mediana es 49.5. Basado en la fórmula de la mandíbula no paramétrica, definida como ()μ μ − − .. )/σ σ ,{displaystyle (mu -nu)/sigma} el puño es negativo. Del mismo modo, podemos hacer la secuencia positivamente marcada añadiendo un valor muy por encima de la media, que es probablemente un outlier positivo, por ejemplo (49, 50, 51, 60), donde la media es 52.5, y la mediana es 50.5.

Como se mencionó anteriormente, una distribución unimodal con valor cero de asimetría no implica que esta distribución sea necesariamente simétrica. Sin embargo, una distribución unimodal o multimodal simétrica siempre tiene una asimetría cero.

Relación de media y mediana

La asimetría no está directamente relacionada con la relación entre la media y la mediana: una distribución con asimetría negativa puede tener su media mayor o menor que la mediana, y lo mismo para asimetría positiva.

En la noción más antigua de costra no paramétrica, definida como ()μ μ − − .. )/σ σ ,{displaystyle (mu -nu)/sigma} Donde μ μ {displaystyle mu } es el medio, .. {displaystyle nu } es la mediana, y σ σ {displaystyle sigma } es la desviación estándar, la aspereza se define en términos de esta relación: el flujo no paramétrico positivo/derecho significa que la media es mayor que (a la derecha de) la mediana, mientras que el flujo no paramétrico negativo/izquierda significa que la media es menos que (a la izquierda de) la mediana. Sin embargo, la definición moderna de la cerviz y la definición tradicional no paramétrica no siempre tienen el mismo signo: mientras que están de acuerdo para algunas familias de distribuciones, difieren en algunos de los casos, y conflarlas es engañosa.

Si la distribución es simétrica, entonces la media es igual a la mediana y la distribución tiene una asimetría cero. Si la distribución es tanto simétrica como unimodal, entonces la media = mediana = moda. Este es el caso de un lanzamiento de moneda o la serie 1,2,3,4,... Tenga en cuenta, sin embargo, que lo contrario no es cierto en general, es decir, la asimetría cero (definida a continuación) no implica que la media sea igual a la mediana.

Un artículo de revista de 2005 señala:

Muchos libros de texto enseñan una regla del pulgar declarando que la media es derecha de la mediana bajo el juguetón derecho, y la izquierda de la mediana bajo el muslo izquierdo. Esta regla falla con sorprendente frecuencia. Puede fallar en distribuciones multimodales, o en distribuciones donde una cola es larga pero la otra es pesada. Lo más común, sin embargo, la regla falla en distribuciones discretas donde las áreas a la izquierda y derecha del medio no son iguales. Tales distribuciones no sólo contradicen la relación de los libros de texto entre media, mediana y picada, sino que también contradicen la interpretación de los libros de texto de la mediana.

Por ejemplo, en la distribución de residentes adultos en los hogares de EE. UU., el sesgo es hacia la derecha. Sin embargo, dado que la mayoría de los casos es menor o igual que la moda, que también es la mediana, la media se encuentra en la cola izquierda más pesada. Como resultado, falló la regla general de que la media está a la derecha de la mediana bajo el sesgo a la derecha.

Definición

Coeficiente de asimetría del momento de Fisher

El aguijón de una variable aleatoria X es el tercer momento estandarizado μ μ ~ ~ 3{displaystyle {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\\fnMicrosoft {\\\fnMicrosoft {\\\\\\\\\\\fnMicrosoft {\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\ }, definido como:

- μ μ ~ ~ 3=E [()X− − μ μ σ σ )3]=μ μ 3σ σ 3=E [()X− − μ μ )3]()E [()X− − μ μ )2])3/2=κ κ 3κ κ 23/2{displaystyle {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\fnMicrosoft {\fnMicrosoft {\\fnMicrosoft {\fnMicrosoft {\\\\fnMicrosoft {\\\\\\\\\\\\\\\\\\fn\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\ ################################################################################################################################################################################################################################################################ {E} left[left({frac {X-mu }{sigma }right)^{3}right]={ frac {mu {fnMicrosoft Sans Serif} {fnMicroc {fnK}left[(X-mu)^{3}right]}{operatorname {E} left[(X-mu)}{3/2}}}}}={kappa {kappa} {kappa ¿Qué? ¿Qué?

donde μ es la media, σ es la desviación estándar, E es el operador de expectativa, μ3 es el tercer momento central, y κt son los t-ésimos cumulantes. A veces se lo denomina coeficiente de asimetría del momento de Pearson, o simplemente coeficiente de asimetría del momento, pero no debe confundirse con los otros coeficientes de asimetría de Pearson. estadísticas de asimetría (ver más abajo). La última igualdad expresa la asimetría en términos de la relación del tercer cumulante κ3 a la potencia 1,5 del segundo cumulante κ 2. Esto es análogo a la definición de curtosis como el cuarto cumulante normalizado por el cuadrado del segundo cumulante. La asimetría también se denota a veces Skew[X].

Si σ es finito, μ también lo es y la asimetría se puede expresar en términos del momento no central E[X3] expandiendo la fórmula anterior,

- μ μ ~ ~ 3=E [()X− − μ μ σ σ )3]=E [X3]− − 3μ μ E [X2]+3μ μ 2E [X]− − μ μ 3σ σ 3=E [X3]− − 3μ μ ()E [X2]− − μ μ E [X])− − μ μ 3σ σ 3=E [X3]− − 3μ μ σ σ 2− − μ μ 3σ σ 3.{displaystyle {begin{aligned}{tilde {mu} ################################################################################################################################################################################################################################################################ {E} left[left({frac {X-mu}{sigma ¿Qué? {E} [X^{3}]-3mu operatorname [E] [X^{2]]+3mu ^{2} nombre del operador {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {f} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft} {fnMicrosoft} {fnMicrosoft} {fnMicrosoft} {f}}}}f}f} {fnMicros}}f}f}f}fnMinMinMinMinMinMinMicros}fnMinMinMinMinMinMinMinMinMinMinMinun}fnMinMinun}fnMinMinun} {fnun}fnun} {fnMinun}fnun}fnMinun}fnun}fnMinun}fnMinMinMinMinun}f} {fnMin

Ejemplos

La asimetría puede ser infinita, como cuando

- xright]=x^{-2}{mbox{ for }}x>1, Pr[XPr[X■x]=x− − 2parax■1,Pr[X.1]=0{displaystyle Pr left[X confianzaxright]=x^{-2}{mbox{ for }x título1, Pr[Xse]=0}

x right]=x^{-2}mbox{ for }x>1, Pr[X

donde los terceros cumulantes son infinitos, o como cuando

- <math alttext="{displaystyle Pr[Xx]=(1+x)^{-3}/2{mbox{ for positive }}x.}" xmlns="http://www.w3.org/1998/Math/MathML">Pr[X.x]=()1− − x)− − 3/2para negativoxyPr[X■x]=()1+x)− − 3/2positivax.{displaystyle Pr[X]=(1-x)^{-3}/2{mbox{ for negative }}x{mbox{ and }}Pr[X]=(1+x)^{-3}/2{mbox{ for positive }x}<img alt="Pr[Xx]=(1+x)^{-3}/2{mbox{ for positive }}x." aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/4c82a811b61702e6fdfff80fa0aa14a86a6e2f16" style="vertical-align: -0.838ex; width:84.137ex; height:3.176ex;"/>

donde el tercer cumulante no está definido.

Los siguientes son ejemplos de distribuciones con asimetría finita.

- Una distribución normal y cualquier otra distribución simétrica con un tercer momento finito tiene una costura de 0

- Una distribución medio-normal tiene un aguijón justo debajo de 1

- Una distribución exponencial tiene una muesca de 2

- Una distribución lognormal puede tener una aspersión de cualquier valor positivo, dependiendo de sus parámetros

Sesgo de la muestra

Para una muestra de n valores, dos estimadores naturales de la asimetría de la población son

- b1=m3s3=1n.. i=1n()xi− − x̄ ̄ )3[1n− − 1.. i=1n()xi− − x̄ ̄ )2]3/2{displaystyle B_{1}={frac {fn} {fn} {fn}} {fn}} {fn}} {fn}} {fn}}} {fn}}} {fn}} {fn}}}}} {fn}}} {fn} {fn}}}}} {fn} {fn}}}}}} {f}}}}}}}} {f}}}}}}}}}}}}}} {f}}} {f} {f} {f} {f}} {fn}}}}}}}}}}}}}}}}} {f}}} {f}} {fn}} {fn}} {f}}}}}} {fn}}}}f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} ¿Por qué? {1}{n-1}sum ¿Por qué? ♪♪

y

- g1=m3m23/2=1n.. i=1n()xi− − x̄ ̄ )3[1n.. i=1n()xi− − x̄ ̄ )2]3/2,{displaystyle G_{1}={frac {fn} {fn} {fn}} {fn} {fn}} {fn}} {fn}}} {fn}}} {fn}}} {fn}}} {fn}}}}}} {fn}} {f}}}}}} {fn}}}}}}}}}}} {f}}}}}}}}}}}}} {f} {f}}}} {f}}} {f}}}}}}} {f} {f}}}}}}}}}}}}}}}}}}}} {f}}} {f} {f} {f} {f}}}}}}}}}} {f}}}}}}}}}}}}}}}}}} {f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} ¿Por qué? ¿Por qué? ♪♪

Donde x̄ ̄ {displaystyle {overline {x}}} es la muestra media, s es la desviación estándar de la muestra, m2 es la muestra segundo momento central, y m3 es el tercer momento central de la muestra. g1{displaystyle G_{1} es un método de cálculo de momentos.

Otra definición común de sesgo de muestra es

- G1=k3k23/2=n2()n− − 1)()n− − 2)b1=n()n− − 1)n− − 2g1,{displaystyle {begin{aligned}G_{1} {k_{3} {k_{2} {3/2}}={frac} {f}} {f}} {f}}} {f}}} {f}} {f}}}} {f}}}} {f}}}} {f}}} {f}}}}} {f}}}}}}}}}}}} {f} {f}}} {f}}}}}} {f}}}}} {f}}}} {f}}}}} {f}}} {f}}}}} {f} {f}}}} {f} {f}}} {f} {f} {f}}}}}}}}}}}}}} {f}}}}}}}}}} {f} {f} {f}}}}}}}}}}} {f}}} {f} {f}}}}}} {n^{2}{(n-1)(n-2)};b_{1}={frac {sqrt {n(n-1)}{n-2};g_{1},\end{aligned}}}

Donde k3{displaystyle K_{3} es el estimador simétrico único e imparcial del tercer acumulativo y k2=s2{displaystyle K_{2}=s^{2} es el estimador simétrico sin prejuicios del segundo acumulativo (es decir, la variación de la muestra). Coeficiente de momento estandarizado Fisher-Pearson G1{displaystyle G_{1} es la versión encontrada en Excel y varios paquetes estadísticos incluyendo Minitab, SAS y SPSS.

Bajo la suposición de que la variable aleatoria subyacente X{displaystyle X} se distribuye normalmente, se puede demostrar que las tres ratios b1{displaystyle B_{1}, g1{displaystyle G_{1} y G1{displaystyle G_{1} son los estimadores imparciales y coherentes de la población γ γ 1=0{displaystyle gamma _{1}=0}, con nb1→dN()0,6){fnMicrosoft} {fnK} {fnK}} {fnMicrosoft}}} {fn0}}, es decir, sus distribuciones convergen a una distribución normal con media 0 y varianza 6 (Fisher, 1930). Por lo tanto, la varianza de la muestra es aproximadamente 6/n{displaystyle 6/n} para muestras suficientemente grandes. Más precisamente, en una muestra aleatoria de tamaño n de una distribución normal,

- Var ()G1)=6n()n− − 1)()n− − 2)()n+1)()n+3).{displaystyle operatorname {var} (G_{1})={frac {6n(n-1)}{(n-2)(n+1)(n+3)}}}

En muestras normales, b1{displaystyle B_{1} tiene la menor varianza de los tres estimadores, con

- <math alttext="{displaystyle operatorname {var} (b_{1})<operatorname {var} (g_{1})Var ()b1).Var ()g1).Var ()G1).{displaystyle operatorname {var} (b_{1}) correspondióoperatorname {var} (g_{1}) seleccionóoperatorname {var} (G_{1}). }<img alt="{displaystyle operatorname {var} (b_{1})<operatorname {var} (g_{1})

Para las distribuciones no normales, b1{displaystyle B_{1}, g1{displaystyle G_{1} y G1{displaystyle G_{1} son generalmente estimadores parciales de la población γ γ 1{displaystyle gamma _{1}; sus valores esperados pueden incluso tener el signo opuesto de la verdadera cerviz. Por ejemplo, una distribución mixta que consiste en gaussianos muy delgados centrados en −99, 0.5 y 2 con pesos 0.01, 0.66, y 0.33 tiene una costura γ γ 1{displaystyle gamma _{1} de aproximadamente −9.77, pero en una muestra de 3 G1{displaystyle G_{1} tiene un valor esperado de alrededor de 0.32, ya que por lo general las tres muestras están en la parte valorada positiva de la distribución, que se hace de otra manera.

Aplicaciones

La asimetría es una estadística descriptiva que se puede utilizar junto con el histograma y el gráfico de cuantiles normales para caracterizar los datos o la distribución.

La asimetría indica la dirección y la magnitud relativa de la desviación de una distribución con respecto a la distribución normal.

Con una asimetría pronunciada, los procedimientos de inferencia estadística estándar, como un intervalo de confianza para una media, no solo serán incorrectos, en el sentido de que el verdadero nivel de cobertura diferirá del nivel nominal (por ejemplo, 95 %), sino que también resultar en probabilidades de error desiguales en cada lado.

La asimetría se puede utilizar para obtener probabilidades aproximadas y cuantiles de distribuciones (como el valor en riesgo en finanzas) a través de la expansión de Cornish-Fisher.

Muchos modelos asumen una distribución normal; es decir, los datos son simétricos con respecto a la media. La distribución normal tiene una asimetría de cero. Pero en realidad, los puntos de datos pueden no ser perfectamente simétricos. Entonces, una comprensión de la asimetría del conjunto de datos indica si las desviaciones de la media serán positivas o negativas.

La prueba de K-cuadrado de Agostino es una prueba de normalidad de bondad de ajuste basada en la asimetría y la curtosis de la muestra.

Otras medidas de asimetría

Se han utilizado otras medidas de asimetría, incluidos cálculos más sencillos sugeridos por Karl Pearson (que no debe confundirse con el coeficiente de asimetría del momento de Pearson, véase más arriba). Estas otras medidas son:

Primer coeficiente de asimetría de Pearson (asimetría modal)

La asimetría del modo de Pearson, o primer coeficiente de asimetría, se define como

- media - modo/Desviación estándar.

Segundo coeficiente de asimetría de Pearson (asimetría mediana)

La asimetría mediana de Pearson, o segundo coeficiente de asimetría, se define como

- 3 (medio)/Desviación estándar.

Que es un simple múltiplo del sesgo no paramétrico.

Vale la pena notar que, dado que la asimetría no está relacionada con una relación de orden entre la moda, la media y la mediana, el signo de estos coeficientes no proporciona información sobre el tipo de asimetría (izquierda/derecha).

Medidas basadas en cuantiles

La medida de sesgo de Bowley (desde 1901), también llamada coeficiente de Yule (desde 1912) se define como:

- Q()3/4)+Q()1/4)2− − Q()1/2)Q()3/4)− − Q()1/4)2=Q()3/4)+Q()1/4)− − 2Q()1/2)Q()3/4)− − Q()1/4),{fnMicroc {fnMicroc} {{{Q}(3/4)}+{Q}(1/4)}} {2}-{Q} {fnMicroc}}{frac} {fnMicroc}} {fnMicroc}}} {fnMicroc}}}}} {fnMicroc}}}}} {fnMicroc}} {f}}}}}} {f}}}}} {f}}}}}} {f} {f} {f}} {f} {f}}}} {f} {f} {f}}}}}}}} {f}}}}} {f}}} {f} {f} {f} {f}}}}}} {f}}}}}}}}} {f} {f}} {f}}}}} {f}}}}}}}}}}}}}}}}}} {f}}}}}}} {{{Q}(3/4)}-{Q} {2}}={frac} {fnMic} {fnK}}}} {fnK}}}} {fnK}}}} {fnK}}}}} {f}} {fnK}}} {fnK}} {f}}} {f}}}}}} {f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {\\\\\\\\f} {f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {\\\\\\\\f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {\ {{{Q}(3/4)}+{Q}(1/4)}-2{Q} {{Q} {{Q}(3/4)}-{Q}(1/4)}}}}}}

Donde Q es la función cuntil (es decir, la inversa de la función de distribución acumulativa). El numerador es la diferencia entre el promedio de los cuartiles superiores e inferiores (una medida de ubicación) y la mediana (otra medida de ubicación), mientras que el denominador es el rango semi-intercuartil ()Q()3/4)− − Q()1/4))/2{displaystyle ({Q}(3/4)}-{Q}(1/4)/2}, que para las distribuciones simétricas es la medida MAD de dispersión.

Otros nombres para esta medida son la medida de asimetría de Galton, el índice de Yule-Kendall y la asimetría del cuartil,

Del mismo modo, la medida de asimetría de Kelly se define como

- Q()9/10)+Q()1/10)− − 2Q()1/2)Q()9/10)− − Q()1/10).{fnMicroc} {{Q}(9/10)}+{Q}(1/10)}-2{Q}{Q}{Q}(9/10)}-{Q}(1/10)}}}}}}} {{Q}}}} {{Q}}} {{Q}}}}} {{Q}}}}}} {{Q}}}} {{Q} {{Q} {}}}}}}}}}}}}}}}}}}}}}}}}}} {}}}}}}}}}}} {{}}}} {} {} {}} {} {} {}}}}}}}}}} {}}}}}}}}} {}}}}} {{{} {}} {}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {}}}}}}}}}}}}}}}}}}}}}}} {}}}}}}}}}}}}}}}}

Groeneveld, R. A. y Meeden, G. (1984) describieron una formulación más general de una función de asimetría:

- γ γ ()u)=Q()u)+Q()1− − u)− − 2Q()1/2)Q()u)− − Q()1− − u){displaystyle gamma (u)={frac {Q(u)+Q(1-u)-2Q(1/2)}{Q(u)-Q(1-u)}}}

La función γ(u) satisface −1 ≤ γ(u) ≤ 1 y está bien definida sin requerir la existencia de ningún momento de la distribución. La medida de asimetría de Bowley es γ(u) evaluada en u = 3/4, mientras que la medida de asimetría de Kelly es γ(u ) evaluado en u = 9/10. Esta definición conduce a una medida general correspondiente de asimetría definida como el supremo de esta sobre el rango 1/2 ≤ u < 1. Se puede obtener otra medida integrando el numerador y el denominador de esta expresión.

A primera vista, las medidas de asimetría basadas en cuantiles son fáciles de interpretar, pero a menudo muestran variaciones de muestra significativamente mayores que los métodos basados en momentos. Esto significa que, a menudo, las muestras de una distribución simétrica (como la distribución uniforme) tienen una gran asimetría basada en cuantiles, simplemente por casualidad.

Coeficiente de Groeneveld y Meeden

Groeneveld y Meeden han sugerido, como una medida alternativa de asimetría,

- skew()X)=()μ μ − − .. )E()SilencioX− − .. Silencio),{displaystyle mathrm {skew} (X)={frac {mu -nu)}{E(Principio X-nu Silencio)}}}}}

donde μ es la media, ν es la mediana, |...| es el valor absoluto y E() es el operador de expectativa. Esto está estrechamente relacionado en forma con el segundo coeficiente de asimetría de Pearson.

Momentos L

El uso de momentos L en lugar de momentos proporciona una medida de asimetría conocida como asimetría L.

Sesgo de distancia

Un valor de esqueje igual a cero no implica que la distribución de probabilidad sea simétrica. Por lo tanto, es necesario adoptar otra medida de asimetría que tenga esta propiedad: dicha medida fue introducida en 2000. Se llama distancia y denotado por DSkew. Si X es una variable aleatoria que toma valores en d-dimensional Espacio euclidiano, X tiene una expectativa finita, X' es una copia independiente de distribución idéntica X, y .. ⋅ ⋅ .. {displaystylefncdotfn} denota la norma en el espacio Euclideano, entonces un simple medida de asimetría con respecto al parámetro de ubicación θ es

- DSkew ()X):=1− − E .. X− − X... E .. X+X.− − 2Silencio Silencio .. siPr()X=Silencio Silencio )ل ل 1{displaystyle operatorname {dSkew} (X):=1-{frac { {E}fnMi-X'fn}{fncipiente {E}fnX+X'-2theta {fnMicrosoft Sans Serif}}pr(X=theta)neq 1}

y dSkew(X) 0 para X= θ (con probabilidad 1). La distancia es siempre entre 0 y 1, igual a 0 si y sólo si X es diagonal simétrico con respecto a θ (X y 2/X tienen la misma distribución de probabilidad) y es igual a 1 si y sólo si X es una constante c ()cل ل Silencio Silencio {displaystyle cneq theta }) con probabilidad uno. Por lo tanto hay una prueba estadística consistente simple de la simetría diagonal basada en la muestreo distancia:

- DSkewn ()X):=1− − .. i,j.. xi− − xj.. .. i,j.. xi+xj− − 2Silencio Silencio .. .{displaystyle operatorname {dSkew} _{n}(X):=1-{frac {sum ¿Por qué? ################################################################################################################################################################################################################################################################ {fnMicrosoft Sans Serif}

Medpareja

La pareja media es una medida robusta de asimetría que no varía de escala, con un punto de ruptura del 25 %. Es la mediana de los valores de la función kernel.

- h()xi,xj)=()xi− − xm)− − ()xm− − xj)xi− − xj{displaystyle h(x_{i},x_{j})={frac {(x_{i}-x_{m})-(x_{m}-x_{j}}{x_{i}-x_{j}}}}}

todas las parejas ()xi,xj){displaystyle (x_{i},x_{j}} tales que xi≥ ≥ xm≥ ≥ xj{displaystyle x_{i}gq x_{m}gq x_{j}}, donde xm{displaystyle x_{m} es la mediana de la muestra {}x1,x2,...... ,xn}{displaystyle {x_{1},x_{2},ldotsx_{n}}. Se puede ver como la mediana de todas las posibles medidas de asiduidad cuantitativa.

Contenido relacionado

Christian Goldbach

Anillo de división

Euclides

![{displaystyle {tilde {mu }}_{3}=operatorname {E} left[left({frac {X-mu }{sigma }}right)^{3}right]={frac {mu _{3}}{sigma ^{3}}}={frac {operatorname {E} left[(X-mu)^{3}right]}{(operatorname {E} left[(X-mu)^{2}right])^{3/2}}}={frac {kappa _{3}}{kappa _{2}^{3/2}}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/30324ac725e96b88638a0fc86f201b174082cbc7)

![{displaystyle {begin{aligned}{tilde {mu }}_{3}&=operatorname {E} left[left({frac {X-mu }{sigma }}right)^{3}right]\&={frac {operatorname {E} [X^{3}]-3mu operatorname {E} [X^{2}]+3mu ^{2}operatorname {E} [X]-mu ^{3}}{sigma ^{3}}}\&={frac {operatorname {E} [X^{3}]-3mu (operatorname {E} [X^{2}]-mu operatorname {E} [X])-mu ^{3}}{sigma ^{3}}}\&={frac {operatorname {E} [X^{3}]-3mu sigma ^{2}-mu ^{3}}{sigma ^{3}}}.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/77a8f1e4f233c410e85698ca11d163f6f81c5e5f)

![{displaystyle b_{1}={frac {m_{3}}{s^{3}}}={frac {{tfrac {1}{n}}sum _{i=1}^{n}(x_{i}-{overline {x}})^{3}}{left[{tfrac {1}{n-1}}sum _{i=1}^{n}(x_{i}-{overline {x}})^{2}right]^{3/2}}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/622780d6e0eb8322149ef5e232e5c8a6ce523e33)

![{displaystyle g_{1}={frac {m_{3}}{m_{2}^{3/2}}}={frac {{tfrac {1}{n}}sum _{i=1}^{n}(x_{i}-{overline {x}})^{3}}{left[{tfrac {1}{n}}sum _{i=1}^{n}(x_{i}-{overline {x}})^{2}right]^{3/2}}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b632e0d32061f78e178eb9a1c6e22da4324e817c)