Multiplicador de Lagrange

En optimización matemática, el método de los multiplicadores de Lagrange es una estrategia para encontrar los máximos y mínimos locales de una función sujeta a restricciones de igualdad (es decir, sujeta a la condición de que una o más ecuaciones deben cumplirse exactamente por los valores elegidos de las variables). Lleva el nombre del matemático Joseph-Louis Lagrange. La idea básica es convertir un problema restringido en una forma tal que aún se pueda aplicar la prueba derivada de un problema no restringido. La relación entre el gradiente de la función y los gradientes de las restricciones conduce de manera bastante natural a una reformulación del problema original, conocida como función lagrangiana.

El método puede resumirse como sigue: Para encontrar el máximo o mínimo de una función f()x){displaystyle f(x) } sujetos a la limitación de la igualdad g()x)=0,{displaystyle g(x)=0} forma la función Lagrangian,

- L()x,λ λ )↑ ↑ f()x)+λ λ ⋅ ⋅ g()x),{displaystyle {mathcal {L}(x,lambda)equiv f(x)+lambda cdot g(x)}

y encontrar los puntos estacionarios de L{displaystyle {fnMitcal {fn}}} considerada como una función x{displaystyle x } y el multiplicador Lagrange λ λ .{displaystyle lambda ~.} Esto significa que todos los derivados parciales deben ser cero, incluyendo el derivado parcial con respecto a λ λ .{displaystyle lambda ~.}

- ∂ ∂ L∂ ∂ x=0{displaystyle {frac {\fnMitcal {f}\\fn}}=0qquad} y ∂ ∂ L∂ ∂ λ λ =0;{displaystyle qquad {frac {partial {mátcal {L}\s}{partial lambda }=0;

o equivalente

- ∂ ∂ f()x)∂ ∂ x+λ λ ⋅ ⋅ ∂ ∂ g()x)∂ ∂ x=0{displaystyle {frac {\fnMicrosoft Sans Serif}{partial x}}+lambda cdot {frac {\\\\partial g(x) } {partial x}=0qquad } y g()x)=0.{displaystyle qquad g(x)=0~.}

La solución correspondiente a la optimización restringida original es siempre un punto silla de la función Lagrangiana, que se puede identificar entre los puntos estacionarios a partir de la definición de la matriz hessiana bordeada.

La gran ventaja de este método es que permite que la optimización se resuelva sin parametrización explícita en términos de las limitaciones. Como resultado, el método de multiplicadores Lagrange es ampliamente utilizado para resolver problemas de optimización limitados desafiantes. Además, el método de multiplicadores Lagrange se generaliza por las condiciones Karush-Kuhn-Tucker, que también pueden tener en cuenta las limitaciones de desigualdad de la forma h()x)≤ ≤ c{displaystyle h(mathbf {x})leq c } para una constante dada c.{displaystyle c~}

Declaración

Lo siguiente se conoce como el teorema del multiplicador de Lagrange.

Vamos f:: Rn→ → R{displaystyle fcolon mathbb {R} {R} {R} {R} {R} {R}} {R}} {R} {R}} {R} {R}}} {R}}} ser la función objetiva, g:: Rn→ → Rc{displaystyle gcolon mathbb {R} {fn}fn}m} {fn} {fn} {fn} {fn} {fn} {fn}fn}fn}fn} {fn}}\fn}\\fn}\fn}\fn}\\fn}}\\\\\fn}}\\\\\\\\\\\\\\\\\\\c}\\c}\\c}}}}}}}}\\\\\c}}}\\\\\\\c}c}c}c}c}c}c}c}c}}c}c}c}c}}c}c}c}c}c}c} ser la función de limitaciones, ambas pertenecientes a C1{displaystyle C^{1} (es decir, teniendo los primeros derivados continuos). Vamos x⋆ ⋆ {displaystyle x_{star } ser una solución óptima para el siguiente problema de optimización tal que <math alttext="{displaystyle operatorname {rank} (operatorname {D} g(x_{star }))=crango ()D g()x⋆ ⋆ ))=c.n{displaystyle \operatorname {rank} (operatorname {D} g(x_{star })=c won }<img alt="{displaystyle operatorname {rank} (operatorname {D} g(x_{star }))=c (Aquí) D g()x⋆ ⋆ ){displaystyle \operatorname {D} g(x_{star } denota la matriz de derivados parciales, [D g()x⋆ ⋆ )]j,k=[∂ ∂ gj∂ ∂ xk]{displaystyle {Bigl [}operatorname {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicroc {\fnMicrosoft Sans Serif}}} {fnMicrosoft Sans Serif}}fnMicrosoft ]} {f} {fnMicrosoft ]} {\fnMicrosoft ]} {f}f}f} {f}f}f}f}f} {f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}fnKf}f}f}f}f}f}f}f}f}fnKfnKfnKf}fnKf}f}f}f}}fn):

- maximizarf()x){displaystyle {text{maximize} f(x)}

- sujeto a:g()x)=0{displaystyle {text{subject to:} g(x)=0}

Entonces existe un multiplicador Lagrange único λ λ ⋆ ⋆ ▪ ▪ Rc{displaystyle lambda _{star }in mathbb. tales que D f()x⋆ ⋆ )=λ λ ⋆ ⋆ TD g()x⋆ ⋆ ).{displaystyle 'operatorname {D} f(x_{star }=lambda _{star ################################################################################################################################################################################################################################################################ {D} g(x_{star }~.}

El teorema del multiplicador de Lagrange establece que en cualquier máximo (o mínimo) local de la función evaluada bajo las restricciones de igualdad, si se aplica la calificación de la restricción (se explica a continuación), entonces el gradiente de la función (en ese punto) se puede expresar como una combinación lineal de los gradientes de las restricciones (en ese punto), con los multiplicadores de Lagrange actuando como coeficientes. Esto equivale a decir que cualquier dirección perpendicular a todos los gradientes de las restricciones también es perpendicular al gradiente de la función. O aún, decir que la derivada direccional de la función es 0 en todas las direcciones factibles.

Restricción única

Para el caso de una sola restricción y solo dos variables de elección (como se ejemplifica en la Figura 1), considere el problema de optimización

- maximizarf()x,Sí.){displaystyle {text{maximize} f(x,y)}

- sujeto a:g()x,Sí.)=0{displaystyle {text{subject to:} g(x,y)=0}

(A veces una constante aditiva se muestra por separado en lugar de ser incluido en g{displaystyle g}, en cuyo caso se escribe la restricción g()x,Sí.)=c,{displaystyle g(x,y)=c} como en la figura 1.) Asumimos que ambos f{displaystylef} y g{displaystyle g} tienen derivados parciales continuos. Presentamos una nueva variable (λ λ {displaystyle lambda }Se llama Multiplicador Lagrange (o Multiplicador indeterminado) y estudiar el Función de separación (o Lagrangian o Lagrangian expression) definido por

- L()x,Sí.,λ λ )=f()x,Sí.)+λ λ ⋅ ⋅ g()x,Sí.),{displaystyle {mathcal {L}(x,y,lambda)=f(x,y)+lambda cdot g(x,y),}

Donde λ λ {displaystyle lambda } el término puede ser añadido o restado. Si f()x0,Sí.0){displaystyle f(x_{0},y_{0} es un máximo f()x,Sí.){displaystyle f(x,y)} para el problema inicial y Silencio Silencio g()x0,Sí.0)ل ل 0,{displaystyle nabla g(x_{0},y_{0})neq 0} entonces existe λ λ 0{displaystyle 'lambda ¿Qué? tal que (x0,Sí.0,λ λ 0{displaystyle x_{0},y_{0},lambda ¿Qué?) es un Punto fijo para la función Lagrange (puntos estecionarios son aquellos puntos donde los primeros derivados parciales de L{displaystyle {fnMitcal {fn}}} son cero). Suposición Silencio Silencio gل ل 0{displaystyle \nabla gneq 0 se llama calificación restrictiva. Sin embargo, no todos los puntos estacionarios producen una solución del problema original, ya que el método de multiplicadores Lagrange produce sólo una condición necesaria para la óptimaidad en problemas limitados. Existen condiciones suficientes para un mínimo o máximo, pero si una solución de candidato en particular satisface las condiciones suficientes, sólo se garantiza que esa solución sea la mejor. localmente – es decir, es mejor que cualquier punto cercano admisible. El mundial óptimo se puede encontrar comparando los valores de la función objetiva original en los puntos que satisfacen las condiciones necesarias y locales suficientes.

El método de los multiplicadores de Lagrange se basa en la intuición de que, como máximo, f(x, y) no puede aumentar en la dirección de ningún punto vecino que también tenga g = 0. Si lo fuera, podríamos caminar a lo largo de g = 0 para llegar más alto, lo que significa que el punto de partida no era en realidad el máximo. Visto de esta manera, es un análogo exacto a probar si la derivada de una función sin restricciones es 0, es decir, estamos verificando que la derivada direccional es 0 en cualquier (dirección viable).

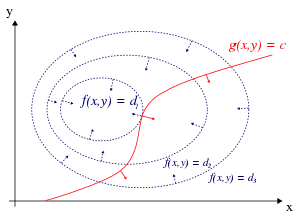

Podemos visualizar contornos de f dados por f (x, y) = d para varios valores de d, y el contorno de g dado por g(x, y) = c.

Supongamos que caminamos a lo largo de la línea de contorno con g = c. Nos interesa encontrar puntos donde f casi no cambia mientras caminamos, ya que estos puntos pueden ser máximos.

Hay dos formas en que esto podría suceder:

- Podríamos tocar una línea de contorno f, ya que por definición f no cambia mientras caminamos por sus líneas de contorno. Esto significaría que los tangentes a las líneas de contorno f y g son paralelos aquí.

- Hemos alcanzado una parte "nivel" de f, significa que f no cambia en ninguna dirección.

Para comprobar la primera posibilidad (tocamos una línea de contorno de f), observe que dado que el gradiente de una función es perpendiculares a las curvas de nivel, las tangentes a las curvas de nivel de f y g son paralelos si y solo si los gradientes de f y g son paralelas. Por lo tanto, queremos puntos (x, y) donde g(x, y) = c y

- Silencio Silencio x,Sí.f=λ λ Silencio Silencio x,Sí.g,{displaystyle nabla _{x,y}f=lambda ,nabla _{x,y}g,}

para algunos λ λ {displaystyle lambda }

dónde

- Silencio Silencio x,Sí.f=()∂ ∂ f∂ ∂ x,∂ ∂ f∂ ∂ Sí.),Silencio Silencio x,Sí.g=()∂ ∂ g∂ ∂ x,∂ ∂ g∂ ∂ Sí.){displaystyle nabla _{x,y}f=left({frac {partial f}{partial x}}},{frac {partial f}{partial y}}right),qquad nabla _{x,y}g=left({partial g}{partial x}} {f} {f}}}}} {f}f}}}}}}}}}}}f} {f} {f}}}}}f}}}}}}}}}}}}}}f} {f} {f}f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}f}f}}f}f}f}f} {f} {f}f}}}}}f}}}}}}f}}}}}}}}}}}}}}}

son los respectivos gradientes. La constante λ λ {displaystyle lambda } se requiere porque aunque los dos vectores gradientes son paralelos, las magnitudes de los vectores gradientes generalmente no son iguales. Esta constante se llama el multiplicador Lagrange. (En algunas convenciones λ λ {displaystyle lambda } es precedido por un signo menos).

Observe que este método también resuelve la segunda posibilidad, que f es nivel: si f es nivel, entonces su gradiente es cero, y el ajuste λ λ =0{displaystyle lambda =0} es una solución independientemente de Silencio Silencio x,Sí.g{displaystyle nabla _{x,y}g}.

Para incorporar estas condiciones en una ecuación, introducimos una función auxiliar

- L()x,Sí.,λ λ )↑ ↑ f()x,Sí.)+λ λ ⋅ ⋅ g()x,Sí.),{displaystyle {mathcal {L}(x,y,lambda)equiv f(x,y)+lambda cdot g(x,y)}

y resolver

- Silencio Silencio x,Sí.,λ λ L()x,Sí.,λ λ )=0.{displaystyle nabla _{x,y,lambda }{mathcal {L}(x,y,lambda)=0~.}

Tenga en cuenta que esto equivale a resolver tres ecuaciones con tres incógnitas. Este es el método de los multiplicadores de Lagrange.

Note que Silencio Silencio λ λ L()x,Sí.,λ λ )=0{displaystyle nabla _{lambda }{mathcal {L}(x,y,lambda)=0 } implicación g()x,Sí.)=0,{displaystyle g(x,y)=0} como el derivado parcial de L{displaystyle {fnMithcal}} con respecto a λ λ {displaystyle lambda } es − − g()x,Sí.),{displaystyle -g(x,y)} que claramente es cero si g()x,Sí.)=0.{displaystyle g(x,y)=0~.}

Para resumir

- Silencio Silencio x,Sí.,λ λ L()x,Sí.,λ λ )=0⟺ ⟺ {}Silencio Silencio x,Sí.f()x,Sí.)=λ λ Silencio Silencio x,Sí.g()x,Sí.)g()x,Sí.)=0{displaystyle nabla _{x,y,lambda }{mathcal {L}(x,y,lambda)=0begin{cases}nabla _{x,y}f(x,y)=lambda ,nabla _{x,y}g(x,y)g(x,y)=endend

El método generaliza fácilmente las funciones en n{displaystyle n} variables

- Silencio Silencio x1,...... ,xn,λ λ L()x1,...... ,xn,λ λ )=0{displaystyle nabla _{x_{1},dotsx_{n}lambda }{mathcal {L}}(x_{1},dotsx_{n},lambda)=0}

lo que equivale a resolver n + 1 ecuaciones en n + 1 incógnitas.

La extrema restringida f son Puntos críticos de la Lagrangia L{displaystyle {fnMithcal}}, pero no son necesariamente local extrema de L{displaystyle {fnMitcal {fn}}} (véase el ejemplo 2 infra).

Se puede reformular el lagrangiano como un hamiltoniano, en cuyo caso las soluciones son mínimos locales para el hamiltoniano. Esto se hace en la teoría del control óptimo, en la forma del principio mínimo de Pontryagin.

El hecho de que las soluciones del Lagrangiano no sean necesariamente extremos también plantea dificultades para la optimización numérica. Esto se puede abordar calculando la magnitud del gradiente, ya que los ceros de la magnitud son necesariamente mínimos locales, como se ilustra en el ejemplo de optimización numérica.

Múltiples restricciones

El método de multiplicadores Lagrange se puede ampliar para resolver problemas con múltiples restricciones utilizando un argumento similar. Considere un paraboloide sujeto a dos limitaciones de línea que se intersectan en un solo punto. Como única solución viable, este punto es obviamente un extremum limitado. Sin embargo, el nivel establecido f{displaystylef} claramente no es paralelo a ninguna limitación en el punto de intersección (ver Figura 3); en cambio, es una combinación lineal de los dos gradientes de las limitaciones. En el caso de múltiples limitaciones, eso será lo que buscamos en general: El método de Lagrange busca puntos no en los que el gradiente de f{displaystylef} es una combinación lineal de todos los gradientes de las limitaciones.

Concretamente, supongo que tenemos M{displaystyle M } restricciones y están caminando por el conjunto de puntos que satisfacen gi()x)=0,i=1,...... ,M.{displaystyle g_{i}(mathbf {x})=0,i=1,dotsM~.} Cada punto x{displaystyle 'mathbf {x} } sobre el contorno de una función de limitación determinada gi{displaystyle g_{i} tiene un espacio de direcciones permitido: el espacio de vectores perpendiculares a Silencio Silencio gi()x).{displaystyle \nabla g_{i}(mathbf {x}).} El conjunto de direcciones que son permitidas por todas las restricciones es por lo tanto el espacio de direcciones perpendiculares a todos los gradientes de las limitaciones. Denota este espacio de movimientos permitidos por A{displaystyle A} y denota el lapso de los gradientes de las limitaciones por S.{displaystyle S~} Entonces... A=S⊥ ⊥ ,{displaystyle A=S^{perp } el espacio de vectores perpendicular a cada elemento de S.{displaystyle S~}

Todavía estamos interesados en encontrar puntos donde f{displaystylef} no cambia a medida que caminamos, ya que estos puntos podrían ser (construidos) extrema. Por lo tanto, buscamos x{displaystyle 'mathbf {x} } tal que cualquier dirección permitida de movimiento lejos de x{displaystyle mathbf {x} es perpendicular a Silencio Silencio f()x){displaystyle \nabla f(mathbf {x}) } (Otra vez podríamos aumentar f{displaystyle f} moviéndose a lo largo de esa dirección permitible). En otras palabras, Silencio Silencio f()x)▪ ▪ A⊥ ⊥ =S.{displaystyle \nabla f(mathbf {x})in A^{perp Sí. Así que hay escalares λ λ 1,λ λ 2,...λ λ M{displaystyle lambda _{1},lambda _{2},...lambda ¿Qué? tales que

- Silencio Silencio f()x)=.. k=1Mλ λ kSilencio Silencio gk()x)⟺ ⟺ Silencio Silencio f()x)− − .. k=1Mλ λ kSilencio Silencio gk()x)=0.{displaystyle nabla f(mathbf {x}=sum _{k=1} {M}lambda _{k},nabla g_{k}(mathbf {x})quad iff quad nabla f(mathbf {x})-sum ¿Qué? ¿Qué?

Estos cuero cabelludos son los multiplicadores Lagrange. Ahora tenemos M{displaystyle M } de ellos, uno por cada limitación.

Como antes, introducimos una función auxiliar

- L()x1,...... ,xn,λ λ 1,...... ,λ λ M)=f()x1,...... ,xn)− − .. k=1Mλ λ kgk()x1,...... ,xn){displaystyle {mathcal {L}left(x_{1},ldotsx_{n},lambda _{1},ldotslambda ¿Por qué? ¿Qué? ¿Por qué? }

y resolver

- Silencio Silencio x1,...... ,xn,λ λ 1,...... ,λ λ ML()x1,...... ,xn,λ λ 1,...... ,λ λ M)=0⟺ ⟺ {}Silencio Silencio f()x)− − .. k=1Mλ λ kSilencio Silencio gk()x)=0g1()x)=⋯ ⋯ =gM()x)=0{displaystyle nabla _{x_{1},ldotsx_{n},lambda _{1},ldotslambda ¿Qué? _{1},ldotslambda ¿Por qué? ¿Qué? ¿Por qué?

que asciende a la solución n+M{displaystyle n+M } ecuaciones en n+M{displaystyle n+M } desconocidos.

La suposición de calificación de restricción cuando hay múltiples restricciones es que los gradientes de restricción en el punto relevante son linealmente independientes.

Formulación moderna a través de variedades diferenciables

El problema de encontrar la máxima local y el minima sujeto a restricciones se puede generalizar para encontrar la máxima local y el minima en un múltiple diferente M.{displaystyle M~} En lo que sigue, no es necesario que M{displaystyle M} ser un espacio euclidiano, o incluso un manifold Riemanniano. Todas las apariencias del gradiente Silencio Silencio {displaystyle nabla } (que depende de la elección de la métrica Riemanniana) puede ser reemplazada por el derivado exterior d .{displaystyle 'operatorname {d}}

Restricción única

Vamos M{displaystyle M } ser un conjunto suave de la dimensión m.{displaystyle m~} Supongamos que deseamos encontrar los puntos estacionarios x{displaystyle x } de una función lisa f:M→ → R{displaystyle f:Mto mathbb {R}} cuando se restringe al submanifold N{displaystyle N } definidas por g()x)=0,{displaystyle g(x)=0} Donde g:M→ → R{displaystyle g:Mto mathbb {R}} es una función suave para la cual 0 es un valor regular.

Vamos d f{displaystyle\\fnK} y d g{displaystyle\\fnMicrosoft} ser los derivados exteriores de f{displaystylef} y g{displaystyle g}. Estabilidad para la restricción fSilencioN{fnMicrosoft Sans Serif} a x▪ ▪ N{displaystyle xin N} medios d ()fSilencioN)x=0.{displaystyle \operatorname {d} (f sometida_{N})_{x}=0~} Equivalentemente, el núcleo ker ()d fx){displaystyle \ker(fnMiembro {d} f_{x}f} contiene TxN=ker ()d gx).{displaystyle T_{x}N=ker(operatorname {d} g_{x}~.} En otras palabras, d fx{displaystyle\\fnK} y d gx{displaystyle\\fnMicrosoft} {fnK} son proporcionales 1-formas. Para ello es necesario y suficiente que el siguiente sistema 12m()m− − 1){fnMicrosoft Sans Serif}m(m-1) ecuaciones sostiene:

- d fx∧ ∧ d gx=0▪ ▪ ▪ ▪ 2()T⋆ ⋆ xM){displaystyle operatorname {d} f_{x}wedge operatorname {d} g_{x}=0in Lambda ^{2}(T_{star x}M)}

Donde ∧ ∧ {displaystyle wedge} denota el producto exterior. Los puntos fijos x{displaystyle x } son las soluciones del sistema anterior de ecuaciones más la limitación g()x)=0.{displaystyle g(x)=0~.} Note que 12m()m− − 1){fnMicrosoft Sans Serif}m(m-1) ecuaciones no son independientes, ya que el lado izquierdo de la ecuación pertenece a la subvariedad de ▪ ▪ 2()T⋆ ⋆ xM){displaystyle \Lambda ^{2}(T_{star x}M) } consistente en elementos descompuestos.

En esta formulación, no es necesario encontrar explícitamente el multiplicador Lagrange, un número λ λ {displaystyle lambda } tales que d fx=λ λ ⋅ ⋅ d gx.{displaystyle \operatorname {d} f_{x}=lambda cdot operatorname {d} G_{x}~}

Múltiples restricciones

Vamos M{displaystyle M } y f{displaystylef} como en la sección anterior relativa al caso de una sola limitación. Más que la función g{displaystyle g} descrito allí, ahora considerar una función suave 1)}" xmlns="http://www.w3.org/1998/Math/MathML">G:M→ → Rp()p■1),{displaystyle G:Mto mathbb [R] ^{p}(p]1)}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/30f319767ea2333871e48baa3aa5f20113618782" style="vertical-align: -0.838ex; width:21.605ex; height:2.843ex;"/> con funciones componentes gi:M→ → R,{displaystyle g_{i}:Mto mathbb {R} ~ para la cual 0▪ ▪ Rp{displaystyle 0in mathbb {R} {fn} es un valor regular. Vamos N{displaystyle N} ser el submanifold de M{displaystyle M } definidas por G()x)=0.{displaystyle G(x)=0~}

x{displaystyle x } es un punto estacionario fSilencioN{displaystyle ¿Por qué? si ker ()d fx){displaystyle \ker(fnMiembro {d} f_{x}f} contiene ker ()d Gx).{displaystyle ker(operatorname {d} G_{x})~.} Para mayor comodidad Lx=d fx{displaystyle ¿Qué? y Kx=d Gx,{displaystyle K_{x}=operatorname {d} G_{x}} Donde d G{displaystyle \operatorname {d} G} denota el mapa tangente o Jacobian TM→ → TRp.{displaystyle TMto Tmathbb {R} ^{p}~} El subespacio ker ()Kx){displaystyle ker(K_{x})} tiene dimensión menor que la de ker ()Lx){displaystyle ker(L_{x})}, a saber dim ()ker ()Lx))=n− − 1{displaystyle dim(ker(L_{x})=n-1 } y dim ()ker ()Kx))=n− − p.{displaystyle dim(ker(K_{x})=n-p~.} ker ()Kx){displaystyle ker(K_{x})} pertenece ker ()Lx){displaystyle ker(L_{x}) } si Lx▪ ▪ T⋆ ⋆ xM{displaystyle L_{x}in T_{star x}M} pertenece a la imagen de K⋆ ⋆ x:R⋆ ⋆ p→ → T⋆ ⋆ xM.{displaystyle K_{star x}:mathbb {R} _{star }{p}to T_{star x}M~} Computationally speaking, the condition is that Lx{displaystyle L_{x} pertenece al espacio de fila de la matriz Kx,{displaystyle K_{x}} o equivalentemente el espacio de la columna de la matriz K⋆ ⋆ x{displaystyle K_{star x} (la transposición). Si ⋅ ⋅ x▪ ▪ ▪ ▪ p()T⋆ ⋆ xM){displaystyle omega _{x}in Lambda ^{p}(T_{star x}M) } denota el producto exterior de las columnas de la matriz de K⋆ ⋆ x,{displaystyle K_{star x}} la condición estacionaria para fSilencioN{fnMicrosoft Sans Serif} a x{displaystyle x } se convierte en

- Lx∧ ∧ ⋅ ⋅ x=0▪ ▪ ▪ ▪ p+1()T⋆ ⋆ xM){displaystyle L_{x}wedge omega _{x}=0in Lambda ^{p+1}left(T_{star x}Mright)}

Una vez más, en esta formulación no es necesario encontrar explícitamente los multiplicadores Lagrange, los números λ λ 1,...... ,λ λ p{displaystyle lambda _{1},ldotslambda _{p} } tales que

- d fx=.. i=1pλ λ id ()gi)x.{displaystyle\fnK}=sum} ###{i=1} {p}lambda ¿Por qué?

Interpretación de los multiplicadores de Lagrange

En esta sección, modificamos las ecuaciones de restricción de la forma gi()x)=0{displaystyle g_{i}({bf {x})=0} a la forma gi()x)=ci,{displaystyle g_{i} {bf} {x}=c_{i} Donde ci{displaystyle c_{i}} son m constantes reales que se consideran argumentos adicionales de la expresión lagrangiana L{displaystyle {fnMithcal}}.

A menudo, los multiplicadores de Lagrange tienen una interpretación como alguna cantidad de interés. Por ejemplo, parametrizando la línea de contorno de la restricción, es decir, si la expresión lagrangiana es

- L()x1,x2,...... ;λ λ 1,λ λ 2,...... ;c1,c2,...... )=f()x1,x2,...... )+λ λ 1()c1− − g1()x1,x2,...... ))+λ λ 2()c2− − g2()x1,x2,...... ))+⋯ ⋯ {2} {2} {2}} {2}cccccH00}cccccH00}ccH00} {ccH00}cccH00}ccH00}cccH00}

entonces

- ∂ ∂ L∂ ∂ ck=λ λ k.{displaystyle {frac {partial {Mathcal {L}}{partial} {fnMicrosoft}}} {fnMicrosoft}}} {f}}} {f}}}} {fn}}}} {fnMicrosoft}}}}}}}} {f}}}}}}}} { C_{k}=lambda - ¿Qué?

Entonces, λk es la tasa de cambio de la cantidad que se optimiza como una función del parámetro de restricción. Como ejemplos, en la mecánica lagrangiana, las ecuaciones de movimiento se derivan al encontrar puntos estacionarios de la acción, la integral de tiempo de la diferencia entre energía cinética y potencial. Por lo tanto, la fuerza sobre una partícula debido a un potencial escalar, F = −∇V, puede interpretarse como un Multiplicador de Lagrange que determina el cambio de acción (transferencia de potencial a energía cinética) después de una variación en la trayectoria restringida de la partícula. En la teoría de control, esto se formula en cambio como ecuaciones de costate.

Además, por el teorema de sobre el valor óptimo de un multiplicador Lagrange tiene una interpretación como el efecto marginal de la constante de restricción correspondiente sobre el valor óptimo alcanzable de la función objetiva original: Si denotamos valores en el óptimo con una estrella (⋆ ⋆ {displaystyle star }), entonces se puede demostrar que

- d f()x1⋆ ⋆ ()c1,c2,...... ),x2⋆ ⋆ ()c1,c2,...... ),...... )d ck=λ λ ⋆ ⋆ k.{displaystyle {frac {\\\fnMicrosoft Sans Serif}(c_{1},c_{2},dots), x_{2star }(c_{1},c_{2},dots), dots right)right - ¿Qué? _{star k}

Por ejemplo, en economía el beneficio óptimo para un jugador se calcula sujeto a un espacio limitado de acciones, donde un multiplicador Lagrange es el cambio en el valor óptimo de la función objetiva (beneficio) debido a la relajación de una determinada limitación (por ejemplo, a través de un cambio de ingreso); en tal contexto λ λ ⋆ ⋆ k{displaystyle lambda _{star k} } es el costo marginal de la restricción, y se conoce como el precio de sombra.

Condiciones suficientes

Se pueden establecer condiciones suficientes para un máximo o mínimo local restringido en términos de una secuencia de menores principales (determinantes de submatrices justificadas en la parte superior izquierda) de la matriz hessiana bordeada de segundas derivadas de la expresión lagrangiana.

Ejemplos

Ejemplo 1

Supongamos que deseamos maximizar f()x,Sí.)=x+Sí.{displaystyle f(x,y)=x+y } sujeto a la limitación x2+Sí.2=1.{displaystyle x^{2}+y^{2}=1~} El conjunto factible es el círculo de unidad, y los conjuntos de nivel f son líneas diagonales (con pendiente −1), por lo que podemos ver gráficamente que el máximo ocurre en ()12,12),{displaystyle \left {1}{sqrt {2}}},{tfrac {1}{sqrt {2}}}}right)} y que el mínimo ocurre ()− − 12,− − 12).{displaystyle left(-{tfrac {1}{sqrt {2}},-{tfrac {1}{sqrt {2}}}right)~}

Para el método de los multiplicadores de Lagrange, la restricción es

- g()x,Sí.)=x2+Sí.2− − 1=0,{displaystyle g(x,y)=x^{2}+y^{2}-1=0}

de ahí la función lagrangiana,

- L()x,Sí.,λ λ )=f()x,Sí.)+λ λ ⋅ ⋅ g()x,Sí.)=x+Sí.+λ λ ()x2+Sí.2− − 1),{displaystyle {begin{aligned}{mathcal {L}}(x,y,lambda) tendríamos que ver con la frase, y)+lambda cdot g(x,y)\[4pt] restringir=x+y+lambda (x^{2}+y^{2}-1)end{aligned}}}}}}}}}}}}

es una función que equivale a f()x,Sí.){displaystyle f(x,y)} cuando g()x,Sí.){displaystyle g(x,y)} se establece 0.

Ahora podemos calcular el gradiente:

- Silencio Silencio x,Sí.,λ λ L()x,Sí.,λ λ )=()∂ ∂ L∂ ∂ x,∂ ∂ L∂ ∂ Sí.,∂ ∂ L∂ ∂ λ λ )=()1+2λ λ x,1+2λ λ Sí.,x2+Sí.2− − 1),{displaystyle {begin{aligned}nabla ¿Por qué? {L}}}{partial lambda }}right)\[4pt] limite=left(1+2lambda x,1+2lambda y,x^{2}+y^{2}-1right)color {gray}{,}end{aligned}}}}}}}}}}}}}} {L}}}}}}}}}}} {}}}}}}}}}}{

y por lo tanto:

- Silencio Silencio x,Sí.,λ λ L()x,Sí.,λ λ )=0.. {}1+2λ λ x=01+2λ λ Sí.=0x2+Sí.2− − 1=0{displaystyle nabla _{x,y,lambda }{mathcal {L}(x,y,lambda)=0quad Leftrightarrow quad {begin{cases}1+2lambda x=01+2lambda Y=0x^{2}+y^{2}-1=0end{cases}

Observe que la última ecuación es la restricción original.

Las dos primeras ecuaciones producen

- x=Sí.=− − 12λ λ ,λ λ ل ل 0.{displaystyle x=y=-{1}{2lambda }}qquad lambda neq 0~.

Sustituyendo en la última ecuación tenemos:

- 14λ λ 2+14λ λ 2− − 1=0,{displaystyle {frac {1}{4lambda }}+{frac {1}{4lambda ^{2}=0}

entonces

- λ λ =± ± 12,{displaystyle lambda =pm {1}{sqrt {2}}}

que implica que los puntos estacionarios de L{displaystyle {fnMithcal}} son

- ()22,22,− − 12),()− − 22,− − 22,12).{fnMicroc {2}{2}{2},{sqrt {2}sqrt {2sqrt {2 }}{2}}},-{tfrac {1}sqrt {2}}derecha),qqd left(-{tfrac {sqrt {sqrt {sqrt {sqrt}}}}}}}}}}}}}}}sqqqqsqsq}}sqdsqdsqdccsqtfraccccccccccccccccccccccccccccccccccccccccccccccccci}c {2} {2}} {fnMicroc {2} {fnMicroc {2}} {fnMicroc {1}{sqrt {2}}}}}}}}}}} {fnMicroc {2}}}}}}} {f}}}}}}} {fnMicroc}}} {f}} {f}}}}}}}}}}} {f}}}}} {f}}}}}}}} {f}}}} {f}}}}}}}}}} {

Evaluar la función objetivo f en estos puntos produce

- f()22,22)=2,f()− − 22,− − 22)=− − 2.{fnMicroc {fnMicroc {2}}{2},{tfrac {sqrt {2}}}}} {sqrt {2}}}}sqrt {2sqrt {2}\qquad fleft(-{tfrac {sqrt {sqrt {sqrt}}}}}f}f}f}f}f}f}f}ccccccccccH00cccH00cccH00ccH00cH00ccccccH00}cH00cccH00ccH00ccH00cccH00}cH00}ccH00}cH00cccH00}ccH00}cccc {2}} {2}} {fnMicroc {sqrt {2} {2}}right)=-{sqrt {2}}~}

Así el máximo limitado es 2{displaystyle { sqrt {2}} y el mínimo limitado − − 2{displaystyle -{sqrt {2}.

Ejemplo 2

Ahora modificamos la función objetiva del Ejemplo1 así que minimizamos f()x,Sí.)=()x+Sí.)2{displaystyle f(x,y)=(x+y)^{2} en lugar de f()x,Sí.)=x+Sí.,{displaystyle f(x,y)=x+y} otra vez a lo largo del círculo g()x,Sí.)=x2+Sí.2− − 1=0.{displaystyle g(x,y)=x^{2}+y^{2}-1=0~.} Ahora el nivel se establece f{displaystyle f} son todavía líneas de pendiente -1, y los puntos en el círculo tangente a estos conjuntos de nivel son de nuevo ()2/2,2/2){displaystyle ({sqrt {2}/2,{sqrt {2}/2) y ()− − 2/2,− − 2/2).{displaystyle (-{sqrt {2}/2,-{sqrt {2}/2)~.} Estos puntos de tangencia son máximas f.{displaystyle f~}

Por otro lado, la minima ocurre en el nivel establecido para f=0{displaystyle f=0} (desde su construcción f{displaystylef} no puede tomar valores negativos, a ()2/2,− − 2/2){displaystyle ({sqrt {2}/2,-{sqrt {2}/2) } y ()− − 2/2,2/2),{displaystyle (-{sqrt {2}/2,{sqrt {2}/2)} donde las curvas de nivel f{displaystylef} no son tangentes a la restricción. La condición de que Silencio Silencio x,Sí.,λ λ ()f()x,Sí.)+λ λ ⋅ ⋅ g()x,Sí.))=0{displaystylenabla _{x,y,lambda }left(f(x,y)+lambda cdot g(x,y)right)=0 } correctamente identifica los cuatro puntos como extremos; la minima se caracteriza por λ λ =0{displaystyle 'lambda =0} y la máxima λ λ =− − 2.{displaystyle 'lambda =-2~}

Ejemplo 3

Este ejemplo trata con cálculos más extenuantes, pero sigue siendo un problema de restricción única.

Supongamos que uno quiere encontrar los valores máximos de

- f()x,Sí.)=x2Sí.{displaystyle f(x,y)=x^{2}y}

con la condición de que x{displaystyle x }- y Sí.{displaystyle y}-coordinados se encuentran en el círculo alrededor del origen con radio 3.{displaystyle {sqrt {3}~}~ Es decir, sujeto a la limitación

- g()x,Sí.)=x2+Sí.2− − 3=0.{displaystyle g(x,y)=x^{2}+y^{2}-3=0~.}

Como sólo hay una sola limitación, hay un solo multiplicador, dicen λ λ .{displaystyle lambda ~.}

La limitación g()x,Sí.){displaystyle g(x,y)} es idéntico cero en el círculo del radio 3.{displaystyle {sqrt {3}~}~ Cualquier múltiplo de g()x,Sí.){displaystyle g(x,y)} se puede añadir a g()x,Sí.){displaystyle g(x,y)} salir g()x,Sí.){displaystyle g(x,y)} sin cambios en la región de interés (en el círculo donde nuestra limitación original está satisfecha).

Aplicando el método ordinario del multiplicador de Lagrange se obtiene

- L()x,Sí.,λ λ )=f()x,Sí.)+λ λ ⋅ ⋅ g()x,Sí.)=x2Sí.+λ λ ()x2+Sí.2− − 3),{displaystyle {begin{aligned}{mathcal {L}}(x,y,lambda) sensible=f(x,y)+lambda cdot g(x,y)\\=x^{2}y+lambda (x^{2}+y^{2}-3)end{aligned}}}}}}}

a partir del cual se puede calcular el gradiente:

- Silencio Silencio x,Sí.,λ λ L()x,Sí.,λ λ )=()∂ ∂ L∂ ∂ x,∂ ∂ L∂ ∂ Sí.,∂ ∂ L∂ ∂ λ λ )=()2xSí.+2λ λ x,x2+2λ λ Sí.,x2+Sí.2− − 3).{displaystyle {begin{aligned}nabla ¿Por qué? {L}}{partial lambda }derecha)=left(2xy+2lambda x,x^{2}+2lambda y,x^{2}+y^{2}-3right)~.

Y por lo tanto:

- Silencio Silencio x,Sí.,λ λ L()x,Sí.,λ λ )=0⟺ ⟺ {}2xSí.+2λ λ x=0x2+2λ λ Sí.=0x2+Sí.2− − 3=0⟺ ⟺ {}x()Sí.+λ λ )=0i)x2=− − 2λ λ Sí.ii)x2+Sí.2=3iii){displaystyle nabla _{x,y,lambda }{mathcal {L}(x,y,lambda)=0quad iff quad {begin{cases}2xy+2lambda x=0x^{2}+2lambda Y=0x^{2}+y^{2}-3=0end{cases}quad iff quad {begin{cases}x(y+lambda)=0 limit {text{(i)}x^{2}=-2lambda y caps {text{(ii)}x^{2}{2}}iii} {c}c}c}c}c}cc}ccccccc}cccccccccccccccccccccccccccccccccccccccccccccccccccccccccccccc

iii) es sólo la limitación original. i) implica x=0{displaystyle x=0} o λ λ =− − Sí..{displaystyle 'lambda Sí. Si x=0{displaystyle x=0} entonces Sí.=± ± 3{displaystyle y=pm {fn}fn} por iii) y en consecuencia λ λ =0{displaystyle 'lambda =0} de ii). Si λ λ =− − Sí.,{displaystyle 'lambda # sustituyendo esto a ii) rendimientos x2=2Sí.2.{displaystyle x^{2}=2y^{2}~} Sustituir esto en iii) y resolver Sí.{displaystyle y} da Sí.=± ± 1.{displaystyle y=pm 1~.} Por lo tanto hay seis puntos críticos L:{displaystyle {\fnMitcal}:}

- ()2,1,− − 1);()− − 2,1,− − 1);()2,− − 1,1);()− − 2,− − 1,1);()0,3,0);()0,− − 3,0).{fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {f}fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans} {fnMicrosoft Sans Serif}

Al evaluar el objetivo en estos puntos, se encuentra que

- f()± ± 2,1)=2;f()± ± 2,− − 1)=− − 2;f()0,± ± 3)=0.{displaystyle f(pm {sqrt {2 }},1)=2;quad f(pm {sqrt {2 }},-1)=-2;quad f(0,pm {3sqrt})=0~.}

Por consiguiente, la función objetiva alcanza el máximo global (sujeto a las limitaciones) ()± ± 2,1){displaystyle (pm {sqrt {2}},1)} y el mínimo mundial ()± ± 2,− − 1).{displaystyle (pm {sqrt {2}},-1)~} El punto ()0,3){displaystyle (0,{sqrt {3 }} es un mínimo local f{displaystylef} y ()0,− − 3){displaystyle (0,-{sqrt {3 }} es un máximo local f,{displaystylef} como puede determinarse por consideración de la matriz hesiana L()x,Sí.,0).{displaystyle {mathcal {}(x,y,0)~.}

Note que mientras ()2,1,− − 1){displaystyle ({sqrt {2}},1,-1)} es un punto crítico L,{displaystyle {\fnMitcal}}} no es un extremum local L.{displaystyle {fnMitcal}~} Tenemos

- L()2+ε ε ,1,− − 1+δ δ )=2+δ δ ()ε ε 2+()22)ε ε ).{displaystyle {mathcal {L}}left({sqrt {2 }+varepsilon1,-1+delta right)=2+delta left(varepsilon ^{2}+left(2{sqrt {2}right)varepsilonright)~}}

Dado cualquier barrio ()2,1,− − 1),{displaystyle ({sqrt {2}}},1,-1)} uno puede elegir un pequeño positivo ε ε {displaystyle varepsilon } y un pequeño δ δ {displaystyle delta } de cualquier signo para conseguir L{displaystyle {fnMitcal}} valores tanto mayores como inferiores 2.{displaystyle 2~.} Esto también se puede ver desde la matriz hesiana L{displaystyle {fnMitcal {fn}}} evaluada en este punto (o de hecho en cualquiera de los puntos críticos) que es una matriz indefinida. Cada uno de los puntos críticos L{displaystyle {fnMitcal {fn}}} es un punto de silla L.{displaystyle {fnMitcal}~}

Ejemplo 4

- Entropy

Supongamos que deseamos encontrar la distribución discreta de probabilidad en los puntos {}p1,p2,...... ,pn}{displaystyle {p_{1},p_{2},ldotsp_{n}\ } con máxima información entropía. Esto es lo mismo que decir que deseamos encontrar la distribución de probabilidad menos estructurada en los puntos {}p1,p2,⋯ ⋯ ,pn}.{displaystyle {p_{1},p_{2},cdotsp_{n}}~} En otras palabras, deseamos maximizar la ecuación entropía de Shannon:

- f()p1,p2,...... ,pn)=− − .. j=1npjlog2 pj.{displaystyle f(p_{1},p_{2},ldotsp_{n}=-sum ¿Por qué? - ¿Qué?

Para que esto sea una distribución de probabilidad la suma de las probabilidades pi{displaystyle p_{i}} en cada punto xi{displaystyle x_{i} debe igual 1, por lo que nuestra limitación es:

- g()p1,p2,...... ,pn)=.. j=1npj=1.{displaystyle g(p_{1},p_{2},ldotsp_{n}=sum ¿Qué?

Usamos multiplicadores Lagrange para encontrar el punto de máxima entropía, p→ → Alternativa Alternativa ,{fnMicrosoft Sans Serif} en todas las distribuciones discretas de probabilidad p→ → {displaystyle {vec {fn}} on {}x1,x2,...... ,xn}.{displaystyle {x_{1},x_{2},ldotsx_{n}}~} Requerimos que:

- ∂ ∂ ∂ ∂ p→ → ()f+λ λ ()g− − 1))Silenciop→ → =p→ → Alternativa Alternativa =0,{displaystyle left.{frac {partial }{partial [vec {}} {f+lambda (g-1) {p}={vec} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif}

que da un sistema de n ecuaciones, k=1,...... ,n,{displaystyle k=1,ldotsn} tal que:

- ∂ ∂ ∂ ∂ pk{}− − ().. j=1npjlog2 pj)+λ λ ().. j=1npj− − 1)}Silenciopk=p⋆ ⋆ k=0.{displaystyle left.{frac {partial }{partial ¿Por qué? ¿Por qué? ¿Por qué? - Sí.

Efectuando la diferenciación de estas n ecuaciones, obtenemos

- − − ()1In 2+log2 p⋆ ⋆ k)+λ λ =0.{displaystyle -left({frac {1}{ln 2}+log ¿Por qué? =0~.}

Esto demuestra que todo p⋆ ⋆ k{displaystyle p_{star k} son iguales (porque dependen de λ solamente). Usando la restricción

- .. jpj=1,{displaystyle sum _{j}p_{j}=1}

encontramos

- p⋆ ⋆ k=1n.{displaystyle p_{star k}={frac} {1}{n}~}

Por lo tanto, la distribución uniforme es la distribución con mayor entropía, entre las distribuciones en n puntos.

Ejemplo 5

- Optimización numérica

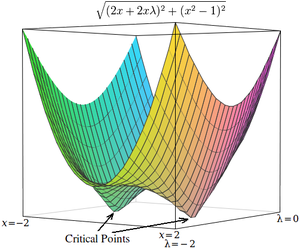

Los puntos críticos de los lagrangianos ocurren en los puntos de silla, en lugar de en los máximos (o mínimos) locales. Desafortunadamente, muchas técnicas de optimización numérica, como el ascenso de colinas, el descenso de gradientes, algunos de los métodos cuasi-Newton, entre otros, están diseñados para encontrar máximos (o mínimos) locales y no puntos de silla. Por esta razón, uno debe modificar la formulación para asegurarse de que sea un problema de minimización (por ejemplo, al extremar el cuadrado del gradiente del Lagrangiano como se muestra a continuación), o bien usar una técnica de optimización que encuentre puntos estacionarios (como como el método de Newton sin una búsqueda de línea de búsqueda de extremos) y no necesariamente extremos.

Como ejemplo simple, considere el problema de encontrar el valor x que minimiza f()x)=x2,{displaystyle f(x)=x^{2} tales restricciones x2=1.{displaystyle x^{2}=1~} (Este problema es algo poco típico porque sólo hay dos valores que satisfacen esta limitación, pero es útil para fines de ilustración porque la función no constreñida correspondiente puede ser visualizada en tres dimensiones.)

Usando multiplicadores de Lagrange, este problema se puede convertir en un problema de optimización sin restricciones:

- L()x,λ λ )=x2+λ λ ()x2− − 1).{displaystyle {mathcal {L}(x,lambda)=x^{2}+lambda (x^{2}-1)~.}

Los dos puntos críticos ocurren en puntos de silla donde x = 1 y x = −1.

Para resolver este problema con una técnica de optimización numérica, primero debemos transformar este problema de modo que los puntos críticos ocurran en los mínimos locales. Esto se hace calculando la magnitud del gradiente del problema de optimización sin restricciones.

Primero, calculamos la derivada parcial del problema sin restricciones con respecto a cada variable:

- ∂ ∂ L∂ ∂ x=2x+2xλ λ ∂ ∂ L∂ ∂ λ λ =x2− − 1.{displaystyle {begin{aligned} {frac {partial {\mathcal {}{partial x}}=2x+2xlambda \[5pt] {L}}{partial lambda - Sí.

Si la función objetivo no es fácilmente diferenciable, el diferencial con respecto a cada variable se puede aproximar como

- ∂ ∂ L∂ ∂ x.. L()x+ε ε ,λ λ )− − L()x,λ λ )ε ε ,∂ ∂ L∂ ∂ λ λ .. L()x,λ λ +ε ε )− − L()x,λ λ )ε ε ,{fnMicrosoft Sans Serif} {fnMithcal {fnMicrosoft Sans Serif} {fnMicrox {fnMithcal {c} {cHFF}(x+varepsilonlambda)-{mthcal {}(x,lambda)}{varepsilonc] }approx {frac {mathcal {L}}(x,lambda +varepsilon)-{mathcal {L}}(x,lambda)}{varepsilon }}},end{aligned}}}}}

Donde ε ε {displaystyle varepsilon } es un pequeño valor.

A continuación, calculamos la magnitud del gradiente, que es la raíz cuadrada de la suma de los cuadrados de las derivadas parciales:

- h()x,λ λ )=()2x+2xλ λ )2+()x2− − 1)2.. ()L()x+ε ε ,λ λ )− − L()x,λ λ )ε ε )2+()L()x,λ λ +ε ε )− − L()x,λ λ )ε ε )2.{displaystyle {begin{aligned}h(x,lambda) {sqrt {(2x+2xlambda)^{2}+(x^{2}-1)}\[4pt] [sqrt {left {\fnMithcal {L}(x+varepsilonlambda)-{mathcal {L}(x,lambda) {fnMicrosoft Sans Serif}(x,lambda +varepsilon)-{mthcal {}(x,lambda +varepsilon)-{mathcal {L}(x,lambda) ¿Qué? }~.

(Dado que la magnitud siempre es no negativa, optimizar sobre la magnitud al cuadrado es equivalente a optimizar sobre la magnitud. Por lo tanto, la "raíz cuadrada" puede omitirse de estas ecuaciones sin que se espere una diferencia en la resultados de la optimización.)

Los puntos críticos h ocurre en x = 1 y x = 1 -, como en L.{displaystyle {fnMitcal}~} A diferencia de los puntos críticos en L,{displaystyle {\fnMitcal}}} sin embargo, los puntos críticos en h ocurre en minima local, por lo que las técnicas de optimización numérica se pueden utilizar para encontrarlas.

Aplicaciones

Teoría del control

En la teoría del control óptimo, los multiplicadores de Lagrange se interpretan como variables de coste y los multiplicadores de Lagrange se reformulan como la minimización del hamiltoniano, en el principio mínimo de Pontryagin.

Programación no lineal

El método del multiplicador de Lagrange tiene varias generalizaciones. En la programación no lineal existen varias reglas multiplicadoras, p. la regla del multiplicador de Carathéodory-John y la regla del multiplicador convexo, para restricciones de desigualdad.

Sistemas de energía

Los métodos basados en multiplicadores de Lagrange tienen aplicaciones en sistemas de potencia, p. en la colocación de recursos de energía distribuida (DER) y el deslastre de carga.

Contenido relacionado

División (matemáticas)

Anillo noetheriano

Blum Blum Shub

![{displaystyle {Bigl [}operatorname {D} g(x_{star }){Bigr ]}_{j,k}=left[{frac { partial g_{j} }{partial x_{k}}}right] }](https://wikimedia.org/api/rest_v1/media/math/render/svg/509ad113a9b25582ecf5246ce24416b000177807)

![{displaystyle {begin{aligned}&{mathcal {L}}(x_{1},x_{2},ldots;lambda _{1},lambda _{2},ldots;c_{1},c_{2},ldots)\[4pt]={}&f(x_{1},x_{2},ldots)+lambda _{1}(c_{1}-g_{1}(x_{1},x_{2},ldots))+lambda _{2}(c_{2}-g_{2}(x_{1},x_{2},dots))+cdots end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1867ddf9118c757c322a3d5c0c94965c64a65d0a)

![{displaystyle {begin{aligned}{mathcal {L}}(x,y,lambda)&=f(x,y)+lambda cdot g(x,y)\[4pt]&=x+y+lambda (x^{2}+y^{2}-1)\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/69623e2b0ffebabe351b9e7ed58a76751601bf66)

![{displaystyle {begin{aligned}nabla _{x,y,lambda }{mathcal {L}}(x,y,lambda)&=left({frac {partial {mathcal {L}}}{partial x}},{frac {partial {mathcal {L}}}{partial y}},{frac {partial {mathcal {L}}}{partial lambda }}right)\[4pt]&=left(1+2lambda x,1+2lambda y,x^{2}+y^{2}-1right) color {gray}{,}end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cdf9c05227cba7a2024d2ef806cf55712c1a3073)

![{displaystyle {begin{aligned}&{frac {partial {mathcal {L}}}{partial x}}=2x+2xlambda \[5pt]&{frac {partial {mathcal {L}}}{partial lambda }}=x^{2}-1~.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/498e5f0200a9e684456385a4d6b121c2274c2737)

![{displaystyle {begin{aligned}{frac { partial {mathcal {L}} }{partial x}}approx {frac {{mathcal {L}}(x+varepsilonlambda)-{mathcal {L}}(x,lambda)}{varepsilon }},\[5pt]{frac { partial {mathcal {L}} }{partial lambda }}approx {frac {{mathcal {L}}(x,lambda +varepsilon)-{mathcal {L}}(x,lambda)}{varepsilon }},end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0de4bda576fdb293b9e0b1f0ebe3f93d57c84f06)

![{displaystyle {begin{aligned}h(x,lambda)&={sqrt {(2x+2xlambda)^{2}+(x^{2}-1)^{2} }}\[4pt]&approx {sqrt {left({frac { {mathcal {L}}(x+varepsilonlambda)-{mathcal {L}}(x,lambda) }{varepsilon }}right)^{2}+left({frac { {mathcal {L}}(x,lambda +varepsilon)-{mathcal {L}}(x,lambda) }{varepsilon }}right)^{2} }}~.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a19179451d91b7f354ff6326de2c76749c3e9f0f)