Mínimos cuadrados ordinarios

En estadística, los mínimos cuadrados ordinarios (OLS) es un tipo de método de mínimos cuadrados lineales para elegir los parámetros desconocidos en un modelo de regresión lineal (con nivel uno fijo). efectos de una función lineal de un conjunto de variables explicativas) por el principio de mínimos cuadrados: minimizar la suma de los cuadrados de las diferencias entre la variable dependiente observada (valores de la variable que se observa) en el conjunto de datos de entrada y la salida del Función (lineal) de la variable independiente.

Geométricamente, esto se ve como la suma de las distancias al cuadrado, paralelas al eje de la variable dependiente, entre cada punto de datos del conjunto y el punto correspondiente en la superficie de regresión: cuanto más pequeñas sean las diferencias, mejor será el modelo. se ajusta a los datos. El estimador resultante se puede expresar mediante una fórmula simple, especialmente en el caso de una regresión lineal simple, en la que hay un único regresor en el lado derecho de la ecuación de regresión.

El estimador MCO es consistente para los efectos fijos de nivel uno cuando los regresores son exógenos y forma una colinealidad perfecta (condición de rango), consistente para la estimación de la varianza de los residuos cuando los regresores tienen cuartos momentos finitos y, según el método de Gauss-Markov teorema: óptimo en la clase de estimadores lineales insesgados cuando los errores son homocedásticos y no correlacionados en serie. En estas condiciones, el método de MCO proporciona una estimación insesgada de media de varianza mínima cuando los errores tienen varianzas finitas. Bajo el supuesto adicional de que los errores se distribuyen normalmente con media cero, MCO es el estimador de máxima verosimilitud que supera a cualquier estimador insesgado no lineal.

Modelo lineal

Supongamos que los datos consisten en n{displaystyle n} Observaciones {}xi,Sí.i}i=1n{displaystyle left{mathbf {x} - Sí.. Cada observación i{displaystyle i} incluye una respuesta de escalar Sí.i{displaystyle Y... y un vector de columna xi{displaystyle mathbf {x} _{i} de p{displaystyle p} parámetros (regresores), es decir, xi=[xi1,xi2,... ... ,xip]T{displaystyle mathbf {x} - ¿Por qué? {T}. En un modelo de regresión lineal, la variable de respuesta, Sí.i{displaystyle Y..., es una función lineal de los rebeldes:

- Sí.i=β β 1 xi1+β β 2 xi2+⋯ ⋯ +β β p xip+ε ε i,{displaystyle Y... ################################################################################################################################################################################################################################################################ ¿Por qué? x_{ip}+varepsilon _{i}

o en forma vectorial,

- Sí.i=xiTβ β +ε ε i,{displaystyle Y... ################################################################################################################################################################################################################################################################ {T} {fn} {fnMicrosoft} {fnMicrosoft} {fnMicrosoft}} {f}}} {fnMicrosoft} }+varepsilon - ¿Qué?

Donde xi{displaystyle mathbf {x} _{i}, como se introdujo anteriormente, es un vector de columna del i{displaystyle i}-la observación de todas las variables explicativas; β β {displaystyle {boldsymbol {beta } es un p× × 1{displaystyle ptimes 1} vector de parámetros desconocidos; y el escalar ε ε i{displaystyle varepsilon _{i} representa variables aleatorias no conservadas (errores) i{displaystyle i}-a observación. ε ε i{displaystyle varepsilon _{i} representa las influencias sobre las respuestas Sí.i{displaystyle Y... de fuentes distintas de las variables explicativas xi{displaystyle mathbf {x} _{i}. Este modelo también se puede escribir en la notación de matriz como

- Sí.=Xβ β +ε ε ,{displaystyle mathbf {y} =mathbf {X} {boldsym {bolbeta }+{boldsymbol {varepsilon },,}

Donde Sí.{displaystyle mathbf {y} y ε ε {displaystyle {boldsymbol {varepsilon } son n× × 1{displaystyle ntimes 1} vectores de las variables de respuesta y los errores de los n{displaystyle n} observaciones, y X{displaystyle mathbf {X} es un n× × p{displaystyle ntimes p} matriz de regresores, también a veces llamada matriz de diseño, cuya fila i{displaystyle i} es xiT{displaystyle mathbf {x} ################################################################################################################################################################################################################################################################ {T} y contiene i{displaystyle i}- observaciones sobre todas las variables explicativas.

Típicamente, un término constante se incluye en el conjunto de regredores X{displaystyle mathbf {X}, digamos, tomando xi1=1{displaystyle x_{i1}=1} para todos i=1,... ... ,n{displaystyle i=1,dotsn}. El coeficiente β β 1{displaystyle beta ¿Qué? correspondiente a este regresión se llama el interceptación. Sin la interceptación, la línea fija se ve obligada a cruzar el origen cuando xi=0→ → {displaystyle x_{i}={vec {0}}.

Los agresores no tienen que ser independientes para que la estimación sea coherente, pero la multicolinealidad hace que la estimación sea inconsistente. Como ejemplo concreto en el que los regredores no son independientes, podríamos sospechar que la respuesta depende linealmente tanto de un valor como de su plaza; en cuyo caso incluiríamos a un regresor cuyo valor es sólo el cuadrado de otro regresión. En ese caso, el modelo sería quadratic en el segundo regresor, pero ninguno-el-no-el-no- linear modelo porque el modelo es todavía lineal en los parámetros (β β {displaystyle {boldsymbol {beta }).

Formulación matricial/vectorial

Considere un sistema sobredeterminado

- . . j=1pxijβ β j=Sí.i, ()i=1,2,... ... ,n),{displaystyle sum _{j=1}{p}x_{ij}beta - Sí.

de n{displaystyle n} ecuaciones lineales en p{displaystyle p} Coeficientes desconocidos, β β 1,β β 2,... ... ,β β p{displaystyle beta _{1},beta _{2},dotsbeta ¿Qué?Con p}" xmlns="http://www.w3.org/1998/Math/MathML">n■p{displaystyle n confiadop}p}" aria-hidden="true" class="mwe-math-fallback-image-inline mw-invert" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/7002b8ec5aefb63e588cf894804ba7cb8401fc95" style="vertical-align: -0.671ex; width:5.663ex; height:2.176ex;"/>. Esto se puede escribir en forma de matriz como

- Xβ β =Sí.,{displaystyle mathbf {X} {boldsymbol {beta }=Mathbf {y}

dónde

- X=[X11X12⋯ ⋯ X1pX21X22⋯ ⋯ X2p⋮ ⋮ ⋮ ⋮ ⋱ ⋱ ⋮ ⋮ Xn1Xn2⋯ ⋯ Xnp],β β =[β β 1β β 2⋮ ⋮ β β p],Sí.=[Sí.1Sí.2⋮ ⋮ Sí.n].{displaystyle mathbf {X} ={begin{bmatrix}X_{11} limitX_{12}cdots ################################################################################################################################################################################################################################################################ ################################################################################################################################################################################################################################################################ ¿Qué? }={begin{bmatrix}beta ¿Por qué? ¿Por qué? {fnMicrosoft Sans Serif} {fn}}

(Nota: para un modelo lineal como arriba, no todos los elementos en X{displaystyle mathbf {X} contiene información sobre los puntos de datos. La primera columna está poblada con unas, Xi1=1{displaystyle X_{i1}=1}. Sólo las otras columnas contienen datos reales. Así que aquí. p{displaystyle p} es igual al número de regredores más uno).

Tal sistema generalmente no tiene una solución exacta, por lo que el objetivo es en lugar de encontrar los coeficientes β β {displaystyle {boldsymbol {beta } que se ajusta a las ecuaciones "mejor", en el sentido de resolver el problema de minimización cuadrática

- β β ^ ^ =argminβ β S()β β ),{displaystyle {hat {beta {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\fnMicrosoft {f}fnMicrosoft {fnMicrosoft {fnMicrosoft {f}f}f}f}f}fnfnMicrosoft {fnMicrosoft {f}f}fnfnMicrosoft {fnfnMicrosoft {fnf}f}fnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnMicrosoft {fnMicrosoft {fn\\fnfn\fnfn }={underset {boldsymbol {beta ## {fnMicrosoft ##},S({boldsym {bolbeta }}}}

donde la función objetiva S{displaystyle S. es dado por

- S()β β )=. . i=1nSilencioSí.i− − . . j=1pXijβ β jSilencio2=.Sí.− − Xβ β .2.{displaystyle S({boldsymbol {beta })=sum ¿Por qué? ################################################################################################################################################################################################################################################################ ¿Por qué? - Mathbf {X} {beta Bien.

Una justificación para elegir este criterio se da en Propiedades abajo. Este problema de minimización tiene una solución única, siempre que el p{displaystyle p} columnas de la matriz X{displaystyle mathbf {X} son linealmente independientes, dadas por la resolución de los llamados ecuaciones normales:

- ()XTX)β β ^ ^ =XTSí. .{displaystyle left(mathbf {X} {fnK} {T}mathbf {X} right){hat {boldsymbol {beta }=Mathbf {X} {fnMicrosoft} Mathbf {y}

La matriz XTX{displaystyle mathbf {X} {fnK} {T} 'Mathbf {X} es conocido como matriz normal o matriz de gramos y la matriz XTSí.{displaystyle mathbf {X} {fnK} # Mathbf {y} es conocido como la matriz de momento de regresión y por los regresores. Finalmente, β β ^ ^ {displaystyle {hat {beta {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {f}fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {f}f}f}f}f}f}fnfnfnMicrosoft {fnMicrosoft {fnfnMicrosoft {fnMicrosoft {fnfnf}fnfn\fnfnfnMicrosoft {fnf}fnMicrosoft {fnfnfnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\\\fnMicrosoft {f}fn } es el vector coeficiente del hiperplano menos cuadrado, expresado como

- β β ^ ^ =()XTX)− − 1XTSí..{displaystyle {hat {beta {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\fnMicrosoft {f}fnMicrosoft {fnMicrosoft {fnMicrosoft {f}f}f}f}f}fnfnMicrosoft {fnMicrosoft {f}f}fnfnMicrosoft {fnfnMicrosoft {fnf}f}fnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnMicrosoft {fnMicrosoft {fn\\fnfn\fnfn }=left(mathbf {X} ^{operatorname {T}mathbf {X} right)}mathbf {X} {fnK} Mathbf.

o

- β β ^ ^ =β β +()XTX)− − 1XTε ε .{displaystyle {hat {beta {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\fnMicrosoft {f}fnMicrosoft {fnMicrosoft {fnMicrosoft {f}f}f}f}f}fnfnMicrosoft {fnMicrosoft {f}f}fnfnMicrosoft {fnfnMicrosoft {fnf}f}fnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnMicrosoft {fnMicrosoft {fn\\fnfn\fnfn }={boldsymbol {beta }+left(mathbf {X} {fnK} {T}mathbf {X} right)}mathbf {X} {fnK} {T}{boldsymbol {varepsilon }}

Estimación

Suppose b es un valor "candidato" para el vector del parámetro β. La cantidad Sí.i − xiTb, llamado el residual para el i-a observación, mide la distancia vertical entre el punto de datos ()xi, Sí.i) y el hiperplano Sí. = xTb, y por lo tanto evalúa el grado de ajuste entre los datos reales y el modelo. El suma de restos cuadrados ()SSR(también llamado el error suma de cuadrados ()ESS) o suma residual de plazas ()RSS)) es una medida del modelo general adecuado:

- S()b)=. . i=1n()Sí.i− − xiTb)2=()Sí.− − Xb)T()Sí.− − Xb),{displaystyle S(b)=sum ¿Por qué? {T}b)^{2}=(y-Xb)^{operatorname {T}(y-Xb),}

Donde T denota la matriz transpose, y las filas de X, denotando los valores de todas las variables independientes asociadas con un valor particular de la variable dependiente, son Xi = xiT. El valor de b que minimiza esta suma se llama Estimador de OLS β. La función S()b) es cuadrático en b con Hessian positivo-definido, y por lo tanto esta función posee un mínimo global único b=β β ^ ^ {displaystyle b={hat {beta }, que puede ser dada por la fórmula explícita:[prueba]

- β β ^ ^ =argminb▪ ▪ Rp S()b)=()XTX)− − 1XTSí. .{displaystyle {hat {beta #### ## ## ## ## ## ## ##operatorname {argmin} _{bin mathbb [R] ^{p}S(b)=(X^{operatorname [T} }X)^{-1}X^{operatorname Sí.

El producto N=XT X es una matriz de Gram y su inversa, Q =N–1, es la matriz de cofactor de β, estrechamente relacionada con su matriz de covarianza , Cβ. La matriz (XT X)–1 XT=Q XT se denomina matriz pseudoinversa de Moore-Penrose de X. Esta formulación resalta el punto de que la estimación se puede realizar si, y sólo si, no existe una multicolinealidad perfecta entre las variables explicativas (lo que provocaría que la matriz de gramos no tuviera inversa).

Después de haber estimado β, los valores ajustados (o valores predichos) de la regresión serán

- Sí.^ ^ =Xβ β ^ ^ =PSí.,{displaystyle {hat {y}= X{hat {beta }=Py,}

donde P = X(XTX) −1XT es la matriz de proyección en el espacio V abarcado por las columnas de X. Esta matriz P también se denomina a veces matriz de sombrero porque "pone un sombrero" en la variable y. Otra matriz, estrechamente relacionada con P es la matriz annihilator M = In − P; esta es una matriz de proyección en el espacio ortogonal a V. Ambas matrices P y M son simétricas e idempotentes (lo que significa que P2 = P y M2 = M), y se relacionan con la matriz de datos X a través de las identidades PX = X y MX = 0. La matriz M crea los residuales de la regresión:

- ε ε ^ ^ =Sí.− − Sí.^ ^ =Sí.− − Xβ β ^ ^ =MSí.=M()Xβ β +ε ε )=()MX)β β +Mε ε =Mε ε .{displaystyle {hat {varepsilon }=y-{hat {y}=y-X{hat {beta} }=My=M(Xbeta +varepsilon)=(MX)beta +Mvarepsilon =Mvarepsilon.}

Usando estos residuos podemos estimar el valor de σ 2 usando el reducido chi-squared estadística:

- s2=ε ε ^ ^ Tε ε ^ ^ n− − p=()MSí.)TMSí.n− − p=Sí.TMTMSí.n− − p=Sí.TMSí.n− − p=S()β β ^ ^ )n− − p,σ σ ^ ^ 2=n− − pns2{displaystyle S^{2}={frac {hat {varepsilon } {fncipum {fnK} {fnK} {fnK} {fnfnK} {fn} {fnfn}fnfnfnK}fnfnfnK}}}} {fnfnfnfnKfnKfnK}}}}}}} {fnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnKfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnfnH0}}fnH ¿Qué? Mi... {fnMicrom} {T}M^{mathrm Mi... {fnMicrom} Mi... {fnMicrosoft {beta} } {n-p}}qquad {fnfn sigma} }{2}={frac {n-p} {n};s^{2}

El denominador, n−p, es los grados estadísticos de libertad. La primera cantidad, s2, es la estimación OLS σ2, mientras que el segundo, σ σ ^ ^ 2{displaystyle scriptstyle {hat {sigma } {2}, es la estimación MLE para σ2. Los dos estimadores son bastante similares en muestras grandes; el primer estimador siempre es imparcial, mientras que el segundo estimador es parcial pero tiene un error medio más pequeño cuadrado. En práctica s2 se utiliza más a menudo, ya que es más conveniente para la prueba de hipótesis. La raíz cuadrada s2 se llama error estándar de regresión, error estándar de la regresióno error estándar de la ecuación.

Es común evaluar la bondad de ajuste de la regresión MCO comparando cuánto se puede reducir la variación inicial en la muestra al regresar a X. El coeficiente de determinación R2 se define como una relación de valores "explicados" variación del "total" varianza de la variable dependiente y, en los casos en que la suma de cuadrados de la regresión sea igual a la suma de cuadrados de residuos:

- R2=. . ()Sí.^ ^ i− − Sí.̄ ̄ )2. . ()Sí.i− − Sí.̄ ̄ )2=Sí.TPTLPSí.Sí.TLSí.=1− − Sí.TMSí.Sí.TLSí.=1− − RSSTSS{displaystyle ¿Qué? (y_{i}-{overline {}} {2}}={frac} {fnMicrom} {T}P^{mathrm Ayúdame. {T}Ly}=1-{frac} {fnMicrom} Mi... {T}}=1-{rm {rm} {rm} {rm {}}} {fn}} {f}}} {fn}} {f}}}}} {fn}}}}}} {f}

donde TSS es suma total de plazas para la variable dependiente, L=In− − 1nJn{fnMicrosoftstyle L=I_{n}-{frac {1}{n}J_{n}, y Jn{textstyle J_{n} es un n×n matriz de los. ()L{displaystyle L. es una matriz de centro que es equivalente a la regresión en una constante; simplemente resta la media de una variable.) Para R2 para ser significativo, la matriz X de los datos sobre los regresionistas deben contener un vector de columna de los que representan la constante cuyo coeficiente es la interceptación de regresión. En ese caso, R2 siempre será un número entre 0 y 1, con valores cercanos a 1 indicando un buen grado de ajuste.

La diferencia en la predicción de la variable independiente como función de la variable dependiente se da en el artículo Polynomial menos cuadrados.

Modelo de regresión lineal simple

Si la matriz de datos X contiene solo dos variables, una constante y un regresor escalar xi, entonces esto se llama &# 34;modelo de regresión simple". Este caso se considera a menudo en las clases de estadística para principiantes, ya que proporciona fórmulas mucho más simples, incluso adecuadas para el cálculo manual. Los parámetros comúnmente se indican como (α, β):

- Sí.i=α α +β β xi+ε ε i.{displaystyle Y_{i}=alpha +beta x_{i}+varepsilon _{i}

Las estimaciones de mínimos cuadrados en este caso están dadas por fórmulas simples

- β β ^ ^ =. . i=1n()xi− − x̄ ̄ )()Sí.i− − Sí.̄ ̄ ). . i=1n()xi− − x̄ ̄ )2α α ^ ^ =Sí.̄ ̄ − − β β ^ ^ x̄ ̄ ,{displaystyle {begin{aligned}{beta} {beta={frac {sum} ¿Qué? {x}) {fn} {fnK}} {fnK}}} {fnK}}} {fnK}}}} {fn}}} {fn}}}} {fn}}} {fn}}} {f}}}} {f}}}}}}}}} {f}}}}}}}} {f}}}}} {f}}}}}}}}}} {f}}}}}}}}} {f}}}}}}}} {f}}}} {f}}}}}}}}}}}}}}} {f}}}}}}}}}} {f}}}}}}}}}}}}}}}}} {f}}}}}}}}}}}}}}}}}}}}} {f}}}}}}}}}}}}}}}}}}}}}}}}} { {fn} {fn} {fn}} {fn}}}}\[2pt]{\\m} {fn}} {fn}} {b}} {b}}}} {fn}}} {beta }}}fn}fnfnfn}} {fn}}}}}}}}}}}}}}}}}}}} {f}}}}}}}}}}}}}}} {f}}}}}}}}}}}}}} {fn}}}}}}}}}}}}}}}}}}}}}}} {m}}}}}}}}}}}}}}} {\\\\\\\\\\\\\\n}}}}}}}}}}}}}}}}}}}}}}}}}}}}}

Derivaciones alternativas

En la sección anterior el estimador menos cuadrados β β ^ ^ {displaystyle {hat {beta } se obtuvo como un valor que minimiza la suma de residuos cuadrados del modelo. Sin embargo, también es posible obtener el mismo estimador de otros enfoques. En todos los casos, la fórmula para el estimador OLS sigue siendo la misma: ^β =XTX)−1XTSí.; la única diferencia es en cómo interpretamos este resultado.

Proyección

Para los matemáticos, MCO es una solución aproximada a un sistema sobredeterminado de ecuaciones lineales Xβ ≈ y, donde β es la incógnita. Suponiendo que el sistema no se puede resolver exactamente (el número de ecuaciones n es mucho mayor que el número de incógnitas p), buscamos una solución que pueda proporcionar la discrepancia más pequeña. entre los lados derecho e izquierdo. En otras palabras, buscamos la solución que satisfaga

- β β ^ ^ =argminβ β . . Sí.− − Xβ β . . ,{displaystyle {hat {beta }={rm {arg} min _{beta },lVert mathbf {y}mathbf {X} {boldsymbol {beta }r Vert.

Donde .·. es la norma L2 estándar en la n-dimensional Espacio euclidiano Rn. La cantidad predicha Xβ es sólo una cierta combinación lineal de los vectores de regresión. Así, el vector residual Sí. − Xβ tendrá la longitud más pequeña cuando Sí. se proyecta ortogonalmente sobre el subespacio lineal abarcado por las columnas de X. El estimador OLS β β ^ ^ {displaystyle {hat {beta } en este caso se puede interpretar como los coeficientes de descomposición vectorial de ^Sí. = Py sobre la base de X.

En otras palabras, las ecuaciones gradientes al mínimo se pueden escribir como:

- ()Sí.− − Xβ β ^ ^ )⊤ ⊤ X=0.{displaystyle (mathbf {}mathbf {X} {hat {boldsymbol {beta }}}}mathbf {X} =0.}

Una interpretación geométrica de estas ecuaciones es que el vector de residuos, Sí.− − Xβ β ^ ^ {displaystyle mathbf {y} -X{hat {boldsymbol {beta} } es ortogonal al espacio de la columna X, desde el producto de puntos ()Sí.− − Xβ β ^ ^ )⋅ ⋅ Xv{displaystyle (mathbf {}})cdot mathbf {X} mathbf {v} es igual a cero para cualquiera vector conformacional, v. Esto significa que Sí.− − Xβ β ^ ^ {displaystyle mathbf {y} -mathbf {X} {boldsym {beta} } es el más corto de todos los vectores posibles Sí.− − Xβ β {displaystyle mathbf {y} -mathbf {X} {boldsym {bolbeta }, es decir, la diferencia de los residuos es el mínimo posible. Esto se ilustra a la derecha.

Introducción γ γ ^ ^ {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\fnMicrosoft {f} {fnMicrosoft {\fnMicrosoft {fnMicrosoft {fnMicrosoft {\fnMicrosoft {\fnMicrosoft {fnMicrosoft {\\\fnMicrosoft {fnMicrosoft {\\fnMicrosoft {\fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\\fn\\\\\fn\\\\fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {\\\fnMicrosoft {\fnMicro } y una matriz K con el supuesto de que una matriz [X K]{displaystyle [mathbf {X} Mathbf {K}}} no es fijo y KT X = 0 (cf. Proyecciones ortogonales), el vector residual debe satisfacer la siguiente ecuación:

- r^ ^ :=Sí.− − Xβ β ^ ^ =Kγ γ ^ ^ .{fnMicrosoft Sans Serif} }=Mathbf {y} - Mathbf {X} {hat {boldsymbol {beta }= 'Mathbf {K} {hat {boldsymbol {gamma }}}

La ecuación y la solución de mínimos cuadrados lineales se describen a continuación:

- Sí.=[XK][β β ^ ^ γ γ ^ ^ ],⇒ ⇒ [β β ^ ^ γ γ ^ ^ ]=[XK]− − 1Sí.=[()X⊤ ⊤ X)− − 1X⊤ ⊤ ()K⊤ ⊤ K)− − 1K⊤ ⊤ ]Sí..{displaystyle {begin{aligned}mathbf {y}={begin{bmatrix}mathbf {X} {begin{bmatrix}{begin{bmatrix}{hat {boldsymbol {beta }}}{hat {boldsymbol {gamma {fnMicrosoft Sans Serif}\fnMicrosoft Sans Serif} Rightarrow {begin{bmatrix}{hat {boldsymbol {beta}\\hat {boldsymbol {gamma} {begin{bmatrix}mathbf {X}mathbf {K}end{bmatrix}mathbf {y}={begin{bmatrix}left(mathbf {X} } {top }mathbf {X} right)^{-1}mathbf {X} ^{top }\left(mathbf {K}top }mathbf {K}right)^{-1}mathbf {K} ^{top }end{bmatrix}mathbf {y}end{aligned}}

Otra forma de verlo es considerar que la línea de regresión es un promedio ponderado de las líneas que pasan por la combinación de dos puntos cualesquiera en el conjunto de datos. Aunque esta forma de cálculo es más costosa desde el punto de vista computacional, proporciona una mejor intuición en OLS.

Máxima probabilidad

El estimador MCO es idéntico al estimador de máxima verosimilitud (MLE) bajo el supuesto de normalidad para los términos de error.[prueba] Este supuesto de normalidad tiene importancia histórica, ya que proporcionó la base para los primeros trabajo en análisis de regresión lineal de Yule y Pearson. A partir de las propiedades de MLE, podemos inferir que el estimador MCO es asintóticamente eficiente (en el sentido de alcanzar la cota de Cramér-Rao para la varianza) si se satisface el supuesto de normalidad.

Método generalizado de momentos

En el caso iid, el estimador MCO también puede verse como un estimador GMM que surge de las condiciones de momento

- E[xi()Sí.i− − xiTβ β )]=0.{displaystyle mathrm {E} {big [,x_{i}left(y_{i}-x_{i}{operatorname {T}betaright),{big]}=0}

Estas condiciones de momento establecen que los regresores no deben estar correlacionados con los errores. Dado que xi es un vector p, el número de condiciones de momento es igual a la dimensión del vector de parámetros β, y así el sistema queda exactamente identificado. Este es el llamado caso clásico de GMM, cuando el estimador no depende de la elección de la matriz de ponderación.

Tenga en cuenta que el supuesto original de exogeneidad estricta E[εi | xi] = 0 implica un conjunto de condiciones de momento mucho más rico que el indicado anteriormente. En particular, esta suposición implica que para cualquier función vectorial ƒ, la condición de momento E[ƒ(xi)·εi] = 0 se mantendrá. Sin embargo, se puede demostrar utilizando el teorema de Gauss-Markov que la elección óptima de la función ƒ es tomar ƒ( x) = x, lo que da como resultado la ecuación de momento publicada anteriormente.

Propiedades

Suposiciones

Existen varios marcos diferentes en los que se puede formular el modelo de regresión lineal para que la técnica OLS sea aplicable. Cada una de estas configuraciones produce las mismas fórmulas y los mismos resultados. La única diferencia es la interpretación y los supuestos que deben imponerse para que el método dé resultados significativos. La elección del marco aplicable depende principalmente de la naturaleza de los datos disponibles y de la tarea de inferencia que debe realizarse.

Una de las líneas de diferencia en la interpretación es si se deben tratar los regresores como variables aleatorias o como constantes predefinidas. En el primer caso (diseño aleatorio), los regresores xi son aleatorios y se muestrean junto con el yi's de alguna población, como en un estudio observacional. Este enfoque permite un estudio más natural de las propiedades asintóticas de los estimadores. En la otra interpretación (diseño fijo), los regresores X se tratan como constantes conocidas establecidas por un diseño, y y se muestrea condicionalmente en el valores de X como en un experimento. Para fines prácticos, esta distinción a menudo no es importante, ya que la estimación y la inferencia se llevan a cabo condicionando X. Todos los resultados indicados en este artículo están dentro del marco de diseño aleatorio.

Modelo clásico de regresión lineal

El modelo clásico se centra en la "muestra finita" estimación e inferencia, lo que significa que el número de observaciones n es fijo. Esto contrasta con los otros enfoques, que estudian el comportamiento asintótico de MCO y en los que se estudia el comportamiento en un gran número de muestras.

- Especificación correcta. La forma funcional lineal debe coincidir con la forma del proceso de generación de datos real.

- Exogeneidad estricta. Los errores en la regresión deben tener una media condicional cero:La consecuencia inmediata de la suposición de exogeneidad es que los errores tienen significado cero: E[E]ε= 0 (para la ley de la expectativa total), y que los regresores no están relacionados con los errores: E[E]XTε= 0. La suposición de exogeneidad es crítica para la teoría de la OLS. Si se sostiene entonces las variables del regresión se llaman exógeno. Si no lo hace, entonces se llama a los regredes que están correlacionados con el término de error endógeno, y el estimador OLS se bifurca. En tal caso se puede utilizar el método de variables instrumentales para realizar inferencia.E [ε ε ▪ ▪ X]=0.{displaystyle operatorname {E} [,varepsilon mid X,]=0.}

- No hay dependencia lineal. Los rebeldes en X Todos deben ser linealmente independientes. Matemáticamente, esto significa que la matriz X debe tener rango completo de columna casi seguro:Por lo general, también se asume que los regentes tienen momentos finitos hasta al menos el segundo momento. Entonces la matriz Qxx EXTX/n] es finito y positivo semi-definido. Cuando esta suposición es violada, los regresores son llamados linealmente dependientes o perfectamente multicolores. En tal caso el valor del coeficiente de regresión β no se puede aprender, aunque la predicción Sí. valores todavía es posible para nuevos valores de los regredores que se encuentran en el mismo subespacio dependiente linealmente.Pr[rango ()X)=p]=1.{displaystyle Pr !{big [},operatorname {rank} (X)=p,{big ]}=1.}

- Errores esféricos:Donde In es la matriz de identidad en dimensión n, y σ2 es un parámetro que determina la varianza de cada observación. Esto σ2 se considera un parámetro de molestia en el modelo, aunque por lo general también se estima. Si se viola esta hipótesis, las estimaciones de la OLS siguen siendo válidas, pero ya no son eficientes. Es habitual dividir esta hipótesis en dos partes:Var [ε ε ▪ ▪ X]=σ σ 2In,{displaystyle operatorname {Var} [,varepsilon mid X,]=sigma ^{2}I_{n}

- Homoscedasticidad: E[E]εi2SilencioX= σ2, lo que significa que el término de error tiene la misma varianza σ2 en cada observación. Cuando se viola este requisito se llama heteroscedasticidad, en tal caso un estimador más eficiente sería ponderado menos cuadrados. Si los errores tienen una varianza infinita, las estimaciones de la OLS también tendrán una varianza infinita (aunque por la ley de números grandes, no obstante, tenderán hacia los valores verdaderos siempre y cuando los errores tengan una media cero). En este caso, se recomiendan técnicas de estimación robustas.

- No autocorrelación: los errores no están relacionados entre las observaciones: E[E]εiεjSilencioX= 0 para i ل j. Este supuesto puede ser violado en el contexto de datos de series temporales, datos de panel, muestras de racimo, datos jerárquicos, datos repetidos de medidas, datos longitudinales y otros datos con dependencias. En tales casos, los mínimos cuadrados generalizados ofrecen una mejor alternativa que el OLS. Otra expresión para la autocorrelación es correlación serial.

- Normalidad. A veces se supone, además, que los errores tienen una distribución normal condicionada a los agresores:Esta suposición no es necesaria para la validez del método OLS, aunque algunas propiedades de muestreo finito adicional pueden establecerse en caso de que lo haga (especialmente en el área de pruebas de hipótesis). También cuando los errores son normales, el estimador OLS es equivalente al estimador de probabilidad máxima (MLE), y por lo tanto es asintoticamente eficiente en la clase de todos los estimadores regulares. Importantly, the normality assumed applies only to the error terms; contrary to a popular misconception, the response ( dependent) variable is not required to be normally distributed.ε ε ▪ ▪ X♪ ♪ N()0,σ σ 2In).{displaystyle varepsilon mid Xsim {mathcal {N}(0,sigma ^{2}I_{n}).}

Independiente e idénticamente distribuido (iid)

En algunas aplicaciones, especialmente con datos transversales, se impone una suposición adicional: que todas las observaciones son independientes y están distribuidas de manera idéntica. Esto significa que todas las observaciones se toman de una muestra aleatoria, lo que hace que todos los supuestos enumerados anteriormente sean más simples y fáciles de interpretar. Además, este marco permite enunciar resultados asintóticos (como el tamaño de la muestra n → ∞), que se entienden como una posibilidad teórica de obtener nuevas observaciones independientes. del proceso de generación de datos. La lista de supuestos en este caso es:

- iid observations#xi, Sí.i) es independiente de, y tiene la misma distribución que, (xj, Sí.j) para todos i;

- no perfecta multicollinearidad: Qxx ExixiT] es una matriz definitiva positiva;

- exogeneity: E[E]εiSilencioxi] = 0;

- homoscedasticidad: Var[εiSilencioxi= σ2.

Modelo de series temporales

- El proceso estocástico {xi, Sí.i} es estacionario y ergodic; si {xi, Sí.i} es no estacionario, los resultados de OLS son a menudo espurios a menos que {xi, Sí.iEstá co-integrando.

- Los rebeldes son predeterminadoExiεi= 0 para todos i = 1,... n;

- El p×p matriz Qxx ExixiT] es de rango completo, y por lo tanto positivo-definido;

- {}xiεi} es una secuencia de diferencia de martingale, con una matriz finita de segundos momentos Qxxε2 Eεi2xixiT].

Propiedades de muestras finitas

Primero, bajo el Exogeneidad estricta suposición de los estimadores de la OLS β β ^ ^ {displaystyle scriptstyle {hat {beta } y s2 son imparciales, lo que significa que sus valores esperados coinciden con los verdaderos valores de los parámetros:[prueba]

- E [β β ^ ^ ▪ ▪ X]=β β ,E [s2▪ ▪ X]=σ σ 2.{displaystyle operatorname {E} [,{hat {beta] ♪♪ X,]=betaquad operatorname {E} X,]=sigma ^{2}

Si la exogeneidad estricta no se cumple (como es el caso de muchos modelos de series temporales, donde se supone exogeneidad sólo con respecto a las crisis pasadas pero no a las futuras), entonces estos estimadores estarán sesgados en muestras finitas.

El matriz de diferencias (o simplemente matriz de covariancia) de β β ^ ^ {displaystyle scriptstyle {hat {beta } es igual a

- Var [β β ^ ^ ▪ ▪ X]=σ σ 2()XTX)− − 1=σ σ 2Q.{displaystyle operatorname {Var} [,{hat {beta] ♪♪ X,]=sigma ^{2}left(X^{operatorname ¿Qué?

En particular, el error estándar de cada coeficiente β β ^ ^ j{displaystyle scriptstyle {hat {beta } es igual a raíz cuadrada de la j- el elemento diagonal de esta matriz. La estimación de este error estándar se obtiene reemplazando la cantidad desconocida σ2 con su estimación s2. Así,

- s.e.^ ^ ()β β ^ ^ j)=s2()XTX)jj− − 1{fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} - Sí.

También se puede mostrar fácilmente que el estimador β β ^ ^ {displaystyle scriptstyle {hat {beta } no está relacionado con los residuos del modelo:

- Cov [β β ^ ^ ,ε ε ^ ^ ▪ ▪ X]=0.{displaystyle operatorname {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif}=0}

El Gauss – Markov teorem declara que bajo errores esféricos suposición (es decir, los errores deben ser incorrelacionados y homoscedastic) el estimador β β ^ ^ {displaystyle scriptstyle {hat {beta } es eficiente en la clase de estimadores lineales imparciales. Esto se llama best linear unbiased estimator (BUE). La eficiencia debe entenderse como si fuéramos a encontrar otro estimador β β ~ ~ {displaystyle scriptstyle {tilde {beta } que sería lineal en Sí. y imparciales, entonces

- Var [β β ~ ~ ▪ ▪ X]− − Var [β β ^ ^ ▪ ▪ X]≥ ≥ 0{displaystyle operatorname {Var} [,{tilde {beta] ♪♪ X,]- [,{hat {beta] }mid X,]geq 0}

en el sentido de que se trata de una matriz definida no negativa. Este teorema establece la optimización sólo en la clase de estimadores lineales insesgados, lo cual es bastante restrictivo. Dependiendo de la distribución de los términos de error ε, otros estimadores no lineales pueden proporcionar mejores resultados que MCO.

Asumiendo normalidad

Todas las propiedades enumeradas hasta ahora son válidas independientemente de la distribución subyacente de los términos de error. Sin embargo, si está dispuesto a asumir que el supuesto de normalidad se cumple (es decir, que ε ~ N (0, σ2In)), entonces se pueden obtener propiedades adicionales de los estimadores MCO. expresarse.

El estimador β β ^ ^ {displaystyle scriptstyle {hat {beta } se distribuye normalmente, con media y varianza como se indica antes:

- β β ^ ^ ♪ ♪ N()β β , σ σ 2()XTX)− − 1).{displaystyle {hat {beta} sim {mathcal {N}{big (}beta sigma ^{2}(X^{mathrm {T}X)^{-1}{big)}}

Este estimador alcanza el límite de Cramér-Rao para el modelo y, por lo tanto, es óptimo en la clase de todos los estimadores insesgados. Tenga en cuenta que, a diferencia del teorema de Gauss-Markov, este resultado establece la optimización entre estimadores lineales y no lineales, pero sólo en el caso de términos de error normalmente distribuidos.

El estimador s2 será proporcional a la distribución chi-cuadrado:

- s2 ♪ ♪ σ σ 2n− − p⋅ ⋅ χ χ n− − p2{displaystyle s^{2}\sim {frac {sigma ^{2} {n-p}cdot chi _{n-p} {2}

La diferencia de este calculador es igual a 2σ4/(n−p), que no alcanza el límite Cramér-Rao 2σ4/n. Sin embargo, se demostró que no hay estimadores imparciales σ2 con diferencia menor que la del estimador s2. Si estamos dispuestos a permitir estimadores parciales, y considerar la clase de estimadores que son proporcionales a la suma de residuos cuadrados (SSR) del modelo, entonces el mejor (en el sentido del error cuadrado medio) estimador en esta clase será ~σ2 SSR/()n−p+ 2), que incluso golpea al Cramér-Rao en caso de que sólo haya un regresión (p = 1).

Además, los estimadores β β ^ ^ {displaystyle scriptstyle {hat {beta } y s2 son independientes, el hecho que viene en utilidad al construir las pruebas t- y F para la regresión.

Observaciones influyentes

Como se mencionó anteriormente, el estimador β β ^ ^ {displaystyle {hat {beta } es lineal en Sí., lo que significa que representa una combinación lineal de las variables dependientes Sí.i. Los pesos en esta combinación lineal son funciones de los regresores X, y generalmente son desiguales. Las observaciones con pesos altos se llaman influyente porque tienen un efecto más pronunciado sobre el valor del estimador.

Para analizar qué observaciones son influyentes, eliminamos una j-ésima observación específica y consideramos cuánto van a cambiar las cantidades estimadas (de manera similar al método jackknife). Se puede demostrar que el cambio en el estimador MCO para β será igual a

- β β ^ ^ ()j)− − β β ^ ^ =− − 11− − hj()XTX)− − 1xjTε ε ^ ^ j,{fnMicrosoft Sans Serif} }=-{frac [1}{1-h_{j}} {X^{mathrm {T}X)^{-1}x_{j}{mathrm {T}{hat {varepsilon }_{j},}

Donde hj = xjT()XTX)−1xj es j- el elemento diagonal de la matriz de sombrero P, y xj es el vector de los regresores correspondientes al j-a observación. Del mismo modo, el cambio en el valor predicho para j-la observación resultante de omitir esa observación del conjunto de datos será igual a

- Sí.^ ^ j()j)− − Sí.^ ^ j=xjTβ β ^ ^ ()j)− − xjTβ β ^ ^ =− − hj1− − hjε ε ^ ^ j{fnMicrosoft Sans Serif} {y}_{j}=x_{j}{mathrm {T}{hat {beta} ### {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {T}{hat {beta} }=-{frac {h_{j}{1-h_{j}},{hat {varepsilon }

De las propiedades de la matriz hat, 0 ≤ hj ≤ 1, y suman p, de modo que en promedio hj ≈ p/n. Estas cantidades hj se denominan apalancamiento y las observaciones con alto hj se denominan puntos de apalancamiento. Por lo general, las observaciones con un alto apalancamiento deberían examinarse más cuidadosamente, en caso de que sean erróneas, o sean atípicas, o de alguna otra manera atípicas del resto del conjunto de datos.

Regresión particionada

A veces las variables y los parámetros correspondientes en la regresión pueden dividirse lógicamente en dos grupos, de modo que la regresión tome forma

- Sí.=X1β β 1+X2β β 2+ε ε ,{displaystyle Y=X_{1}beta ###{1}+X_{2}beta ¿Qué?

donde X1 y X2 tienen dimensiones n×p1, n×p2 y β 1, β2 son p1×1 y p2×1 vectores, con p1 + p2 = p.

El Frisch–Waugh–Lovell theorem declara que en esta regresión los residuos ε ε ^ ^ {displaystyle {hat {varepsilon}}} y la estimación de la OLS β β ^ ^ 2{displaystyle scriptstyle {hat {beta }_{2} será numéricamente idéntica a los residuos y la estimación OLS para β2 en la siguiente regresión:

- M1Sí.=M1X2β β 2+. . ,{displaystyle M_{1}y=M_{1}X_{2}beta ¿Qué?

donde M1 es la matriz aniquiladora para los regresores X1.

El teorema se puede utilizar para establecer una serie de resultados teóricos. Por ejemplo, tener una regresión con una constante y otro regresor equivale a restar las medias de la variable dependiente y el regresor y luego ejecutar la regresión para las variables desmediadas pero sin el término constante.

Estimación restringida

Supongamos que se sabe que los coeficientes de la regresión satisfacen un sistema de ecuaciones lineales

- A:: QTβ β =c,{displaystyle Acolon quad Q^{operatorname {T}beta =c,,}

donde Q es una matriz p×q de rango completo y c es una q×1 vector de constantes conocidas, donde q < p. En este caso la estimación de mínimos cuadrados equivale a minimizar la suma de los residuos cuadrados del modelo sujeto a la restricción A. El estimador de mínimos cuadrados restringidos (CLS) puede obtenerse mediante una fórmula explícita:

- β β ^ ^ c=β β ^ ^ − − ()XTX)− − 1Q()QT()XTX)− − 1Q)− − 1()QTβ β ^ ^ − − c).{displaystyle {hat {beta }{c}={hat {beta }-(X^{operatorname [T] }X)^{-1}Q{ Grande. [T] }(X^{operatorname [T} }X)^{-1}Q{Big]}{-1}(Q^{operatorname) {T}{hat {beta} }-c).}

Esta expresión para el estimador restringido es válida siempre que la matriz XTX sea invertible. Desde el principio de este artículo se supuso que esta matriz tiene rango completo y se observó que cuando la condición de rango falla, β no será identificable. Sin embargo, puede suceder que agregar la restricción A haga que β sea identificable, en cuyo caso nos gustaría encontrar la fórmula para el estimador. El estimador es igual a

- β β ^ ^ c=R()RTXTXR)− − 1RTXTSí.+()Ip− − R()RTXTXR)− − 1RTXTX)Q()QTQ)− − 1c,{displaystyle {hat {beta ################################################################################################################################################################################################################################################################ [T] }X^{ nombre del operador [T] }XR)^{-1}R^{operatorname [T] }X^{ nombre del operador {T} }y+{Big (}I_{p}-R(R^{fone [T] }X^{ nombre del operador [T] }XR)^{-1}R^{operatorname [T] }X^{ nombre del operador [T] }X{Big)}Q(Q^{operatorname {T} }Q)^{-1}c, }

Donde R es un p×p − q) matriz tal que la matriz [Q R] no es fijo, y RTQ = 0. Tal matriz siempre se puede encontrar, aunque generalmente no es única. La segunda fórmula coincide con la primera en caso de que XTX es invertible.

Propiedades de gran muestra

Los estimadores de mínimos cuadrados son estimaciones puntuales de los parámetros del modelo de regresión lineal β. Sin embargo, en general también queremos saber qué tan cerca podrían estar esas estimaciones de los valores reales de los parámetros. En otras palabras, queremos construir estimaciones de intervalo.

Ya que no hemos hecho ninguna suposición sobre la distribución del término de error εi, es imposible inferir la distribución de los estimadores β β ^ ^ {displaystyle {hat {beta } y σ σ ^ ^ 2{displaystyle {hat {sigma} } {2}. Sin embargo, podemos aplicar el teorema límite central para derivar su asintotic propiedades como tamaño de muestra n va al infinito. Aunque el tamaño de la muestra es necesariamente finito, es habitual asumir que n es " suficientemente grande" para que la verdadera distribución del estimador OLS esté cerca de su límite asintotico.

Podemos demostrar que bajo los supuestos modelo, el estimador menos cuadrados para β es consistente (eso es β β ^ ^ {displaystyle {hat {beta } converge en probabilidad de β) y asintotically normal:[prueba]

- ()β β ^ ^ − − β β ) →d N()0,σ σ 2Qxx− − 1),{displaystyle ({hat {beta}-beta) {xrightarrow {d} {fnMitcal {fn}{big}0,;sigma ^{2}Q_{xx}{-1}{big)}}}}

Donde Qxx=XTX.{displaystyle Q_{xx}=X^{operatorname - Sí.

Intervalos

Usando esta distribución asintotica, intervalos de confianza aproximados de dos caras para los j-to componente del vector β β ^ ^ {displaystyle {hat {beta } se puede construir como

- β β j▪ ▪ [ β β ^ ^ j± ± q1− − α α 2N()0,1)σ σ ^ ^ 2[Qxx− − 1]jj ]{displaystyle beta _{j}in {bigg [] {beta} }_{j}pm q_{1-{frac {fnMicrosoft} {fnMitcal {fnh} {fnMicrosoft Sans Serif} {fnMicrosoft {fnMicrosoft {fnMicrosoft Sans Serif} {fnMicrosoft Sans} {fnMicrosoft {f} {fnMicrosoft {fnMicrosoft Sans} {f}}}}} {f}}}}}}} {f}}}}}}}}}} {f}}}}}}}} {\\f}}}}}\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\fnMitH0}\\\\\\\\\\\\\\ }{2}left [Q_{xx} {-1}right] {bigg}} en el 1 − α nivel de confianza,

donde q denota la función cuantil de la distribución normal estándar y [·]jj es el j -ésimo elemento diagonal de una matriz.

Del mismo modo, el estimador de mínimos cuadrados para σ2 también es consistente y asintóticamente normal (siempre que el cuarto momento de εi>i> existe) con distribución limitante

- ()σ σ ^ ^ 2− − σ σ 2) →d N()0,E [ε ε i4]− − σ σ 4).{displaystyle ({hat {sigma }{2}-sigma ^{2} {xrightarrow {d} {fnK}left(0,;fncipi} left[varepsilon] ¿Qué? }

Estas distribuciones asintoticas se pueden utilizar para predicción, pruebas de hipótesis, construcción de otros estimadores, etc. Como ejemplo, considere el problema de la predicción. Suppose x0{displaystyle x_{0} es un punto dentro del dominio de la distribución de los regresores, y uno quiere saber cuál sería la variable de respuesta en ese punto. La respuesta media es la cantidad Sí.0=x0Tβ β {displaystyle Y... {T}beta }, mientras que la respuesta prevista es Sí.^ ^ 0=x0Tβ β ^ ^ {displaystyle {hat {f}_{0}=x_{0}{m} {fnhm} {T}{hat {beta} }. Claramente la respuesta predicha es una variable aleatoria, su distribución puede derivarse de la de β β ^ ^ {displaystyle {hat {beta }:

- ()Sí.^ ^ 0− − Sí.0) →d N()0,σ σ 2x0TQxx− − 1x0),{displaystyle left({hat {y}_{0}-y_{0}right) {xrightarrow {d} {fnMitcal {fn}left(0,;sigma ^{2}x_{0}{mathrm {T} }Q_{xx}{-1}x_{0}right),}

que permite construir intervalos de confianza para la respuesta media Sí.0{displaystyle Y... a construir:

- Sí.0▪ ▪ [ x0Tβ β ^ ^ ± ± q1− − α α 2N()0,1)σ σ ^ ^ 2x0TQxx− − 1x0 ]{displaystyle y_{0}in left[] x_{0}{mathrm {T}{hat {beta} }pm q_{1-{frac {fnMicrosoft} {fnMitcal {fnh} {fnMicrosoft Sans Serif} {fnMicrosoft {fnMicrosoft {fnMicrosoft Sans Serif} {fnMicrosoft Sans} {fnMicrosoft {f} {fnMicrosoft {fnMicrosoft Sans} {f}}}}} {f}}}}}}} {f}}}}}}}}}} {f}}}}}}}} {\\f}}}}}\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\\fnMitH0}\\\\\\\\\\\\\\ }{2}x_{0} {mathrm {T}Q_{xx}{-1}x_{0}} {cHFF}} en el 1 − α nivel de confianza.

Prueba de hipótesis

Dos pruebas de hipótesis se utilizan particularmente ampliamente. Primero, uno quiere saber si la ecuación de regresión estimada es mejor que simplemente predecir que todos los valores de la variable de respuesta son iguales a su media muestral (si no, se dice que no tiene poder explicativo). La hipótesis nula de que la regresión estimada no tiene valor explicativo se prueba mediante una prueba F. Si se encuentra que el valor F calculado es lo suficientemente grande como para exceder su valor crítico para el nivel de significancia elegido previamente, se rechaza la hipótesis nula y se acepta la hipótesis alternativa de que la regresión tiene poder explicativo. En caso contrario, se acepta la hipótesis nula de falta de poder explicativo.

En segundo lugar, para cada variable explicativa de interés, uno quiere saber si su coeficiente estimado difiere significativamente de cero, es decir, si esta variable explicativa particular de hecho tiene poder explicativo para predecir la variable de respuesta. Aquí la hipótesis nula es que el coeficiente verdadero es cero. Esta hipótesis se prueba calculando el estadístico t del coeficiente, como la relación entre la estimación del coeficiente y su error estándar. Si el estadístico t es mayor que un valor predeterminado, se rechaza la hipótesis nula y se encuentra que la variable tiene poder explicativo, con su coeficiente significativamente diferente de cero. En caso contrario, se acepta la hipótesis nula de un valor cero del coeficiente verdadero.

Además, la prueba de Chow se utiliza para comprobar si dos submuestras tienen los mismos valores de coeficientes verdaderos subyacentes. La suma de los residuos cuadrados de las regresiones en cada uno de los subconjuntos y en el conjunto de datos combinado se compara calculando un estadístico F; si éste excede un valor crítico, se rechaza la hipótesis nula de que no hay diferencia entre los dos subconjuntos; en caso contrario, se acepta.

Ejemplo con datos reales

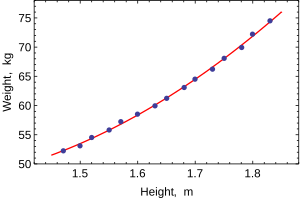

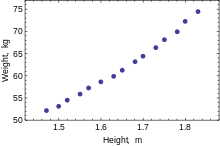

El siguiente conjunto de datos proporciona alturas y pesos promedio para mujeres estadounidenses de entre 30 y 39 años (fuente: The World Almanac and Book of Facts, 1975).

Cuando solo se modela una variable dependiente, un diagrama de dispersión sugerirá la forma y la fuerza de la relación entre la variable dependiente y los regresores. También podría revelar valores atípicos, heterocedasticidad y otros aspectos de los datos que pueden complicar la interpretación de un modelo de regresión ajustado. El diagrama de dispersión sugiere que la relación es fuerte y puede aproximarse como una función cuadrática. OLS puede manejar relaciones no lineales introduciendo el regresor HEIGHT2. El modelo de regresión se convierte entonces en un modelo lineal múltiple:

- wi=β β 1+β β 2hi+β β 3hi2+ε ε i.{displaystyle ¿Qué? ¿Qué? - ¿Qué? ¿Qué? _{i}

El resultado de los paquetes estadísticos más populares será similar a este:

Método Menos cuadrados Variante dependiente NOSOTROS Observaciones 15 Parámetro Valor Error Std t-estadística p-value β β 1{displaystyle beta ¿Qué? 128.8128 16.3083 7.8986 0,0000 β β 2{displaystyle beta _{2} –143.1620 19.8332 –7.2183 0,0000 β β 3{displaystyle beta ¿Qué? 61.9603 6.0084 10.3122 0,0000 R2 0.9989 S.E. of regression 0,2516 Ajuste R2 0.9987 Modelo de suma de cuadra. 692.61 Log-likelihood 1.0890 Residual sum-of-sq. 0,7595 Durbin-Watson stat. 2.1013 Total suma de cuadra. 693.37 Akaike criterion 0,2548 F-estadística 5471.2 criterio de Schwarz 0,364 p-valor (F-stat) 0,0000

En esta tabla:

- El Valor columna da las estimaciones menos cuadrados de parámetros βj

- El Error Std columna muestra errores estándar de cada estimación del coeficiente: σ σ ^ ^ j=()σ σ ^ ^ 2[Qxx− − 1]jj)12{displaystyle {hat {sigma} }_{j}=left({hat {sigma ¿Por qué? {1}{2}}}

- El t-estadística y p-value Las columnas están probando si alguno de los coeficientes podría ser igual a cero. El t-Estadística se calcula simplemente como t=β β ^ ^ j/σ σ ^ ^ j{displaystyle T={hat {beta }_{j}/{hat {sigma }. Si los errores ε siguen una distribución normal, t sigue una distribución de Student-t. En condiciones más débiles, t es asintoticamente normal. Valores grandes de t indicar que la hipótesis nula puede ser rechazada y que el coeficiente correspondiente no es cero. La segunda columna, p-valor, expresa los resultados de la prueba de hipótesis como un nivel de significación. Convencionalmente, p- los valores menores de 0,05 se toman como prueba de que el coeficiente de población no es cero.

- R-squared es el coeficiente de determinación que indica la bondad del beneficio de la regresión. Esta estadística será igual a una si el ajuste es perfecto, y a cero cuando los regredores X No tienen ningún poder explicativo. Esta es una estimación parcial de la población R-squared, y nunca disminuirá si se añaden regredores adicionales, incluso si son irrelevantes.

- Ajustado R-squared es una versión ligeramente modificada R2{displaystyle R^{2}, diseñado para penalizar por el exceso de regresión que no suma al poder explicativo de la regresión. Esta estadística es siempre más pequeña que R2{displaystyle R^{2}, puede disminuir a medida que se añaden nuevos retrocesores, e incluso ser negativo para los modelos deficientemente adecuados:

- R̄ ̄ 2=1− − n− − 1n− − p()1− − R2){displaystyle {overline {}}{2}=1-{frac} {n-1}{n-p}(1-R^{2}}

- Log-likelihood se calcula bajo el supuesto de que los errores siguen la distribución normal. Aunque la suposición no es muy razonable, esta estadística todavía puede encontrar su uso en la realización de pruebas de RL.

- Estatística de Durbin-Watson prueba si hay alguna evidencia de correlación serial entre los residuos. Como regla de pulgar, el valor menor a 2 será una evidencia de correlación positiva.

- Akaike information criterion y criterio de Schwarz ambos se utilizan para la selección de modelos. Generalmente al comparar dos modelos alternativos, los valores más pequeños de uno de estos criterios indicarán un mejor modelo.

- Error estándar de regresión es una estimación de σ, error estándar del término de error.

- Total suma de plazas, modelo suma de cuadrado, y suma residual de plazas díganos cuánto de la variación inicial de la muestra se explicó por la regresión.

- F-estadística Intenta probar la hipótesis de que todos los coeficientes (excepto la interceptación) son iguales a cero. Esta estadística tiene F()p–1,n-p) distribución bajo la hipótesis nula y la suposición de normalidad, y su p-value indica la probabilidad de que la hipótesis sea verdadera. Tenga en cuenta que cuando los errores no son normales esta estadística se vuelve inválida, y deben usarse otras pruebas como la prueba Wald o la prueba LR.

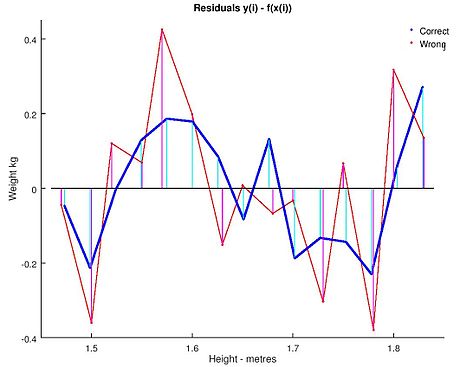

El análisis de mínimos cuadrados ordinario a menudo incluye el uso de gráficos de diagnóstico diseñados para detectar desviaciones de los datos de la forma supuesta del modelo. Estas son algunas de las gráficas de diagnóstico comunes:

- Residuals contra las variables explicativas del modelo. Una relación no lineal entre estas variables sugiere que la linealidad de la función media condicional puede no mantener. Diferentes niveles de variabilidad en los residuos para diferentes niveles de las variables explicativas sugieren posible heteroscedasticidad.

- Residuals contra variables explicativas no en el modelo. Cualquier relación de los residuos a estas variables sugeriría considerar estas variables para su inclusión en el modelo.

- Residuals contra los valores ajustados, Sí.^ ^ {displaystyle {hat {y}}}.

- Residuals against the preceding residual. Esta trama puede identificar correlaciones en serie en los residuos.

Una consideración importante al realizar inferencias estadísticas utilizando modelos de regresión es cómo se muestrearon los datos. En este ejemplo, los datos son promedios en lugar de mediciones de mujeres individuales. El ajuste del modelo es muy bueno, pero esto no implica que el peso de una mujer individual pueda predecirse con gran precisión basándose únicamente en su altura.

Sensibilidad al redondeo

Este ejemplo también demuestra que los coeficientes determinados por estos cálculos son sensibles a cómo se preparan los datos. Las alturas se redondearon originalmente a la pulgada más cercana y se convirtieron y redondearon al centímetro más cercano. Dado que el factor de conversión es de una pulgada a 2,54 cm, esta no es una conversión exacta. Las pulgadas originales se pueden recuperar mediante Round(x/0.0254) y luego volver a convertirlas al sistema métrico sin redondear. Si se hace esto los resultados serán:

| Const | Altura | Altura2 | |

|---|---|---|---|

| Convertido en métrica con redondeo. | 128.8128 | −143.162 | 61.96033 |

| Convertirse en métrica sin redondeo. | 119.0205 | −131.5076 | 58.5046 |

Usando cualquiera de estas ecuaciones para predecir el peso de un 5' 6" (1,6764 m) la mujer da valores similares: 62,94 kg con redondeo vs. 62,98 kg sin redondeo. Así, una variación aparentemente pequeña en los datos tiene un efecto real en los coeficientes, pero un efecto pequeño en los resultados de la ecuación.

Si bien esto puede parecer inocuo en el medio del rango de datos, podría volverse significativo en los extremos o en el caso en que el modelo ajustado se utiliza para proyectar fuera del rango de datos (extrapolación).

Esto resalta un error común: este ejemplo es un abuso de MCO que inherentemente requiere que los errores en la variable independiente (en este caso, altura) sean cero o al menos insignificantes. El redondeo inicial a la pulgada más cercana más cualquier error de medición real constituye un error finito y no despreciable. Como resultado, los parámetros ajustados no son las mejores estimaciones que se supone que son. Aunque no es totalmente espurio, el error en la estimación dependerá del tamaño relativo de los errores x e y.

Otro ejemplo con menos datos reales

Enunciado del problema

Podemos utilizar el mecanismo menos cuadrado para determinar la ecuación de una órbita de dos cuerpos en coordenadas de base polar. La ecuación típicamente utilizada es r()Silencio Silencio )=p1− − e# ()Silencio Silencio ){displaystyle r(theta)={1-ecos(theta)}} Donde r()Silencio Silencio ){displaystyle r(theta)} es el radio de cuán lejos está el objeto de uno de los cuerpos. En la ecuación los parámetros p{displaystyle p} y e{displaystyle e} se utilizan para determinar el camino de la órbita. Hemos medido los siguientes datos.

| Silencio Silencio {displaystyle theta } (en grados) | 43 | 45 | 52 | 93 | 108 | 116 |

|---|---|---|---|---|---|---|

| r()Silencio Silencio ){displaystyle r(theta)} | 4.7126 | 4.5542 | 4.0419 | 2.2187 | 1.8910 | 1.7599 |

Necesitamos encontrar la aproximación de los mínimos cuartos e{displaystyle e} y p{displaystyle p} para los datos dados.

Solución

Primero necesitamos representar e y p en forma lineal. Así que vamos a reescribir la ecuación r()Silencio Silencio ){displaystyle r(theta)} como 1r()Silencio Silencio )=1p− − ep# ()Silencio Silencio ){displaystyle {frac {1}{theta}}={frac {1}{}-{frac {e}cos(theta)}. Además, uno podría caber para las apsides expandiendo # ()Silencio Silencio ){displaystyle cos(theta)} con un parámetro extra como # ()Silencio Silencio − − Silencio Silencio 0)=# ()Silencio Silencio )# ()Silencio Silencio 0)+pecado ()Silencio Silencio )pecado ()Silencio Silencio 0){displaystyle cos(theta -theta _{0})=cos(theta)cos(theta _{0})+sin(theta)sin(theta _{0})}, que es lineal en ambos # ()Silencio Silencio ){displaystyle cos(theta)} y en la función adicional pecado ()Silencio Silencio ){displaystyle sin(theta)}, usado para extra # Silencio Silencio 0=pecado ()Silencio Silencio 0)/# ()Silencio Silencio 0){displaystyle tan theta ¿Por qué?. Utilizamos el formulario original de dos parámetros para representar nuestros datos observacionales como:

ATA()xSí.)=ATb{displaystyle A.A. {x} {y}=A^{T}b} Donde x{displaystyle x} es 1p{fnMicroc} {1}{p}} y Sí.{displaystyle y} es ep{displaystyle {frac {e}{p}} y A{displaystyle A} es construido por la primera columna siendo el coeficiente de 1p{fnMicroc} {1}{p}} y la segunda columna siendo el coeficiente ep{displaystyle {frac {e}{p}} y b{displaystyle b} es los valores para los respectivos 1r()Silencio Silencio ){displaystyle {frac {1} {theta}}}} Así que... A=[1− − 0,713541− − 0,071071− − 0.6156611 0,05233610.30901710.438371]{displaystyle A={begin{bmatrix}1 punto-0.7313541 punto-0.7071071 punto-0.6156611 tercero1 tercero 0,0523361 tercero0.3090171 tercero0.438371end{bmatrix}}}}}} y b=[0.212200.219580,247410.450710,28830,56820].{displaystyle b={begin{bmatrix}0.21220.21958.24741.45071.52883.56820end{bmatrix}.}

En la solución tenemos ()xSí.)=()0.434780,0435){binom} {binom}}} {binom {0.43478}{0.30435}}}}

Así que... p=1x=2.3000{displaystyle p={frac}=2.3000} y e=p⋅ ⋅ Sí.=0,701{displaystyle e=pcdot y=0.70001}

![{displaystyle mathbf {x} _{i}=left[x_{i1},x_{i2},dotsx_{ip}right]^{operatorname {T} }}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3278872b5bdb53e6af3474d92e9926c0238e8935)

![{displaystyle {begin{aligned}{widehat {beta }}&={frac {sum _{i=1}^{n}{(x_{i}-{bar {x}})(y_{i}-{bar {y}})}}{sum _{i=1}^{n}{(x_{i}-{bar {x}})^{2}}}}\[2pt]{widehat {alpha }}&={bar {y}}-{widehat {beta }},{bar {x}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/932c6407f7ceba533fef69961fe504fc3b565e1e)

![{displaystyle [mathbf {X} mathbf {K} ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2ac770308f79814997ffbdfd971621c67b76aef6)

![{displaystyle mathrm {E} {big [},x_{i}left(y_{i}-x_{i}^{operatorname {T} }beta right),{big ]}=0.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1d7894c141dad7e6dae3aed8bb708aada174daf2)

![{displaystyle operatorname {E} [,varepsilon mid X,]=0.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dcdfa07f07180573874658708bc2a889d5416199)

![{displaystyle Pr !{big [},operatorname {rank} (X)=p,{big ]}=1.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6a11be3b89ce51c6441155fddbe512a991132fbf)

![{displaystyle operatorname {Var} [,varepsilon mid X,]=sigma ^{2}I_{n},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0df70427bd7e0b69175caf9150b2d465dd152474)

![{displaystyle operatorname {E} [,{hat {beta }}mid X,]=betaquad operatorname {E} [,s^{2}mid X,]=sigma ^{2}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/67bc2fd0f90c46da207712893fdcea01e729026c)

![{displaystyle operatorname {Var} [,{hat {beta }}mid X,]=sigma ^{2}left(X^{operatorname {T} }Xright)^{-1}=sigma ^{2}Q.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/08f6cb596d94073731ee47f4a2571dbbfc1d214a)

![{displaystyle operatorname {Cov} [,{hat {beta }},{hat {varepsilon }}mid X,]=0.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/664c1a5e37957a1aa2ae381b9bcb07350c2c816c)

![{displaystyle operatorname {Var} [,{tilde {beta }}mid X,]-operatorname {Var} [,{hat {beta }}mid X,]geq 0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/53796c9205889cc4d675b9749a58eb97fcd998f1)

![{displaystyle beta _{j}in {bigg [} {hat {beta }}_{j}pm q_{1-{frac {alpha }{2}}}^{{mathcal {N}}(0,1)}!{sqrt {{hat {sigma }}^{2}left[Q_{xx}^{-1}right]_{jj}}} {bigg ]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cf79688aac9f662ff39253fbfb0d234246d370e5)

![{displaystyle ({hat {sigma }}^{2}-sigma ^{2}) {xrightarrow {d}} {mathcal {N}}left(0,;operatorname {E} left[varepsilon _{i}^{4}right]-sigma ^{4}right).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7c909dea2a4f0bf40e253680b953d1bfbb66298f)

![{displaystyle y_{0}in left[ x_{0}^{mathrm {T} }{hat {beta }}pm q_{1-{frac {alpha }{2}}}^{{mathcal {N}}(0,1)}!{sqrt {{hat {sigma }}^{2}x_{0}^{mathrm {T} }Q_{xx}^{-1}x_{0}}} right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cf86d7a311c97d35fb6e039c3cd74bc9f3e752bf)

![{displaystyle {hat {sigma }}_{j}=left({hat {sigma }}^{2}left[Q_{xx}^{-1}right]_{jj}right)^{frac {1}{2}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5087e66171bf3ef9ad3ac75decdd715274919669)