Métodos numéricos para ecuaciones diferenciales ordinarias

Los métodos numéricos para ecuaciones diferenciales ordinarias son métodos utilizados para encontrar aproximaciones numéricas a las soluciones de ecuaciones diferenciales ordinarias (EDO). Su uso también se conoce como "integración numérica", aunque este término también puede referirse al cálculo de integrales.

Muchas ecuaciones diferenciales no se pueden resolver con exactitud. Sin embargo, a efectos prácticos, como en ingeniería, suele ser suficiente una aproximación numérica a la solución. Los algoritmos estudiados aquí se pueden utilizar para calcular dicha aproximación. Un método alternativo es usar técnicas de cálculo para obtener una expansión en serie de la solución.

Las ecuaciones diferenciales ordinarias ocurren en muchas disciplinas científicas, incluidas la física, la química, la biología y la economía. Además, algunos métodos en ecuaciones diferenciales parciales numéricas convierten la ecuación diferencial parcial en una ecuación diferencial ordinaria, que luego debe resolverse.

El problema

Una ecuación diferencial de primer orden es un problema de valor inicial (PIV) de la forma,

- Sí..()t)=f()t,Sí.()t)),Sí.()t0)=Sí.0,{displaystyle y'(t)=f(t,y(t)),qquad y(t_{0}=y_{0},}

()1)

Donde f{displaystyle f} es una función f:[t0,JUEGO JUEGO )× × Rd→ → Rd{displaystyle f:[t_{0},infty)times mathbb {R} ^{d}to mathbb {R} ^{d}, y la condición inicial Sí.0▪ ▪ Rd{displaystyle y_{0}in mathbb {R} {d} es un vector dado. Primera orden significa que sólo el primer derivado de Sí. aparece en la ecuación, y los derivados superiores están ausentes.

Sin perder la generalidad de los sistemas de orden superior, nos limitamos a las ecuaciones diferenciales de primer orden, porque una EDO de orden superior se puede convertir en un sistema más grande de ecuaciones de primer orden introduciendo variables adicionales. Por ejemplo, la ecuación de segundo orden y′′ = −y se puede reescribir como dos ecuaciones de primer orden: y′ = z y z′ = − y.

En esta sección, describimos métodos numéricos para IVP y destacamos que los problemas de valor límite (BVP) requieren un conjunto diferente de herramientas. En un BVP, uno define valores o componentes de la solución y en más de un punto. Debido a esto, se deben usar diferentes métodos para resolver los BVP. Por ejemplo, el método de tiro (y sus variantes) o métodos globales como diferencias finitas, métodos de Galerkin o métodos de colocación son apropiados para esa clase de problemas.

El teorema de Picard-Lindelöf establece que existe una solución única, siempre que f sea continua de Lipschitz.

Métodos

Los métodos numéricos para resolver IVP de primer orden suelen pertenecer a una de dos grandes categorías: métodos lineales de varios pasos o métodos de Runge-Kutta. Se puede realizar una división adicional dividiendo los métodos en aquellos que son explícitos y aquellos que son implícitos. Por ejemplo, los métodos de varios pasos lineales implícitos incluyen métodos de Adams-Moulton y métodos de diferenciación hacia atrás (BDF), mientras que los métodos implícitos de Runge-Kutta incluyen Runge-Kutta implícito en diagonal (DIRK), Runge-Kutta implícito en diagonal única (SDIRK) y Gauss- Métodos numéricos de Radau (basados en la cuadratura gaussiana). Los ejemplos explícitos de la familia lineal de varios pasos incluyen los métodos de Adams-Bashforth, y cualquier método de Runge-Kutta con un cuadro de Butcher en diagonal inferior es explícito. Una regla práctica dicta que las ecuaciones diferenciales rígidas requieren el uso de esquemas implícitos, mientras que los problemas no rígidos se pueden resolver de manera más eficiente con esquemas explícitos.

Los llamados métodos lineales generales (GLM) son una generalización de las dos grandes clases de métodos anteriores.

Método de Euler

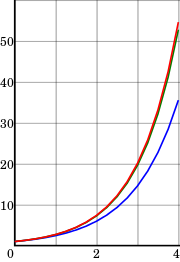

Desde cualquier punto de una curva, puede encontrar una aproximación de un punto cercano de la curva moviéndose una distancia corta a lo largo de una línea tangente a la curva.

Comenzando con la ecuación diferencial (1), reemplazamos la derivada y′ por la aproximación de diferencias finitas

- Sí..()t).. Sí.()t+h)− − Sí.()t)h,{displaystyle y'(t)approx {frac {y(t+h)-y(t)}{h}}}

()2)

que cuando se reorganiza produce la siguiente fórmula

- Sí.()t+h).. Sí.()t)+hSí..()t){displaystyle y(t+h)approx y(t)+hy'(t)}

y usando (1) da:

- Sí.()t+h).. Sí.()t)+hf()t,Sí.()t)).{displaystyle y(t+h)approx y(t)+hf(t,y(t)). }

()3)

Esta fórmula se aplica generalmente de la siguiente manera. Elegimos un tamaño de paso h, y construimos la secuencia t0,t1=t0+h,t2=t0+2h,...{displaystyle ¿Qué? Denotamos Sí.n{displaystyle y_{n} una estimación numérica de la solución exacta Sí.()tn){displaystyle y(t_{n}}. Motivado por (3), calculamos estas estimaciones por el siguiente esquema recursivo

- Sí.n+1=Sí.n+hf()tn,Sí.n).{displaystyle Y...

()4)

Este es el método de Euler (o método de Euler hacia adelante, en contraste con el método de Euler hacia atrás, que se describirá a continuación). El método lleva el nombre de Leonhard Euler, quien lo describió en 1768.

El método de Euler es un ejemplo de un método explícito. Esto significa que el nuevo valor yn+1 se define en términos de cosas que ya se conocen, como yn.

Método de Euler hacia atrás

Si, en lugar de (2), usamos la aproximación

- Sí..()t).. Sí.()t)− − Sí.()t− − h)h,{displaystyle y'(t)approx {frac {y(t)-y(t-h)}{h}}}

()5)

we get the backward Euler method ()6)

El método de Euler hacia atrás es un método implícito, lo que significa que tenemos que resolver una ecuación para encontrar yn+1. A menudo se usa la iteración de punto fijo o (alguna modificación del) método de Newton-Raphson para lograr esto.

Cuesta más tiempo resolver esta ecuación que los métodos explícitos; este costo debe tenerse en cuenta cuando se selecciona el método a utilizar. La ventaja de los métodos implícitos como (6) es que suelen ser más estables para resolver una ecuación rígida, lo que significa que se puede usar un tamaño de paso mayor h.

Método integrador exponencial de primer orden

Los integradores exponenciales describen una gran clase de integradores que recientemente han experimentado un gran desarrollo. Se remontan al menos a la década de 1960.

En lugar de (1), suponemos que la ecuación diferencial tiene la forma

- Sí..()t)=− − ASí.+N()Sí.),{displaystyle y'(t)=-A,y+{mathcal {N}(y),}

()7)

o se ha linealizado localmente sobre un estado de fondo para producir un término lineal − − ASí.{displaystyle - Sí. y un mandato no lineal N()Sí.){displaystyle {mathcal}(y)}.

Los integradores exponenciales se construyen multiplicando (7) by eAt{textstyle e^ {}}, e integrar exactamente el resultado sobre un intervalo de tiempo [tn,tn+1=tn+h]{displaystyle [t_{n},t_{n+1}=t_{n}h]:

- Sí.n+1=e− − AhSí.n+∫ ∫ 0he− − ()h− − τ τ )AN()Sí.()tn+τ τ ))dτ τ .{displaystyle Y... ¿Por qué?

This integral equation is exact, but it doesn't#39;to define the integral.

El integrador exponencial de primer orden se puede realizar sosteniendo N()Sí.()tn+τ τ )){displaystyle {mathcal {N}(y(t_{n}+tau)} constante sobre el intervalo completo:

- Sí.n+1=e− − AhSí.n+A− − 1()1− − e− − Ah)N()Sí.()tn)).{displaystyle Y...

()8)

Generalizaciones

El método de Euler a menudo no es lo suficientemente preciso. En términos más precisos, solo tiene orden uno (el concepto de orden se explica a continuación). Esto hizo que los matemáticos buscaran métodos de orden superior.

Una posibilidad es usar no solo el valor calculado previamente yn para determinar y n+1, pero hacer que la solución dependa de más valores pasados. Esto produce el llamado método de varios pasos. Quizás el más simple es el método de salto, que es de segundo orden y (en términos generales) se basa en dos valores de tiempo.

Casi todos los métodos prácticos de varios pasos pertenecen a la familia de métodos lineales de varios pasos, que tienen la forma

Otra posibilidad es utilizar más puntos en el intervalo [tn,tn+1]{displaystyle [t_{n},t_{n+1}. Esto conduce a la familia de los métodos Runge-Kutta, nombrados por Carl Runge y Martin Kutta. Uno de sus métodos de cuarto orden es especialmente popular.

Características avanzadas

Una buena implementación de uno de estos métodos para resolver una EDO implica más que la fórmula de pasos de tiempo.

A menudo es ineficaz usar el mismo tamaño de paso todo el tiempo, por lo que se han desarrollado métodos de tamaño de paso variable. Por lo general, el tamaño del paso se elige de modo que el error (local) por paso esté por debajo de algún nivel de tolerancia. Esto significa que los métodos también deben calcular un indicador de error, una estimación del error local.

Una extensión de esta idea es elegir dinámicamente entre diferentes métodos de diferentes órdenes (esto se llama método de orden variable). Los métodos basados en la extrapolación de Richardson, como el algoritmo de Bulirsch-Stoer, a menudo se utilizan para construir varios métodos de diferentes órdenes.

Otras características deseables incluyen:

- producción densa: aproximaciones numéricas baratas para todo el intervalo de integración, y no sólo en los puntos t0, t1, t2,...

- ubicación del evento: encontrar los tiempos donde, por ejemplo, una función particular desaparece. Esto normalmente requiere el uso de un algoritmo de determinación de raíces.

- soporte para computación paralela.

- cuando se utiliza para integrar con respecto al tiempo, reversibilidad del tiempo

Métodos alternativos

Muchos métodos no caen dentro del marco discutido aquí. Algunas clases de métodos alternativos son:

- multiderivative methods, que utilizan no sólo la función f pero también sus derivados. Esta clase incluye Métodos Hermite-Obreschkoff y Métodos de Fehlberg, así como métodos como el método Parker–Sochacki o el método Bychkov–Scherbakov, que computan los coeficientes de la serie Taylor de la solución Sí. recursivamente.

- métodos para los ODE de segundo orden. Dijimos que todos los ODE de orden superior pueden transformarse en ODE de primer orden de la forma (1). Aunque esto es cierto, puede que no sea la mejor manera de proceder. En particular, Métodos de Nyström trabajar directamente con ecuaciones de segundo orden.

- métodos de integración geométrica están especialmente diseñados para clases especiales de EDE (por ejemplo, integradores de símplice para la solución de ecuaciones Hamiltonianas). Se encargan de que la solución numérica respete la estructura o geometría subyacentes de estas clases.

- Métodos cuantificados de sistemas estatales son una familia de métodos de integración de ODE basados en la idea de cuantificación estatal. Son eficientes al simular sistemas de escaso con discontinuidades frecuentes.

Métodos paralelos en el tiempo

Para aplicaciones que requieren cómputo paralelo en supercomputadoras, el grado de concurrencia que ofrece un método numérico se vuelve relevante. En vista de los desafíos de los sistemas informáticos de exaescala, se están estudiando métodos numéricos para problemas de valor inicial que pueden proporcionar concurrencia en la dirección temporal. Parareal es un ejemplo relativamente conocido de un método de integración paralelo en el tiempo, pero las primeras ideas se remontan a la década de 1960. Con el advenimiento de la computación a exaescala, los métodos de integración en paralelo en el tiempo reciben nuevamente una mayor atención. Los algoritmos para integradores exponenciales pueden aprovechar, por ejemplo, las funciones BLAS por lotes estandarizadas que permiten una implementación fácil y eficiente de integradores en paralelo.

Análisis

El análisis numérico no es solo el diseño de métodos numéricos, sino también su análisis. Tres conceptos centrales en este análisis son:

- convergencia: si el método aproxima la solución,

- orden: lo bien que aproxima la solución, y

- estabilidad: si los errores se amortiguan.

Convergencia

Se dice que un método numérico es convergente si la solución numérica se aproxima a la solución exacta cuando el tamaño del paso h llega a 0. Más precisamente, requerimos que para cada ODE (1) con una función de Lipschitz f y cada t* > 0,

- limh→ → 0+maxn=0,1,...... ,⌊ ⌊ tAlternativa Alternativa /h⌋ ⌋ .Sí.n,h− − Sí.()tn).=0.{displaystyle lim _{hto 0^{+}max _{n=0,1,dotslfloor t^{*}/hrfloor } 'izquierda 'pretensión',h}-y.

Todos los métodos mencionados anteriormente son convergentes.

Coherencia y orden

Supongamos que el método numérico es

- Sí.n+k=Ψ Ψ ()tn+k;Sí.n,Sí.n+1,...... ,Sí.n+k− − 1;h).{displaystyle Y...

El error local (truncamiento) del método es el error cometido por un paso del método. Es decir, es la diferencia entre el resultado que da el método, suponiendo que no se cometió ningún error en los pasos anteriores, y la solución exacta:

- δ δ n+kh=Ψ Ψ ()tn+k;Sí.()tn),Sí.()tn+1),...... ,Sí.()tn+k− − 1);h)− − Sí.()tn+k).{displaystyle delta ¿Qué? Psi left(t_{n+k};y(t_{n}),y(t_{n+1}),dotsy(t_{n+k-1});hright)-y(t_{n+k}).}

The method is said to be <inconsistent if

- limh→ → 0δ δ n+khh=0.{displaystyle lim _{hto 0}{frac {delta - Sí.

El método tiene orden p{displaystyle p} si

- δ δ n+kh=O()hp+1)comoh→ → 0.{displaystyle delta ################################################################################################################################################################################################################################################################ 0.}

Por lo tanto, un método es consistente si tiene un orden mayor que 0. El método de Euler (hacia adelante) (4) y el método de Euler hacia atrás (6) presentados anteriormente tienen orden 1, por lo que son consistentes. La mayoría de los métodos que se utilizan en la práctica alcanzan un orden superior. La consistencia es una condición necesaria para la convergencia, pero no suficiente; para que un método sea convergente, debe ser consistente y estable en cero.

Un concepto relacionado es el error global (truncation), el error sostenido en todos los pasos que uno necesita para alcanzar un tiempo fijo t{displaystyle t}. Explícitamente, el error global a tiempo t{displaystyle t} es Sí.N− − Sí.()t){displaystyle y_{N}-y(t)} Donde N=()t− − t0)/h{displaystyle N=(t-t_{0}/h}. El error global de un p{displaystyle p}el método de un paso es O()hp){displaystyle O(h^{p}}; en particular, tal método es convergente. Esta declaración no es necesariamente verdadera para los métodos de varios pasos.

Estabilidad y rigidez

Para algunas ecuaciones diferenciales, la aplicación de métodos estándar, como el método de Euler, los métodos explícitos de Runge-Kutta o los métodos de varios pasos (por ejemplo, los métodos de Adams-Bashforth), muestran inestabilidad en las soluciones, aunque otros métodos pueden producir resultados estables. soluciones Este "comportamiento difícil" en la ecuación (que puede no ser necesariamente compleja en sí misma) se describe como rigidez y, a menudo, se debe a la presencia de diferentes escalas de tiempo en el problema subyacente. Por ejemplo, una colisión en un sistema mecánico como en un oscilador de impacto normalmente ocurre en una escala de tiempo mucho más pequeña que el tiempo de movimiento de los objetos; esta discrepancia genera "giros bruscos" en las curvas de los parámetros de estado.

Los problemas rígidos son omnipresentes en la cinética química, la teoría de control, la mecánica de sólidos, el pronóstico del tiempo, la biología, la física del plasma y la electrónica. Una forma de superar la rigidez es extender la noción de ecuación diferencial a la de inclusión diferencial, que permite y modela la falta de suavidad.

Historia

A continuación se muestra una cronología de algunos desarrollos importantes en este campo.

- 1768 - Leonhard Euler publica su método.

- 1824 - Augustin Louis Cauchy demuestra la convergencia del método Euler. En esta prueba, Cauchy utiliza el método implícito de Euler.

- 1855 - Primera mención de los métodos multipasos de John Couch Adams en una carta escrita por Francis Bashforth.

- 1895 - Carl Runge publica el primer método Runge–Kutta.

- 1901 - Martin Kutta describe el popular método Runge–Kutta de cuarto orden.

- 1910 - Lewis Fry Richardson anuncia su método de extrapolación, Richardson extrapolación.

- 1952 - Charles F. Curtiss y Joseph Oakland Hirschfelder coin the term ecuaciones rígidas.

- 1963 - Germund Dahlquist presenta Estabilidad de los métodos de integración.

Soluciones numéricas a problemas de valor límite unidimensionales de segundo orden

Los problemas de valores en la frontera (BVP) generalmente se resuelven numéricamente resolviendo un problema de matriz aproximadamente equivalente obtenido al discretizar el BVP original. El método más utilizado para resolver numéricamente los BVP en una dimensión se denomina método de diferencias finitas. Este método aprovecha las combinaciones lineales de valores puntuales para construir coeficientes de diferencias finitas que describen las derivadas de la función. Por ejemplo, la aproximación de la diferencia central de segundo orden a la primera derivada está dada por:

- ui+1− − ui− − 12h=u.()xi)+O()h2),{fnMicroc} {u_{i+1}-u_{i-1} {2h}=u'(x_{i})+{mathcal {O}}(h^{2h}}}}

y la diferencia central de segundo orden para la segunda derivada está dada por:

- ui+1− − 2ui+ui− − 1h2=u.()xi)+O()h2).{fnMicroc} {u_{i+1}=u'(x_{i})+{i-1} {h^{2}=u'''(x_{i})+{mathcal {O}(h^{2}). }

En ambas fórmulas, h=xi− − xi− − 1{displaystyle h=x_{i}-x_{i-1} es la distancia entre vecinos x valores en el dominio discretizado. Uno construye entonces un sistema lineal que puede ser resuelto por métodos de matriz estándar. Por ejemplo, supongamos que la ecuación a resolver es:

- d2udx2− − u=0,u()0)=0,u()1)=1.{displaystyle {begin{aligned} {frac} {d^{2}u} {dx^{2}}}-u=0,\\cH00}=0,\\\ {}u(1)=1.end{aligned}}

El siguiente paso sería discretizar el problema y usar aproximaciones derivadas lineales como

- ui.=ui+1− − 2ui+ui− − 1h2{displaystyle u'_{i}={frac} {u_{i+1}-2u_{i-1} {h^{2}}}

y resuelve el sistema de ecuaciones lineales resultante. Esto daría lugar a ecuaciones como:

- ui+1− − 2ui+ui− − 1h2− − ui=0,О О i=1,2,3,...,n− − 1.{fnMicroc} {u_{i+1}-2u_{i-1} {h^{2}-u_{i}=0,quad forall i={1,2,3,...,n-1}

En primera vista, este sistema de ecuaciones parece tener dificultad asociada al hecho de que la ecuación no implica términos que no se multiplican por variables, pero de hecho esto es falso. At i = 1 y n − 1 hay un término que implica los valores de límites u()0)=u0{displaystyle u(0)=u_{0} y u()1)=un{displaystyle u(1)=u_{n} y ya que estos dos valores son conocidos, uno puede simplemente sustituirlos en esta ecuación y como resultado tiene un sistema lineal no homogéneo de ecuaciones que tiene soluciones no-triviales.

Contenido relacionado

Notación de Leibniz

Dodecaedro truncado

Equinumerosidad

![[t_{n},t_{n+1}=t_{n}+h]](https://wikimedia.org/api/rest_v1/media/math/render/svg/12509e2c621cd352867e237af8a03b79eddcc166)

![{displaystyle {begin{aligned}&{}alpha _{k}y_{n+k}+alpha _{k-1}y_{n+k-1}+cdots +alpha _{0}y_{n}\&{}quad =hleft[beta _{k}f(t_{n+k},y_{n+k})+beta _{k-1}f(t_{n+k-1},y_{n+k-1})+cdots +beta _{0}f(t_{n},y_{n})right].end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/47bb8bad1854dddf30061661932c07d46850ceff)

![{displaystyle [t_{n},t_{n+1}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ea7558633c567b46e0e6a00c0284e61646613660)