Grupo de renormalización

En física teórica, el término grupo de renormalización (RG) se refiere a un aparato formal que permite la investigación sistemática de los cambios de un sistema físico visto en diferentes escalas. En la física de partículas, refleja los cambios en las leyes de fuerza subyacentes (codificadas en una teoría cuántica de campos) a medida que varía la escala de energía en la que ocurren los procesos físicos, las escalas de energía/momento y distancia de resolución se conjugan efectivamente bajo el principio de incertidumbre.

Un cambio de escala se denomina transformación de escala. El grupo de renormalización está íntimamente relacionado con la invariancia de escala y la invariancia conforme, simetrías en las que un sistema parece ser el mismo en todas las escalas (la llamada autosimilitud).

A medida que la escala varía, es como si uno estuviera cambiando el poder de aumento de un microscopio ficticio que observa el sistema. En las llamadas teorías renormalizables, el sistema en una escala generalmente consistirá en copias autosimilares de sí mismo cuando se ve en una escala más pequeña, con diferentes parámetros que describen los componentes del sistema. Los componentes, o variables fundamentales, pueden relacionarse con átomos, partículas elementales, espines atómicos, etc. Los parámetros de la teoría típicamente describen las interacciones de los componentes. Estos pueden ser acoplamientos variables que miden la fuerza de varias fuerzas o parámetros de masa en sí mismos. Los componentes mismos pueden parecer compuestos de más de los mismos componentes a medida que se recorren distancias más cortas.

Por ejemplo, en la electrodinámica cuántica (QED), un electrón parece estar compuesto de pares de electrones y positrones y fotones, ya que uno lo ve a mayor resolución, a distancias muy cortas. El electrón a distancias tan cortas tiene una carga eléctrica ligeramente diferente que el electrón vestido visto a grandes distancias, y este cambio, o correr, en el valor de la carga eléctrica está determinado por la ecuación del grupo de renormalización.

Historia

La idea de las transformaciones de escala y la invariancia de escala es antigua en la física: los argumentos de escala eran comunes para la escuela pitagórica, Euclides y hasta Galileo. Volvieron a ser populares a fines del siglo XIX, siendo quizás el primer ejemplo la idea de una mayor viscosidad de Osborne Reynolds, como una forma de explicar la turbulencia.

El grupo de renormalización se ideó inicialmente en la física de partículas, pero hoy en día sus aplicaciones se extienden a la física del estado sólido, la mecánica de fluidos, la cosmología física e incluso la nanotecnología. Un artículo temprano de Ernst Stueckelberg y André Petermann en 1953 anticipa la idea en la teoría cuántica de campos. Stueckelberg y Petermann abrieron el campo conceptualmente. Señalaron que la renormalización exhibe un grupo de transformaciones que transfieren cantidades de los términos simples a los contratérminos. Introdujeron una función h(e) en electrodinámica cuántica (QED), que ahora se llama función beta (ver más abajo).

Comienzos

Murray Gell-Mann y Francis E. Low restringieron la idea a las transformaciones de escala en QED en 1954, que son las más significativas físicamente, y se centraron en las formas asintóticas del propagador de fotones a altas energías. Determinaron la variación del acoplamiento electromagnético en QED, apreciando la simplicidad de la estructura de escala de esa teoría. Así descubrieron que el parámetro de acoplamiento g(μ) en la escala de energía μ está efectivamente dado por la ecuación de grupo (traducción unidimensional)

- g()μ μ )=G− − 1()()μ μ M)dG()g()M))){displaystyle g(mu)=G^{-1}left({frac {mu] ¿Qué?

o equivalentemente, G()g()μ μ ))=G()g()M))()μ μ /M)d{displaystyle Gleft(g(mu)right)=G(g(M)left({mu }/{M}right)}{d}, para alguna función G (no especificado—nowadays called Wegner's scaling function) and a constant d, en términos del acoplamiento g(M) a escala de referencia M.

Gell-Mann y Low se dieron cuenta en estos resultados que la escala efectiva puede tomarse arbitrariamente como μ, y puede variar para definir la teoría en cualquier otra escala:

- g()κ κ )=G− − 1()()κ κ μ μ )dG()g()μ μ )))=G− − 1()()κ κ M)dG()g()M))){fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicroc {kappa} {m}}}right)} {d}G(g(mu)right)=G^{-1}left({kappa }{M}right)} {g}g}g} {g}g}g}g}}}g}g}g}g}g}g}g}g}g}g}g}g}}g}g}g}g}g}g}}g}g}g}}g}g}g}g}g}g}}g}}g}g}}cH0}cccH0}}cH0}cH0}g}g}g}g}g}g}g}}cH

La esencia del RG es esta propiedad de grupo: a medida que la escala μ varía, la teoría presenta una réplica autosimilar de sí misma, y se puede acceder a cualquier escala de manera similar desde cualquier otra escala, mediante acción de grupo, una conjugación transitiva formal de acoplamientos en el sentido matemático (ecuación de Schröder).

Sobre la base de esta ecuación de grupo (finito) y su propiedad de escala, Gell-Mann y Low pudieron centrarse en transformaciones infinitesimales e inventaron un método computacional basado en una función de flujo matemática ψ(g) = G d/(∂G/∂ g) del parámetro de acoplamiento g, que introdujeron. Al igual que la función h(e) de Stueckelberg y Petermann, su función determina el cambio diferencial del acoplamiento g(μ) con respecto a un pequeño cambio en la escala de energía μ a través de una ecuación diferencial, la ecuación del grupo de renormalización:

- ∂ ∂ g∂ ∂ In μ μ =↑ ↑ ()g)=β β ()g){displaystyle displaystyle {frac {partial g}{partial ln mu }=psi (g)=beta (g)}

También se indica el nombre moderno, la función beta, introducida por C. Callan y K. Symanzik en 1970. Dado que es una mera función de g, la integración en g de una estimación perturbativa de ella permite especificar la trayectoria de renormalización del acoplamiento, es decir, su variación con la energía, efectivamente la función G en esta aproximación perturbativa. La predicción del grupo de renormalización (cf. trabajos de Stueckelberg–Petermann y Gell-Mann–Low) se confirmó 40 años después en los experimentos del acelerador LEP: la estructura fina "constante" de QED se midió en aproximadamente 1⁄127 a energías cercanas a 200 GeV, a diferencia del valor estándar de física de baja energía de 1⁄137.

Comprensión más profunda

El grupo de renormalización surge de la renormalización de las variables del campo cuántico, que normalmente tiene que abordar el problema de los infinitos en una teoría cuántica de campos. Este problema de manejar sistemáticamente los infinitos de la teoría cuántica de campos para obtener cantidades físicas finitas fue resuelto para QED por Richard Feynman, Julian Schwinger y Shin'ichirō Tomonaga, quienes recibieron el premio Nobel de 1965 por estas contribuciones. Efectivamente, idearon la teoría de la renormalización de la masa y la carga, en la que el infinito en la escala de impulso se corta mediante un regulador ultragrande, Λ.

La dependencia de las cantidades físicas, como la carga eléctrica o la masa del electrón, en la escala Λ está oculta, efectivamente intercambiada por las escalas de mayor distancia en las que se miden las cantidades físicas y, como resultado, todas las cantidades observables termina siendo finito en su lugar, incluso para un Λ infinito. Gell-Mann y Low se dieron cuenta en estos resultados de que, infinitesimalmente, mientras que la ecuación RG anterior proporciona un pequeño cambio en g dado ψ(g), la auto- la similitud se expresa por el hecho de que ψ(g) depende explícitamente solo de los parámetros de la teoría, y no de la escala μ. En consecuencia, la ecuación del grupo de renormalización anterior puede resolverse para (G y, por lo tanto) g(μ).

Una comprensión más profunda del significado físico y la generalización del proceso de renormalización, que va más allá del grupo de dilatación de las teorías renormalizables convencionales, considera métodos en los que aparecen simultáneamente escalas de longitud muy diferentes. Provino de la física de la materia condensada: el artículo de Leo P. Kadanoff de 1966 proponía el "block-spin" grupo de renormalización. La "idea de bloqueo" es una forma de definir los componentes de la teoría a grandes distancias como agregados de componentes a distancias más cortas.

Este enfoque cubrió el punto conceptual y se le dio sustancia computacional completa en las extensas e importantes contribuciones de Kenneth Wilson. El poder de las ideas de Wilson se demostró mediante una solución de renormalización iterativa constructiva de un problema de larga data, el problema de Kondo, en 1975, así como los desarrollos seminales precedentes de su nuevo método en la teoría de la fase de segundo orden. transiciones y fenómenos críticos en 1971. Fue galardonado con el premio Nobel por estas contribuciones decisivas en 1982.

Reformulación

Mientras tanto, el RG en la física de partículas había sido reformulado en términos más prácticos por Callan y Symanzik en 1970. La función beta anterior, que describe el "funcionamiento del acoplamiento" parámetro con escala, también se encontró que equivalía a la "anomalía de traza canónica", que representa la ruptura mecánica cuántica de la simetría de escala (dilatación) en una teoría de campo. Las aplicaciones del RG a la física de partículas explotaron en número en la década de 1970 con el establecimiento del Modelo Estándar.

En 1973, se descubrió que una teoría de quarks de colores interactuando, llamada cromodinámica cuántica, tenía una función beta negativa. Esto significa que un valor inicial de alta energía del acoplamiento generará un valor especial de μ en el que el acoplamiento explota (diverge). Este valor especial es la escala de las interacciones fuertes, μ = ΛQCD y se produce a unos 200 MeV. Por el contrario, el acoplamiento se vuelve débil a energías muy altas (libertad asintótica) y los quarks se vuelven observables como partículas puntuales, en una dispersión inelástica profunda, como lo anticipa la escala de Feynman-Bjorken. QCD se estableció así como la teoría cuántica de campos que controla las interacciones fuertes de las partículas.

El espacio de momento RG también se convirtió en una herramienta muy desarrollada en la física del estado sólido, pero se vio obstaculizada por el uso extensivo de la teoría de la perturbación, que impidió que la teoría tuviera éxito en sistemas fuertemente correlacionados.

Simetría conforme

La simetría conforme está asociada con la desaparición de la función beta. Esto puede ocurrir naturalmente si una constante de acoplamiento es atraída, corriendo, hacia un punto fijo en el que β(g) = 0. En QCD, el punto fijo se produce a distancias cortas donde g → 0 y se denomina punto fijo ultravioleta (trivial). Para los quarks pesados, como el quark top, el acoplamiento con el bosón de Higgs que da masa se dirige hacia un punto fijo infrarrojo fijo distinto de cero (no trivial), predicho por primera vez por Pendleton y Ross (1981) y C. T. Hill. El acoplamiento Yukawa del quark top se encuentra ligeramente por debajo del punto fijo infrarrojo del modelo estándar, lo que sugiere la posibilidad de una nueva física adicional, como los bosones de Higgs pesados secuenciales.

En la teoría de cuerdas, la invariancia conforme de la hoja del mundo de cuerdas es una simetría fundamental: β = 0 es un requisito. Aquí, β es una función de la geometría del espacio-tiempo en el que se mueve la cuerda. Esto determina la dimensionalidad del espacio-tiempo de la teoría de cuerdas y aplica las ecuaciones de la relatividad general de Einstein en la geometría. El RG es de fundamental importancia para la teoría de cuerdas y las teorías de gran unificación.

También es la idea clave moderna que subyace a los fenómenos críticos en la física de la materia condensada. De hecho, el RG se ha convertido en una de las herramientas más importantes de la física moderna. A menudo se utiliza en combinación con el método Monte Carlo.

Giro de bloque

Esta sección presenta pedagógicamente una imagen de RG que puede ser la más fácil de comprender: el RG de giro en bloque, ideado por Leo P. Kadanoff en 1966.

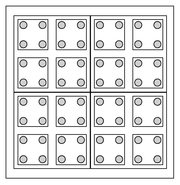

Considere un sólido 2D, un conjunto de átomos en una matriz cuadrada perfecta, como se muestra en la figura.

Suponga que los átomos interactúan entre ellos solo con sus vecinos más cercanos y que el sistema está a una temperatura determinada T. La fuerza de su interacción se cuantifica mediante un cierto acoplamiento J. La física del sistema se describirá mediante una determinada fórmula, por ejemplo, el hamiltoniano H(T, J).

Ahora proceda a dividir el sólido en bloques de 2×2 cuadrados; intentamos describir el sistema en términos de variables de bloque, es decir, variables que describen el comportamiento promedio del bloque. Suponga además que, por alguna afortunada coincidencia, la física de las variables de bloque se describe mediante una fórmula del mismo tipo, pero con valores diferentes para T y J: <span class="texhtml" H(T′, J′). (Esto no es exactamente cierto, en general, pero a menudo es una buena primera aproximación).

Tal vez, el problema inicial era demasiado difícil de resolver, ya que había demasiados átomos. Ahora, en el problema renormalizado tenemos solo una cuarta parte de ellos. Pero ¿por qué parar ahora? Otra iteración del mismo tipo conduce a H(T",J"), y sólo un dieciseisavo de los átomos. Estamos aumentando la escala de observación con cada paso de RG.

Por supuesto, la mejor idea es iterar hasta que solo haya un bloque muy grande. Dado que el número de átomos en cualquier muestra real de material es muy grande, esto es más o menos equivalente a encontrar el comportamiento de largo alcance de la transformación RG que tomó (T,J) → (T′,J′) y (T′, J′) → (T", J"). A menudo, cuando se repite muchas veces, esta transformación RG conduce a un cierto número de puntos fijos.

Para ser más concreto, considere un sistema magnético (por ejemplo, el modelo Ising), en el que el acoplamiento J denota el la tendencia de los giros vecinos a ser paralela. La configuración del sistema es el resultado de la compensación entre el término J que ordena y el efecto desordenador de la temperatura.

Para muchos modelos de este tipo hay tres puntos fijos:

- T = 0 y J →. Esto significa que, al tamaño más grande, la temperatura se vuelve inimportante, es decir, el factor de desorden desaparece. Así, en grandes escalas, el sistema parece ser ordenado. Estamos en una fase ferromagnética.

- T → y J → 0. Exactamente lo contrario; aquí domina la temperatura, y el sistema está desordenado a grandes escalas.

- Un punto nodrivial entre ellos, T = Tc y J = Jc. En este punto, cambiar la escala no cambia la física, porque el sistema está en un estado fractal. Corresponde a la transición de fase Curie, y también se llama un punto crítico.

Entonces, si recibimos un determinado material con valores dados de T y J, todo lo que tenemos que hacer para averiguar el comportamiento a gran escala del sistema es iterar el par hasta encontrar el punto fijo correspondiente.

Teoría elemental

En términos más técnicos, asumamos que tenemos una teoría descrita por una determinada función Z{displaystyle Z} de las variables estatales {}si}{displaystyle {fnK}} y un cierto conjunto de constantes de acoplamiento {}Jk}{displaystyle {J_{k}}}. Esta función puede ser una función de partición, una acción, un Hamiltonian, etc. Debe contener toda la descripción de la física del sistema.

Ahora consideramos una cierta transformación bloqueadora de las variables estatales {}si}→ → {}s~ ~ i}{displaystyle {fnK}to} {fnMide {fnK}} {f}}, el número de s~ ~ i{displaystyle {tilde {}_{i}} debe ser inferior al número de si{displaystyle S_{i}. Ahora tratemos de reescribir el Z{displaystyle Z} función sólo en términos de la s~ ~ i{displaystyle {tilde {}_{i}}. Si esto es alcanzable por cierto cambio en los parámetros, {}Jk}→ → {}J~ ~ k}{displaystyle {J_{k}to {fnMide {J}_{k}}, entonces se dice que la teoría renormalizable.

La mayoría de las teorías fundamentales de la física, como la electrodinámica cuántica, la cromodinámica cuántica y la interacción electrodébil, pero no la gravedad, son exactamente renormalizables. Además, la mayoría de las teorías de la física de la materia condensada son aproximadamente renormalizables, desde la superconductividad hasta la turbulencia de fluidos.

El cambio en los parámetros se realiza mediante una determinada función beta: {}J~ ~ k}=β β (){}Jk}){displaystyle {fnMicrosoft Sans Serif}, que se dice para inducir a flujo de grupo de normalización (o Flujo de RG) en el J{displaystyle J}- espacio. Los valores de J{displaystyle J} bajo el flujo se llama acoplamientos.

Como se indicó en la sección anterior, la información más importante en el flujo de RG son sus puntos fijos. Los posibles estados macroscópicos del sistema, a gran escala, vienen dados por este conjunto de puntos fijos. Si estos puntos fijos corresponden a una teoría de campo libre, se dice que la teoría exhibe trivialidad cuántica, poseyendo lo que se llama un polo de Landau, como en la electrodinámica cuántica. Para una interacción φ4, Michael Aizenman demostró que esta teoría es realmente trivial, para el espacio-tiempo dimensión D ≥ 5. Para D = 4, la trivialidad aún no se ha probado rigurosamente (en espera de la presentación reciente al arxiv), pero los cálculos de celosía han proporcionado una fuerte evidencia de esto. Este hecho es importante ya que la trivialidad cuántica se puede utilizar para vincular o incluso predecir parámetros como la masa del bosón de Higgs en escenarios asintóticos de seguridad. Numerosos puntos fijos aparecen en el estudio de las teorías reticulares de Higgs, pero la naturaleza de las teorías cuánticas de campos asociadas con estos sigue siendo una pregunta abierta.

Dado que las transformaciones RG en tales sistemas son con pérdida (es decir, el número de variables disminuye; vea un ejemplo en un contexto diferente, compresión de datos con pérdida), no es necesario que haya una inversa para una dada la transformación RG. Por lo tanto, en tales sistemas con pérdida, el grupo de renormalización es, de hecho, un semigrupo, ya que la pérdida implica que no hay un inverso único para cada elemento.

Operadores relevantes e irrelevantes y clases de universalidad

Considere una determinada A observable de un sistema físico que experimenta una transformación RG. La magnitud del observable a medida que la escala de longitud del sistema va de pequeña a grande determina la importancia de los observables para la ley de escala:

| Si su magnitud... | entonces el observable es... |

| siempre aumenta | pertinentes |

| siempre disminuye | irrelevantes |

| otros | marginal |

Se necesita un observable relevante para describir el comportamiento macroscópico del sistema; No se necesitan observables irrelevantes. Los observables marginales pueden o no necesitar ser tomados en cuenta. Un hecho general notable es que la mayoría de los observables son irrelevantes, es decir, la física macroscópica está dominada por solo unos pocos observables en la mayoría de los sistemas.

Por ejemplo, en física microscópica, para describir un sistema formado por un mol de átomos de carbono-12 necesitamos del orden de 1023 (el número de Avogadro) variables, mientras que para describirlo como sistema macroscópico (12 gramos de carbono-12) solo necesitamos unos pocos.

Antes del enfoque RG de Wilson, había un hecho empírico sorprendente para explicar: la coincidencia de los exponentes críticos (es decir, los exponentes de la dependencia de temperatura reducida de varias cantidades cerca de una transición de fase de segundo orden) en muy fenómenos dispares, como sistemas magnéticos, transición superfluida (transición Lambda), física de aleaciones, etc. Por lo tanto, en general, las características termodinámicas de un sistema cerca de una transición de fase dependen solo de un pequeño número de variables, como como la dimensionalidad y la simetría, pero son insensibles a los detalles de las propiedades microscópicas subyacentes del sistema.

Esta coincidencia de exponentes críticos para sistemas físicos ostensiblemente bastante diferentes, llamada universalidad, se explica fácilmente usando el grupo de renormalización, al demostrar que las diferencias en los fenómenos entre los componentes individuales de escala fina están determinadas por observables irrelevantes, mientras que los observables relevantes se comparten en común. Por lo tanto, muchos fenómenos macroscópicos pueden agruparse en un pequeño conjunto de clases de universalidad, especificadas por los conjuntos compartidos de observables relevantes.

Espacio de impulso

Los grupos de renormalización, en la práctica, vienen en dos "sabores" principales. La imagen de Kadanoff explicada anteriormente se refiere principalmente al llamado RG del espacio real.

Momentum-space RG por otro lado, tiene una historia más larga a pesar de su relativa sutileza. Se puede usar para sistemas en los que los grados de libertad se pueden expresar en términos de los modos de Fourier de un campo dado. La transformación RG procede mediante la integración de un cierto conjunto de modos de alto impulso (gran número de onda). Dado que los números de onda grandes están relacionados con escalas de longitud corta, el RG del espacio de momento da como resultado un efecto de granulado grueso esencialmente análogo al del RG del espacio real.

La RG espacio-momento generalmente se realiza en una expansión de perturbación. La validez de tal expansión se basa en que la física real de un sistema sea similar a la de un sistema de campo libre. En este caso, uno puede calcular observables sumando los términos principales en la expansión. Este enfoque ha resultado exitoso para muchas teorías, incluida la mayoría de la física de partículas, pero falla para sistemas cuya física está muy lejos de cualquier sistema libre, es decir, sistemas con fuertes correlaciones.

Como ejemplo del significado físico de RG en la física de partículas, considere una descripción general de la renormalización de carga en la electrodinámica cuántica (QED). Supongamos que tenemos una carga puntual positiva de cierta magnitud verdadera (o desnuda). El campo electromagnético que lo rodea tiene cierta energía y, por lo tanto, puede producir algunos pares virtuales de electrones y positrones (por ejemplo). Aunque las partículas virtuales se aniquilan muy rápidamente, durante su corta vida el electrón será atraído por la carga y el positrón será repelido. Dado que esto sucede de manera uniforme en todas partes cerca de la carga puntual, donde su campo eléctrico es lo suficientemente fuerte, estos pares crean efectivamente una pantalla alrededor de la carga cuando se ven desde lejos. La fuerza medida de la carga dependerá de qué tan cerca pueda acercarse nuestra sonda de medición a la carga puntual, pasando por alto más parte de la pantalla de partículas virtuales cuanto más se acerque. De ahí una dependencia de cierta constante de acoplamiento (aquí, la carga eléctrica) con la escala de distancia.

Las escalas de cantidad de movimiento y de longitud están relacionadas inversamente, de acuerdo con la relación de De Broglie: cuanto mayor sea la escala de energía o de cantidad de movimiento que alcancemos, menor será la escala de longitud que podamos explorar y resolver. Por lo tanto, los practicantes de RG espacio-momento a veces afirman integrar momentos altos o energías altas de sus teorías.

Ecuaciones de grupo de renormalización exacta

Una ecuación de grupo de renormalización exacta (ERGE) es aquella que tiene en cuenta los acoplamientos irrelevantes. Hay varias formulaciones.

El Wilson ERGE es el más simple conceptualmente, pero es prácticamente imposible de implementar. Transformada de Fourier en espacio de cantidad de movimiento después de la rotación de Wick en espacio euclidiano. Insista en un límite de impulso estricto, p2 ≤ Λ2 de modo que los únicos grados de libertad son aquellos con momentos menores que Λ. La función de partición es

- Z=∫ ∫ p2≤ ≤ ▪ ▪ 2Dφ φ exp [− − S▪ ▪ [φ φ ]].{displaystyle Z=int _{2}leq Lambda ^{2}{mathcal {D}phi exp left[-S_{Lambda }[phi ]right].}

Para cualquier Λ' positivo menor que Λ, defina SΛ' (un funcional sobre configuraciones de campo φ cuya transformada de Fourier tiene soporte de impulso dentro de p2 ≤ Λ' 2) como

- exp ()− − S▪ ▪ .[φ φ ])=def∫ ∫ ▪ ▪ .≤ ≤ p≤ ≤ ▪ ▪ Dφ φ exp [− − S▪ ▪ [φ φ ]].{displaystyle exp left(-S_{Lambda}[phi ]right) {fnhm {fnhm} {fnh00}tH00fnhm} {fnK} {\fnfnh00}fnfnK}fn9fnfn\fnH00\fnh00\fnh00fnKfnh00}\\fnK\\fnhnK\fnhnhnhnhnK\\\\\fnKfnK\fnKh00\\\\fnKh00\\\\\\\\\\\\\fnKhnKhnKhnKhnhnKh00fnKh00\\fnKhnKh00\\\\\\fnKh00\\\fnKh Lambda 'leq pleq Lambda }{mathcal {D}phi exp left[-S_{Lambda }[phi ]right].}

Si SΛ depende solo de ϕ y no en derivados de ϕ, esto puede reescribirse como

exp ()− − S▪ ▪ .[φ φ ])=def∏ ∏ ▪ ▪ .≤ ≤ p≤ ≤ ▪ ▪ ∫ ∫ dφ φ ()p)exp [− − S▪ ▪ [φ φ ()p)]],{displaystyle exp left(-S_{Lambda}[phi ]right) {fnMicrosoft} } {=} prod _{Lambda 'leq pleq Lambda }int dphi (p)exp left[-S_{Lambda }[phi (p)]right],}

en el que queda claro que, dado que solo funciona ϕ con soporte entre Λ' y Λ están integrados, el lado izquierdo aún puede depender de ϕ con soporte fuera de ese rango. Obviamente,

- Z=∫ ∫ p2≤ ≤ ▪ ▪ .2Dφ φ exp [− − S▪ ▪ .[φ φ ]].{displaystyle Z=int _{2}leq #Lambda {fnMitcal {fnMicrosoft Sans Serif}

De hecho, esta transformación es transitiva. Si calcula SΛ′ a partir de SΛ y luego calcule SΛ′′ a partir de SΛ′′, esto le da la misma acción wilsoniana que calcular SΛ″ directamente desde SΛ.

El Polchinski ERGE implica un corte suave del regulador UV. Básicamente, la idea es una mejora sobre Wilson ERGE. En lugar de un corte de impulso brusco, utiliza un corte suave. Esencialmente, suprimimos las contribuciones de momentos mayores que Λ en gran medida. Sin embargo, la suavidad del corte nos permite derivar una ecuación diferencial funcional en la escala de corte Λ. Al igual que en el enfoque de Wilson, tenemos un funcional de acción diferente para cada escala de energía de corte Λ. Se supone que cada una de estas acciones describe exactamente el mismo modelo, lo que significa que sus funciones de partición deben coincidir exactamente.

En otras palabras, (para un campo escalar real; las generalizaciones a otros campos son obvias),

- Z▪ ▪ [J]=∫ ∫ Dφ φ exp ()− − S▪ ▪ [φ φ ]+J⋅ ⋅ φ φ )=∫ ∫ Dφ φ exp ()− − 12φ φ ⋅ ⋅ R▪ ▪ ⋅ ⋅ φ φ − − Sint▪ ▪ [φ φ ]+J⋅ ⋅ φ φ ){displaystyle Z_{Lambda }[J]=int {mathcal {D}phi exp left(-S_{Lambda }[phi ]+Jcdot phi right)=int {mathcal {D}fexp left(-{tfrac {1}{2}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}fff}f}f}f}f}f}ff}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f R_{Lambda }cdot phi -S_{text{int},Lambda }[phi]+Jcdot phi right)}

y ZΛ es realmente independiente de Λ. Hemos utilizado la notación de Witt condensada aquí. También hemos dividido la acción pura SΛ en una parte cinética cuadrática y una parte interactiva Sint Λ. Esta división ciertamente no está limpia. El "interactuar" parte también puede contener términos cinéticos cuadráticos. De hecho, si hay alguna renormalización de la función de onda, seguramente lo hará. Esto se puede reducir un poco introduciendo cambios de escala de campo. RΛ es una función del momento p y el segundo término en el exponente es

- 12∫ ∫ ddp()2π π )dφ φ ~ ~ Alternativa Alternativa ()p)R▪ ▪ ()p)φ φ ~ ~ ()p){displaystyle {frac {2} {fnK} {fnMicroc}{}p}{} {f}} {f}} {fn}} {fnK}}} {fnK}}} {f}}}}}}}}} {f}}}f}fnf}fnf}f}}}}}}}}}}} {f}}}}}}f}f}}f}}}}f} {f}f}}f}}f}f}}}}}}f}f}}}}}}}}f}}\f}f}}}}f}}}}}}}}}}f}\\f}f}\f}}}}}f}}}}}}}}f}f}}}}}\\\\f}}}}}}}} ¿Qué?

cuando se expande.

Cuando p≪ ≪ ▪ ▪ {displaystyle pll Lambda }, R▪()p)/p2 es esencialmente 1. Cuando p≫ ≫ ▪ ▪ {displaystyle pgg Lambda }, R▪()p)/p2 se vuelve muy enorme y se acerca al infinito. R▪()p)/p2 es siempre mayor o igual a 1 y es suave. Básicamente, esto deja las fluctuaciones con momenta menos que el corte ▪ no afectados pero fuertemente suprime las contribuciones de fluctuaciones con momenta mayor que el corte. Esto es obviamente una gran mejora sobre Wilson.

La condición de que

- dd▪ ▪ Z▪ ▪ =0{displaystyle {fnMicroc}{d Lambda }Z_{Lambda }=0}

puede ser satisfecho por (pero no solo por)

- dd▪ ▪ Sint▪ ▪ =12δ δ Sint▪ ▪ δ δ φ φ ⋅ ⋅ ()dd▪ ▪ R▪ ▪ − − 1)⋅ ⋅ δ δ Sint▪ ▪ δ δ φ φ − − 12Tr [δ δ 2Sint▪ ▪ δ δ φ φ δ δ φ φ ⋅ ⋅ R▪ ▪ − − 1].{displaystyle {fnMicroc}{d Lambda }S_{text{int}, Lambda. S_{text{int},Lambda }{delta phi }cdot left({frac {d}{d Lambda ¿Qué? "Lambda" {fnMicroc {1}{2}fnuncio {Tr} left[{frac {delta ¿Qué?

Jacques Distler claimed without proof that this MERGE is not correct nonperturbative.

El ERGE de acción promedio efectivo implica un corte suave del regulador IR. La idea es tener en cuenta todas las fluctuaciones hasta una escala IR k. La acción promedio efectiva será precisa para fluctuaciones con momentos mayores que k. A medida que el parámetro k se reduce, la acción promedio efectiva se acerca a la acción efectiva que incluye todas las fluctuaciones clásicas y cuánticas. Por el contrario, para grandes k, la acción promedio efectiva está cerca de la "acción simple". Entonces, la acción promedio efectiva se interpola entre la "acción pura" y la acción eficaz.

Para un campo escalar real, se agrega un corte IR

- 12∫ ∫ ddp()2π π )dφ φ ~ ~ Alternativa Alternativa ()p)Rk()p)φ φ ~ ~ ()p){displaystyle {frac {2} {fnK} {fnMicroc}{}p}{} {f}} {f}} {fn}} {fnK}}} {fnK}}} {f}}}}}}}}} {f}}}f}fnf}fnf}f}}}}}}}}}}} {f}}}}}}f}f}}f}}}}f} {f}f}}f}}f}f}}}}}}f}f}}}}}}}}f}}\f}f}}}}f}}}}}}}}}}f}\\f}f}\f}}}}}f}}}}}}}}f}f}}}}}\\\\f}}}}}}}} ¿Qué?

to the action S, donde Rk es una función de ambos k y p tal que p≫ ≫ k{displaystyle pgg k}, Rk(p) is very small and approaches 0 and for p≪ ≪ k{displaystyle pll k}, Rk()p)≳ ≳ k2{displaystyle R_{k}(p)gtrsim k^{2}. Rk es lisa y no negativa. Su gran valor para el pequeño momenta conduce a la supresión de su contribución a la función de partición que es efectivamente lo mismo que descuidar las fluctuaciones a gran escala.

Se puede usar la notación deWitt condensada

- 12φ φ ⋅ ⋅ Rk⋅ ⋅ φ φ {displaystyle {frac {1}{2}phi cdot R_{k}cdot phi }

para este regulador IR.

Entonces,

- exp ()Wk[J])=Zk[J]=∫ ∫ Dφ φ exp ()− − S[φ φ ]− − 12φ φ ⋅ ⋅ Rk⋅ ⋅ φ φ +J⋅ ⋅ φ φ ){displaystyle exp left(W_{k}[J]right)=Z_{k}[J]=int {mathcal {D}phi exp left(-S[phi ]-{frac {1}{2}phi cdot R_{k}cdot phi +Jcdot phi right)}

donde J es el campo fuente. La transformada de Legendre de Wk normalmente da la acción efectiva. Sin embargo, la acción con la que comenzamos es realmente S[φ]+1/2 φ⋅Rk⋅φ y, por lo tanto, para obtener la acción promedio efectiva, restamos 1/2 φ⋅ Rk⋅φ. En otras palabras,

- φ φ [J;k]=δ δ Wkδ δ J[J]{displaystyle phi [J;k]={frac {delta [J]

se puede invertir para dar Jk[φ] y definimos la acción promedio efectiva Γk como

- .. k[φ φ ]=def()− − W[Jk[φ φ ]]+Jk[φ φ ]⋅ ⋅ φ φ )− − 12φ φ ⋅ ⋅ Rk⋅ ⋅ φ φ .{displaystyle "Gamma" {fnhm {fnhm {f} {f}left(-Wleft[J_{k}[phi ]right]+J_{k}[fi ]cdot phi right)-{tfrac {1}{2}}ficdot}cdot ¿Qué?

Por lo tanto,

- ddk.. k[φ φ ]=− − ddkWk[Jk[φ φ ]]− − δ δ Wkδ δ J⋅ ⋅ ddkJk[φ φ ]+ddkJk[φ φ ]⋅ ⋅ φ φ − − 12φ φ ⋅ ⋅ ddkRk⋅ ⋅ φ φ =− − ddkWk[Jk[φ φ ]]− − 12φ φ ⋅ ⋅ ddkRk⋅ ⋅ φ φ =12.φ φ ⋅ ⋅ ddkRk⋅ ⋅ φ φ .Jk[φ φ ];k− − 12φ φ ⋅ ⋅ ddkRk⋅ ⋅ φ φ =12Tr [()δ δ Jkδ δ φ φ )− − 1⋅ ⋅ ddkRk]=12Tr [()δ δ 2.. kδ δ φ φ δ δ φ φ +Rk)− − 1⋅ ⋅ ddkRk]{displaystyle {begin{aligned}{frac} {d}{dk} Gamma... {fnK}W_{k} [J_{k} [phi]-{frac {delta] W_{k}{delta J. {d} {dk}J_{k}[phi] [phi]cdot phi -{tfrac {1}{2}phi cdot {frac}phi cdot {frac] {d}R_{k}cdot phi \\c {fnK} {fnK} {fnMicrosoft}}fnMicroc {c}}ficdot {frac] {d}R_{k}cdot phi \cdot {1}leftlangle phi cdot {frac {d}R_{k}cdot phi right rangle ################################################################################################################################################################################################################################################################ {d} {dk}R_{k}cdot phi \f} {tfrac} {1}{2} {Tr} left[left({frac {delta ¿Qué? {fnK}R_{k}derecha]\\fnMicroc {1}{2} {Tr} left[left({frac {delta ^{2}Gamma _{k}{delta phi delta phi ¿Qué? {d} {dk}R_{k}right}end{aligned}}

así

- ddk.. k[φ φ ]=12Tr [()δ δ 2.. kδ δ φ φ δ δ φ φ +Rk)− − 1⋅ ⋅ ddkRk]{displaystyle {frac {d} {fnK}fnMicroc} {fnMicroc} {fnK}}}fn}fn}fnK}fnK}}fnK}fn} Gamma... {1}{2} {Tr} left[left({frac {delta ^{2}Gamma _{k}{delta phi delta phi ¿Qué? {d} {dk}R_{k}right]

es el ERGE, también conocido como la ecuación de Wetterich. Como lo muestra Morris, la acción efectiva Γk está de hecho simplemente relacionada con la acción efectiva Sint de Polchinski a través de una relación de transformación de Legendre.

Como hay infinitas opciones de Rk, también hay infinitamente muchos ERGE de interpolación diferentes. La generalización a otros campos como los campos espinoriales es sencilla.

Aunque el Polchinski ERGE y el ERGE de acción media efectiva parecen similares, se basan en filosofías muy diferentes. En el ERGE de acción promedio efectiva, la acción desnuda no se modifica (y la escala de corte de UV, si la hay, también se deja sin cambios), pero las contribuciones de IR a la acción efectiva se suprimen, mientras que en Polchinski ERGE, el QFT es fijo. de una vez por todas excepto la "acción pura" varía a diferentes escalas de energía para reproducir el modelo preespecificado. La versión de Polchinski ciertamente se acerca mucho más a la idea de Wilson en espíritu. Tenga en cuenta que uno usa "acciones simples" mientras que el otro utiliza acciones efectivas (promedio).

Grupo de renormalización mejora del potencial efectivo

El grupo de renormalización también se puede utilizar para calcular los potenciales efectivos a órdenes superiores a 1 bucle. Este tipo de enfoque es particularmente interesante para calcular las correcciones al mecanismo Coleman-Weinberg. Para ello, se debe escribir la ecuación del grupo de renormalización en términos del potencial efectivo. Al caso del φ φ 4{displaystyle phi ^{4} modelo:

- ()μ μ ∂ ∂ ∂ ∂ μ μ +β β λ λ ∂ ∂ ∂ ∂ λ λ +φ φ γ γ φ φ ∂ ∂ ∂ ∂ φ φ )Veff=0.{displaystyle left(mu {partial }{partial mu }+beta _{lambda }{frac {partial }{partial lambda }+phi gamma ¿Por qué?

Para determinar el potencial efectivo, es útil escribir Veff{displaystyle V_{text{eff}} como

- Veff=14φ φ 4Seff()λ λ ,L()φ φ )),{displaystyle V_{text{eff}={frac {1}{4}phi ¿Qué?

Donde Seff{displaystyle S_{text{eff}} es una serie de energía L()φ φ )=log φ φ 2μ μ 2{displaystyle L(phi)=log {frac {phi ^{2}{mu ^{2}}}}:

- Seff=A+BL+CL2+DL3+...... .{displaystyle S_{text{eff}=A+BL+CL^{2}+DL^{3}+dots.}

Usando el ansatz anterior, es posible resolver perturbativamente la ecuación del grupo de renormalización y encontrar el potencial efectivo hasta el orden deseado. En la referencia se muestra una explicación pedagógica de esta técnica.

Observaciones

- ^ Tenga en cuenta que las transformaciones de escala son un subconjunto estricto de transformaciones conformales, en general, esta última incluyendo generadores de simetría adicionales asociados con transformaciones conformales especiales.

- ^ Las primeras aplicaciones a la electrodinámica cuántica se discuten en el influyente libro de 1959 The The The Theory of Quantized Fields por Nikolay Bogolyubov y Dmitry Shirkov.

- ^ Aunque tenga en cuenta que el RG existe independientemente de los infinitos.

- ^ En última instancia, se podría tomar el parámetro regulador ≥ para ser infinito – los infinitos reflejan la acumulación de contribuciones de un infinito de grados de libertad a escalas energéticas infinitamente altas.

- ^ Es notable que la anomalía de traza y los procedimientos mecánicos cuánticos de acoplamiento pueden inducir la masa.

- ^ Para sistemas fuertemente correlativos, las técnicas de variación son una mejor alternativa.

- ^ Una excelente exposición técnica de J. Zinn-Justin (2010) es el artículo clásico Zinn-Justin, Jean (2010). "Fenomena crítica: enfoque teórico de campo". Scholarpedia. 5 (5): 8346. Bibcode:2010SchpJ...5.8346Z. doi:10.4249/scholarpedia.8346.. Por ejemplo, para sistemas similares a Ising con Z2 simetría o, más generalmente, para modelos con una simetría O(N), el punto fijo Gaussiano (gratuito) es estable a larga distancia sobre la dimensión espacial cuatro, marginalmente estable en la dimensión cuatro, e inestable debajo de la dimensión cuatro. Ver trivialidad cuántica.

Contenido relacionado

Valor en riesgo

Picotear

Ley (principio)

![Z=int_{p^2leq Lambda^2} mathcal{D}phi expleft[-S_Lambda[phi]right].](https://wikimedia.org/api/rest_v1/media/math/render/svg/407f39dfbe3fffdf0cdfcda4c213e3007b2cd0c3)

![expleft(-S_{Lambda'}[phi]right) stackrel{mathrm{def}}{=} int_{Lambda' leq p leq Lambda} mathcal{D}phi expleft[-S_Lambda[phi]right].](https://wikimedia.org/api/rest_v1/media/math/render/svg/bf56b09cdad1d26dce97b24c499cfc95eca28586)

![{displaystyle exp left(-S_{Lambda '}[phi ]right) {stackrel {mathrm {def} }{=}} prod _{Lambda 'leq pleq Lambda }int dphi (p)exp left[-S_{Lambda }[phi (p)]right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/22f1f208908d1bbd6d4e2bdc5c23f717a4888ede)

![Z=int_{p^2leq {Lambda'}^2}mathcal{D}phi expleft[-S_{Lambda'}[phi]right].](https://wikimedia.org/api/rest_v1/media/math/render/svg/a30b6a93bee7f6140761de35da087130e3524e9b)

![Z_Lambda[J]=int mathcal{D}phi expleft(-S_Lambda[phi]+Jcdot phiright)=int mathcal{D}phi expleft(-tfrac{1}{2}phicdot R_Lambda cdot phi-S_{text{int},Lambda}[phi]+Jcdotphiright)](https://wikimedia.org/api/rest_v1/media/math/render/svg/f364baf8f856610db0a57369b606409808d00589)

![frac{d}{dLambda}S_{text{int},Lambda}=frac{1}{2}frac{delta S_{text{int},Lambda}}{delta phi}cdot left(frac{d}{dLambda}R_Lambda^{-1}right)cdot frac{delta S_{text{int},Lambda}}{delta phi}-frac{1}{2}operatorname{Tr}left[frac{delta^2 S_{text{int},Lambda}}{delta phi, delta phi}cdot R_Lambda^{-1}right].](https://wikimedia.org/api/rest_v1/media/math/render/svg/8a8fc5a8a4699b729795a56866c916396f9dfec4)

![expleft(W_k[J]right)=Z_k[J]=int mathcal{D}phi expleft(-S[phi]-frac{1}{2}phi cdot R_k cdot phi +Jcdotphiright)](https://wikimedia.org/api/rest_v1/media/math/render/svg/3a3212e0a52d1f9114e79e3cc9a749034cf068f8)

![phi[J;k]=frac{delta W_k}{delta J}[J]](https://wikimedia.org/api/rest_v1/media/math/render/svg/0afaa4d38c67da64b67c436bf4ff8c04bcb4627c)

![Gamma_k[phi] stackrel{mathrm{def}}{=} left(-Wleft[J_k[phi]right]+J_k[phi]cdotphiright)-tfrac{1}{2}phicdot R_kcdot phi.](https://wikimedia.org/api/rest_v1/media/math/render/svg/67380c14186a08119e066bd78e76d075522fba59)

![begin{align}

frac{d}{dk}Gamma_k[phi] &=-frac{d}{dk}W_k[J_k[phi]]-frac{delta W_k}{delta J}cdotfrac{d}{dk}J_k[phi]+frac{d}{dk}J_k[phi]cdot phi-tfrac{1}{2}phicdot frac{d}{dk}R_k cdot phi \

&=-frac{d}{dk}W_k[J_k[phi]]-tfrac{1}{2}phicdot frac{d}{dk}R_k cdot phi \

&=tfrac{1}{2}leftlanglephi cdot frac{d}{dk}R_k cdot phirightrangle_{J_k[phi];k}-tfrac{1}{2}phicdot frac{d}{dk}R_k cdot phi \

&=tfrac{1}{2}operatorname{Tr}left[left(frac{delta J_k}{delta phi}right)^{-1}cdotfrac{d}{dk}R_kright] \

&=tfrac{1}{2}operatorname{Tr}left[left(frac{delta^2 Gamma_k}{delta phi delta phi}+R_kright)^{-1}cdotfrac{d}{dk}R_kright]

end{align}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a6a20a231ad085c0e40a2f534e78100eb0c0280b)

![frac{d}{dk}Gamma_k[phi] =tfrac{1}{2}operatorname{Tr}left[left(frac{delta^2 Gamma_k}{delta phi delta phi}+R_kright)^{-1}cdotfrac{d}{dk}R_kright]](https://wikimedia.org/api/rest_v1/media/math/render/svg/24c2d81a4a60a3551f2351b02b5255c11a0ec169)