Equilibrio de Nash

En teoría de juegos, el equilibrio de Nash, llamado así por el matemático John Nash, es la forma más común de definir la solución de un juego no cooperativo en el que participan dos o más jugadores. En un equilibrio de Nash, se supone que cada jugador conoce las estrategias de equilibrio de los otros jugadores, y nadie tiene nada que ganar cambiando solo su propia estrategia. El principio del equilibrio de Nash se remonta a la época de Cournot, quien en 1838 lo aplicó a empresas competidoras que elegían productos.

Si cada jugador ha elegido una estrategia, un plan de acción basado en lo que ha sucedido hasta ahora en el juego, y nadie puede aumentar el pago esperado propio cambiando la estrategia de uno mientras los otros jugadores mantienen sus & # 39; s sin cambios, entonces el conjunto actual de opciones de estrategia constituye un equilibrio de Nash.

Si dos jugadores, Alice y Bob, eligen las estrategias A y B, (A, B) es un equilibrio de Nash si Alice no tiene otra estrategia disponible que sea mejor que A para maximizar su pago en respuesta a que Bob elija B, y Bob tiene ninguna otra estrategia disponible que sea mejor que B para maximizar su pago en respuesta a que Alicia elija A. En un juego en el que Carol y Dan también son jugadores, (A, B, C, D) es un equilibrio de Nash si A es Alicia. La mejor respuesta de 39 a (B, C, D), B es la mejor respuesta de Bob a (A, C, D), y así sucesivamente.

Nash demostró que existe un equilibrio de Nash para cada juego finito: consulte más adelante el artículo sobre estrategia.

Aplicaciones

Los teóricos de los juegos utilizan el equilibrio de Nash para analizar el resultado de la interacción estratégica de varios tomadores de decisiones. En una interacción estratégica, el resultado para cada tomador de decisiones depende de las decisiones de los demás, así como de las propias. La idea simple que subyace a la idea de Nash es que no se pueden predecir las elecciones de múltiples tomadores de decisiones si se analizan esas decisiones de forma aislada. En cambio, uno debe preguntarse qué haría cada jugador teniendo en cuenta lo que el jugador espera que hagan los demás. El equilibrio de Nash requiere que las elecciones de uno sean consistentes: ningún jugador desea deshacer su decisión dado lo que los demás están decidiendo.

El concepto se ha utilizado para analizar situaciones hostiles, como guerras y carreras armamentistas (consulte el dilema del prisionero), y también cómo se puede mitigar el conflicto mediante una interacción repetida (consulte ojo por ojo). También se ha utilizado para estudiar hasta qué punto las personas con diferentes preferencias pueden cooperar (ver batalla de sexos) y si se arriesgarán para lograr un resultado cooperativo (ver caza de ciervos). Se ha utilizado para estudiar la adopción de normas técnicas, y también la ocurrencia de corridas bancarias y crisis cambiarias (ver juego de coordinación). Otras aplicaciones incluyen el flujo de tráfico (consulte el principio de Wardrop), cómo organizar subastas (consulte la teoría de la subasta), el resultado de los esfuerzos ejercidos por múltiples partes en el proceso educativo, la legislación regulatoria, como las regulaciones ambientales (consulte la tragedia de los bienes comunes).), gestión de recursos naturales, análisis de estrategias en marketing, incluso tiros penales en el fútbol (ver igualar centavos), sistemas de energía, sistemas de transporte, problemas de evacuación y comunicaciones inalámbricas.

Historia

El equilibrio de Nash lleva el nombre del matemático estadounidense John Forbes Nash Jr. La misma idea fue utilizada en una aplicación particular en 1838 por Antoine Augustin Cournot en su teoría del oligopolio. En la teoría de Cournot, cada una de varias empresas elige la cantidad de producción que producirá para maximizar su beneficio. La mejor producción de una empresa depende de la producción de las demás. Un equilibrio de Cournot ocurre cuando la producción de cada empresa maximiza sus ganancias dada la producción de las otras empresas, que es un equilibrio de Nash de estrategia pura. Cournot también introdujo el concepto de dinámica de mejor respuesta en su análisis de la estabilidad del equilibrio. Sin embargo, Cournot no usó la idea en ninguna otra aplicación ni la definió en general.

En cambio, el concepto moderno de equilibrio de Nash se define en términos de estrategias mixtas, donde los jugadores eligen una distribución de probabilidad sobre posibles estrategias puras (lo que podría poner el 100 % de la probabilidad en una estrategia pura; tales estrategias puras son un subconjunto de estrategias mixtas). estrategias). El concepto de equilibrio de estrategia mixta fue introducido por John von Neumann y Oskar Morgenstern en su libro de 1944 The Theory of Games and Economic Behavior, pero su análisis se restringió al caso especial de los juegos de suma cero.. Demostraron que existirá un equilibrio de Nash de estrategia mixta para cualquier juego de suma cero con un conjunto finito de acciones. La contribución de Nash en su artículo de 1951 "Juegos no cooperativos" fue definir un equilibrio de Nash de estrategia mixta para cualquier juego con un conjunto finito de acciones y probar que debe existir al menos un equilibrio de Nash (de estrategia mixta) en dicho juego. La clave de la capacidad de Nash para probar la existencia de manera mucho más general que von Neumann radica en su definición de equilibrio. Según Nash, “un punto de equilibrio es una n-tupla tal que la estrategia mixta de cada jugador maximiza su pago si las estrategias de los demás se mantienen fijas. Así la estrategia de cada jugador es óptima frente a las de los demás." Poner el problema en este marco permitió a Nash emplear el teorema del punto fijo de Kakutani en su artículo de 1950 para demostrar la existencia de equilibrios. Su artículo de 1951 usó el teorema de punto fijo de Brouwer más simple para el mismo propósito.

Los teóricos de los juegos han descubierto que, en algunas circunstancias, el equilibrio de Nash hace predicciones inválidas o no logra hacer una predicción única. Han propuesto muchos conceptos de solución ('refinamientos' de los equilibrios de Nash) diseñados para descartar equilibrios de Nash inverosímiles. Una cuestión particularmente importante es que algunos equilibrios de Nash pueden estar basados en amenazas que no son 'creíbles'. En 1965, Reinhard Selten propuso el equilibrio perfecto en subjuegos como un refinamiento que elimina los equilibrios que dependen de amenazas no creíbles. Otras extensiones del concepto de equilibrio de Nash han abordado lo que sucede si se repite un juego, o lo que sucede si se juega un juego en ausencia de información completa. Sin embargo, los refinamientos posteriores y las extensiones del equilibrio de Nash comparten la idea principal en la que se basa el concepto de Nash: el equilibrio es un conjunto de estrategias tales que la estrategia de cada jugador es óptima dadas las elecciones de los demás.

Definiciones

Equilibrio de Nash

Un perfil de estrategia es un conjunto de estrategias, una para cada jugador. Informalmente, un perfil de estrategia es un equilibrio de Nash si ningún jugador puede hacerlo mejor cambiando unilateralmente su estrategia. Para ver lo que esto significa, imagina que a cada jugador se le explican las estrategias de los demás. Supongamos entonces que cada jugador se pregunta: "Conociendo las estrategias de los otros jugadores y tratando las estrategias de los otros jugadores como grabadas en piedra, ¿puedo beneficiarme al cambiar mi estrategia?"

Si cualquier jugador pudiera responder "Sí", entonces ese conjunto de estrategias no es un equilibrio de Nash. Pero si todos los jugadores prefieren no cambiar (o les es indiferente cambiar o no), entonces el perfil de la estrategia es un equilibrio de Nash. Por lo tanto, cada estrategia en un equilibrio de Nash es la mejor respuesta a las decisiones de los otros jugadores. estrategias en ese equilibrio.

Formally, déjalo Si{displaystyle S_{i} ser el conjunto de todas las estrategias posibles para el jugador i{displaystyle i}, donde i=1,...... ,N{displaystyle i=1,ldotsN}. Vamos sAlternativa Alternativa =()siAlternativa Alternativa ,s− − iAlternativa Alternativa ){displaystyle s^{*}=(s_{i}{*},s_{-i}{*} } ser un perfil de estrategia, un conjunto consistente en una estrategia para cada jugador, donde s− − iAlternativa Alternativa {displaystyle S_{-i} {*} denota los N− − 1{displaystyle N-1} estrategias de todos los jugadores excepto i{displaystyle i}. Vamos ui()si,s− − iAlternativa Alternativa ){fnMicrosoft Sans Serif} } ser jugador es el pago como una función de las estrategias. El perfil de la estrategia sAlternativa Alternativa {displaystyle s^{*} es un equilibrio de Nash si

- ui()siAlternativa Alternativa ,s− − iAlternativa Alternativa )≥ ≥ ui()si,s− − iAlternativa Alternativa )forallsi▪ ▪ Si{fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} geq ¿Por qué? S_{i}

Un juego puede tener más de un equilibrio de Nash. Incluso si el equilibrio es único, podría ser débil: un jugador podría ser indiferente entre varias estrategias dado que los otros jugadores ' opciones Es único y se llama equilibrio de Nash estricto si la desigualdad es estricta, por lo que una estrategia es la única mejor respuesta:

- u_{i}(s_{i},s_{-i}^{*});;{rm {for;all}};;s_{i}in S_{i},s_{i}neq s_{i}^{*}}" xmlns="http://www.w3.org/1998/Math/MathML">ui()siAlternativa Alternativa ,s− − iAlternativa Alternativa )■ui()si,s− − iAlternativa Alternativa )forallsi▪ ▪ Si,siل ل siAlternativa Alternativa [displaystyle u_{i}(s_{i}{*},s_{-i}{*})}(s_{i},s_{-i});;;; {fn}fn};; s_{i}i}in}i}i} S_{i},s_{i}neq - Sí.

u_{i}(s_{i},s_{-i}^{*});;{rm {for;all}};;s_{i}in S_{i},s_{i}neq s_{i}^{*}}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/e737ebb23ae75905963689cf5f26ceef29c6abe8" style="vertical-align: -1.171ex; width:47.16ex; height:3.176ex;"/>

- u_{i}(s_{i},s_{-i}^{*});;{rm {for;all}};;s_{i}in S_{i},s_{i}neq s_{i}^{*}}" xmlns="http://www.w3.org/1998/Math/MathML">ui()siAlternativa Alternativa ,s− − iAlternativa Alternativa )■ui()si,s− − iAlternativa Alternativa )forallsi▪ ▪ Si,siل ل siAlternativa Alternativa [displaystyle u_{i}(s_{i}{*},s_{-i}{*})}(s_{i},s_{-i});;;; {fn}fn};; s_{i}i}in}i}i} S_{i},s_{i}neq - Sí.

Note that the strategy set Si{displaystyle S_{i} puede ser diferente para diferentes jugadores, y sus elementos pueden ser una variedad de objetos matemáticos. Simplemente, un jugador puede elegir entre dos estrategias, por ejemplo. Si={}Sí.,No}.{displaystyle S_{i}={text{Sí}},{text{No}} O, el conjunto de estrategias podría ser un conjunto finito de estrategias condicionales que responden a otros jugadores, por ejemplo. Si={}Sí.Silenciop=Baja,NoSilenciop=Alto}.{displaystyle S_{i}={text{ Yes} {text{Low}},{text{No}}Principado={text{High}}}} O, podría ser un conjunto infinito, un continuo o sin límites, por ejemplo. Si={}Precio}{displaystyle S_{i}={text{Price}}} tales que Precio{displaystyle {text{Price}}} es un número real no negativo. Las pruebas de existencia de Nash asumen un conjunto de estrategia finita, pero el concepto de equilibrio de Nash no lo requiere.

El equilibrio de Nash a veces puede parecer no racional en una perspectiva de tercera persona. Esto se debe a que un equilibrio de Nash no es necesariamente óptimo de Pareto.

El equilibrio de Nash también puede tener consecuencias no racionales en juegos secuenciales porque los jugadores pueden "amenazar" unos a otros con amenazas que en realidad no llevarían a cabo. Para tales juegos, el equilibrio de Nash perfecto en subjuegos puede ser más significativo como herramienta de análisis.

Equilibrio estricto/débil

Suponga que en el equilibrio de Nash, cada jugador se pregunta: "Conociendo las estrategias de los otros jugadores y tratando las estrategias de los otros jugadores como inamovibles, ¿sufriría una pérdida al cambiar mi estrategia?" "

Si la respuesta de todos los jugadores es "Sí", entonces el equilibrio se clasifica como un equilibrio de Nash estricto.

Si, por el contrario, para algún jugador existe una igualdad exacta entre la estrategia en el equilibrio de Nash y alguna otra estrategia que da exactamente el mismo pago (es decir, a este jugador le es indiferente cambiar o no), entonces el equilibrio se clasifica como un equilibrio de Nash débil.

Un juego puede tener un equilibrio de Nash de estrategia pura o de estrategia mixta. (En este último se elige estocásticamente una estrategia pura con una probabilidad fija).

Teorema de existencia de Nash

Nash demostró que si se permiten estrategias mixtas (donde un jugador elige probabilidades de usar varias estrategias puras), entonces cada juego con un número finito de jugadores en el que cada jugador puede elegir entre un número finito de estrategias puras tiene al menos un equilibrio de Nash, que podría ser una estrategia pura para cada jugador o podría ser una distribución de probabilidad sobre estrategias para cada jugador.

No es necesario que existan equilibrios de Nash si el conjunto de opciones es infinito y no compacto. Un ejemplo es un juego en el que dos jugadores nombran un número simultáneamente y el jugador que nombra el número mayor gana. Otro ejemplo es donde cada uno de los dos jugadores elige un número real estrictamente menor que 5 y el ganador es el que tiene el número más grande; no existe ningún número mayor estrictamente menor que 5 (si el número pudiera ser igual a 5, el equilibrio de Nash haría que ambos jugadores eligieran 5 y empataran el juego). Sin embargo, existe un equilibrio de Nash si el conjunto de opciones es compacto y el pago de cada jugador es continuo en las estrategias de todos los jugadores.

Ejemplos

Juego de coordinación

| Estrategia del jugador 1 | Estrategia del jugador 2 | |||

|---|---|---|---|---|

| El jugador 2 adopta la estrategia A | El jugador 2 adopta la estrategia B | |||

| El jugador 1 adopta la estrategia A | 4 4 | 3 1 | ||

| El jugador 1 adopta la estrategia B | 1 3 | 2 2 | ||

El juego de coordinación es un juego clásico de dos jugadores y dos estrategias, como se muestra en la matriz de pagos de ejemplo a la derecha. Hay dos equilibrios de estrategia pura, (A,A) con un pago de 4 para cada jugador y (B,B) con un pago de 2 para cada uno. La combinación (B,B) es un equilibrio de Nash porque si cualquiera de los jugadores cambia unilateralmente su estrategia de B a A, su pago caerá de 2 a 1.

| Estrategia del jugador 1 | Estrategia del jugador 2 | |||

|---|---|---|---|---|

| Hunt | Hunt conejo | |||

| Hunt | 2 2 | 1 0 | ||

| Hunt conejo | 0 1 | 1 1 | ||

Un famoso ejemplo de un juego de coordinación es la caza del ciervo. Dos jugadores pueden elegir cazar un ciervo o un conejo, proporcionando el ciervo más carne (4 unidades de utilidad, 2 para cada jugador) que el conejo (1 unidad de utilidad). La advertencia es que el ciervo debe ser cazado en cooperación, por lo que si un jugador intenta cazar el ciervo, mientras que el otro caza el conejo, el cazador de ciervos fallará por completo, con un pago de 0, mientras que el cazador de conejos tendrá éxito, por un pago de 1. El juego tiene dos equilibrios, (ciervo, ciervo) y (conejo, conejo), porque la estrategia óptima de un jugador depende de sus expectativas sobre lo que hará el otro jugador. Si un cazador confía en que el otro cazará al ciervo, debe cazar al ciervo; sin embargo, si cree que el otro cazará al conejo, él también cazará al conejo. Este juego se usa como una analogía para la cooperación social, ya que gran parte del beneficio que las personas obtienen en la sociedad depende de que las personas cooperen y confíen implícitamente entre sí para actuar de una manera que corresponda a la cooperación.

Conducir en una carretera contra un automóvil que se aproxima y tener que elegir girar bruscamente a la izquierda o girar bruscamente a la derecha de la carretera también es un juego de coordinación. Por ejemplo, con pagos 10 que significa que no hay choque y 0 que significa choque, el juego de coordinación se puede definir con la siguiente matriz de pagos:

| Estrategia del jugador 1 | Estrategia del jugador 2 | |||

|---|---|---|---|---|

| Conducir a la izquierda | Conduzca a la derecha | |||

| Conducir a la izquierda | 10 10 | 0 0 | ||

| Conduzca a la derecha | 0 0 | 10 10 | ||

En este caso, hay dos equilibrios de Nash de estrategia pura, cuando ambos eligen conducir por la izquierda o por la derecha. Si admitimos estrategias mixtas (donde se elige aleatoriamente una estrategia pura, sujeta a una probabilidad fija), entonces hay tres equilibrios de Nash para el mismo caso: dos que hemos visto de la forma de estrategia pura, donde las probabilidades son (0 %, 100%) para el jugador uno, (0%, 100%) para el jugador dos; y (100%, 0%) para el jugador uno, (100%, 0%) para el jugador dos respectivamente. Agregamos otro donde están las probabilidades para cada jugador (50%, 50%).

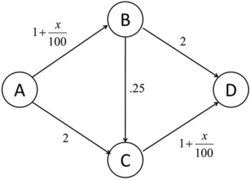

Tráfico de red

Una aplicación de Nash equilibria es determinar el flujo esperado de tráfico en una red. Considere el gráfico a la derecha. Si asumimos que hay x{displaystyle x} "carros" viajando desde A a D, ¿cuál es la distribución esperada del tráfico en la red?

Esta situación se puede modelar como un "juego", donde cada viajero tiene una selección de 3 estrategias y donde cada estrategia es una ruta desde A a D (uno de ellos) ABD, ABCD, o ACD). El "pago" de cada estrategia es el tiempo de viaje de cada ruta. En el gráfico a la derecha, un coche que viaja por ABD experiencia tiempo de viaje 1+x100+2{displaystyle 1+{frac {x}{100}+2}, donde x{displaystyle x} es el número de coches que viajan en el borde AB. Así, los pagos por cualquier estrategia dada dependen de las opciones de los otros jugadores, como es habitual. Sin embargo, el objetivo, en este caso, es minimizar el tiempo de viaje, no maximizarlo. El equilibrio ocurrirá cuando el tiempo en todos los caminos es exactamente el mismo. Cuando eso sucede, ningún conductor tiene ningún incentivo para cambiar las rutas, ya que sólo puede agregar a su tiempo de viaje. Para el gráfico a la derecha, si, por ejemplo, 100 coches están viajando desde A a D, entonces el equilibrio se producirá cuando 25 conductores viajan a través ABD, 50 via ABCD, y 25 via ACD. Cada conductor ahora tiene un tiempo total de viaje de 3,75 (para ver esto, note que un total de 75 coches tomar el AB borde, y de la misma manera, 75 coches tomar el CD borde).

Observe que esta distribución no es, en realidad, socialmente óptima. Si los 100 autos acordaran que 50 viajan a través de ABD y los otros 50 a través de ACD, entonces el tiempo de viaje para cualquier auto sería en realidad sea 3.5, que es menor que 3.75. Este también es el equilibrio de Nash si se elimina la ruta entre B y C, lo que significa que agregar otra ruta posible puede disminuir la eficiencia del sistema, un fenómeno conocido como la paradoja de Braess.

Juego de competición

| Estrategia del jugador 1 | Estrategia del jugador 2 | |||

|---|---|---|---|---|

| Elige "0" | Elija "1" | Elija "2" | Elija "3" | |

| Elige "0" | 0, 0 | 2, −2 | 2, −2 | 2, −2 |

| Elija "1" | −2, 2 | 1, 1 | 3, −1 | 3, −1 |

| Elija "2" | −2, 2 | −1, 3 | 2, 2 | 4, 0 |

| Elija "3" | −2, 2 | −1, 3 | 0, 4 | 3, 3 |

Esto se puede ilustrar con un juego de dos jugadores en el que ambos jugadores eligen simultáneamente un número entero del 0 al 3 y ambos ganan el menor de los dos números en puntos. Además, si un jugador elige un número mayor que el otro, entonces tiene que ceder dos puntos al otro.

Este juego tiene un equilibrio de Nash de estrategia pura único: ambos jugadores eligen 0 (resaltado en rojo claro). Cualquier otra estrategia puede mejorarse si un jugador cambia su número a uno menos que el del otro jugador. En la tabla adyacente, si el juego comienza en el cuadrado verde, al jugador 1 le interesa moverse al cuadrado morado y al jugador 2 le interesa moverse al cuadrado azul. Aunque no encajaría en la definición de un juego de competición, si el juego se modifica de modo que los dos jugadores ganen la cantidad indicada si ambos eligen el mismo número, y de lo contrario no ganan nada, entonces hay 4 equilibrios de Nash: (0,0), (1,1), (2,2) y (3,3).

Equilibrios de Nash en una matriz de pagos

Existe una forma numérica fácil de identificar los equilibrios de Nash en una matriz de pagos. Es especialmente útil en juegos de dos personas donde los jugadores tienen más de dos estrategias. En este caso, el análisis formal puede volverse demasiado largo. Esta regla no se aplica en el caso de que interesen estrategias mixtas (estocásticas). La regla es la siguiente: si el primer número de pago, en el par de pago de la celda, es el máximo de la columna de la celda y si el segundo número es el máximo de la fila de la celda, entonces la celda representa un equilibrio de Nash.

| Estrategia del jugador 1 | Estrategia del jugador 2 | ||

|---|---|---|---|

| Opción A | Opción B | Opción C | |

| Opción A | 0, 0 | 25, 40 | 5, 10 |

| Opción B | 40, 25 | 0, 0 | 5, 15 |

| Opción C | 10, 5 | 15, 5 | 10, 10 |

Podemos aplicar esta regla a una matriz de 3×3:

Usando la regla, podemos ver muy rápidamente (mucho más rápido que con el análisis formal) que las celdas de los equilibrios de Nash son (B,A), (A,B) y (C,C). De hecho, para la celda (B,A), 40 es el máximo de la primera columna y 25 es el máximo de la segunda fila. Para (A,B), 25 es el máximo de la segunda columna y 40 es el máximo de la primera fila; lo mismo aplica para la celda (C,C). Para otras celdas, uno o ambos miembros del dupla no son el máximo de las filas y columnas correspondientes.

Dicho esto, la mecánica real para encontrar celdas de equilibrio es obvia: encuentre el máximo de una columna y verifique si el segundo miembro del par es el máximo de la fila. Si se cumplen estas condiciones, la celda representa un equilibrio de Nash. Marque todas las columnas de esta manera para encontrar todas las celdas NE. Una matriz N×N puede tener entre 0 y N×N equilibrios de Nash de estrategia pura.

Estabilidad

El concepto de estabilidad, útil en el análisis de muchos tipos de equilibrios, también se puede aplicar a los equilibrios de Nash.

Un equilibrio de Nash para un juego de estrategia mixta es estable si un pequeño cambio (específicamente, un cambio infinitesimal) en las probabilidades de un jugador conduce a una situación en la que se cumplen dos condiciones:

- el jugador que no cambió no tiene mejor estrategia en la nueva circunstancia

- el jugador que cambió ahora está jugando con una estrategia estrictamente peor.

Si ambos casos se cumplen, entonces un jugador con el pequeño cambio en su estrategia mixta regresará inmediatamente al equilibrio de Nash. Se dice que el equilibrio es estable. Si la condición uno no se cumple, entonces el equilibrio es inestable. Si solo se cumple una condición, es probable que haya un número infinito de estrategias óptimas para el jugador que cambió.

En el "juego de conducción" ejemplo anterior hay equilibrios estables e inestables. Los equilibrios que involucran estrategias mixtas con 100% de probabilidades son estables. Si cualquiera de los jugadores cambia ligeramente sus probabilidades, ambos estarán en desventaja y su oponente no tendrá motivos para cambiar su estrategia a su vez. El equilibrio (50%,50%) es inestable. Si cualquiera de los jugadores cambia sus probabilidades (lo que no beneficiaría ni dañaría las expectativas del jugador que hizo el cambio, si la estrategia mixta del otro jugador sigue siendo (50 %, 50 %)), entonces el otro jugador tiene inmediatamente una mejor estrategia en (0%, 100%) o (100%, 0%).

La estabilidad es crucial en las aplicaciones prácticas de los equilibrios de Nash, ya que la estrategia mixta de cada jugador no se conoce perfectamente, sino que debe inferirse de la distribución estadística de sus acciones en el juego. En este caso, es muy poco probable que surjan equilibrios inestables en la práctica, ya que cualquier cambio mínimo en las proporciones de cada estrategia observada conducirá a un cambio en la estrategia y la ruptura del equilibrio.

El equilibrio de Nash define la estabilidad solo en términos de desviaciones unilaterales. En los juegos cooperativos, tal concepto no es lo suficientemente convincente. El fuerte equilibrio de Nash permite desviaciones de todas las coaliciones concebibles. Formalmente, un equilibrio de Nash fuerte es un equilibrio de Nash en el que ninguna coalición, tomando como dadas las acciones de sus complementos, puede desviarse cooperativamente de manera que beneficie a todos sus miembros. Sin embargo, el concepto fuerte de Nash a veces se percibe como demasiado "fuerte" en que el entorno permite una comunicación privada ilimitada. De hecho, un equilibrio de Nash fuerte tiene que ser eficiente en el sentido de Pareto. Como resultado de estos requisitos, el Nash fuerte es demasiado raro para ser útil en muchas ramas de la teoría de juegos. Sin embargo, en juegos como elecciones con muchos más jugadores que posibles resultados, puede ser más común que un equilibrio estable.

Un equilibrio de Nash refinado conocido como equilibrio de Nash a prueba de coaliciones (CPNE) ocurre cuando los jugadores no pueden hacerlo mejor, incluso si se les permite comunicarse y hacer "auto-ejecución" acuerdo de desviarse. Cada estrategia correlacionada apoyada por dominancia estricta iterada y en la frontera de Pareto es una CPNE. Además, es posible que un juego tenga un equilibrio de Nash resistente a coaliciones de un tamaño menor que el especificado, k. CPNE está relacionado con la teoría del núcleo.

Finalmente, en los años ochenta, basándose con gran profundidad en tales ideas, se introdujeron los equilibrios estables de Mertens como un concepto de solución. Los equilibrios estables de Mertens satisfacen tanto la inducción directa como la inducción inversa. En un contexto de teoría de juegos, los equilibrios estables ahora generalmente se refieren a los equilibrios estables de Mertens.

Ocurrencia

Si un juego tiene un equilibrio de Nash único y se juega entre jugadores bajo ciertas condiciones, entonces se adoptará el conjunto de estrategias NE. Condiciones suficientes para garantizar que se juega el equilibrio de Nash son:

- Todos los jugadores harán todo lo posible para maximizar su pago esperado como se describe en el juego.

- Los jugadores son impecables en ejecución.

- Los jugadores tienen suficiente inteligencia para deducir la solución.

- Los jugadores conocen la estrategia de equilibrio planificada de todos los otros jugadores.

- Los jugadores creen que una desviación en su propia estrategia no causará desviaciones por ningún otro jugador.

- Hay conocimiento común de que todos los jugadores cumplen estas condiciones, incluyendo esta. Por lo tanto, no sólo cada jugador debe saber que los otros jugadores cumplen con las condiciones, sino también deben saber que todos saben que los conocen, y saben que saben que ellos los conocen, y así sucesivamente.

Donde no se cumplen las condiciones

Ejemplos de problemas de teoría de juegos en los que no se cumplen estas condiciones:

- La primera condición no se cumple si el juego no describe correctamente las cantidades que un jugador desea maximizar. En este caso no hay ninguna razón particular para que ese jugador adopte una estrategia de equilibrio. Por ejemplo, el dilema del prisionero no es un dilema si un jugador está feliz de ser encarcelado indefinidamente.

- Intencional o accidental imperfección en ejecución. Por ejemplo, una computadora capaz de juego lógico impecable frente a una segunda computadora impecable resultará en equilibrio. La introducción de la imperfección llevará a su perturbación ya sea a través de la pérdida al jugador que comete el error, o mediante la negación del criterio de conocimiento común que conduce a la posible victoria para el jugador. (Un ejemplo sería un jugador de repente poniendo el coche en reversa en el juego de pollo, asegurando un escenario sin pérdidas de no-ganar).

- En muchos casos, la tercera condición no se cumple porque, aunque el equilibrio debe existir, se desconoce debido a la complejidad del juego, por ejemplo en ajedrez chino. O, si se sabe, puede que no sea conocido por todos los jugadores, como cuando juegan tic-tac-toe con un niño pequeño que desesperadamente quiere ganar (mediando los otros criterios).

- El criterio del conocimiento común puede no cumplirse incluso si todos los jugadores cumplen, de hecho, todos los demás criterios. Los jugadores erróneamente desconfiando la racionalidad de los demás pueden adoptar contra-estrategias para el juego irracional esperado en nombre de sus oponentes. Esta es una consideración importante en "chicken" o una carrera de armamentos, por ejemplo.

Donde se cumplen las condiciones

En su doctorado. En su disertación, John Nash propuso dos interpretaciones de su concepto de equilibrio, con el objetivo de mostrar cómo los puntos de equilibrio pueden conectarse con fenómenos observables.

(...) Una interpretación es racionalista: si asumimos que los jugadores son racionales, conocen la estructura completa del juego, el juego se juega una vez, y sólo hay un equilibrio de Nash, entonces los jugadores jugarán según ese equilibrio.

Esta idea fue formalizada por R. Aumann y A. Brandenburger, 1995, Epistemic Conditions for Nash Equilibrium, Econometrica, 63, 1161-1180, quienes interpretaron la estrategia mixta de cada jugador como una conjetura sobre el comportamiento de otros jugadores y han demostrado que si el juego y la racionalidad de los jugadores se conocen mutuamente y estas conjeturas se conocen comúnmente, entonces las conjeturas deben ser un equilibrio de Nash (se necesita una suposición previa común para este resultado en general, pero no en el caso de dos jugadores, en este caso las conjeturas sólo necesitan ser conocidas mutuamente).

Una segunda interpretación, a la que Nash se refirió como la interpretación de acción de masas, es menos exigente para los jugadores:

[i]t es innecesario asumir que los participantes tienen pleno conocimiento de la estructura total del juego, o la capacidad e inclinación para pasar por cualquier complejo proceso de razonamiento. Lo que se supone es que hay una población de participantes para cada posición en el juego, que se jugará a lo largo del tiempo por los participantes dibujados al azar de las diferentes poblaciones. Si hay una frecuencia media estable con la que cada estrategia pura es empleada por el miembro promedio de la población apropiada, entonces esta frecuencia media estable constituye una estrategia mixta equilibrio Nash.

Para obtener un resultado formal en este sentido, consulte Kuhn, H. and et al., 1996, "The Work of John Nash in Game Theory," Revista de Teoría Económica, 69, 153–185.

Debido a las condiciones limitadas en las que se pueden observar los NE, rara vez se los trata como una guía para el comportamiento diario, o se los observa en la práctica en las negociaciones humanas. Sin embargo, como concepto teórico en economía y biología evolutiva, la EN tiene poder explicativo. La recompensa en economía es la utilidad (o, a veces, el dinero), y en biología evolutiva es la transmisión de genes; ambos son la base fundamental de la supervivencia. Los investigadores que aplican la teoría de los juegos en estos campos afirman que las estrategias que no las maximicen por cualquier motivo serán eliminadas del mercado o del entorno, a las que se atribuye la capacidad de probar todas las estrategias. Esta conclusión se extrae de la "estabilidad" teoría anterior. En estas situaciones, la suposición de que la estrategia observada es en realidad una EN a menudo ha sido confirmada por la investigación.

NE y amenazas no creíbles

El equilibrio de Nash es un superconjunto del equilibrio de Nash perfecto en subjuegos. El equilibrio perfecto en subjuegos además del equilibrio de Nash requiere que la estrategia también sea un equilibrio de Nash en cada subjuego de ese juego. Esto elimina todas las amenazas no creíbles, es decir, las estrategias que contienen movimientos irracionales para hacer que el contrajugador cambie su estrategia.

La imagen de la derecha muestra un juego secuencial simple que ilustra el problema de los equilibrios de Nash imperfectos en subjuegos. En este juego, el jugador uno elige izquierda (L) o derecha (R), a lo que sigue el jugador dos que debe ser amable (K) o desagradable (U) con el jugador uno. Sin embargo, el jugador dos solo se beneficia de ser desagradable si el jugador uno va a la izquierda. Si el jugador uno sale bien, el jugador racional dos sería de hecho amable con él/ella en ese subjuego. Sin embargo, la amenaza no creíble de ser cruel en 2(2) sigue siendo parte del equilibrio azul (L, (U,U)) de Nash. Por lo tanto, si ambas partes pueden esperar un comportamiento racional, el equilibrio de Nash perfecto en subjuegos puede ser un concepto de solución más significativo cuando surgen tales inconsistencias dinámicas.

Prueba de existencia

Prueba usando el teorema del punto fijo de Kakutani

La prueba original de Nash (en su tesis) utilizó el teorema del punto fijo de Brouwer (por ejemplo, vea una variante a continuación). Damos una prueba más simple a través del teorema del punto fijo de Kakutani, siguiendo el artículo de Nash de 1950 (él atribuye a David Gale la observación de que tal simplificación es posible).

Para probar la existencia de un equilibrio de Nash, ri()σ σ − − i){displaystyle r_{i}(sigma _{-i}) } ser la mejor respuesta del jugador a las estrategias de todos los demás jugadores.

- ri()σ σ − − i)=argmaxσ σ i ui()σ σ i,σ σ − − i){displaystyle r_{i}(sigma _{-i})=mathop {compset {sigma ¿Qué? _{i},sigma _{-i})}

Aquí, σ σ ▪ ▪ .. {displaystyle sigma in Sigma }, donde .. =.. i× × .. − − i{displaystyle Sigma =Sigma _{i}times Sigma _{-i}}, es un perfil de estrategia mixta en el conjunto de todas las estrategias y ui{displaystyle U_{i} es la función de pago para el jugador i. Definir una función de valor fijo r:: .. → → 2.. {displaystyle rcolon Sigma rightarrow 2^{ Sigma tales que r=ri()σ σ − − i)× × r− − i()σ σ i){displaystyle r=r_{i}(sigma _{-i})times r_{-i}(sigma _{i})}. La existencia de un equilibrio nash equivale a r{displaystyle r} teniendo un punto fijo.

El teorema del punto fijo de Kakutani garantiza la existencia de un punto fijo si se cumplen las siguientes cuatro condiciones.

- .. {displaystyle Sigma } es compacto, convexo y no vacío.

- r()σ σ ){displaystyle r(sigma)} no está vacío.

- r()σ σ ){displaystyle r(sigma)} es alta hemicontinua

- r()σ σ ){displaystyle r(sigma)} es convex.

Estado 1. está satisfecho por el hecho de que .. {displaystyle Sigma } es un simplex y por lo tanto compacto. La convexidad se deriva de la capacidad de los jugadores para mezclar estrategias. .. {displaystyle Sigma } no está vacío mientras los jugadores tengan estrategias.

Condición 2. y 3. están satisfechos por medio del teorema máximo de Berge. Porque... ui{displaystyle U_{i} es continuo y compacto, r()σ σ i){displaystyle r(sigma _{i})} es no vacío y hemicontínua superior.

Estado 4. está satisfecho como resultado de estrategias mixtas. Suppose σ σ i,σ σ i.▪ ▪ r()σ σ − − i){displaystyle sigma _{i},sigma '_{i}in r(sigma _{-i}) }, entonces λ λ σ σ i+()1− − λ λ )σ σ i.▪ ▪ r()σ σ − − i){displaystyle lambda sigma _{i}+(1-lambda)sigma '_{i}in r(sigma _{-i}) }. es decir, si dos estrategias maximizan los pagos, entonces una combinación entre las dos estrategias dará el mismo pago.

Por lo tanto, existe un punto fijo en r{displaystyle r} y un equilibrio de Nash.

Cuando Nash le comentó este punto a John von Neumann en 1949, von Neumann lo desestimó con las palabras: "Eso es trivial, ¿sabes?". Eso es solo un teorema de punto fijo." (Véase Nasar, 1998, pág. 94.)

Prueba alternativa usando el teorema del punto fijo de Brouwer

Tenemos un juego G=()N,A,u){displaystyle G=(N,A,u)} Donde N{displaystyle N} es el número de jugadores y A=A1× × ⋯ ⋯ × × AN{displaystyle A=A_{1}times cdots times A_{N} es la acción establecida para los jugadores. Todos los conjuntos de acción Ai{displaystyle A_{i} son finitos. Vamos Δ Δ =Δ Δ 1× × ⋯ ⋯ × × Δ Δ N{displaystyle Delta =Delta _{1}times cdots times Delta _{N} denota el conjunto de estrategias mixtas para los jugadores. La finicidad de la Ai{displaystyle A_{i}s garantiza la compactidad de Δ Δ {displaystyle Delta }.

Ahora podemos definir las funciones de ganancia. Para una estrategia mixta σ σ ▪ ▪ Δ Δ {displaystyle sigma in Delta }, dejamos la ganancia para el jugador i{displaystyle i} sobre las medidas adoptadas a▪ ▪ Ai{displaystyle ain A_{i} Ser

- Gaini()σ σ ,a)=max{}0,ui()a,σ σ − − i)− − ui()σ σ i,σ σ − − i)}.{displaystyle {text{Gain}_{i}(sigmaa)=max{0,u_{i}(a,sigma _{-i})-u_{i}(sigma _{i},sigma _{-i})}

La función de ganancia representa el beneficio que obtiene un jugador cambiando unilateralmente su estrategia. Ahora definimos g=()g1,...... ,gN){displaystyle g=(g_{1},dotscg_{N}} Donde

- gi()σ σ )()a)=σ σ i()a)+Gaini()σ σ ,a){displaystyle g_{i}(sigma)=sigma _{i}(a)+{text{Gain}}_{i}(sigmaa)}

para σ σ ▪ ▪ Δ Δ ,a▪ ▪ Ai{displaystyle sigma in Deltaain A_{i}. Lo vemos.

- 0.}" xmlns="http://www.w3.org/1998/Math/MathML">.. a▪ ▪ Aigi()σ σ )()a)=.. a▪ ▪ Aiσ σ i()a)+Gaini()σ σ ,a)=1+.. a▪ ▪ AiGaini()σ σ ,a)■0.{displaystyle sum _{ain A_{i}g_{i}(sigma)(a)=sum _{ain A_{i}sigma _{i}(a)+{text{Gain}_{i}(sigmaa)=1+sum _{ain ¿Qué?

0.}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/e4e4f03384b71906ff6134490336d1b36bb72665" style="vertical-align: -3.505ex; width:66.089ex; height:6.009ex;"/>

A continuación definimos:

- {}f=()f1,⋯ ⋯ ,fN):Δ Δ → → Δ Δ fi()σ σ )()a)=gi()σ σ )()a).. b▪ ▪ Aigi()σ σ )()b)a▪ ▪ Ai{displaystyle {begin{cases}f=(f_{1},cdotsf_{N}):Delta to Delta \f_{i}(sigma)={frac {g_{i}(sigma)}{sum _{bin A_{i}g_{i}(sigma)(b)} {i}} A_{i}end{cases}}

Es fácil ver que cada uno fi{displaystyle F_{i} es una estrategia mixta válida Δ Δ i{displaystyle Delta _{i}. También es fácil comprobar que cada uno fi{displaystyle F_{i} es una función continua σ σ {displaystyle sigma }, y por lo tanto f{displaystyle f} es una función continua. Como el producto cruzado de un número finito de conjuntos compactos de convex, Δ Δ {displaystyle Delta } es también compacto y convexo. Aplicar el teorema de punto fijo Brouwer para f{displaystyle f} y Δ Δ {displaystyle Delta } concluimos que f{displaystyle f} tiene un punto fijo Δ Δ {displaystyle Delta }, llámalo σ σ Alternativa Alternativa {displaystyle sigma ^{*}. Afirmamos que σ σ Alternativa Alternativa {displaystyle sigma ^{*} es un equilibrio de Nash en G{displaystyle G.. Para ello basta demostrar que

- О О i▪ ▪ {}1,⋯ ⋯ ,N},О О a▪ ▪ Ai:Gaini()σ σ Alternativa Alternativa ,a)=0.{displaystyle forall iin {1,cdots ################################################################################################################################################################################################################################################################ A_{i}:quad {text{Gain}_{i}(sigma ^{*}a)=0.}

Esto simplemente establece que ningún jugador obtiene ningún beneficio al cambiar unilateralmente su estrategia, que es exactamente la condición necesaria para un equilibrio de Nash.

Ahora asumen que las ganancias no son todos cero. Por lo tanto, ∃ ∃ i▪ ▪ {}1,⋯ ⋯ ,N},{displaystyle exists iin {1,cdotsN},} y a▪ ▪ Ai{displaystyle ain A_{i} tales que 0}" xmlns="http://www.w3.org/1998/Math/MathML">Gaini()σ σ Alternativa Alternativa ,a)■0{displaystyle {text{Gain}}_{i}(sigma ^{*}a) Confía0}0" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/6b46e6899283ac62308c7580632a292e54e2c627" style="vertical-align: -0.838ex; width:16.445ex; height:2.843ex;"/>. Note entonces que

- 1.}" xmlns="http://www.w3.org/1998/Math/MathML">.. a▪ ▪ Aigi()σ σ Alternativa Alternativa ,a)=1+.. a▪ ▪ AiGaini()σ σ Alternativa Alternativa ,a)■1.{displaystyle sum _{ain A_{i}g_{i}(sigma ^{*}a)=1+sum _{ain A_{i}{text{Gain}}_{i}(sigma ^{*}a) Conde1.}

1.}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/869523966ec58885119b1ec7358c82abb661db05" style="vertical-align: -3.505ex; width:40.98ex; height:6.009ex;"/>

Así que deja

- C=.. a▪ ▪ Aigi()σ σ Alternativa Alternativa ,a).{displaystyle C=sum _{ain A_{i}g_{i}(sigma ^{*}a). }

También denotaremos Gain()i,⋅ ⋅ ){displaystyle {text{Gain}}(i,cdot)} como vector de ganancia indexado por acciones Ai{displaystyle A_{i}. Desde σ σ Alternativa Alternativa {displaystyle sigma ^{*} es el punto fijo que tenemos:

- σ σ Alternativa Alternativa =f()σ σ Alternativa Alternativa )⇒ ⇒ σ σ iAlternativa Alternativa =fi()σ σ Alternativa Alternativa )⇒ ⇒ σ σ iAlternativa Alternativa =gi()σ σ Alternativa Alternativa ).. a▪ ▪ Aigi()σ σ Alternativa Alternativa )()a)⇒ ⇒ σ σ iAlternativa Alternativa =1C()σ σ iAlternativa Alternativa +Gaini()σ σ Alternativa Alternativa ,⋅ ⋅ ))⇒ ⇒ Cσ σ iAlternativa Alternativa =σ σ iAlternativa Alternativa +Gaini()σ σ Alternativa Alternativa ,⋅ ⋅ )⇒ ⇒ ()C− − 1)σ σ iAlternativa Alternativa =Gaini()σ σ Alternativa Alternativa ,⋅ ⋅ )⇒ ⇒ σ σ iAlternativa Alternativa =()1C− − 1)Gaini()σ σ Alternativa Alternativa ,⋅ ⋅ ).{displaystyle {begin{aligned}sigma ¿Por qué? ¿Por qué? A_{i}g_{i}(sigma ^{*}a)}[6pt] ¿Qué? {1}{C}left(sigma) ¿Por qué? Csigma ¿Qué? ¿Qué? ¿Por qué? Rightarrow sigma ¿Qué? {1}{C-1}right){text{Gain}_{i}(sigma ^{*},cdot).end{aligned}}}

Desde 1}" xmlns="http://www.w3.org/1998/Math/MathML">C■1{displaystyle C]1" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/536c544fc840b3b0bc20994827352e7396cf3e5d" style="vertical-align: -0.338ex; width:6.027ex; height:2.176ex;"/> tenemos σ σ iAlternativa Alternativa {displaystyle sigma _{i}{*}} es un aumento positivo del vector Gaini()σ σ Alternativa Alternativa ,⋅ ⋅ ){displaystyle {text{Gain}_{i}(sigma ^{*},cdot)}. Ahora afirmamos que

- О О a▪ ▪ Ai:σ σ iAlternativa Alternativa ()a)()ui()ai,σ σ − − iAlternativa Alternativa )− − ui()σ σ iAlternativa Alternativa ,σ σ − − iAlternativa Alternativa ))=σ σ iAlternativa Alternativa ()a)Gaini()σ σ Alternativa Alternativa ,a){displaystyle forall ain A_{i}:quad sigma _{i}{*}(a)(u_{i}(a_{i},sigma ¿Qué? ¿Qué? sigma _{-i}{*})=sigma _{i}{*}(a){text{Gain}}_{i}(sigma ^{*}a)}

Para ver esto, notamos primero que si 0}" xmlns="http://www.w3.org/1998/Math/MathML">Gaini()σ σ Alternativa Alternativa ,a)■0{displaystyle {text{Gain}}_{i}(sigma ^{*}a) Confía0}0" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/6b46e6899283ac62308c7580632a292e54e2c627" style="vertical-align: -0.838ex; width:16.445ex; height:2.843ex;"/> entonces esto es verdad por definición de la función de ganancia. Ahora asume que Gaini()σ σ Alternativa Alternativa ,a)=0{displaystyle {text{Gain}}_{i}(sigma ^{*}a)=0}. En nuestras declaraciones anteriores tenemos que

- σ σ iAlternativa Alternativa ()a)=()1C− − 1)Gaini()σ σ Alternativa Alternativa ,a)=0{displaystyle sigma _{*}(a)=left({frac {1}{C-1}right){text{Gain}}_{i}(sigma ^{*},a)=0}

y así el término izquierdo es cero, dándonos que toda la expresión es 0{displaystyle 0} según sea necesario.

Así que finalmente tenemos eso

- 0end{aligned}}}" xmlns="http://www.w3.org/1998/Math/MathML">0=ui()σ σ iAlternativa Alternativa ,σ σ − − iAlternativa Alternativa )− − ui()σ σ iAlternativa Alternativa ,σ σ − − iAlternativa Alternativa )=().. a▪ ▪ Aiσ σ iAlternativa Alternativa ()a)ui()ai,σ σ − − iAlternativa Alternativa ))− − ui()σ σ iAlternativa Alternativa ,σ σ − − iAlternativa Alternativa )=.. a▪ ▪ Aiσ σ iAlternativa Alternativa ()a)()ui()ai,σ σ − − iAlternativa Alternativa )− − ui()σ σ iAlternativa Alternativa ,σ σ − − iAlternativa Alternativa ))=.. a▪ ▪ Aiσ σ iAlternativa Alternativa ()a)Gaini()σ σ Alternativa Alternativa ,a)por las declaraciones anteriores=.. a▪ ▪ Ai()C− − 1)σ σ iAlternativa Alternativa ()a)2■0{displaystyle {begin{aligned}0 limit=u_{i}(sigma _{i}^{*} sigma _{-i} {*})-u_{i}(sigma _{i}^{*} sigma ################################################################################################################################################################################################################################################################ _{ain A_{i}sigma ¿Qué? ¿Qué? sigma _{-i}{*} \fn=sum _{ain ¿Qué? ¿Qué? ¿Qué? sigma _{-i}{*})\ A_{i}sigma {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} }\\fnMicrosoft Sans Serif _{ain A_{i}left(C-1right)sigma _{i}^{*}(a)} {2}end{aligned}}}

0end{aligned}}}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/4ea4fef6857d9bf266486c62e73c19b68e0de8fa" style="vertical-align: -14.171ex; width:75.121ex; height:29.509ex;"/>

donde la última desigualdad sigue desde entonces σ σ iAlternativa Alternativa {displaystyle sigma _{i}{*}} es un vector no cero. Pero esta es una clara contradicción, así que todas las ganancias deben ser cero. Por lo tanto, σ σ Alternativa Alternativa {displaystyle sigma ^{*} es un equilibrio de Nash G{displaystyle G. según sea necesario.

Cálculo de equilibrios de Nash

Si un jugador A tiene una estrategia dominante sA{displaystyle s_{A} entonces existe un equilibrio de Nash en el que A juega sA{displaystyle s_{A}. En el caso de dos jugadores A y B, existe un equilibrio de Nash en el que A juega sA{displaystyle s_{A} y B juega una mejor respuesta sA{displaystyle s_{A}. Si sA{displaystyle s_{A} es una estrategia estrictamente dominante, A play sA{displaystyle s_{A} en todo Nash equilibria. Si ambos A y B tienen estrategias estrictamente dominantes, existe un equilibrio Nash único en el que cada uno juega su estrategia estrictamente dominante.

En juegos con equilibrios de Nash de estrategia mixta, la probabilidad de que un jugador elija cualquier estrategia en particular (tan pura) se puede calcular asignando una variable a cada estrategia que represente una probabilidad fija de elegir esa estrategia. Para que un jugador esté dispuesto a aleatorizar, su pago esperado para cada estrategia (pura) debe ser el mismo. Además, la suma de las probabilidades de cada estrategia de un jugador en particular debe ser 1. Esto crea un sistema de ecuaciones a partir del cual se pueden derivar las probabilidades de elegir cada estrategia.

Ejemplos

| Estrategia | Jugador B juega H | Jugador B juega T |

|---|---|---|

| Jugador A juega H | −1, +1 | +1, −1 |

| Jugador A juega T | +1, −1 | −1, +1 |

En el juego de peniques, el jugador A pierde un punto a B si A y B juegan la misma estrategia y gana un punto de B si juegan estrategias diferentes. Para calcular el equilibrio entre estrategias mixtas, asigne A la probabilidad p{displaystyle p} de jugar H y ()1− − p){displaystyle (1-p)} de jugar T, y asignar B la probabilidad q{displaystyle q} de jugar H y ()1− − q){displaystyle (1-q)} de jugar T.

- E[pago por A jugando H]=()− − 1)q+()+1)()1− − q)=1− − 2qE[pago Un juego de T]=()+1)q+()− − 1)()1− − q)=2q− − 1E[pago por A jugando H]=E[pago Un juego de T]⟹ ⟹ 1− − 2q=2q− − 1⟹ ⟹ q=12E[pago por B jugando H]=()+1)p+()− − 1)()1− − p)=2p− − 1E[pago por B jugando T]=()− − 1)p+()+1)()1− − p)=1− − 2pE[pago por B jugando H]=E[pago por B jugando T]⟹ ⟹ 2p− − 1=1− − 2p⟹ ⟹ p=12{displaystyle {begin{aligned} {E} [{text{payoff for Una jugada H}]=(-1)q+(+1)(1-q)=1-2q\\mathbb {E} [{text{payoff for A playing T}]=(+1)q+(-1)(1-q)=2q-1\\mathbb {E} [{text{payoff for Un juego H}]=Mathbb {E} [{text{payoff for A playing T}]implies 1-2q=2q-1implies q={frac {1}{2}\\\\\fnMithbb {E} [{text{payoff for B playing H}]=(+1)p+(-1)(1-p)=2p-1\\mathbb {E} [{text{payoff for B playing T}]=(-1)p+(+1)(1-p)=1-2p\\mathbb {E} [{text{payoff for B playing H}]=Mathbb {E} [{text{payoff for B playing T}]implies 2p-1=1-2pimplies p={frac {1}\end{aligned}}

Así, un equilibrio entre estrategias mixtas en este juego es para que cada jugador elija al azar H o T con p=12{displaystyle p={frac {1}{2}}} y q=12{displaystyle q={frac {1}{2}}}.

Imparidad de los puntos de equilibrio

En 1971, Robert Wilson propuso el Teorema de la rareza, que dice que "casi todos" Los juegos finitos tienen un número finito e impar de equilibrios de Nash. En 1993, Harsanyi publicó una prueba alternativa del resultado. "Casi todos" aquí significa que cualquier juego con un número infinito o par de equilibrios es muy especial en el sentido de que si sus pagos fueran ligeramente perturbados al azar, con probabilidad uno tendría un número impar de equilibrios.

| Estrategia | Votos del jugador B Sí. | Jugador B votos No |

|---|---|---|

| Jugador A votos Sí | 1, 1 | 0, 0 |

| Jugador A votos No | 0, 0 | 0, 0 |

El dilema del prisionero, por ejemplo, tiene un equilibrio, mientras que la batalla de los sexos tiene tres: dos puros y uno mixto, y esto sigue siendo cierto incluso si los pagos cambian ligeramente. El juego de dinero gratis es un ejemplo de un juego "especial" juego con un número par de equilibrios. En él, dos jugadores tienen que votar "sí" en lugar de "no" para obtener una recompensa y los votos son simultáneos. Hay dos equilibrios de Nash de estrategia pura, (sí, sí) y (no, no), y ningún equilibrio de estrategia mixta, porque la estrategia "sí" domina débilmente "no". "Sí" es tan bueno como "no" independientemente de la acción del otro jugador, pero si hay alguna posibilidad de que el otro jugador elija 'sí' entonces "sí" es la mejor respuesta. Sin embargo, bajo una pequeña perturbación aleatoria de los pagos, la probabilidad de que dos pagos cualesquiera permanezcan empatados, ya sea en 0 o en algún otro número, es muy pequeña, y el juego tendría uno o tres equilibrios en su lugar.

Contenido relacionado

Kristen nygaard

Esclavitud asalariada

Transformada rápida de Fourier

![{displaystyle {begin{aligned}sigma ^{*}=f(sigma ^{*})&Rightarrow sigma _{i}^{*}=f_{i}(sigma ^{*})\&Rightarrow sigma _{i}^{*}={frac {g_{i}(sigma ^{*})}{sum _{ain A_{i}}g_{i}(sigma ^{*})(a)}}\[6pt]&Rightarrow sigma _{i}^{*}={frac {1}{C}}left(sigma _{i}^{*}+{text{Gain}}_{i}(sigma ^{*},cdot)right)\[6pt]&Rightarrow Csigma _{i}^{*}=sigma _{i}^{*}+{text{Gain}}_{i}(sigma ^{*},cdot)\&Rightarrow left(C-1right)sigma _{i}^{*}={text{Gain}}_{i}(sigma ^{*},cdot)\&Rightarrow sigma _{i}^{*}=left({frac {1}{C-1}}right){text{Gain}}_{i}(sigma ^{*},cdot).end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/556e976617ee74da95e980547e8d4f7a1aef701c)

![{displaystyle {begin{aligned}&mathbb {E} [{text{payoff for A playing H}}]=(-1)q+(+1)(1-q)=1-2q\&mathbb {E} [{text{payoff for A playing T}}]=(+1)q+(-1)(1-q)=2q-1\&mathbb {E} [{text{payoff for A playing H}}]=mathbb {E} [{text{payoff for A playing T}}]implies 1-2q=2q-1implies q={frac {1}{2}}\&mathbb {E} [{text{payoff for B playing H}}]=(+1)p+(-1)(1-p)=2p-1\&mathbb {E} [{text{payoff for B playing T}}]=(-1)p+(+1)(1-p)=1-2p\&mathbb {E} [{text{payoff for B playing H}}]=mathbb {E} [{text{payoff for B playing T}}]implies 2p-1=1-2pimplies p={frac {1}{2}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2eb56208b46327ad1d4aba30ca5f8d81a22a043f)