Era de la información

La Era de la información (también conocida como la Era de la computadora, Era digital, Era del silicio o < b>Nueva Era de los Medios) es un período histórico que comenzó a mediados del siglo XX. Se caracteriza por un rápido cambio de las industrias tradicionales, tal como se estableció durante la Revolución Industrial, a una economía centrada en la tecnología de la información. El inicio de la era de la información se ha relacionado con el desarrollo del transistor en 1947, el amplificador óptico en 1957 y el tiempo Unix, que comenzó el 1 de enero de 1970 y sirve como base para el tiempo universal coordinado y el protocolo de tiempo de red. Estos avances tecnológicos han tenido un impacto significativo en la forma en que se procesa y transmite la información.

Según la Red de Administración Pública de las Naciones Unidas, la Era de la Información se formó al capitalizar los avances en la microminiaturización de las computadoras, lo que condujo a la modernización de los sistemas de información y las comunicaciones por Internet como fuerza motriz de la evolución social.

Resumen de los primeros desarrollos

Expansión de la biblioteca y ley de Moore

Fremont Rider calculó en 1945 que la expansión de la biblioteca duplicaría su capacidad cada 16 años cuando hubiera suficiente espacio disponible. Abogó por reemplazar las obras impresas voluminosas y en descomposición con fotografías analógicas en microformas miniaturizadas, que podrían duplicarse a pedido para los usuarios de bibliotecas y otras instituciones.

Rider no previó, sin embargo, la tecnología digital que seguiría décadas más tarde para reemplazar la microforma analógica con imágenes digitales, almacenamiento y medios de transmisión, mediante los cuales se harían posibles grandes aumentos en la rapidez del crecimiento de la información a través de medios automatizados, potencialmente... Tecnologías digitales sin pérdidas. En consecuencia, la ley de Moore, formulada alrededor de 1965, calcularía que el número de transistores en un circuito integrado denso se duplica aproximadamente cada dos años.

A principios de la década de 1980, junto con las mejoras en el poder de cómputo, la proliferación de computadoras personales más pequeñas y menos costosas permitió el acceso inmediato a la información y la capacidad de compartirla y almacenarla. La conectividad entre las computadoras dentro de las organizaciones permitió el acceso a una mayor cantidad de información.

Almacenamiento de información y ley de Kryder

La capacidad tecnológica mundial para almacenar información creció de 2,6 exabytes (EB) (comprimidos de forma óptima) en 1986 a 15,8 EB en 1993; más de 54,5 EB en 2000; ya 295 EB (comprimidos de manera óptima) en 2007. Este es el equivalente informativo a menos de un CD-ROM de 730 megabytes (MB) por persona en 1986 (539 MB por persona); aproximadamente cuatro CD-ROM por persona en 1993; doce CD-ROM por persona en el año 2000; y casi sesenta y un CD-ROM por persona en 2007. Se estima que la capacidad mundial para almacenar información alcanzó los 5 zettabytes en 2014, el equivalente informativo de 4.500 pilas de libros impresos desde la tierra hasta el sol.

La cantidad de datos digitales almacenados parece estar creciendo de forma aproximadamente exponencial, lo que recuerda a la ley de Moore. Como tal, la ley de Kryder prescribe que la cantidad de espacio de almacenamiento disponible parece estar creciendo de manera exponencial.

Transmisión de información

La capacidad tecnológica mundial para recibir información a través de redes de transmisión unidireccionales era de 432 exabytes de información (comprimida de manera óptima) en 1986; 715 exabytes (comprimidos de forma óptima) en 1993; 1,2 zettabytes (comprimidos de forma óptima) en 2000; y 1,9 zettabytes en 2007, la información equivalente a 174 diarios por persona y día.

La capacidad efectiva mundial para intercambiar información a través de redes de telecomunicaciones bidireccionales era de 281 petabytes de información (comprimida de manera óptima) en 1986; 471 petabytes en 1993; 2,2 exabytes (comprimidos de forma óptima) en 2000; y 65 (comprimidos de manera óptima) exabytes en 2007, la información equivalente a 6 periódicos por persona por día. En la década de 1990, la expansión de Internet provocó un salto repentino en el acceso y la capacidad para compartir información en empresas y hogares de todo el mundo. La tecnología se estaba desarrollando tan rápidamente que una computadora que costaba $3000 en 1997 costaría $2000 dos años después y $1000 el año siguiente.

Cálculo

La capacidad tecnológica mundial para procesar información con computadoras de propósito general guiadas por humanos creció de 3,0 × 108 MIPS en 1986 a 4,4 × 109 MIPS en 1993; a 2,9 × 1011 MIPS en 2000; a 6,4 × 1012 MIPS en 2007. Un artículo publicado en la revista Trends in Ecology and Evolution en 2016 informó que:

La tecnología digital ha superado enormemente la capacidad cognitiva de cualquier ser humano único y lo ha hecho una década antes de lo previsto. En términos de capacidad, hay dos medidas de importancia: el número de operaciones que un sistema puede realizar y la cantidad de información que se puede almacenar. El número de operaciones sinápticas por segundo en un cerebro humano se ha estimado que miente entre 10^15 y 10^17. Aunque este número es impresionante, incluso en 2007 las computadoras de uso general de la humanidad fueron capaces de realizar más de 10^18 instrucciones por segundo. Las estimaciones sugieren que la capacidad de almacenamiento de un cerebro humano individual es de unos 10^12 bytes. Sobre una base per cápita, esto se combina con el almacenamiento digital actual (5x10^21 bytes por 7.2x10^9 personas).

Información genética

El código genético también puede considerarse parte de la revolución de la información. Ahora que la secuenciación ha sido informatizada, el genoma se puede representar y manipular como datos. Esto comenzó con la secuenciación del ADN, inventada por Walter Gilbert y Allan Maxam en 1976-1977 y Frederick Sanger en 1977, creció constantemente con el Proyecto Genoma Humano, inicialmente concebido por Gilbert y, finalmente, las aplicaciones prácticas de la secuenciación, como las pruebas genéticas, después de el descubrimiento por parte de Myriad Genetics de la mutación del gen del cáncer de mama BRCA1. Los datos de secuencias en Genbank han crecido de las 606 secuencias de genomas registradas en diciembre de 1982 a los 231 millones de genomas en agosto de 2021. En agosto de 2021, se registraron 13 billones de secuencias incompletas adicionales en la base de datos de presentación de Whole Genome Shotgun. La información contenida en estos registros registrados secuencias se ha duplicado cada 18 meses.

Conceptualizaciones de diferentes etapas

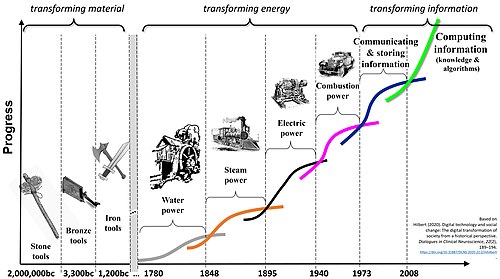

Durante tiempos excepcionales en la historia humana, ha habido períodos de innovación que han transformado la vida humana. La Era Neolítica, la Era Científica y la Era Industrial, en última instancia, indujeron cambios discontinuos e irreversibles en los elementos económicos, sociales y culturales de la vida diaria de la mayoría de las personas. Tradicionalmente, estas épocas han tenido lugar durante cientos, o en el caso de la Revolución Neolítica, miles de años, mientras que la Era de la Información se extendió por todas partes del mundo en solo unos pocos años. La razón de su rápida adopción es el rápido avance de la velocidad del intercambio de información.

Hace entre 7.000 y 10.000 años, durante el período Neolítico, los humanos comenzaron a domesticar animales, comenzaron a cultivar granos y a reemplazar las herramientas de piedra por otras de metal. Estas innovaciones permitieron que los cazadores-recolectores nómadas se establecieran. Las aldeas se formaron a lo largo del río Yangtze en China en el año 6500 a.C., en la región del río Nilo en África y en Mesopotamia (Iraq) en el año 6000 a.C. Las ciudades surgieron entre el 6.000 a.C. y 3500 a.C. El desarrollo de la comunicación escrita (cuneiforme en Sumeria y jeroglíficos en Egipto en el 3500 a. C. y escritura en Egipto en el 2560 a. C. y en Minoa y China alrededor del 1450 a. C.) permitió que las ideas se conservaran durante períodos prolongados para difundirse ampliamente. En total, los desarrollos del Neolítico, aumentados por la escritura como herramienta de información, sentaron las bases para el advenimiento de la civilización.

La era científica comenzó en el período entre la prueba de Galileo en 1543 de que los planetas giran alrededor del sol y la publicación de Newton de las leyes del movimiento y la gravedad en Principia en 1697. Esta era de descubrimiento continuó durante el siglo XVIII, acelerada por el uso generalizado de la imprenta de tipos móviles por parte de Johannes Gutenberg.

La era industrial comenzó en Gran Bretaña en 1760 y continuó hasta mediados del siglo XIX. Alteró muchos aspectos de la vida en todo el mundo. La invención de máquinas como la tejedora textil mecánica de Edmund Cartwrite, la máquina de vapor de eje giratorio de James Watt y la desmotadora de algodón de Eli Whitney, junto con los procesos de fabricación en masa, llegaron a satisfacer las necesidades de una población mundial en crecimiento. La era industrial aprovechó el vapor y la energía hidráulica para reducir la dependencia del trabajo físico animal y humano como principal medio de producción. Así, el núcleo de la Revolución Industrial fue la generación y distribución de energía a partir del carbón y el agua para producir vapor y, más adelante en el siglo XX, electricidad.

La era de la información también requiere electricidad para alimentar las redes globales de computadoras que procesan y almacenan datos. Sin embargo, lo que aceleró dramáticamente el ritmo de adopción de la era de la información, en comparación con las anteriores, fue la velocidad con la que el conocimiento podía transferirse e impregnar a toda la familia humana en unas pocas décadas. Esta aceleración se produjo con la adopción de una nueva forma de poder. A partir de 1972, los ingenieros idearon formas de aprovechar la luz para transmitir datos a través del cable de fibra óptica. Hoy en día, los sistemas de redes ópticas basadas en luz en el corazón de las redes de telecomunicaciones e Internet se extienden por todo el mundo y transportan la mayor parte del tráfico de información hacia y desde los usuarios y los sistemas de almacenamiento de datos.

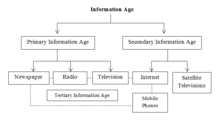

Existen diferentes conceptualizaciones de la era de la información. Algunos se centran en la evolución de la información a lo largo de las edades, distinguiendo entre la Era de la Información Primaria y la Era de la Información Secundaria. La información en la era de la información primaria estaba a cargo de los periódicos, la radio y la televisión. La Era de la Información Secundaria fue desarrollada por Internet, las televisiones por satélite y los teléfonos móviles. La Era de la Información Terciaria surgió por los medios de la Era de la Información Primaria interconectados con los medios de la Era de la Información Secundaria tal como se experimenta actualmente.

Otros lo clasifican en términos de las bien establecidas ondas largas schumpeterianas u ondas de Kondratiev. Aquí los autores distinguen tres metaparadigmas a largo plazo diferentes, cada uno con diferentes ondas largas. El primero se centró en la transformación del material, incluida la piedra, el bronce y el hierro. La segunda, a menudo denominada revolución industrial, se dedicó a la transformación de la energía, incluidos el agua, el vapor, la electricidad y la combustión. Finalmente, el metaparadigma más reciente apunta a transformar la información. Comenzó con la proliferación de la comunicación y los datos almacenados y ahora ha entrado en la era de los algoritmos, cuyo objetivo es crear procesos automatizados para convertir la información existente en conocimiento procesable.

Economía

Con el tiempo, las tecnologías de la información y la comunicación (TIC), es decir, computadoras, maquinaria computarizada, fibra óptica, satélites de comunicación, Internet y otras herramientas TIC— se convirtieron en una parte importante de la economía mundial, ya que el desarrollo de las redes ópticas y las microcomputadoras cambió en gran medida muchas empresas e industrias. Nicholas Negroponte capturó la esencia de estos cambios en su libro de 1995, Being Digital, en el que analiza las similitudes y diferencias entre productos hechos de átomos y productos hechos de bits.

Empleos y distribución del ingreso

La era de la información ha afectado a la fuerza laboral de varias maneras, como obligar a los trabajadores a competir en un mercado laboral global. Una de las preocupaciones más evidentes es la sustitución de la mano de obra humana por computadoras que puedan hacer su trabajo de manera más rápida y eficaz, creando así una situación en la que las personas que realizan tareas que pueden automatizarse fácilmente se ven obligadas a encontrar empleo donde su trabajo no es tan desechable. Esto crea un problema especialmente para aquellos en ciudades industriales, donde las soluciones generalmente implican reducir el tiempo de trabajo, lo que a menudo es muy resistido. Por lo tanto, las personas que pierden sus trabajos pueden verse presionadas a ascender y unirse a los 'trabajadores de la mente'. (por ejemplo, ingenieros, médicos, abogados, maestros, profesores, científicos, ejecutivos, periodistas, consultores), que pueden competir con éxito en el mercado mundial y recibir salarios (relativamente) altos.

Junto con la automatización, los trabajos tradicionalmente asociados con la clase media (por ejemplo, línea de montaje, procesamiento de datos, administración y supervisión) también han comenzado a desaparecer como resultado de la subcontratación. Incapaces de competir con los de los países en desarrollo, los trabajadores de la producción y los servicios en las sociedades posindustriales (es decir, desarrolladas) pierden sus trabajos a través de la subcontratación, aceptan recortes salariales o se conforman con trabajos de servicios de baja calificación y bajos salarios. En el pasado, el destino económico de los individuos estaría ligado al de su nación. Por ejemplo, los trabajadores en los Estados Unidos alguna vez fueron bien pagados en comparación con los de otros países. Con el advenimiento de la era de la información y las mejoras en la comunicación, este ya no es el caso, ya que los trabajadores ahora deben competir en un mercado laboral global, en el que los salarios dependen menos del éxito o el fracaso de las economías individuales.

Al llevar a cabo una fuerza laboral globalizada, Internet también ha permitido mayores oportunidades en los países en desarrollo, haciendo posible que los trabajadores en esos lugares brinden servicios en persona, por lo tanto, compiten directamente con sus contrapartes en otras naciones. Esta ventaja competitiva se traduce en mayores oportunidades y salarios más altos.

Automatización, productividad y creación de empleo

La era de la información ha afectado a la fuerza laboral en el sentido de que la automatización y la informatización han resultado en una mayor productividad junto con la pérdida neta de empleos en la fabricación. En los Estados Unidos, por ejemplo, desde enero de 1972 hasta agosto de 2010, la cantidad de personas empleadas en trabajos de manufactura se redujo de 17 500 000 a 11 500 000, mientras que el valor de la manufactura aumentó un 270 %. Aunque inicialmente parecía que la pérdida de puestos de trabajo en el sector industrial podría compensarse parcialmente con el rápido crecimiento de puestos de trabajo en tecnología de la información, la recesión de marzo de 2001 presagió una fuerte caída en el número de puestos de trabajo en el sector. Este patrón de disminución de puestos de trabajo continuaría hasta 2003, y los datos han demostrado que, en general, la tecnología crea más puestos de trabajo de los que destruye, incluso a corto plazo.

Industria intensiva en información

La industria se ha vuelto más intensiva en información y menos intensiva en mano de obra y capital. Esto ha dejado implicaciones importantes para la fuerza laboral, ya que los trabajadores se han vuelto cada vez más productivos a medida que disminuye el valor de su trabajo. Para el sistema del capitalismo mismo, el valor del trabajo disminuye, el valor del capital aumenta.

En el modelo clásico, las inversiones en capital humano y financiero son indicadores importantes del desempeño de una nueva empresa. Sin embargo, como lo demostraron Mark Zuckerberg y Facebook, ahora parece posible que un grupo de personas relativamente inexpertas con un capital limitado tenga éxito a gran escala.

Innovaciones

La era de la información fue posible gracias a la tecnología desarrollada en la revolución digital, que a su vez fue posible gracias a los desarrollos de la revolución tecnológica.

Transistores

El inicio de la era de la información se puede asociar con el desarrollo de la tecnología de transistores. El concepto de transistor de efecto de campo fue teorizado por primera vez por Julius Edgar Lilienfeld en 1925. El primer transistor práctico fue el transistor de contacto puntual, inventado por los ingenieros Walter Houser Brattain y John Bardeen mientras trabajaban para William Shockley en Bell Labs en 1947. Este fue un gran avance que sentó las bases para la tecnología moderna. El equipo de investigación de Shockley también inventó el transistor de unión bipolar en 1952. El tipo de transistor más utilizado es el transistor de efecto de campo semiconductor de óxido de metal (MOSFET), inventado por Mohamed M. Atalla y Dawon Kahng en Bell Labs. en 1960. El proceso de fabricación de MOS complementario (CMOS) fue desarrollado por Frank Wanlass y Chih-Tang Sah en 1963.

Ordenadores

Antes de la llegada de la electrónica, las computadoras mecánicas, como el motor analítico en 1837, se diseñaron para proporcionar cálculos matemáticos de rutina y capacidades simples de toma de decisiones. Las necesidades militares durante la Segunda Guerra Mundial impulsaron el desarrollo de las primeras computadoras electrónicas, basadas en válvulas de vacío, incluidas la Z3, la computadora Atanasoff-Berry, la computadora Colossus y ENIAC.

La invención del transistor hizo posible la era de las computadoras centrales (de 1950 a 1970), tipificada por la IBM 360. Estas computadoras grandes, del tamaño de una habitación, proporcionaban un cálculo y una manipulación de datos mucho más rápidos de lo humanamente posible, pero eran costosos de comprar y mantener, por lo que inicialmente se limitaron a unas pocas instituciones científicas, grandes corporaciones y agencias gubernamentales.

El circuito integrado de germanio (IC) fue inventado por Jack Kilby en Texas Instruments en 1958. El circuito integrado de silicio fue inventado en 1959 por Robert Noyce en Fairchild Semiconductor, utilizando el proceso planar desarrollado por Jean Hoerni, quien a su vez fue basándose en el método de pasivación de la superficie de silicio de Mohamed Atalla desarrollado en Bell Labs en 1957. Tras la invención del transistor MOS por Mohamed Atalla y Dawon Kahng en Bell Labs en 1959, el circuito integrado MOS fue desarrollado por Fred Heiman y Steven Hofstein en RCA en 1962. El MOS IC de puerta de silicio fue desarrollado más tarde por Federico Faggin en Fairchild Semiconductor en 1968. Con la llegada del transistor MOS y el MOS IC, la tecnología de transistores mejoró rápidamente y la relación entre potencia informática y tamaño aumentó drásticamente., dando acceso directo a las computadoras a grupos cada vez más pequeños de personas.

El primer microprocesador comercial de un solo chip lanzado en 1971, el Intel 4004, que fue desarrollado por Federico Faggin utilizando su tecnología MOS IC de puerta de silicio, junto con Marcian Hoff, Masatoshi Shima y Stan Mazor.

Junto con las máquinas recreativas electrónicas y las consolas de videojuegos para el hogar iniciadas por Nolan Bushnell en la década de 1970, el desarrollo de computadoras personales como Commodore PET y Apple II (ambas en 1977) dieron a las personas acceso a la computadora. Pero el intercambio de datos entre computadoras individuales era inexistente o en gran parte manual, al principio usando tarjetas perforadas y cinta magnética, y luego disquetes.

Datos

Los primeros desarrollos para el almacenamiento de datos se basaron inicialmente en fotografías, comenzando con la microfotografía en 1851 y luego con la microforma en la década de 1920, con la capacidad de almacenar documentos en película, haciéndolos mucho más compactos. La teoría de la información temprana y los códigos de Hamming se desarrollaron alrededor de 1950, pero esperaban innovaciones técnicas en la transmisión y el almacenamiento de datos para poder utilizarlos por completo.

La memoria de núcleo magnético se desarrolló a partir de la investigación de Frederick W. Viehe en 1947 y An Wang en la Universidad de Harvard en 1949. Con la llegada del transistor MOS, John Schmidt desarrolló la memoria de semiconductores MOS en Fairchild Semiconductor en 1964. En 1967, Dawon Kahng y Simon Sze en Bell Labs describieron en 1967 cómo la puerta flotante de un dispositivo semiconductor MOS podría usarse para la celda de una ROM reprogramable. Tras la invención de la memoria flash por Fujio Masuoka en Toshiba en 1980, Toshiba comercializó la memoria flash NAND en 1987.

Los cables de alambre de cobre que transmiten datos digitales conectan terminales de computadora y periféricos a mainframes, y sistemas especiales para compartir mensajes que conducen al correo electrónico, se desarrollaron por primera vez en la década de 1960. Las redes independientes de computadora a computadora comenzaron con ARPANET en 1969. Esto se expandió para convertirse en Internet (acuñado en 1974). El acceso a Internet mejoró con la invención de la World Wide Web en 1991. La expansión de la capacidad a partir de la multiplexación por división de onda densa, la amplificación óptica y las redes ópticas a mediados de la década de 1990 condujo a tasas de transferencia de datos sin precedentes. Para 2018, las redes ópticas entregaban rutinariamente 30,4 terabits/s a través de un par de fibra óptica, el equivalente de datos de 1,2 millones de transmisiones de video HD 4K simultáneas.

La escala de MOSFET, la rápida miniaturización de los MOSFET a una velocidad predicha por la ley de Moore, llevó a que las computadoras se hicieran más pequeñas y poderosas, hasta el punto en que podían transportarse. Durante las décadas de 1980 y 1990, las computadoras portátiles se desarrollaron como una forma de computadora portátil y los asistentes digitales personales (PDA) se podían usar mientras estaba de pie o caminando. Los buscapersonas, ampliamente utilizados en la década de 1980, fueron reemplazados en gran medida por teléfonos móviles a partir de fines de la década de 1990, lo que proporcionó funciones de red móvil a algunas computadoras. Ahora común, esta tecnología se extiende a las cámaras digitales y otros dispositivos portátiles. A partir de fines de la década de 1990, las tabletas y luego los teléfonos inteligentes combinaron y ampliaron estas capacidades de computación, movilidad e intercambio de información. Los sensores de imagen de semiconductores de óxido de metal (MOS), que comenzaron a aparecer a fines de la década de 1960, llevaron a la transición de imágenes analógicas a digitales y de cámaras analógicas a digitales durante las décadas de 1980 y 1990. Los sensores de imagen más comunes son el sensor de dispositivo de carga acoplada (CCD) y el sensor de píxeles activos (sensor CMOS) CMOS (MOS complementario).

El papel electrónico, que tiene su origen en la década de 1970, permite que la información digital aparezca como documentos en papel.

Ordenadores personales

En 1976, había varias empresas compitiendo para presentar las primeras computadoras personales comerciales realmente exitosas. Tres máquinas, Apple II, PET 2001 y TRS-80, se lanzaron en 1977 y se convirtieron en las más populares a finales de 1978. La revista Byte más tarde se refirió a Commodore, Apple y Tandy como las "1977 Trinidad". También en 1977, Sord Computer Corporation lanzó la computadora doméstica inteligente Sord M200 en Japón.

Apple II

Steve Wozniak (conocido como "Woz"), un visitante habitual de las reuniones del Homebrew Computer Club, diseñó la computadora Apple I de placa única y la demostró por primera vez allí. Con las especificaciones en la mano y un pedido de 100 máquinas a US$500 cada una de Byte Shop, Woz y su amigo Steve Jobs fundaron Apple Computer.

Alrededor de 200 de las máquinas vendidas antes de que la empresa anunciara la Apple II como una computadora completa. Tenía gráficos en color, un teclado QWERTY completo y ranuras internas para expansión, que estaban montadas en una carcasa de plástico aerodinámica de alta calidad. El monitor y los dispositivos de E/S se vendieron por separado. El sistema operativo Apple II original era solo el intérprete BASIC incorporado contenido en la ROM. Se agregó Apple DOS para admitir la unidad de disquete; la última versión fue "Apple DOS 3.3".

Su precio más alto y la falta de punto flotante BASIC, junto con la falta de sitios de distribución minorista, hicieron que las ventas se quedaran atrás con respecto a las otras máquinas Trinity hasta 1979, cuando superó al PET. Volvió a ocupar el cuarto lugar cuando Atari presentó sus populares sistemas Atari de 8 bits.

A pesar de las bajas ventas iniciales, la vida útil de la Apple II fue unos ocho años más larga que la de otras máquinas, por lo que acumuló las ventas totales más altas. Para 1985, se habían vendido 2,1 millones y se enviaron más de 4 millones de Apple II al final de su producción en 1993.

Redes ópticas

La comunicación óptica juega un papel crucial en las redes de comunicación. La comunicación óptica proporciona la columna vertebral de transmisión para las redes informáticas y de telecomunicaciones que subyacen a Internet, la base de la revolución digital y la era de la información.

Las dos tecnologías principales son la fibra óptica y la amplificación de luz (el amplificador óptico). En 1953, Bram van Heel demostró la transmisión de imágenes a través de haces de fibras ópticas con un revestimiento transparente. El mismo año, Harold Hopkins y Narinder Singh Kapany del Imperial College lograron fabricar haces de transmisión de imágenes con más de 10 000 fibras ópticas y, posteriormente, lograron la transmisión de imágenes a través de un haz de 75 cm de largo que combinaba varios miles de fibras.

Gordon Gould inventó el amplificador óptico y el láser, y también estableció la primera empresa de telecomunicaciones ópticas, Optelecom, para diseñar sistemas de comunicación. La empresa fue cofundadora de Ciena Corp., la empresa que popularizó el amplificador óptico con la introducción del primer sistema de multiplexación por división de onda densa. Esta tecnología de comunicación a gran escala se ha convertido en la base común de todas las redes de telecomunicaciones y, por tanto, en la base de la era de la información.

Economía, sociedad y cultura

Manuel Castells capta el significado de la era de la información en La era de la información: economía, sociedad y cultura cuando escribe sobre nuestra interdependencia global y las nuevas relaciones entre economía, estado y sociedad, lo que él llama "una nueva sociedad en construcción." Advierte que el hecho de que los humanos hayan dominado el mundo material no significa que la era de la información sea el final de la historia:

De hecho, es todo lo contrario: la historia está empezando, si por la historia entendemos el momento en que, después de milenios de una batalla prehistórica con la Naturaleza, primero para sobrevivir, luego conquistarla, nuestra especie ha alcanzado el nivel de conocimiento y organización social que nos permitirá vivir en un mundo predominantemente social. Es el comienzo de una nueva existencia, y de hecho el comienzo de una nueva era, La Era de la Información, marcada por la autonomía de la cultura frente a la base material de nuestra existencia.

Contenido relacionado

Refugio Churnsike

Checoslovaquia

Telecomunicaciones en Brasil