Derivado

En matemáticas, la derivada de una función de una variable real mide la sensibilidad al cambio del valor de la función (valor de salida) con respecto a un cambio en su argumento (valor de entrada). Las derivadas son una herramienta fundamental del cálculo. Por ejemplo, la derivada de la posición de un objeto en movimiento con respecto al tiempo es la velocidad del objeto: mide qué tan rápido cambia la posición del objeto cuando el tiempo avanza.

La derivada de una función de una sola variable en un valor de entrada elegido, cuando existe, es la pendiente de la línea tangente a la gráfica de la función en ese punto. La línea tangente es la mejor aproximación lineal de la función cerca de ese valor de entrada. Por esta razón, la derivada a menudo se describe como la "tasa de cambio instantánea", la relación entre el cambio instantáneo de la variable dependiente y el de la variable independiente.

Las derivadas se pueden generalizar a funciones de varias variables reales. En esta generalización, la derivada se reinterpreta como una transformación lineal cuya gráfica es (después de una traducción adecuada) la mejor aproximación lineal a la gráfica de la función original. La matriz jacobiana es la matriz que representa esta transformación lineal con respecto a la base dada por la elección de las variables independientes y dependientes. Se puede calcular en términos de las derivadas parciales con respecto a las variables independientes. Para una función de valor real de varias variables, la matriz jacobiana se reduce al vector gradiente.

El proceso de encontrar una derivada se llama diferenciación. El proceso inverso se llama antidiferenciación. El teorema fundamental del cálculo relaciona la antidiferenciación con la integración. La diferenciación y la integración constituyen las dos operaciones fundamentales en el cálculo de una sola variable.

Definición

Una función de una variable real f(x) es diferenciable en un punto a de su dominio, si su dominio contiene un intervalo abierto I que contiene a, y el límite

- L=limh→ → 0f()a+h)− − f()a)h{displaystyle L=lim _{hto 0}{frac {f(a+h)-f(a)}{h}}

existe. Esto significa que, por cada número real positivo ε ε {displaystyle varepsilon } (incluso muy pequeño), existe un número real positivo δ δ {displaystyle delta } así, por cada h tales que <math alttext="{displaystyle |h|SilenciohSilencio.δ δ {displaystyle Нововованиваниванный<img alt="{displaystyle |h| y hل ل 0{displaystyle hneq 0} entonces f()a+h){displaystyle f(a+h)} se define, y

- <math alttext="{displaystyle left|L-{frac {f(a+h)-f(a)}{h}}right|SilencioL− − f()a+h)− − f()a)hSilencio.ε ε ,{displaystyle left WordPress-{frac {f(a+h)-f(a)}{h}}right sobre la vida escuchadavarepsilon}<img alt="{displaystyle left|L-{frac {f(a+h)-f(a)}{h}}right|

donde las barras verticales indican el valor absoluto (ver (ε, δ)-definición de límite).

Si la función f es diferente en a, eso es si el límite L existe, entonces este límite se llama el derivados de f a a, y denotado f.()a){displaystyle f'(a)} (leer como "f de primera a") o dfdx()a){fnK}(a)} (leer como "el derivado de f con respecto a x a a", "dy por dx a a", o "dy sobre dx a a); véase § Notación (detalles), a continuación.

Continuidad y diferenciabilidad

Si f es diferenciable en a, entonces f también debe ser continuo en a. Como ejemplo, elija un punto a y sea f la función de paso que devuelve el valor 1 para todos los x menores que a, y devuelve un valor diferente de 10 para todas las x mayores o iguales que a. f no puede tener una derivada en a. Si h es negativo, entonces a + h está en la parte inferior del escalón, por lo que la línea secante desde a hasta a + h es muy empinada, y como h tiende a cero, la pendiente tiende hasta el infinito. Si h es positivo, entonces a + h está en la parte alta del escalón, por lo que la línea secante desde a hasta a + h tiene pendiente cero. En consecuencia, las rectas secantes no se acercan a ninguna pendiente única, por lo que el límite del cociente de diferencias no existe.

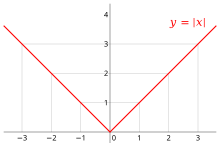

Sin embargo, incluso si una función es continua en un punto, es posible que no sea diferenciable allí. Por ejemplo, la función de valor absoluto dada por f(x) = |x| es continuo en x = 0, pero no es diferenciable allí. Si h es positivo, entonces la pendiente de la recta secante de 0 a h es uno, mientras que si h es negativo, entonces la pendiente de la recta secante de 0 a h es uno negativo. Esto se puede ver gráficamente como un "torcedura" o una "cúspide" en el gráfico en x = 0. Incluso una función con un gráfico uniforme no es diferenciable en un punto donde su tangente es vertical: por ejemplo, la función dada por f(x) = x1/3 no es diferenciable en x = 0.

En resumen, una función que tiene derivada es continua, pero hay funciones continuas que no tienen derivada.

La mayoría de las funciones que ocurren en la práctica tienen derivadas en todos los puntos o en casi todos los puntos. Al principio de la historia del cálculo, muchos matemáticos asumieron que una función continua era diferenciable en la mayoría de los puntos. En condiciones suaves, por ejemplo, si la función es una función monótona o una función de Lipschitz, esto es cierto. Sin embargo, en 1872 Weierstrass encontró el primer ejemplo de una función que es continua en todas partes pero diferenciable en ninguna. Este ejemplo ahora se conoce como la función de Weierstrass. En 1931, Stefan Banach demostró que el conjunto de funciones que tienen derivada en algún punto es un conjunto exiguo en el espacio de todas las funciones continuas. Informalmente, esto significa que casi ninguna función aleatoria continua tiene una derivada en un solo punto.

Derivada como función

(feminine)Sea f una función que tiene una derivada en cada punto de su dominio. Luego podemos definir una función que asigna cada punto x al valor de la derivada de f en x. Esta función se escribe f′ y es llamada la función derivada o la derivada de f.

A veces, f tiene una derivada en la mayoría de los puntos de su dominio, pero no en todos. La función cuyo valor en a es igual a f′(a) siempre que f′(a) está definido y en otros lugares no está definido, también se denomina derivado de f. Sigue siendo una función, pero su dominio puede ser más pequeño que el dominio de f.

Usando esta idea, la diferenciación se convierte en una función de funciones: La derivada es un operador cuyo dominio es el conjunto de todas las funciones que tienen derivadas en cada punto de su dominio y cuyo rango es un conjunto de funciones. Si denotamos este operador por D, entonces D(f) es la función f′. Dado que D(f) es una función, se puede evaluar en un punto a. Por la definición de la función derivada, D(f)(a) = f′(a).

Para comparar, considere la función de duplicación dada por f(x) = 2x; f es una función de valor real de un número real, lo que significa que toma números como entradas y tiene números como salidas:

- 1↦ ↦ 2,2↦ ↦ 4,3↦ ↦ 6.{displaystyle {begin{aligned}1 {}mapsto 2,2 reducida{}mapsto 4,3 {}m]mpsto 6.end{aligned}}

El operador D, sin embargo, no está definido en números individuales. Solo se define en funciones:

- D()x↦ ↦ 1)=()x↦ ↦ 0),D()x↦ ↦ x)=()x↦ ↦ 1),D()x↦ ↦ x2)=()x↦ ↦ 2⋅ ⋅ x).{displaystyle {begin{aligned}D(xmapsto 1) ventaja=(xmapsto 0),\D(xmapsto x) adult=(xmapsto 1),Dleft(xmapsto x^{2}right)} {c]}(xmapsto 2cdot x).end{aligned}}}}}}}}}}}}}}}}}}}}}

Debido a que la salida de D es una función, la salida de D se puede evaluar en un punto. Por ejemplo, cuando D se aplica a la función cuadrada, x ↦ x2, D genera la función de duplicación x ↦ 2x, que llamamos f(x). Esta función de salida se puede evaluar para obtener f(1) = 2, f(2) = 4, y así sucesivamente.

Derivadas superiores

Sea f una función diferenciable, y sea f ′ sea su derivada. La derivada de f ′ (si la tiene) se escribe f ′′ y se denomina segunda derivada de f. De manera similar, la derivada de la segunda derivada, si existe, se escribe f ′′′ y se llama tercera derivada de f. Continuando con este proceso, se puede definir, si existe, la nésima derivada como la derivada de la (n−1)ésima derivada. Estas derivadas repetidas se denominan derivadas de orden superior. La nésima derivada también se denomina derivada de orden n y denotado f (n).

Si x(t) representa la posición de un objeto en el momento t, entonces las derivadas de orden superior de x tienen interpretaciones específicas en física. La primera derivada de x es la velocidad del objeto. La segunda derivada de x es la aceleración. La tercera derivada de x es el idiota. Y finalmente, las derivadas cuarta a sexta de x son chasquido, crujido y estallido; más aplicable a la astrofísica.

Una función f no necesita tener una derivada (por ejemplo, si no es continua). De manera similar, incluso si f tiene una derivada, es posible que no tenga una segunda derivada. Por ejemplo, deja

- f()x)={}+x2,six≥ ≥ 0− − x2,six≤ ≤ 0.{displaystyle f(x)={begin{cases}+x^{2}, reducida{text{if }xgeq 0\x^{2}, limit{if }xleq 0.end{cases}}}

La cálculo muestra que f es una función diferenciable cuyo derivado a x{displaystyle x} es dado por

- f.()x)={}+2x,six≥ ≥ 0− − 2x,six≤ ≤ 0.{displaystyle f'(x)={begin{cases}+2x, reducida{if }xgeq 0-2x, limitante {if }xend{cases}}}}

f '()x) es el doble de la función de valor absoluto x{displaystyle x}, y no tiene un derivado a cero. Ejemplos similares muestran que una función puede tener una kth derivative for each non-negative integer k pero no ()k + 1)derivado. Una función que tiene k derivados sucesivos se llama k tiempos diferentes. Si además el kel derivado es continuo, entonces se dice que la función es de clase de diferenciabilidad Ck. (Esta es una condición más fuerte que tener k derivados, como muestra el segundo ejemplo de Smoothness § Ejemplos.) Una función que tiene infinitamente muchos derivados se llama infinitamente diferente o lisa.

En la recta real, toda función polinomial es infinitamente diferenciable. Por reglas de diferenciación estándar, si un polinomio de grado n se deriva n veces, entonces se convierte en una función constante. Todas sus derivadas posteriores son idénticamente cero. En particular, existen, por lo que los polinomios son funciones suaves.

Las derivadas de una función f en un punto x proporcione aproximaciones polinómicas a esa función cerca de x. Por ejemplo, si f es dos veces diferenciable, entonces

- f()x+h).. f()x)+f.()x)h+12f.()x)h2{displaystyle f(x+h)approx f(x)+f'(x)h+{tfrac {1}{2}f'(x)h^{2}}

en el sentido de que

- limh→ → 0f()x+h)− − f()x)− − f.()x)h− − 12f.()x)h2h2=0.{displaystyle lim _{hto 0}{frac {f(x+h)-f(x)-f'(x)h-{frac {1} {2}f''h^{2}{h^{2}}}=0}} {f} {f} {f}f}

Si f es infinitamente diferenciable, entonces este es el comienzo de la serie de Taylor para f evaluado en x + h alrededor de x.

Punto de inflexión

Un punto donde el segundo derivado de un signo de cambios de función se llama punto de inflexión. En un punto de inflexión, el segundo derivado puede ser cero, como en el caso del punto de inflexión x = 0 de la función dada por f()x)=x3{displaystyle f(x)=x^{3}, o puede no existir, como en el caso del punto de inflexión x = 0 de la función dada por f()x)=x13{displaystyle f(x)=x^{frac {1}{3}}. En un punto de inflexión, una función cambia de ser una función convexa a ser una función concave o viceversa.

Notación (detalles)

Notación de Leibniz

Los símbolos dx{displaystyle dx}, dSí.{displaystyle dy}, y dSí.dx{displaystyle {frac {}{dx}} fueron introducidos por Gottfried Wilhelm Leibniz en 1675. Todavía se utiliza comúnmente cuando la ecuación Sí. = f()x) se considera una relación funcional entre variables dependientes e independientes. Entonces el primer derivado es denotado por

- dSí.dx,dfdx,oddxf,{displaystyle {frac {f} {f}f} {f}} {text{ or }}{frac} {f} {f}}} {f}}} {f}f} {dx}f,}

y alguna vez se pensó que era un cociente infinitesimal. Las derivadas superiores se expresan usando la notación

- dnSí.dxn,dnfdxn,odndxnf{displaystyle {frac {f} {f}}} {f}f} {f}} {f} {f}} {f}} {f}}}f} {f}} {f}} {f}}} {f}}} {f}}}} {f}}} {f}}}}} {f} {f}}}} {}}}}}}}}}}} {f}}} {f}}}}} {f}}}}}}}}}}}} {f} {}}}}}}}}}}}}}}}} {f}}}}} {f} {f}}}}}}}}}}} {f}}}} {f}}}}}}}}}}}}}}}}}}}}}} {f}}}}}}}}}}}}}}}}}}}}}}}}}

para el nth derivative of Sí.=f()x){displaystyle y=f(x)}. Estas son abreviaturas para múltiples aplicaciones del operador derivado. Por ejemplo,

- d2Sí.dx2=ddx()dSí.dx).{displaystyle {frac {f} {f}}={f}}={f} {f}} {f}} {f}}} {f}}}} {d}dx}left({frac {y}right)}

Con la notación de Leibniz, podemos escribir el derivado de Sí.{displaystyle y} en el punto x=a{displaystyle x=a} de dos maneras diferentes:

- dSí.dxSilenciox=a=dSí.dx()a).{displaystyle left.{frac {y} {dx} {fnMicroc} {fnMicroc} {fnMicroc} {y} {dx}(a).}

La notación de Leibniz permite especificar la variable para la diferenciación (en el denominador), que es relevante en la diferenciación parcial. También se puede usar para escribir la regla de la cadena como

- dSí.dx=dSí.du⋅ ⋅ dudx.{displaystyle {frac {fnMicroc} {fnMicroc} {fnMicrosoft} {fnMicrosoft} {fn}}} {fnMicrosoft}}}}} {fnMicroc}}}} {fnMicroc} {y} {du}cdot {fnMic {} {fnK}}}

Notación de Lagrange

A veces referido como primera notación, una de las notaciones modernas más comunes para la diferenciación es debido a Joseph-Louis Lagrange y utiliza la marca principal, de modo que el derivado de una función f{displaystyle f} es denotado f.{displaystyle f'}. Del mismo modo, los derivados segundo y tercero son denotados

- ()f.).=f.{displaystyle (f')'=f'} y ()f.).=f′′.{displaystyle (f'')'=f''.}

Para indicar el número de derivadas más allá de este punto, algunos autores usan números romanos en superíndice, mientras que otros colocan el número entre paréntesis:

- fiv{displaystyle f^{mathrm {}}} o f()4).{displaystyle f^{(4)}

Esta última notación generaliza el rendimiento de la notación f()n){displaystyle f^{(n)} para el nth derivative of f{displaystyle f} – esta notación es muy útil cuando deseamos hablar del derivado como una función en sí, como en este caso la notación de Leibniz puede llegar a ser engorrosa.

Notación de Newton

La notación de Newton para la diferenciación, también llamada la notación de puntos, coloca un punto sobre el nombre de la función para representar un derivado del tiempo. Si Sí.=f()t){displaystyle y=f(t)}, entonces

- Sí.Í Í {displaystyle { dot {y}} y Sí... {displaystyle {ddot {}}}

denota, respectivamente, los derivados primero y segundo de Sí.{displaystyle y}. Esta notación se utiliza exclusivamente para derivados con respecto al tiempo o longitud de arco. Se utiliza típicamente en ecuaciones diferenciales en física y geometría diferencial. La notación de puntos, sin embargo, se vuelve inmanageable para derivados de alto orden (orden 4 o más) y no puede tratar con múltiples variables independientes.

Notación de Euler

La notación de Euler utiliza un operador diferencial D{displaystyle D}, que se aplica a una función f{displaystyle f} para dar el primer derivado Df{displaystyle Df.. El nth derivative is denoted Dnf{displaystyle D^{n}f}.

Si y = f(x) es una variable dependiente, entonces a menudo el subíndice x se adjunta a la D para aclarar la variable independiente x. Luego se escribe la notación de Euler

- DxSí.{displaystyle D_{x}y} o Dxf()x){displaystyle D_{x}f(x)},

aunque este subíndice a menudo se omite cuando se entiende la variable x, por ejemplo, cuando esta es la única variable independiente presente en la expresión.

La notación de Euler es útil para enunciar y resolver ecuaciones diferenciales lineales.

Reglas de cálculo

La derivada de una función puede, en principio, calcularse a partir de la definición considerando el cociente de diferencias y calculando su límite. En la práctica, una vez que se conocen las derivadas de algunas funciones simples, las derivadas de otras funciones se calculan más fácilmente usando reglas para obtener derivadas de funciones más complicadas a partir de otras más simples.

Reglas para funciones básicas

Estas son las reglas para las derivadas de las funciones básicas más comunes, donde a es un número real.

- Derivativos de poderes:

- ddxxa=axa− − 1.{displaystyle {frac {dx}x^{a}=ax^{a-1}

- Funciones exponenciales y logarítmicas:

- ddxex=ex.{displaystyle {frac {dx}e^{x}=e^{x}

- 0}" xmlns="http://www.w3.org/1998/Math/MathML">ddxax=axIn ()a),a■0{displaystyle {frac {dx}a}=a^{x}ln(a),qquad a confía0}

0}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/d45f4385b350131524cc1672f79de17340944c09" style="vertical-align: -2.005ex; width:27.82ex; height:5.509ex;"/>

- 0.}" xmlns="http://www.w3.org/1998/Math/MathML">ddxIn ()x)=1x,x■0.{displaystyle {frac {dx}ln(x)={frac {1}}}qquad x confianza0.}

0." aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/3f5c086b15d3f8c104011b5125089811cd704fa0" style="vertical-align: -2.005ex; width:26.028ex; height:5.509ex;"/>

- 0}" xmlns="http://www.w3.org/1998/Math/MathML">ddxloga ()x)=1xIn ()a),x,a■0{displaystyle {frac {d}log _{a}(x)={frac {1}{xln(a)}}}qquad x,a}0}

0}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/4e8d6dc82c78d0c9f98fa48093b76dd23d5f47a4" style="vertical-align: -2.671ex; width:35.145ex; height:6.176ex;"/>

- Funciones trigonométricas:

- ddxpecado ()x)=# ()x).{displaystyle {frac {d}sin(x)=cos(x).}

- ddx# ()x)=− − pecado ()x).{displaystyle {frac {d}cos(x)=-sin(x).}

- ddx# ()x)=sec2 ()x)=1#2 ()x)=1+#2 ()x).{displaystyle {frac {d}tan(x)=sec ^{2}(x)={frac {1}{cos ^{2}(x)}=1+tan ^{2}(x). }

- Funciones trigonométricas inversas:

- <math alttext="{displaystyle {frac {d}{dx}}arcsin(x)={frac {1}{sqrt {1-x^{2}}}},qquad -1<xddxarcsin ()x)=11− − x2,− − 1.x.1.{displaystyle {frac {d}dx}arcsin(x)={frac {1}{sqrt {1-x^{2}}}}}},qquad -1 se hizo realidad1.}<img alt="{displaystyle {frac {d}{dx}}arcsin(x)={frac {1}{sqrt {1-x^{2}}}},qquad -1<x

- <math alttext="{displaystyle {frac {d}{dx}}arccos(x)=-{frac {1}{sqrt {1-x^{2}}}},qquad -1<xddxarccos ()x)=− − 11− − x2,− − 1.x.1.{displaystyle {frac {dx}arccos(x)=-{frac {1} {sqrt {1-x^{2}}}}qquad -1 se hizo realidad1.}<img alt="{displaystyle {frac {d}{dx}}arccos(x)=-{frac {1}{sqrt {1-x^{2}}}},qquad -1<x

- ddxarctan ()x)=11+x2{displaystyle {frac {dx}arctan(x)={frac {1}{1+x^{2}}}

Reglas para funciones combinadas

Estas son algunas de las reglas más básicas para deducir la derivada de una función compuesta a partir de derivadas de funciones básicas.

- Regla constanteSi f()x) es constante, entonces

- f.()x)=0.{displaystyle f'(x)=0.}

- Regla de Sum:

- ()α α f+β β g).=α α f.+β β g.{displaystyle (alpha f+beta g)'=alpha f'+beta g'} para todas las funciones f y g y todos los números reales α α {displaystyle alpha } y β β {displaystyle beta }.

- Regla de producto:

- ()fg).=f.g+fg.{displaystyle (fg)'=f'g+fg'} para todas las funciones f y g. Como caso especial, esta norma incluye el hecho ()α α f).=α α f.{displaystyle (alpha f)'=alpha f'} siempre α α {displaystyle alpha } es una constante, porque α α .f=0⋅ ⋅ f=0{displaystyle alpha 'f=0cdot f=0} por la regla constante.

- Regla de referencia:

- ()fg).=f.g− − fg.g2{displaystyle left {f} {f}}} {f}}}} {f}}} {f}}} {f}} {f}}} {f}}} para todas las funciones f y g en todas las entradas donde g ل 0.

- Regla de cadena para funciones compuestas: Si f()x)=h()g()x)){displaystyle f(x)=h(g(x)}, entonces

- f.()x)=h.()g()x))⋅ ⋅ g.()x).{displaystyle f'(x)=h'(g(x))cdot g'(x). }

Ejemplo de cálculo

La derivada de la función dada por

- f()x)=x4+pecado ()x2)− − In ()x)ex+7{displaystyle f(x)=x^{4}+sin left(x^{2}right)-ln(x)e^{x}+7}

es

- f.()x)=4x()4− − 1)+d()x2)dx# ()x2)− − d()In x)dxex− − In ()x)d()ex)dx+0=4x3+2x# ()x2)− − 1xex− − In ()x)ex.{x} {x}} {x} {x}} {x}}} {x}} {cccccccccccccH0}} {ccH0} {cH0}cccH0} {cccH0}cccH0} {ccH0}cccH0}ccccH00}cccccccccccccccH00}ccH00}ccccccccccccccccccccccccccccccH00}ccH00}ccccccccccc

Aquí el segundo término se calculó usando la regla de la cadena y el tercero usando la regla del producto. Las derivadas conocidas de las funciones elementales x2, x4, sin(x), ln(x) y exp(x) = ex También se utilizaron , así como la constante 7.

Definición con hiperreales

Relativo a una extensión hiperreal R ⊂ ⁎R de los números reales, la derivada de una función real y = f(x) en un punto real x se puede definir como la sombra del cociente ∆y/∆x para infinitesimal ∆x, donde ∆y = f(x + ∆x) − f(x ). Aquí la extensión natural de f a los hiperreales todavía se denota f. Aquí se dice que la derivada existe si la sombra es independiente del infinitesimal elegido.

En dimensiones superiores

Funciones con valores vectoriales

Una función vectorial y de una variable real envía números reales a vectores en algún espacio vectorial Rn. Una función con valores vectoriales se puede dividir en sus funciones de coordenadas y1(t), y2(t),..., yn(t), lo que significa que y(t) = ( y1(t),..., yn(t)). Esto incluye, por ejemplo, curvas paramétricas en R2 o R3. Las funciones de coordenadas son funciones de valor real, por lo que se les aplica la definición anterior de derivada. La derivada de y(t) se define como el vector, llamado vector tangente, cuyas coordenadas son las derivadas de las funciones de coordenadas. Es decir,

- Sí..()t)=()Sí.1.()t),...... ,Sí.n.()t)).{displaystyle mathbf {y} '(t)=(y'_{1}(t),ldotsy'_{n}(t)). }

Equivalentemente,

- Sí..()t)=limh→ → 0Sí.()t+h)− − Sí.()t)h,{displaystyle mathbf {y} '(t)=lim _{hto 0}{frac {mathbf {y} (t+h)-mathbf {y} {h}}}}} {}} {f}

si existe el límite. La resta en el numerador es la resta de vectores, no de escalares. Si la derivada de y existe para cada valor de t, entonces y′ es otra función vectorial.

Si e1,..., en es la base estándar para Rn, luego y(t) también se puede escribir como y1(t) e1 + ⋯ + yn(t)en. Si asumimos que la derivada de una función vectorial conserva la propiedad de linealidad, entonces la derivada de y(t) debe ser

- Sí.1.()t)e1+⋯ ⋯ +Sí.n.()t)en{displaystyle y'_{1}(t)mathbf {e} _{1}+cdots +y'_{n}(t)mathbf {e} _{n}

porque cada uno de los vectores base es una constante.

Esta generalización es útil, por ejemplo, si y(t) es el vector de posición de una partícula en el tiempo t; entonces la derivada y′(t) es el vector de velocidad de la partícula en el tiempo t.

Derivadas parciales

Supongamos que f es una función que depende de más de una variable, por ejemplo,

- f()x,Sí.)=x2+xSí.+Sí.2.{displaystyle f(x,y)=x^{2}+xy+y^{2}

f se puede reinterpretar como una familia de funciones de una variable indexada por las otras variables:

- f()x,Sí.)=fx()Sí.)=x2+xSí.+Sí.2.{displaystyle f(x,y)=f_{x}(y)=x^{2}+xy+y^{2}

En otras palabras, cada valor de x elige una función, denominada fx, que es una función de un número real. Es decir,

- x↦ ↦ fx,{displaystyle xmapsto f_{x},}

- fx()Sí.)=x2+xSí.+Sí.2.{displaystyle f_{x}(y)=x^{2}+xy+y^{2}

Una vez que se elige un valor de x, diga a, luego f(x , y) determina una función fa que envía y a a2 + ay + y2:

- fa()Sí.)=a2+aSí.+Sí.2.{displaystyle f_{a}(y)=a^{2}+ay+y^{2}

En esta expresión, a es una constante, no una variable, por lo que fa es una función de una sola variable real. En consecuencia, se aplica la definición de la derivada para una función de una variable:

- fa.()Sí.)=a+2Sí..{displaystyle f_{a}(y)=a+2y.}

El procedimiento anterior se puede realizar para cualquier elección de a. Reunir las derivadas en una función da como resultado una función que describe la variación de f en la dirección y:

- ∂ ∂ f∂ ∂ Sí.()x,Sí.)=x+2Sí..{displaystyle {frac {partial f} {partial y}(x,y)=x+2y.}

Esta es la derivada parcial de f con respecto a y. Aquí ∂ es una d redondeada llamada símbolo de derivada parcial. Para distinguirla de la letra d, ∂ a veces se pronuncia "der", "del" o "parcial" en lugar de "dee".

En general, la derivada parcial de una función f(x1, …, xn) en la dirección xi en el punto (a1,..., an) se define como:

- ∂ ∂ f∂ ∂ xi()a1,...... ,an)=limh→ → 0f()a1,...... ,ai+h,...... ,an)− − f()a1,...... ,ai,...... ,an)h.{displaystyle {frac {partial f}{partial [A_{1},ldotsa_{n}]=lim _{hto 0}{frac {f(a_{1},ldotsa_{i}+h,ldotsa_{n})-f(a_{1},ldotsa_{i} {}} {}}}} {}} {}}}} {}}} {}}}}} {}}}}}}}}}}} {ldot} {}}}}} {}}}} {}}}}}} {}}}}}}}} {}}}}} {}}}}}}}}}}}} {}}}}}}}}}} {ldot}} {}}}}}}}}}}}}}} {}}}}}} {}}}} {}}}}}}}}}} {}}}}}}}}}}}}}} {}}}}}}}}}}}}}}

En el cociente de diferencia anterior, todas las variables excepto xi se mantienen fijas. Esa elección de valores fijos determina una función de una variable

- fa1,...... ,ai− − 1,ai+1,...... ,an()xi)=f()a1,...... ,ai− − 1,xi,ai+1,...... ,an),{displaystyle f_{a_{1},ldotsa_{i-1},a_{i+1},ldotsa_{n}(x_{i})=f(a_{1},ldotsa_{i-1},x_{i},a_{i+1},ldotsa_{n}}}}

y, por definición,

- dfa1,...... ,ai− − 1,ai+1,...... ,andxi()ai)=∂ ∂ f∂ ∂ xi()a1,...... ,an).{displaystyle {frac {df_{a_{1},ldotsa_{i-1},a_{i+1},ldotsa_{n}}}{dx_{i}} {a_{i}={i}={f} {f} {f}} {f}}} {f}}}} {f}}} {f}}}}}}}}}} {f} {f}} {f}}}}}}}}}}}}}} {f}}}} {f}}}}}}}}}}}} {f} {f} {f} {f} {f} {f}} {f}}}}}}}}}}}}}}}}}}}}f}}}}}f}}}}}}}}}f}}}}}}f}f}}}f}}}}}}}}} {partial f}{partial x_{i} {a_{1},ldotsa_{n}). }

En otras palabras, las diferentes opciones de a indexan una familia de funciones de una variable tal como en el ejemplo anterior. Esta expresión también muestra que el cálculo de derivadas parciales se reduce al cálculo de derivadas de una variable.

Esto es fundamental para el estudio de las funciones de varias variables reales. Sea f(x1,..., x n) sea una función de valor tan real. Si todas las derivadas parciales ∂f / ∂xj de f se definen en el punto a = (a1,..., an), estos parciales derivadas definen el vector

- Silencio Silencio f()a1,...... ,an)=()∂ ∂ f∂ ∂ x1()a1,...... ,an),...... ,∂ ∂ f∂ ∂ xn()a1,...... ,an)),{displaystyle nabla f(a_{1},ldotsa_{n}=left({frac {partial f}{partial [a_{1}},ldotsa_{n}),ldots{frac {partial f}{partial f}{partial ¿Qué?

que se llama el gradiente de f en a. Si f es diferenciable en cada punto de algún dominio, entonces el gradiente es una función vectorial ∇f que mapea el punto (a1,..., an) al vector ∇f(a1,..., an). En consecuencia, el gradiente determina un campo vectorial.

Derivadas direccionales

(feminine)Si f es una función de valor real en Rn, entonces las derivadas parciales de f miden su variación en la dirección de los ejes de coordenadas. Por ejemplo, si f es una función de x y y, entonces sus derivadas parciales miden la variación en f en la dirección x y en la dirección y. Sin embargo, no miden directamente la variación de f en ninguna otra dirección, como a lo largo de la línea diagonal y = x. Estos se miden utilizando derivadas direccionales. Elige un vector

- v=()v1,...... ,vn).{displaystyle mathbf {v} =(v_{1},ldotsv_{n}). }

La derivada direccional de f en la dirección de v en el punto x es el límite

- Dvf()x)=limh→ → 0f()x+hv)− − f()x)h.{displaystyle D_{mathbf}{f}(mathbf {x}=lim _{hrightarrow Oh, Dios.

En algunos casos, puede ser más fácil calcular o estimar la derivada direccional después de cambiar la longitud del vector. A menudo, esto se hace para convertir el problema en el cálculo de una derivada direccional en la dirección de un vector unitario. Para ver cómo funciona esto, supongamos que v = λu donde u es un vector unitario en la dirección de v. Sustituye h = k/λ en el cociente de diferencia. El cociente de la diferencia se convierte en:

- f()x+()k/λ λ )()λ λ u))− − f()x)k/λ λ =λ λ ⋅ ⋅ f()x+ku)− − f()x)k.{displaystyle {frac {f(mathbf {x} +(k/lambda)(lambda mathbf {u}))-f(mathbf {x}{k/lambda }=lambda cdot {frac {f(mathbf {x} +kmathbf {u})-f(mathbf {x}} {k}}}}} {ccHFF}

Esto es λ veces el cociente de diferencia para la derivada direccional de f con respecto a u. Además, tomar el límite cuando h tiende a cero es lo mismo que tomar el límite cuando k tiende a cero porque h y k son múltiplos entre sí. Por lo tanto, Dv(f) = λDu(f). Debido a esta propiedad de cambio de escala, las derivadas direccionales se consideran con frecuencia solo para vectores unitarios.

Si todas las derivadas parciales de f existen y son continuas en x, entonces determinan la derivada direccional de f en la dirección v por la fórmula:

- Dvf()x)=.. j=1nvj∂ ∂ f∂ ∂ xj.{displaystyle D_{mathbf} {f} {f}}=sum _{j=1}{n}v_{j}{j}{f}{f}{f}{f} {f} {partial f}{partial #

Esto es una consecuencia de la definición de la derivada total. De ello se deduce que la derivada direccional es lineal en v, lo que significa que Dv + w(f) = Dv(f) + Dw(f).

La misma definición también funciona cuando f es una función con valores en Rm. La definición anterior se aplica a cada componente de los vectores. En este caso, la derivada direccional es un vector en Rm.

Derivada total, diferencial total y matriz jacobiana

Cuando f es una función de un subconjunto abierto de Rn a Rm, entonces la derivada direccional de f en una dirección elegida es la mejor aproximación lineal a f en ese punto y en esa dirección. Pero cuando n > 1, ninguna derivada direccional única puede dar una imagen completa del comportamiento de f. La derivada total da una imagen completa al considerar todas las direcciones a la vez. Es decir, para cualquier vector v que comience en a, se cumple la fórmula de aproximación lineal:

- f()a+v).. f()a)+f.()a)v.{displaystyle f(mathbf {a} +mathbf {v})approx f(mathbf {a})+f'(mathbf {a})mathbf {v}.}

Al igual que la derivada de una sola variable, se elige f ′(a) para que el error en este la aproximación es lo más pequeña posible.

Si n y m son uno, entonces la derivada f ′(a ) es un número y la expresión f ′(a)v es el producto de dos números. Pero en dimensiones superiores, es imposible que f ′(a) sea un número. Si fuera un número, f ′(a)v sería un vector en Rn mientras que los otros términos serían vectores en Rm, y por lo tanto la fórmula no tendría sentido. Para que la fórmula de aproximación lineal tenga sentido, f ′(a) debe ser una función que envíe vectores en Rn a vectores en Rm, y f ′(a)v debe indicar esta función evaluada en v.

Para determinar qué tipo de función es, observe que la fórmula de aproximación lineal se puede reescribir como

- f()a+v)− − f()a).. f.()a)v.{displaystyle f(mathbf {a} +mathbf {v})-f(mathbf {a})approx f'(mathbf {a})mathbf {v}.}

Observe que si elegimos otro vector w, entonces esta ecuación aproximada determina otra ecuación aproximada sustituyendo w por v. Determina una tercera ecuación aproximada sustituyendo w por v y a + v para a. Al restar estas dos nuevas ecuaciones, obtenemos

- f()a+v+w)− − f()a+v)− − f()a+w)+f()a).. f.()a+v)w− − f.()a)w.{displaystyle f(mathbf {a} +mathbf {v} +mathbf {w})-f(mathbf {a} +mathbf {v})-f(mathbf {a} +mathbf {w})+f(mathbf {a})approx f'(mathbf {a} +mathbf {f} {w}mathbf} {w})mathbf} {mathbf}c}cc}ccccH0}cccH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00}cH00} Mathbf.

Si asumimos que v es pequeño y que la derivada varía continuamente en a, entonces f ′(a + v) es aproximadamente igual a f ′(a ) y, por lo tanto, el lado derecho es aproximadamente cero. El lado izquierdo se puede reescribir de una manera diferente usando la fórmula de aproximación lineal con v + w sustituido por v. La fórmula de aproximación lineal implica:

- 0.. f()a+v+w)− − f()a+v)− − f()a+w)+f()a)=()f()a+v+w)− − f()a))− − ()f()a+v)− − f()a))− − ()f()a+w)− − f()a)).. f.()a)()v+w)− − f.()a)v− − f.()a)w.{displaystyle {begin{aligned}0 ventajaapprox f(mathbf {a} ¿Qué?

Esto sugiere que f ′(a) es una transformación lineal del espacio vectorial Rn al espacio vectorial Rm. De hecho, es posible hacer de esto una derivación precisa midiendo el error en las aproximaciones. Suponga que el error en esta fórmula de aproximación lineal está acotado por una constante multiplicada por ||v||, donde la constante es independiente de v pero depende continuamente de a . Luego, después de agregar un término de error apropiado, todas las igualdades aproximadas anteriores se pueden reformular como desigualdades. En particular, f ′(a) es una transformación lineal hasta un término de error pequeño. En el límite como v y w tienden a cero, por lo tanto debe ser una transformación lineal. Dado que definimos la derivada total tomando un límite cuando v llega a cero, f ′(a) debe ser una transformación lineal.

En una variable, el hecho de que la derivada sea la mejor aproximación lineal se expresa por el hecho de que es el límite de los cocientes de diferencias. Sin embargo, el cociente de diferencias habitual no tiene sentido en dimensiones superiores porque normalmente no es posible dividir vectores. En particular, el numerador y el denominador del cociente de diferencias ni siquiera están en el mismo espacio vectorial: el numerador se encuentra en el codominio Rm mientras que el denominador se encuentra en el dominio Rn. Además, la derivada es una transformación lineal, un tipo de objeto diferente tanto del numerador como del denominador. Para precisar la idea de que f ′(a) es la mejor aproximación lineal, es necesario adaptar una diferente fórmula para la derivada de una variable en la que estos problemas desaparecen. Si f: R → R, entonces se puede manipular la definición habitual de la derivada para mostrar que la derivada de f en a es el número único f ′(a) tal que

- limh→ → 0f()a+h)− − ()f()a)+f.()a)h)h=0.{displaystyle lim _{hto 0}{frac {f(a+h)-(f(a)+f'(a)h)}{h}=0}

Esto es equivalente a

- limh→ → 0Silenciof()a+h)− − ()f()a)+f.()a)h)SilencioSilenciohSilencio=0{displaystyle lim _{hto 0}{frac { sometidaf(a+h)-(f(a)+f'(a)h)h)

porque el límite de una función tiende a cero si y solo si el límite del valor absoluto de la función tiende a cero. Esta última fórmula se puede adaptar a la situación de muchas variables reemplazando los valores absolutos con normas.

La definición de la derivada total de f en a, por lo tanto, es que es la única transformación lineal f ′(a): Rn → Rm tal que

- limh→ → 0.. f()a+h)− − ()f()a)+f.()a)h).. .. h.. =0.{displaystyle lim _{mathbf {h} to 0}{frac {l Vert f(mathbf {a} +mathbf {h})-(f(mathbf {a})+f'(mathbf {a})mathbf {h})rVert }{l Vert mathbf {h}=0}

Aquí h es un vector en Rn, por lo que la norma en el denominador es la longitud estándar en Rn. Sin embargo, f′(a)h es un vector en Rm, y la norma en el numerador es la longitud estándar en Rm. Si v es un vector que comienza en a, entonces f ′(a)v es llamado el avance de v por f y a veces se escribe f∗v.

Si la derivada total existe en a, entonces todas las derivadas parciales y direccionales de f existen en a, y para todo v, f ′(a)v es la dirección derivada de f en la dirección v. Si escribimos f usando funciones de coordenadas, de modo que f = (f1, f2,..., fm), entonces la derivada total se puede expresar usando las derivadas parciales como matriz. Esta matriz se denomina matriz jacobiana de f en a:

- f.()a)=Jaca=()∂ ∂ fi∂ ∂ xj)ij.{displaystyle f'(mathbf {a})=operatorname [Jac] _{mathbf {a} #=left({fracpartial F_{i}{partial - Sí.

La existencia de la derivada total f′(a) es estrictamente más fuerte que la existencia de todas las derivadas parciales, pero si las derivadas parciales existen y son continuas, entonces la derivada total existe, viene dada por el jacobiano y depende continuamente de a.

La definición de la derivada total subsume la definición de la derivada en una variable. Es decir, si f es una función de valor real de una variable real, entonces la derivada total existe si y solo si existe la derivada habitual. La matriz jacobiana se reduce a una matriz 1×1 cuya única entrada es la derivada f′(x). Esta matriz 1×1 satisface la propiedad de que f(a + h) − (f (a) + f ′(a)h) es aproximadamente cero, en otras palabras que

- f()a+h).. f()a)+f.()a)h.{displaystyle f(a+h)approx f(a)+f'(a)h.}

Hasta variables cambiantes, esta es la afirmación de que la función x↦ ↦ f()a)+f.()a)()x− − a){displaystyle xmapsto f(a)+f'(a)(x-a)} es la mejor aproximación lineal a f a a.

La derivada total de una función no da otra función de la misma manera que en el caso de una variable. Esto se debe a que la derivada total de una función multivariable tiene que registrar mucha más información que la derivada de una función de una sola variable. En cambio, la derivada total da una función desde el paquete tangente de la fuente al paquete tangente del objetivo.

El análogo natural de las derivadas totales de segundo, tercer y orden superior no es una transformación lineal, no es una función en el paquete tangente y no se construye tomando repetidamente la derivada total. El análogo de una derivada de orden superior, llamada chorro, no puede ser una transformación lineal porque las derivadas de orden superior reflejan información geométrica sutil, como la concavidad, que no se puede describir en términos de datos lineales como los vectores. No puede ser una función en el paquete tangente porque el paquete tangente solo tiene espacio para el espacio base y las derivadas direccionales. Debido a que los chorros capturan información de orden superior, toman como argumentos coordenadas adicionales que representan cambios de dirección de orden superior. El espacio determinado por estas coordenadas adicionales se denomina haz de jets. La relación entre la derivada total y las derivadas parciales de una función es paralela a la relación entre el jet de orden késimo de una función y sus derivadas parciales de orden menor o igual a k.

Al tomar repetidamente la derivada total, se obtienen versiones superiores de la derivada de Fréchet, especializada en Rp. La derivada total de késimo orden puede interpretarse como un mapa

- Dkf:Rn→ → Lk()Rn× × ⋯ ⋯ × × Rn,Rm){displaystyle "Mathbb" L^{k}(mathbb {R} ^{n}times cdots times mathbb {R} ^{n},mathbb {R})}

que toma un punto x en Rn y le asigna un elemento del espacio de k-mapas lineales de Rn a Rm : el "mejor" (en cierto sentido preciso) k-aproximación lineal a f en ese punto. Al precomponerlo con el mapa diagonal Δ, x → (x, x), una serie de Taylor generalizada puede comenzar como

- f()x).. f()a)+()Df)()x− − a)+()D2f)()Δ Δ ()x− − a))+⋯ ⋯ =f()a)+()Df)()x− − a)+()D2f)()x− − a,x− − a)+⋯ ⋯ =f()a)+.. i()Df)i()xi− − ai)+.. j,k()D2f)jk()xj− − aj)()xk− − ak)+⋯ ⋯ {fnMicrosoft Sans Serif}

donde f(a) se identifica con una función constante, xi − ai son las componentes del vector x − a y (Df)i y (D2f)jk son los componentes de Df y D 2f como transformaciones lineales.

Generalizaciones

El concepto de derivado se puede extender a muchos otros escenarios. El hilo común es que la derivada de una función en un punto sirve como una aproximación lineal de la función en ese punto.

- Una importante generalización de la derivación se refiere a funciones complejas de variables complejas, tales como funciones de (un dominio en) los números complejos C a C. La noción del derivado de tal función se obtiene reemplazando variables reales por variables complejas en la definición. Si C se identifica con R2 escribiendo un número complejo z como x + i, entonces una función diferente de C a C es ciertamente diferente como una función de R2 a R2 (en el sentido de que todos sus derivados parciales existen), pero el converso no es cierto en general: el derivado complejo sólo existe si el derivado real es lineal complejo y esto impone relaciones entre los derivados parciales llamados las ecuaciones Cauchy-Riemann – ver funciones holomorfas.

- Otra generalización se refiere a las funciones entre los diferentes o suaves. Intuitivamente hablando como un manifold M es un espacio que se puede aproximar cerca de cada punto x por un espacio vectorial llamado su espacio tangente: el ejemplo prototípico es una superficie lisa R3. El derivado (o diferencial) de un mapa (diferenciable) f: M → N en un momento x dentro M, es entonces un mapa lineal desde el espacio tangente M a x al espacio tangente N a f()x). La función derivada se convierte en un mapa entre los paquetes tangentes de M y N. Esta definición es fundamental en la geometría diferencial y tiene muchos usos – ver pushforward (diferencial) y pullback (geometría diferencial).

- La diferenciación también se puede definir para mapas entre espacios vectoriales dimensionales infinitos como espacios de Banach y espacios Fréchet. Hay una generalización tanto del derivado direccional, llamado el derivado de Gateaux, como del diferencial, llamado el derivado de Fréchet.

- Una deficiencia del derivado clásico es que muchas funciones no son diferenciables. Sin embargo, hay una manera de extender la noción del derivado para que todas las funciones continuas y muchas otras funciones puedan ser diferenciadas utilizando un concepto conocido como el derivado débil. La idea es incrustar las funciones continuas en un espacio más grande llamado el espacio de distribuciones y sólo requiere que una función sea diferente "en promedio".

- Las propiedades del derivado han inspirado la introducción y estudio de muchos objetos similares en álgebra y topología — ver, por ejemplo, álgebra diferencial.

- El equivalente discreto de diferenciación es diferencias finitas. El estudio del cálculo diferencial se unifica con el cálculo de diferencias finitas en el cálculo de escala temporal.

- También vea derivado aritmético.

Historia

El cálculo, conocido en su historia temprana como cálculo infinitesimal, es una disciplina matemática centrada en límites, funciones, derivadas, integrales y series infinitas. Isaac Newton y Gottfried Leibniz descubrieron el cálculo de forma independiente a mediados del siglo XVII. Sin embargo, cada inventor afirmó que el otro robó su trabajo en una amarga disputa que continuó hasta el final de sus vidas.

Contenido relacionado

Ecuación lineal

Conjetura de poincaré

Zurra