Curtosis

En teoría de probabilidad y estadística, kurtosis (del griego: κυρτός, kyrtos o kurtos, que significa "curvado, arqueado") es una medida de la "colada" de la distribución de probabilidad de una variable aleatoria de valor real. Al igual que la asimetría, la curtosis describe un aspecto particular de una distribución de probabilidad. Existen diferentes formas de cuantificar la curtosis para una distribución teórica, y existen formas correspondientes de estimarla utilizando una muestra de una población. Diferentes medidas de curtosis pueden tener diferentes interpretaciones.

La medida estándar de la curtosis de una distribución, que se originó con Karl Pearson, es una versión escalada del cuarto momento de la distribución. Este número está relacionado con las colas de la distribución, no con su pico; por lo tanto, la caracterización a veces vista de la curtosis como "picos" Es incorrecto. Para esta medida, una mayor curtosis corresponde a una mayor extremidad de las desviaciones (o valores atípicos), y no a la configuración de datos cerca de la media.

Es común comparar el exceso de curtosis (definido a continuación) de una distribución con 0, que es el exceso de curtosis de cualquier distribución normal univariante. Se dice que las distribuciones con un exceso de curtosis negativo son platicúrticas, aunque esto no implica que la distribución sea "de parte superior plana" como se afirma a veces. Más bien, significa que la distribución produce menos valores atípicos y/o menos extremos que la distribución normal. Un ejemplo de distribución platicúrtica es la distribución uniforme, que no produce valores atípicos. Las distribuciones con un exceso de curtosis positivo se denominan leptocúrticas. Un ejemplo de una distribución leptocúrtica es la distribución de Laplace, que tiene colas que asintóticamente se acercan a cero más lentamente que una gaussiana y, por lo tanto, produce más valores atípicos que la distribución normal. Es una práctica común usar el exceso de curtosis, que se define como la curtosis de Pearson menos 3, para proporcionar una comparación simple con la distribución normal. Algunos autores y paquetes de software usan "curtosis" por sí mismo para referirse al exceso de curtosis. Sin embargo, para mayor claridad y generalidad, este artículo indica explícitamente dónde se entiende que no hay exceso de curtosis.

Las medidas alternativas de la curtosis son: la L-curtosis, que es una versión escalada del cuarto momento L; medidas basadas en cuatro cuantiles de población o muestra. Estas son análogas a las medidas alternativas de asimetría que no se basan en momentos ordinarios.

Momentos Pearson

La curtosis es el cuarto momento estandarizado, definido como

- Kurt [X]=E [()X− − μ μ σ σ )4]=E [()X− − μ μ )4]()E [()X− − μ μ )2])2=μ μ 4σ σ 4,{displaystyle operatorname {Kurt} [X]= {E} left[left({frac {X-mu }{sigma }right)^{4}right]={frac {operatorname {E} left[(X-mu)}{4} {left {e}left {E}left {E}left {c}{2}{}{}}}}}{}}}}}}}}}}}}}}{dere}}}}}}} {c}}}}}}}}}}}}}}i}i}i}i}i}i}i}i}i}i}i}i}i}i}i}i}i}c}i}i}i}i}i}i}i}i}i}i}i}i}i}i}i}i}i}i} - ¿Qué?

donde μ4 es el cuarto momento central y σ es la desviación estándar. Varias letras se utilizan en la literatura para indicar la curtosis. Una opción muy común es κ, que está bien siempre que quede claro que no se refiere a un cumulante. Otras opciones incluyen γ2, para ser similar a la notación de asimetría, aunque a veces esto se reserva para el exceso de curtosis.

La curtosis está limitada a continuación por la asimetría al cuadrado más 1:

- μ μ 4σ σ 4≥ ≥ ()μ μ 3σ σ 3)2+1,{displaystyle {frac {fnMicroc} {fnK} {fnMicroc {fnMicroc {fnMicroc} ¿Qué?

donde μ3 es el tercer momento central. El límite inferior se realiza mediante la distribución de Bernoulli. No existe un límite superior para la curtosis de una distribución de probabilidad general y puede ser infinita.

Una razón por la que algunos autores favorecen el exceso de curtosis es que los cumulantes son extensos. Las fórmulas relacionadas con la propiedad extensiva se expresan más naturalmente en términos del exceso de curtosis. Por ejemplo, sean X1,..., Xn independientes variables aleatorias para las que existe el cuarto momento, y sea Y la variable aleatoria definida por la suma de las Xi. El exceso de curtosis de Y es

- Kurt [Y]− − 3=1().. j=1nσ σ j2)2.. i=1nσ σ i4⋅ ⋅ ()Kurt [Xi]− − 3),{displaystyle operatorname {Kurt} [Y]-3={frac {1}{left _{j=1}sigma ¿Qué? ###{i=1} {n}sigma ################################################################################################################################################################################################################################################################ {Kurt} left[X_{i}right]-3right),}

Donde σ σ i{displaystyle sigma _{i} es la desviación estándar de Xi{displaystyle X_{i}. En particular, si todos Xi tener la misma varianza, entonces esto simplifica

- Kurt [Y]− − 3=1n2.. i=1n()Kurt [Xi]− − 3).{displaystyle operatorname {Kurt} [Y]-3={1over n^{2}sum ################################################################################################################################################################################################################################################################ {Kurt} left[X_{i}right]-3right). }

La razón para no restar 3 es que el cuarto momento simple se generaliza mejor a las distribuciones multivariadas, especialmente cuando no se asume la independencia. La cocurtosis entre pares de variables es un tensor de orden cuatro. Para una distribución normal bivariada, el tensor de cocurtosis tiene términos fuera de la diagonal que en general no son ni 0 ni 3, por lo que intentar "corregir" porque un exceso se vuelve confuso. Es cierto, sin embargo, que los cumulantes conjuntos de grado mayor que dos para cualquier distribución normal multivariante son cero.

Para dos variables aleatorias, X e Y, no necesariamente independientes, la curtosis de la suma, X + Y, es

- Kurt [X+Y]=1σ σ X+Y4()σ σ X4Kurt [X]+4σ σ X3σ σ YCokurt [X,X,X,Y]+6σ σ X2σ σ Y2Cokurt [X,X,Y,Y]+4σ σ Xσ σ Y3Cokurt [X,Y,Y,Y]+σ σ Y4Kurt [Y]).{displaystyle {begin{aligned}operatorname {Kurt} [X+Y]={1 over sigma ¿Por qué? ################################################################################################################################################################################################################################################################ [X]+4sigma ################################################################################################################################################################################################################################################################ ################################################################################################################################################################################################################################################################ {Cokurt} [X,X,X,Y]\\cH00}+6sigma - ¿Qué? ################################################################################################################################################################################################################################################################ [X,X,Y,Y][6pt] _{X}sigma ################################################################################################################################################################################################################################################################ {Cokurt} [X,Y,Y,Y]+sigma ################################################################################################################################################################################################################################################################ {Kurt} [Y]{big]}

Tenga en cuenta que los coeficientes binomiales de cuarta potencia (1, 4, 6, 4, 1) aparecen en la ecuación anterior.

Interpretación

La interpretación exacta de la medida de curtosis de Pearson (o exceso de curtosis) solía estar en disputa, pero ahora está resuelta. Como señala Westfall en 2014, "...su única interpretación inequívoca es en términos de la extremidad de la cola; es decir, valores atípicos existentes (para la curtosis de la muestra) o propensión a producir valores atípicos (para la curtosis de una distribución de probabilidad)." La lógica es simple: la curtosis es el promedio (o el valor esperado) de la datos estandarizados elevados a la cuarta potencia. Los valores estandarizados que son menores que 1 (es decir, datos dentro de una desviación estándar de la media, donde estaría el 'pico') no contribuyen prácticamente en nada a la curtosis, ya que elevar un número que es menor que 1 a la cuarta la potencia lo hace más cercano a cero. Los únicos valores de datos (observados u observables) que contribuyen a la curtosis de forma significativa son los que están fuera de la región del pico; es decir, los valores atípicos. Por lo tanto, la curtosis mide solo los valores atípicos; no mide nada sobre el "pico".

Se han dado muchas interpretaciones incorrectas de la curtosis que involucran nociones de pico. Una es que la curtosis mide tanto el "punto máximo" de la distribución y la pesadez de su cola. Se han sugerido varias otras interpretaciones incorrectas, como "falta de hombros" (donde el 'hombro' se define vagamente como el área entre el pico y la cola, o más específicamente como el área aproximadamente a una desviación estándar de la media) o 'bimodalidad'. Balanda y MacGillivray afirman que la definición estándar de curtosis "es una medida pobre de la curtosis, el pico o el peso de la cola de una distribución" y en su lugar proponen "definir la curtosis vagamente como el movimiento libre de ubicación y escala de la masa de probabilidad desde los hombros de una distribución hasta su centro y colas".

Moros' interpretación

En 1986 Moors dio una interpretación de la curtosis. Dejar

- Z=X− − μ μ σ σ ,{displaystyle Z={frac {X-mu}{sigma}}}

donde X es una variable aleatoria, μ es la media y σ es la desviación estándar.

Ahora por definición de la kurtosis κ κ {displaystyle kappa }, y por la identidad conocida E[V2]=Var [V]+[E[V]]2,{displaystyle Eleft [V^{2}right]=operatorname {var} [V]+[E[V]]^{2}

- κ κ =E[Z4]=Var [Z2]+[E[Z2]]2=Var [Z2]+[Var [Z]]2=Var [Z2]+1{displaystyle kappa =Eleft[Z^{4}right]=operatorname {var} left[Z^{2}right]+left[Eleft[Z^{2}right]right]^{2}=operatorname {var}left[Z^{2}right]+[operatorname {var} [Z]]^{2}=operatorname {var} left[Z^{2}right]+1}.

La curtosis ahora puede verse como una medida de la dispersión de Z2 alrededor de su expectativa. Alternativamente, puede verse como una medida de la dispersión de Z alrededor de +1 y −1. κ alcanza su valor mínimo en una distribución simétrica de dos puntos. En términos de la variable original X, la curtosis es una medida de la dispersión de X alrededor de los dos valores μ ± σ.

Altos valores de κ surgen en dos circunstancias:

- donde la masa de probabilidad se concentra alrededor de la media y el proceso de generación de datos produce valores ocasionales lejos de la media,

- donde la masa de probabilidad se concentra en las colas de la distribución.

Exceso de curtosis

El exceso de curtosis se define como curtosis menos 3. Hay 3 regímenes distintos, como se describe a continuación.

Mesocúrtico

Las distribuciones con cero exceso de kurtosis se llaman mesokurtic, o mesokurtotic. El ejemplo más prominente de una distribución mescúrtica es la familia de distribución normal, independientemente de los valores de sus parámetros. Algunas otras distribuciones bien conocidas pueden ser mesokurtic, dependiendo de los valores del parámetro: por ejemplo, la distribución binomial es mesokurtic para p=1/2± ± 1/12{displaystyle p=1/2pm {1/12}}.

Leptocúrtico

Una distribución con un exceso de curtosis positivo se denomina leptocúrtica o leptocúrtica. "Lepto-" significa "delgado". En términos de forma, una distribución leptocúrtica tiene colas más gruesas. Los ejemplos de distribuciones leptocúrticas incluyen la distribución t de Student, la distribución de Rayleigh, la distribución de Laplace, la distribución exponencial, la distribución de Poisson y la distribución logística. Estas distribuciones a veces se denominan supergaussianas.

Platykurtic

Una distribución con un exceso de curtosis negativo se denomina platikúrtica, o platicurtósica. "Platy-" significa "amplio". En términos de forma, una distribución platicúrtica tiene colas más delgadas. Los ejemplos de distribuciones platicúrticas incluyen las distribuciones uniformes continuas y discretas, y la distribución de coseno elevado. La distribución más platicúrtica de todas es la distribución de Bernoulli con p = 1/2 (por ejemplo, el número de veces que uno obtiene "cara" al lanzar una moneda una vez, un lanzamiento de moneda), para el cual el exceso de curtosis es −2.

Ejemplos gráficos

La familia Pearson tipo VII

Los efectos de la curtosis se ilustran utilizando una familia paramétrica de distribuciones cuya curtosis se puede ajustar mientras sus momentos de orden inferior y cumulantes permanecen constantes. Considere la familia Pearson tipo VII, que es un caso especial de la familia Pearson tipo IV restringida a densidades simétricas. La función de densidad de probabilidad viene dada por

- f()x;a,m)=.. ()m)aπ π .. ()m− − 1/2)[1+()xa)2]− − m,{displaystyle f(x;a,m)={frac {Gamma (m)}{a,{sqrt {pi)} },Gamma (m-1/2)}left[1+left({frac {x}{a}right)}right)}right]^{-m}}}

donde a es un parámetro de escala y m es un parámetro de forma.

Todas las densidades de esta familia son simétricas. El kel momento que existe m (k+ 1)/2. Para que exista la kurtosis, necesitamos mEntonces el medio y la astucia existen y ambos son idénticos cero. Ajuste a2= 2m3 - hace que la varianza sea igual a la unidad. Entonces el único parámetro libre es m, que controla el cuarto momento (y acumulativo) y por lo tanto la kurtosis. Uno puede reparameterse con m=5/2+3/γ γ 2{displaystyle m=5/2+3/gamma _{2}}, donde γ γ 2{displaystyle gamma _{2} es el exceso de kurtosis tal como se define anteriormente. Esto produce una familia leptokurtica de un solo parámetro con cero media, varianza unitaria, cero esquisto y kurtosis no negativa arbitraria. La densidad reparamétrica es

- g()x;γ γ 2)=f()x;a=2+6γ γ 2,m=52+3γ γ 2).{displaystyle g(x;gamma _{2})=fleft(x;;a={sqrt {2+{frac {6}{gamma ♪♪♪ {5}{2}}+{frac {3}{gamma _{2}}derecha).!}

En el límite como γ γ 2→ → JUEGO JUEGO {displaystyle gamma _{2}to infty } uno obtiene la densidad

- g()x)=3()2+x2)− − 52,{displaystyle g(x)=3left(2+x^{2}right)^{-{frac {5} {2}}}}, !

que se muestra como la curva roja en las imágenes de la derecha.

En la otra dirección como γ γ 2→ → 0{displaystyle gamma _{2}to 0} uno obtiene la densidad normal estándar como la distribución limitante, mostrada como la curva negra.

En las imágenes de la derecha, la curva azul representa la densidad x↦ ↦ g()x;2){displaystyle xmapsto g(x;2)} con exceso de kurtosis de 2. La imagen superior muestra que las densidades leptokurtic en esta familia tienen un pico más alto que la densidad normal mesokurtic, aunque esta conclusión sólo es válida para esta familia selecta de distribuciones. Las colas comparativamente más grasas de las densidades leptokurtic se ilustran en la segunda imagen, que traza el logaritmo natural de las densidades tipo Pearson VII: la curva negra es el logaritmo de la densidad normal estándar, que es una parabola. Se puede ver que la densidad normal asigna poca masa de probabilidad a las regiones lejos de la media ("tiene colas delgadas"), en comparación con la curva azul de la densidad pearson tipo VII de la leptokurtic con exceso de kurtosis de 2. Entre la curva azul y el negro hay otras densidades de tipo Pearson VII con γ2= 1, 1/2, 1/4, 1/8 y 1/16. La curva roja muestra nuevamente el límite superior de la familia Pearson tipo VII, con γ γ 2=JUEGO JUEGO {displaystyle gamma _{2}=infty } (que, estrictamente hablando, significa que el cuarto momento no existe). La curva roja disminuye la más lenta a medida que se mueve hacia fuera del origen ("tiene colas de grasa").

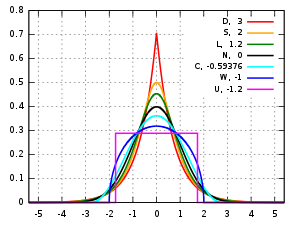

Otras distribuciones conocidas

Aquí se comparan varias distribuciones unimodales y simétricas bien conocidas de diferentes familias paramétricas. Cada uno tiene una media y un sesgo de cero. Los parámetros han sido elegidos para dar como resultado una varianza igual a 1 en cada caso. Las imágenes de la derecha muestran curvas para las siguientes siete densidades, en escala lineal y escala logarítmica:

- D: Distribución del lugar, también conocida como la doble distribución exponencial, curva roja (dos líneas rectas en la trama log-scale), exceso de kurtosis = 3

- S: distribución de secano hiperbólico, curva naranja, exceso de kurtosis = 2

- L: distribución logística, curva verde, exceso de kurtosis = 1.2

- N: distribución normal, curva negra (parabola invertida en la trama log-scale), exceso de kurtosis = 0

- C: distribución cosina elevada, curva cian, exceso de kurtosis = −0.593762...

- W: Distribución de semicírculo de alambre, curva azul, exceso de kurtosis = −1

- U: distribución uniforme, curva magenta (muestra para claridad como rectángulo en ambas imágenes), exceso de kurtosis = −1.2.

Nótese que en estos casos las densidades platicúrticas tienen soporte acotado, mientras que las densidades con exceso de curtosis positivo o cero están soportadas en toda la línea real.

No se puede inferir que las distribuciones de curtosis alta o baja tengan las características indicadas en estos ejemplos. Existen densidades platicúrticas con soporte infinito,

- por ejemplo, distribuciones de potencia exponenciales con parámetro de forma suficientemente grande b

y existen densidades leptocúrticas con soporte finito.

- por ejemplo, una distribución uniforme entre −3 y −0.3, entre −0.3 y 0.3, y entre 0,3 y 3, con la misma densidad en los intervalos (−3, −0.3) y (0.3, 3), pero con 20 veces más densidad en el intervalo (−0.3, 0.3)

Además, existen densidades platicúrticas con picos infinitos,

- por ejemplo, una mezcla igual de la distribución beta con parámetros 0.5 y 1 con su reflexión sobre 0.0

y existen densidades leptocúrticas que parecen tener la parte superior plana,

- por ejemplo, una mezcla de distribución uniforme entre -1 y 1 con T(4.0000001) Distribución t del estudiante, con probabilidades de mezcla 0.999 y 0.001.

Muestra de curtosis

Definiciones

Un estimador natural pero sesgado

Para una muestra de n valores, un método de estimación de momentos del exceso de curtosis poblacional se puede definir como

- g2=m4m22− − 3=1n.. i=1n()xi− − x̄ ̄ )4[1n.. i=1n()xi− − x̄ ̄ )2]2− − 3{displaystyle G_{2}={frac {m_{4} {m_{2}}}-3={frac {tfrac {1}{n}}}sum} {c} {c}}} {c}}} {c}}}}}} {c}}}}} {c}}}} {c}}}}}}}}}} {c}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {c}}}} {c}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {c}}}} {c}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} { {fn} {fn} {fn}} {fn}} {fn}} {fn} {fn}} {fn}}}} {fn} {fn} ¿Por qué?

Donde m4 es el cuarto momento de la muestra sobre el medio, m2 es el segundo momento de la muestra sobre la media (es decir, la varianza de la muestra), xi es iT valor, y x̄ ̄ {displaystyle {overline {x}}} es la muestra media.

Esta fórmula tiene la representación más simple,

- g2=1n.. i=1nzi4− − 3{displaystyle G_{2}={frac {1}{n}sum ¿Qué?

Donde zi{displaystyle z_{i} valores son los valores de datos estandarizados utilizando la desviación estándar definida n en lugar de n− 1 en el denominador.

Por ejemplo, suponga que los valores de los datos son 0, 3, 4, 1, 2, 3, 0, 2, 1, 3, 2, 0, 2, 2, 3, 2, 5, 2, 3, 999.

Entonces el zi{displaystyle z_{i} −0.239, −0.225, −0.221, −0.234, −0.230, −0.225, −0.239, −0.230, −0.234, −0.225, −0.230, −0.239, −0.230,

y el zi4{displaystyle z_{i} {4} los valores son 0,003, 0,003, 0,002, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 0,003, 360.976.

La media de estos valores es 18,05 y el exceso de curtosis es, por tanto, 18,05 − 3 = 15,05. Este ejemplo deja en claro que los datos cerca del "medio" o "pico" de la distribución no contribuyen a la estadística de curtosis, por lo tanto, la curtosis no mide el "punto máximo". Es simplemente una medida del valor atípico, 999 en este ejemplo.

Estimador imparcial estándar

Dado un subconjunto de muestras de una población, el exceso de la muestra kurtosis g2{displaystyle G_{2} arriba es un estimador parcial del exceso de población kurtosis. Un estimador alternativo del exceso de población kurtosis, que es imparcial en muestras aleatorias de una distribución normal, se define como sigue:

- G2=k4k22=n2[()n+1)m4− − 3()n− − 1)m22]()n− − 1)()n− − 2)()n− − 3)()n− − 1)2n2m22=n− − 1()n− − 2)()n− − 3)[()n+1)m4m22− − 3()n− − 1)]=n− − 1()n− − 2)()n− − 3)[()n+1)g2+6]=()n+1)n()n− − 1)()n− − 2)()n− − 3).. i=1n()xi− − x̄ ̄ )4().. i=1n()xi− − x̄ ̄ )2)2− − 3()n− − 1)2()n− − 2)()n− − 3)=()n+1)n()n− − 1)()n− − 2)()n− − 3).. i=1n()xi− − x̄ ̄ )4k22− − 3()n− − 1)2()n− − 2)()n− − 3){displaystyle {begin{aligned}G_{2} {fn1} {fn1} {fn1} {fn1} {fn1}} {ccn}cccn} {ccH0}ccH00} {ccH00}cccH00}ccH00}cH00}ccH00cH00} {cH00}cccccccH00}ccccccccccccH00}ccccccH00}ccccccccccH00}cccccH00}cccccccccH00}cH00}ccH00}ccccccH00}ccc {m_{4} {m_{2}}}-3,(n-1)derecha][6pt] limit={frac {n-1}{(n-2),(n-3)}left[n+1),g_{2}+6right][6pt]={={n+1)nnc] ¿Por qué? {fn1}}}}3, {fn1} {fn1} {fn2}}\fn1} {fn1}{2} {n-2},(n-3)}\[6pt]} {fn1} {fn1} {fn1} {fn1} {ccfn1}fn1}fn1}c}fn1}c}cccc}ccccccccccccccH00ccccccccccccccccccccccccH00ccccH00cH00cH00}ccH00ccH00cH00cH00c}ccc ¿Qué? {x}}} {4} {k_{2}}}}}-3,{frac {(n-1)}{(n-2) {} {}}end{aligned}}

Donde k4 es el estimador simétrico único sin prejuicios del cuarto acumulativo, k2 es la estimación imparcial del segundo acumulativo (idental a la estimación imparcial de la variación de la muestra), m4 es el cuarto momento de la muestra sobre el medio, m2 es el segundo momento de la muestra sobre el medio, xi es iT valor, y x̄ ̄ {displaystyle {bar {x}} es la muestra media. Coeficiente de momento estandarizado Fisher-Pearson G2{displaystyle G_{2} es la versión encontrada en Excel y varios paquetes estadísticos incluyendo Minitab, SAS y SPSS.

Desafortunadamente, en muestras no normales G2{displaystyle G_{2} es generalmente parcial.

Límite superior

Un límite superior para la muestra de curtosis de n (n > 2) números reales es

- g2≤ ≤ 12n− − 3n− − 2g12+n2− − 3.{displaystyle g_{2}leq {frac}{2}{frac} {frac}} {f}} {f}}} {f}}}} {f}}} {f}}}} {f}}} {f} {n-3}{n-2}g_{1}{2}+{frac} {n}{2}-3.}

Donde g1=m3/m23/2{displaystyle G_{1}=m_{3}/m_{2}{3/2} es la muestra correspondiente skewness.

Varianza bajo normalidad

La varianza de la curtosis muestral de una muestra de tamaño n de la distribución normal es

- Var ()g2)=24n()n− − 1)2()n− − 3)()n− − 2)()n+3)()n+5){displaystyle operatorname {var} (g_{2})={frac {24n(n-1)^{2}{(n-3)(n-2)(n+3)(n+5)}}}

Diferentemente, bajo la suposición de que la variable aleatoria subyacente X{displaystyle X} se distribuye normalmente, se puede demostrar que ng2→dN()0,24){fnMicrosoft Sans Serif} {d}{mathcal {N}(0,24)}.

Aplicaciones

La curtosis de muestra es una medida útil de si existe un problema con los valores atípicos en un conjunto de datos. Una curtosis más grande indica un problema de valores atípicos más grave y puede llevar al investigador a elegir métodos estadísticos alternativos.

La prueba de K-cuadrado de Agostino es una prueba de normalidad de bondad de ajuste basada en una combinación de la asimetría y la curtosis de la muestra, al igual que la prueba de normalidad de Jarque-Bera.

Para muestras no normales, la varianza de la varianza de la muestra depende de la curtosis; para más detalles, consulte la variación.

La definición de curtosis de Pearson se utiliza como indicador de la intermitencia en la turbulencia. También se utiliza en imágenes de resonancia magnética para cuantificar la difusión no gaussiana.

Un ejemplo concreto es el siguiente lema por He, Zhang y Zhang: Asuma una variable aleatoria X{displaystyle X} tiene expectativa E[X]=μ μ {displaystyle E[X]=mu }, varianza E[()X− − μ μ )2]=σ σ 2{displaystyle Eleft[(X-mu)}derecha]=sigma ^{2} y kurtosis κ κ =1σ σ 4E[()X− − μ μ )4]{displaystyle kappa ={tfrac {1}{4}}Eleft[(X-mu)}right]. Asumo que muestra n=23+33κ κ log 1δ δ {displaystyle n={tfrac {2{sqrt {3}+3}{3}kappa log {tfrac} {1}{delta } muchas copias independientes. Entonces...

- Pr[maxi=1nXi≤ ≤ μ μ ]≤ ≤ δ δ yPr[mini=1nXi≥ ≥ μ μ ]≤ ≤ δ δ {displaystyle Pr left[max _{i=1}{n}X_{i}leq mu right]leq delta quad {text{and}quad Pr left[min ¿Por qué?.

Esto lo demuestra con .. ()κ κ log 1δ δ ){displaystyle Theta (kappa log {tfrac {1}{delta }}}}} muchas muestras, veremos una que está por encima de la expectativa con probabilidad al menos 1− − δ δ {displaystyle 1-delta }. En otras palabras: Si la kurtosis es grande, podríamos ver muchos valores por debajo o por encima de la media.

Convergencia de curtosis

Al aplicar filtros de paso de banda a imágenes digitales, los valores de curtosis tienden a ser uniformes, independientemente del rango del filtro. Este comportamiento, denominado convergencia de curtosis, se puede utilizar para detectar el empalme de imágenes en el análisis forense.

Otras medidas

Una medida diferente de "curtosis" se proporciona mediante el uso de momentos L en lugar de los momentos ordinarios.

Contenido relacionado

Tendencia central

Autocorrelación

Cuadrado latino

![{displaystyle operatorname {Kurt} [X]=operatorname {E} left[left({frac {X-mu }{sigma }}right)^{4}right]={frac {operatorname {E} left[(X-mu)^{4}right]}{left(operatorname {E} left[(X-mu)^{2}right]right)^{2}}}={frac {mu _{4}}{sigma ^{4}}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/abb6badbf13364972b05d9249962f5ff87aba236)

![{displaystyle operatorname {Kurt} [Y]-3={frac {1}{left(sum _{j=1}^{n}sigma _{j}^{,2}right)^{2}}}sum _{i=1}^{n}sigma _{i}^{,4}cdot left(operatorname {Kurt} left[X_{i}right]-3right),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8f295e334581a6f264d3ca40bf75df3293fb0f3e)

![{displaystyle operatorname {Kurt} [Y]-3={1 over n^{2}}sum _{i=1}^{n}left(operatorname {Kurt} left[X_{i}right]-3right).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6c397ae36f0e23dd0fff0c1137e5dcddc2e9217b)

![{displaystyle {begin{aligned}operatorname {Kurt} [X+Y]={1 over sigma _{X+Y}^{4}}{big (}&sigma _{X}^{4}operatorname {Kurt} [X]+4sigma _{X}^{3}sigma _{Y}operatorname {Cokurt} [X,X,X,Y]\&{}+6sigma _{X}^{2}sigma _{Y}^{2}operatorname {Cokurt} [X,X,Y,Y]\[6pt]&{}+4sigma _{X}sigma _{Y}^{3}operatorname {Cokurt} [X,Y,Y,Y]+sigma _{Y}^{4}operatorname {Kurt} [Y]{big)}.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ca0a7f4889310fb96ed071c23a6d6af959ef500d)

![{displaystyle Eleft[V^{2}right]=operatorname {var} [V]+[E[V]]^{2},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6782f578cb9d22c509a08ab7d43a21735eba1cde)

![{displaystyle kappa =Eleft[Z^{4}right]=operatorname {var} left[Z^{2}right]+left[Eleft[Z^{2}right]right]^{2}=operatorname {var} left[Z^{2}right]+[operatorname {var} [Z]]^{2}=operatorname {var} left[Z^{2}right]+1}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8ed2d37d4494e13b10f81b83797c0d689ff740d2)

![f(x; a, m) = frac{Gamma(m)}{a,sqrt{pi},Gamma(m-1/2)} left[1+left(frac{x}{a}right)^2 right]^{-m}, !](https://wikimedia.org/api/rest_v1/media/math/render/svg/688a4a90b74edb0216f35dd7fd915132f37599f8)

![{displaystyle g_{2}={frac {m_{4}}{m_{2}^{2}}}-3={frac {{tfrac {1}{n}}sum _{i=1}^{n}(x_{i}-{overline {x}})^{4}}{left[{tfrac {1}{n}}sum _{i=1}^{n}(x_{i}-{overline {x}})^{2}right]^{2}}}-3}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e30ed8db4466ff3e448b71e729464506ddce7770)

![{displaystyle {begin{aligned}G_{2}&={frac {k_{4}}{k_{2}^{2}}}\[6pt]&={frac {n^{2},[(n+1),m_{4}-3,(n-1),m_{2}^{2}]}{(n-1),(n-2),(n-3)}};{frac {(n-1)^{2}}{n^{2},m_{2}^{2}}}\[6pt]&={frac {n-1}{(n-2),(n-3)}}left[(n+1),{frac {m_{4}}{m_{2}^{2}}}-3,(n-1)right]\[6pt]&={frac {n-1}{(n-2),(n-3)}}left[(n+1),g_{2}+6right]\[6pt]&={frac {(n+1),n,(n-1)}{(n-2),(n-3)}};{frac {sum _{i=1}^{n}(x_{i}-{bar {x}})^{4}}{left(sum _{i=1}^{n}(x_{i}-{bar {x}})^{2}right)^{2}}}-3,{frac {(n-1)^{2}}{(n-2),(n-3)}}\[6pt]&={frac {(n+1),n}{(n-1),(n-2),(n-3)}};{frac {sum _{i=1}^{n}(x_{i}-{bar {x}})^{4}}{k_{2}^{2}}}-3,{frac {(n-1)^{2}}{(n-2)(n-3)}}end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/51b0b3b5d766ffd8f2c3be0fbe899873b41bb961)

![{displaystyle E[X]=mu }](https://wikimedia.org/api/rest_v1/media/math/render/svg/51ed977b56d8e513d9eb92193de5454ac545231e)

![{displaystyle Eleft[(X-mu)^{2}right]=sigma ^{2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cedd17629b1a84a72ee82ac046028e7628811148)

![{displaystyle kappa ={tfrac {1}{sigma ^{4}}}Eleft[(X-mu)^{4}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f9596b45af565b781abac4f4bad3ae95dc48f57f)

![{displaystyle Pr left[max _{i=1}^{n}X_{i}leq mu right]leq delta quad {text{and}}quad Pr left[min _{i=1}^{n}X_{i}geq mu right]leq delta }](https://wikimedia.org/api/rest_v1/media/math/render/svg/7dd308935ef5c101697f8d1f64b76d7e42591ad6)