Coeficiente de correlación de Pearson

En estadística, el coeficiente de correlación de Pearson (PCC, pronunciado), también conocido como Pearson's r, el coeficiente de correlación producto-momento de Pearson (PPMCC), la correlación bivariada, o coloquialmente simplemente como coeficiente de correlación ― es una medida de correlación lineal entre dos conjuntos de datos. Es el cociente entre la covarianza de dos variables y el producto de sus desviaciones estándar; por lo tanto, es esencialmente una medida normalizada de la covarianza, de modo que el resultado siempre tiene un valor entre −1 y 1. Al igual que con la covarianza misma, la medida solo puede reflejar una correlación lineal de variables e ignora muchos otros tipos de relaciones o correlaciones. Como ejemplo simple, uno esperaría que la edad y la estatura de una muestra de adolescentes de una escuela secundaria tuvieran un coeficiente de correlación de Pearson significativamente mayor que 0, pero menor que 1 (ya que 1 representaría una correlación irrealmente perfecta).

Nombre e historia

Fue desarrollado por Karl Pearson a partir de una idea relacionada introducida por Francis Galton en la década de 1880, y cuya fórmula matemática fue derivada y publicada por Auguste Bravais en 1844. El nombre del coeficiente es, por lo tanto, un ejemplo de Stigler's Ley.

Definición

El coeficiente de correlación de Pearson es la covarianza de las dos variables dividida por el producto de sus desviaciones estándar. La forma de la definición involucra un 'momento del producto', es decir, la media (el primer momento sobre el origen) del producto de las variables aleatorias ajustadas a la media; de ahí el modificador product-moment en el nombre.

Para una población

El coeficiente de correlación de Pearson, cuando se aplica a una población, es comúnmente representado por la letra griega *** (rho) and may be referred to as the coeficiente de correlación de población o el Coeficiente de correlación Pearson. Dado un par de variables aleatorias ()X,Y){displaystyle (X,Y)}, la fórmula para *** es

dónde

- cov{displaystyle operatorname {cov} es la covariancia

- σ σ X{displaystyle sigma _{X} es la desviación estándar de X{displaystyle X}

- σ σ Y{displaystyle sigma _{Y} es la desviación estándar de Y{displaystyle Sí..

La fórmula para *** *** {displaystyle rho } se puede expresar en términos de media y expectativa. Desde

- cov ()X,Y)=E [()X− − μ μ X)()Y− − μ μ Y)],{displaystyle operatorname {cov} (X,Y)=operatorname {mathbb {E} [(X-mu _{X})(Y-mu _{Y})}

la fórmula para *** *** {displaystyle rho } también se puede escribir como

dónde

- σ σ Y{displaystyle sigma _{Y} y σ σ X{displaystyle sigma _{X} se definen como

- μ μ X{displaystyle mu _{X}} es la media de X{displaystyle X}

- μ μ Y{displaystyle mu _{Y}} es la media de Y{displaystyle Sí.

- E{displaystyle operatorname {Mathbb {E} es la expectativa.

La fórmula para *** *** {displaystyle rho } se puede expresar en términos de momentos no centrados. Desde

- μ μ X=E [X]μ μ Y=E [Y]σ σ X2=E [()X− − E [X])2]=E [X2]− − ()E [X])2σ σ Y2=E [()Y− − E [Y])2]=E [Y2]− − ()E [Y])2E [()X− − μ μ X)()Y− − μ μ Y)]=E [()X− − E [X])()Y− − E [Y])]=E [XY]− − E [X]E [Y],{displaystyle {begin{aligned}mu} ################################################################################################################################################################################################################################################################ {fnMithbb {fnMicrosoft Sans Serif} ################################################################################################################################################################################################################################################################ {fnMithbb {fnMicrosoft Sans Serif} ################################################################################################################################################################################################################################################################ {cHFF} left[,left(X-operatorname {mathbb {E} [X]right)^{2},right]=operatorname {mathbb {E} left[,X^{2},right]-left(operatorname {mathbb {E} } [,X,]right)}sigma - ¿Qué? {cHFF} left[,left(Y-operatorname {mathbb {E} [Y]right)^{2},right]= 'operatorname {mathbb {E} left[,Y^{2},right]-left(,operatorname {mathbb {E} [,Y,]right)}right)}{2}\cH00cH00cH00cH00cH00s]s]cH00cH00cH00cH00cH00cH00}cH00cH00cH00cH00cH00cH00cH00cH00cH00cH00cH00}cH00}cH00cH00cH00cH00cH00cH00cH00cH00cH00cH00cH00cH00cH00cH00cH00}cH00cH {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {fnMicrosoft ] {E} [,Y,]derecha],]=operatorname {mathbb {E} [,X,Y,]-operatorname {mathbb {E} [,X,]operatorname {mathbb {mathbb {E} } [,Y,,fnMicrosoft} {f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}f}fnKf}fnfnf}fnf}fnfnfnKfnfnfnfnfnfnMinfnfnMinMinfnf}f}fn

la fórmula para *** *** {displaystyle rho } también se puede escribir como

El coeficiente de correlación de Pearson no existe cuando o σ σ X{displaystyle sigma _{X} o σ σ Y{displaystyle sigma _{Y} son cero, infinito o indefinido.

Para una muestra

El coeficiente de correlación de Pearson, cuando se aplica a una muestra, es comúnmente representado por rxSí.{displaystyle r_{xy} y puede ser referido como el coeficiente de correlación de muestra o el muestra Coeficiente de correlación Pearson. Podemos obtener una fórmula para rxSí.{displaystyle r_{xy} sustituyendo estimaciones de las covarianzas y diferencias basadas en una muestra a la fórmula anterior. Datos pares dados {}()x1,Sí.1),...... ,()xn,Sí.n)}{displaystyle left{(x_{1},y_{1}),ldots(x_{n},y_{n})right} consistente en n{displaystyle n} pares, rxSí.{displaystyle r_{xy} se define como

dónde

- n{displaystyle n} es tamaño de muestra

- xi,Sí.i{displaystyle ¿Qué? son los puntos de muestra individuales indexados con i

- x̄ ̄ =1n.. i=1nxi{fnMicrosoft {fnfnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoft {fnMicrosoftfnMicrosoft {fnMicrosoft {fnMicrosoft}\fnMicrosoft}\fnMis {fnMicrosoft}fnMicrosoft {fnMicrosoft}fnMis {fnMicrosoft}fnfnMis {fnMicrosoft}fnfnMis {fnMis {f}fnMis {fnMis {fnMicrosoftfnfnMicrosoftfnMis {fnMis {fnMis}fnMicrosoftfnMicrosoft}fnfnMi {x}={frac {1}{n}sum ¿Qué? (la muestra significa); y analógicamente Sí.̄ ̄ {displaystyle {bar {y}}}.

Rearranging nos da esta fórmula para rxSí.{displaystyle r_{xy}:

- rxSí.=n.. xiSí.i− − .. xi.. Sí.in.. xi2− − ().. xi)2n.. Sí.i2− − ().. Sí.i)2.{displaystyle ################################################################################################################################################################################################################################################################ x_{i}y_{i}-sum x_{i}sum Y_{i} {sqrt {nsum x_{i} {2}-left(sum x_{i}{2}}}~{sqrt {nsum y_{i} {2}-left(sum y_{i}right)}}}}}}}}}}}}

Donde n,xi,Sí.i{displaystyle No. se definen como anteriores.

Esta fórmula sugiere un algoritmo conveniente de un solo paso para calcular las correlaciones de la muestra, aunque dependiendo de los números involucrados, a veces puede ser numéricamente inestable.

Reorganizar de nuevo nos da esta fórmula para rxSí.{displaystyle r_{xy}:

- rxSí.=.. ixiSí.i− − nx̄ ̄ Sí.̄ ̄ .. ixi2− − nx̄ ̄ 2.. iSí.i2− − nSí.̄ ̄ 2.{displaystyle ################################################################################################################################################################################################################################################################ ¿Qué? {fnK} {fn} {fnK}} {fnK}} {fnK}} {f} {f}}} {fn}}} {fn}} {fn}}} {fn}}} {f}}}} {f}}}}} {f}}}}} {f}}}}}} {f}}}}}}}}}}}}}}} {f}}}}}}}}} {f} {f}}}}} {f}}} {f}}}}}} {f}}}}}}}}}}}}}}}}} {f}} {f} {f}}}}}} {f}}} {f}}}} {f} {f} {f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} { ¿Qué? {fnK} {fnK}} {fnK}} {fnK}} {fnK}}} {fn}}} {fn}}} {fnK}}}}}} {fn}}}} {f}}}} {f}}}}}}} {f}}}}}} {f}}}}} {f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} { sq}}}} { sq sq sqf}} { sq}} { sq}}} { sq sq sq sq sq sq sqsq sq sqsqsqsqsqsqsqsqrt {f}} {sqsqsqsqrt {sqsq - Sí. - Sí.

Donde n,xi,Sí.i,x̄ ̄ ,Sí.̄ ̄ {displaystyle n,x_{i},y_{i},{bar {x},{bar {y}} se definen como anteriores.

Una expresión equivalente da la fórmula para rxSí.{displaystyle r_{xy} como la media de los productos de las puntuaciones estándar como sigue:

- rxSí.=1n− − 1.. i=1n()xi− − x̄ ̄ sx)()Sí.i− − Sí.̄ ̄ sSí.){displaystyle r_{xy}={frac {1}{n-1}sum ¿Por qué? {x_{i}-{bar Está bien. {y_{i}-{bar {y} {y} {y}} {y}}} {y}}} {y}} {y}} {y}}} {}} {y}}}} {y}}}}}} {y}} {}}} {}}} {}} {}} {}} {}} {}}} {}}}}} {y}}}} {}}}}}}}}} {}}}}}} {}}}}}} {}}}}} {}}}}}} {}}} {} {}}}}}}} {} {}}}} {} {}}} {}}}}}}}} {}}}}}}}}}}}}}}}} {} {}}} {}}}}}}} {}}}}}} {}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {}}}}}}

dónde

- n,xi,Sí.i,x̄ ̄ ,Sí.̄ ̄ {displaystyle n,x_{i},y_{i},{bar {x},{bar {y}} se definen como anteriores, y sx,sSí.{displaystyle S_{x},s_{y} se definen a continuación

- ()xi− − x̄ ̄ sx){textstyle left({frac {x_{i}-{bar {x}} {s_{x}}} {}}}} {fnK}}} {fnK}}}} {f}}}}}}}}}}}}} {f}}}}}} {f}} {f}}}}} {f}}}}}}}} {f}}}}} {}}}}}}}}} {}}}}}}}}}}}}}}} {}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {}}}}}}}}}}}} {}}}}}}}}}}}}}}}}}}}}}}}}}}} es la puntuación estándar (y analógicamente para la puntuación estándar Sí.{displaystyle y}).

Fórmulas alternativas para rxSí.{displaystyle r_{xy} también están disponibles. Por ejemplo, se puede utilizar la siguiente fórmula para rxSí.{displaystyle r_{xy}:

- rxSí.=.. xiSí.i− − nx̄ ̄ Sí.̄ ̄ ()n− − 1)sxsSí.{displaystyle ################################################################################################################################################################################################################################################################ x_{i}y_{i}-n{bar {x} {fn} {fn1}} {fn}}} {fn}}}} {fn}} {c}}}} {cH}}}}} {cH}}}}}} {cH}}}}}} {cH}}}} {cH}}}}}} {c}}}}}}}}}}}}}}}}}} {\\\\cH}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {\\\\\\\\\\cH}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {

dónde

- n,xi,Sí.i,x̄ ̄ ,Sí.̄ ̄ {displaystyle n,x_{i},y_{i},{bar {x},{bar {y}} se definen como anteriores y:

- sx=1n− − 1.. i=1n()xi− − x̄ ̄ )2{fnMicroc} {fnMicroc} {1}{n-1}sum ¿Qué? (la desviación estándar de la muestra); y analógicamente para sSí.{displaystyle s_{y}.

Cuestiones prácticas

En condiciones de mucho ruido, extraer el coeficiente de correlación entre dos conjuntos de variables estocásticas no es trivial, en particular cuando el análisis de correlación canónica informa valores de correlación degradados debido a las fuertes contribuciones de ruido. Una generalización del enfoque se da en otra parte.

En caso de que falten datos, Garren derivó el estimador de máxima verosimilitud.

Algunas distribuciones (por ejemplo, distribuciones estables que no sean una distribución normal) no tienen una varianza definida.

Propiedades matemáticas

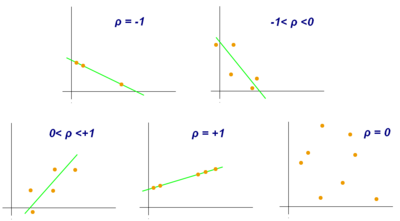

Los valores de los coeficientes de correlación de Pearson tanto de la muestra como de la población están entre -1 y 1. Las correlaciones iguales a +1 o -1 corresponden a puntos de datos que se encuentran exactamente en una línea (en el caso de la correlación de la muestra), oa una distribución bivariada completamente apoyada en una línea (en el caso de la correlación poblacional). El coeficiente de correlación de Pearson es simétrico: corr(X,Y) = corr(Y,X).

Una propiedad matemática clave del coeficiente de correlación de Pearson es que es invariable ante cambios separados en la ubicación y la escala de las dos variables. Es decir, podemos transformar X en a + bX y transformar Y a c + dY, donde a, b, c y d son constantes con b, d > 0, sin cambiar el coeficiente de correlación. (Esto es válido tanto para la población como para los coeficientes de correlación de Pearson de la muestra). Las transformaciones lineales más generales cambian la correlación: consulte § Decorrelación de n variables aleatorias para ver una aplicación de esto.

Interpretación

El coeficiente de correlación varía de −1 a 1. Un valor absoluto de exactamente 1 implica que una ecuación lineal describe perfectamente la relación entre X e Y, con todos los datos puntos que se encuentran en una línea. El signo de correlación está determinado por la pendiente de regresión: un valor de +1 implica que todos los puntos de datos se encuentran en una línea en la que Y aumenta a medida que aumenta X, y viceversa para −1. Un valor de 0 implica que no existe una dependencia lineal entre las variables.

Más generalmente, (Xi − X)(Yi − Y) es positivo si y solo si Xi y Yi se encuentran del mismo lado de sus respectivos medios. Por tanto, el coeficiente de correlación es positivo si Xi y Yi tienden a ser simultáneamente mayores o menores que sus respectivas medias. El coeficiente de correlación es negativo (anticorrelación) si Xi y Yi tienden a estar en lados opuestos de sus respectivos medios. Además, cuanto más fuerte es cualquiera de las tendencias, mayor es el valor absoluto del coeficiente de correlación.

Rodgers y Nicewander catalogaron trece formas de interpretar la correlación o funciones simples de la misma:

- Función de puntajes brutos y medios

- Covariancia estandarizada

- Pendiente estandarizada de la línea de regresión

- Medio geométrico de las dos pendientes de regresión

- Base cuadrada de la relación de dos diferencias

- Producción cruzada media de variables estandarizadas

- Función del ángulo entre dos líneas de regresión estandarizadas

- Función del ángulo entre dos vectores variables

- Variación a escala de la diferencia entre las calificaciones estandarizadas

- Estimación de la regla del globo

- Relacionados con los elipses bivariados de la isoconcentración

- Función de las estadísticas de prueba de experimentos diseñados

- Relación de dos medios

Interpretación geométrica

Para datos no centrados, existe una relación entre el coeficiente de correlación y el ángulo φ entre las dos líneas de regresión, y = gX(x) y x = gY(y), obtenido al retroceder y en x y x en y respectivamente. (Aquí, φ se mide en sentido antihorario dentro del primer cuadrante formado alrededor del punto de intersección de las líneas si r > 0, o en sentido antihorario desde el cuarto al segundo cuadrante si r < 0.) Se puede demostrar que si las desviaciones estándar son iguales, entonces r = sec φ − tan φ, donde sec y tan son funciones trigonométricas.

Para datos centrados (es decir, datos que han sido desplazados por las medias muestrales de sus respectivas variables para tener un promedio de cero para cada variable), el coeficiente de correlación también puede verse como el coseno del ángulo θ entre los dos vectores observados en un espacio N-dimensional (para N observaciones de cada variable)

Se pueden determinar los coeficientes de correlación no centrados (no compatibles con Pearson) y centrados para un conjunto de datos. Como ejemplo, supongamos que se encuentra que cinco países tienen productos nacionales brutos de 1, 2, 3, 5 y 8 mil millones de dólares, respectivamente. Suponga que se encuentra que estos mismos cinco países (en el mismo orden) tienen 11%, 12%, 13%, 15% y 18% de pobreza. Luego, permita que x y y sean vectores de 5 elementos ordenados que contengan los datos anteriores: x = (1, 2, 3, 5, 8) y y = (0,11, 0,12, 0,13, 0,15, 0,18).

Por el procedimiento usual para encontrar el ángulo θ entre dos vectores (ver producto escalar), el coeficiente de correlación no centrado es

- # Silencio Silencio =x⋅ ⋅ Sí..x..Sí..=2.931030,0983=0.920814711.{displaystyle cos theta ={frac {mathbf {x} cdot mathbf {y} {leftPrincemathbf {x}rightspedaleftsuficientemathbf {y}derecho a la vida}={frac {2.93}{sqrt {103}{sqrt {0.0983}}}}}}=0.920814711}}

Este coeficiente de correlación no centrado es idéntico a la similitud del coseno. Los datos anteriores se eligieron deliberadamente para que estuvieran perfectamente correlacionados: y = 0,10 + 0,01 x. Por lo tanto, el coeficiente de correlación de Pearson debe ser exactamente uno. Centrar los datos (cambiando x por ℰ(x) = 3.8 y y por ℰ(y) = 0,138) produce x = (−2,8, −1,8, −0.8, 1.2, 4.2) y y = (−0.028, −0.018, −0.008, 0.012, 0.042), de donde

- # Silencio Silencio =x⋅ ⋅ Sí..x..Sí..=0,30830,80,00308=1=*** *** xSí.,{displaystyle cos theta ={frac {mathbf {x} cdot mathbf {y} {leftmathbf {x}rightfnseleftfnhmhmhbf {y} {fn}={frac {0.308}{sqrt {30.8}{sqrt {0.00308}}}}}}=1=rho ¿Qué?

como se esperaba.

Interpretación del tamaño de una correlación

Varios autores han ofrecido pautas para la interpretación de un coeficiente de correlación. Sin embargo, todos estos criterios son en cierto modo arbitrarios. La interpretación de un coeficiente de correlación depende del contexto y los propósitos. Una correlación de 0,8 puede ser muy baja si se está verificando una ley física utilizando instrumentos de alta calidad, pero puede considerarse muy alta en las ciencias sociales, donde puede haber una mayor contribución de los factores de complicación.

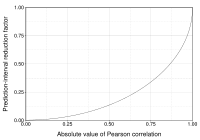

Inferencia

La inferencia estadística basada en el coeficiente de correlación de Pearson a menudo se centra en uno de los dos objetivos siguientes:

- Un objetivo es probar la hipótesis nula de que el verdadero coeficiente de correlación *** es igual a 0, basado en el valor del coeficiente de correlación de muestra r.

- El otro objetivo es obtener un intervalo de confianza que, en el muestreo repetido, tiene una probabilidad dada de contener ***.

Discutimos métodos para lograr uno o ambos de estos objetivos a continuación.

Usando una prueba de permutación

Las pruebas de permutación proporcionan un enfoque directo para realizar pruebas de hipótesis y construir intervalos de confianza. Una prueba de permutación para el coeficiente de correlación de Pearson implica los siguientes dos pasos:

- Utilizando los datos emparejados originales (xi,Sí.i), redefine al azar los pares para crear un nuevo conjunto de datos (xi,Sí.i), donde el i son una permutación del set {1,...n}. La permutación i se selecciona aleatoriamente, con igual probabilidad puestos en todos n! permutaciones posibles. Esto equivale a dibujar i al azar sin reemplazo del set {1,... n}. En el arranque, un enfoque estrechamente relacionado, i y el i son iguales y dibujados con reemplazo de {1,... n};

- Construir un coeficiente de correlación r de los datos aleatorizados.

Para realizar la prueba de permutación, repite los pasos (1) y (2) muchas veces. El valor p para la prueba de permutación es la proporción de los valores r generados en el paso (2) que son mayores que el coeficiente de correlación de Pearson que se calculó a partir de los datos originales. Aquí "más grande" puede significar que el valor es mayor en magnitud o mayor en valor con signo, dependiendo de si se desea una prueba unilateral o bilateral.

Usando un arranque

El bootstrap se puede utilizar para construir intervalos de confianza para el coeficiente de correlación de Pearson. En el "no paramétrico" arranque, n pares (xi, y i) se vuelven a muestrear "con reemplazo" del conjunto observado de n pares, y el coeficiente de correlación r se calcula en función de los datos remuestreados. Este proceso se repite una gran cantidad de veces y la distribución empírica de los valores de r remuestreados se utiliza para aproximar la distribución de muestreo de la estadística. Un intervalo de confianza del 95 % para ρ se puede definir como el intervalo que abarca desde el percentil 2,5 al 97,5 de los valores de r remuestreados.

Error estándar

Si x{displaystyle x} y Sí.{displaystyle y} son variables aleatorias, un error estándar asociado a la correlación en el caso null es

- σ σ r=1− − r2n− − 2{displaystyle sigma ¿Qué? {1-r^{2} {n-2}}}

Donde r{displaystyle r} es la correlación (supuesta ry n{displaystyle n} el tamaño de la muestra.

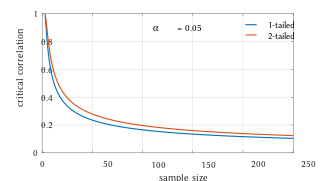

Pruebas usando la distribución t de Student

Para los pares de una distribución normal bivariada no correlacionada, la distribución de muestreo del coeficiente de correlación de Pearson estudentizado sigue la distribución t de Student con grados de libertad n − 2. Específicamente, si las variables subyacentes tienen una distribución normal bivariada, la variable

- t=rσ σ r=rn− − 21− − r2{displaystyle t={frac {r}{sigma ¿Qué? {n-2}{1-r^{2}}}}

tiene una distribución t de estudiante en el caso nulo (correlación cero). Esto se mantiene aproximadamente en el caso de valores observados no normales si los tamaños de muestra son lo suficientemente grandes. Para determinar los valores críticos de r se necesita la función inversa:

- r=tn− − 2+t2.{displaystyle r={frac {T}{sqrt {n-2+t^{2}}}}}

Como alternativa, se pueden utilizar enfoques asintóticos de muestras grandes.

Otro artículo anterior proporciona gráficos y tablas para los valores generales de ρ, para tamaños de muestra pequeños, y analiza los enfoques computacionales.

En caso de que las variables subyacentes no sean normales, la distribución muestral del coeficiente de correlación de Pearson sigue una distribución t de Student, pero los grados de libertad se reducen.

Usando la distribución exacta

Para los datos que siguen una distribución normal bivariada, la función de densidad exacta f(r) para el coeficiente de correlación muestral r de una normal bivariado es

- f()r)=()n− − 2).. ()n− − 1)()1− − *** *** 2)n− − 12()1− − r2)n− − 422π π .. ()n− − 12)()1− − *** *** r)n− − 322F1()12,12;12()2n− − 1);12()*** *** r+1)){displaystyle f(r)={frac {(n-2),mathrm {Gamma } (n-1)left(1-rho ^{2}right)}{frac {n-1}left(1-r^{2}right)^{frac}frac}{frac {n-4}{2} {sqrt {2pi},fnMiembro de operador {fnMicrosoft Sans Serif} {fnMicroc}} {fnMicrosoft Sans Serif}} {fn-- {fn-00}}} {fn-}} {fnMicroc}}} {fn-fn-cH00FF} {cH00FF}} {cH00}}}}}}} {m}}}} {m} {fn-fn-fn-fn-fn-fn-cH00}n-cHFFFFFFFFFFFFFFFFFFFFFFFF}}}}}}}} {fn-fn-fn-n-fnun-fn-n-n-n-n-fn-fn-fn-n-fnun-fnun-fnun-fnun-cHFF}fnun-n-n- {3}{2}}} {2}}mathrm} {F} _{1}{mhord {tfrac {1}{2},{tfrac {1}{2}}};{tfrac {1}{2} {2n-1);{tfrac {1}{2} {2}}} {rho r+1)}}}}}}}}}}}}}}} {f}}}} {}}}}}}}} {}}}} {}}}}}} {}}}}}}}}}}}} {}}}}}}} {}}}}} {}}}}}}}}}}}}}}}}}}}}}} {}}}}}}}} {} {}}}}}}}}}}}}}}}}}}}}}} {m}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {

Donde .. {displaystyle "Gamma" es la función gamma y 2F1()a,b;c;z){displaystyle {}_{2}mathrm {F} _{1}(a,b;c;z)} es la función hipergeométrica gaussiana.

En el caso especial cuando *** *** =0{displaystyle rho =0} (correlación de población cero), función de densidad exacta f()r) puede ser escrito como

- f()r)=()1− − r2)n− − 42B()12,12()n− − 2)),{displaystyle f(r)={frac {left(1-r^{2}right)^{frac {n-4}{2}}{mathrm {B}left({tfrac {1}{2}}} {tfrac {1}{2}}} {n-2)}}}}}} {n2}}}} {n2}}}} {n2}}}}} {n2}}}}}} {n2}}}}}}}}}}}}}}}} {n}}}} {n2)}}}}}} {n2)}}}}}}}}}} {n2)}} {n2)}}}}}}}}}}}}}}}} {n}}}}} {n2)} {n2)}}} {n2)}}}}}}}}}}}}}}}}} {n2)}}}}}}}}}}}}}} {n2)}}}}}}}}}} {n2)}}}}}}}} {n }

Donde B{displaystyle mathrm {B} es la función beta, que es una forma de escribir la densidad de la t-distribución de un estudiante, como arriba.

Uso de la distribución de confianza exacta

Los intervalos de confianza y las pruebas se pueden calcular a partir de una distribución de confianza. Una densidad de confianza exacta para ρ es

Donde F{displaystyle operatorname {F} es la función hipergeométrica de Gauss 1}" xmlns="http://www.w3.org/1998/Math/MathML">.. =n− − 1■1{displaystyle nu =n-1]1}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/90621e9d8a7d137425c6871c269cc3dc8acddfe6" style="vertical-align: -0.505ex; width:13.989ex; height:2.343ex;"/>.

Uso de la transformación de Fisher

En la práctica, intervalos de confianza y pruebas de hipótesis relacionadas con *** se realizan generalmente utilizando la transformación Fisher, F{displaystyle F}:

- F()r)↑ ↑ 12In ()1+r1− − r)=Artanh ()r){displaystyle F(r)equiv {tfrac {1}{2},ln left({frac {1+r}{1-r}right)=operatorname {artanh} (r)}

F(r) sigue aproximadamente una distribución normal con

- #=F()*** *** )=Artanh ()*** *** ){displaystyle {text{mean}=F(rho)=operatorname {artanh} (rho)}y error estándar =SE=1n− − 3,{displaystyle ={text{SE}={frac} {1}{sqrt {n-3}}}}

Donde n es el tamaño de la muestra. El error de aproximación es más bajo para un tamaño de muestra grande n{displaystyle n} pequeño r{displaystyle r} y *** *** 0{displaystyle rho _{0} y aumenta lo contrario.

Usando la aproximación, una puntuación z es

- z=x− − #SE=[F()r)− − F()*** *** 0)]n− − 3{displaystyle z={frac {x-{text{mean}} {text{SE}}=[F(r)-F(rho _{0})}{sqrt {n-3}}}}} {f}} {f}}}} {f}

bajo la hipótesis nula *** *** =*** *** 0{displaystyle rho =rho _{0}, dada la suposición de que los pares de muestra son independientes e idénticamente distribuidos y siguen una distribución normal bivariada. Así se puede obtener un valor p aproximado de una tabla de probabilidad normal. Por ejemplo, si z= 2.2 se observa y se desea un p-valor de dos lados para probar la hipótesis nula que *** *** =0{displaystyle rho =0}, el valor p es 2 Negotiat(−2.2) = 0,028, donde Ё es la función de distribución acumulativa normal.

Para obtener un intervalo de confianza para ρ, primero computamos un intervalo de confianza para F()*** *** {displaystyle rho }):

- 100()1− − α α )% % CI:Artanh ()*** *** )▪ ▪ [Artanh ()r)± ± zα α /2SE]{displaystyle 100(1-alpha)%{text{CI}:operatorname {artanh}(rho)in [operatorname {artanh} (r)pm z_{alpha /2}{text{SE}}}}}} {f}}}}}}

La transformación inversa de Fisher devuelve el intervalo a la escala de correlación.

- 100()1− − α α )% % CI:*** *** ▪ ▪ [Tanh ()Artanh ()r)− − zα α /2SE),Tanh ()Artanh ()r)+zα α /2SE)]{displaystyle 100(1-alpha)%{CI}:rho in [tanh(operatorname {artanh} (r)-z_{alpha /2} {text{SE}),tanh(operatorname {artanh} (r)+z_{alpha /2}{text{SE}}]

Por ejemplo, supongamos que observamos r = 0,7 con un tamaño de muestra de n=50, y deseamos obtener un intervalo de confianza del 95 % para ρ . El valor transformado es arctanh(r) = 0,8673, por lo que el intervalo de confianza en la escala transformada es 0,8673 ± 1,96/√47, o (0.5814, 1.1532). Convirtiendo de nuevo a los rendimientos de la escala de correlación (0.5237, 0.8188).

En análisis de regresión de mínimos cuadrados

El cuadrado del coeficiente de correlación muestral es generalmente denotado r2 y es un caso especial del coeficiente de determinación. En este caso, estima la fracción de la diferencia en Y que se explica X en una simple regresión lineal. Así que si tenemos el conjunto de datos observado Y1,...... ,Yn{displaystyle Y_{1},dots Y... y el conjunto de datos Y^ ^ 1,...... ,Y^ ^ n{fnMicrosoft Sans Serif} {Y}_{n} entonces como punto de partida la variación total en Yi alrededor de su valor promedio se puede descomponer de la siguiente manera

- .. i()Yi− − Ȳ ̄ )2=.. i()Yi− − Y^ ^ i)2+.. i()Y^ ^ i− − Ȳ ̄ )2,{displaystyle sum _{i}(Y_{i}-{bar {Y}}{2}=sum ¿Qué? {Y}_{i}}{2}+sum _{i} {Y}_{i}-{i} {Y}} {2},}

Donde Y^ ^ i{fnMicrosoft Sans Serif} {fnK}}} {fnMicrosoft} {fn}}} {fn}}}}}}} {fnMicrosoft}}}} {fnK}}}}}}}}} {f}}}}}}}}}}}}}}}}} {f}}}}} son los valores ajustados del análisis de regresión. Esto se puede reorganizar para dar

- 1=.. i()Yi− − Y^ ^ i)2.. i()Yi− − Ȳ ̄ )2+.. i()Y^ ^ i− − Ȳ ̄ )2.. i()Yi− − Ȳ ̄ )2.{displaystyle 1={frac {sum ¿Qué? {Y}_{i} {fn} {fnK}} {fnK}} {f}}} {f}}} {f}}}} {f}} {f}}}} {f}}}} {fn}}}} {f}}}}}}}}}} {f}}}}}}}}}}}}}}}}}}}}}}}}}} {}}}}} {}}}}}}}}} {}}}}}}}}}}}} {}}}}}} {}}}}}}} {}}}}}}}}}}}}}}}}}}}}}}}}}}}} {}}}}}}} {}}}}}}} {}}}}}}}}}}} {}}}}}}}}}}}}}}}}}}}}}}}}}} {}}}}}}}}}}} { ¿Qué? {fnK}} {fnK} {fnK} {fnh} {fnh} {fnfn} {fnfn} {fn}fnfn}fnfnfnf}fnfnf}fnfnKfnK}}}}\\\\fnK\\fnKfnfnKfnKfnKfnKfnKfnKcH00}fnKfnK\fnKfnKfnKfnKfnKfnKfnKfnKfnK}}}}}cH00}\\fnK\fnKfnKfnK}}\fnKcH00}}}}\\\\fnK\cH0 {Y}} {fn} {fnK}} {fnK}}} {f}}} {f}} {f}}}} {fn}}}} {f}}}}}}} {f}}}}}}} {f}}}}}} {f}}}}}}}}}} {}}}}}} {}}}}}}} {}}}}}}}} {}}}}}}}}} {}}}}}}}}}}}}}}}}} {}}}}}}}}}}}}}}}}}}}}}} {}}}}}}}}}}}} {} {}}} {} {}}}}}}}}}}}}} {}}}}}}}}}}}}}}}}}}}}}}} {}}}}}}}}}}}}}}}}}}}}}}}}}}} { ¿Qué?

Los dos sumandos anteriores son la fracción de varianza en Y que se explica por X (derecha) y que no se explica por X (izquierda).

A continuación, aplicamos una propiedad de menos modelos de regresión cuadrada, que la covariancia muestra entre Y^ ^ i{fnMicrosoft Sans Serif} {fnK}}} {fnMicrosoft} {fn}}} {fn}}}}}}} {fnMicrosoft}}}} {fnK}}}}}}}}} {f}}}}}}}}}}}}}}}}} {f}}}}} y Yi− − Y^ ^ i{displaystyle Y... {Y}_{i} es cero. Así, se puede escribir el coeficiente de correlación entre los valores de respuesta observados y ajustados en la regresión (la cálculo está bajo expectativa, asume estadísticas gausianas)

- r()Y,Y^ ^ )=.. i()Yi− − Ȳ ̄ )()Y^ ^ i− − Ȳ ̄ ).. i()Yi− − Ȳ ̄ )2⋅ ⋅ .. i()Y^ ^ i− − Ȳ ̄ )2=.. i()Yi− − Y^ ^ i+Y^ ^ i− − Ȳ ̄ )()Y^ ^ i− − Ȳ ̄ ).. i()Yi− − Ȳ ̄ )2⋅ ⋅ .. i()Y^ ^ i− − Ȳ ̄ )2=.. i[()Yi− − Y^ ^ i)()Y^ ^ i− − Ȳ ̄ )+()Y^ ^ i− − Ȳ ̄ )2].. i()Yi− − Ȳ ̄ )2⋅ ⋅ .. i()Y^ ^ i− − Ȳ ̄ )2=.. i()Y^ ^ i− − Ȳ ̄ )2.. i()Yi− − Ȳ ̄ )2⋅ ⋅ .. i()Y^ ^ i− − Ȳ ̄ )2=.. i()Y^ ^ i− − Ȳ ̄ )2.. i()Yi− − Ȳ ̄ )2.{displaystyle {begin{aligned}r(Y,{hat {Y}}} {frac {sum _{i}(Y_{i}-{bar {Y}})({hathat {Y}_{i}-{i} {Y}} {sqrt {sum} {i} {fn}} {fn}} {fn} {fn} {fn} {fn}} {fn}} {fn}}} {fn}} {f}} {fnf}} {fnfnfnfnKf}}}}}}}}}} {f}}}}} {sqf}}}}} {f}}} {sqf}}} {sqf}} {fnsqfnfnf}}fnf}f}sqf} { sqsqsqsqsqsqsq sqsqsqsqsqfnfnsqfnsqsqfnsqsqsqsqfn {Y})} {2}cdot sum _{i}({hat {Y}_{i}-{bar} {fnMicrosoft Sans Ser _{i}(Y_{i} {Y} {fn} {fnK}} {fnK}}} {fnK}}}} {fn}}}} {fn}}}} {f}}}} {fn}}}}}}}}} {\\fnf}}}}}}}}}\\fnf}}}}}}}}}}}}\\\\\f}}}}}}}}}}}}}}}}\\\\\\\\\\\\f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}\\\\\\\f}}}}}}}}}}}}}}}}}}}}}}}}\\\\\\\\\\ {Y}_{i}-{} {hat} {Y}_{i}-{i} {Y}} {sqrt {sum} {i} {fn}} {fn}} {fn} {fn} {fn} {fn}} {fn}} {fn}}} {fn}} {f}} {fnf}} {fnfnfnfnKf}}}}}}}}}} {f}}}}} {sqf}}}}} {f}}} {sqf}}} {sqf}} {fnsqfnfnf}}fnf}f}sqf} { sqsqsqsqsqsqsq sqsqsqsqsqfnfnsqfnsqsqfnsqsqsqsqfn {Y})} {2}cdot sum _{i}({hat {Y}_{i}-{bar} {fnMicrosoft Sans Ser _{i} {fnK} {fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif} {Y}_{i})({hat {Y}_{i}-{b})+({hat {Y}_{i}-{i} {Y})} {sqrt {sum} {i} {i} {i} {i} {fn}} {fn} {fn}}} {fn}}}} {fn}}}} {fn}} {f}}}} {f}}}}} {f}}}}} {f}}}}} {f}}}}}} {f}}}}}}}} {f}}}}}} {f}} {f}}}}} {f}}}}} {f}}}} {f}}}}}}}}} {f}}}} {f} {f} {f}}}}}} {f}}}}}} {f}} {f}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {f}}}}}}} {Y})} {2}cdot sum _{i}({hat {Y}_{i}-{bar} {fnK} {fnK}}}[6pt]} {fnMicroc {fnh} {fnh} {fnh} {fnfnh00}fnK} {fnfnK} {fnfnK}}}}}}\cH00}}}}}}\\\\\[6pt]}}}}}}}}}}}\\\\\\\\\cH00}}}}}}\\\\\\\\\\\\\\\\\\cH00}}\\\\\\\\\\\\\\cH00}cH00}\cH00}}\cH00}\cH00}}}}}}}} {Y}} {fn} {fnK}} {fnK}} {f}}} {fn} {fn}}} {fn}}}} {fn}}} {fn}}} {fn}}} {f}}} {f}}}}}} {f}}}}}}} {f}} {f}}}}}}}}}}}}}}}}}}}}}}}} {f}}}}} {f}}}}} {f}}}}} {f}}}} {f}}}}}}}}} {f}}}}} { sq} { sq} {f}}}} { sq}}}} { sq}} {f}}} {f}}}}} {f}}}}}}}}}}}}}}}}}}}}}}}}}}}} { ¿Qué? {Y})} {2}cdot sum _{i}({hat {Y}_{i}-{bar} {fnK} {fnK}}}[6pt]} {sqrt {frac {sum _{i} {hat {}_{i}-{i}-{b} {Y}} {fn} {fnK}} {fnK}}} {f}}}} {f}}} {f}}}}} {f}}}}} {f}}}}}}} {fn}}}}} {f}}}}}}}} {f}}}}}}}}}}} {}}} {}}}}}} {}}}}}}}} {}}}}}}}}}} {}}}}}}}}}}}}}}}}}}}}} {}}}}}}}}}}}}}}}} {}}}}}}}}}}} {} {}}}}}} {}}}}} {}}}}}}} {}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}}} {}} { ¿Qué? {Y}} {fn}} {fnMicrosoft}}}

Así

- r()Y,Y^ ^ )2=.. i()Y^ ^ i− − Ȳ ̄ )2.. i()Yi− − Ȳ ̄ )2{displaystyle r(Y,{hat {Y}}{2}={ frac {sum _{i}({hat {Y}_{i}-{i} {Y}} {fn} {fnK}} {fnK}}} {f}}} {f}} {f}}}} {fn}}}} {f}}}}}}} {f}}}}}}} {f}}}}}} {f}}}}}}}}}} {}}}}}} {}}}}}}} {}}}}}}}} {}}}}}}}}} {}}}}}}}}}}}}}}}}} {}}}}}}}}}}}}}}}}}}}}}} {}}}}}}}}}}}} {} {}}} {} {}}}}}}}}}}}}} {}}}}}}}}}}}}}}}}}}}}}}} {}}}}}}}}}}}}}}}}}}}}}}}}}}} { ¿Qué? {Y}}} {c}}}}

Donde r()Y,Y^ ^ )2{displaystyle r(Y,{hat {Y}} {2}} es la proporción de la diferencia en Y explicado por una función lineal X.

En la derivación anterior, el hecho de que

- .. i()Yi− − Y^ ^ i)()Y^ ^ i− − Ȳ ̄ )=0{displaystyle sum _{i}(Y_{i}-{hat {Y}_{i})({hat {Y}_{i}-{i} {Y}=0}

puede probarse observando que las derivadas parciales de la suma residual de cuadrados (RSS) sobre β0 y β1 son iguales a 0 en el modelo de mínimos cuadrados, donde

- RSS=.. i()Yi− − Y^ ^ i)2{displaystyle {text{RSS}=sum ¿Qué? {Y}_{i}} {2}}.

Al final, la ecuación se puede escribir como

- r()Y,Y^ ^ )2=SSregSSTot{displaystyle r(Y,{hat {Y}}} {frac {text{text{}}} {text{}}} {text{text{}}}}}} {text{}}}}}}}} {f}}}}} {f}}}}}} {f}}}}}}}}}}} {

dónde

- SSreg=.. i()Y^ ^ i− − Ȳ ̄ )2{displaystyle {text{SS}_{text{reg}=sum ¿Qué? {Y}_{i}-{i} {Y}} {2}}

- SSTot=.. i()Yi− − Ȳ ̄ )2{displaystyle {text{SS}_{text{tot}=sum - Sí..

El símbolo SSreg{displaystyle {text{SS}} {text{reg}} {f}}} {fnK}} {f}}} {f}}} {f}}}}}}} {fn}}}}} {f}}}} se llama la suma de regresión de cuadrados, también llamada la suma explicada de cuadrados, y SSTot{displaystyle {text{SS}_{text{tot}} {fnK}} {fnK}} {f}}}} {fn}}}}}}}}} {fnK}}}}} {fnK}}}}} {f}}}}}}}}}}}}}}}} es la suma total de cuadrados (proporcional a la diferencia de los datos).

Sensibilidad a la distribución de datos

Existencia

El coeficiente de correlación de Pearson de la población se define en términos de momentos y, por lo tanto, existe para cualquier distribución de probabilidad bivariada para la que se define la covarianza de la población y las varianzas marginales de la población son distintas de cero. Algunas distribuciones de probabilidad, como la distribución de Cauchy, tienen una varianza indefinida y, por lo tanto, ρ no está definido si X o Y siguen dicha distribución. En algunas aplicaciones prácticas, como aquellas que involucran datos que se sospecha que siguen una distribución de colas pesadas, esta es una consideración importante. Sin embargo, la existencia del coeficiente de correlación no suele ser motivo de preocupación; por ejemplo, si el rango de la distribución está acotado, ρ siempre está definido.

Tamaño de la muestra

- Si el tamaño de la muestra es moderado o grande y la población es normal, entonces, en el caso de la distribución bivariada normal, el coeficiente de correlación muestral es la estimación máxima de probabilidad del coeficiente de correlación de población, y es asintomáticamente imparcial y eficiente, lo que significa aproximadamente que es imposible construir una estimación más exacta que el coeficiente de correlación muestral.

- Si el tamaño de la muestra es grande y la población no es normal, entonces el coeficiente de correlación de la muestra sigue siendo aproximadamente imparcial, pero puede que no sea eficiente.

- Si el tamaño de la muestra es grande, entonces el coeficiente de correlación de muestra es un calculador constante del coeficiente de correlación de población mientras la muestra significa, las diferencias y la covariancia son consistentes (que se garantiza cuando se puede aplicar la ley de grandes cantidades).

- Si el tamaño de la muestra es pequeño, entonces el coeficiente de correlación de la muestra r no es una estimación imparcial de ***. El coeficiente de correlación ajustado debe ser utilizado en su lugar: ver en otro lugar en este artículo para la definición.

- Las correlaciones pueden ser diferentes para datos dicotomosos desbalanzados cuando hay error de varianza en la muestra.

Robustez

Al igual que muchas estadísticas de uso común, la estadística de muestra r no es sólida, por lo que su valor puede ser engañoso si hay valores atípicos. Específicamente, el PMCC no es ni distributivamente robusto ni resistente a valores atípicos (ver Estadísticas robustas § Definición). La inspección del diagrama de dispersión entre X e Y normalmente revelará una situación en la que la falta de robustez podría ser un problema, y en tales casos puede ser recomendable utilizar una medida robusta de asociación. Tenga en cuenta, sin embargo, que si bien los estimadores de asociación más robustos miden la dependencia estadística de alguna manera, generalmente no se pueden interpretar en la misma escala que el coeficiente de correlación de Pearson.

La inferencia estadística del coeficiente de correlación de Pearson es sensible a la distribución de datos. Se pueden aplicar pruebas exactas y pruebas asintóticas basadas en la transformación de Fisher si los datos tienen una distribución aproximadamente normal, pero de lo contrario pueden ser engañosos. En algunas situaciones, se puede aplicar bootstrap para construir intervalos de confianza y se pueden aplicar pruebas de permutación para realizar pruebas de hipótesis. Estos enfoques no paramétricos pueden dar resultados más significativos en algunas situaciones donde la normalidad bivariada no se cumple. Sin embargo, las versiones estándar de estos enfoques se basan en la intercambiabilidad de los datos, lo que significa que no hay ordenación ni agrupación de los pares de datos que se analizan que puedan afectar el comportamiento de la correlación estimada.

Un análisis estratificado es una forma de adaptarse a la falta de normalidad bivariada o de aislar la correlación resultante de un factor mientras se controla por otro. Si W representa la pertenencia a un clúster u otro factor que es deseable controlar, podemos estratificar los datos según el valor de W y luego calcular un coeficiente de correlación dentro de cada estrato. Las estimaciones a nivel de estrato se pueden combinar para estimar la correlación general mientras se controla por W.

Variantes

Las variaciones del coeficiente de correlación se pueden calcular para diferentes propósitos. Aquí hay unos ejemplos.

Coeficiente de correlación ajustado

El coeficiente de correlación de la muestra r no es una estimación imparcial de ρ. Para los datos que siguen una distribución normal bivariada, la expectativa E[r] para el coeficiente de correlación de la muestra r de una bivariada normal es

- E [r]=*** *** − − *** *** ()1− − *** *** 2)2n+⋯ ⋯ ,{displaystyle operatorname {Mathbb {E} left[rright]=rho -{frac {rho left(1-rho ^{2}right)}{2n}cdotsquad } por lo tanto, r es un estimador parcial de *** *** .{displaystyle rho.}

El estimador imparcial de varianza mínima único radj viene dado por

- radj=r2F1()12,12;n− − 12;1− − r2),{displaystyle r_{text{adj}=r,mathbf {_{2}F_{1}}left({frac {1}{2}},{frac {1}{2}}} {frac {n-1}{2}}};1-r^{2}derecho),}

()1)

donde:

- r,n{displaystyle r,n} se definen como anteriores,

- 2F1()a,b;c;z){displaystyle mathbf {_{2}F_{1} (a,b;c;z)} es la función hipergeométrica gaussiana.

Se puede obtener un estimador aproximadamente imparcial radj truncando E[ r] y resolviendo esta ecuación truncada:

- r=E [r].. radj− − radj()1− − radj2)2n.{displaystyle r=operatorname [Mathbb {E} [r]approx r_{text{adj}-{frac} {\fnMicrosoft Sans Serif} {fnMicrosoft Sans Serif}}} {2n}}} {fn} {fn_fn}} {fnfnfnfnK}} {fnf}}}fnfnfnfnKfnKf}}}}}}}}} {fnfn9}}}}}}}}}}}}}}}}}}}}}}pppppppppppppppppppppppppppppppppppppppppppppppppppppppppppppp

()2)

Una solución aproximada a la ecuación (2) es

- radj.. r[1+1− − r22n],{displaystyle r_{text{adj}approx rleft[1+{1-r^{2}{2n}right],}

()3)

donde en (3)

- r,n{displaystyle r,n} se definen como anteriores,

- radj es un estimador suboptimal,

- radj también se puede obtener al máximo log(f()r)),

- radj tiene una diferencia mínima para los grandes valores n,

- radj tiene un sesgo de orden 1.()n −1).

Otro coeficiente de correlación ajustado propuesto es

- radj=1− − ()1− − r2)()n− − 1)()n− − 2).{displaystyle {fn1}}}}}}

radj ≈ r para valores grandes de n.

Coeficiente de correlación ponderado

Supongamos que las observaciones que se van a correlacionar tienen diferentes grados de importancia que se pueden expresar con un vector de pesos w. Para calcular la correlación entre los vectores x e y con el vector de peso w (todos de longitud n),

- Significado ponderado: m ()x;w)=.. iwixi.. iwi.{displaystyle operatorname {m} (x;w)={frac {sum ¿Qué? - Sí.

- Covariancia ponderada cov ()x,Sí.;w)=.. iwi⋅ ⋅ ()xi− − m ()x;w))()Sí.i− − m ()Sí.;w)).. iwi.{displaystyle operatorname {cov} (x,y;w)={frac {sum ¿Por qué? - Sí.

- Correlación ponderada corrido ()x,Sí.;w)=cov ()x,Sí.;w)cov ()x,x;w)cov ()Sí.,Sí.;w).{displaystyle operatorname {corr} (x,y;w)={frac {operatorname {cov} (x,y;w)}{sqrt {operatorname {cov} (x,x;w)operatorname {cov} (y,y,w)}}}}}}}

Coeficiente de correlación de reflexión

La correlación reflexiva es una variante de la correlación de Pearson en la que los datos no se centran en torno a sus valores medios. La correlación reflexiva de la población es

- corridor ()X,Y)=E [XY]E [X2]⋅ ⋅ E [Y2].{displaystyle operatorname {corr} _{r}(X,Y)={frac {fnMitbb {f} [,X,Y,]}{sqrt {operatorname {mathbb {f} [,X^{2},]cdot operatorname {mathbbbbbb.

La correlación reflexiva es simétrica, pero no es invariante bajo traducción:

- 0.}" xmlns="http://www.w3.org/1998/Math/MathML">corridor ()X,Y)=corridor ()Y,X)=corridor ()X,bY)ل ل corridor ()X,a+bY),aل ل 0,b■0.{displaystyle operatorname {corr} _{r}(X,Y)=operatorname {corr} _{r}(Y,X)=operatorname {corr} _{r}(X,bY)neq operatorname {corr} _{r}(X,a+bY),quad aneq 0,b}

0.}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/45be7f276b0b408d286c9d49ed7dff78e2a0aa69" style="vertical-align: -0.838ex; width:77.501ex; height:2.843ex;"/>

La correlación reflexiva de la muestra es equivalente a la similitud del coseno:

- rrxSí.=.. xiSí.i().. xi2)().. Sí.i2).{displaystyle rr_{xy}={fracsum {fnMicrosoft Sans Serif}}

La versión ponderada de la correlación reflexiva muestral es

- rrxSí.,w=.. wixiSí.i().. wixi2)().. wiSí.i2).{displaystyle rr_{xy,w}={frac {sum w_{i}x_{i}y_{i} {sqrt {(sum w_{i}x_{i}{2})(sum {fnMicrosoft Sans Serif}

Coeficiente de correlación escalado

La correlación escalada es una variante de la correlación de Pearson en la que el rango de los datos se restringe de manera intencional y controlada para revelar correlaciones entre componentes rápidos en series temporales. La correlación escalada se define como la correlación promedio entre segmentos cortos de datos.

Vamos K{displaystyle K} ser el número de segmentos que pueden encajar en la longitud total de la señal T{displaystyle T} para una escala determinada s{displaystyle s}:

- K=redonda ()Ts).{displaystyle K=operatorname {round} left({frac {T}right). }

La correlación escalada en todas las señales r̄ ̄ s{displaystyle {bar {}_{s}} {fnK}} {fnMicrosoft}} {fnMicrosoft}}} {fnMicrosoft}}} {fnMicrosoft}}}}}} {fnK}}}}}}} {f}}} es entonces calculado como

- r̄ ̄ s=1K.. k=1Krk,{fnMicrosoft Sans Serif} {fnMicroc} {1}{K}sum limits ¿Qué?

Donde rk{displaystyle R_{k} es el coeficiente de correlación de Pearson para el segmento k{displaystyle k}.

Eligiendo el parámetro s{displaystyle s}, el rango de valores se reduce y se filtran las correlaciones a largo plazo, sólo las correlaciones a corto plazo se revelan. Así, se eliminan las contribuciones de los componentes lentos y se mantienen las de los componentes rápidos.

Distancia de Pearson

Una métrica de distancia para dos variables X e Y conocida como distancia de Pearson se puede definir a partir de su coeficiente de correlación como

- dX,Y=1− − *** *** X,Y.{displaystyle D_{X,Y}=1-rho - Sí.

Teniendo en cuenta que el coeficiente de correlación de Pearson se encuentra entre [−1, +1], la distancia de Pearson se encuentra en [0, 2]. La distancia de Pearson se ha utilizado en análisis de conglomerados y detección de datos para comunicaciones y almacenamiento con ganancia y compensación desconocidas.

La "distancia" Pearson definió de esta manera asigna distancia mayor de 1 a correlaciones negativas. En realidad, tanto la correlación positiva fuerte como las correlaciones negativas son significativas, por lo que se debe cuidar cuando Pearson "distance" se utiliza para algoritmo vecino más cercano ya que tal algoritmo sólo incluirá a vecinos con correlación positiva y excluye a los vecinos con correlación negativa. Alternativamente, una distancia valorada absoluta, dX,Y=1− − Silencio*** *** X,YSilencio{displaystyle ################################################################################################################################################################################################################################################################ ################################################################################################################################################################################################################################################################, se puede aplicar, lo que tendrá en cuenta correlaciones positivas y negativas. La información sobre asociación positiva y negativa puede extraerse por separado, más tarde.

Coeficiente de correlación circular

Para variables X = {x1,...,x n} y Y = {y1,...,y n} que se definen en el círculo unitario [0, 2π), es posible definir un análogo circular de Coeficiente de Pearson. Esto se hace transformando los puntos de datos en X e Y con una función seno tal que el coeficiente de correlación se da como:

- rcircular circular=.. i=1npecado ()xi− − x̄ ̄ )pecado ()Sí.i− − Sí.̄ ̄ ).. i=1npecado ()xi− − x̄ ̄ )2.. i=1npecado ()Sí.i− − Sí.̄ ̄ )2{displaystyle ################################################################################################################################################################################################################################################################ {fnfn} {fnfnK}}sin(y_{i}- {fn}}{sqrt {sqrt {sum})} {fnK} {fnfnK} {fn}} {fn} {fn}} {fn}} {fn}}} {sqrt {sum} - ¿Qué?

Donde x̄ ̄ {displaystyle {bar {x}} y Sí.̄ ̄ {displaystyle {bar {y}}} son los medios circulares X yY. Esta medida puede ser útil en campos como la meteorología donde la dirección angular de los datos es importante.

Correlación parcial

Si una población o conjunto de datos se caracteriza por más de dos variables, un coeficiente de correlación parcial mide la fuerza de dependencia entre un par de variables que no se explica por la forma en que ambas cambian en respuesta a las variaciones en un subconjunto seleccionado de las otras variables.

Decorrelación de n variables aleatorias

Siempre es posible eliminar las correlaciones entre todos los pares de un número arbitrario de variables aleatorias mediante una transformación de datos, incluso si la relación entre las variables no es lineal. Cox & Hinkley.

Existe un resultado correspondiente para reducir las correlaciones de la muestra a cero. Suponga un vector de n se observan variables aleatorias m veces. Vamos X ser una matriz donde Xi,j{displaystyle X_{i,j} es jt variable de observación i. Vamos Zm,m{displaystyle Z_{m,m} ser un m por m matriz cuadrada con cada elemento 1. Entonces D es los datos transformados por lo que cada variable aleatoria tiene cero significa, y T es los datos transformados por lo que todas las variables tienen correlación cero media y cero con todas las otras variables – la matriz de correlación muestral T será la matriz de identidad. Esto debe dividirse aún más en la desviación estándar para conseguir la varianza unitaria. Las variables transformadas no estarán relacionadas, aunque no sean independientes.

- D=X− − 1mZm,mX{displaystyle D=X-{frac {1} {m}Z_{m}X}

- T=D()DTD)− − 12,{displaystyle T=D(D^{mathsf {T}D)^{-{frac {1}{2}}}}

donde un exponente de −+1⁄ 2 representa la raíz cuadrada de la matriz de la inversa de una matriz. La matriz de correlación de T será la matriz identidad. Si una nueva observación de datos x es un vector fila de n elementos, entonces se puede aplicar la misma transformación a x para obtener los vectores transformados d y t:

- d=x− − 1mZ1,mX,{displaystyle d=x-{frac Z_{1,m}X,}

- t=d()DTD)− − 12.{displaystyle t=d(D^{mathsf {T}D)}{-{frac {1} {2}}}}

Esta descorrelación está relacionada con el análisis de componentes principales para datos multivariados.

Implementaciones de software

- El paquete base de estadísticas de R implementa el coeficiente de correlación con

cor(x, y), o (con el valor P también) con cor.test(x, y). - La biblioteca SciPy Python vía pearsonr(x, y).

- La biblioteca Pandas Python implementa el cálculo de coeficiente de correlación Pearson como la opción predeterminada para el método pandas. DataFrame.corr

- Wolfram Mathematica a través de la función de Correlación, o (con el valor P) con CorrelaciónTest.

- La biblioteca Boost C+ a través de la función correlation_coefficient.

- Excel tiene una función correl (array1, array2) incorporada para calcular el coeficiente de correlación del pearson.

Contenido relacionado

Funciones hiperbólicas

Principio de Pareto

Coeficiente GINI

![{displaystyle operatorname {cov} (X,Y)=operatorname {mathbb {E} } [(X-mu _{X})(Y-mu _{Y})],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1e88bc4ba085b98d5cca09b958ad378d50127308)

![{displaystyle rho _{X,Y}={frac {operatorname {mathbb {E} } [(X-mu _{X})(Y-mu _{Y})]}{sigma _{X}sigma _{Y}}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/042c646e848d2dc6e15d7b5c7a5b891941b2eab6)

![{displaystyle {begin{aligned}mu _{X}={}&operatorname {mathbb {E} } [,X,]\mu _{Y}={}&operatorname {mathbb {E} } [,Y,]\sigma _{X}^{2}={}&operatorname {mathbb {E} } left[,left(X-operatorname {mathbb {E} } [X]right)^{2},right]=operatorname {mathbb {E} } left[,X^{2},right]-left(operatorname {mathbb {E} } [,X,]right)^{2}\sigma _{Y}^{2}={}&operatorname {mathbb {E} } left[,left(Y-operatorname {mathbb {E} } [Y]right)^{2},right]=operatorname {mathbb {E} } left[,Y^{2},right]-left(,operatorname {mathbb {E} } [,Y,]right)^{2}\&operatorname {mathbb {E} } [,left(X-mu _{X}right)left(Y-mu _{Y}right),]=operatorname {mathbb {E} } [,left(X-operatorname {mathbb {E} } [,X,]right)left(Y-operatorname {mathbb {E} } [,Y,]right),]=operatorname {mathbb {E} } [,X,Y,]-operatorname {mathbb {E} } [,X,]operatorname {mathbb {E} } [,Y,],,end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a2469cdb397ef7d50c200b03c9e9f7311f0ab2b1)

![{displaystyle rho _{X,Y}={frac {operatorname {mathbb {E} } [,X,Y,]-operatorname {mathbb {E} } [,X,]operatorname {mathbb {E} } [,Y,]}{{sqrt {operatorname {mathbb {E} } left[,X^{2},right]-left(operatorname {mathbb {E} } [,X,]right)^{2}}}~{sqrt {operatorname {mathbb {E} } left[,Y^{2},right]-left(operatorname {mathbb {E} } [,Y,]right)^{2}}}}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5984dfb290912b0e0b92a984bf49cdd628c38b2c)

![z={frac {x-{text{mean}}}{text{SE}}}=[F(r)-F(rho _{0})]{sqrt {n-3}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/da7a3d54a70f9005e3bf9a2accf62cbf0fa0ea71)

![{displaystyle 100(1-alpha)%{text{CI}}:operatorname {artanh} (rho)in [operatorname {artanh} (r)pm z_{alpha /2}{text{SE}}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/affc3f0ee39499c97bb851229113f49d83100bf2)

![{displaystyle 100(1-alpha)%{text{CI}}:rho in [tanh(operatorname {artanh} (r)-z_{alpha /2}{text{SE}}),tanh(operatorname {artanh} (r)+z_{alpha /2}{text{SE}})]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bf658969d39ea848505750b5cd76db21da78dd5c)

![{displaystyle {begin{aligned}r(Y,{hat {Y}})&={frac {sum _{i}(Y_{i}-{bar {Y}})({hat {Y}}_{i}-{bar {Y}})}{sqrt {sum _{i}(Y_{i}-{bar {Y}})^{2}cdot sum _{i}({hat {Y}}_{i}-{bar {Y}})^{2}}}}\[6pt]&={frac {sum _{i}(Y_{i}-{hat {Y}}_{i}+{hat {Y}}_{i}-{bar {Y}})({hat {Y}}_{i}-{bar {Y}})}{sqrt {sum _{i}(Y_{i}-{bar {Y}})^{2}cdot sum _{i}({hat {Y}}_{i}-{bar {Y}})^{2}}}}\[6pt]&={frac {sum _{i}[(Y_{i}-{hat {Y}}_{i})({hat {Y}}_{i}-{bar {Y}})+({hat {Y}}_{i}-{bar {Y}})^{2}]}{sqrt {sum _{i}(Y_{i}-{bar {Y}})^{2}cdot sum _{i}({hat {Y}}_{i}-{bar {Y}})^{2}}}}\[6pt]&={frac {sum _{i}({hat {Y}}_{i}-{bar {Y}})^{2}}{sqrt {sum _{i}(Y_{i}-{bar {Y}})^{2}cdot sum _{i}({hat {Y}}_{i}-{bar {Y}})^{2}}}}\[6pt]&={sqrt {frac {sum _{i}({hat {Y}}_{i}-{bar {Y}})^{2}}{sum _{i}(Y_{i}-{bar {Y}})^{2}}}}.end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d86595f3f77e8ee96952760d9176a5fa140cc562)

![{displaystyle operatorname {mathbb {E} } left[rright]=rho -{frac {rho left(1-rho ^{2}right)}{2n}}+cdotsquad }](https://wikimedia.org/api/rest_v1/media/math/render/svg/683b838e709e3b32a3c22dfec4fa665a593f42ad)

![{displaystyle r=operatorname {mathbb {E} } [r]approx r_{text{adj}}-{frac {r_{text{adj}}left(1-r_{text{adj}}^{2}right)}{2n}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e094c3fdfcb0bfd127f4be74e582f22a407201c4)

![{displaystyle r_{text{adj}}approx rleft[1+{frac {1-r^{2}}{2n}}right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cbf3f71f2cfe17f8f0d422d5ac0d482cc429a925)

![{displaystyle operatorname {corr} _{r}(X,Y)={frac {operatorname {mathbb {E} } [,X,Y,]}{sqrt {operatorname {mathbb {E} } [,X^{2},]cdot operatorname {mathbb {E} } [,Y^{2},]}}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e6d897e4b303a062ed14cc9f88f35f5c8ffc91f7)