Ceph (software)

Ceph (pronunciado) es una plataforma de almacenamiento definida por software, libre y de código abierto, que ofrece almacenamiento de objetos, almacenamiento en bloques y almacenamiento de archivos, basada en un clúster distribuido común. Ceph proporciona operaciones distribuidas sin un único punto de fallo y escalabilidad a nivel de exabyte. Desde la versión 12 (Luminous), Ceph no depende de ningún otro sistema de archivos convencional y gestiona directamente discos duros y SSD con su propio backend de almacenamiento, BlueStore, y puede exponer un sistema de archivos POSIX.

Ceph replica datos con tolerancia a fallos, utilizando hardware estándar y Ethernet IP, sin necesidad de soporte de hardware específico. Ceph ofrece alta disponibilidad y garantiza una gran durabilidad de los datos mediante técnicas como replicación, codificación de borrado, instantáneas y clones. Por diseño, el sistema es autoreparador y autogestionable, lo que minimiza el tiempo de administración y otros costos.Las implementaciones de Ceph para producción a gran escala incluyen CERN, OVH y DigitalOcean.Diseño

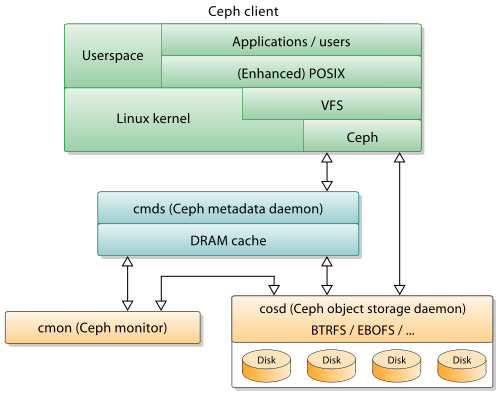

- Monitores de racimo (Ceph-mon) que mantienen un seguimiento de los nodos de racimo activos y fallidos, configuración de grupos e información sobre la colocación de datos y estado de agrupación global.

- OSD (Ceph-osd) que administra los dispositivos de almacenamiento de datos a granel directamente a través del extremo trasero de BlueStore, que desde la versión v12.x reemplaza el extremo trasero de Filestore, que se implementó en la parte superior de un sistema de archivos tradicional)

- Servidores de metadatos (cef-mds) que mantiene y correta el acceso a inodes y directorios dentro de un sistema de archivos CephFS

- Portones HTTP (HTTP)Ceph-rgw) que expone la capa de almacenamiento de objetos como una interfaz compatible con Amazon S3 o OpenStack Swift APIs

- Administradores (Ceph-mgr) que realizan tareas de monitoreo de grupos, contabilidad y mantenimiento, e interfaz a sistemas de monitoreo externo y gestión (por ejemplo, balanceador, dashboard, Prometheus, plugin Zabbix)

Almacenamiento de objetos S3

Almacenamiento de bloques

RBD se basa en el sistema de almacenamiento de objetos RADOS, base de Ceph, que proporciona la interfaz de Librados y el sistema de archivos CephFS. Dado que RBD se basa en Librados, hereda sus capacidades, incluyendo clones e instantáneas. Al distribuir volúmenes en franjas dentro del clúster, Ceph mejora el rendimiento de las imágenes de dispositivos de bloque grandes.

"Ceph-iSCSI" es una puerta de enlace que permite el acceso a almacenamiento en bloque distribuido de alta disponibilidad desde servidores o clientes Microsoft Windows y VMware vSphere compatibles con el protocolo iSCSI. Al usar ceph-iscsi en uno o más hosts de puerta de enlace iSCSI, las imágenes RBD de Ceph se convierten en unidades lógicas (LU) asociadas a destinos iSCSI, a los que se puede acceder con alta disponibilidad y balanceo de carga opcional.

Dado que la configuración de ceph-iscsi se almacena en el almacén de objetos Ceph RADOS, los hosts de la puerta de enlace de ceph-iscsi carecen de estado persistente y, por lo tanto, pueden reemplazarse, ampliarse o reducirse a voluntad. Como resultado, Ceph Storage permite a los clientes ejecutar una tecnología de almacenamiento empresarial verdaderamente distribuida, de alta disponibilidad, resiliente y autorreparable en hardware estándar y una plataforma completamente de código abierto.El dispositivo de bloque se puede virtualizar, proporcionando almacenamiento en bloque a máquinas virtuales, en plataformas de virtualización como OpenShift, OpenStack, Kubernetes, OpenNebula, Ganeti, Apache CloudStack y Proxmox Virtual Environment.

Almacenamiento de archivos

Dashboard

Crimson

Historia

Historia de la liberación

| Nombre | Liberación | Primera liberación | Fin de vida | Hitos |

|---|---|---|---|---|

| Argonaut | 0.48 | 3 de julio de 2012 | Primer lanzamiento "estable" | |

| Bobtail | 0,56 | Enero 1, 2013 | ||

| Cuttlefish | 0.61 | 7 de mayo de 2013 | Ceph-deploy es estable | |

| Dumpling | 0,677 | Agosto 14, 2013 | Mayo de 2015 | namespace, region, monitoring REST API |

| Emperador | 0.72 | 9 de noviembre de 2013 | Mayo de 2014 | réplica multi-datacenter para RGW |

| Fuego | 0.80 | 7 de mayo de 2014 | Abril 2016 | codificación de borrado, revestimiento de caché, afinidad primaria, backend de OSD clave/valor (experimental), RGW independiente (experimental) |

| Giant | 0.87 | 29 de octubre de 2014 | Abril de 2015 | |

| Hammer | 0.94 | Abril 7, 2015 | Agosto de 2017 | |

| Infernalis | 9.2.0 | 6 de noviembre de 2015 | Abril 2016 | |

| Jewel | 10.2.0 | Abril 21, 2016 | 2018-06-01 | Stable CephFS, experimental OSD back end llamado BlueStore, los daemons ya no funcionan como el usuario root |

| Kraken | 11.2.0 | 20 de enero de 2017 | 2017-08-01 | BlueStore es estable, EC para piscinas RBD |

| Luminoso | 12.2.0 | Agosto 29, 2017 | 2020-03-01 | pg-upmap balancer |

| Mimic | 13.2.0 | Junio 1, 2018 | 2020-07-22 | instantáneas son estables, La Bestia es estable, GUI oficial (Dashboard) |

| Nautilus | 14.2.0 | 19 de marzo de 2019 | 2021-06-01 | réplica asincrónica, auto-retry de escritos fallidos debido a la remapping de defectos |

| Octopus | 15.2.0 | 23 de marzo de 2020 | 2022-06-01 | |

| Pacífico | 16.2.0 | 31 de marzo, 2021 | 2023-06-01 | |

| Quincy | 17.2.0 | 19 de abril, 2022 | 2024-06-01 | auto-ajuste de min_alloc_size para medios novedosos |

| Reef | 18.2.0 | 3 de agosto de 2023 | 2025-08-01 | |

| Squid | 19.2.0 | 26 de septiembre de 2024 | 2026-09-19 | |

| Tentacle | TBA | TBA |

Plataformas disponibles

Etymology

Véase también

- BeeGFS

- Sistema de archivos distribuido

- Distribuidos sistemas de archivos paralelos tolerantes a la falla

- Sistema de archivos Gfarm

- GlusterFS

- GPFS

- Kubernetes

- LizardFS

- Lustre

- MapR FS

- Sistema de archivos Moose

- OrangeFS

- Parallel Virtual Sistema de archivos

- Sistema de archivos de Quantcast

- RozoFS

- Almacenamiento definido por software

- XtreemFS

- ZFS

- Comparación de sistemas de archivos distribuidos

Referencias

- ^ "Ceph Community Forms Advisory Board". 2015-10-28. Archivado desde el original en 2019-01-29. Retrieved 2016-01-20.

- ^ https://ceph.io/en/news/blog/2025/v19-2-1-squid-released/. Retrieved 19 de marzo 2025.

{{cite web}}: Desaparecido o vacío|title=(Ayuda) - ^ "Repositorio GitHub". GitHub.

- ^ a b "FreeBSD Informe trimestral de estado".

- ^ a b "Cef de instalación en Windows". Ceph. Retrieved 2 de julio 2023.

- ^ "LGPL2.1 archivo de licencia en las fuentes de Ceph". GitHub. 2014-10-24. Retrieved 2014-10-24.

- ^ Nicolas, Philippe (2016-07-15). "Los chicos de la historia: almacenamiento de objetos... desde el principio". El Registro.

- ^ Jeremy Andrews (2007-11-15). "Ceph Distributed Network File System". KernelTrap. Archivado desde el original en 2007-11-17. Retrieved 2007-11-15.

- ^ "Ceph Clusters". CERN. Archivado desde el original el 12 de noviembre de 2022. Retrieved 12 de noviembre 2022.

- ^ "Ceph Operations at CERN: Where Do We Go From Here? - Dan van der Ster & Teo Mouratidis, CERN". YouTube24 de mayo de 2019. Retrieved 12 de noviembre 2022.

- ^ Dorosz, Filip (15 de junio de 2020). "Viaje al almacenamiento de Ceph de próxima generación en OVHcloud con LXD". OVHcloud. Retrieved 12 de noviembre 2022.

- ^ "CephFS sistema de archivos distribuido". OVHcloud. Retrieved 12 de noviembre 2022.

- ^ "Ceph - Sistema de almacenamiento distribuido en OVH [en] - Bartłomiej Święcki". YouTube7 de abril de 2016. Retrieved 12 de noviembre 2022.

- ^ "200 Clusters vs 1 Admin - Bartosz Rabiega, OVH". YouTube24 de mayo de 2019. Retrieved 15 de noviembre 2022.

- ^ D'Atri, Anthony (31 de mayo de 2018). "Por qué elegimos a Ceph para construir almacenamiento de bloques". DigitalOcean. Retrieved 12 de noviembre 2022.

- ^ "Ceph Tech Talk: Ceph en DigitalOcean". YouTube7 de octubre de 2021. Retrieved 12 de noviembre 2022.

- ^ a b c M. Tim Jones (2010-06-04). "Ceph: A Linux petabyte-scale distributed file system" (PDF). IBM. Retrieved 2014-12-03.

- ^ "BlueStore". Ceph. Retrieved 2017-09-29.

- ^ "BlueStore Migration". Archivado desde el original en 2019-12-04. Retrieved 2020-04-12.

- ^ "Ceph Manager Daemon — Ceph Documentation". docs.ceph.com. Archivado desde el original el 6 de junio de 2018. Retrieved 2019-01-31. archivado junio 19, 2020, en la máquina Wayback

- ^ Jake Edge (2007-11-14). "El sistema de archivos Ceph". LWN.net.

- ^ Anthony D'Atri, Vaibhav Bhembre (2017-10-01). "Aprender a Ceph, segunda edición". Packt.

- ^ Sage Weil (2017-08-29). "v12.2.0 Luminous Released". Ceph Blog.

- ^ "Hard Disk and File System Recommendations". ceph.com. Archivado desde el original en 2017-07-14. Retrieved 2017-06-26.

- ^ "BlueStore Config Reference". Archivado desde el original el 20 de julio de 2019. Retrieved 12 de abril, 2020.

- ^ "10a Conferencia Internacional "Computing Distributed and Grid Technologies in Science and Education" (GRID'2023)". JINR (Indico). 2023-07-03. Retrieved 2023-08-09.

- ^ "Ceph Dashboard". Documentación de Ceph. Retrieved 11 de abril 2023.

- ^ Gómez, Pedro González (23 de febrero de 2023). "Introduciendo la nueva página de aterrizaje de Dashboard". Retrieved 11 de abril 2023.

- ^ "Operando al Ceph Dashboard: pasado, presente y futuro". YouTube22 de noviembre de 2022. Retrieved 11 de abril 2023.

- ^ Solo, Sam (18 de enero de 2021). "Crimson: evolución de Ceph para NVMe de alto rendimiento". Red Hat Tecnologías emergentes. Retrieved 12 de noviembre 2022.

- ^ Solo, Samuel (10 de noviembre de 2022). "¿Qué hay de nuevo con Crimson y Seastore?". YouTube. Retrieved 12 de noviembre 2022.

- ^ "Crimson: Next-generation Ceph OSD for Multi-core Scalability". Ceph blog7 de febrero de 2023. Retrieved 11 de abril 2023.

- ^ Sage Weil (2007-12-01). "Ceph: Almacenamiento distribuido fiable, escalable y de alto rendimiento" (PDF). Universidad de California, Santa Cruz. Archivado desde el original (PDF) on 2017-07-06. Retrieved 2017-03-11.

- ^ Gary Grider (2004-05-01). "La historia y la estrategia escalables de ASCI/DOD" (PDF). University of Minnesota. Retrieved 2019-07-17.

- ^ Gestión dinámica de metadatos para sistemas de archivos Petabyte-Scale, SA Weil, KT Pollack, SA Brandt, EL Miller, Proc. SC'04, Pittsburgh, PA, noviembre, 2004

- ^ "Ceph: Un sistema de archivos distribuidos de alto rendimiento", SA Weil, SA Brandt, EL Miller, DDE Long, C Maltzahn, Proc. OSDI, Seattle, WA, noviembre, 2006

- ^ "CRUSH: Colocación controlada, escalable, descentralizada de datos replicados", SA Weil, SA Brandt, EL Miller, DDE Long, C Maltzahn, SC'06, Tampa, FL, noviembre, 2006

- ^ Sage Weil (2010-02-19). "Client se fusionó por 2.6.34". Ceph.newdream.net. Archivado desde el original en 2010-03-23. Retrieved 2010-03-21.

- ^ Tim Stephens (2010-05-20). "Nueva versión de Linux OS incluye el sistema de archivos Ceph desarrollado en UCSC". news.ucsc.edu.

- ^ Bryan Bogensberger (2012-05-03). "Y todo viene juntos". Inktank Blog. Archivado desde el original el 2012-07-19. Retrieved 2012-07-10.

- ^ Joseph F. Kovar (10 de julio de 2012). "The 10 Coolest Storage Startups Of 2012 (So Far)". CRN. Retrieved 19 de julio, 2013.

- ^ Red Hat Inc (2014-04-30). "Red Hat to Acquire Inktank, Proveedor de Ceph". Red Hat. Retrieved 2014-08-19.

- ^ "Ceph Community Forms Advisory Board". 2015-10-28. Archivado desde el original en 2019-01-29. Retrieved 2016-01-20.

- ^ "La Fundación Linux lanza la Fundación Ceph para promover el almacenamiento de código abierto". 2018-11-12.

- ^ "SUSE dice tschüss al producto de almacenamiento empresarial basado en Ceph - es el Longhorn de Rancher de aquí en adelante".

- ^ "SUSE Enterprise Software-Defined Storage".

- ^ Ceph.io — v16.2.0 Pacific released

- ^ Ceph.io — v17.2.0 Quincy released

- ^ Flores, Laura (6 de agosto de 2023). "v18.2.0 Reef liberado". Ceph Blog. Retrieved 26 de agosto 2023.

- ^ "Libertad activa". docs.ceph.com. Retrieved 3 de octubre 2024.

- ^ Flores, Laura (26 de septiembre de 2024). "v19.2.0 Squid liberado". Ceph Blog. Retrieved 3 de octubre 2024.

- ^ "Libertad activa". docs.ceph.com. Retrieved 3 de octubre 2024.

- ^ "Ceph Developer Summit - Tentacle". ceph.io11 de agosto de 2024. Retrieved 3 de octubre 2024.

- ^ "Ceph para Windows". Cloudbase Solutions. Retrieved 2 de julio 2023.

- ^ Pilotti, Alessandro (4 mayo 2023). "Ceph en Windows". YouTube. Retrieved 2 de julio 2023.

Más lectura

- M. Tim Jones (2010-05-04). "Ceph: A Linux petabyte-scale distributed file system". DesarrolladoresWorks > Linux > Biblioteca Técnica. Retrieved 2010-05-06.

- Jeffrey B. Layton (2010-04-20). "Ceph: The Distributed File System Creature from the Object Lagoon". Linux Magazine. Archivado desde el original el 23 de abril de 2010. Retrieved 2010-04-24.

- Carlos Maltzahn; Esteban Molina-Estolano; Amandeep Khurana; Alex J. Nelson; Scott A. Brandt; Sage Weil (agosto de 2010). "Ceph como una alternativa escalable al sistema de archivos distribuidos Hadoop". ;login:. 35 4). Retrieved 2012-03-09.

- Martin Loschwitz (24 de abril de 2012). "The RADOS Object Store and Ceph Filesystem". HPC ADMIN Magazine. Retrieved 2012-04-25.

Enlaces externos

- Sitio oficial

- Estado del Cephalopod 2022 en YouTube

- Estado del Cephalopod en YouTube (2023)