Calibración

En tecnología de medición y metrología, la calibración es la comparación de los valores de medición entregados por un dispositivo bajo prueba con los de un estándar de calibración de precisión conocida. Dicho estándar podría ser otro dispositivo de medición de precisión conocida, un dispositivo que genere la cantidad a medir, como un voltaje, un tono de sonido o un artefacto físico, como una regla de metro.

El resultado de la comparación puede resultar en uno de los siguientes:

- no hay error significativo en el dispositivo bajo prueba

- un error importante que se observa pero no se hace ningún ajuste

- un ajuste hecho para corregir el error a un nivel aceptable

Estrictamente hablando, el término "calibración" significa simplemente el acto de comparación y no incluye ningún ajuste posterior.

El estándar de calibración normalmente es trazable a un estándar nacional o internacional en poder de un organismo de metrología.

Definición de BIPM

La definición formal de calibración de la Oficina Internacional de Pesos y Medidas (BIPM) es la siguiente: "Operación que, bajo condiciones específicas, en un primer paso, establece una relación entre los valores de cantidad con las incertidumbres de medición proporcionadas por patrones de medición e indicaciones correspondientes con incertidumbres de medición asociadas (del instrumento calibrado o patrón secundario) y, en un segundo paso, utiliza esta información para establecer una relación para obtener un resultado de medición a partir de una indicación."

Esta definición establece que el proceso de calibración es puramente una comparación, pero introduce el concepto de incertidumbre de medición al relacionar las precisiones del dispositivo bajo prueba y el estándar.

Modernos procesos de calibración

La creciente necesidad de precisión e incertidumbre conocidas y la necesidad de tener estándares consistentes y comparables a nivel internacional ha llevado al establecimiento de laboratorios nacionales. En muchos países existirá un Instituto Nacional de Metrología (NMI) que mantendrá estándares primarios de medición (las unidades SI principales más un número de unidades derivadas) que se utilizarán para brindar trazabilidad a los instrumentos del cliente mediante calibración.

El NMI apoya la infraestructura metrológica en ese país (ya menudo en otros) al establecer una cadena ininterrumpida, desde el nivel superior de estándares hasta un instrumento utilizado para la medición. Ejemplos de Institutos Nacionales de Metrología son NPL en el Reino Unido, NIST en los Estados Unidos, PTB en Alemania y muchos otros. Desde que se firmó el Acuerdo de Reconocimiento Mutuo, ahora es sencillo obtener la trazabilidad de cualquier INM participante y ya no es necesario que una empresa obtenga la trazabilidad de las mediciones del INM del país en el que se encuentra, como el Laboratorio Nacional de Física. en el Reino Unido.

Calidad

Para mejorar la calidad de la calibración y que organizaciones externas acepten los resultados, es deseable que la calibración y las mediciones posteriores sean "rastreables" a las unidades de medida definidas internacionalmente. El establecimiento de la trazabilidad se logra mediante una comparación formal con un estándar que está directa o indirectamente relacionado con estándares nacionales (como NIST en los EE. UU.), estándares internacionales o materiales de referencia certificados. Esto puede ser realizado por laboratorios de patrones nacionales operados por el gobierno o por firmas privadas que ofrecen servicios de metrología.

Los sistemas de gestión de la calidad exigen un sistema de metrología eficaz que incluya la calibración formal, periódica y documentada de todos los instrumentos de medición. Las normas ISO 9000 e ISO 17025 requieren que estas acciones rastreables sean de alto nivel y establecen cómo se pueden cuantificar.

Para comunicar la calidad de una calibración, el valor de calibración suele ir acompañado de una declaración de incertidumbre trazable a un nivel de confianza establecido. Esto se evalúa a través de un cuidadoso análisis de incertidumbre. Algunas veces se requiere un DFS (Departure From Spec) para operar maquinaria en un estado degradado. Siempre que esto suceda, debe ser por escrito y autorizado por un gerente con la asistencia técnica de un técnico de calibración.

Los dispositivos e instrumentos de medición se clasifican según las cantidades físicas para las que están diseñados. Estos varían internacionalmente, por ejemplo, NIST 150-2G en EE. UU. y NABL-141 en India. Juntos, estos estándares cubren instrumentos que miden varias cantidades físicas como radiación electromagnética (sondas de RF), sonido (medidor de nivel de sonido o dosímetro de ruido), tiempo y frecuencia (intervalómetro), radiación ionizante (contador Geiger), luz (medidor de luz), cantidades mecánicas (interruptor de límite, manómetro, interruptor de presión) y propiedades termodinámicas o térmicas (termómetro, controlador de temperatura). El instrumento estándar para cada dispositivo de prueba varía en consecuencia, por ejemplo, un probador de peso muerto para la calibración del indicador de presión y un probador de temperatura de bloque seco para la calibración del indicador de temperatura.

Avisos de calibración del instrumento

La calibración puede ser necesaria por las siguientes razones:

- un nuevo instrumento

- después de que un instrumento haya sido reparado o modificado

- pasar de un lugar a otro

- cuando ha transcurrido un período de tiempo determinado

- cuando un uso específico (horas de operación) ha pasado

- antes y/o después de una medición crítica

- después de un evento, por ejemplo

- después de que un instrumento haya sido expuesto a un choque, vibración o daño físico, que podría haber comprometido potencialmente la integridad de su calibración

- cambios repentinos en el tiempo

- cuando las observaciones parecen cuestionables o las indicaciones de instrumentos no coinciden con la producción de instrumentos sustitutos

- como se especifica en un requisito, por ejemplo, especificación del cliente, recomendación del fabricante de instrumentos.

En general, se suele considerar que la calibración incluye el proceso de ajustar la salida o indicación de un instrumento de medición para coincidir con el valor del estándar aplicado, dentro de una precisión especificada. Por ejemplo, se podría calibrar un termómetro para determinar el error de indicación o la corrección y ajustarlo (por ejemplo, a través de constantes de calibración) para que muestre la temperatura real en grados Celsius en puntos específicos de la escala. Esta es la percepción del usuario final del instrumento. Sin embargo, muy pocos instrumentos se pueden ajustar para que coincidan exactamente con los estándares con los que se comparan. Para la gran mayoría de las calibraciones, el proceso de calibración es en realidad la comparación de un desconocido con un conocido y el registro de los resultados.

Proceso básico de calibración

Propósito y alcance

El proceso de calibración comienza con el diseño del instrumento de medición que necesita ser calibrado. El diseño debe poder "mantener una calibración" a través de su intervalo de calibración. En otras palabras, el diseño debe ser capaz de realizar mediciones que estén "dentro de la tolerancia de ingeniería" cuando se utiliza dentro de las condiciones ambientales establecidas durante un período de tiempo razonable. Tener un diseño con estas características aumenta la probabilidad de que los instrumentos de medición reales funcionen como se espera. Básicamente, el propósito de la calibración es mantener la calidad de la medición y garantizar el funcionamiento adecuado de un instrumento en particular.

Frecuencia

El mecanismo exacto para asignar valores de tolerancia varía según el país y el tipo de industria. El fabricante de equipos de medición generalmente asigna la tolerancia de medición, sugiere un intervalo de calibración (CI) y especifica el rango ambiental de uso y almacenamiento. La organización usuaria generalmente asigna el intervalo de calibración real, que depende del nivel de uso probable de este equipo de medición específico. La asignación de intervalos de calibración puede ser un proceso formal basado en los resultados de calibraciones anteriores. Los estándares en sí mismos no son claros sobre los valores de IC recomendados:

- ISO 17025

- "Un certificado de calibración (o etiqueta de calibración) no incluirá ninguna recomendación sobre el intervalo de calibración excepto cuando se haya acordado con el cliente. Este requisito puede ser reemplazado por normas legales. ”

- ANSI/NCSL Z540

- "...será calibrado o verificado a intervalos periódicos establecidos y mantenidos para asegurar una confiabilidad aceptable..."

- ISO-9001

- "Cuando sea necesario para asegurar resultados válidos, el equipo de medición... será calibrado o verificado a intervalos específicos, o antes de usar... ”

- MIL-STD-45662A

- "... se calibrará a intervalos periódicos establecidos y mantenidos para asegurar una precisión y fiabilidad aceptables... Los intervalos serán acortados o pueden ser alargados, por el contratista, cuando los resultados de calibraciones anteriores indican que dicha acción es apropiada para mantener una fiabilidad aceptable".

Estándares requeridos y precisión

El siguiente paso es definir el proceso de calibración. La selección de un estándar o estándares es la parte más visible del proceso de calibración. Idealmente, el estándar tiene menos de 1/4 de la incertidumbre de medición del dispositivo que se está calibrando. Cuando se cumple este objetivo, la incertidumbre de medición acumulada de todos los estándares involucrados se considera insignificante cuando la medición final también se realiza con la relación 4:1. Esta relación probablemente se formalizó por primera vez en el Manual 52 que acompañaba a MIL-STD-45662A, una de las primeras especificaciones del programa de metrología del Departamento de Defensa de EE. UU. Fue 10:1 desde su inicio en la década de 1950 hasta la década de 1970, cuando la tecnología avanzada hizo que 10:1 fuera imposible para la mayoría de las mediciones electrónicas.

Es difícil mantener una relación de precisión de 4:1 con equipos modernos. El equipo de prueba que se está calibrando puede ser tan preciso como el estándar de trabajo. Si la relación de precisión es inferior a 4:1, la tolerancia de calibración se puede reducir para compensar. Cuando se alcanza 1:1, solo una coincidencia exacta entre el estándar y el dispositivo que se está calibrando es una calibración completamente correcta. Otro método común para lidiar con este desajuste de capacidad es reducir la precisión del dispositivo que se está calibrando.

Por ejemplo, un indicador con una precisión establecida por el fabricante del 3 % se puede cambiar al 4 % para que se pueda usar un estándar de precisión del 1 % en 4:1. Si el manómetro se usa en una aplicación que requiere una precisión del 16 %, reducir la precisión del manómetro al 4 % no afectará la precisión de las mediciones finales. Esto se llama una calibración limitada. Pero si la medición final requiere un 10 % de precisión, entonces el calibre del 3 % nunca podrá ser mejor que 3,3:1. Entonces quizás ajustar la tolerancia de calibración para el medidor sería una mejor solución. Si la calibración se realiza a 100 unidades, el estándar del 1 % en realidad estaría entre 99 y 101 unidades. Los valores aceptables de las calibraciones en las que el equipo de prueba tiene una relación de 4:1 serían de 96 a 104 unidades, inclusive. Cambiar el rango aceptable de 97 a 103 unidades eliminaría la contribución potencial de todos los estándares y preservaría una proporción de 3,3:1. Continuando, un cambio adicional al rango aceptable de 98 a 102 restaura más de una proporción final de 4:1.

Este es un ejemplo simplificado. Las matemáticas del ejemplo pueden ser cuestionadas. Es importante que cualquier pensamiento que guió este proceso en una calibración real sea registrado y accesible. La informalidad contribuye a las pilas de tolerancia y otros problemas posteriores a la calibración difíciles de diagnosticar.

También en el ejemplo anterior, idealmente, el valor de calibración de 100 unidades sería el mejor punto en el rango del indicador para realizar una calibración de un solo punto. Puede ser la recomendación del fabricante o puede ser la forma en que ya se están calibrando dispositivos similares. También se utilizan calibraciones de múltiples puntos. Dependiendo del dispositivo, un estado de unidad cero, la ausencia del fenómeno que se mide, también puede ser un punto de calibración. O el usuario puede restablecer el cero; hay varias variaciones posibles. Nuevamente, se deben registrar los puntos a utilizar durante la calibración.

Puede haber técnicas de conexión específicas entre el estándar y el dispositivo que se está calibrando que pueden influir en la calibración. Por ejemplo, en calibraciones electrónicas que involucran fenómenos analógicos, la impedancia de las conexiones de los cables puede influir directamente en el resultado.

Calibraciones manuales y automáticas

Los métodos de calibración para dispositivos modernos pueden ser manuales o automáticos.

Como ejemplo, se puede utilizar un proceso manual para la calibración de un manómetro. El procedimiento requiere varios pasos, para conectar el manómetro bajo prueba a un manómetro maestro de referencia y una fuente de presión ajustable, para aplicar presión de fluido tanto a los manómetros de referencia como a los de prueba en puntos definidos sobre el alcance del manómetro, y comparar las lecturas de los dos. El manómetro bajo prueba puede ajustarse para asegurar que su punto cero y su respuesta a la presión se acerquen lo más posible a la precisión deseada. Cada paso del proceso requiere un registro manual.

Un calibrador automático de presión es un dispositivo que combina una unidad de control electrónico, un intensificador de presión que se usa para comprimir un gas como el nitrógeno, un transductor de presión que se usa para detectar los niveles deseados en un acumulador hidráulico y accesorios como trampas de líquido y manómetro guarniciones. Un sistema automático también puede incluir instalaciones de recopilación de datos para automatizar la recopilación de datos para el mantenimiento de registros.

Descripción y documentación del proceso

Toda la información anterior se recopila en un procedimiento de calibración, que es un método de prueba específico. Estos procedimientos capturan todos los pasos necesarios para realizar una calibración exitosa. El fabricante puede proporcionar uno o la organización puede preparar uno que también capture todos los demás requisitos de la organización. Existen cámaras de compensación para los procedimientos de calibración, como el Programa de Intercambio de Datos de la Industria y el Gobierno (GIDEP) en los Estados Unidos.

Este proceso exacto se repite para cada uno de los estándares utilizados hasta que se alcanzan los estándares de transferencia, los materiales de referencia certificados y/o las constantes físicas naturales, los estándares de medición con la menor incertidumbre en el laboratorio. Esto establece la trazabilidad de la calibración.

Consulte Metrología para conocer otros factores que se consideran durante el desarrollo del proceso de calibración.

Después de todo esto, finalmente se pueden calibrar los instrumentos individuales del tipo específico mencionado anteriormente. El proceso generalmente comienza con una verificación básica de daños. Algunas organizaciones, como las plantas de energía nuclear, recopilan información "tal como se encuentra" datos de calibración antes de realizar cualquier mantenimiento de rutina. Después de que se solucionen el mantenimiento de rutina y las deficiencias detectadas durante la calibración, se muestra un mensaje "como se dejó" se realiza la calibración.

Más comúnmente, un técnico de calibración se encarga de todo el proceso y firma el certificado de calibración, que documenta la finalización de una calibración exitosa. El proceso básico descrito anteriormente es un desafío difícil y costoso. El costo del soporte de equipo ordinario es generalmente alrededor del 10% del precio de compra original anualmente, como regla general comúnmente aceptada. Los dispositivos exóticos, como los microscopios electrónicos de barrido, los sistemas de cromatografía de gases y los dispositivos de interferómetro láser, pueden ser aún más costosos de mantener.

La 'medida única' dispositivo utilizado en la descripción del proceso de calibración básica anterior existe. Pero, dependiendo de la organización, la mayoría de los dispositivos que necesitan calibración pueden tener varios rangos y muchas funcionalidades en un solo instrumento. Un buen ejemplo es un osciloscopio moderno común. Fácilmente podría haber 200,000 combinaciones de configuraciones para calibrar completamente y limitaciones sobre cuánto de una calibración con todo incluido se puede automatizar.

Para evitar el acceso no autorizado a un instrumento, normalmente se aplican sellos a prueba de manipulaciones después de la calibración. La imagen de la gradilla del osciloscopio los muestra y demuestra que el instrumento no se ha quitado desde la última vez que se calibró, ya que es posible que no estén autorizados a los elementos de ajuste del instrumento. También hay etiquetas que muestran la fecha de la última calibración y cuándo el intervalo de calibración dicta cuándo se necesita la siguiente. Algunas organizaciones también asignan una identificación única a cada instrumento para estandarizar el mantenimiento de registros y realizar un seguimiento de los accesorios que son parte integral de una condición de calibración específica.

Cuando los instrumentos que se calibran están integrados con computadoras, los programas informáticos integrados y cualquier corrección de calibración también están bajo control.

Desarrollo histórico

Orígenes

Las palabras "calibrar" y "calibración" ingresó al idioma inglés tan recientemente como la Guerra Civil estadounidense, en descripciones de artillería, que se cree que se deriva de una medida del calibre de un arma.

Algunos de los primeros sistemas conocidos de medición y calibración parecen haber sido creados entre las antiguas civilizaciones de Egipto, Mesopotamia y el valle del Indo, con excavaciones que revelan el uso de gradaciones angulares para la construcción. El término "calibración" probablemente se asoció por primera vez con la división precisa de la distancia lineal y los ángulos usando un motor de división y la medición de la masa gravitatoria usando una balanza. Estas dos formas de medición por sí solas y sus derivados directos respaldaron casi todo el comercio y el desarrollo tecnológico desde las primeras civilizaciones hasta aproximadamente el año 1800 d.C.

Calibración de pesos y distancias (c. 1100 CE)

Los primeros dispositivos de medición eran directos, es decir, tenían las mismas unidades que la cantidad que se estaba midiendo. Los ejemplos incluyen la longitud usando una vara de medir y la masa usando una balanza. A principios del siglo XII, durante el reinado de Enrique I (1100-1135), se decretó que una yarda sería "la distancia desde la punta de la nariz del rey hasta el final de su brazo extendido. pulgar." Sin embargo, no fue hasta el reinado de Ricardo I (1197) que encontramos evidencia documentada.

- Medidas

- "A lo largo del reino habrá el mismo patio del mismo tamaño y debe ser de hierro."

Siguieron otros intentos de estandarización, como la Carta Magna (1225) para medidas líquidas, hasta el Mètre des Archives de Francia y el establecimiento del sistema métrico.

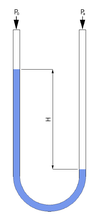

La calibración temprana de instrumentos de presión

Uno de los primeros dispositivos de medición de presión fue el barómetro de Mercurio, atribuido a Torricelli (1643), que leía la presión atmosférica usando Mercurio. Poco después, se diseñaron manómetros llenos de agua. Todos estos tendrían calibraciones lineales utilizando principios gravimétricos, donde la diferencia de niveles era proporcional a la presión. Las unidades de medida normales serían las convenientes pulgadas de mercurio o agua.

En el diseño de manómetro hidrostático de lectura directa de la derecha, la presión aplicada Pa empuja el líquido hacia abajo por el lado derecho del tubo en U del manómetro, mientras que una escala de longitud junto al tubo mide la diferencia de niveles La diferencia de altura resultante "H" es una medida directa de la presión o vacío con respecto a la presión atmosférica. En ausencia de presión diferencial, ambos niveles serían iguales, y esto se usaría como el punto cero.

La Revolución Industrial vio la adopción de "indirect" dispositivos de medición de presión, que eran más prácticos que el manómetro. Un ejemplo son las máquinas de vapor de alta presión (hasta 50 psi), en las que se utilizó mercurio para reducir la longitud de la escala a unas 60 pulgadas, pero dicho manómetro era caro y propenso a sufrir daños. Esto estimuló el desarrollo de instrumentos de lectura indirecta, de los cuales el tubo de Bourdon inventado por Eugène Bourdon es un ejemplo notable.

En las vistas frontal y posterior de un manómetro Bourdon a la derecha, la presión aplicada en el accesorio inferior reduce el rizo en la tubería aplanada proporcionalmente a la presión. Esto mueve el extremo libre del tubo que está vinculado al puntero. El instrumento se calibraría contra un manómetro, que sería el estándar de calibración. Para la medición de cantidades indirectas de presión por unidad de área, la incertidumbre de calibración dependería de la densidad del fluido del manómetro y de los medios para medir la diferencia de altura. A partir de esto, se podrían inferir y marcar en la escala otras unidades, como libras por pulgada cuadrada.

Contenido relacionado

FileMan

Sistema de señalización de acceso digital 1

Bola de dragón de escala libre