Análisis de los datos

Análisis de datos es el proceso de inspeccionar, limpiar, transformar y modelar datos con el objetivo de descubrir información útil, fundamentar conclusiones y respaldar la toma de decisiones. El análisis de datos tiene múltiples facetas y enfoques, abarca diversas técnicas bajo una variedad de nombres y se utiliza en diferentes dominios de negocios, ciencias y ciencias sociales. En el mundo empresarial actual, el análisis de datos desempeña un papel a la hora de tomar decisiones más científicas y ayudar a las empresas a operar de forma más eficaz.

La minería de datos es una técnica particular de análisis de datos que se centra en el modelado estadístico y el descubrimiento de conocimientos con fines predictivos más que puramente descriptivos, mientras que la inteligencia empresarial cubre el análisis de datos que depende en gran medida de la agregación, centrándose principalmente en la información empresarial. En aplicaciones estadísticas, el análisis de datos se puede dividir en estadística descriptiva, análisis de datos exploratorios (EDA) y análisis de datos confirmatorios (CDA). EDA se centra en descubrir nuevas características en los datos, mientras que CDA se centra en confirmar o refutar hipótesis existentes. El análisis predictivo se centra en la aplicación de modelos estadísticos para la predicción o clasificación, mientras que el análisis de texto aplica técnicas estadísticas, lingüísticas y estructurales para extraer y clasificar información de fuentes textuales, una especie de datos no estructurados. Todo lo anterior son variedades de análisis de datos.

La integración de datos es un precursor del análisis de datos, y el análisis de datos está estrechamente relacionado con la visualización de datos y la difusión de datos.

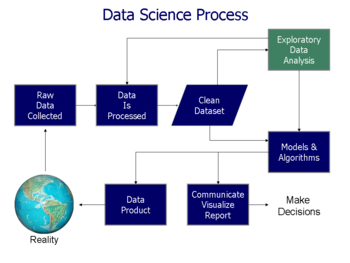

El proceso de análisis de datos

Análisis se refiere a dividir un todo en sus componentes separados para un examen individual. El análisis de datos es un proceso para obtener datos sin procesar, y posteriormente convertirlos en información útil para la toma de decisiones por parte de los usuarios. Los datos se recopilan y analizan para responder preguntas, probar hipótesis o refutar teorías.

El estadístico John Tukey, definió el análisis de datos en 1961, como:

"Procedimientos para analizar datos, técnicas para interpretar los resultados de tales procedimientos, formas de planificar la reunión de datos para facilitar su análisis, más preciso o más preciso, y todas las máquinas y resultados de estadísticas (matemáticas) que se aplican para analizar datos".

Hay varias fases que se pueden distinguir, que se describen a continuación. Las fases son iterativas, en el sentido de que la retroalimentación de fases posteriores puede resultar en trabajo adicional en fases anteriores. El marco CRISP, utilizado en la minería de datos, tiene pasos similares.

Requisitos de datos

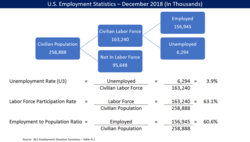

Los datos son necesarios como entradas para el análisis, que se especifica en función de los requisitos de quienes dirigen el análisis (o de los clientes, que utilizarán el producto final del análisis). El tipo general de entidad sobre la cual se recopilarán los datos se denomina unidad experimental (por ejemplo, una persona o población de personas). Se pueden especificar y obtener variables específicas relacionadas con una población (por ejemplo, edad e ingresos). Los datos pueden ser numéricos o categóricos (es decir, una etiqueta de texto para números).

Recopilación de datos

Los datos se recopilan de una variedad de fuentes. Hay una lista de fuentes de datos disponibles para estudio y consulta. investigación. Los analistas podrán comunicar los requisitos a los custodios de los datos; como por ejemplo, personal de Tecnología de la Información dentro de una organización. La recopilación de datos o recopilación de datos es el proceso de recopilar y medir información sobre variables específicas en un sistema establecido, que luego permite responder preguntas relevantes y evaluar resultados. Los datos también pueden recopilarse a partir de sensores en el medio ambiente, incluidas cámaras de tráfico, satélites, dispositivos de grabación, etc. También pueden obtenerse a través de entrevistas, descargas de fuentes en línea o lectura de documentación.

Procesamiento de datos

Los datos, cuando se obtienen inicialmente, deben procesarse u organizarse para su análisis. Por ejemplo, esto puede implicar colocar datos en filas y columnas en un formato de tabla (conocido como datos estructurados) para su posterior análisis, a menudo mediante el uso de hojas de cálculo o software estadístico.

Limpieza de datos

Una vez procesados y organizados, los datos pueden estar incompletos, contener duplicados o contener errores. La necesidad de limpieza de datos surgirá de problemas en la forma en que se ingresan y almacenan los datos. La limpieza de datos es el proceso de prevenir y corregir estos errores. Las tareas comunes incluyen la comparación de registros, la identificación de inexactitud de los datos, la calidad general de los datos existentes, la deduplicación y la segmentación de columnas. Estos problemas de datos también pueden identificarse mediante una variedad de técnicas analíticas. Por ejemplo; Con la información financiera, los totales de variables particulares pueden compararse con números publicados por separado que se consideran confiables. También podrán revisarse los importes inusuales, superiores o inferiores a umbrales predeterminados. Existen varios tipos de limpieza de datos, que dependen del tipo de datos del conjunto; Estos podrían ser números de teléfono, direcciones de correo electrónico, empleadores u otros valores. Los métodos de datos cuantitativos para la detección de valores atípicos se pueden utilizar para eliminar datos que parecen tener una mayor probabilidad de ingresarse incorrectamente. Los correctores ortográficos de datos textuales se pueden utilizar para reducir la cantidad de palabras mal escritas. Sin embargo, es más difícil saber si las palabras en sí son correctas.

Análisis exploratorio de datos

Una vez que se limpian los conjuntos de datos, se pueden analizar. Los analistas pueden aplicar una variedad de técnicas, denominadas análisis de datos exploratorios, para comenzar a comprender los mensajes contenidos en los datos obtenidos. El proceso de exploración de datos puede resultar en una limpieza de datos adicional o solicitudes de datos adicionales; de ahí la inicialización de las fases iterativas mencionadas en el párrafo inicial de esta sección. Se pueden generar estadísticas descriptivas, como el promedio o la mediana, para ayudar a comprender los datos. La visualización de datos también es una técnica utilizada, en la que el analista puede examinar los datos en un formato gráfico para obtener información adicional sobre los mensajes dentro de los datos.

Modelado y algoritmos

Se pueden aplicarfórmulas matemáticas o modelos (también conocidos como algoritmos) a los datos para identificar relaciones entre las variables; por ejemplo, utilizando correlación o causalidad. En términos generales, se pueden desarrollar modelos para evaluar una variable específica basándose en otras variables contenidas en el conjunto de datos, con algún error residual dependiendo de la precisión del modelo implementado ( por ejemplo, Datos = Modelo + Error).

La estadística inferencial incluye la utilización de técnicas que miden las relaciones entre variables particulares. Por ejemplo, el análisis de regresión se puede utilizar para modelar si un cambio en la publicidad (variable independiente X) proporciona una explicación para la variación en las ventas (variable dependiente Y). En términos matemáticos, Y (ventas) es función de X (publicidad). Puede describirse como (Y = aX + b + error), donde el modelo está diseñado de tal manera que (a) y (b) minimizan el error cuando el modelo predice Y para un rango dado de valores de X. Los analistas también pueden intentar construir modelos que sean descriptivos de los datos, con el objetivo de simplificar el análisis y comunicar los resultados.

Producto de datos

Un producto de datos es una aplicación informática que toma entradas de datos y genera salidas, devolviéndolas al medio ambiente. Puede basarse en un modelo o algoritmo. Por ejemplo, una aplicación que analiza datos sobre el historial de compras del cliente y utiliza los resultados para recomendar otras compras que el cliente podría disfrutar.

Comunicación

Una vez analizados los datos, se pueden informar en muchos formatos a los usuarios del análisis para respaldar sus requisitos. Los usuarios pueden tener comentarios, lo que resulta en análisis adicionales. Como tal, gran parte del ciclo analítico es iterativo.

Al determinar cómo comunicar los resultados, el analista puede considerar implementar una variedad de técnicas de visualización de datos para ayudar a comunicar el mensaje de manera más clara y eficiente a la audiencia. La visualización de datos utiliza visualizaciones de información (gráficos como tablas y cuadros) para ayudar a comunicar mensajes clave contenidos en los datos. Las tablas son una herramienta valiosa que permite al usuario consultar y centrarse en números específicos; mientras que los gráficos (por ejemplo, gráficos de barras o gráficos de líneas) pueden ayudar a explicar los mensajes cuantitativos contenidos en los datos.

Mensajes cuantitativos

Stephen Few describió ocho tipos de mensajes cuantitativos que los usuarios pueden intentar comprender o comunicar a partir de un conjunto de datos y los gráficos asociados utilizados para ayudar a comunicar el mensaje. Los clientes que especifican requisitos y los analistas que realizan el análisis de datos pueden considerar estos mensajes durante el curso del proceso.

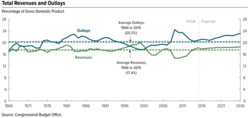

- Series temporales: Una sola variable se captura durante un período de tiempo, como la tasa de desempleo durante un período de 10 años. Se puede utilizar un gráfico de línea para demostrar la tendencia.

- Clasificación: Las subdivisiones cateóricas están clasificadas en orden ascendente o descendente, como un ranking de rendimiento de ventas (las Medida) por los vendedores (los categoría, con cada vendedor a subdivisión categórica) durante un solo período. Se puede utilizar un gráfico de barras para mostrar la comparación entre los vendedores.

- Parte-total: Las subdivisiones cateóricas se miden como una relación con el conjunto (es decir, un porcentaje del 100%). Un gráfico de tartas o un gráfico de barras pueden mostrar la comparación de ratios, como la cuota de mercado representada por los competidores en un mercado.

- Desviación: Las subdivisiones cateóricas se comparan con una referencia, como una comparación de los gastos efectivos vs. del presupuesto para varios departamentos de una empresa durante un período determinado. Un gráfico de barras puede mostrar la comparación de la cantidad real versus la referencia.

- Distribución de frecuencias: Muestra el número de observaciones de una variable particular para un intervalo dado, como el número de años en los que la rentabilidad del mercado de valores es entre intervalos como 0–10%, 11–20%, etc. Un histograma, un tipo de gráfico de barras, se puede utilizar para este análisis.

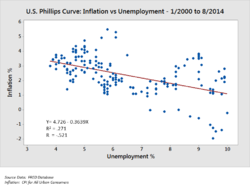

- Correlación: Comparación entre observaciones representadas por dos variables (X,Y) para determinar si tienden a moverse en las mismas direcciones opuestas. Por ejemplo, trazar el desempleo (X) y la inflación (Y) para una muestra de meses. Un diagrama de dispersión se utiliza típicamente para este mensaje.

- Comparación nominal: Comparando subdivisiones categóricas en ningún orden particular, como el volumen de ventas por código de producto. Se puede utilizar un gráfico de barras para esta comparación.

- Geográfico o geoespacial: Comparación de una variable en un mapa o diseño, como la tasa de desempleo por estado o el número de personas en los diversos pisos de un edificio. Un cartograma es un gráfico típico utilizado.

Técnicas de análisis de datos cuantitativos

El autor Jonathan Koomey ha recomendado una serie de mejores prácticas para comprender los datos cuantitativos. Éstas incluyen:

- Comprobar datos brutos para anomalías antes de realizar un análisis;

- Realizar cálculos importantes, como la verificación de columnas de datos que son impulsadas por fórmulas;

- Confirmar los totales principales son la suma de subtotales;

- Revisar las relaciones entre los números que deben estar relacionados de manera predecible, como las relaciones con el tiempo;

- Normalizar los números para facilitar las comparaciones, como el análisis de las cantidades por persona o relativa al PIB o como un valor índice relativo a un año base;

- Rompe los problemas en las partes componentes analizando factores que llevaron a los resultados, como el análisis de DuPont sobre el rendimiento en la equidad.

Para las variables examinadas, los analistas suelen obtener estadísticas descriptivas para ellos, como la media (promedio), mediana y desviación estándar. También pueden analizar la distribución de las variables clave para ver cómo se agrupan los valores individuales alrededor de la media.

Los consultores de McKinsey and Company denominaron una técnica para dividir un problema cuantitativo en sus componentes llamada principio MECE. Cada capa se puede dividir en sus componentes; cada uno de los subcomponentes debe ser mutuamente excluyente entre sí y sumar colectivamente la capa superior a ellos. La relación se denomina "mutuamente excluyente y colectivamente exhaustiva" o MECE. Por ejemplo, las ganancias, por definición, se pueden dividir en ingresos totales y costos totales. A su vez, los ingresos totales pueden analizarse por sus componentes, como los ingresos de las divisiones A, B y C (que se excluyen mutuamente) y deben sumarse a los ingresos totales (colectivamente exhaustivos).

Los analistas pueden utilizar mediciones estadísticas sólidas para resolver ciertos problemas analíticos. La prueba de hipótesis se utiliza cuando el analista formula una hipótesis particular sobre el verdadero estado de cosas y se recopilan datos para determinar si ese estado de cosas es verdadero o falso. Por ejemplo, la hipótesis podría ser que "el desempleo no tiene ningún efecto sobre la inflación", lo que se relaciona con un concepto económico llamado curva de Phillips. La prueba de hipótesis implica considerar la probabilidad de errores de tipo I y tipo II, que se relacionan con si los datos respaldan la aceptación o el rechazo de la hipótesis.

El análisis de regresión se puede utilizar cuando el analista intenta determinar en qué medida la variable independiente X afecta la variable dependiente Y (por ejemplo, "En qué medida los cambios en la tasa de desempleo (X) afectan la tasa de inflación ( ¿Y)?"). Este es un intento de modelar o ajustar una línea o curva de ecuación a los datos, de modo que Y sea una función de X.

El análisis de condición necesaria (NCA) se puede utilizar cuando el analista intenta determinar en qué medida la variable independiente X permite la variable Y (por ejemplo, "¿En qué medida es necesaria una determinada tasa de desempleo (X) para que un cierta tasa de inflación (Y)?"). Mientras que el análisis de regresión (múltiple) usa lógica aditiva donde cada variable X puede producir el resultado y las X pueden compensarse entre sí (son suficientes pero no necesarias), el análisis de condición necesaria (NCA) usa lógica de necesidad, donde una o más variables X permiten que exista el resultado, pero pueden no producirlo (son necesarias pero no suficientes). Cada una de las condiciones necesarias debe estar presente y la compensación no es posible.

Actividades analíticas de los usuarios de datos

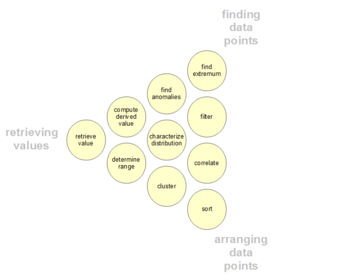

Los usuarios pueden tener puntos de interés de datos particulares dentro de un conjunto de datos, en lugar de la mensajería general descrita anteriormente. Dichas actividades analíticas de usuario de bajo nivel se presentan en la siguiente tabla. La taxonomía también puede ser organizada por tres polos de actividades: recuperar valores, encontrar puntos de datos y organizar puntos de datos.

| # | Tareas | General Descripción | Pro Forma Resumen | Ejemplos |

|---|---|---|---|---|

| 1 | Valor de recuperación | Dado un conjunto de casos específicos, encontrar atributos de esos casos. | ¿Cuáles son los valores de los atributos {X, Y, Z,...} en los casos de datos {A, B, C,...}? | - ¿Cuál es el kilometraje por galón del Ford Mondeo? - ¿Cuánto dura la película? |

| 2 | Filtro | Dada algunas condiciones concretas en valores de atributos, encuentre casos de datos que satisfagan esas condiciones. | ¿Qué casos de datos satisfacen las condiciones {A, B, C...}? | - ¿Qué cereales de Kellogg tienen fibra alta? - ¿Qué comedias han ganado premios? - ¿Qué fondos sufrieron el SP-500? |

| 3 | Compute Derived Valor | Dado un conjunto de casos de datos, computar una representación numérica agregada de esos casos de datos. | ¿Cuál es el valor de la función de agregación F sobre un conjunto dado S de casos de datos? | - ¿Cuál es el contenido promedio de calorías de los cereales post? - ¿Cuál es el ingreso bruto de todas las tiendas combinadas? - ¿Cuántos fabricantes de coches hay? |

| 4 | Encontrar Extremum | Encontrar casos de datos que posean un valor extremo de un atributo sobre su rango dentro del conjunto de datos. | ¿Cuáles son los casos de datos superiores/de abajo con respecto al atributo A? | - ¿Cuál es el coche con el MPG más alto? - ¿Qué director/film ha ganado más premios? - ¿Qué película de Marvel Studios tiene la fecha de lanzamiento más reciente? |

| 5 | # | Dado un conjunto de casos de datos, clasificarlos según alguna métrica ordinal. | ¿Cuál es el orden ordenados de un conjunto S de casos de datos de acuerdo a su valor de atributo A? | - Pide los coches en peso. - Ranke los cereales por calorías. |

| 6 | Determine Range | Dado un conjunto de casos de datos y un atributo de interés, encuentre el alcance de los valores dentro del conjunto. | ¿Cuál es el rango de valores del atributo A en un conjunto S de casos de datos? | - ¿Cuál es la gama de longitudes de película? - ¿Cuál es la gama de caballos de coches? - ¿Qué actrices están en el conjunto de datos? |

| 7 | Caracterizar la distribución | Dado un conjunto de casos de datos y un atributo cuantitativo de interés, caracterizan la distribución de los valores de ese atributo sobre el conjunto. | ¿Cuál es la distribución de valores del atributo A en un conjunto S de casos de datos? | - ¿Cuál es la distribución de carbohidratos en cereales? - ¿Cuál es la distribución de edad de los compradores? |

| 8 | Encontrar anomalías | Identificar cualquier anomalía dentro de un determinado conjunto de casos de datos con respecto a una relación o expectativa determinada, por ejemplo, los outliers estadísticos. | ¿Qué casos de datos en un conjunto S de casos de datos tienen valores inesperados/excepcionales? | - ¿Hay excepciones a la relación entre caballos de fuerza y aceleración? - ¿Hay algún outlier en proteína? |

| 9 | Grupo | Dado un conjunto de casos de datos, encontrar grupos de valores de atributos similares. | ¿Qué casos de datos en un conjunto S de casos de datos son similares en valor para atributos {X, Y, Z,...}? | - ¿Hay grupos de cereales w / grasa similar / calorías / azúcar? - ¿Hay un grupo de largos típicos? |

| 10 | Correlato | Dado un conjunto de casos de datos y dos atributos, determinar relaciones útiles entre los valores de esos atributos. | ¿Cuál es la correlación entre atributos X y Y sobre un conjunto dado S de casos de datos? | - ¿Hay una correlación entre carbohidratos y grasa? - ¿Hay una correlación entre país de origen y MPG? - ¿Tienen diferentes géneros un método de pago preferido? - ¿Hay una tendencia a aumentar la longitud de la película a lo largo de los años? |

| 11 | Contextualization | Dado un conjunto de casos de datos, encontrar la relevancia contextual de los datos a los usuarios. | ¿Qué casos de datos en un conjunto S de casos de datos son relevantes para el contexto actual de los usuarios? | - ¿Hay grupos de restaurantes que tienen alimentos basados en mi ingesta calórica actual? |

Barreras para un análisis eficaz

Pueden existir barreras para un análisis eficaz entre los analistas que realizan el análisis de datos o entre la audiencia. Distinguir los hechos de las opiniones, los sesgos cognitivos y la aritmética son desafíos para un análisis sólido de los datos.

Hechos y opiniones confusos

Tiene derecho a su propia opinión, pero no tiene derecho a sus propios hechos.

Daniel Patrick Moynihan

El análisis eficaz requiere obtener hechos relevantes para responder preguntas, respaldar una conclusión u opinión formal, o probar hipótesis. Los hechos, por definición, son irrefutables, lo que significa que cualquier persona involucrada en el análisis debería poder ponerse de acuerdo sobre ellos. Por ejemplo, en agosto de 2010, la Oficina de Presupuesto del Congreso (CBO) estimó que ampliar los recortes de impuestos de Bush de 2001 y 2003 para el período 2011-2020 añadiría aproximadamente 3,3 billones de dólares a la deuda nacional. Todo el mundo debería poder estar de acuerdo en que, efectivamente, esto es lo que informó la CBO; Todos pueden examinar el informe. Esto lo convierte en un hecho. Si las personas están de acuerdo o en desacuerdo con la CBO es su propia opinión.

Como otro ejemplo, el auditor de una empresa pública debe llegar a una opinión formal sobre si los estados financieros de las empresas que cotizan en bolsa están "expresados de manera justa, en todos los aspectos importantes". Esto requiere un análisis exhaustivo de datos fácticos y pruebas que respalden su opinión. Al dar el salto de los hechos a las opiniones, siempre existe la posibilidad de que la opinión sea errónea.

Sesgos cognitivos

Existe una variedad de sesgos cognitivos que pueden afectar negativamente al análisis. Por ejemplo, el sesgo de confirmación es la tendencia a buscar o interpretar información de una manera que confirme las ideas preconcebidas. Además, las personas pueden desacreditar información que no respalde sus puntos de vista.

Los analistas pueden recibir capacitación específica para ser conscientes de estos sesgos y cómo superarlos. En su libro Psicología del análisis de inteligencia, el analista retirado de la CIA Richards Heuer escribió que los analistas deben delinear claramente sus suposiciones y cadenas de inferencia y especificar el grado y la fuente de la incertidumbre involucrada en las conclusiones. Hizo hincapié en los procedimientos para ayudar a sacar a la luz y debatir puntos de vista alternativos.

Inalfabetismo

Los analistas eficaces generalmente son expertos en una variedad de técnicas numéricas. Sin embargo, es posible que el público no tenga ese conocimiento de los números o la aritmética; se dice que son innumerables. Las personas que comunican los datos también pueden estar intentando engañar o desinformar, utilizando deliberadamente malas técnicas numéricas.

Por ejemplo, si un número aumenta o disminuye puede no ser el factor clave. Más importante puede ser el número en relación con otro número, como el tamaño de los ingresos o gastos del gobierno en relación con el tamaño de la economía (PIB) o el monto del costo en relación con los ingresos en los estados financieros corporativos. Esta técnica numérica se conoce como normalización o dimensionamiento común. Los analistas emplean muchas técnicas de este tipo, ya sea ajustando la inflación (es decir, comparando datos reales con datos nominales) o considerando aumentos de población, datos demográficos, etc. Los analistas aplican una variedad de técnicas para abordar los diversos mensajes cuantitativos descritos en la sección anterior.

Los analistas también pueden analizar datos bajo diferentes supuestos o escenarios. Por ejemplo, cuando los analistas realizan análisis de estados financieros, a menudo los reformulan bajo diferentes supuestos para ayudar a llegar a una estimación del flujo de efectivo futuro, que luego descuentan al valor presente con base en alguna tasa de interés, para determinar la valoración del activo. empresa o sus acciones. De manera similar, la CBO analiza los efectos de varias opciones de políticas sobre los ingresos, los desembolsos y los déficits del gobierno, creando escenarios futuros alternativos para medidas clave.

Otros temas

Construcción inteligente

Se puede utilizar un enfoque de análisis de datos para predecir el consumo de energía en los edificios. Los diferentes pasos del proceso de análisis de datos se llevan a cabo para realizar edificios inteligentes, donde las operaciones de control y gestión del edificio, incluidas calefacción, ventilación, aire acondicionado, iluminación y seguridad, se realizan automáticamente imitando las necesidades de los usuarios del edificio y optimizando los recursos. como la energía y el tiempo.

Análisis e inteligencia de negocios

El análisis es el "uso extensivo de datos, análisis estadísticos y cuantitativos, modelos explicativos y predictivos y gestión basada en hechos para impulsar decisiones y acciones". Es un subconjunto de la inteligencia empresarial, que es un conjunto de tecnologías y procesos que utilizan datos para comprender y analizar el desempeño empresarial para impulsar la toma de decisiones.

Educación

En educación, la mayoría de los educadores tienen acceso a un sistema de datos con el fin de analizar los datos de los estudiantes. Estos sistemas de datos presentan datos a los educadores en un formato de venta libre (incorporando etiquetas, documentación complementaria y un sistema de ayuda y tomando decisiones clave sobre empaque/exhibición y contenido) para mejorar la precisión de los análisis de datos de los educadores.

Notas del practicante

Esta sección contiene explicaciones bastante técnicas que pueden ayudar a los profesionales, pero que están más allá del alcance típico de un artículo de Wikipedia.

Análisis de datos inicial

La distinción más importante entre la fase de análisis de datos inicial y la fase de análisis principal es que durante el análisis de datos inicial uno se abstiene de cualquier análisis que tenga como objetivo responder la pregunta de investigación original. La fase inicial de análisis de datos se guía por las siguientes cuatro preguntas:

Calidad de los datos

La calidad de los datos debe comprobarse lo antes posible. La calidad de los datos se puede evaluar de varias maneras, utilizando diferentes tipos de análisis: recuentos de frecuencia, estadísticas descriptivas (media, desviación estándar, mediana), normalidad (asimetría, curtosis, histogramas de frecuencia), y se necesita una imputación normal.

- Análisis de observaciones extremas: se analizan las observaciones salientes en los datos para ver si parecen perturbar la distribución.

- Comparación y corrección de las diferencias en los esquemas de codificación: las variables se comparan con los esquemas de codificación de variables externas al conjunto de datos, y posiblemente corregidos si los esquemas de codificación no son comparables.

- Prueba para la varianza de metodos comunes.

La elección de los análisis para evaluar la calidad de los datos durante la fase inicial de análisis de datos depende de los análisis que se realizarán en la fase de análisis principal.

Calidad de las mediciones

La calidad de los instrumentos de medición sólo debe comprobarse durante la fase inicial de análisis de datos cuando este no sea el foco o la pregunta de investigación del estudio. Se debe comprobar si la estructura de los instrumentos de medición corresponde a la estructura reportada en la literatura.

Hay dos formas de evaluar la calidad de la medición:

- Análisis del factor confirmatorio

- Análisis de homogeneidad (congruencia interna), que da una indicación de la fiabilidad de un instrumento de medición. Durante este análisis, se inspeccionan las diferencias de los elementos y las escalas, el α de las escalas del Cronbach, y el cambio en el alfa del Cronbach cuando se eliminaría un elemento de una escala

Transformaciones iniciales

Después de evaluar la calidad de los datos y de las mediciones, uno podría decidir imputar datos faltantes, o realizar transformaciones iniciales de una o más variables, aunque esto también se puede hacer durante la fase de análisis principal.

Las posibles transformaciones de las variables son:

- Transformación de raíz cuadrada (si la distribución difiere moderadamente de lo normal)

- Transformación de registros (si la distribución difiere sustancialmente de lo normal)

- Transformación inversa (si la distribución difiere severamente de lo normal)

- Hacer categórica (ordinal / dicotomoso) (si la distribución difiere severamente de lo normal, y ninguna transformación ayuda)

¿La implementación del estudio cumplió con las intenciones del diseño de investigación?

Se debe comprobar el éxito del procedimiento de aleatorización, por ejemplo comprobando si las variables de fondo y sustantivas están distribuidas equitativamente dentro y entre los grupos.

Si el estudio no necesita o utiliza un procedimiento de aleatorización, se debe comprobar el éxito del muestreo no aleatorio, por ejemplo comprobando si todos los subgrupos de la población de interés están representados en la muestra.

Otros Las posibles distorsiones de datos que deben comprobarse son:

- deserción (esto debe identificarse durante la fase inicial de análisis de datos)

- No respuesta (si esto es aleatorio o no se debe evaluar durante la fase inicial de análisis de datos)

- Calidad del tratamiento (con controles de manipulación).

Características de la muestra de datos

En cualquier informe o artículo, se debe describir con precisión la estructura de la muestra. Es especialmente importante determinar exactamente la estructura de la muestra (y específicamente el tamaño de los subgrupos) cuando se realizarán análisis de subgrupos durante la fase de análisis principal.

Las características de la muestra de datos se pueden evaluar observando:

- Estadísticas básicas de variables importantes

- Scatter plots

- Correlaciones y asociaciones

- Transacciones

Etapa final del análisis inicial de datos

Durante la etapa final, se documentan las conclusiones del análisis inicial de datos y se toman las medidas correctivas necesarias, preferibles y posibles.

Además, el plan original para los principales análisis de datos puede y debe especificarse con más detalle o reescrito.

Para ello se pueden y deben tomar varias decisiones sobre los principales análisis de datos:

- En el caso de los no-normales: ¿debería transformar variables; hacer variables categóricas (ordinal/dicotómico); adaptar el método de análisis?

- En el caso de los datos faltantes: ¿debe descuidarse o impedir los datos faltantes; qué técnica de imputación debe ser utilizada?

- En el caso de los atípicos: ¿se debe utilizar una técnica de análisis robusta?

- En caso de que los elementos no se ajusten a la escala: ¿debería uno adaptar el instrumento de medición omitiendo elementos, o más bien asegurar comparabilidad con otros (usos de los) instrumentos de medición?

- En el caso de pequeños subgrupos (demasiado) ¿debería uno soltar la hipótesis sobre las diferencias entre grupos, o utilizar técnicas de muestra pequeñas, como pruebas exactas o arranque?

- En caso de que el procedimiento de aleatoriedad parezca ser defectuoso: ¿puede y debe calcular las puntuaciones de propensión e incluirlas como covariados en los análisis principales?

Análisis

Se pueden utilizar varios análisis durante la fase inicial de análisis de datos:

- Estadísticas Univariadas (variable única)

- Asociaciones bivariadas (correlación)

- Técnicas gráficas

Es importante tener en cuenta los niveles de medición de las variables de los análisis, ya que hay técnicas estadísticas especiales disponibles para cada nivel:

- Variables nominales y ordinal

- Cuentas de frecuencia (números y porcentajes)

- Asociaciones

- circunambulaciones (crosstabulaciones)

- análisis jerárquico loglineal (restrictado a un máximo de 8 variables)

- análisis loglinear (para identificar variables relevantes/importantes y posibles confundadores)

- Pruebas de salida o arranque (en los subgrupos de caso son pequeños)

- Computación de nuevas variables

- Variables continuas

- Distribución

- Estadísticas (M, SD, varianza, picazón, kurtosis)

- Pantallas Stem-and-leaf

- Parcelas de caja

- Distribución

Análisis no lineal

El análisis no lineal suele ser necesario cuando los datos se registran desde un sistema no lineal. Los sistemas no lineales pueden exhibir efectos dinámicos complejos que incluyen bifurcaciones, caos, armónicos y subarmónicos que no pueden analizarse utilizando métodos lineales simples. El análisis de datos no lineal está estrechamente relacionado con la identificación de sistemas no lineales.

Análisis de datos principales

En la fase de análisis principal, se realizan análisis destinados a responder la pregunta de investigación, así como cualquier otro análisis relevante necesario para redactar el primer borrador del informe de investigación.

Enfoques exploratorios y confirmatorios

En la fase de análisis principal, se puede adoptar un enfoque exploratorio o confirmatorio. Generalmente el enfoque se decide antes de recopilar los datos. En un análisis exploratorio no se plantea ninguna hipótesis clara antes de analizar los datos, y se buscan modelos que los describan bien. En un análisis confirmatorio se prueban hipótesis claras sobre los datos.

El análisis de datos exploratorios debe interpretarse con cuidado. Al probar varios modelos a la vez, existe una alta probabilidad de encontrar que al menos uno de ellos sea significativo, pero esto puede deberse a un error de tipo 1. Es importante ajustar siempre el nivel de significancia al probar varios modelos con, por ejemplo, una corrección de Bonferroni. Además, no se debe seguir un análisis exploratorio con un análisis confirmatorio en el mismo conjunto de datos. Un análisis exploratorio se utiliza para encontrar ideas para una teoría, pero no para probarla también. Cuando se considera que un modelo es exploratorio en un conjunto de datos, seguir ese análisis con un análisis confirmatorio en el mismo conjunto de datos podría significar simplemente que los resultados del análisis confirmatorio se deben al mismo error tipo 1 que resultó en el modelo exploratorio en el primer conjunto de datos. lugar. Por lo tanto, el análisis confirmatorio no será más informativo que el análisis exploratorio original.

Estabilidad de los resultados

Es importante obtener alguna indicación sobre cuán generalizables son los resultados. Si bien esto suele ser difícil de comprobar, se puede observar la estabilidad de los resultados. ¿Los resultados son fiables y reproducibles? Hay dos formas principales de hacerlo.

- Cross-validation. Al dividir los datos en múltiples partes, podemos comprobar si un análisis (como un modelo ajustado) basado en una parte de los datos se generaliza a otra parte de los datos también. La validación cruzada es generalmente inapropiada, aunque, si hay correlaciones dentro de los datos, por ejemplo con datos de panel. Por lo tanto, otros métodos de validación a veces necesitan ser utilizados. Para más información sobre este tema, consulte validación de modelos estadísticos.

- Análisis de sensibilidad. Un procedimiento para estudiar el comportamiento de un sistema o modelo cuando los parámetros globales son (sistémicamente) variados. Una manera de hacer eso es a través de arranque.

Software gratuito para análisis de datos

El software gratuito destacado para el análisis de datos incluye:

- DevInfo – Un sistema de bases de datos respaldado por el Grupo de las Naciones Unidas para el Desarrollo para supervisar y analizar el desarrollo humano.

- ELKI – Marco de extracción de datos en Java con funciones de visualización orientadas a la minería de datos.

- KNIME – The Konstanz Information Miner, un marco de análisis de datos amigable y completo.

- Orange – Una herramienta de programación visual que ofrece visualización interactiva de datos y métodos para el análisis estadístico de datos, la minería de datos y el aprendizaje automático.

- Pandas – Biblioteca pitón para el análisis de datos.

- PAW – FORTRAN/C data analysis framework developed at CERN.

- R – Un lenguaje de programación y un entorno de software para computación estadística y gráficos.

- ROOT – Marco de análisis de datos C++ desarrollado en CERN.

- Sci Py – Biblioteca Python para el análisis de datos.

- Julia – Un lenguaje de programación bien adaptado para el análisis numérico y la ciencia computacional.

Análisis reproducible

El flujo de trabajo típico de análisis de datos implica recopilar datos, ejecutar análisis a través de varios scripts, crear visualizaciones y escribir informes. Sin embargo, este flujo de trabajo presenta desafíos, incluida una separación entre los scripts de análisis y los datos, así como una brecha entre el análisis y la documentación. A menudo, el orden correcto de ejecución de scripts sólo se describe de manera informal o reside en la memoria del científico de datos. La posibilidad de perder esta información crea problemas de reproducibilidad. Para abordar estos desafíos, es esencial contar con scripts de análisis escritos para flujos de trabajo automatizados y reproducibles. Además, la documentación dinámica es crucial, ya que proporciona informes que son comprensibles tanto para las máquinas como para los humanos, lo que garantiza una representación precisa del flujo de trabajo de análisis incluso a medida que los scripts evolucionan.

Concursos internacionales de análisis de datos

Diferentes empresas u organizaciones realizan concursos de análisis de datos para alentar a los investigadores a utilizar sus datos o resolver una pregunta particular utilizando el análisis de datos. Algunos ejemplos de concursos de análisis de datos internacionales conocidos son los siguientes:

- Competencia Kaggle, que es sostenida por Kaggle.

- Concurso de análisis de datos LTPP realizado por FHWA y ASCE.