Almacén de datos

En informática, un almacén de datos (DW o DWH), también conocido como almacén de datos empresarial (EDW), es un sistema que se utiliza para generar informes y analizar datos y se considera un componente central de la inteligencia empresarial. Los DW son repositorios centrales de datos integrados de una o más fuentes dispares. Almacenan datos actuales e históricos en un solo lugar que se utilizan para crear informes analíticos para los trabajadores de toda la empresa.

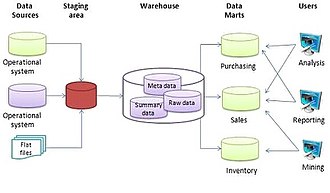

Los datos almacenados en el almacén se cargan desde los sistemas operativos (como marketing o ventas). Los datos pueden pasar a través de un almacén de datos operativos y pueden requerir una limpieza de datos para operaciones adicionales a fin de garantizar la calidad de los datos antes de que se utilicen en el DW para generar informes.

Extraer, transformar, cargar (ETL) y extraer, cargar, transformar (ELT) son los dos enfoques principales utilizados para crear un sistema de almacenamiento de datos.

Almacenamiento de datos basado en ETL

El almacén de datos típico basado en extracción, transformación y carga (ETL) utiliza capas de preparación, integración de datos y acceso para albergar sus funciones clave. La capa de ensayo o la base de datos de ensayo almacena datos sin procesar extraídos de cada uno de los sistemas de datos de origen dispares. La capa de integración integra los conjuntos de datos dispares mediante la transformación de los datos de la capa de ensayo, a menudo almacenando estos datos transformados en una base de datos de almacenamiento de datos operativos (ODS). Luego, los datos integrados se trasladan a otra base de datos, a menudo denominada base de datos de almacén de datos, donde los datos se organizan en grupos jerárquicos, a menudo denominados dimensiones, y en hechos y hechos agregados. La combinación de hechos y dimensiones a veces se denomina esquema en estrella. La capa de acceso ayuda a los usuarios a recuperar datos.

La principal fuente de datos se limpia, transforma, cataloga y pone a disposición de los gerentes y otros profesionales de negocios para la extracción de datos, el procesamiento analítico en línea, la investigación de mercado y el apoyo a la toma de decisiones. Sin embargo, los medios para recuperar y analizar datos, extraer, transformar y cargar datos y administrar el diccionario de datos también se consideran componentes esenciales de un sistema de almacenamiento de datos. Muchas referencias al almacenamiento de datos utilizan este contexto más amplio. Por lo tanto, una definición ampliada de almacenamiento de datos incluye herramientas de inteligencia comercial, herramientas para extraer, transformar y cargar datos en el repositorio y herramientas para administrar y recuperar metadatos.

Almacenamiento de datos basado en ELT

El almacenamiento de datos basado en ELT elimina una herramienta ETL independiente para la transformación de datos. En su lugar, mantiene un área de preparación dentro del propio almacén de datos. En este enfoque, los datos se extraen de sistemas de origen heterogéneos y luego se cargan directamente en el almacén de datos, antes de que ocurra cualquier transformación. Luego, todas las transformaciones necesarias se manejan dentro del propio almacén de datos. Finalmente, los datos manipulados se cargan en tablas de destino en el mismo almacén de datos.

Beneficios

Un almacén de datos mantiene una copia de la información de los sistemas de transacción de origen. Esta complejidad arquitectónica brinda la oportunidad de:

- Integrar datos de múltiples fuentes en una sola base de datos y un modelo de datos. Más congregación de datos en una base de datos única para que un motor de consulta único pueda ser utilizado para presentar datos en un SAO.

- Mitigate the problem of database isolation level lock contention in transactions processing systems caused by attempts to run large, long-running analysis consultas in transactions processing databases.

- Mantener el historial de datos, incluso si los sistemas de transacción de origen no lo hacen.

- Integrar datos de múltiples sistemas de fuentes, permitiendo una visión central en toda la empresa. Este beneficio siempre es valioso, pero sobre todo cuando la organización ha crecido por fusión.

- Mejorar la calidad de los datos, proporcionando códigos y descripciones consistentes, marcando o incluso fijando datos malos.

- Presente la información de la organización consistentemente.

- Proporcionar un único modelo de datos común para todos los datos de interés independientemente de la fuente de los datos.

- Reestructurar los datos para que tenga sentido para los usuarios de negocios.

- Reestructurar los datos para que ofrezca un excelente rendimiento de consulta, incluso para consultas analíticas complejas, sin afectar los sistemas operativos.

- Añada valor a las aplicaciones operativas de negocios, en particular los sistemas de gestión de relaciones con los clientes.

- Hacer consultas de apoyo a la decisión más fácil de escribir.

- Organizar y desambiguar datos repetitivos.

Genérico

El entorno para data warehouses y marts incluye lo siguiente:

- Sistemas de fuentes que proporcionan datos al almacén o al mart;

- Tecnología y procesos de integración de datos necesarios para preparar los datos para su utilización;

- Diferentes arquitecturas para almacenar datos en el almacén de datos de una organización o en las redes de datos;

- Herramientas y aplicaciones diferentes para una variedad de usuarios;

- Los procesos de metadatos, calidad de los datos y gobernanza deben estar en marcha para asegurar que el almacén o el mart cumpla sus propósitos.

Con respecto a los sistemas de origen enumerados anteriormente, R. Kelly Rainer afirma: "Una fuente común para los datos en los almacenes de datos son las bases de datos operativas de la empresa, que pueden ser bases de datos relacionales".

Con respecto a la integración de datos, Rainer afirma: "Es necesario extraer datos de los sistemas de origen, transformarlos y cargarlos en un data mart o almacén".

Rainer analiza el almacenamiento de datos en el almacén de datos o data marts de una organización.

Los metadatos son datos sobre datos. "El personal de TI necesita información sobre las fuentes de datos; nombres de bases de datos, tablas y columnas; actualizar horarios; y medidas de uso de datos".

Hoy en día, las empresas más exitosas son aquellas que pueden responder con rapidez y flexibilidad a los cambios y oportunidades del mercado. Una clave de esta respuesta es el uso eficaz y eficiente de los datos y la información por parte de analistas y gerentes. Un "almacén de datos" es un repositorio de datos históricos que es organizado por el sujeto para apoyar a los tomadores de decisiones en la organización. Una vez que los datos se almacenan en un data mart o almacén, se puede acceder a ellos.

Sistemas relacionados (data mart, OLAP, OLTP, análisis predictivo)

Un data mart es una forma simple de un almacén de datos que se centra en un solo tema (o área funcional), por lo que extraen datos de un número limitado de fuentes, como ventas, finanzas o marketing. Los data marts a menudo son creados y controlados por un solo departamento dentro de una organización. Las fuentes pueden ser sistemas operativos internos, un almacén de datos central o datos externos. La desnormalización es la norma para las técnicas de modelado de datos en este sistema. Dado que los data marts generalmente cubren solo un subconjunto de los datos contenidos en un almacén de datos, a menudo son más fáciles y rápidos de implementar.

| Attribute | Almacen de datos | Data mart |

|---|---|---|

| Alcance de los datos | a nivel institucional | de todo el Departamento |

| Número de esferas temáticas | múltiple | single |

| Cuán difícil de construir | difícil | fácil |

| Cuánto tiempo tarda en construir | más | menos |

| Cantidad de memoria | más grande | limitada |

Los tipos de data marts incluyen data marts dependientes, independientes e híbridos.

El procesamiento analítico en línea (OLAP) se caracteriza por un volumen relativamente bajo de transacciones. Las consultas suelen ser muy complejas e implican agregaciones. Para los sistemas OLAP, el tiempo de respuesta es una medida efectiva. Las aplicaciones OLAP son ampliamente utilizadas por las técnicas de Minería de Datos. Las bases de datos OLAP almacenan datos históricos agregados en esquemas multidimensionales (generalmente esquemas en estrella). Los sistemas OLAP suelen tener una latencia de datos de unas pocas horas, a diferencia de los data marts, donde se espera que la latencia sea más cercana a un día. El enfoque OLAP se utiliza para analizar datos multidimensionales de múltiples fuentes y perspectivas. Las tres operaciones básicas en OLAP son Roll-up (Consolidación), Drill-down y Slicing & Cortar en cubitos.

El procesamiento de transacciones en línea (OLTP) se caracteriza por una gran cantidad de transacciones en línea breves (INSERTAR, ACTUALIZAR, ELIMINAR). Los sistemas OLTP enfatizan el procesamiento de consultas muy rápido y el mantenimiento de la integridad de los datos en entornos de acceso múltiple. Para los sistemas OLTP, la eficacia se mide por el número de transacciones por segundo. Las bases de datos OLTP contienen datos detallados y actualizados. El esquema utilizado para almacenar bases de datos transaccionales es el modelo de entidad (generalmente 3NF). La normalización es la norma para las técnicas de modelado de datos en este sistema.

El análisis predictivo consiste en encontrar y cuantificar patrones ocultos en los datos mediante modelos matemáticos complejos que se pueden usar para predecir resultados futuros. El análisis predictivo se diferencia de OLAP en que OLAP se centra en el análisis de datos históricos y es de naturaleza reactiva, mientras que el análisis predictivo se centra en el futuro. Estos sistemas también se utilizan para la gestión de relaciones con los clientes (CRM).

Historia

El concepto de almacenamiento de datos se remonta a finales de la década de 1980, cuando los investigadores de IBM, Barry Devlin y Paul Murphy, desarrollaron el "almacén de datos empresariales". En esencia, el concepto de almacenamiento de datos pretendía proporcionar un modelo arquitectónico para el flujo de datos desde los sistemas operativos hasta los entornos de soporte de decisiones. El concepto intentó abordar los diversos problemas asociados con este flujo, principalmente los altos costos asociados con él. En ausencia de una arquitectura de almacenamiento de datos, se requería una enorme cantidad de redundancia para soportar múltiples entornos de soporte de decisiones. En las corporaciones más grandes, era típico que los entornos de soporte de múltiples decisiones operaran de manera independiente. Aunque cada entorno servía a diferentes usuarios, a menudo requerían gran parte de los mismos datos almacenados. El proceso de recopilación, limpieza e integración de datos de varias fuentes, generalmente de sistemas operativos existentes a largo plazo (generalmente denominados sistemas heredados), generalmente se replicó en parte para cada entorno. Además, los sistemas operativos se reexaminaban con frecuencia a medida que surgían nuevos requisitos de apoyo a las decisiones. A menudo, los nuevos requisitos requerían recopilar, limpiar e integrar nuevos datos de "data marts" que se adaptó para el fácil acceso de los usuarios.

Además, con la publicación de The IRM Imperative (Wiley & Sons, 1991) de James M. Kerr, la idea de administrar y poner un valor en dólares a los recursos de datos de una organización y luego informar ese valor como un activo en una hoja de balance se hizo popular. En el libro, Kerr describió una forma de poblar bases de datos de áreas temáticas a partir de datos derivados de sistemas basados en transacciones para crear un área de almacenamiento donde los datos de resumen podrían aprovecharse aún más para informar la toma de decisiones ejecutiva. Este concepto sirvió para promover una mayor reflexión sobre cómo se podría desarrollar y administrar un almacén de datos de manera práctica dentro de cualquier empresa.

Desarrollos clave en los primeros años del almacenamiento de datos:

- 1960s – General Mills y Dartmouth College, en un proyecto conjunto de investigación, desarrollar los términos dimensiones y hechos.

- 1970s – ACNielsen e IRI proporcionan marts de datos dimensionales para ventas minoristas.

- 1970s – Bill Inmon comienza a definir y discutir el término Data Warehouse.

- 1975 – Sperry Univac introduce MAPPER (MAintain, Prepare y Produce Informes Ejecutivos), un sistema de gestión y reportaje de bases de datos que incluye el primer 4GL del mundo. Es la primera plataforma diseñada para construir Centros de Información (un precursor de la tecnología de almacén de datos contemporáneo).

- 1983 – Teradata introduce el ordenador de base de datos DBC/1012 diseñado específicamente para el soporte de decisiones.

- 1984 – Metaphor Computer Systems, fundada por David Liddle y Don Massaro, lanza un paquete hardware/software y GUI para que los usuarios de negocios creen un sistema analítico y de gestión de bases de datos.

- 1988 – Barry Devlin y Paul Murphy publican el artículo "Una arquitectura para un sistema de negocios e información" donde introducen el término "almacén de datos de negocios".

- 1990 – Red Brick Systems, fundada por Ralph Kimball, introduce Red Brick Warehouse, un sistema de gestión de bases de datos específicamente para almacenamiento de datos.

- 1991 - Autores de James M. Kerr The IRM Imperative, which suggest data resources could be reported as an asset on a balance sheet, furthering commercial interest in the establishment of data warehouses.

- 1991 – Prism Solutions, fundada por Bill Inmon, introduce Prism Warehouse Manager, software para desarrollar un almacén de datos.

- 1992 – Bill Inmon publica el libro Construcción del almacén de datos.

- 1995 – El almacenamiento de datos Se funda el Instituto, organización sin ánimo de lucro que promueve el almacenamiento de datos.

- 1996 – Ralph Kimball publica el libro The Data Warehouse Toolkit.

- 2000 – Dan Linstedt libera en el dominio público el modelado de bóveda de datos, concebido en 1990 como una alternativa a Inmon y Kimball para proporcionar almacenamiento histórico a largo plazo de datos procedentes de múltiples sistemas operativos, con énfasis en el rastreo, la auditoría y la resiliencia para cambiar el modelo de datos fuente.

- 2008 – Bill Inmon, junto con Derek Strauss y Genia Neushloss, publica "DW 2.0: The Architecture for the Next Generation of Data Warehousing", explicando su enfoque de arriba hacia abajo en el almacenamiento de datos y acuñando el término, data-warehousing 2.0.

- 2012 – Bill Inmon desarrolla y hace conocida la tecnología pública como "desambiguación textual". La desambiguación textual aplica contexto a texto bruto y reforma el texto crudo y el contexto en un formato base de datos estándar. Una vez que el texto crudo se transmite a través de la desambiguación textual, puede acceder y analizarse de forma fácil y eficiente por la tecnología estándar de inteligencia empresarial. La desambiguación textual se realiza mediante la ejecución de ETL textual. La desambiguación textual es útil donde se encuentra el texto crudo, como en documentos, Hadoop, correo electrónico, etc.

Almacenamiento de información

Hechos

Un hecho es un valor, o medida, que representa un hecho sobre la entidad o el sistema administrado.

Se dice que los hechos, tal como los informa la entidad que informa, están en un nivel bruto; Por ejemplo, en un sistema de telefonía móvil, si una BTS (estación transceptora base) recibe 1000 solicitudes de asignación de canales de tráfico, asigna 820 y rechaza el resto, informaría tres hechos o mediciones a un administrador. sistema:

tch_req_total = 1000tch_req_success = 820tch_req_fail = 180

Los hechos en el nivel sin procesar se agregan a niveles más altos en varias dimensiones para extraer de ellos más información relevante para el servicio o el negocio. Estos se denominan agregados o resúmenes o hechos agregados.

Por ejemplo, si hay tres BTS en una ciudad, los datos anteriores se pueden agregar desde el BTS hasta el nivel de la ciudad en la dimensión de la red. Por ejemplo:

tch_req_success_city = tch_req_success_bts1 + tch_req_success_bts2 + tch_req_success_bts3avg_tch_req_success_city = (tch_req_success_bts1 + tch_req_success_bts2 + tch_req_success_bts3) / 3

Enfoque dimensional versus normalizado para el almacenamiento de datos

Existen tres o más enfoques principales para almacenar datos en un almacén de datos; los enfoques más importantes son el enfoque dimensional y el enfoque normalizado.

El enfoque dimensional se refiere al enfoque de Ralph Kimball en el que se establece que el almacén de datos debe modelarse mediante un modelo dimensional/esquema en estrella. El enfoque normalizado, también llamado modelo 3NF (Tercera Forma Normal), se refiere al enfoque de Bill Inmon en el que se establece que el almacén de datos debe modelarse utilizando un modelo E-R/modelo normalizado.

Enfoque dimensional

En un enfoque dimensional, los datos de transacciones se dividen en "hechos", que generalmente son datos numéricos de transacciones, y "dimensiones", que son la información de referencia que brinda contexto a los hechos.. Por ejemplo, una transacción de venta se puede dividir en datos como el número de productos pedidos y el precio total pagado por los productos, y en dimensiones como la fecha del pedido, el nombre del cliente, el número del producto, el destino del pedido y el destino de la factura. ubicaciones y vendedor responsable de recibir el pedido.

Una ventaja clave de un enfoque dimensional es que el almacén de datos es más fácil de entender y usar para el usuario. Además, la recuperación de datos del almacén de datos tiende a funcionar muy rápidamente. Las estructuras dimensionales son fáciles de entender para los usuarios comerciales, porque la estructura se divide en medidas/hechos y contexto/dimensiones. Los hechos están relacionados con los procesos comerciales y el sistema operativo de la organización, mientras que las dimensiones que los rodean contienen un contexto sobre la medición (Kimball, Ralph 2008). Otra ventaja que ofrece el modelo dimensional es que no involucra una base de datos relacional cada vez. Por lo tanto, este tipo de técnica de modelado es muy útil para las consultas de los usuarios finales en el almacén de datos.

El modelo de hechos y dimensiones también puede entenderse como un cubo de datos. Donde las dimensiones son las coordenadas categóricas en un cubo multidimensional, el hecho es un valor correspondiente a las coordenadas.

Las principales desventajas del enfoque dimensional son las siguientes:

- Para mantener la integridad de los hechos y dimensiones, es complicado cargar el almacén de datos con datos de diferentes sistemas operativos.

- Es difícil modificar la estructura del almacén de datos si la organización que adopta el enfoque dimensional cambia la forma en que hace negocios.

Enfoque normalizado

En el enfoque normalizado, los datos en el almacén de datos se almacenan siguiendo, hasta cierto punto, las reglas de normalización de la base de datos. Las tablas se agrupan por áreas temáticas que reflejan categorías de datos generales (por ejemplo, datos sobre clientes, productos, finanzas, etc.). La estructura normalizada divide los datos en entidades, lo que crea varias tablas en una base de datos relacional. Cuando se aplica en grandes empresas, el resultado son docenas de tablas que están unidas por una red de uniones. Además, cada una de las entidades creadas se convierte en tablas físicas separadas cuando se implementa la base de datos (Kimball, Ralph 2008). La principal ventaja de este enfoque es que es sencillo agregar información a la base de datos. Algunas desventajas de este enfoque son que, debido a la cantidad de tablas involucradas, puede ser difícil para los usuarios unir datos de diferentes fuentes en información significativa y acceder a la información sin una comprensión precisa de las fuentes de datos y de la estructura de datos. del almacén de datos.

Tanto los modelos normalizados como los dimensionales se pueden representar en diagramas de entidad-relación, ya que ambos contienen tablas relacionales unidas. La diferencia entre los dos modelos es el grado de normalización (también conocido como Formas Normales). Estos enfoques no son mutuamente excluyentes y existen otros enfoques. Los enfoques dimensionales pueden implicar la normalización de los datos hasta cierto punto (Kimball, Ralph 2008).

En Information-Driven Business, Robert Hillard propone un enfoque para comparar los dos enfoques en función de las necesidades de información del problema empresarial. La técnica muestra que los modelos normalizados contienen mucha más información que sus equivalentes dimensionales (incluso cuando se usan los mismos campos en ambos modelos), pero esta información adicional tiene un costo de usabilidad. La técnica mide la cantidad de información en términos de entropía de información y usabilidad en términos de la medida de transformación de datos de Small Worlds.

Métodos de diseño

Diseño de abajo hacia arriba

En el enfoque ascendente, los data marts se crean primero para proporcionar capacidades analíticas y de generación de informes para procesos comerciales específicos. Estos data marts se pueden integrar para crear un almacén de datos completo. La arquitectura de bus de almacenamiento de datos es principalmente una implementación de 'el bus', una colección de dimensiones compatibles y hechos compatibles, que son dimensiones que se comparten (de una manera específica) entre hechos en dos o más data marts.

Diseño de arriba hacia abajo

El enfoque descendente está diseñado utilizando un modelo de datos empresariales normalizados. "Atómica" Los datos, es decir, los datos con el mayor nivel de detalle, se almacenan en el almacén de datos. Los data marts dimensionales que contienen los datos necesarios para procesos comerciales específicos o departamentos específicos se crean a partir del almacén de datos.

Diseño híbrido

Los almacenes de datos (DW) a menudo se asemejan a la arquitectura central y radial. Los sistemas heredados que alimentan el almacén a menudo incluyen la gestión de relaciones con los clientes y la planificación de recursos empresariales, lo que genera grandes cantidades de datos. Para consolidar estos diversos modelos de datos y facilitar el proceso de extracción, transformación y carga, los almacenes de datos a menudo utilizan un almacén de datos operativos, cuya información se analiza en el DW real. Para reducir la redundancia de datos, los sistemas más grandes suelen almacenar los datos de forma normalizada. Los data marts para informes específicos se pueden construir sobre el almacén de datos.

Una base de datos DW híbrida se mantiene en la tercera forma normal para eliminar la redundancia de datos. Sin embargo, una base de datos relacional normal no es eficiente para los informes de inteligencia comercial donde prevalece el modelado dimensional. Los pequeños data marts pueden comprar datos del almacén consolidado y utilizar los datos específicos filtrados para las tablas de hechos y las dimensiones requeridas. El DW proporciona una única fuente de información de la que pueden leer los data marts, proporcionando una amplia gama de información empresarial. La arquitectura híbrida permite reemplazar un DW con un repositorio de administración de datos maestros donde podría residir información operativa (no estática).

Los componentes de modelado de la bóveda de datos siguen una arquitectura central y radial. Este estilo de modelado es un diseño híbrido, que consta de las mejores prácticas tanto de la tercera forma normal como del esquema en estrella. El modelo de bóveda de datos no es una verdadera tercera forma normal y rompe algunas de sus reglas, pero es una arquitectura de arriba hacia abajo con un diseño de abajo hacia arriba. El modelo de bóveda de datos está diseñado para ser estrictamente un almacén de datos. No está diseñado para que sea accesible para el usuario final, lo que, una vez construido, aún requiere el uso de un data mart o un área de lanzamiento basada en un esquema en estrella para fines comerciales.

Características del almacén de datos

Existen funciones básicas que definen los datos en el almacén de datos, que incluyen la orientación por temas, la integración de datos, la variación temporal, los datos no volátiles y la granularidad de los datos.

Orientada a temas

(feminine)A diferencia de los sistemas operativos, los datos en el almacén de datos giran en torno a los temas de la empresa. La orientación del sujeto no es la normalización de la base de datos. La orientación temática puede ser realmente útil para la toma de decisiones. Recolectar los objetos requeridos se llama orientado al sujeto.

Integrado

Los datos que se encuentran dentro del almacén de datos están integrados. Dado que proviene de varios sistemas operativos, se deben eliminar todas las inconsistencias. Las consistencias incluyen convenciones de nomenclatura, medición de variables, estructuras de codificación, atributos físicos de los datos, etc.

Variante de tiempo

Si bien los sistemas operativos reflejan los valores actuales a medida que respaldan las operaciones diarias, los datos del almacén de datos representan un horizonte de tiempo prolongado (hasta 10 años), lo que significa que almacena principalmente datos históricos. Está destinado principalmente a la extracción de datos y la previsión. (Por ejemplo, si un usuario está buscando un patrón de compra de un cliente específico, el usuario necesita ver los datos de las compras actuales y pasadas).

No volátil

Los datos del almacén de datos son de solo lectura, lo que significa que no se pueden actualizar, crear ni eliminar (a menos que exista una obligación reglamentaria o legal para hacerlo).

Opciones de almacenamiento de datos

Agregación

En el proceso de almacenamiento de datos, los datos se pueden agregar en data marts en diferentes niveles de abstracción. El usuario puede comenzar a mirar las unidades de venta totales de un producto en toda una región. Luego, el usuario mira los estados en esa región. Finalmente, pueden examinar las tiendas individuales en un estado determinado. Por lo tanto, por lo general, el análisis comienza en un nivel superior y profundiza en niveles inferiores de detalles.

Virtualización

Con la virtualización de datos, los datos utilizados permanecen en sus ubicaciones originales y se establece el acceso en tiempo real para permitir el análisis a través de múltiples fuentes creando un almacén de datos virtual. Esto puede ayudar a resolver algunas dificultades técnicas, como problemas de compatibilidad al combinar datos de varias plataformas, reducir el riesgo de error causado por datos defectuosos y garantizar que se utilicen los datos más recientes. Además, evitar la creación de una nueva base de datos que contenga información personal puede facilitar el cumplimiento de las normas de privacidad. Sin embargo, con la virtualización de datos, la conexión a todas las fuentes de datos necesarias debe estar operativa ya que no hay una copia local de los datos, lo cual es uno de los principales inconvenientes del enfoque.

Arquitectura de almacén de datos

Los diferentes métodos utilizados para construir/organizar un almacén de datos especificado por una organización son numerosos. El hardware utilizado, el software creado y los recursos de datos específicamente requeridos para la correcta funcionalidad de un almacén de datos son los componentes principales de la arquitectura del almacén de datos. Todos los almacenes de datos tienen múltiples fases en las que se modifican y ajustan los requisitos de la organización.

En comparación con el sistema operativo

Los sistemas operativos están optimizados para la preservación de la integridad de los datos y la velocidad de registro de las transacciones comerciales mediante el uso de la normalización de la base de datos y un modelo de entidad-relación. Los diseñadores de sistemas operativos generalmente siguen las 12 reglas de normalización de bases de datos de Codd para garantizar la integridad de los datos. Los diseños de bases de datos completamente normalizados (es decir, aquellos que satisfacen todas las reglas de Codd) a menudo dan como resultado que la información de una transacción comercial se almacene en docenas o cientos de tablas. Las bases de datos relacionales son eficientes en la gestión de las relaciones entre estas tablas. Las bases de datos tienen un rendimiento de inserción/actualización muy rápido porque solo una pequeña cantidad de datos en esas tablas se ve afectada cada vez que se procesa una transacción. Para mejorar el rendimiento, los datos más antiguos generalmente se eliminan periódicamente de los sistemas operativos.

Los almacenes de datos están optimizados para patrones de acceso analítico. Los patrones de acceso analítico generalmente implican la selección de campos específicos y rara vez select *, que selecciona todos los campos/columnas, como es más común en las bases de datos operativas. Debido a estas diferencias en los patrones de acceso, las bases de datos operativas (en general, OLTP) se benefician del uso de un DBMS orientado a filas, mientras que las bases de datos analíticas (en general, OLAP) se benefician del uso de un DBMS orientado en columnas. A diferencia de los sistemas operativos que mantienen una instantánea del negocio, los almacenes de datos generalmente mantienen un historial infinito que se implementa a través de procesos ETL que periódicamente migran datos de los sistemas operativos al almacén de datos.

Evolución en el uso de la organización

Estos términos se refieren al nivel de sofisticación de un almacén de datos:

- Almacen de datos operacionales

- Los almacenes de datos en esta etapa de evolución se actualizan en un ciclo de tiempo ordinario (generalmente diario, semanal o mensual) de los sistemas operativos y los datos se almacenan en una base de datos integrada orientada a la presentación de informes.

- Almacén de datos

- Los almacenes de datos en esta etapa se actualizan periódicamente de los datos de los sistemas operativos y los datos de los almacenes de datos se almacenan en una estructura de datos diseñada para facilitar la presentación de informes.

- Almacen de datos a tiempo

- Online Integrada Datos El almacenamiento representa los datos en tiempo real de los almacenes de datos en el almacén se actualiza para cada transacción realizada en los datos de origen

- Almacén integrado de datos

- Estos almacenes de datos reúnen datos de diferentes áreas de negocio, por lo que los usuarios pueden buscar la información que necesitan en otros sistemas.

Contenido relacionado

Código n-ario

Programa de supervisión

Programación de culto de carga