Distribuição normal

Em estatística, uma distribuição normal ou distribuição Gaussiana é um tipo de distribuição de probabilidade contínua para uma variável aleatória de valor real. A forma geral de sua função de densidade de probabilidade é

- f(x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1σ σ 2D D e- Sim. - Sim. 12(x- Sim. - Sim. μ μ σ σ )2{displaystyle f(x)={frac {1}{sigma {2pi }}e^{-{frac {1}{2}}left({frac {x-mu }{sigma }}right)^{2}}}

O parâmetro μ μ - Sim. é a média ou expectativa da distribuição (e também sua mediana e modo), enquanto o parâmetro σ σ - Sim. é seu desvio padrão. A variância da distribuição é σ σ 2{displaystyle sigma ^{2}}. Diz-se que uma variável aleatória com distribuição gaussiana normalmente distribuídoe é chamado de desvio normal.

As distribuições normais são importantes em estatística e são freqüentemente usadas nas ciências naturais e sociais para representar variáveis aleatórias de valor real cujas distribuições não são conhecidas. Sua importância se deve em parte ao teorema do limite central. Ele afirma que, sob algumas condições, a média de muitas amostras (observações) de uma variável aleatória com média e variância finitas é ela própria uma variável aleatória - cuja distribuição converge para uma distribuição normal à medida que o número de amostras aumenta. Portanto, as quantidades físicas que se espera serem a soma de muitos processos independentes, como erros de medição, geralmente têm distribuições quase normais.

Além disso, as distribuições gaussianas têm algumas propriedades únicas que são valiosas em estudos analíticos. Por exemplo, qualquer combinação linear de uma coleção fixa de desvios normais é um desvio normal. Muitos resultados e métodos, como propagação de incerteza e ajuste de parâmetros de mínimos quadrados, podem ser derivados analiticamente de forma explícita quando as variáveis relevantes são normalmente distribuídas.

Às vezes, uma distribuição normal é informalmente chamada de curva de sino. No entanto, muitas outras distribuições são em forma de sino (como Cauchy, t de Student e distribuições logísticas). Para outros nomes, consulte Nomenclatura.

A distribuição de probabilidade univariada é generalizada para vetores na distribuição normal multivariada e para matrizes na distribuição normal de matriz.

Definições

Distribuição normal padrão

O caso mais simples de uma distribuição normal é conhecido como o distribuição normal padrão ou distribuição normal da unidade. Este é um caso especial quando μ μ = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =0{displaystyle mu =0} e σ σ = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1{displaystyle sigma} - Sim., e é descrito por esta função de densidade de probabilidade (ou densidade):

- φ φ (zangão.)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =e- Sim. - Sim. zangão.2/22D D {displaystyle varphi (z)={frac {e^{-z^{2}/2}}{sqrt {2pi }}}}

A variável zangão.Não. tem uma média de 0 e uma variância e desvio padrão de 1. A densidade φ φ (zangão.){displaystyle varphi (z)} tem seu pico 1/2D D {displaystyle 1/{sqrt {2pi }}} em zangão.= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =0- Sim. e pontos de inflexão zangão.= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =+1- Sim. e zangão.= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. 1Não. - Sim..

Embora a densidade acima seja mais comumente conhecida como normal padrão, alguns autores usaram esse termo para descrever outras versões da distribuição normal. Carl Friedrich Gauss, por exemplo, uma vez definiu a normal padrão como

- φ φ (zangão.)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =e- Sim. - Sim. zangão.2D D {displaystyle varphi (z)={frac {e^{-z^{2}}}{sqrt {pi Sim.

que tem uma variação de 1/2, e Stephen Stigler uma vez definiu o padrão normal como

- φ φ (zangão.)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =e- Sim. - Sim. D D zangão.2{displaystyle varphi (z)=e^{-pi z^{2}}}

que tem uma forma funcional simples e uma variância σ σ 2= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1/(2D D ){displaystyle sigma ^{2}=1/(2pi)}

Distribuição normal geral

Cada distribuição normal é uma versão da distribuição normal padrão, cujo domínio foi esticado por um fator σ σ - Sim. (o desvio padrão) e depois traduzido por μ μ - Sim. (o valor médio):

- f(x∣ ∣ μ μ ,σ σ 2)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1σ σ φ φ (x- Sim. - Sim. μ μ σ σ ){displaystyle f(xmid musigma ^{2})={frac {1}{sigma }}varphi left({frac {x-mu }{sigma }}right)}

A densidade de probabilidade deve ser dimensionada 1/σ σ - Não. para que a integral ainda seja 1.

Se Z.Não. é um desvio normal padrão, então X= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =σ σ Z.+μ μ Não. X=sigma Z+mu } terá uma distribuição normal com o valor esperado μ μ - Sim. e desvio padrão σ σ - Sim.. Isto equivale a dizer que a distribuição normal "padrão" Z.Não. pode ser dimensionado/forçado por um fator de σ σ - Sim. e deslocado por μ μ - Sim. para produzir uma distribuição normal diferente, chamada X- Sim.. Por outro lado, se X- Sim. é um desvio normal com parâmetros μ μ - Sim. e σ σ 2{displaystyle sigma ^{2}}Então isto X- Sim. a distribuição pode ser redimensionada e deslocada através da fórmula Z.= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =(X- Sim. - Sim. μ μ )/σ σ {displaystyle Z=(X-mu)/sigma } converter para a distribuição normal "padrão". Este varite também é chamado de forma padronizada de X- Sim..

Notação

A densidade de probabilidade da distribuição Gaussiana padrão (distribuição normal padrão, com variância média zero e unidade) é frequentemente denotada com a letra grega φ φ - Sim. (phi). A forma alternativa da letra grega phi, φ φ - Sim., também é usado bastante frequentemente.

A distribuição normal é frequentemente referida como N(μ μ ,σ σ 2){displaystyle N(musigma ^{2})} ou N(μ μ ,σ σ 2){displaystyle {mathcal {N}}(musigma ^{2})}. Assim, quando uma variável aleatória X- Sim. é normalmente distribuído com média μ μ - Sim. e desvio padrão σ σ - Sim., um pode escrever

- X∼ ∼ N(μ μ ,σ σ 2).Não. Xsim {mathcal {N}}(musigma ^{2}). ?

Parametrizações alternativas

Alguns autores defendem a precisão ? ? - Sim. como o parâmetro que define a largura da distribuição, em vez do desvio σ σ - Sim. ou a variância σ σ 2{displaystyle sigma ^{2}}. A precisão é normalmente definida como o recíproco da variância, 1/σ σ 2{displaystyle 1/sigma ^{2}}. A fórmula para a distribuição torna-se então

- f(x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =? ? 2D D e- Sim. - Sim. ? ? (x- Sim. - Sim. μ μ )2/2.(x)={sqrt {frac {tau }{2pi }}}e^{-tau (x-mu)^{2}/2}.}

Esta escolha é reivindicada ter vantagens em computação numérica quando σ σ - Sim. é muito próximo de zero, e simplifica fórmulas em alguns contextos, como na inferência bayesiana de variáveis com distribuição normal multivariada.

Alternativamente, o reciprocal do desvio padrão ? ? ? ? = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1/σ σ (em inglês) ? pode ser definido como precisão, em que caso a expressão da distribuição normal se torna

- f(x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =? ? ? ? 2D D e- Sim. - Sim. (? ? ? ? )2(x- Sim. - Sim. μ μ )2/2.{displaystyle f(x)={frac {tau ^{prime }}{sqrt {2pi }}}e^{-(tau ^{prime })^{2}(x-mu)^{2}/2}.}

De acordo com Stigler, esta formulação é vantajosa por causa de uma fórmula muito mais simples e fácil de lembrar, e fórmulas aproximadas simples para os quantis da distribuição.

As distribuições normais formam uma família exponencial com parâmetros naturais θ θ 1= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =μ μ σ σ 2{displaystyle textstyle theta _{1}={frac {mu }{sigma ^{2}}}} e θ θ 2= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. 12σ σ 2{displaystyle textstyle theta _{2}={frac {-1}{2sigma ^{2}}}}, e estatísticas naturais x e x2. Os parâmetros de dupla expectativa para distribuição normal são ?1 = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = μ e ?2 = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = μ2 + σ2.

Funções de distribuição cumulativas

A função de distribuição cumulativa (CDF) da distribuição normal padrão, geralmente denotada com a letra grega capital Φ Φ Não. Não. (phi), é a integral

- Φ Φ (x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =12D D ∫ ∫ - Sim. - Sim. ∞ ∞ xe- Sim. - Sim. )2/2D){displaystyle Phi (x)={frac {1}{sqrt {2pi }}}int _{-infty }^{x}e^{-t^{2}/2},dt}

A função de erro relacionada E (x)(x)} dá a probabilidade de uma variável aleatória, com distribuição normal de média 0 e variância 1/2 caindo no intervalo Não.- Sim. - Sim. x,x][displaystyle [-x,x]}. Isso é:

- E (x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =2D D ∫ ∫ 0xe- Sim. - Sim. )2D){displaystyle operatorname {erf} (x)={frac {2}{sqrt {pi }}}int _{0}^{x}e^{-t^{2}},dt}

Essas integrais não podem ser expressas em termos de funções elementares, e muitas vezes são chamadas de funções especiais. No entanto, muitas aproximações numéricas são conhecidas; veja abaixo para mais.

As duas funções estão intimamente relacionadas, ou seja,

- Φ Φ (x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =12Não.1+E (x2)]Não. Phi (x)={frac {1}{2}}left[1+operatorname {erf} left({frac {x}{sqrt {2}}}right)right]}

Para uma distribuição normal genérica com densidade fNão.Quero dizer... μ μ - Sim. e desvio σ σ - Sim., a função de distribuição cumulativa é

- F(x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =Φ Φ (x- Sim. - Sim. μ μ σ σ )= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =12Não.1+E (x- Sim. - Sim. μ μ σ σ 2)]{displaystyle F(x)=Phi left({frac {x-mu) }{sigma }}right)={frac {1}{2}}left[1+operatorname {erf} left({frac {x-mu }{sigma {sqrt {2}}}}right]}

O complemento do CDF normal padrão, Q(x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1- Sim. - Sim. Φ Φ (x)(x)=1-Phi (x)}, é frequentemente chamado de Q-função, especialmente em textos de engenharia. Dá a probabilidade de que o valor de uma variável aleatória normal padrão X- Sim. exceda xNão.: x)}" xmlns="http://www.w3.org/1998/Math/MathML">P(X>x)(X>x)}x)}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/767fd276524cfb3556093722a4f40a9209194ea5" style="vertical-align: -0.838ex; width:9.963ex; height:2.843ex;"/>. Outras definições das QNão.-função, todas elas são transformações simples de Φ Φ Não. Não., também são usados ocasionalmente.

O gráfico do CDF normal padrão Φ Φ Não. Não. tem 2 vezes simetria rotacional em torno do ponto (0,1/2); isto é, Φ Φ (- Sim. - Sim. x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1- Sim. - Sim. Φ Φ (x)Não. Phi (-x)=1-Phi (x)}. Seu antiderivativo (indefinido integral) pode ser expresso da seguinte forma:

- ∫ ∫ Φ Φ (x)Dx= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =xΦ Φ (x)+φ φ (x)+C.{displaystyle int Phi (x),dx=xPhi (x)+varphi (x)+C.}

O CDF da distribuição normal padrão pode ser expandido por Integração por partes em uma série:

- Φ Φ (x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =12+12D D )) e- Sim. - Sim. x2/2Não.x+x33+x53)) 5+⋯ ⋯ +x2n+1(2n+1)!!+⋯ ⋯ ]Não. Phi (x)={frac {1}{2}}+{frac {1}{sqrt {2pi }}}cdot e^{-x^{2}/2}left[x+{frac {x^{3}}{3}}+{frac {x^{5}}{3cdot 5}}+cdots +{frac {x^{2n+1}}{(2n+1)!}}+cdots right]}

Onde? !!! denota o factorial duplo.

Uma expansão assintótica do CDF para x grande também pode ser derivada usando a integração por partes. Para saber mais, consulte Função de erro#Expansão assintótica.

Uma aproximação rápida para o CDF da distribuição normal padrão pode ser encontrada usando uma aproximação da série de Taylor:

Φ Φ (x)? ? 12+12D D Gerenciamento Gerenciamento k= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =0n(- Sim. - Sim. 1)kx(2k+1)2kk!(2k+1)Não. Phi (x)approx {frac {1}{2}+{frac {1}{sqrt {2pi }}}sum _{k=0}^{n}{frac {left(-1right)^{k}x^{left(2k+1right)}}{2^{k}k!left(2k+1right)}}}

Cálculo recursivo com expansão Taylor Series

A natureza recursiva da eumx2{displaystyle e^{ax^{2}}}família de derivados pode ser usado para construir facilmente uma expansão da série Taylor rapidamente convergente usando entradas recursivas sobre qualquer ponto do valor conhecido da distribuição,Φ Φ (x0)(x_{0})}:

Φ Φ (x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =Gerenciamento Gerenciamento n= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =0∞ ∞ Φ Φ (n)(x0)n!(x- Sim. - Sim. x0)nNão. Phi (x)=sum _{n=0}^{infty }{frac {Phi ^{(n)}(x_{0})}{n!}}(x-x_{0})^{n}}

Onde:

Φ Φ (0)(x0)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =12D D ∫ ∫ - Sim. - Sim. ∞ ∞ x0e- Sim. - Sim. )2/2D)(x_{0})={frac {1}{sqrt {2pi }}}int _{-infty }^{x_{0}}e^{-t^{2}/2},dt}

Φ Φ (1)(x0)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =12D D e- Sim. - Sim. x02/2{displaystyle Phi ^{(1)}(x_{0})={frac {1}{sqrt {2pi }}}e^{-x_{0}^{2}/2}}

Φ Φ (n)(x0)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. (x0Φ Φ (n- Sim. - Sim. 1)(x0)+(n- Sim. - Sim. 2)Φ Φ (n- Sim. - Sim. 2)(x0)){displaystyle Phi ^{(n)}(x_{0})=-(x_{0}Phi ^{(n-1)}(x_{0})+(n-2)Phi ^{(n-2)}(x_{0})})}, para todos n ≥ 2.

Usando a série de Taylor e o método de Newton para a função inversa

Uma aplicação para a expansão da série Taylor acima é usar o método de Newton para reverter a computação. Ou seja, se tivermos um valor para o CDF, Φ Φ (x)(x)}, mas não sabe o x necessário para obter o Φ Φ (x)(x)}, podemos usar o método de Newton para encontrar x, e usar a expansão da série Taylor acima para minimizar o número de cálculos. O método de Newton é ideal para resolver este problema porque o primeiro derivado de Φ Φ (x)(x)}, que é uma parte integrante da distribuição normal padrão, é a distribuição padrão normal, e está prontamente disponível para usar na solução de método de Newton.

Para resolver, selecione uma solução aproximada conhecida, x0{displaystyle x_{0}}, ao desejado Φ Φ (x)(x)}. x0{displaystyle x_{0}} pode ser um valor de uma tabela de distribuição, ou uma estimativa inteligente seguida por uma computação Φ Φ (x0)(x_{0})} usando qualquer meio desejado para calcular. Use este valor de x0{displaystyle x_{0}} e a expansão da série Taylor acima para minimizar as computações.

Repita o seguinte processo até a diferença entre o computadorizado Φ Φ (xn)(x_{n})} e o desejado Φ Φ Não. Não.O que vamos chamar Φ Φ (DeSEu...ReD)Não. Phi (mathrm {Desired})}, está abaixo de um erro aceitável pequeno escolhido, como 1.e-05, 1.e-15, etc:

Onde

Φ Φ (x,x0,Φ Φ (x0))Não. Phi (x,x_{0},Phi (x_{0})})} é o Φ Φ (x)(x)} de uma solução de série Taylor usando x0{displaystyle x_{0}} e Φ Φ (x0)(x_{0})}

Φ Φ ?(x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =12D D e- Sim. - Sim. x2/2Não. Phi '(x)={frac {1}{sqrt {2pi }}}e^{-x^{2}/2}}

Quando as computações repetidas convergem para um erro abaixo do valor aceitavelmente pequeno escolhido, x será o valor necessário para obter um Φ Φ (x)(x)} do valor desejado, Φ Φ (DeSEu...ReD)Não. Phi (mathrm {Desired})}. Se x0{displaystyle x_{0}} é uma boa estimativa inicial, a convergência deve ser rápida com apenas um pequeno número de iterações necessárias.

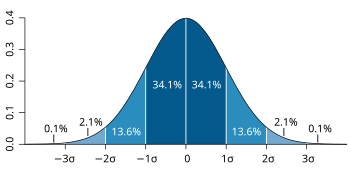

Desvio padrão e cobertura

Cerca de 68% dos valores extraídos de uma distribuição normal estão dentro de um desvio padrão σ da média; cerca de 95% dos valores estão dentro de dois desvios padrão; e cerca de 99,7% estão dentro de três desvios padrão. Esse fato é conhecido como regra 68-95-99,7 (empírica) ou regra dos 3 sigmas.

Mais precisamente, a probabilidade de um desvio normal estar no intervalo entre μ μ - Sim. - Sim. nσ σ - Sim. e μ μ +nσ σ {displaystyle mu +nsigma } é dado por

- F(μ μ +nσ σ )- Sim. - Sim. F(μ μ - Sim. - Sim. nσ σ )= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =Φ Φ (n)- Sim. - Sim. Φ Φ (- Sim. - Sim. n)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =E (n2).{displaystyle F(mu +nsigma)-F(mu -nsigma)=Phi (n)-Phi (-n)=operatorname {erf} left({frac {n}{sqrt {2}}}right). ?

Para 12 dígitos significativos, os valores para n= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1,2,...... ,6- Não. são:

| nNão. | p= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =F(μ μ +nσ σ )- Sim. - Sim. F(μ μ - Sim. - Sim. nσ σ ){displaystyle p=F(mu +nsigma)-F(mu -nsigma)} | Ou seja.1- Sim. - Sim. pNão. }}1-p | ou1emp{displaystyle {text{or }}1{text{in }}p} | OEIS | ||

|---|---|---|---|---|---|---|

| 1 | 0,682689492137 | 0.317310507863 |

| OEIS: A178647 | ||

| 2 | 0,954499736104 | 0,045500.263896 |

| OEIS: A110894 | ||

| 3 | 0.997300203937 | 0,002699796063 |

| OEIS: A270712 | ||

| 4 | 0,999936657516 | 0,000063342484 |

| |||

| 5 | 0,999999426697 | 0,000)573303 |

| |||

| 6 | 0,999999998027 | 0,000)001973 |

|

Para grande nNão., pode-se usar a aproximação 1- Sim. - Sim. p? ? e- Sim. - Sim. n2/2nD D /2{displaystyle 1-papprox {frac {e^{-n^{2}/2}}{n{sqrt Sim..

Função quantílica

A função quantil de uma distribuição é o inverso da função de distribuição cumulativa. A função quantil da distribuição normal padrão é chamada de função probit e pode ser expressa em termos da função de erro inversa:

- Φ Φ - Sim. - Sim. 1(p)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =2E- Sim. - Sim. 1 (2p- Sim. - Sim. 1),p∈ ∈ (0,1).Não. Phi ^{-1}(p)={sqrt {2}}operatorname {erf} ^{-1}(2p-1),quad pin (0,1). ?

Para uma variável aleatória normal com média μ μ - Sim. e variância σ σ 2{displaystyle sigma ^{2}}, a função quantil é

- F- Sim. - Sim. 1(p)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =μ μ +σ σ Φ Φ - Sim. - Sim. 1(p)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =μ μ +σ σ 2E- Sim. - Sim. 1 (2p- Sim. - Sim. 1),p∈ ∈ (0,1).{displaystyle F^{-1}(p)=mu +sigma Phi ^{-1}(p)=mu +sigma {sqrt {2}}operatorname {erf} ^{-1}(2p-1),quad pin (0,1). ?

O quantil Φ Φ - Sim. - Sim. 1(p)Não. Phi ^{-1}(p)} da distribuição normal padrão é comumente denotada como zangão.pNão. Z_{p}}. Esses valores são usados em testes de hipóteses, construção de intervalos de confiança e gráficos Q-Q. Uma variável aleatória normal X- Sim. exceda μ μ +zangão.pσ σ {displaystyle mu +z_{p}sigma } com probabilidade 1- Sim. - Sim. pNão., e vai ficar fora do intervalo μ μ ± ± zangão.pσ σ {displaystyle mu pm z_{p}sigma } com probabilidade 2(1- Sim. - Sim. p){displaystyle 2(1-p)}. Em particular, o quantil zangão.0.975{displaystyle z_{0.975}} é 1,96; portanto, uma variável aleatória normal estará fora do intervalo μ μ ± ± 1.96σ σ {displaystyle mu pm 1.96sigma } em apenas 5% dos casos.

A tabela a seguir dá o quantil zangão.pNão. Z_{p}} tal que X- Sim. vai mentir no intervalo μ μ ± ± zangão.pσ σ {displaystyle mu pm z_{p}sigma } com uma probabilidade especificada pNão.. Esses valores são úteis para determinar o intervalo de tolerância para médias de amostra e outros estimadores estatísticos com distribuições normais (ou assintoticamente normais). Note que a tabela a seguir mostra 2E- Sim. - Sim. 1 (p)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =Φ Φ - Sim. - Sim. 1(p+12){displaystyle {sqrt {2}}operatorname {erf} ^{-1}(p)=Phi ^{-1}left({frac {p+1}{2}}right)}, não Φ Φ - Sim. - Sim. 1(p)Não. Phi ^{-1}(p)} como definido acima.

| pNão. | zangão.pNão. Z_{p}} | pNão. | zangão.pNão. Z_{p}} | |

|---|---|---|---|---|

| 0,80 | 1.281551565545 | 0,999 | 3.290526731492 | |

| 0,90 | 1.644853626951 | 0,9999 | 3.890591886413 | |

| 0,95 | 1.959963984540 | 0,99999 | 4.417173413469 | |

| 0,98 | 2.326347874041 | 999.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99.99. | 4.891638475699 | |

| 0,99 | 2.575829303549 | 9.999 | 5.326723886384 | |

| 0,995 | 2.807033768344 | 999.99 | 5.730728868236 | |

| 0,998 | 3.090232306168 | 9.99999 | 6.109410204869 |

Para pequeno pNão., a função quantil tem a expansão assintotic útil Φ Φ - Sim. - Sim. 1(p)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. I 1p2- Sim. - Sim. I I 1p2- Sim. - Sim. I (2D D )+o(1).Não. Phi ^{-1}(p)=-{sqrt {ln {frac {1}{p^{2}}}-ln ln {1}{p^{2}}}-ln(2pi)}}+{mathcal {o}}(1).}

Propriedades

A distribuição normal é a única distribuição cujos cumulantes além dos dois primeiros (isto é, exceto a média e a variância) são zero. É também a distribuição contínua com a entropia máxima para uma média e variância especificadas. Geary mostrou, assumindo que a média e a variância são finitas, que a distribuição normal é a única distribuição em que a média e a variância calculadas a partir de um conjunto de extrações independentes são independentes uma da outra.

A distribuição normal é uma subclasse das distribuições elípticas. A distribuição normal é simétrica em relação à sua média e é diferente de zero em toda a linha real. Como tal, pode não ser um modelo adequado para variáveis inerentemente positivas ou fortemente distorcidas, como o peso de uma pessoa ou o preço de uma ação. Tais variáveis podem ser melhor descritas por outras distribuições, como a distribuição log-normal ou a distribuição de Pareto.

O valor da distribuição normal é praticamente zero quando o valor xNão. Encontra-se mais do que alguns desvios padrão fora da média (por exemplo, uma propagação de três desvios padrão abrange todos, mas 0,27% da distribuição total). Portanto, pode não ser um modelo apropriado quando se espera uma fração significativa de outliers - valores que estão muitos desvios padrão longe da média - e menos quadrados e outros métodos de inferência estatística que são ideais para variáveis normalmente distribuídas muitas vezes se tornam altamente confiáveis quando aplicados a tais dados. Nesses casos, deve-se assumir uma distribuição mais pesada e aplicar-se os métodos de inferência estatística robustos adequados.

A distribuição gaussiana pertence à família das distribuições estáveis que são os atratores de somas de distribuições independentes e identicamente distribuídas, quer a média ou a variância seja finita ou não. Com exceção da gaussiana, que é um caso limite, todas as distribuições estáveis têm caudas pesadas e variância infinita. É uma das poucas distribuições estáveis e que possuem funções de densidade de probabilidade que podem ser expressas analiticamente, sendo as outras a distribuição de Cauchy e a distribuição de Lévy.

Simetrias e derivadas

A distribuição normal com densidade f(x)(x)} (Mean) μ μ - Sim. e desvio padrão 0}" xmlns="http://www.w3.org/1998/Math/MathML">σ σ >0- Sim.0" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/762ecd0f0905dd0d4d7a07f80fa8bfb324b9b021" style="vertical-align: -0.338ex; width:5.591ex; height:2.176ex;"/>) tem as seguintes propriedades:

- É simétrico em torno do ponto x= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =μ μ ,Não. que é ao mesmo tempo o modo, a mediana e a média da distribuição.

- É unimodal: seu primeiro derivado é positivo para <math alttext="{displaystyle xx<μ μ ,- Sim.<img alt="{displaystyle x negativo para mu}" xmlns="http://www.w3.org/1998/Math/MathML">x>μ μ ,- Sim.

mu}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/d3463a22382792e476326893bbc79d8ca5ed60c3" style="vertical-align: -0.838ex; width:6.477ex; height:2.343ex;"/> e zero apenas em x= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =μ μ .{displaystyle x=mu.}

- A área limitada pela curva e pela xNão.-axis é unidade (ou seja, igual a um).

- Seu primeiro derivado é f? ? (x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. x- Sim. - Sim. μ μ σ σ 2f(x).(x)=-{frac {x-mu }{sigma ^{2}}}f(x).}

- Sua densidade tem dois pontos de inflexão (onde o segundo derivado de fNão. é zero e mudança sinal), localizado um desvio padrão longe da média, ou seja, em x= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =μ μ - Sim. - Sim. σ σ {displaystyle x=mu -sigma } e x= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =μ μ +σ σ .{displaystyle x=mu +sigma.}

- Sua densidade é log-concave.

- Sua densidade é infinitamente diferenciável, de fato supersmooth da ordem 2.

Além disso, a densidade φ φ - Sim. da distribuição normal padrão (i.e. μ μ = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =0{displaystyle mu =0} e σ σ = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =1{displaystyle sigma} - Sim.) também tem as seguintes propriedades:

- Seu primeiro derivado é φ φ ? ? (x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. xφ φ (x).{displaystyle varphi ^{prime }(x)=-xvarphi (x).}

- Seu segundo derivado é φ φ ? ? ? ? (x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =(x2- Sim. - Sim. 1)φ φ (x)(x)=(x^{2}-1)varphi (x)}

- Mais geralmente, sua no derivado é φ φ (n)(x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =(- Sim. - Sim. 1)nEle.n (x)φ φ (x),{displaystyle varphi ^{(n)}(x)=(-1)^{n}operatorname {He} _{n}(x)varphi (x),} Onde? Ele.n (x){displaystyle operatorname {He} _{n}(x)} é o nth (probabilist) Hermite polinomial.

- A probabilidade de uma variável normalmente distribuída X- Sim. com conhecido μ μ - Sim. e σ σ - Sim. é em um conjunto particular, pode ser calculado usando o fato de que a fração Z.= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =(X- Sim. - Sim. μ μ )/σ σ {displaystyle Z=(X-mu)/sigma } tem uma distribuição normal padrão.

Momentos

Os momentos simples e absolutos de uma variável X- Sim. são os valores esperados de Xp{displaystyle X^{p}} e |X|p{displaystyle |X|^{p}}, respectivamente. Se o valor esperado μ μ - Sim. de X- Sim. é zero, estes parâmetros são chamados momentos centrais; caso contrário, estes parâmetros são chamados momentos não centrais. Normalmente estamos interessados apenas em momentos com ordem inteiro p{displaystyle p}.

Se X- Sim. tem uma distribuição normal, os momentos não centrais existem e são finitos para qualquer pNão. cuja parte real é maior que −1. Para qualquer inteiro não negativo pNão., os momentos centrais simples são:

- E Não.(X- Sim. - Sim. μ μ )p]= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =(0sepé estranho,σ σ p(p- Sim. - Sim. 1)!!sepé mesmo.{displaystyle operatorname {E} left[(X-mu)^{p}right]={begin{cases}0&{text{if }}p{text{ is odd,}}\sigma ^{p}(p-1)!&{text{if }}p{text{ is even.}}end{cases}}}

Aqui. n!!Não! denota o factorial duplo, ou seja, o produto de todos os números de nNão. a 1 que tem a mesma paridade n.Não.

Os momentos absolutos centrais coincidem com momentos simples para todas as ordens, mas são nonzero para ordens ímpares. Para qualquer inteiro não negativo p,Não.

- E Não.|X- Sim. - Sim. μ μ |p]= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =σ σ p(p- Sim. - Sim. 1)!!)) (2D D sepé estranho1sepmesmo= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =σ σ p)) 2p/2)) (p+12)D D .{displaystyle {begin{aligned}operatorname} {E} left[|X-mu |^{p}right]&=sigma ^{p}(p-1)! cdot {begin{cases}{sqrt {frac {2}{pi }}}&{text{if }}p{text{ is odd}}1&{text{if }}p{text{ is even}}end{cases}}&=sigma ^{p}cdot {frac {2^{p/2}Gamma left({frac {p+1}{2}}

A última fórmula é válida também para qualquer não inteiro -1.}" xmlns="http://www.w3.org/1998/Math/MathML">p>- Sim. - Sim. 1.Não.-1.}" aria-hidden="true" class="mwe-math-fallback-image-inline" src="https://wikimedia.org/api/rest_v1/media/math/render/svg/2664add830e3fdc570b1dddcdbe85950c3055332" style="vertical-align: -0.671ex; margin-left: -0.089ex; width:7.975ex; height:2.509ex;"/> Quando a média μ μ ≠ ≠ 0,{displaystyle mu neq 0,} os momentos simples e absolutos podem ser expressos em termos de funções hipergeométricas confluentes 1F1Não. {}_{1}F_{1}} e U.Não. U.

- E Não.Xp]= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =σ σ p)) (- Sim. - Sim. Eu...2)pU(- Sim. - Sim. p2,12,- Sim. - Sim. 12(μ μ σ σ )2),E Não.|X|p]= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =σ σ p)) 2p/2)) (1+p2)D D 1F1(- Sim. - Sim. p2,12,- Sim. - Sim. 12(μ μ σ σ )2).{displaystyle {begin{aligned}operatorname} {E} left[X^{p}right]&=sigma ^{p}cdot (-i{sqrt {2}})^{p}Uleft(-{frac {p}{2}},{frac {1}{2}},-{frac {1}{2}}left({frac {mu }{sigma }}right)^{2}right,\operatorname {E} left[|X|^{p}right]&=sigma ^{p}cdot 2^{p/2}{frac {Gamma left({frac {1+p}{2}}right)}{sqrt {pi }}}{}_{1}F_{1}left(-{frac {p}{2}},{frac {1}{2}},-{frac {1}{2}}left({frac {mu }{sigma }}right)^{2}right).end{aligned}}}

Estas expressões permanecem válidas mesmo se pNão. não é um inteiro. Veja também polinômios herméticos generalizados.

| Ordem | Momento não central | Hora central |

|---|---|---|

| 1 | μ μ - Sim. | 0Não. 0 |

| 2 | μ μ 2+σ σ 2{displaystyle mu ^{2}+sigma ^{2}} | σ σ 2{displaystyle sigma ^{2}} |

| 3 | μ μ 3+3μ μ σ σ 2{displaystyle mu ^{3}+3mu sigma ^{2}} | 0Não. 0 |

| 4 | μ μ 4+6μ μ 2σ σ 2+3σ σ 4{displaystyle mu ^{4}+6mu ^{2}sigma ^{2}+3sigma ^{4}} | 3σ σ 4{displaystyle 3sigma ^{4}} |

| 5 | μ μ 5+10.μ μ 3σ σ 2+15μ μ σ σ 4{displaystyle mu ^{5}+10mu ^{3}sigma ^{2}+15mu sigma ^{4}} | 0Não. 0 |

| 6 | μ μ 6+15μ μ 4σ σ 2+45μ μ 2σ σ 4+15σ σ 6{displaystyle mu ^{6}+15mu ^{4}sigma ^{2}+45mu ^{2}sigma ^{4}+15sigma ^{6}} | 15σ σ 6{displaystyle 15sigma ^{6}} |

| 7 | μ μ 7+21μ μ 5σ σ 2+105μ μ 3σ σ 4+105μ μ σ σ 6{displaystyle mu ^{7}+21mu ^{5}sigma ^{2}+105mu ^{3}sigma ^{4}+105mu sigma ^{6}} | 0Não. 0 |

| 8 | μ μ 8+28μ μ 6σ σ 2+210μ μ 4σ σ 4+420μ μ 2σ σ 6+105σ σ 8{displaystyle mu ^{8}+28mu ^{6}sigma ^{2}+210mu ^{4}sigma ^{4}+420mu ^{2}sigma ^{6}+105sigma ^{8}} | 105σ σ 8{displaystyle 105sigma ^{8}} |

A expectativa de X- Sim. condicionado no evento que X- Sim. está em um intervalo Não.um,b)]Não. é dado por

- <math alttext="{displaystyle operatorname {E} left[Xmid a<XE Não.X∣ ∣ um<X<b)]= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =μ μ - Sim. - Sim. σ σ 2f(b))- Sim. - Sim. f(um)F(b))- Sim. - Sim. F(um){displaystyle operatorname {E} left[Xmid a<X<bright]=mu -sigma ^{2}{frac {f(b)-f(a)}{F(b)-F(a)}}}<img alt="{displaystyle operatorname {E} left[Xmid a<X

Onde? fNão. e FNão. respectivamente são a densidade e a função de distribuição cumulativa de X- Sim.. Para b)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =∞ ∞ Não. Isto é conhecido como a relação Mills inversa. Note que acima, densidade fNão. de X- Sim. é usado em vez da densidade normal padrão como no inverso Taxa de moinhos, então aqui temos σ σ 2{displaystyle sigma ^{2}} em vez de σ σ - Sim..

Transformada de Fourier e função característica

A transformação de Fourier de uma densidade normal fNão. com média μ μ - Sim. e desvio padrão σ σ - Sim. o

- f^ ^ ())= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =∫ ∫ - Sim. - Sim. ∞ ∞ ∞ ∞ f(x)e- Sim. - Sim. Eu...)xDx= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =e- Sim. - Sim. Eu...μ μ )e- Sim. - Sim. 12(σ σ ))2{displaystyle {hat {f}}(t)=int _{-infty }^{infty }f(x)e^{-itx},dx=e^{-imu t}e^{-{frac {1}{2}}(sigma t)^{2}}}

Onde? Eu...Não. é a unidade imaginária. Se a média μ μ = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =0{displaystyle mu =0}, o primeiro fator é 1, e a transforma Fourier é, além de um fator constante, uma densidade normal no domínio de frequência, com média 0 e desvio padrão 1/σ σ - Não.. Em particular, a distribuição normal padrão φ φ - Sim. é um eigenfunction da transformação Fourier.

Em teoria da probabilidade, a transformação de Fourier da distribuição de probabilidade de uma variável aleatória de valor real X- Sim. está intimamente ligado à função característica φ φ X())(t)} dessa variável, que é definida como o valor esperado de eEu...)X{displaystyle e^{itX}}, como uma função da variável real )Não. (o parâmetro de frequência da transformação de Fourier). Esta definição pode ser analiticamente estendida a uma variável de valor complexo )Não.. A relação entre ambos é:

- φ φ X())= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =f^ ^ (- Sim. - Sim. )){displaystyle varphi _{X}(t)={hat {f}}(-t)}

Funções geradoras de momentos e cumulantes

A função geradora de momento de uma variável aleatória real X- Sim. é o valor esperado de e)X{displaystyle e^{tX}}, como uma função do parâmetro real )Não.. Para uma distribuição normal com densidade fNão.Quero dizer... μ μ - Sim. e desvio σ σ - Sim., a função geradora de momento existe e é igual a

- M())= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =E Não.e)X]= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =f^ ^ (Eu...))= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =eμ μ )e12σ σ 2)2{displaystyle M(t)=operatorname {E} [e^{tX}]={hat {f}}(it)=e^{mu t}e^{{tfrac {1}{2}}sigma ^{2}t^{2}}}

A função geradora cumulante é o logaritmo da função geradora de momento, ou seja

- g())= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =I M())= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =μ μ )+12σ σ 2)2{displaystyle g(t)=ln M(t)=mu t+{tfrac {1}{2}}sigma ^{2}t^{2}}

Uma vez que este é um polinomial quadrático em )Não., apenas os dois primeiros cumulants são nonzero, ou seja, a médiaμ μ - Sim. e a variânciaσ σ 2{displaystyle sigma ^{2}}.

Operador e classe de Stein

Dentro do método de Stein o operador Stein e classe de uma variável aleatória X∼ ∼ N(μ μ ,σ σ 2)Não. Xsim {mathcal {N}}(musigma ^{2})} são Af(x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =σ σ 2f?(x)- Sim. - Sim. (x- Sim. - Sim. μ μ )f(x){displaystyle {mathcal {A}}f(x)=sigma ^{2}f'(x)-(x-mu)f(x)} e F{displaystyle {mathcal {F}}} a classe de todas as funções absolutamente contínuas <math alttext="{displaystyle f:mathbb {R} to mathbb {R} {mbox{ such that }}mathbb {E} [|f'(X)|]f:R→ → Rtal queENão.|f?(X)|]<∞ ∞ {displaystyle f:mathbb] {R} to mathbb {R} {mbox{ such that }}mathbb {E} [|f'(X)|infty }<img alt="{displaystyle f:mathbb {R} to mathbb {R} {mbox{ such that }}mathbb {E} [|f'(X)|].

Limite de variância zero

No limite quando σ σ - Sim. tende a zero, a densidade de probabilidade f(x)(x)} eventualmente tende a zero em qualquer x≠ ≠ μ μ {displaystyle xneq mu }, mas cresce sem limite se x= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =μ μ - Sim., enquanto sua integral permanece igual a 1. Portanto, a distribuição normal não pode ser definida como uma função comum quando σ σ = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =0{displaystyle sigma=0}.

No entanto, pode-se definir a distribuição normal com zero variância como uma função generalizada; especificamente, como "função delta" de Dirac δ δ - Sim. traduzido pela média μ μ - Sim., isto é f(x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =δ δ (x- Sim. - Sim. μ μ ).{displaystyle f(x)=delta (x-mu). ?Seu CDF é então a função passo pesado traduzida pela média μ μ - Sim.,

- <math alttext="{displaystyle F(x)={begin{cases}0&{text{if }}xF(x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =(0sex<μ μ 1sex≥ ≥ μ μ {displaystyle F(x)={begin{cases}0&{text{if }}x<mu \1&{text{if }}xgeq mu end{cases}}}<img alt="{displaystyle F(x)={begin{cases}0&{text{if }}x

Entropia máxima

De todas as distribuições de probabilidade sobre os reais com uma média especificada μ μ - Sim. e variânciaσ σ 2{displaystyle sigma ^{2}}, a distribuição normal N(μ μ ,σ σ 2){displaystyle N(musigma ^{2})} é aquele com entropia máxima. Se X- Sim. é uma variável aleatória contínua com densidade de probabilidade f(x)(x)}, então a entropia de X- Sim. é definido como

- H. H. H.(X)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =- Sim. - Sim. ∫ ∫ - Sim. - Sim. ∞ ∞ ∞ ∞ f(x)log f(x)Dx{displaystyle H(X)=-int _{-infty }^{infty }f(x)log f(x),dx}

Onde? f(x)log f(x){displaystyle f(x)log f(x)} é entendido como zero sempre f(x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =0(x)=0}. Este funcional pode ser maximizado, sujeito às restrições que a distribuição é adequadamente normalizada e tem uma variância especificada, usando cálculo variacional. Uma função com dois multiplicadores Lagrange é definida:

- L= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =∫ ∫ - Sim. - Sim. ∞ ∞ ∞ ∞ f(x)I (f(x))Dx- Sim. - Sim. λ λ 0(1- Sim. - Sim. ∫ ∫ - Sim. - Sim. ∞ ∞ ∞ ∞ f(x)Dx)- Sim. - Sim. λ λ (σ σ 2- Sim. - Sim. ∫ ∫ - Sim. - Sim. ∞ ∞ ∞ ∞ f(x)(x- Sim. - Sim. μ μ )2Dx){displaystyle L=int _{-infty }^{infty }f(x)ln(f(x)),dx-lambda _{0}left(1-int _{-infty }^{infty }f(x),dxright)-lambda left(sigma ^{2}-int

Onde? f(x)(x)} é, por enquanto, considerado como uma função de densidade com média μ μ - Sim. e desvio padrão σ σ - Sim..

Na entropia máxima, uma pequena variação δ δ f(x)(x)} sobre f(x)(x)} produzirá uma variação δ δ L- Sim. sobre LNão. L. que é igual a 0:

- 0= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =δ δ L= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =∫ ∫ - Sim. - Sim. ∞ ∞ ∞ ∞ δ δ f(x)(I (f(x))+1+λ λ 0+λ λ (x- Sim. - Sim. μ μ )2)Dx{displaystyle 0=delta L=int _{-infty }^{infty }delta f(x)left(ln(f(x))+1+lambda _{0}+lambda (x-mu)^{2}right),dx}

Uma vez que isso deve segurar qualquer pequeno δ δ f(x)(x)}, o termo entre parênteses deve ser zero, e resolver para f(x)(x)} Rendimentos:

- f(x)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =e- Sim. - Sim. λ λ 0- Sim. - Sim. 1- Sim. - Sim. λ λ (x- Sim. - Sim. μ μ )2{displaystyle f(x)=e^{-lambda _{0}-1-lambda (x-mu)^{2}}}

Usando as equações de restrição para resolver λ λ 0{displaystyle lambda _{0}} e λ λ - Sim. produz a densidade da distribuição normal:

- f(x,μ μ ,σ σ )= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =12D D σ σ 2e- Sim. - Sim. (x- Sim. - Sim. μ μ )22σ σ 2{displaystyle f(x,musigma)={frac {1}{sqrt {2pi sigma ^{2}}^{-{frac {(x-mu)^{2}}{2sigma ^{2}}}}

A entropia de uma distribuição normal é igual a

- H. H. H.(X)= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =12(1+I (2σ σ 2D D )){displaystyle H(X)={tfrac {1}{2}}(1+ln(2sigma ^{2}pi)}

Outras propriedades

- Se a função característica φ φ X{displaystyle phi _{X}} de alguma variável aleatória X- Sim. é da forma φ φ X())= = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = = =expQ()){displaystyle phi _{X}(t)=exp ^{Q(t)}}, onde Q())(T)} é um polinômio, então o Marcinkiewicz teorema (nomeado após Józef Marcinkiewicz) afirma que QNão. pode ser no máximo um polinômio quadrático, e, portanto, X- Sim. é uma variável aleatória normal. A consequência deste resultado é que a distribuição normal é a única distribuição com um número finito (dois) de cumulants não-zero.

- Se X- Sim. e YNão. Sim. são comuns normais e não-cor-relacionadas, então eles são independentes. A exigência de que X- Sim. e YNão. Sim. deve ser em conjunto normal é essencial; sem ele a propriedade não segura.[prova] Para variáveis aleatórias não-normais a uncorrelatedness não implica independência.